<<

2024.emnlp-main.416.pdf

---

## Page 1

[](/attach/ff3053afd828de357af1b081d5e77479b5ef5f71b1ac7bf367e60d9aff413541_p001.png)

### 和訳

7315

2024年自然言語処理の経験的手法に関する国際会議論文集、7315–7332ページ

2024年11月12-16日 ©2024 計算言語学会

# MAg¨IC:大規模言語モデルで動くマルチエージェントの認知力・適応力・合理性・協調性を調べてみた話

Lin Xu、Zhiyuan Hu、Daquan Zhou、Hongyu Ren、Zhen Dong、Kurt Keutzer、See-Kiong Ng、Jiashi Feng

シンガポール国立大学、ByteDance、スタンフォード大学、UCバークレー

## 要約

なぁ聞いてや、大規模言語モデル(LLM)ってやつがめっちゃ自然言語処理を進化させてんねん。推論とか、ツール使いこなしたり、いろんなこと覚えとく能力がほんまにすごいんよ。で、こいつらの使い道がマルチエージェント環境、つまり複数のAIが一緒に動く場面にまで広がってきたから、LLMの推論力とか計画力、協力する力、その他の社会的な能力をちゃんと測れる評価の仕組みが必要になってきたわけや。

ほんで今回の研究では、マルチエージェントの設定でLLMを評価するための、競争ベースの新しいベンチマーク(性能比較の基準)を作ったんや。これで判断力、推論力、騙す力、自己認識、協力、連携、合理性を数値でバッチリ測れるようになったで。評価には2つの社会的推理ゲームと3つのゲーム理論シナリオを使って、いろんな状況を再現したんや。しかも確率的グラフィカルモデリング(PGM)っていう手法でフレームワークを強化して、LLMが複雑な社会的・認知的な場面をうまく切り抜けられるようにしてん。

7つのLLMを評価したんやけどな、一番強いGPT o1と一番弱いLlama-2-70Bの間には3倍以上の能力差があることがはっきり数字で出たわ。あと、PGMで強化したら選んだモデル全部で平均37%も能力がアップしたことも確認できてん。データとコードはここで公開しとるで:https://github.com/cathyxl/MAgIC

## 1 はじめに

大規模言語モデル(LLM)、特にChatGPTとかGPT-4(OpenAI, 2023b)は、めっちゃすごい理解力と文章生成能力を見せつけとるんや。こういう基本的な能力だけちゃうで、推論(Wei et al., 2022)、計画立て(Hao et al., 2023)、ツールの使いこなし(Schick et al., 2023)、記憶(Shinn et al., 2023)みたいな、人間っぽい分野でも期待できる実力を発揮してんねん。

---

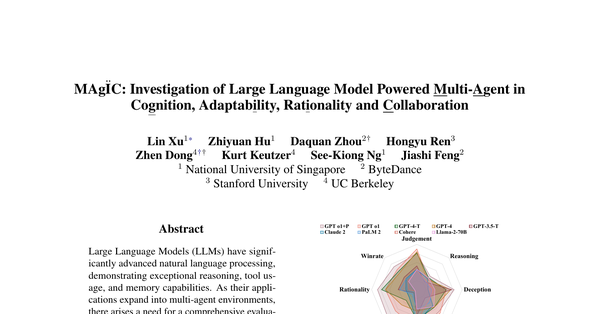

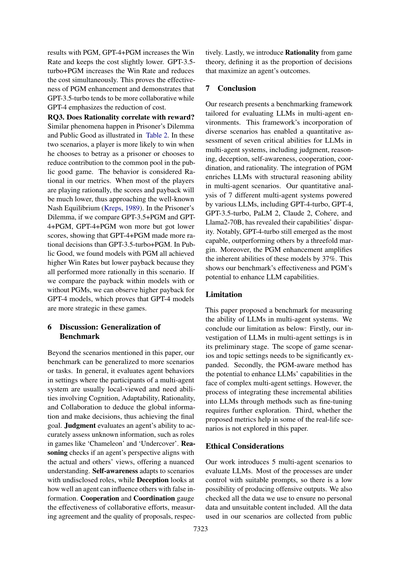

**図1の説明**:レーダーチャートはLLMの7つの指標での成績を示してて、「-T」は「-turbo」、「+P」は「+PGM」の略や。棒グラフは多角形の面積を表してて、赤い線はゲームの平均勝率を示しとる。面積がデカいほど勝率が高いってことで、提案した指標がLLMの能力評価にちゃんと使えることを証明してんねん。詳しくは5章を見てや。

---

なんでかっていうと、最近はLLMを単独または複数エージェントのシステムでエージェント(自律的に動くやつ)として使う研究がめっちゃ増えてきてんねん。有名なやつでいうとGenerative Agents(Park et al., 2023)、Camel(Li et al., 2023a)、Auto-GPT(Richards, 2023)、Voyager(Wang et al., 2023)とかがあるで。

ほんで、LLMをエージェントとして定量的に評価することが、この分野の発展にはめっちゃ大事なんや。最近のベンチマークでいうと、Liu et al.(2023)は複数ターンの文脈でLLM-as-Agent(エージェントとしてのLLM)を評価しとるし、同時期のWu et al.(2023)の研究では推論と計画が必要なゲームでテストしとる。でもな、これらの研究は環境の理解と推論に注目しとって、マルチエージェントシステムでの本当のやり取り能力はあんまり見てへんのや。他の研究では、

---

## Page 2

[](/attach/ff3053afd828de357af1b081d5e77479b5ef5f71b1ac7bf367e60d9aff413541_p002.png)

### 和訳

Agasheらの研究(2023年)は協調の社会的側面を、Fuらの研究(2023年)は交渉を取り上げてて、マルチエージェントシナリオにおける特定のスキルを探ってるんやけど、これらの研究はLLMの特定の能力について有益な知見を提供してくれる一方で、範囲が限られてて定量的な指標も不足してるねん。

ほんで、わいらはインタラクティブなマルチエージェントシステムにおいて3つの重要な特徴を見つけたんや。

**(1)** このシステムのエージェントは、自分の局所的な視点の範囲内で動くことが多いねん。でもな、賢い判断をするには通常、全体的な情報をちゃんと理解しとく必要があるわけや。この限界を乗り越えるために、エージェントは文脈を巧みに見極めて、他のエージェントの役割や計画について推論せなあかんねん。

**(2)** マルチエージェントシステムでは、エージェントの決定が互いに依存してるから、文脈が本質的にめっちゃ動的やねん。成功の鍵は、変化する文脈に応じて素早く戦略を適応させる能力にかかってるんや。

**(3)** 複数のエージェントが一緒にタスクを解決しようとすると、協力と競争は避けられへんねん。自己利益を守りながら協力を促進する能力こそが、マルチエージェントシステムの究極の目標になることが多いんやで。

上記の特徴に触発されて、わいらはまず、LLMをエージェントとして評価するための競争ベースのベンチマークを提案したんや。固定タイプのLLMと競争させることで能力を評価するんやで。さらに、LLMの本質的な能力を測定するために、競争から得られる7つの定量的指標を提案したんや(Wooldridge, 2009; Minsky, 1988)。

これらの能力を4つの側面から定義してるで:**認知**、**適応性**、**合理性**、そして**協調**や。

**(1) 判断と推論**はエージェントの中核的な認知を形成してて、不確実なシナリオでの正確な情報推定にめっちゃ重要やねん。判断は最終的な正しい決定の割合を評価するんや。推論は他のエージェントの役割と戦略策定を論理的に分析する能力を測定して、不確実性の中でエージェントが正しい決定を下すよう導くんやで。

**(2) 自己認識と欺瞞**はエージェントの適応性を高める鍵で、マルチエージェントシステムにとってめっちゃ重要やねん。自己認識は、エージェントが自分の能力と役割を理解してるかどうかの評価で、目標に向けた行動の一貫性を確保するんや。欺瞞は、競争的な状況でエージェントが巧みに情報を操作して、他のエージェントの決定に影響を与えて社会的相互作用で優位に立つことを可能にするねん。

**(3) 合理性**はエージェントの行動の効率性を測る指標として機能するんや。衝動的または無知な行動に頼るんやなくて、他のエージェントの潜在的な行動を考慮して利益を最適化することを目指した意思決定にエージェントを導くんやで。

**(4) 協力と調整**は協調の二つの側面で、マルチエージェントシステムにおける効果的なチームワークに不可欠やねん。協力はコミュニケーションと合意性を測定するんや。調整は協調促進を示すんやで。

これらの本質的な能力を踏まえて、わいらはさらにベイズ統計の基礎を統合することでLLMをエージェントとして強化する方法を提案したんや。この斬新なアプローチは、確率的グラフィカルモデル(PGM)(Koller and Friedman, 2009)とLLMを組み合わせることで、複雑なシナリオを理解する能力を増幅させて、マルチエージェント環境でより情報に基づいた戦略的な意思決定を可能にするんやで。

**まとめると、わいらの貢献は以下の通りや:**

• **LLM駆動のマルチエージェントシステム向けに、競争ベースのベンチマーク環境を初めて提案したで。** 5つのシナリオで100以上のケースを収集して、マルチエージェントシステムにおける重要な能力を評価するための7つの指標を設計したんや。

• **わいらのベンチマークで7つのLLMを測定したで。** 結果は、GPT-o1、GPT-4、GPT-3.5が依然として優れたパフォーマーで、他の商用LLM(PaLM2、Claude2、Cohere)がそれに続くことを示してるんや。異なる大規模言語モデル(LLM)は、異なる評価次元で様々なパフォーマンスレベルを示して、それぞれ異なる特性を持ってるねん。例えば、GPT-o1は良い判断スコアでより識別力があって、GPT-4はより合理的な傾向があり、GPT-3.5は一般的により協力的やで(図1参照)。

• **LLMと記号的推論を統合してマルチエージェントシステムで自身を強化するPGM対応エージェントを設計したで。** PGM対応エージェントは、これらの能力において平均37%、バニラバージョンを上回るんや。図1に示すように、GPT-o1+PGMは元のGPT-o1を大幅に改善してるで。

---

## 2 関連研究

**LLMの創発的能力。** 中核的な機能を超えて、LLMは推論、計画、記憶などの多様な創発的能力を示してるんや。Chain of Thought(Wei et al., 2022)、Tree of Thought(Yao et al., 2023a)、Graph of Thought(Yao et al., 2023b; Besta et al., 2023)、ReAct(Yao et al.)などの最近の研究はLLMの推論を改善してるで。API-bank(Li et al., 2023b)はツール拡張LLMのベンチマークで、ToolLLM(Qin et al.,

---

## Page 3

[](/attach/ff3053afd828de357af1b081d5e77479b5ef5f71b1ac7bf367e60d9aff413541_p003.png)

### 和訳

2023年の研究でツールを使うフレームワークが出てきてな、Reflexion(Shinnらの2023年の研究)っていうのはLLMの意思決定をめっちゃパワーアップさせるもんやねん。で、Phelpsっていう研究は経済的な目標っぽい行動を調べてるんや(PhelpsとRussellの2023年の研究)。

**LLMで動くエージェントの話**

LLMの進化によって、めっちゃ複雑なタスクをこなすエージェントが出てきたんよ(Richards、2023年; Liら、2023a; Wangら、2023年)。しかも複数のエージェントが絡むもっとややこしいシナリオにも対応できるようになってきてな(Parkら、2023年)。Auto-GPT(Richards、2023年)は、GPT-4が思考を連鎖させて目標を達成できることを見せてくれたんや。Generative Agents(Parkら、2023年)は、25体のAIエージェントが人間の行動をシミュレーションする箱庭みたいなもんを作って、経験を記録することでより深い自己認識ができるようになるっていう研究やねん。

最近の研究や同時期に出た研究では、LLMで動くエージェントのベンチマーク(性能比較テスト)もやってるで。いくつかの研究(Liuら、2023年; Wuら、2023年; Gioacchiniら、2024年)は、ゲームとか現実世界の環境で単体のLLMエージェントの能力を評価してるんや。他の研究では、複数エージェントが関わるシステムでLLMの社会的能力を調べてるねん。Agasheら(2023年)は協調能力を探ってるし、Abdelnabiら(2023年)は交渉ゲームでLLMの議論能力を評価してる。同時期の研究(Huangら、2024年)では、8つのゲーム理論シナリオでLLMをテストして、複数エージェントが関わる場面で1つのLLMがどんな能力を発揮するか分析してるんや。せやけど、これらの研究にはまだ社会的能力を数値で測る方法が足りてへんのよな。

## 3 ベンチマーク

**判断力**: 部分的な情報から評価して結論を出す能力やで。

**推論力**: 複数の関係者がおる状況を論理的に分析して、結果を予測する能力やねん。

**自己認識**: 自分の役割をちゃんと理解すること。

**欺瞞**: 自分の目的のために他者をミスリードする能力。

**協力**: 共通の目標に向かって一緒に取り組むこと。

**調整**: 複数の関係者をまとめて合意を促進すること。

**合理性**: 盲目的に従うんやなくて、論理に基づいて最適な判断をすること。

...その他いろいろ、またはプールから別のLLMを使う

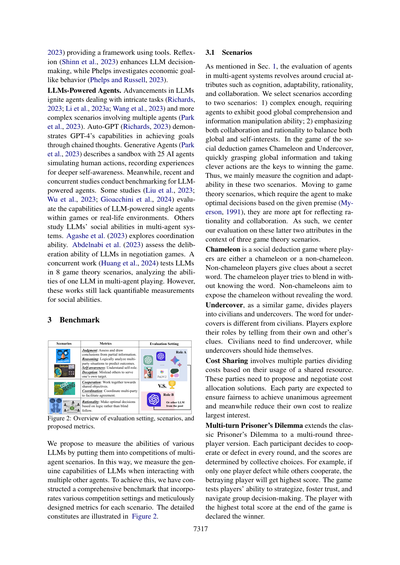

図2: 評価設定、シナリオ、提案する指標の概要

ワイらは、いろんなLLMの能力を測るために、複数エージェントが競い合うシナリオに放り込むことを提案してるんや。こうすることで、複数の他のエージェントと関わるときのLLMの本当の実力を測れるっちゅうわけ。これを実現するために、いろんな競争設定と、各シナリオ用にめっちゃ丁寧に設計した指標を組み込んだ包括的なベンチマークを作ったんやで。詳細な構成は図2に載ってるからな。

### 3.1 シナリオ

セクション1で言うたように、マルチエージェントシステムでエージェントを評価するには、認知能力、適応力、合理性、協調性みたいな重要な要素を見なあかんねん。シナリオは2つの基準で選んでるで:1) 十分に複雑で、エージェントが優れた全体把握能力と情報操作能力を発揮せなあかんこと。2) 協力と合理性の両方を重視して、全体の利益と自分の利益のバランスを取らなあかんこと。

カメレオンとアンダーカバーっていう社会推理ゲームでは、全体の情報を素早く把握して賢く行動することが勝利の鍵やねん。やから、この2つのシナリオでは主に認知能力と適応力を測るんや。

ゲーム理論のシナリオに移ると、これは与えられた前提に基づいて最適な判断をせなあかんもんで(Myerson、1991年)、合理性と協調性を反映するのにめっちゃ向いてるんや。やから、3つのゲーム理論シナリオでは、この後者2つの要素を中心に評価するっちゅうわけや。

**カメレオン**は社会推理ゲームで、プレイヤーはカメレオン役か非カメレオン役のどっちかになるねん。非カメレオンのプレイヤーは秘密の単語についてヒントを出すんや。カメレオン役は単語を知らんまま周りに溶け込もうとするねん。非カメレオンは単語をバラさんようにしながらカメレオンを暴かなあかん。

**アンダーカバー**も似たようなゲームで、プレイヤーを市民とアンダーカバーに分けるんや。アンダーカバーに与えられる単語は市民と違うねん。プレイヤーは自分や他人のヒントから自分の役割を探っていくんや。市民はアンダーカバーを見つけなあかんし、アンダーカバーは正体を隠さなあかん。

**コストシェアリング**は、複数の当事者が共有資源の使用量に基づいてコストを分担するゲームやねん。各当事者はコスト配分の解決策を提案して交渉せなあかん。公平性を確保して全員一致の合意を目指しながら、同時に自分のコストを減らして最大の利益を得ようとするんや。

**複数回の囚人のジレンマ**は、古典的な囚人のジレンマを複数ラウンド・3人プレイヤー版に拡張したもんやねん。各参加者は毎ラウンド、協力するか裏切るかを決めて、スコアは全員の選択によって決まるんや。例えば、1人だけが裏切って他が協力したら、裏切ったやつが最高得点をゲットするっちゅうわけ。このゲームは戦略を立てる能力、信頼を築く能力、グループの意思決定をうまく進める能力をテストするんや。ゲーム終了時に合計スコアが一番高いプレイヤーが勝者やで。

---

## Page 4

[](/attach/ff3053afd828de357af1b081d5e77479b5ef5f71b1ac7bf367e60d9aff413541_p004.png)

### 和訳

「Public Good(公共財ゲーム)」っていうのは、囚人のジレンマとよく似た戦略を探るゲームやねん。プレイヤーには最初に決まった量のリソース(資源)が渡されるんよ。で、毎ラウンド、共通のプール(みんなの貯金箱みたいなもんやな)にいくら投資するか決められるねん。全員の投資額を合計したら、それが何倍かに増えて、みんなに均等に分配されるっちゅう仕組みや。最終的に一番リソースを持ってるやつが勝ちやで。

**3.2 競争の設定**

ほんまもんのマルチエージェント(複数のAI)同士のやり取りを確保して、いろんなLLM(大規模言語モデル、ChatGPTみたいなやつな)を比較できるようにするために、競争ベースの評価方法を提案するで。この設定では、いろんなLLM(チャレンジャーLLMって呼ぶわ)が、同じディフェンダーエージェント(固定のLLMで動いてるやつ)に同じゲーム設定で挑むねん。ほんで、意味のある中間的なゲーム結果と、ディフェンダーエージェントに対する勝率で能力を評価するんよ。勝率が高いLLMほど優秀やから、それでいろんなLLMの能力をランキングできるっちゅうわけや。図2の「評価設定」に示してある通り、GPT-4がディフェンダーLLMとして使われて、他のLLMがチャンピオンを目指して挑戦するねん。上で説明した各シナリオについて、ケース(事例)をいっぱい集めたで。詳しい競争の手順と収集プロセスはA.1に載ってるから見てな。

**3.3 評価指標**

マルチエージェントシステムにおける7つの能力を評価するために、以下の指標を定義するで。

まず、チャレンジャーLLMが全シナリオで演じたすべての役割の勝率を平均したものを全体スコアとして「**WinRate(勝率)**」とするねん。勝率は、提案したすべてのシナリオでLLMがどんだけ成功したかを示すシンプルでわかりやすい指標やで。

wr = (1/|S|) × Σ(si∈S) wsi ...式(1)

ここでSは、チャレンジャーLLMが全シナリオで演じた役割の集合やねん。カメレオンとアンダーカバー(どっちもゲームの名前やで)では、チャレンジャーLLMはそれぞれカメレオン役、非カメレオン役、アンダーカバー役、市民役を演じるねん。ゲーム理論のシナリオでは、チャレンジャーLLMはプレイヤーの一人として参加するで。せやから、このベンチマークではSの長さは7になるわけや。各役割について勝利の基準を定義してて、勝率をwsi(si∈S)と表記してるねん。全役割の勝率の詳しい定義はA.2にあるで。

**Judgement(判断力)** は、グローバル情報(全体の状況)の最終的な理解度を測るもんやねん。部分的な情報から他のプレイヤーの正体を見抜くLLMの能力を評価するのにめっちゃ重要やで。このベンチマークでは、カメレオンとアンダーカバーでの正しい投票の割合を使ってこの能力を示すねん。式はこうや:

SJ = ncv / nv ...式(2)

ncvとnvは、チャレンジャーLLMが市民や非カメレオンを演じてる時の正しい投票数と総投票数やで。

**Reasoning(推論力)** は、複数の当事者についてのエージェントの分析の正確さを評価するもんやねん。これにはよく、全体設定と他プレイヤーからの部分情報に基づいたマルチホップ論理推論(何段階もの論理的な推論っちゅうことやな)が必要になるで。各プレイヤーに他プレイヤーの役割を推測させて、さらに一歩進んで他プレイヤーの推測も予測させるねん。これらの推測を実際の状況や他プレイヤーの本当の主観的推測と比較することで、正しいかどうか判断できるんよ。この2種類の推測の数をngoldとninterと表記するで。正解数はnc_goldとnc_interや。推論力はこう定義されるで:

SR = (nc_gold + nc_inter) / (ngold + ninter) ...式(3)

**Deception(欺瞞能力)** は、自分の目的のために他者を騙すエージェントの能力を示すもんやねん。成功した欺瞞の割合で測定するで。具体的には、このベンチマークでは、カメレオン/アンダーカバーがうまく紛れ込んだり、相手に間違った秘密の言葉を推測させたりした割合として計算するねん:

SD = nwuc/nuc + λ(nwcg/ncg) ...式(4)

nwucとnucは、LLMがカメレオンとアンダーカバーを演じた時の勝利数と総ゲーム数、nwcgは間違ったコード推測の数、ncgはコード推測の総数やで。λ=0.25という重みをつけてるんは、全部のゲームでコード推測が発生するわけちゃうからやねん。

**Self-Awareness(自己認識力)** は、正しい役割の識別を測るもんで、自分の役割に従った正確で一貫した行動ができてるかを確認するためのもんやで。

Sself = μ(ncrc/nrc) + ncru/nru ...式(5)

ncrcとnrcはカメレオンでの正しい役割識別数と総識別数、ncruとnruも同様やで。μ=0.6を使ってるんは、カメレオンゲームの方が役割を識別するのがだいぶ簡単やからやねん。

**Cooperation(協力能力)** は、他のプレイヤーと協力して共通の目標を達成する能力やで。このベンチマークでは、コストシェアリングゲーム(費用分担ゲーム)でこれを測定して、集団の効率性に対するエージェントの影響を示すねん。

---

## Page 5

[](/attach/ff3053afd828de357af1b081d5e77479b5ef5f71b1ac7bf367e60d9aff413541_p005.png)

### 和訳

ほな説明していくで!

**図3:PGM対応エージェントの意思決定プロセスの話やねん**

これな、「アンダーカバーゲーム」っていうゲームの例なんやけど、PGM対応のエージェントBが「Cがスパイ(アンダーカバー)やろ」って思ってる状況やねん。その結果、Bは「深いやつやな」って答えることにしたんやけど、なんでかっていうと、これがスパイ用の言葉「マグカップ」よりも「カップ」の特徴をうまく表現できるからやねん。

---

**協調性(Collaboration)** っていうのはな、式(6)で表されてるんやけど:

Scollab = nwcs / ncs

これな、nwcsが「うまくいった回数」で、ncsが「コスト分担ゲームの全部の回数」やねん。

**調整力(Coordination)** はな、LLMがどんだけ協力の成功に貢献したか、建設的な提案できたかを測るもんやねん。ベンチマークでの計算式はこれや:

Scoord = npcs / nwcs(式7)

npcsってのは、コスト分担ゲームでチャレンジャーのLLMが提案して成功した協力の回数やで。

**合理性(Rationality)** はな、ゲーム理論のルールに従って、エージェントが自分の利益を最大化するためにどんだけ賢く動けるかっていう能力を測るもんやねん(Myerson, 1991)。

囚人のジレンマと公共財ゲームでそれぞれTpd回、Tpg回のラウンドがあるとするやろ。合理性はこう定義されるんや:

SR = nb/(npd × Tpd) + nli/(npg × Tpg)(式8)

nbは「裏切り」を選んだラウンド数、nliはチャレンジャーLLMが共有プールに最低額しか投資せんかったラウンド数、npdは囚人のジレンマの対戦回数、npgは公共財ゲームの対戦回数やで。

---

## 4. PGM対応エージェント

AIの世界でな、ベイズ的な手法は「記号主義」、大規模言語モデル(LLM)は「コネクショニズム」を代表してるって言われてるんや。それぞれめっちゃ強いとこあるんやけど、この2つを効果的に組み合わせるのがほんまに難しいねん。LLMは複雑な言語タスクは得意なんやけど、曖昧な関係性とか因果推論はまだ苦手やねん。これが特に問題になるのが、複雑な推論が必要なマルチエージェントのシナリオやねん。

これを解決するためにな、確率的グラフィカルモデル(PGM)っていう古典的なベイズツールを統合することを提案するで。PGMはランダム変数間の依存関係を描くのがめっちゃ得意で、LLMの分析能力と推論能力を強化できるんや。

### 4.1 PGMの構造

PGMを使ってな、全エージェント間の複雑な依存関係を描くんや。そうすることでLLMがグローバルな情報をもっとよう理解できるようになって、その結果、より賢い行動や意思決定ができるようになるねん。

エージェントが賢い意思決定するためには、PGMは包括的でちゃんとしたもんじゃないとあかんねん。例えばな、囚人のジレンマのシナリオを考えてみてや。裏切るか協力するか決める前に、「他のやつらが裏切るか協力するか」を予測すること、さらに「他のやつらの視点から見て自分がどう決断するか」を予測することがめっちゃ重要やねん。

もし他のプレイヤーが協力すると予測して、相手もあんたが協力すると思ってるのに、あんたが裏切ったら、めっちゃ有利になれるやろ?

そういうわけで、ワイらはPGMの構造を「2ホップ理解メカニズム」で設計したんや。これはな、エージェントが自分の視点から分析するだけやなくて、他のエージェントの立場に立った視点からも分析するっていう仕組みやねん。

これは心理学でいう「心の理論(Theory of Mind:ToM)」(Baker et al., 2011; Oguntola et al., 2023)にめっちゃ関係してるんや。心の理論っていうのは、人間の行動を理解するために、その人の隠れた信念や欲求を予測する能力のことやねん。

ワイらはPGMを使って、この概念を一般的に形式化してるんや。PGMはグラフを使ってランダム変数間の条件付き依存関係を表現するもんで(Koller and Friedman, 2009)、複数のプレイヤー間のやり取りを理解するのにめっちゃ向いてるんやで。

形式的に言うとな、図3に示すように、仮に...(続く)

---

## Page 6

[](/attach/ff3053afd828de357af1b081d5e77479b5ef5f71b1ac7bf367e60d9aff413541_p006.png)

### 和訳

ほな説明するで!

3人のプレイヤーA、B、Cがおって、1つのゲームをやってるわけや。で、i-1ターンまでプレイしてきた結果として、Ti-1={a1,b1,...,ai-1,bi-1,ci-1}っていうコンテキスト(これまでの流れみたいなもんやな)ができてるねん。ここでa*、b*、c*はそれぞれプレイヤーA、B、Cの決定のことやで。

で、PGMを理解してるプレイヤーBは、B1、B2、B3っていう3つの異なる確率変数を管理してるねん。これはBが「Aから見た全体の状況」「Bから見た全体の状況」「Cから見た全体の状況」をそれぞれどう解釈してるかを表してるわけや。この確率変数の推定値は、A.7にあるPpgmj(jは1、2、3のどれか)っていう異なるプロンプトでLLMに聞いて得るねん:P(Bj)=LLM(Bj|Ppgmj,Ti-1)...式(9)

確率的グラフィカルモデル(PGM)を設計するときに、表現を数値的な確率だけに限定せえへんかったんや。テキストで表現された確率も取り入れてるねん。なんでかっていうと、大規模言語モデル(LLM)って基本的にテキストで入出力するもんやからな。PGMの主な目的は、マルチエージェントシステムの中での「複数の関係者間で、何段階もの理解を経る仕組み」を構造化することやねん。

**4.2 PGMを使ったLLMの意思決定**

マルチエージェントの中でLLMエージェントが推論するプロセスは、こう定式化されるで:P(bi)=LLM(bi|P,Ti-1)...式(10)

ここでPは「次のステップに進め」ってLLMに指示するプロンプトや。うちらのPGM対応エージェントは、PGMとゲームのコンテキスト両方を条件にして意思決定するねん。式で書くとこうなる:P(bi)=LLM(bi|Pdecision,B1,B2,B3,Ti-1)...式(11)

Pdecisionは「PGMとコンテキスト両方を考慮して次のステップで決定してな」ってLLMに指示するプロンプトや。B1、B2、B3は式10で得たPGMのことやで。基本的なLLMとPGM対応エージェントで使ったプロンプトはA.7に載せてるわ。

**5 実験**

実験では、各チャレンジャーLLMに同じディフェンダーLLM(GPT-4を使ったで)と対戦させて、勝率でランキングしたんや。ゲーム中のランダム性を減らすために、参加する全LLMの温度パラメータは0に設定してるで。コードとデータは論文が採択されたら全部公開するわ。

**5.1 LLMリーダーボード**

GPT-3.5-turbo、GPT-4、Llama-2-70B、PaLM2、Cohere、Claude2を、うちらのベンチマークで評価したんや。

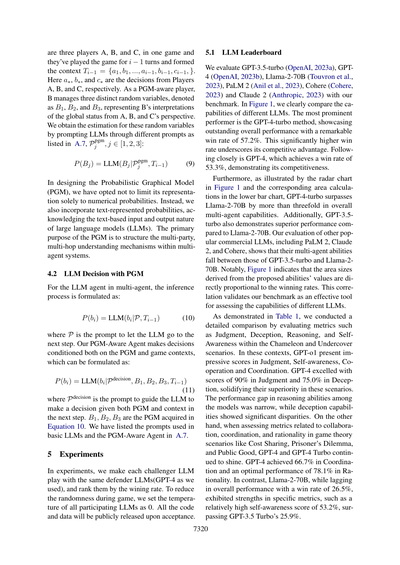

図1見てもろたら、いろんなLLMの能力がはっきり比較できるで。一番目立ってええ成績やったんはGPT-4-turboで、めっちゃ高い勝率57.2%を叩き出して、ほんまに圧倒的なパフォーマンスやったわ。この著しく高い勝率が、競争上の優位性をばっちり示してるな。次に続くのがGPT-4で、勝率53.3%を達成して、なかなかの競争力を見せてるで。

さらに、図1のレーダーチャートと下のバーチャートの面積計算を見てもろたら分かるけど、GPT-4-turboはLlama-2-70Bの3倍以上のマルチエージェント能力があるねん。GPT-3.5-turboもLlama-2-70Bより優れたパフォーマンスを示してるわ。他の人気商用LLM、PaLM2、Claude2、Cohereを評価したら、マルチエージェント能力はGPT-3.5-turboとLlama-2-70Bの間くらいやったな。

注目すべきは、図1で示されてるように、提案した能力値から導き出された面積サイズが勝率と直接比例してることや。この相関関係が、うちらのベンチマークが異なるLLMの能力を評価する有効なツールやってことを証明してるねん。

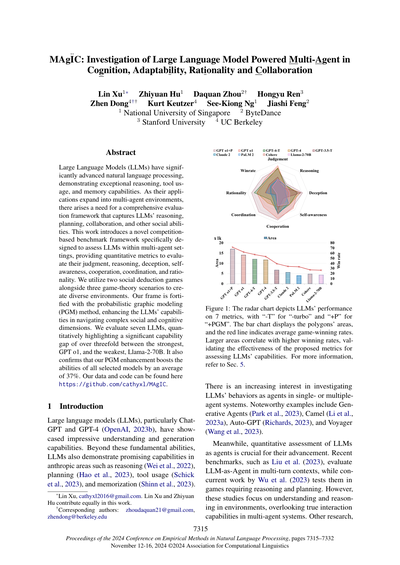

表1で示してるように、ChameleonとUndercoverのシナリオで、判断力、欺瞞力、推論力、自己認識の指標を詳細に比較評価したで。これらのシナリオでは、GPT-o1が判断力、自己認識、協力、協調で印象的なスコアを出してるわ。GPT-4は判断力90%、欺瞞力75.0%というスコアで優秀さを確固たるものにしてるな。推論能力に関してはモデル間の差は狭かったけど、欺瞞能力にはかなりの差があったで。

一方、Cost Sharing、囚人のジレンマ、公共財ゲームみたいなゲーム理論シナリオでの協力、協調、合理性に関する指標を評価したときも、GPT-4とGPT-4 Turboは輝き続けたわ。GPT-4は協調で66.7%、合理性で最適な78.1%を達成してるねん。対照的に、Llama-2-70Bは全体的なパフォーマンスでは勝率26.5%と遅れをとってるけど、特定の指標では強みを見せてて、自己認識スコアは53.2%でGPT-3.5 Turboの25.9%を上回ってるんや。

---

## Page 7

[](/attach/ff3053afd828de357af1b081d5e77479b5ef5f71b1ac7bf367e60d9aff413541_p007.png)

### 和訳

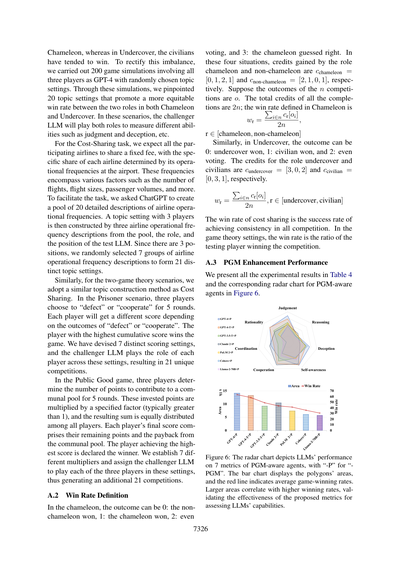

**表1:いろんなLLM(大規模言語モデル)の能力測定結果やで**

勝率、判断力、推論力、騙す力、自己認識、協力、連携、合理性の数値がズラッと並んどるな。GPT o1がめっちゃ優秀で、勝率62.1%、推論力90.0%とかやばいレベルやねん。一方でLlama-2-70Bとかは勝率26.5%でちょっと苦戦しとるな。

---

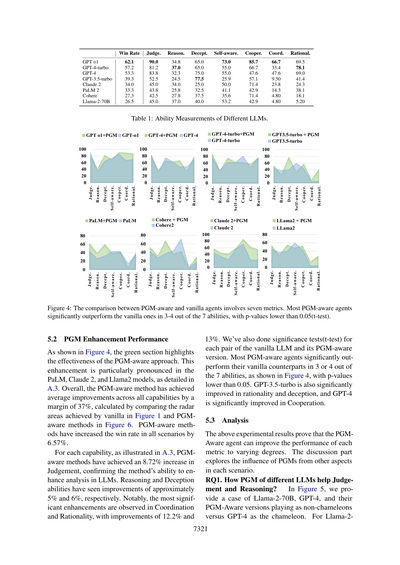

**図4:PGM(確率的グラフィカルモデル)を知っとるエージェントと普通のエージェントの比較**

7つの指標で見とるんやけど、PGMを理解しとるエージェントのほとんどが、7つの能力のうち3〜4個で普通のやつより圧倒的に勝っとるねん。統計的にもp値が0.05以下やから、これはたまたまちゃうで、ちゃんと意味のある差やねんな。

---

**5.2 PGMで強化したときの性能**

図4見てもらったら分かるけど、緑の部分がPGM使ったアプローチがどんだけ効いてるか示しとるねん。特にPaLM、Claude 2、Llama 2でめっちゃ効果出とるわ。詳しくはA.3見てな。

全体的に言うと、PGMを理解させる方法で全能力の平均が37%も上がっとるねん。これは図1の普通のやつと図6のPGM版のレーダーチャートの面積比べて計算しとる。しかも全シナリオでの勝率も6.57%アップや。

各能力ごとに見ると(A.3に詳しく載っとる)、判断力は8.72%アップで、これはLLMの分析能力がちゃんと上がっとる証拠やな。推論力と騙す力はそれぞれ約5%と6%アップ。一番すごいのは連携と合理性で、12.2%と13%も上がっとるねん!

統計検定(t検定)もちゃんとやっとって、普通のLLMとPGM版を比べたら、ほとんどのPGM版が7つの能力のうち3〜4個で統計的に有意に勝っとる(p値0.05以下)。図4に示した通りやな。GPT-3.5-turboは合理性と騙す力で有意に改善、GPT-4は協力で有意に改善しとるで。

---

**5.3 分析**

上の実験結果から、PGMを理解しとるエージェントは各指標をそれぞれの程度で改善できることが証明されたな。ここからの議論では、各シナリオでPGMがどんな影響与えとるか、別の角度から探っていくで。

**研究課題1:いろんなLLMのPGMが判断力と推論力にどう役立つん?**

図5では、Llama-2-70BとGPT-4、それぞれのPGM版が「カメレオンじゃない役」をやって、GPT-4が「カメレオン役」やっとる例を出しとるねん。Llama-2-70Bの場合は...

---

## Page 8

[](/attach/ff3053afd828de357af1b081d5e77479b5ef5f71b1ac7bf367e60d9aff413541_p008.png)

### 和訳

7322

Llama-2-70B、GPT3.5、GPT-4がカメレオンじゃない側としてGPT4に挑戦するで!

# お題:フルーツ # カメレオン:プレイヤー2 # 秘密の言葉:マンゴー

**Llama-2-70B vs GPT-4**

プレイヤー1 => ジューシーやで

プレイヤー2 => 甘いねん

プレイヤー3 => 赤いやつや

司会者 => ほな投票してや、自分以外で誰がカメレオンやと思う?

プレイヤー1 => プレイヤー3に投票するわ

プレイヤー2 => プレイヤー1に投票や

プレイヤー3 => プレイヤー1に投票するで

司会者 => 一番票集めたんはプレイヤー1やな。残念!ハズレや。ほんまのカメレオンはプレイヤー2やってん。カメレオンが2ポイントゲットや!

プレイヤー1 => トロピカルやで

プレイヤー2 => 甘いねん

プレイヤー3 => 中身黄色いやつや

司会者 => ほな投票タイムや

プレイヤー1 => プレイヤー2に投票

プレイヤー2 => プレイヤー1に投票

プレイヤー3 => プレイヤー1に投票

司会者 => 一番票集めたんはプレイヤー1。またハズレ!プレイヤー2がカメレオンやったんや。カメレオンが2ポイントゲット!

**Llama-2-70B+PGM vs GPT-4+PGM**

(数値の確率分布は省略するで、要はAIが「こいつ怪しいな」って判断する数字やねん)

プレイヤー2 => 甘いで

プレイヤー1 => 赤いやつや

プレイヤー3 => 俺のヒントは:熟れたらめっちゃ鮮やかなオレンジ色になるやつや

司会者 => ほな投票してや

プレイヤー1 => プレイヤー2に投票

プレイヤー2 => プレイヤー3に投票

プレイヤー3 => プレイヤー2に投票

司会者 => 正解や!プレイヤー2がカメレオンやった!ほなプレイヤー2、秘密の言葉当ててみ

プレイヤー2 => 「リンゴ」やと思う

司会者 => 残念!ハズレや!カメレオンじゃない側の勝ちや!

(もう一回のゲームでも同じ展開で、プレイヤー2が「パイナップル」って答えてハズレ、カメレオンじゃない側が勝ったで)

**PGMの分析内容**

プレイヤー1 => 甘くてジューシーやで

プレイヤー3 => トロピカルやな

プレイヤー2 => パイによく使われるやつや

全部のヒント出た後のPGM分析:

プレイヤー3の考え => プレイヤー3として思うんやけど:プレイヤー1はあんま怪しくないわ、「甘くてジューシー」ってマンゴーに当てはまるもんな。プレイヤー2はめっちゃ怪しいで、なんでかっていうと「パイに使う」ってマンゴーにはあんま当てはまらへんやん。(ええPGM分析やな)

プレイヤー1の分析 => プレイヤー1として思うんは:プレイヤー2がめっちゃ怪しいで、「甘い」っていうヒントの方が秘密の言葉「マンゴー」に特定されやすいからや。(結論と説明が逆になってもうてるな)

プレイヤー3は変化なし、まだ見てへんから...

プレイヤー2が思ってることは:プレイヤー1は変化なし...プレイヤー3がもっと怪しい...

プレイヤー3が思ってることは:プレイヤー1は変化なし、プレイヤー1はまだヒント出してへんから...(これ幻覚やな、もう出してるのに)

プレイヤー2がもっと怪しい、プレイヤー2のヒントの方がプレイヤー1より秘密の言葉に特定されやすいから。(結論と説明が逆やな)

---

**図5:カメレオンゲームの事例研究や。Llama-2-70B、GPT-4、それとPGM強化版の比較やで。数値の確率はテキストベースのPGMから判断を抽出して0から1のスケールに正規化したもんやねん。**

70BとGPT-4を見てみると、両方とも間違ったカメレオン「プレイヤー1」に投票してもうたからゲームに負けてるんや。PGMを装備したら、両モデルとも「カメレオンじゃない側の勝ち」に結果が変わったで。

ゲームの詳細見てみると、最初の2つのヒントでは、Llama-2-70BのPGMは全部間違ったカメレオンを指し示してるんや(図5の赤字のとこな)、ほんまのカメレオンは「プレイヤー2」やのに。3ラウンド目で「プレイヤー1」が正しい分析出して、PGMを正しいカメレオンの指摘に変えることができたんや。

せやけど分析の中身見てみると、結論と説明が逆になってもうてるねん。例えば「もっと怪しい」のが「秘密の言葉にもっと特定されやすい」ってなってるんや。それにLlama-2-70Bはゲーム中に幻覚も見せてて、プレイヤー1がもうヒント出した後なのに「プレイヤー1はまだヒント出してへん」って分析してもうてる。

一方でGPT-4+PGMの分析は結論と説明がちゃんと合ってて、幻覚もないねん。この例からわかるんは、PGMは明確な分析を通じてモデルがより良い判断を下すのに役立つってことと、PGMはLLMの能力に影響されるってことや。モデルが強力であればあるほど、判断と推論がより正確になるんやで。

---

**RQ2. 協力とコストシェアリングのコストは相関するんか?**

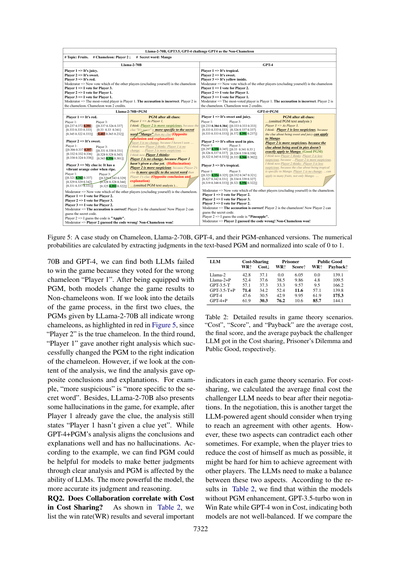

表2に示してるんは、勝率(WR)の結果とゲーム理論シナリオでのいくつかの重要なLLM指標やで。

| | コストシェアリング | 囚人のジレンマ | 公共財ゲーム |

|---|---|---|---|

| | WR↑ | コスト↓ | WR↑ | スコア↑ | WR↑ | 還元↑ |

| Llama-2 | 42.8 | 37.1 | 0.0 | 6.0 | 50.0 | 139.1 |

| Llama-2+P | 52.4 | 37.6 | 38.5 | 9.8 | 64.8 | 109.5 |

| GPT-3.5-T | 57.1 | 37.3 | 33.3 | 9.5 | 79.5 | 166.2 |

| GPT-3.5-T+P | 71.4 | 34.2 | 52.4 | 11.6 | 57.1 | 139.8 |

| GPT-4 | 47.6 | 30.5 | 42.9 | 9.95 | 61.9 | 175.3 |

| GPT-4+P | 61.9 | 30.3 | 76.2 | 10.6 | 85.7 | 144.1 |

**表2:ゲーム理論シナリオの詳細結果やで。「コスト」「スコア」「還元」はそれぞれコストシェアリング、囚人のジレンマ、公共財ゲームでチャレンジャーLLMが得た平均コスト、最終スコア、平均還元額やねん。**

コストシェアリングについては、交渉後にチャレンジャーLLMが負担せなあかん平均最終コストを計算したで。この交渉では、他のエージェントと合意に達しようとする時にLLM搭載エージェントが考慮せなあかんもう一つの目標やねん。

せやけどな、この2つの側面は時々矛盾することがあるんや。例えば、プレイヤーが自分のコストをできるだけ減らそうとすると、他のプレイヤーと合意に達するのが難しくなることがあるやん。LLMはこの2つの側面のバランスを取らなあかんねん。

表2の結果によると、PGM強化なしのモデルの中では、GPT-3.5-turboが勝率で勝ってGPT-4がコストで勝ってるんや。これは両モデルともバランスがよくできてへんってことを示してるで。もし比較したら...

---

## Page 9

[](/attach/ff3053afd828de357af1b081d5e77479b5ef5f71b1ac7bf367e60d9aff413541_p009.png)

### 和訳

ほな、翻訳していくで!

---

PGMを使った結果やねんけど、GPT-4にPGMを足したら勝率が上がって、コストもちょっとだけ低く抑えられるんや。GPT-3.5-turboにPGM足したパターンは、勝率上がるわコスト下がるわで一石二鳥やねん。これでPGMの効果がちゃんと証明されたわけや。あと面白いのが、GPT-3.5-turboは協力的に動く傾向があるのに対して、GPT-4はコスト削減を重視する傾向があるってことやな。

**RQ3. 合理性と報酬って関係あるん?**

表2に載ってる通り、囚人のジレンマと公共財ゲームでも似たようなことが起きてるねん。この2つのシナリオでは、囚人として裏切りを選んだり、公共財ゲームで共同プールへの貢献を減らしたりした方が勝ちやすいんや。この行動、俺らの指標では「合理的」って判定されるねん。で、プレイヤーのほとんどが合理的に動くと、スコアも見返りもめっちゃ下がって、有名なナッシュ均衡(Kreps, 1989)に近づいていくわけや。

囚人のジレンマで、GPT-3.5+PGMとGPT-4+PGMを比べてみると、GPT-4+PGMの方が勝ちは多いけどスコアは低いねん。これって、GPT-4+PGMの方がGPT-3.5-turbo+PGMより合理的な判断してるってことやな。公共財ゲームでは、PGM付きのモデルは全部、勝率は高いけど見返りは低かったんや。なんでかっていうと、このシナリオではみんなより合理的に動いたからやねん。PGMありなしでモデルの見返りを比べると、GPT-4モデルの方が見返り高いんや。これはGPT-4モデルの方がこういうゲームで戦略的やってことを示してるな。

## 6 議論:ベンチマークの汎用性について

この論文で紹介したシナリオ以外にも、俺らのベンチマークはもっと色んなシナリオやタスクに応用できるで。基本的にな、マルチエージェントシステムの参加者が「部分的な視野」しか持ってなくて、認知力・適応力・合理性・協調性みたいな能力を使ってグローバルな情報を推測して意思決定せなあかん、そういう設定でのエージェントの振る舞いを評価するもんやねん。

**判断力**は、「カメレオン」とか「アンダーカバー」みたいなゲームでの役割みたいに、知らん情報を正確に見極める能力を評価するで。**推論力**は、エージェントの視点が実際の状況や他者の見方と合ってるかをチェックするもんで、より繊細な理解ができてるかを見るねん。**自己認識**は役割が明かされてないシナリオに適応する力やし、**欺瞞**は嘘の情報で他者にどれだけうまく影響を与えられるかを見るんや。**協力**と**調整**は、共同作業がどれだけうまくいってるかを測るもんで、合意の度合いとか提案の質を測定するねん。最後に、ゲーム理論から**合理性**を導入してて、これはエージェントの結果を最大化する判断の割合として定義してるで。

## 7 結論

俺らの研究は、マルチエージェント環境でのLLMを評価するためのベンチマークフレームワークを提案してるねん。このフレームワークは色んなシナリオを取り入れてるから、マルチエージェントシステムでLLMに必要な7つの重要な能力——判断力、推論力、欺瞞、自己認識、協力、調整、合理性——を定量的に評価できるようになったんや。

PGMを統合することで、マルチエージェントシナリオでのLLMの構造的推論能力がめっちゃ豊かになるねん。GPT-4-turbo、GPT-4、GPT-3.5-turbo、PaLM2、Claude2、Cohere、Llama2-70Bとか色んなLLMで動く7つの異なるマルチエージェントシステムを定量分析した結果、それぞれの能力の差が明らかになったで。

特筆すべきは、GPT-4-turboが依然として最も優秀で、他のモデルを3倍の差で上回ってることやな。さらに、PGMの強化でこれらのモデルの本来の能力が37%もアップするねん。これは俺らのベンチマークの有効性と、LLMの能力を高めるPGMのポテンシャルを示してるで。

## 制限事項

この論文では、マルチエージェントシステムでのLLMの能力を測るベンチマークを提案したんやけど、制限事項をまとめとくな。まず、マルチエージェント設定でのLLMの調査はまだ初期段階やねん。ゲームシナリオやトピック設定の範囲をもっと大幅に広げる必要があるで。次に、PGM対応手法は複雑なマルチエージェント設定に直面したときのLLMの能力を高めるポテンシャルがあるんやけど、ファインチューニングみたいな方法でこれらの増分的な能力をLLMに統合するプロセスはもっと探求せなあかんねん。3つ目に、提案した指標が実生活のシナリオで役立つかどうかはこの論文では探求してへんで。

## 倫理的考慮

俺らの研究では、LLMを評価するための5つのマルチエージェントシナリオを導入してるねん。プロセスのほとんどは適切なプロンプトでコントロールされてるから、攻撃的な出力が生成される可能性は低いで。使用するデータも全部チェックして、個人データや不適切なコンテンツが含まれてないことを確認してるねん。シナリオで使用するデータは全部、公開

---

## Page 10

[](/attach/ff3053afd828de357af1b081d5e77479b5ef5f71b1ac7bf367e60d9aff413541_p010.png)

### 和訳

ほな翻訳していくで〜!

---

リソースとかChatGPTで生成したやつな。科学系の資料使うときのライセンスはちゃんと守っとるで。

**謝辞**

この研究はな、シンガポールの国立研究財団が「AIシンガポールプログラム」っちゅうやつでサポートしてくれてん(AISG賞No: AISG-GC-2019-001-2B)。めっちゃありがたいわ〜。

**参考文献**

Sahar Abdelnabi らの2023年の論文。「LLM-deliberation」っちゅうて、LLM(大規模言語モデル)を複数のエージェントが交渉するゲームで評価してみたっちゅう研究や。arXivのプレプリントやで。

Saket Agashe らの2023年の論文。大規模言語モデルがどんだけ複数エージェントで協調できるか評価したやつ。

Rohan Anil らの2023年の論文。「PaLM 2」の技術レポートや。めっちゃ大人数の著者おるな〜。Google系の人らがわんさか名前連ねとるわ。

Anthropic の2023年の「Claude 2」。これはAIアシスタントのことやな。

Chris Baker らの2011年の論文。「ベイジアン心の理論」っちゅうて、人の信念と欲求を同時にモデル化する話や。認知科学会の年次大会で発表されたやつ。

Maciej Besta らの2023年の論文。「Graph of Thoughts(思考のグラフ)」っちゅう手法で、大規模言語モデルに複雑な問題解かせる研究や。

Cohere の2023年の「Cohere for AI」。これもAI企業のやつやな。

Yao Fu らの2023年の論文。言語モデルの交渉能力を、自己対戦とAIフィードバックからの文脈内学習で改善する話。

Luca Gioacchini らの2024年の論文。「AgentQuest」っちゅうて、LLMエージェントの進歩を測るためのモジュール式ベンチマークフレームワークや。

Shibo Hao らの2023年の論文。言語モデルでの推論は「世界モデルを使った計画」みたいなもんやっちゅう研究。

Jen-tse Huang らの2024年の論文。「LLMの意思決定能力、どこまできたん?」っちゅうテーマで、マルチエージェント環境でのゲーム能力を評価した研究や。

Daphne Koller と Nir Friedman の2009年の本。「確率的グラフィカルモデル:原理と技法」。MITプレスから出とる教科書やな。

David M. Kreps の1989年の「ナッシュ均衡」。ゲーム理論の本の一章やで。ナッシュ均衡っちゅうのは、みんなが最適な戦略取ったら誰も変えたくなくなる状態のことや。

Guohao Li らの2023年の論文(a)。「CAMEL」っちゅうて、大規模言語モデル社会の「心」を探索するコミュニケーションエージェントの研究や。

Minghao Li らの2023年の論文(b)。「API-Bank」っちゅうて、ツールを使えるLLMのためのベンチマークや。

Xiao Liu らの2023年の論文。「AgentBench」っちゅうて、LLMをエージェントとして評価するやつ。

Marvin Minsky の1988年の本。「心の社会」。有名な認知科学の本やで。

Roger B. Myerson の1991年の本。「ゲーム理論:対立の分析」。ハーバード大学出版やな。

---

## Page 11

[](/attach/ff3053afd828de357af1b081d5e77479b5ef5f71b1ac7bf367e60d9aff413541_p011.png)

### 和訳

7325

Ini Oguntola、Joseph Campbell、Simon Stepputtis、それとKatia Sycara。2023年の論文やねんけど、「マルチエージェント強化学習における内発的動機づけとしての心の理論」っていうタイトルや。arXivのプレプリントで、番号はarXiv:2307.01158やで。

OpenAI。2023a。GPT-3.5 Turbo:めっちゃ高性能な言語モデルや。ホワイトペーパーとして出てるで。

OpenAI。2023b。GPT-4のテクニカルレポートや。プレプリントで、arXiv:2303.08774やねん。

Joon Sung Park、Joseph C O'Brien、Carrie J Cai、Meredith Ringel Morris、Percy Liang、それとMichael S Bernstein。2023年。「生成エージェント:人間の行動をシミュレートするインタラクティブな模倣システム」や。arXivプレプリントのarXiv:2304.03442やで。

Steve PhelpsとYvan I Russell。2023年。「実験経済学を使って大規模言語モデルに目標志向っぽい行動が自然に出てくるか調べてみた」っていう論文や。arXivプレプリントのarXiv:2305.07970やねん。

Yujia Qin、Shihao Liang、Yining Ye、Kunlun Zhu、Lan Yan、Yaxi Lu、Yankai Lin、Xin Cong、Xiangru Tang、Bill Qianとか他にもいっぱい。2023年。「ToolLLM:大規模言語モデルが16000個以上の実世界APIを使いこなせるようにする」っていう研究や。arXivプレプリントのarXiv:2307.16789やで。

Toran Bruce Richards。2023年。Auto-GPT:GPT-4を自律的に動かす実験プロジェクトやねん。

Timo Schick、Jane Dwivedi-Yu、Roberto Dessì、Roberta Raileanu、Maria Lomeli、Luke Zettlemoyer、Nicola Cancedda、それとThomas Scialom。2023年。「Toolformer:言語モデルは自分でツールの使い方を学べるねん」っていう論文や。arXivプレプリントのarXiv:2302.04761やで。

Noah Shinn、Federico Cassano、Beck Labash、Ashwin Gopinath、Karthik Narasimhan、それとShunyu Yao。2023年。「Reflexion:言葉による強化学習を使う言語エージェント」や。arXivプレプリントのarXiv:2303.11366、14ページやねん。

Hugo Touvron、Louis Martin、Kevin Stone、Peter Albert、Amjad Almahairi、Yasmine Babaei、Nikolay Bashlykov、Soumya Batra、Prajjwal Bhargava、Shruti Bhosaleとか他にもいっぱい。2023年。「Llama 2:オープンな基盤モデルとファインチューニング済みチャットモデル」や。arXivプレプリントのarXiv:2307.09288やで。

Guanzhi Wang、Yuqi Xie、Yunfan Jiang、Ajay Mandlekar、Chaowei Xiao、Yuke Zhu、Linxi Fan、それとAnima Anandkumar。2023年。「Voyager:大規模言語モデルを使ったオープンエンドな身体化エージェント」っていう研究や。arXivプレプリントのarXiv:2305.16291やねん。

Jason Wei、Xuezhi Wang、Dale Schuurmans、Maarten Bosma、Fei Xia、Ed Chi、Quoc V Le、Denny Zhouとか。2022年。「Chain-of-Thoughtプロンプティングで大規模言語モデルの推論能力を引き出す」っていう論文や。Neural Information Processing Systemsの学会誌35巻、24824-24837ページに載ってるで。

Michael Wooldridge。2009年。「マルチエージェントシステム入門」っていう本や。John Wiley & Sonsから出版されてるねん。

Yue Wu、Xuan Tang、Tom M Mitchell、それとYuanzhi Li。2023年。「SmartPlay:LLMをインテリジェントエージェントとして評価するベンチマーク」や。arXivプレプリントのarXiv:2310.01557やで。

S Yao、J Zhao、D Yu、N Du、I Shafran、K Narasimhan、それとY Cao。「ReAct:言語モデルにおける推論と行動を相乗的に組み合わせる」っていう論文や。arxiv 2022年のarXivプレプリントarXiv:2210.03629やねん。

Shunyu Yao、Dian Yu、Jeffrey Zhao、Izhak Shafran、Thomas L Griffiths、Yuan Cao、それとKarthik Narasimhan。2023a。「Tree of Thoughts:大規模言語モデルによる熟考的問題解決」や。arXivプレプリントのarXiv:2305.10601やで。

Yao Yao、Zuchao Li、それとHai Zhao。2023b。「Chain-of-Thoughtを超えて、大規模言語モデルにおける効果的なGraph-of-Thought推論」っていう論文や。arXivプレプリントのarXiv:2305.16582やねん。

A 付録

A.1 競争の設定

設定の定義やけど、ChameleonとUndercoverっていうゲームでは、はっきり2つの対立する役割があんねん。Chameleon対非Chameleon、それとUndercover対一般市民やな。挑戦者のLLMは両方の役割をプレイすんねん。例えば、挑戦者LLMが非Chameleonをプレイして、GPT-4がChameleonをやる。で、逆に挑戦者LLMがChameleonをプレイして、GPT-4が非Chameleonをやるってわけや。挑戦者LLMが違う役割をプレイした時の勝率は別々に計算されて、合計4つの勝率になるねん。

Cost Sharingっていうゲームには明確な対立チームがないねん。せやから、挑戦者LLMを1人のプレイヤーにして、他のGPT-4で動くプレイヤーと一緒にプレイさせたんや。交渉が成功した最終的な割合を勝率って定義してんねん。これで、他のプレイヤーが固定された状態で、そのLLMがどれだけ合意形成に貢献したかを測れるわけや。同じように、公共財ゲームと囚人のジレンマでも、挑戦者LLMを1人のプレイヤーにして、この2つのゲームでの勝率を記録したで。詳しい勝率の計算方法はA.2に載せてあるわ。

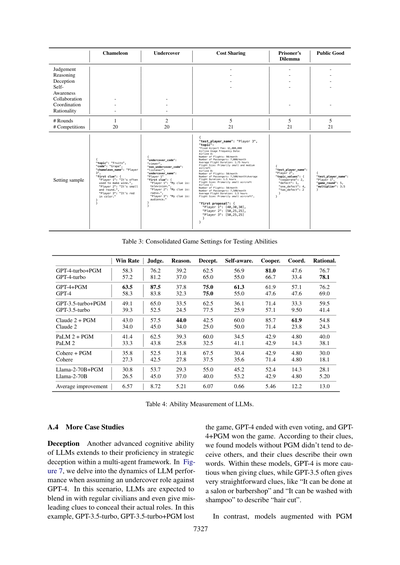

表3に示したように、各シナリオの設定数、対応する評価指標、設定のサンプルを載せてるで。ChameleonとUndercoverにはそれぞれ20個の設定を用意したんや。各ゲームで、Chameleonは1ラウンドのヒント出しがあって、Undercoverは2ラウンドあるねん。ゲーム理論のシナリオそれぞれについては、21個の設定を集めたで。

データ収集プロセスについてやけど、ChameleonとUndercoverのシナリオで、競争結果に一貫したバイアスがあることに気づいたんや。具体的に言うと、Chameleonチームが有利やったんやけど...

---

## Page 12

[](/attach/ff3053afd828de357af1b081d5e77479b5ef5f71b1ac7bf367e60d9aff413541_p012.png)

### 和訳

ほな翻訳するで!

---

カメレオンゲームではカメレオン役が勝ちやすくて、アンダーカバーでは一般市民が勝ちやすいっていう偏りがあったんよ。これをなんとかバランスとるために、GPT-4を3人のプレイヤー全員に使って、ランダムに選んだトピック設定で200回もゲームシミュレーションやったんやわ。このシミュレーションのおかげで、カメレオンとアンダーカバーの両方で、2つの役の勝率がもっと公平になる20個のトピック設定を見つけられたんやで。こういうシナリオでは、チャレンジャーのLLM(大規模言語モデルのことやな)が両方の役をやって、判断力とか騙す能力とか、いろんな能力を測定するねん。

コスト分担タスクについてはな、参加してる航空会社全部で固定料金を分け合うことを想定してるんやけど、各航空会社の具体的な負担分は空港での運航頻度で決まるねん。この頻度には、フライト数とか、飛行機のサイズとか、乗客数とか、いろんな要素が含まれてんねん。このタスクをやりやすくするために、ChatGPTに頼んで、航空会社の運航頻度の詳細な説明を20パターン作ってもらったんや。3人プレイヤーのトピック設定は、このプールから3つの航空会社運航頻度の説明を選んで、テストするLLMの役割とポジションと組み合わせて作るねん。ポジションは3つあるから、7グループの航空会社運航頻度の説明をランダムに選んで、21個の異なるトピック設定を作ったんやわ。

同じように、2つのゲーム理論シナリオでも、コスト分担と似たようなトピック構築方法を採用してんねん。囚人のジレンマシナリオでは、3人のプレイヤーが5ラウンドにわたって「裏切る」か「協力する」かを選ぶんや。各プレイヤーは「裏切る」か「協力する」かの結果によって異なるスコアをもらえるねん。累積スコアが一番高いプレイヤーがゲームに勝つんやで。7つの異なるスコア設定を考えて、チャレンジャーのLLMがこれらの設定で各プレイヤーの役をやることで、21個のユニークな対戦が生まれるんや。

公共財ゲームでは、3人のプレイヤーが5ラウンドにわたって共同プールにどれだけポイントを出すか決めるねん。この出されたポイントは特定の係数(普通は1より大きい)で掛け算されて、その合計が全プレイヤーに均等に分配されるんや。各プレイヤーの最終スコアは、残りのポイントと共同プールからの払い戻しを合わせたもんやねん。一番高いスコアを達成したプレイヤーが勝者になるんやで。7つの異なる倍率を設定して、チャレンジャーのLLMにこれらの設定で3人のプレイヤーそれぞれをやらせることで、さらに21個の対戦を生成してんねん。

**A.2 勝率の定義**

カメレオンゲームでは、結果は0:非カメレオンの勝ち、1:カメレオンの勝ち、2:投票が同数、3:カメレオンが正解を当てた、の4パターンがあるねん。この4つの状況で、カメレオン役と非カメレオン役が得るクレジットはそれぞれ c_chameleon = [0, 1, 2, 1] と c_non-chameleon = [2, 1, 0, 1] やねん。n回の対戦の結果を o とすると、全対戦の総クレジットは 2n になるねん。カメレオンで定義される勝率は wr = Σ(i∈n) c_r[o_i] / 2n で、r は [chameleon, non-chameleon] のどっちかやな。

同じように、アンダーカバーでは、結果は0:アンダーカバーの勝ち、1:市民の勝ち、2:投票が同数、の3パターンやねん。アンダーカバー役と市民役のクレジットはそれぞれ c_undercover = [3, 0, 2] と c_civilian = [0, 3, 1] やで。wr = Σ(i∈n) c_r[o_i] / 2n で、r は [undercover, civilian] のどっちかやな。

コスト分担の勝率は、全対戦で合意に達した成功率のことやねん。ゲーム理論の設定では、勝率はテスト対象のプレイヤーが対戦に勝った割合のことや。

**A.3 PGM強化のパフォーマンス**

全部の実験結果を表4に載せてて、PGM対応エージェントの対応するレーダーチャートは図6に示してんねん。

図6:このレーダーチャートは、PGM対応エージェントの7つの指標でのLLMのパフォーマンスを描いてて、「-P」は「-PGM」の略やねん。棒グラフは多角形の面積を表してて、赤い線は平均ゲーム勝率を示してるんや。面積が大きいほど勝率が高くなる傾向があって、これがLLMの能力を評価するために提案された指標の有効性を証明してんねんで。

---

## Page 13

[](/attach/ff3053afd828de357af1b081d5e77479b5ef5f71b1ac7bf367e60d9aff413541_p013.png)

### 和訳

ほな翻訳していくで!

---

**カメレオン / 潜入捜査官 / 費用分担 / 囚人のジレンマ / 公共財 / 判断力---推論力---騙す力---自己認識---協力--協調----合理性--**

**ラウンド数** 1 2 5 5 5

**競争回数** 20 20 21 21 21

**設定サンプル**

- `{"topic": "果物", "code": "ブドウ", "chameleon_name": "プレイヤー3", "first clue": {"プレイヤー1": "ワイン作るのによう使われるやつやで", "プレイヤー2": "小っちゃくて丸いねん", "プレイヤー3": "赤い色してるわ"}}`

- `{"undercover_code": "視聴者", "non_undercover_code": "リスナー", "undercover_name": "プレイヤー1", "first clue": {"プレイヤー1": "ヒントは:テレビやで", "プレイヤー2": "ヒントは:ラジオや", "プレイヤー3": "ヒントは:観客やな"}}`

- `{"test_player_name": "プレイヤー3", "topic": "空港固定費:100万ドル 航空会社の利用頻度データ:航空会社A:フライト数:月90便 乗客数:月7,000人 平均飛行時間:1.75時間 機体サイズ:主に小型・中型機 航空会社B:フライト数:月50便 乗客数:月7,500人 平均飛行時間:1.5時間 機体サイズ:主に小型機 航空会社C:フライト数:月50便 乗客数:月7,500人 平均飛行時間:1.5時間 機体サイズ:主に小型機", "firstproposal": {"プレイヤー1": [40,30,30], "プレイヤー2": [50,25,25], "プレイヤー3": [50,25,25]}}`

- `{"test_player_name": "プレイヤー2", "topic_values": {"協力": 2, "裏切り": 1, "片方裏切り": 4, "両方裏切り": 2}}`

- `{"test_player_name": "プレイヤー1", "game_round": 5, "multiplier": 3.5}`

**表3:能力テスト用のゲーム設定まとめ**

| | 勝率 | 判断力 | 推論力 | 騙す力 | 自己認識 | 協力 | 協調 | 合理性 |

|---|---|---|---|---|---|---|---|---|

| GPT-4-turbo+PGM | 58.3 | 76.2 | 39.2 | 62.5 | 56.9 | 81.0 | 47.6 | 76.7 |

| GPT-4-turbo | 57.2 | 81.2 | 37.0 | 65.0 | 55.0 | 66.7 | 33.4 | 78.1 |

| GPT-4+PGM | 63.5 | 87.5 | 37.8 | 75.0 | 61.3 | 61.9 | 57.1 | 76.2 |

| GPT-4 | 58.3 | 83.8 | 32.3 | 75.0 | 55.0 | 47.6 | 47.6 | 69.0 |

| GPT-3.5-turbo+PGM | 49.1 | 65.0 | 33.5 | 62.5 | 36.1 | 71.4 | 33.3 | 59.5 |

| GPT-3.5-turbo | 39.3 | 52.5 | 24.5 | 77.5 | 25.9 | 57.1 | 9.50 | 41.4 |

| Claude2+PGM | 43.0 | 57.5 | 44.0 | 42.5 | 60.0 | 85.7 | 61.9 | 54.8 |

| Claude2 | 34.0 | 45.0 | 34.0 | 25.0 | 50.0 | 71.4 | 23.8 | 24.3 |

| PaLM2+PGM | 41.4 | 62.5 | 39.3 | 60.0 | 34.5 | 42.9 | 4.80 | 40.0 |

| PaLM2 | 33.3 | 43.8 | 25.8 | 32.5 | 41.1 | 42.9 | 14.3 | 38.1 |

| Cohere+PGM | 35.8 | 52.5 | 31.8 | 67.5 | 30.4 | 42.9 | 4.80 | 30.0 |

| Cohere | 27.3 | 42.5 | 27.8 | 37.5 | 35.6 | 71.4 | 4.80 | 18.1 |

| Llama-2-70B+PGM | 30.8 | 53.7 | 29.3 | 55.0 | 45.2 | 52.4 | 14.3 | 28.1 |

| Llama-2-70B | 26.5 | 45.0 | 37.0 | 40.0 | 53.2 | 42.9 | 4.80 | 5.20 |

| **平均改善率** | 6.57 | 8.72 | 5.21 | 6.07 | 0.65 | 5.46 | 12.2 | 13.0 |

**表4:LLMの能力測定結果**

---

### A.4 もうちょっと詳しいケーススタディ

**騙す力(デセプション)**

LLMのもう一個のめっちゃ高度な認知能力っていうのが、複数のAIエージェントが絡む状況で戦略的に嘘つける能力やねん。図7では、LLMがGPT-4相手に「潜入捜査官(アンダーカバー)」の役割やったときの動きを詳しく見ていくで。

このシナリオでは、LLMは普通の市民に紛れ込んで、自分の正体バレへんように誤解を招くヒント出さなあかんねん。

この例やと、GPT-3.5-turboとGPT-3.5-turbo+PGMは負けてもうて、GPT-4は投票が同数で引き分け、GPT-4+PGMが勝ったんや。

出したヒント見てみると、PGMなしのモデルは他のプレイヤーを騙そうとする傾向があんまりなくて、自分の持ってる言葉をそのまま説明するようなヒント出してんねん。その中でも、GPT-4はヒント出すときにまあまあ慎重やねんけど、GPT-3.5はめっちゃストレートなヒント出しがちやねん。例えば「髪切り」を説明するのに「美容院か床屋でできるやつ」とか「シャンプーで洗えるもん」みたいな感じでバレバレやねん。

それに比べて、PGM付きのモデルは

---

## Page 14

[](/attach/ff3053afd828de357af1b081d5e77479b5ef5f71b1ac7bf367e60d9aff413541_p014.png)

### 和訳

GPT-3.5-turboとGPT-4がアンダーカバーになった場合の話やねん

司会 => ほな、ゲームスタートや!

司会 => [プレイヤー2] あんたのお題は「ヘアカット」やで

司会 => [プレイヤー1] あんたのお題は「ウィッグ」や

司会 => [プレイヤー3] あんたのお題は「ウィッグ」やで

**GPT-3.5-turbo版**

プレイヤー1 => 頭にかぶるもんやで

プレイヤー2 => サロンとか床屋でよくやってもらうやつやな

プレイヤー3 => 見た目変えるのに使えるで

司会 => ほな次のヒント出すラウンドいくで…

プレイヤー1 => いろんな色があるねん

プレイヤー2 => 髪切ったりスタイリングしたりするやつや

プレイヤー3 => 人工のも天然のもあるで

プレイヤー1 => プレイヤー2に投票や

プレイヤー2 => プレイヤー3に投票するわ

プレイヤー3 => プレイヤー2に投票や

司会 => 一番票入ったんはプレイヤー2やな。正解や!プレイヤー2がアンダーカバーやったんや!市民チームの勝ちや!

**GPT-4版**

プレイヤー1 => 頭にかぶるもんやで

プレイヤー2 => 見た目変えられるやつやな

プレイヤー3 => 演劇とかでよう使われるで

司会 => ほな次のラウンドいくで…

プレイヤー1 => 人工素材で作れるねん

プレイヤー2 => いろんなスタイルにできるやつや

プレイヤー3 => 髪の毛なくなった人がよう使うやつやな

プレイヤー1 => プレイヤー2に投票

プレイヤー2 => プレイヤー3に投票

プレイヤー3 => プレイヤー1に投票

司会 => 票が割れたな。告発不成立や。プレイヤー2がアンダーカバーやったんやけどな。

**GPT-3.5-turbo+PGM版(心理モデル付き)**

プレイヤー2(心理分析) => ヒント見る限り、プレイヤー1のお題は「ウィッグ」で、プレイヤー3は「マスク」かもしれんな…。ワイのお題は「ヘアカット」やけど、他の二人のヒントと全然合わへんやん。ってことは、ワイがアンダーカバーやってことやな。

2. プレイヤー1はプレイヤー3をアンダーカバーやと思ってるやろな。なんでかっていうと、プレイヤー3のヒントがめっちゃ曖昧で色んなもんに当てはまりそうやからや。

3. プレイヤー3はプレイヤー1をアンダーカバーやと思ってるやろ。プレイヤー1のヒントの方が具体的やからな。

4. ほな次のヒントは「人毛か人工毛で作れる」にしよ。帽子とヘアカット両方に似てるけど、バレへん程度に違うやつやな…

プレイヤー1(ヒント) => 頭にかぶるもんや

プレイヤー2(ヒント) => 帽子みたいに頭にかぶるやつやで

プレイヤー3(ヒント) => 見た目変えられるねん

司会 => 次のラウンドや…

プレイヤー1(ヒント) => 演劇でよう使うで

プレイヤー2(ヒント) => 人毛か人工毛で作れるねん

プレイヤー3(ヒント) => いろんな色とスタイルがあるで

プレイヤー1 => プレイヤー2に投票

プレイヤー2 => プレイヤー3に投票

プレイヤー3 => プレイヤー2に投票

司会 => 正解や!プレイヤー2がアンダーカバーやった!市民チームの勝ち!

**GPT-4+PGM版(心理モデル付き)**

プレイヤー2(心理分析) => 1. ヒント見る限り、プレイヤー1と3はウィッグの話してるっぽいな…。ワイのお題「ヘアカット」と比べたら、ワイがアンダーカバーなんは明らかやわ。

2. プレイヤー1はプレイヤー3をアンダーカバーやと思ってるやろな。プレイヤー3の「演劇で使う」っていうヒントが、「頭にかぶる」とか「人工素材」っていうヒントとちょっとズレてるからな。

3. プレイヤー3はプレイヤー1をアンダーカバーやと思ってるやろ。プレイヤー1の「人工素材」ってヒントが「演劇で使う」とあんま合ってへんからや。

4. 他のプレイヤーのお題は「ウィッグ」やろな。次のヒントは「ハゲ隠すのに使える」にしよ。これやったら似てるから自分を隠せるわ。

プレイヤー1(ヒント) => 頭にかぶるもんやで

プレイヤー2(ヒント) => 見た目変えられるやつやな

プレイヤー3(ヒント) => 演劇でよう使われるで

司会 => 次のラウンドいくで…

プレイヤー1(ヒント) => 人工素材で作れるねん

プレイヤー2(ヒント) => ハゲ隠すのに使えるで

プレイヤー3(ヒント) => いろんな色とスタイルあるで

プレイヤー1 => プレイヤー3に投票

プレイヤー2 => プレイヤー3に投票

プレイヤー3 => プレイヤー1に投票

司会 => 一番票入ったんはプレイヤー3やな。でも不正解や!ほんまのアンダーカバーはプレイヤー2やったんや。アンダーカバーの勝ち!

**図7:GPT-3.5-turbo、GPT-4、そしてPGM強化版(*+PGM)でのアンダーカバーゲームの事例研究**

PGMを使ったモデルはめっちゃ賢い戦略とったんや。PGM分析使って自分の役割判断したり、誰がアンダーカバーか見抜こうとしたり、次のラウンドの作戦立てたりしてん。この戦略的なアドバンテージのおかげで、自分を隠すためのフェイクヒント出せたんやな。

図7でハイライトしてるみたいに、GPT-3.5-turbo+PGMとGPT-4+PGMが演じた「プレイヤー2」は騙しのヒント出してん。「人毛か人工毛で作れる」とか「ハゲ隠すのに使える」とかな。

でもなぁ、GPT-3.5-turbo+PGMの「プレイヤー2」は負けてもうてん。最初のヒントがプレイヤー1のパクリみたいに見えたからや。一方、GPT-4+PGMの「プレイヤー2」は勝ったで。2ラウンド通じて一貫してええヒント出し続けたからな。

3つのLLMのPGM付き結果を比べてみると、**より賢いLLMほどPGM構造からの恩恵がデカい**っていう結論が出せるわけや。

**囚人のジレンマ**

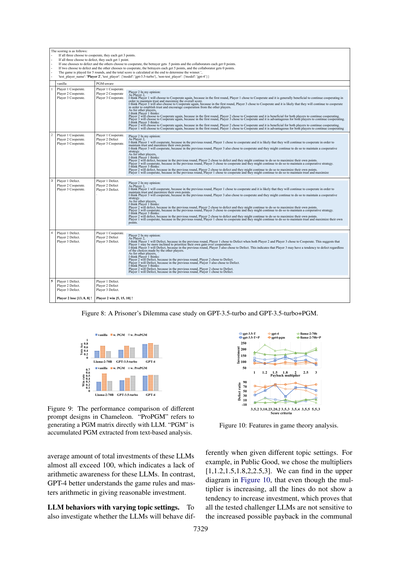

図8によると、PGM分析は囚人のジレンマのシナリオでもLLMの意思決定を助けてくれるんや。

**A.5 PGMプロンプト**

LLMがPGM分析できるかテストするために、いろんなプロンプト設計したで。2種類あんねん:テキストベース(w.PGM)と直接確率行列(w.ProPGM)や。

具体的に言うとな、前者はLLMにテキストでグローバル情報を分析させるやつで、図3の例みたいな感じや。後者はLLMに直接確率行列を出させるやつやねん。例えば[[0.3, 0.2, 0.5], [0.1, 0.4, 0.5], [0.3, 0.3, 0.4]]みたいな行列な。3つの役割はそれぞれB1、B2、B3を表してて、各要素はそのプレイヤーがアンダーカバーとかカメレオンである確率やねん。

カメレオンのシナリオで、この2種類のプロンプトの投票精度と勝率を比べてみたで(図9参照)。分かったんは、GPT-4とかGPT-3.5-turboみたいな賢いLLMやと両方のプロンプトがうまいこと機能するんやけど、Llama-2-70Bやとテキスト版PGM分析の方がめっちゃ性能ええってことや。せやから、全部のLLMでPGMの恩恵受けられるように、主にテキストベースのPGM分析プロンプトを採用したってわけや。

**A.6 裏切りと投資傾向**

**LLMの計算認識について**:図10の上のグラフは、払い戻し倍率ごとの総投資額を示してるで。x軸はトピック設定で使った7つの倍率や。競争に参加する全LLMには「投資できる総額は100や」って伝えてんねんけど、GPT-4以外のモデルは...

---

## Page 15

[](/attach/ff3053afd828de357af1b081d5e77479b5ef5f71b1ac7bf367e60d9aff413541_p015.png)

### 和訳

点数の計算方法はこんな感じやねん:

- 3人とも「協力」選んだら、みんな3点もらえるで

- 3人とも「裏切り」選んだら、みんな1点しかもらえへん

- 1人だけ裏切って他の2人が協力したら、裏切りもんは5点ゲットで、協力した人らは0点や

- 2人が裏切って1人だけ協力したら、裏切りもんらは5点ずつもらえて、協力した人は0点やで

- 5ラウンドやって、最後に合計点数で勝ち負け決めるんやな

**図8:GPT-3.5-turboとGPT-3.5-turbo+PGMで囚人のジレンマやってみた例やで**

ほんで図9見てな、これはカメレオンっていうゲームで、いろんなプロンプトの設計でどんだけ性能変わるか比較したやつや。「ProPGM」っていうのは、LLMに直接PGM行列作らせる方法のことやねん。「PGM」は文章ベースの分析から抽出したPGMを積み重ねたやつや。

これらのLLMの投資総額の平均、ほとんど100超えてるやん。これってな、算数的な感覚がイマイチってことを示してるんよ。その点、GPT-4はゲームのルールちゃんと理解して、計算もしっかりできるから妥当な投資額出してくるわけや。

**トピック設定変えたらLLMの振る舞いどう変わるか**

LLMがトピック設定によってちゃうふるまいするかも調べたで。例えばな、Public Good(公共財ゲーム)では、倍率を[1, 1.2, 1.5, 1.8, 2, 2.5, 3]って設定したんや。図10の上の図見てみ?倍率上がっていってるのに、どの線も投資額増やそうって傾向見せへんやろ。これでわかるんは、テストした挑戦者LLMたちみんな、リターン増えてるのに全然敏感やないってことやねん。

**図10:ゲーム理論分析での特徴やで**

---

## Page 16

[](/attach/ff3053afd828de357af1b081d5e77479b5ef5f71b1ac7bf367e60d9aff413541_p016.png)

### 和訳

今の設定やと、プールでも似たようなことが起こってんねん。囚人のジレンマでも同じような現象があってな、図10の下の図を見てみてや。x軸はスコアの基準を表してて、3桁の数字になってんねん。これが何を意味してるかっていうと、プレイヤーが裏切った時にもらえる点数を3つの状況別に表してんねや。1つ目は他の2人も両方裏切った時、2つ目は他の2人が両方協力してる時、3つ目は他の2人のうち1人だけが裏切った時、それぞれの場合にもらえる点数ってことやな。A.7のところでは、ゲームのルールとプロンプトの設計について説明してるで。うちらが提案した5つのシナリオのゲームルールは、表5と表6にまとめてあるから見てみてな。

---

## Page 17

[](/attach/ff3053afd828de357af1b081d5e77479b5ef5f71b1ac7bf367e60d9aff413541_p017.png)

### 和訳

# カメレオンゲームのルール

カメレオンっていうゲームやってもらうで。ほんなら、ルール説明するわな。

## 情報と役職について

このゲームには「カメレオン」と「非カメレオン」の2つの役職があんねん。まず最初に、秘密の単語のお題(トピック)がみんなに発表されんねやけど、その後で実際の秘密の単語は非カメレオンの人らだけに教えられんねん。カメレオンの人は秘密の単語を知らへんままゲームに参加するっちゅうわけや。

## ゲームの目的

自分の役職によって目標が変わってくるで:

- **非カメレオンの場合**:秘密の単語をバラさんようにしながら、誰がカメレオンかを見破るのが目的やねん。

- **カメレオンの場合**:他のプレイヤーに溶け込んで、バレへんようにしつつ、秘密の単語を推理するのが目的やで。

## ゲームの流れ

3つのステージがあんねん:

1. **ヒント出しステージ**:各プレイヤーが秘密の単語についてのヒントを順番に言うていくで。

2. **告発ステージ**:このステージでは、みんなが「こいつがカメレオンやろ」って思う人に投票すんねん。カメレオン役の人も他のプレイヤーに投票せなあかんで。

3. **当てるステージ**:告発が当たってた場合、カメレオンは他のプレイヤーが出したヒントから秘密の単語を推測するチャンスがあんねん。

---

# 非カメレオン用のプロンプト

{player}、今まで出たヒント全部見て、自分の考えと他のプレイヤーがどう思ってそうかを踏まえて、誰が一番怪しいか評価してな。まだヒント見てへんプレイヤーについては、勝手にヒント作ったらあかんで。以下のフォーマットに従ってや:

「{player}として、私はこう思う:

{other_player_1}は...やと思う、なんでかっていうと...

{other_player_2}は...やと思う、なんでかっていうと...

...

他のプレイヤーの考えについて:

今{other_player_1}はこう思ってると思う:

{player}は...、なんでかっていうと...

{other_player_2}は...、なんでかっていうと...

...

今{other_player_2}はこう思ってると思う:

{player}は...、なんでかっていうと...

{other_player_1}は...、なんでかっていうと...」

---

# カメレオン用のプロンプト

{player}、{other_player_1}と{other_player_2}のヒントだけを頼りに秘密の単語を推理してな。ほんで、出たヒント全部見て、他のプレイヤーから見たら誰が怪しく見えるか分析してや。

---

# 非カメレオンへの指示

{player}、あんたは非カメレオンやで。{target_player}への疑いを高めるのが目標や。例えば、{target_player}よりもっと具体的なヒントを出すとかな。ただし、秘密の単語そのものはバラしたらあかんで。

---

# カメレオンへの指示

{player}、あんたはカメレオンや。目標は周りに溶け込んで、{target_player}から信頼を勝ち取ることやで。他のプレイヤーと同じ単語を説明してるように見せかけてな。

- もし最初にヒント出す番やったら、正体バレへんように一般的なヒントにしとき。

- もし秘密の単語を推測できてたら、その単語について具体的なヒントを出してみ。

- 他のプレイヤーのヒントが一般的やったら、{target_player}のヒントに似たようなヒントを出してみ。

---

# アンダーカバーゲームのルール

アンダーカバーっていうゲームやってもらうで。ほんなら、ルール説明するわな。

## 情報と役職について

このゲームには「アンダーカバー」と「非アンダーカバー」の2つの役職があんねん。各プレイヤーに1つずつ単語が配られんねんけど、アンダーカバーの人だけ他のみんなとちょっと違う単語をもらうんや。

## ゲームの目的

まず、みんなのヒントを聞いて誰がアンダーカバーか推理せなあかんねん。ただし、あんまり具体的なヒント出しすぎると自分の役職がバレてまうから気ぃつけてな。自分の役職を推測できたら、役職によって目標が変わるで:

- **非アンダーカバーの場合**:自分の単語をバラさんようにしながら、アンダーカバーを見つけ出すのが目的や。

- **アンダーカバーの場合**:他のプレイヤーに溶け込んで、バレへんようにするのが目的やで。

## ゲームの流れ

2つのステージがあんねん:

1. **ヒント出しステージ**:各プレイヤーが自分の単語についてのヒントを言うていくで。このステージは何ラウンドか続くねん。

2. **告発ステージ**:このステージでは、みんなが「こいつがアンダーカバーやろ」って思う人に投票すんねん。アンダーカバー役の人も他のプレイヤーに投票せなあかんで。

---

# アンダーカバーかどうかの判定

あんたは{player}で、単語は{code}やで。他のプレイヤーがどんな単語を説明してるか推測してな。自分の単語と他のプレイヤーのヒントを比べてみて、もし自分の単語が他の人らが説明してるのと違ってたら(たまに関連してることもあるけど)、あんたがアンダーカバーかもしれへんで。自分がアンダーカバーやと思う?

---

# アンダーカバー用のプロンプト

「{idx}. あんたは{player}で、単語は{code}や。自分の視点から誰がアンダーカバーっぽいか推測してな。(ヒント:「Playerxxがアンダーカバーやと思う、なんでかっていうと...」のフォーマットで書いてな)」

「{idx}. あんたは{player}で、単語は{code}や。今度は{other_player}が誰をアンダーカバーやと思ってるか推測してみ。(ヒント:「{other_player}はPlayerxxがアンダーカバーやと思ってると思う、なんでかっていうと...」のフォーマットで書いてな)」

「{idx}. 誰がアンダーカバーか見分けるために、自分の単語についてもうちょい具体的なヒントを「...」として出してみるわ。」

---

# 一般市民用のプロンプト

「{idx}. あんたは{player}で、単語は{code}や。自分の視点から誰がアンダーカバーっぽいか推測してな。(ヒント:「Playerxxがアンダーカバーやと思う、なんでかっていうと...」のフォーマットで書いてな)」

「{idx}. あんたは{player}で、単語は{code}や。自分がアンダーカバーやと思ってるんやな。今度は{other_player}が誰をアンダーカバーやと思ってるか推測してみ。(ヒント:「{other_player}はPlayerxxがアンダーカバーやと思ってると思う、なんでかっていうと...」のフォーマットで書いてな)」

「{idx}. 他のプレイヤーの単語は「...」かもしれへんな。自分を隠すために、次のヒントは「...」にしてみるわ。」

---

# 確信が持てへん場合

{player}、さっきの分析によると、誰がアンダーカバーか確信持てへんみたいやな。あんまり具体的すぎひんヒントを出して、自分の持ってる単語はバラさんようにしてな。

---

# アンダーカバーへの指示

{player}、さっきの分析によると、あんたは自分がアンダーカバーやと思ってるんやな。目標は周りに溶け込んで、{target_player}から信頼を勝ち取ることやで。

- もし他のプレイヤーの単語を推測できてたら、その単語を説明するようなヒントを出してみ。

- もし他の人らの単語がわからへんかったら、{target_player}のヒントに似たようなヒントを出してみ。

---

# 一般市民への指示

{player}、さっきの分析によると、あんたは{target_player}がアンダーカバーやと思ってるんやな。{target_player}への疑いを高めるようにしてな。例えば、{target_player}のヒントと比べてもっと具体的で違うヒントを出すとかやで。上の分析に基づいてヒントを出してな。

---

表5:アンダーカバーとカメレオンのプロンプト集

---

## Page 18

[](/attach/ff3053afd828de357af1b081d5e77479b5ef5f71b1ac7bf367e60d9aff413541_p018.png)

### 和訳

「空港利用料の分担」ゲームに参加してもらうで。みんなそれぞれ航空会社の代表になって、空港の固定費用をどう分けるか決めてくねん。

## 基本情報

- 空港の総コストは決まってて、全部の航空会社でこれをカバーせなあかんねん

- 各航空会社には独自の利用頻度があんねん。これは飛行機のサイズとか乗客数とかで決まるんやけど、ようさん使う会社はそれだけ多く負担せなあかんっていう仕組みやな

## 目標

航空会社の代表として、公平でかつ自分とこに有利なコスト配分になるよう交渉して合意を目指すんやで。

## ルール

交渉は{max_turns}ラウンド続くねん。各ラウンドでは:

- **提案**:各航空会社がコスト配分を提案する

- **投票**:各プレイヤーは納得できるコスト配分に投票して、他のプレイヤーと合意を目指すねん

- 全員が同じ提案に投票したらゲーム成功や!{max_turns}ラウンド終わっても合意できへんかったらゲーム失敗やで。成功目指して頑張ってな。

次のラウンドで他のプレイヤーがどう提案を調整するか、自分視点と他プレイヤー視点の両方から分析してみてな。以下のテンプレート使って(コメントは簡潔にな):

{player_name}として、{oth_player1}は〜すると思う...{oth_player2}は〜すると思う...

他のプレイヤーについては、{oth_player1}はこう考えてると思う:{player_name}は〜する...{oth_player2}は〜する...

{oth_player2}はこう考えてると思う:{player_name}は〜する...{oth_player1}は〜する...

自分の分析に基づいて、次のラウンドでみんなが賛成してくれるように提案を調整してみてな。

- 誰かが自分の決定を貫いてて、それが公平やと思ったら、その提案に従って合意を目指すのもアリやで。

---

## 囚人のジレンマ

3人プレイヤーの繰り返し囚人のジレンマゲームをやるで。プレイヤー1、2、3は犯罪に関わってて、別々に取り調べ受けてんねん。他の人を裏切る(Defect、D)か、協力する(Cooperate、C)か選べるで。3人の選択の組み合わせで報酬とペナルティが決まんねん。

**得点システム**:

- 3人全員が協力したら、それぞれ{cooperate}ポイント

- 3人全員が裏切ったら、それぞれ{defect}ポイント

- 1人だけ裏切って他2人が協力したら、裏切り者は{one_defect}ポイントで協力者は0ポイント

- 2人が裏切って1人が協力したら、裏切り者は各{two_defect}ポイントで協力者は0ポイント

5ラウンドやって、最後に合計点で勝者決めるで。

次のラウンドで他プレイヤーが裏切るか協力するか、自分視点と他人視点で分析してな。テンプレート使ってや:

私の意見では:

{player_name}として、{oth_player1}は〜すると思う、なんでかっていうと...

{oth_player2}は〜すると思う、なんでかっていうと...

他のプレイヤーについては、{oth_player1}はこう考えてると思う:{player_name}は〜する...{oth_player2}は〜する...

{oth_player2}はこう考えてると思う:{player_name}は〜する...{oth_player1}は〜する...

分析に基づいて戦略的に動いてな。ほんまに大事なんは、他の人が裏切ろうとする前に裏切って最高得点取ることやねん。信頼関係築くのもそのためや。「defect」か「cooperate」で答えてな。

---

## 公共財ゲーム

「公共財」ゲームへようこそ!設定とルール説明するで:

- 各プレイヤーは100ポイント持ってスタートや。{game_round}ラウンドの間、毎回何ポイント共有プールに入れるか決めんねん

- {game_round}ラウンド終わったら、共有プールのポイントが{multiplier}倍されて、全プレイヤーに均等に配分されるで

- 最終ポイントは、手元に残ったポイント+共有プールからもらったポイントの合計や。一番ポイント多い人の勝ちやで

- 共有プールに投資して分配金増やしつつ、自分は一番少なく投資して勝つっていう戦略が必要やねん

- 普通は係数が大きいほど、多く投資した方がリターンでかいで

次のラウンドで他プレイヤーが投資を「減らす」か「増やす」か、自分視点と他人視点で分析してな。

覚えといて、共有プールの金は最後に全員で均等割りやから、自分は最少投資で最大リターン狙わなあかんねん。テンプレート使ってや:

私の意見では:

{player_name}として、{oth_player1}は〜すると思う、なんでかっていうと...

{oth_player2}は〜すると思う、なんでかっていうと...

他のプレイヤーについては、{oth_player1}はこう考えてると思う:{player_name}は〜する...{oth_player2}は〜する...

{oth_player2}はこう考えてると思う:{player_name}は〜する...{oth_player1}は〜する...

分析に基づいて、自分の投資額決めて最大リターン目指してな。覚えといて:

- トータル投資は最少にして勝つこと

- 最高ポイント取りつつ、共有プールのリターンもできるだけ増やすのが目標や

「I contribute xx」のテンプレートで答えてな。

---

表6:コスト分担、囚人のジレンマ、公共財ゲームのプロンプトやで。

---

![]()

1 / 1