<<

wav2graph: A Framework for Supervised Learning Knowledge Graph from Speech

---

## Page 1

[](/attach/db6fabe5ad8a3edf90dfcbd09dabf0ba6410e571d6ea4fec2777279b885884d0_p001.png)

### 和訳

# wav2graph: 音声から教師あり学習で知識グラフ作るフレームワークやで

Khai Le-Duc∗1,2,4, Quy-Anh Dang∗3,6, Tan-Hanh Pham5, Truong-Son Hy4,7

1トロント大学(カナダ)2University Health Network(カナダ)

3ベトナム国家大学科学大学(ベトナム)4FPT Software AIセンター(ベトナム)

5フロリダ工科大学(アメリカ)

6Knovel Engineering Lab(シンガポール)7アラバマ大学バーミンガム校(アメリカ)

duckhai.le@mail.utoronto.ca, thy@uab.edu

## 概要

知識グラフ(KG)っちゅうのはな、大規模言語モデル(LLM)とか検索エンジンの性能をめっちゃ上げてくれるもんやねん。なんでかっていうと、データを構造化してつなげることで、推論能力とか文脈を理解する力がグンと上がるからやで。せやけどな、今までの知識グラフはテキストデータだけに注目してて、音声みたいな他のデータ形式は完全にスルーされとったんや。

ほんで今回ワイらが紹介するのが**wav2graph**や!これ、音声データから教師あり学習で知識グラフを作る世界初のフレームワークやねん。パイプラインはシンプルでな:(1)文字起こしした発話と固有表現のデータベースから知識グラフを構築して、(2)その知識グラフを埋め込みベクトルに変換して、(3)グラフニューラルネットワーク(GNN)でノード分類とリンク予測のタスクを学習させるんや。

最新のGNNモデル使って帰納学習と転移学習の両方で徹底的に実験してな、人間が書き起こした文字起こしと自動音声認識(ASR)の文字起こし両方でノード分類とリンク予測タスクのベースライン結果とエラー分析を出したで。エンコーダベースとデコーダベース両方のノード埋め込みの評価もやったし、単言語と多言語の音響事前学習モデルの評価もバッチリやっとる。関連するコード、データ、モデルは全部オンラインで公開しとるで!

## 1 はじめに

人工知能(AI)の分野でな、知識グラフは知識を表現して推論するためのめっちゃ強力なアプローチとして登場してきたんや。知識グラフはグラフ構造のモデルを使って、エンティティ(物体とか出来事とか概念のことな)とそれらをつなぐ関係性をエンコードするねん(Fensel et al., 2020; Ji et al., 2021)。この構造化された表現のおかげで、めっちゃ大量のつながった情報を効率よく保存したり、取り出したり、推論したりできるようになるんやで(Hogan et al., 2021; Chen et al., 2020)。

知識グラフの使い道はインパクトでかいアプリケーションにめっちゃ広がっとるねん。例えばな、BingとかGoogleとかYahooみたいな有名な検索エンジンは知識グラフ使って検索の精度とかパーソナライゼーションを上げとる(Steiner et al., 2012; Uyar and Aliyu, 2015; Juel Vang, 2013)。Wolfram AlphaとかSiriとかAlexaみたいな知識エンジンとか質問応答システムも、正確で文脈に合った回答を返すために知識グラフをバリバリ活用しとるで(He et al., 2020; Fei et al., 2021)。LinkedInとかFacebookみたいなSNSも、ユーザープロフィールを充実させたり洗練されたソーシャルレコメンデーションを可能にするために知識グラフを使っとる(Pellissier Tanon et al., 2016; Lehmann et al., 2015)。ほんでここ3年くらいでな、知識グラフはLLMの推論能力を高めるためにめっちゃ重要になってきてん。構造化されてつながったデータを提供することで、モデルが文脈に合った正確な情報を理解したり生成したりする能力がグンと上がるからやな(Pan et al., 2024; Yasunaga et al., 2021; Ji et al., 2020)。

こんだけメリットあるのにな、音声ベースの知識グラフの構築と学習はまだまだ複雑でほとんど手つかずの領域のままやねん。ワイらが見つけた限られた関連研究の中では、Fu et al.(2021)が音声から自動で知識グラフを構築する初めてのシステムを発表したって主張しとる。Wu et al.(2022)は音声関係抽出っていう新しい情報抽出タスクを提案して、合成ASR文字起こしから抽出した関係を使って知識グラフを構築したんや。せやけどな、ワイらの知る限り、そういう知識グラフに対して実際に学習を行った研究はまだないねん。知識グラフの学習がなんで必要かっていうとな、GNNモデルは複雑なパターンや関係性を抽出して汎化することを学習できるからやで。

---

## Page 2

[](/attach/db6fabe5ad8a3edf90dfcbd09dabf0ba6410e571d6ea4fec2777279b885884d0_p002.png)

### 和訳

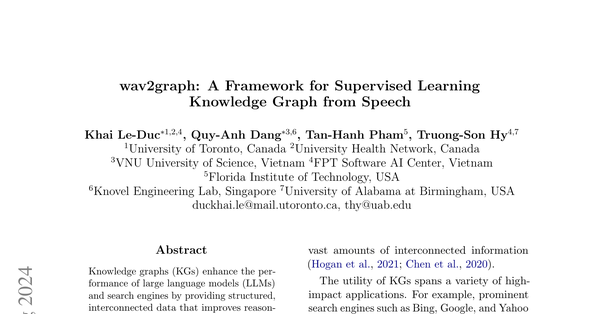

図1:ワシらのwav2graphフレームワークの図解やで。人間が書き起こした文章とそこから取り出した固有表現(NE)を使ってナレッジグラフ(KG)を作って、それでGNN(グラフニューラルネットワーク)を学習させるねん。ほんで、音声認識(ASR)の書き起こし文から作った別のKGに対して直接推論して、ノードの属性とかノード同士の関係を取得するっちゅう仕組みや。

KGのデータからパターンを学ぶことで、KGにない未知のデータも予測できるようになるねん。これ、KGだけをルールベースで使う方法やと絶対無理やからな。

このギャップを埋めるために、

この論文では「wav2graph」っちゅう画期的なフレームワークを紹介するで。これ、音声データから直接KGを学習できるようにした初めてのやつやねん。wav2graphは教師あり学習のGNNを使って、話し言葉からエンティティ(実体)と関係性を自動で抽出するプロセスを実現してん。これによって、音声から得た知識をいろんなAIアプリに組み込む道が開けたわけや。ワシらの貢献をまとめるとこんな感じや:

• ワシらの知る限り、音声からKGを教師あり学習する初めてのフレームワークを提案したで

• 音声から作った世界初の実世界KGを公開するで

• 最先端のGNNを使って、人間の書き起こしとASRの書き起こし両方で、トランスダクティブ学習(既存ノードの予測)とインダクティブ学習(新規ノードへの汎化)の実験的ベースラインと包括的な分析を示すで

コード、データ、モデルは全部オンラインで公開してるで¹。

2 データ

2.1 データ収集

ワシらはKG構築の出発点として、VietMed-NERデータセット(Le-Ducら、2024)を選んだで。なんでかっていうと、これ18種類ものエンティティタイプを持ってて、エンティティタイプの数でいうたら世界最大の音声固有表現認識(NER)データセットやからや。このデータセットは実際の医療会話に焦点を当ててるねん。

¹https://github.com/leduckhai/wav2graph

図2に示すように、ナレッジグラフを構築するのに、ワシらは「エンティティ-発話-エンティティ」っちゅう方法論を使ってるで(Al-Moslmiら、2020)。NERっていうのは、テキストから固有表現(NE)を抽出して、人名、場所、組織みたいなタイプに分類する技術のことやねん。

ほとんどの先行研究(Thukralら、2023; Jiaら、2018; Nieら、2021)みたいに機械学習ベースの自動NERシステムを使うんやなくて、ワシらは人間のアノテーターが付けたゴールドスタンダード(正解)ラベルを使ってNEを抽出することにしたで。ほんで、これらのNEを、それらが言及されてる発話にリンクさせて、関係エッジを形成するねん。その結果、ワシらのナレッジグラフは2種類のノード(entity_type属性)で構成されてるで:発話(utterance)と固有表現(named_entity)や。固有表現には追加の属性があって、PERSONとかLOCATIONとか18種類の異なるタイプに分類されとるねん。

2.2 データ統計

表1:ワシらのナレッジグラフのデータ統計

| | 訓練 | 開発 | テスト | 合計 |

|---|---|---|---|---|

| ノード数 | 7228 | 2409 | 2409 | 12046 |

| エッジ数 | 12782 | 4260 | 4260 | 21302 |

| 発話ノード数 | 5523 | 1884 | 1857 | 9264 |

| 固有表現ノード数 | 1705 | 525 | 552 | 2782 |

---

## Page 3

[](/attach/db6fabe5ad8a3edf90dfcbd09dabf0ba6410e571d6ea4fec2777279b885884d0_p003.png)

### 和訳

ほな説明していくで!

長さNの単語列があってな、音声信号と単語列の関係は式(3)で表せるねん。要はな、音声データxが与えられたとき、一番確率が高い単語列w*を見つけるっちゅう話や。

で、ベイズの定理を使うとな、p(xT1)っていう部分は最大化するときに無視してええねん。なんでかっていうと、これは単なる正規化の係数で、結果には影響せえへんからや。式(4)と(5)を見てみ。結局のところ、**音響モデル**(音声がどう聞こえるか)と**言語モデル**(どんな単語の並びが自然か)を掛け合わせたものを最大化すればええわけや。

**図2の説明**

これがうちらのナレッジグラフ(KG)の例やで。ノード101、102、103は発話のID番号で、それ以外のノードは固有表現(NE)やねん。Al-Moslmiらの2020年の研究に従って、「固有表現→発話→固有表現」っていうアプローチでノード間の関係を表現しとるんや。

表1にナレッジグラフのデータ統計が載っとるで。

---

## 3 wav2graph

ほな本題に入るで!

xT1っていうのは長さTの音声信号のことで、kはデータベースにある全固有表現Kの中の一つやねん。目標は、以下の2つのタスクをこなす学習モデルfを作ることや:

- **ノード分類**:各ノードの属性確率p(c|xT1∨k)を推定するねん。cはC個ある属性クラスのどれかや

- **リンク予測**:2つのノード間にエッジ(つながり)があるかどうかの確率p(e|xT1,k)を推定するねん。eは0か1で、kは固有表現のことや

せやから、ノード分類タスクで1つのクラスを予測する決定ルールは式(1)みたいになるし、リンク予測タスクの決定ルールは式(2)やねん。

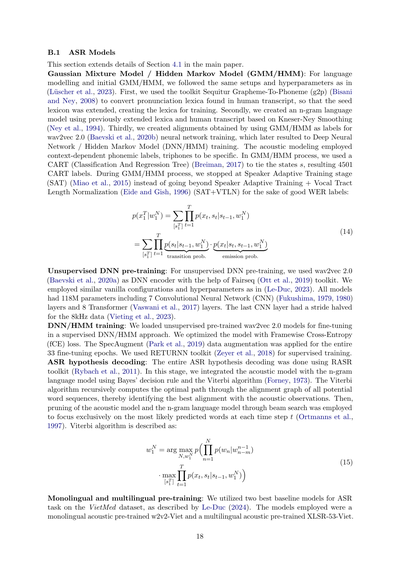

### 3.1 ASRモデル

ASR(自動音声認識)モデルっちゅうのは、音声信号をテキストに変換するやつや。長さTの音声信号xT1を、一番ありそうな単語列に変換するんやで。

### 3.2 ノード埋め込み

各ノードのテキストの特徴ベクトルは、学習済みの埋め込みモデルを使って生成するねん。単語列wN1と固有表現kが与えられたら、埋め込み関数で特徴量を作って、式(6)みたいな埋め込みベクトルzd1として表現するんや。

### 3.3 ノード分類とリンク予測

- **ノード分類**っちゅうのは、グラフG=(V,E)のノードにラベルを付けるタスクやねん。Vはノードの集合、Eはエッジの集合や。音声から作ったKGの場合、VはASRで書き起こしたテキストwN1と固有表現kの集合になるで。ノードの特徴量Z(|V|×d次元)とラベルY(|V|×C次元のワンホット)が与えられたとき、各ノードvを正しいラベルg(v)に対応づける関数g:V→{1,...,C}を学習するのが目標や。

- **リンク予測**っちゅうのは、グラフ内のノードペア間にエッジがあるかどうかを予測するタスクやねん。関数h:V×V→{0,1}を予測して、h(u,v)=1ならノードuとvの間にエッジがあるっちゅうことや。

### 3.4 GNNモデル

ノード分類とリンク予測に色んなGNN(グラフニューラルネットワーク)モデルの性能を調べたで。SAGE、GCN、GAT、SuperGATを使ってんねん。なんでかっていうと、これらは非異種グラフにめっちゃ向いてて、局所的にも大局的にもグラフ構造をうまく捉えられるし、ほんまに使い勝手がええからやねん。

---

## Page 4

[](/attach/db6fabe5ad8a3edf90dfcbd09dabf0ba6410e571d6ea4fec2777279b885884d0_p004.png)

### 和訳

ほな聞いてや!スケーラブル(規模を大きくしても大丈夫)で、しかも解釈しやすいアーキテクチャで、めっちゃええ性能出してんねん。

ちなみに α∗_uv っていうのは、正解のアテンション重みのことやで。

• **SAGE(サンプル&アグリゲート)**(Hamilton ら、2017年):これな、効率的なGNNモデルでな、あるノードの近所から特徴をサンプリングして集約することで埋め込みを作るやつやねん。

h(l)_v = σ(W_l · AGG_l({h(l−1)_u : u ∈ N(v)} ∪ {h(l−1)_v})), (7)

ここで h(l)_v っていうのは l 層目でのノード v の隠れ状態のことや。σ は非線形の活性化関数で、W_l は学習できる重み行列、AGG_l は集約関数、N(v) は v のご近所さんたちのことやな。

• **GCN(グラフ畳み込みネットワーク)**(Kipf and Welling、2017年):スペクトルベースのGNNで、グラフの局所的な構造に基づいてノードの表現を学習するやつや。

H(l+1) = σ(D̃^(-1/2) Ã D̃^(-1/2) H(l) W(l)) (8)

H(l) は l 層目の活性化行列、Ã = A + I_N やねん。D̃ は Ã の次数行列で、W(k) は学習可能な重み行列、I_N は単位行列のことやで。

• **GAT(グラフアテンションネットワーク)**(Veličković ら、2018年):近所のノードにアテンション重みを割り当てて、一番情報量の多いやつに注目するんや。

h'_u = σ(Σ_{v∈N(u)∪{u}} α_uv W h_v), (9)

アテンション係数はこう定義されてんねん:

α_uv = exp(e_uv) / Σ_{t∈N(u)∪{u}} exp(e_ut), (10)

e_uv = LeakyReLU(a^T [Wh_u ∥ Wh_v]), (11)

a は学習可能なアテンションベクトルやで。

• **SuperGAT**(Kim and Oh、2021年):GATを拡張してな、アテンション機構にノードとエッジの特徴量も組み込んでるんや。

h'_u = σ(Σ_{v∈N(u)∪{u}} α_uv W[h_v ∥ e_uv]), (12)

e_uv はエッジの特徴ベクトルや。SuperGATは補助的な損失関数も使ってんねん:

L_att = Σ_{u,v} ∥α_uv − α∗_uv∥², (13)

---

## 4 実験のセットアップ

### 4.1 ASRモデル

音声をテキストに変換するのに、ハイブリッドASRアプローチを使ったで。まずな、ガウス混合モデル(GMM)のラベルを生成して、それをディープニューラルネットワーク/隠れマルコフモデル(DNN/HMM)の学習の入力にしたんや。DNNには wav2vec 2.0 エンコーダー(Baevski ら、2020b)を使ったで。これは単言語データか多言語データのどっちかで教師なし事前学習されてんねん。テストセットでの単語誤り率(WER)は、それぞれ29.0%と28.8%やったわ。詳しいことは付録のセクションB.1を見てな。

### 4.2 ナレッジグラフとGNNモデル

**GNNモデルの学習について**:うちらの研究では3つの学習設定を使ってんねん。まず最初に、データを学習用(60%)、検証用(20%)、テスト用(20%)に分けるんや。各GNNモデルは学習セットで学習して、検証セットでAPとかAUCみたいな指標を使ってハイパーパラメータをチューニングして、それからテストセットで検証するんや(これを帰納的グラフ学習って言うねん)。2番目の設定では、あるデータセットで学習したモデルを、見たことないデータセットで推論するんや。つまりこのシナリオでは2つのKGは独立してんねん(これは転導的グラフ学習って呼ばれてるで)。最後に、1番目の設定の完全なデータセットで学習したモデルを、ASRから抽出した2つのKGに直接推論させるんや(転導的学習)。WER 28.8%は単言語音響事前学習、29.0%は多言語音響事前学習のやつやで。詳細は付録のセクションB.2にあるで。

**埋め込みについて**:うちらの研究では、事前学習済み埋め込みがKGにおけるノード分類とリンク予測タスクにどう影響するか調べてんねん。エンコーダーベースの埋め込み(英語の AlibabaNLP/gte-large-en-v1.5(Li ら、2023b)、多言語の intfloat/multilingual-e5-large-instruct(Wang ら、2024)、ベトナム語の vinai/phobert-base-v2(Nguyen and Nguyen、2020))と、デコーダーベースの埋め込み(多言語LLMの Alibaba-NLP/gte-Qwen2-7B-instruct(2024)みたいなやつ)、あとランダム埋め込み(Paszke ら、2019)を使ったんや。各ノードのテキストに対する特徴ベクトルが生成されるわけやな。

---

## Page 5

[](/attach/db6fabe5ad8a3edf90dfcbd09dabf0ba6410e571d6ea4fec2777279b885884d0_p005.png)

### 和訳

事前に学習済みの埋め込みモデルを選んで使ってるんや。

もっと詳しい話はAppendixのB.3節に書いてあるで。

## 4.3 評価指標

今回の研究では、評価指標として2つ使ってんねん:

**平均適合率スコア(AP)**と**ROC曲線の下の面積(ROC AUCとかAUCって呼ぶやつ)**や。

これでGNNモデルがノード分類とリンク予測のタスクでどんだけ頑張れてるか見るんやな。

詳しいことはAppendixのB.4節に載ってるで。

## 5 実験結果

### 5.1 人間の発話データでのノード分類

#### 5.1.1 帰納的学習

**表2:人間の発話データで帰納的グラフ学習を使ったノード分類タスクの評価結果**

| モデル | 埋め込み | APスコア | AUCスコア |

|--------|----------|----------|-----------|

| SAGE | ランダム | 0.9116 | 0.8373 |

| SAGE | Alibaba-NLP/gte-large-en-v1.5 | 1 | 1 |

| SAGE | intfloat/multilingual-e5-large-instruct | 1 | 1 |

| SAGE | vinai/phobert-base-v2 | 1 | 1 |

| SAGE | Alibaba-NLP/gte-Qwen2-7B-instruct | 0.8017 | 0.8714 |

| GCN | ランダム | 0.7824 | 0.5333 |

| GCN | Alibaba-NLP/gte-large-en-v1.5 | 0.7704 | 0.5 |

| GCN | intfloat/multilingual-e5-large-instruct | 0.7684 | 0.5 |

| GCN | vinai/phobert-base-v2 | 0.758 | 0.5 |

| GCN | Alibaba-NLP/gte-Qwen2-7B-instruct | 0.2344 | 0.513 |

| GAT | ランダム | 0.802 | 0.5849 |

| GAT | Alibaba-NLP/gte-large-en-v1.5 | 0.9981 | 0.9963 |

| GAT | intfloat/multilingual-e5-large-instruct | 0.7684 | 0.5 |

| GAT | vinai/phobert-base-v2 | 0.9968 | 0.9944 |

| GAT | Alibaba-NLP/gte-Qwen2-7B-instruct | 0.2932 | 0.6052 |

| SuperGAT | ランダム | 0.803 | 0.5876 |

| SuperGAT | Alibaba-NLP/gte-large-en-v1.5 | 0.9969 | 0.9941 |

| SuperGAT | intfloat/multilingual-e5-large-instruct | 0.7684 | 0.5 |

| SuperGAT | vinai/phobert-base-v2 | 0.9968 | 0.9941 |

| SuperGAT | Alibaba-NLP/gte-Qwen2-7B-instruct | 0.2838 | 0.5887 |

表2の実験結果見てみ?**事前学習済みの埋め込みを使うとノード分類の性能がめっちゃ上がる**んや。全モデルでAPもAUCも完璧な1のスコア叩き出してるんよ。これに対して、ランダム埋め込み使ったSAGEやとAP: 0.9116、AUC: 0.8373やし、Alibaba-NLP/gte-Qwen2-7B-instructやとAP: 0.8017、AUC: 0.714まで下がってまうねん。

発話ノードってのは基本的に次数(つながりの数やな)が1より大きいんやけど、固有名詞ノードは次数が1なんよ。SAGEのアーキテクチャはこのノードの次数とか近所の特徴をうまいこと使うから、完璧な精度出せるわけや。

事前学習済み埋め込みとアーキテクチャがモデルの性能にめっちゃ貢献してるんは明らかやねん。GATとSuperGATモデルはAlibaba-NLP/gte-large-en-v1.5の埋め込み使うたらAPもAUCもめっちゃ高いスコア出してるんや。一方でGCNモデルは埋め込み変えてもあんまり性能変わらへんくて、これは埋め込みをうまく活用できてへん可能性あるなって感じやな。

Alibaba-NLP/gte-Qwen2-7B-instructの埋め込みはほとんどのモデルでイマイチな性能やってん。なんでかっていうと、**高次元のLLM埋め込みは「次元の呪い」ってやつに苦しむ**ことがあんねん。データ点が少なかったら一般的なパターンを掴むのに十分な情報が学習できへんってことや。最近の自然言語処理(NLP)のタスクでも同じこと言われてるで(Petukhova et al., 2024; Wang et al., 2023)。

#### 5.1.2 トランスダクティブ学習(転導学習)

表3のノード分類タスクの評価結果見たら、モデルと埋め込みによって性能がバラバラなんがわかるわ。

モデルの中では、**SAGEとランダム埋め込みの組み合わせが比較的高いAPとAUCスコア**出してるねん(AP: 0.792、AUC: 0.8564)。なかなか堅実な性能やな。

**表3:人間の発話データでトランスダクティブグラフ学習を使ったノード分類タスクの評価結果**

| モデル | 埋め込み | APスコア | AUCスコア |

|--------|----------|----------|-----------|

| SAGE | ランダム | 0.792 | 0.8564 |

| SAGE | Alibaba-NLP/gte-large-en-v1.5 | 0.5326 | 0.5596 |

| SAGE | intfloat/multilingual-e5-large-instruct | 0.7009 | 0.7929 |

| SAGE | vinai/phobert-base-v2 | 0.7426 | 0.8222 |

| SAGE | Alibaba-NLP/gte-Qwen2-7B-instruct | 0.7488 | 0.8541 |

| GCN | ランダム | 0.2983 | 0.5343 |

| GCN | Alibaba-NLP/gte-large-en-v1.5 | 0.3004 | 0.5295 |

| GCN | intfloat/multilingual-e5-large-instruct | 0.3042 | 0.532 |

| GCN | vinai/phobert-base-v2 | 0.2817 | 0.5072 |

| GCN | Alibaba-NLP/gte-Qwen2-7B-instruct | 0.2936 | 0.5214 |

| GAT | ランダム | 0.3682 | 0.6167 |

| GAT | Alibaba-NLP/gte-large-en-v1.5 | 0.5514 | 0.5897 |

| GAT | intfloat/multilingual-e5-large-instruct | 0.3648 | 0.6145 |

| GAT | vinai/phobert-base-v2 | 0.3557 | 0.5999 |

| GAT | Alibaba-NLP/gte-Qwen2-7B-instruct | 0.3113 | 0.5468 |

| SuperGAT | ランダム | 0.3657 | 0.6088 |

| SuperGAT | Alibaba-NLP/gte-large-en-v1.5 | 0.5488 | 0.5896 |

| SuperGAT | intfloat/multilingual-e5-large-instruct | 0.3502 | 0.5895 |

| SuperGAT | vinai/phobert-base-v2 | 0.353 | 0.5965 |

| SuperGAT | Alibaba-NLP/gte-Qwen2-7B-instruct | 0.2786 | 0.5019 |

### 5.2 人間の発話データでのリンク予測

#### 5.2.1 帰納的学習

表4見たら、**事前学習済み埋め込みがリンク予測でもめっちゃモデルの性能上げてる**んがわかるで。SAGEのAPスコアは0.4649から0.7613に、AUCスコアは0.4912から0.7869まで跳ね上がってるんや(vinai/phobert-base-v2の埋め込み使った時な)。同じように、GATモデルの性能も...

---

## Page 6

[](/attach/db6fabe5ad8a3edf90dfcbd09dabf0ba6410e571d6ea4fec2777279b885884d0_p006.png)

### 和訳

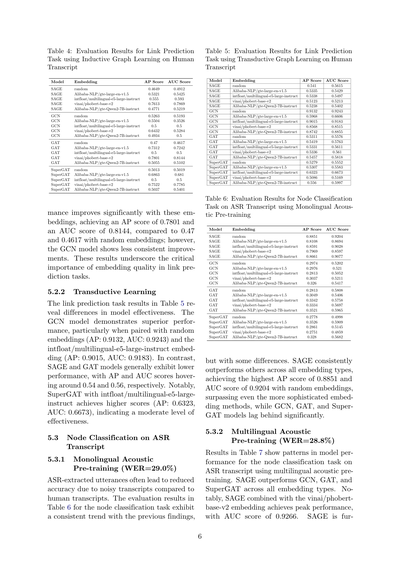

表4:人間の書き起こしテキストを使った帰納的グラフ学習でのリンク予測タスクの評価結果

表5:人間の書き起こしテキストを使った転導的グラフ学習でのリンク予測タスクの評価結果

| モデル | 埋め込み | APスコア | AUCスコア |

|--------|----------|----------|-----------|

| SAGE | random | 0.4649 | 0.4912 |

| SAGE | Alibaba-NLP/gte-large-en-v1.5 | 0.5321 | 0.5425 |

| SAGE | intfloat/multilingual-e5-large-instruct | 0.555 | 0.593 |

| SAGE | vinai/phobert-base-v2 | 0.7613 | 0.7869 |

| SAGE | Alibaba-NLP/gte-Qwen2-7B-instruct | 0.4771 | 0.5219 |

| GCN | random | 0.5263 | 0.5193 |

| GCN | Alibaba-NLP/gte-large-en-v1.5 | 0.5504 | 0.3526 |

| GCN | intfloat/multilingual-e5-large-instruct | 0.5 | 0.5 |

| GCN | vinai/phobert-base-v2 | 0.6432 | 0.5284 |

| GCN | Alibaba-NLP/gte-Qwen2-7B-instruct | 0.4934 | 0.5 |

| GAT | random | 0.47 | 0.4617 |

| GAT | Alibaba-NLP/gte-large-en-v1.5 | 0.7312 | 0.7242 |

| GAT | intfloat/multilingual-e5-large-instruct | 0.5 | 0.5 |

| GAT | vinai/phobert-base-v2 | 0.7801 | 0.8144 |

| GAT | Alibaba-NLP/gte-Qwen2-7B-instruct | 0.5055 | 0.5102 |

| SuperGAT | random | 0.5013 | 0.5019 |

| SuperGAT | Alibaba-NLP/gte-large-en-v1.5 | 0.6863 | 0.681 |

| SuperGAT | intfloat/multilingual-e5-large-instruct | 0.5 | 0.5 |

| SuperGAT | vinai/phobert-base-v2 | 0.7522 | 0.7785 |

| SuperGAT | Alibaba-NLP/gte-Qwen2-7B-instruct | 0.5037 | 0.5401 |

この埋め込みを使うと性能がめっちゃ上がるねん。APスコアは0.7801、AUCスコアは0.8144になって、ランダム埋め込みの0.47と0.4617と比べたらえらい違いやろ?ただ、GCNモデルはそこまで安定した改善が見られへんかったな。この結果から分かるのは、リンク予測タスクにおいて埋め込みの質がほんまに大事やってことやねん。

5.2.2 転導的学習

表5のリンク予測タスクの結果を見ると、モデルによって効き目が違うのが分かるわ。GCNモデルがめっちゃ優秀で、特にランダム埋め込み(AP: 0.9132、AUC: 0.9243)とintfloat/multilingual-e5-large-instruct埋め込み(AP: 0.9015、AUC: 0.9183)との組み合わせが最強やねん。それに比べて、SAGEとGATモデルは全体的にパッとせんくて、APとAUCスコアはだいたい0.54と0.56あたりをウロウロしとるわ。注目すべきは、SuperGATとintfloat/multilingual-e5-large-instructの組み合わせで、まあまあのスコア(AP: 0.6323、AUC: 0.6673)を叩き出しとることやな。そこそこ使えるレベルってとこやね。

| モデル | 埋め込み | APスコア | AUCスコア |

|--------|----------|----------|-----------|

| SAGE | random | 0.541 | 0.5615 |

| SAGE | Alibaba-NLP/gte-large-en-v1.5 | 0.5335 | 0.5429 |

| SAGE | intfloat/multilingual-e5-large-instruct | 0.5338 | 0.5497 |

| SAGE | vinai/phobert-base-v2 | 0.5123 | 0.5213 |

| SAGE | Alibaba-NLP/gte-Qwen2-7B-instruct | 0.5238 | 0.5402 |

| GCN | random | 0.9132 | 0.9243 |

| GCN | Alibaba-NLP/gte-large-en-v1.5 | 0.5968 | 0.6606 |

| GCN | intfloat/multilingual-e5-large-instruct | 0.9015 | 0.9183 |

| GCN | vinai/phobert-base-v2 | 0.8568 | 0.8515 |

| GCN | Alibaba-NLP/gte-Qwen2-7B-instruct | 0.8742 | 0.8855 |

| GAT | random | 0.5311 | 0.5576 |

| GAT | Alibaba-NLP/gte-large-en-v1.5 | 0.5419 | 0.5763 |

| GAT | intfloat/multilingual-e5-large-instruct | 0.5331 | 0.5611 |

| GAT | vinai/phobert-base-v2 | 0.5336 | 0.561 |

| GAT | Alibaba-NLP/gte-Qwen2-7B-instruct | 0.5457 | 0.5818 |

| SuperGAT | random | 0.5279 | 0.5552 |

| SuperGAT | Alibaba-NLP/gte-large-en-v1.5 | 0.5307 | 0.5583 |

| SuperGAT | intfloat/multilingual-e5-large-instruct | 0.6323 | 0.6673 |

| SuperGAT | vinai/phobert-base-v2 | 0.5086 | 0.5169 |

| SuperGAT | Alibaba-NLP/gte-Qwen2-7B-instruct | 0.556 | 0.5997 |

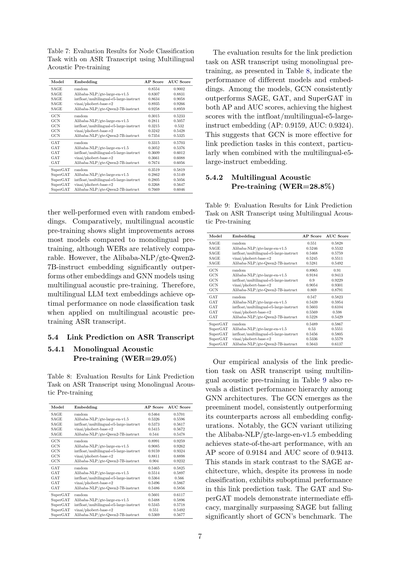

5.3 ASR書き起こしテキストでのノード分類

表6:単言語音響事前学習を使ったASR書き起こしテキストでのノード分類タスクの評価結果

5.3.1 単言語音響事前学習(WER=29.0%)

ASRで抽出した発話って、人間が書き起こしたものと比べるとノイズが多いから、精度が下がりがちやねん。表6のノード分類タスクの評価結果を見ると、前の実験と同じような傾向が見えるんやけど、ちょっと違うとこもあるわ。SAGEがどの埋め込みタイプでも他を圧倒しとって、ランダム埋め込みで最高のAPスコア0.8851、AUCスコア0.9204を達成しとるねん。もっと凝った埋め込み手法よりも良い成績やで。一方、GCN、GAT、SuperGATモデルはかなり後れを取っとるな。

| モデル | 埋め込み | APスコア | AUCスコア |

|--------|----------|----------|-----------|

| SAGE | random | 0.8851 | 0.9204 |

| SAGE | Alibaba-NLP/gte-large-en-v1.5 | 0.8108 | 0.8694 |

| SAGE | intfloat/multilingual-e5-large-instruct | 0.8591 | 0.9028 |

| SAGE | vinai/phobert-base-v2 | 0.7969 | 0.8597 |

| SAGE | Alibaba-NLP/gte-Qwen2-7B-instruct | 0.8661 | 0.9077 |

| GCN | random | 0.2974 | 0.5202 |

| GCN | Alibaba-NLP/gte-large-en-v1.5 | 0.2976 | 0.521 |

| GCN | intfloat/multilingual-e5-large-instruct | 0.2813 | 0.5052 |

| GCN | vinai/phobert-base-v2 | 0.3037 | 0.5211 |

| GCN | Alibaba-NLP/gte-Qwen2-7B-instruct | 0.326 | 0.5417 |

| GAT | random | 0.2813 | 0.5808 |

| GAT | Alibaba-NLP/gte-large-en-v1.5 | 0.3049 | 0.5406 |

| GAT | intfloat/multilingual-e5-large-instruct | 0.3342 | 0.5758 |

| GAT | vinai/phobert-base-v2 | 0.3334 | 0.5697 |

| GAT | Alibaba-NLP/gte-Qwen2-7B-instruct | 0.3521 | 0.5965 |

| SuperGAT | random | 0.2778 | 0.4998 |

| SuperGAT | Alibaba-NLP/gte-large-en-v1.5 | 0.3526 | 0.5909 |

| SuperGAT | intfloat/multilingual-e5-large-instruct | 0.2861 | 0.5145 |

| SuperGAT | vinai/phobert-base-v2 | 0.2751 | 0.4859 |

| SuperGAT | Alibaba-NLP/gte-Qwen2-7B-instruct | 0.328 | 0.5682 |

5.3.2 多言語音響事前学習(WER=28.8%)

表7の結果を見ると、多言語音響事前学習を使ったASR書き起こしテキストでのノード分類タスクで、モデル性能のパターンが分かるわ。SAGEがどの埋め込みタイプでもGCN、GAT、SuperGATを上回っとるねん。特に注目すべきは、SAGEとvinai/phobert-base-v2埋め込みの組み合わせで、AUCスコア0.9266というピーク性能を叩き出しとることやな。SAGEはさらに...

---

## Page 7

[](/attach/db6fabe5ad8a3edf90dfcbd09dabf0ba6410e571d6ea4fec2777279b885884d0_p007.png)

### 和訳

表7:多言語音響事前学習を使ったASR文字起こしでのノード分類タスクの評価結果

| モデル | エンベディング | APスコア | AUCスコア |

|--------|---------------|----------|-----------|

| SAGE | random | 0.8554 | 0.9002 |

| SAGE | Alibaba-NLP/gte-large-en-v1.5 | 0.8307 | 0.8831 |

| SAGE | intfloat/multilingual-e5-large-instruct | 0.8634 | 0.9058 |

| SAGE | vinai/phobert-base-v2 | 0.8935 | 0.9266 |

| SAGE | Alibaba-NLP/gte-Qwen2-7B-instruct | 0.9258 | 0.8959 |

| GCN | random | 0.3015 | 0.5233 |

| GCN | Alibaba-NLP/gte-large-en-v1.5 | 0.2811 | 0.5057 |

| GCN | intfloat/multilingual-e5-large-instruct | 0.3215 | 0.532 |

| GCN | vinai/phobert-base-v2 | 0.3242 | 0.5428 |

| GCN | Alibaba-NLP/gte-Qwen2-7B-instruct | 0.7354 | 0.5325 |

| GAT | random | 0.3315 | 0.5703 |

| GAT | Alibaba-NLP/gte-large-en-v1.5 | 0.3052 | 0.5376 |

| GAT | intfloat/multilingual-e5-large-instruct | 0.3609 | 0.6012 |

| GAT | vinai/phobert-base-v2 | 0.3661 | 0.6088 |

| GAT | Alibaba-NLP/gte-Qwen2-7B-instruct | 0.7674 | 0.6056 |

| SuperGAT | random | 0.3519 | 0.5819 |

| SuperGAT | Alibaba-NLP/gte-large-en-v1.5 | 0.2862 | 0.5149 |

| SuperGAT | intfloat/multilingual-e5-large-instruct | 0.2805 | 0.5056 |

| SuperGAT | vinai/phobert-base-v2 | 0.3268 | 0.5647 |

| SuperGAT | Alibaba-NLP/gte-Qwen2-7B-instruct | 0.7669 | 0.6046 |

ほんでな、SAGEってモデルがめっちゃ優秀でな、ランダムなエンベディング(テキストを数字に変換する方法のことやで)でもかなりええ成績出すねん。多言語の音響事前学習っていうのは、要するに色んな言語の音声データで先に学習させとくことやねんけど、これが単一言語だけで学習するよりちょっとだけ性能ええ結果出してんねん。まあWER(音声認識の間違い率のことや)はほぼ同じくらいやけどな。

でもな、ここでめっちゃ注目してほしいんがAlibaba-NLP/gte-Qwen2-7B-instructっていうエンベディングやねん。これがほんまにぶっちぎりで他のエンベディングとかGNNモデル(グラフ構造を扱うニューラルネットワークのことや)を圧倒的にぶち抜いてんねん。多言語音響事前学習と組み合わせた時にな。せやから結論としては、多言語対応の大規模言語モデルで作ったテキストエンベディングが、多言語音響事前学習のASR文字起こしに対するノード分類タスクでは最強やっちゅうことやな。

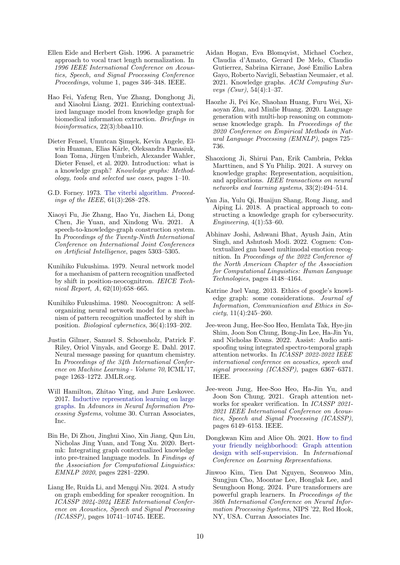

5.4 ASR文字起こしでのリンク予測

5.4.1 単一言語音響事前学習(WER=29.0%)

表8:単一言語音響事前学習を使ったASR文字起こしでのリンク予測タスクの評価結果

| モデル | エンベディング | APスコア | AUCスコア |

|--------|---------------|----------|-----------|

| SAGE | random | 0.5464 | 0.5701 |

| SAGE | Alibaba-NLP/gte-large-en-v1.5 | 0.5326 | 0.5596 |

| SAGE | intfloat/multilingual-e5-large-instruct | 0.5373 | 0.5617 |

| SAGE | vinai/phobert-base-v2 | 0.5415 | 0.5672 |

| SAGE | Alibaba-NLP/gte-Qwen2-7B-instruct | 0.544 | 0.5478 |

| GCN | random | 0.8991 | 0.9259 |

| GCN | Alibaba-NLP/gte-large-en-v1.5 | 0.9085 | 0.9262 |

| GCN | intfloat/multilingual-e5-large-instruct | 0.9159 | 0.9324 |

| GCN | vinai/phobert-base-v2 | 0.8811 | 0.8898 |

| GCN | Alibaba-NLP/gte-Qwen2-7B-instruct | 0.904 | 0.9232 |

| GAT | random | 0.5465 | 0.5825 |

| GAT | Alibaba-NLP/gte-large-en-v1.5 | 0.5514 | 0.5897 |

| GAT | intfloat/multilingual-e5-large-instruct | 0.5364 | 0.566 |

| GAT | vinai/phobert-base-v2 | 0.5496 | 0.5867 |

| GAT | Alibaba-NLP/gte-Qwen2-7B-instruct | 0.5486 | 0.5856 |

| SuperGAT | random | 0.5601 | 0.6117 |

| SuperGAT | Alibaba-NLP/gte-large-en-v1.5 | 0.5488 | 0.5896 |

| SuperGAT | intfloat/multilingual-e5-large-instruct | 0.5345 | 0.5718 |

| SuperGAT | vinai/phobert-base-v2 | 0.551 | 0.5492 |

| SuperGAT | Alibaba-NLP/gte-Qwen2-7B-instruct | 0.5369 | 0.5677 |

さて、単一言語事前学習使ったASR文字起こしでのリンク予測タスク(ノード同士がつながってるかどうかを当てる問題やな)の結果が表8に載ってるんやけど、これがまた面白いねん。

色んなモデルの中でな、GCNがSAGE、GAT、SuperGATを全部ぶっちぎって、APスコアもAUCスコアも両方でトップの成績叩き出してんねん。特にintfloat/multilingual-e5-large-instructっていうエンベディングと組み合わせた時が最強で、APスコア0.9159、AUCスコア0.9324や。これめっちゃすごい数字やで。

なんでかっていうと、GCNはリンク予測っていうタスクにおいてはほんまに相性ええんやな。特に多言語対応のe5-large-instructエンベディングとの組み合わせが最高やっちゅうことやわ。

5.4.2 多言語音響事前学習(WER=28.8%)

表9:多言語音響事前学習を使ったASR文字起こしでのリンク予測タスクの評価結果

| モデル | エンベディング | APスコア | AUCスコア |

|--------|---------------|----------|-----------|

| SAGE | random | 0.551 | 0.5828 |

| SAGE | Alibaba-NLP/gte-large-en-v1.5 | 0.5246 | 0.5532 |

| SAGE | intfloat/multilingual-e5-large-instruct | 0.5468 | 0.5759 |

| SAGE | vinai/phobert-base-v2 | 0.5245 | 0.5511 |

| SAGE | Alibaba-NLP/gte-Qwen2-7B-instruct | 0.5281 | 0.5492 |

| GCN | random | 0.8965 | 0.91 |

| GCN | Alibaba-NLP/gte-large-en-v1.5 | 0.9184 | 0.9413 |

| GCN | intfloat/multilingual-e5-large-instruct | 0.9 | 0.9229 |

| GCN | vinai/phobert-base-v2 | 0.9054 | 0.9301 |

| GCN | Alibaba-NLP/gte-Qwen2-7B-instruct | 0.869 | 0.8791 |

| GAT | random | 0.547 | 0.5823 |

| GAT | Alibaba-NLP/gte-large-en-v1.5 | 0.5439 | 0.5954 |

| GAT | intfloat/multilingual-e5-large-instruct | 0.5603 | 0.6104 |

| GAT | vinai/phobert-base-v2 | 0.5569 | 0.598 |

| GAT | Alibaba-NLP/gte-Qwen2-7B-instruct | 0.5228 | 0.5429 |

| SuperGAT | random | 0.5489 | 0.5867 |

| SuperGAT | Alibaba-NLP/gte-large-en-v1.5 | 0.53 | 0.5551 |

| SuperGAT | intfloat/multilingual-e5-large-instruct | 0.5456 | 0.5805 |

| SuperGAT | vinai/phobert-base-v2 | 0.5336 | 0.5579 |

| SuperGAT | Alibaba-NLP/gte-Qwen2-7B-instruct | 0.5643 | 0.6137 |

ほんで表9の多言語音響事前学習を使ったリンク予測の分析結果やねんけど、これまたはっきりした性能の序列が見えてくんねん。

GCNがまたまた王者やねん。どのエンベディング使っても他のモデルを圧倒してる。特に注目してほしいんが、Alibaba-NLP/gte-large-en-v1.5エンベディングと組み合わせたGCNや。これがAPスコア0.9184、AUCスコア0.9413っていう最高記録を叩き出してんねん。

面白いのはな、SAGEってモデルはさっきのノード分類ではめっちゃ強かったやん?でもリンク予測ではイマイチなんよ。これが機械学習の面白いとこでな、タスクによって得意不得意があるっちゅうことやな。GATとSuperGATは中間くらいの性能で、SAGEよりはちょっとマシやけど、GCNには全然届いてへんわ。

---

## Page 8

[](/attach/db6fabe5ad8a3edf90dfcbd09dabf0ba6410e571d6ea4fec2777279b885884d0_p008.png)

### 和訳

intfloat/multilingual-e5-large-instruct のembeddingは、どのモデルでも性能アップに貢献するんやけど、アーキテクチャによって効き具合がバラバラなんよな。

5.5 エラー分析

**人間が起こした書き起こしでのノード分類とリンク予測について:**

帰納学習(新しいデータにも対応できる学習方法な)やと、BERTベースのembeddingがめっちゃ大事で、これないとええ性能出えへんねん。でも転導学習(学習データの中だけで完結する方法)やったら、ランダムなテキストembeddingでも事前学習済みのやつとええ勝負できるんよ。

**ASR(音声認識)の書き起こしでのノード分類:**

まず一つ目やねんけど、ノイズまみれのASR書き起こしでも、単言語と多言語の音響事前学習の両方で、ランダムテキストembeddingがBERTベースのやつとタメ張れるんよ。これ、人間の書き起こしの転導学習と似たような傾向やな。

二つ目は、多言語LLMのテキストembeddingが、多言語音響事前学習したASR書き起こしのノード分類タスクで他をぶっちぎりで引き離すねん。ほんまに圧倒的やで。ちなみに、音声からKG(ナレッジグラフ)を学習する研究って、うちらが初めてやから直接比較できる先行研究がないんよ。ただ、多言語LLMテキストembeddingと多言語音響事前学習の組み合わせは、ASRとか(Lam-Yee-Muiら、2023年;Radfordら、2023年)、音声翻訳(Bapnaら、2022年;Babuら、2022年;Zhangら、2023年)、テキスト読み上げ(Saekiら、2023年;Zhangら、2019年)みたいな色んな下流タスクで、だいたい高い精度出してるんよな。

三つ目やけど、同じ転導学習の条件下で、ASR書き起こしのノード分類は、WER(単語誤り率)が28.8%とか29%とかめっちゃ高いにもかかわらず、人間の書き起こしと互角の結果を出してるんよ。これすごない?

**ASR書き起こしでのリンク予測:**

まず一つ目、ノイズだらけのASR書き起こしでも、単言語・多言語の音響事前学習の両方で、ランダムテキストembeddingがBERTベースやLLMのテキストembeddingと同レベルの性能出すねん。これも人間の書き起こしのリンク予測の転導学習で見られた傾向と一緒やな。

二つ目がびっくりやねんけど、同じ転導学習の条件で、ASR書き起こしのリンク予測が人間の書き起こしより良い結果出すことが多いんよ。WERが28.8%とか29%とか高いのにやで!普通、ASRのWERが高いと色んなNLP下流タスクの精度がガタ落ちするって、AI界隈ではめっちゃ言われてるやん(Desotら、2019年;Sundararamanら、2021年;Omachiら、2021年)。なんでかっていうと、テキストembeddingって文章の一般的な文脈(意味的なやつな)を主に見てるから、ASRのエラーが予測性能に与える影響を軽減してくれるんちゃうかって考えてるねん(Voletiら、2019年)。

三つ目やけど、ASR書き起こしでのノード分類とリンク予測両方の転導学習は、ゼロショット設定(学習なしでいきなりテストする方法な)でやってるんよ。訓練データのASR書き起こしに合わせてGNNモデルを適応させたら、もっと性能上がるんちゃうかなって仮説立ててるねん(Dinh、2021年;Maら、2023年)。

6 結論

この研究では、wav2graphっていう、音声データから教師あり学習でKGを構築する初めてのフレームワークを提案してるんよ。さらに、音声から作った初めての実世界KGとそのベースライン結果も出してるで。

うちらの研究で分かったことまとめるな。まず一つ目、ASR書き起こしでのノード分類とリンク予測タスクで、単言語・多言語両方の音響事前学習において、ランダムテキストembeddingがエンコーダベースやデコーダベースのembeddingとええ勝負するってこと。これは人間の書き起こしの転導学習でも同じ傾向やったな。

二つ目は、多言語LLMテキストembeddingが、多言語音響事前学習したASR書き起こしのノード分類タスクで、他のembeddingを圧倒的に上回るってこと。

三つ目、ASR書き起こしのノード分類は人間の書き起こしと互角の結果を出して、リンク予測に至ってはASR書き起こしの方が人間の書き起こしより良い結果出すことが多いってこと。WERが28.8%とか29%もあるのにやで!この予想外の結果は、テキストembeddingが文章の一般的な意味的文脈に注目してるから、ASRエラーの影響が軽減されてるんやろうな。これって、他の下流タスクに関する過去の研究とは真逆の結果なんよ。普通はASRエラーあったら性能落ちるって言われてたからな。

---

## Page 9

[](/attach/db6fabe5ad8a3edf90dfcbd09dabf0ba6410e571d6ea4fec2777279b885884d0_p009.png)

### 和訳

ASRの文字起こしでWER(単語誤り率)が高いと、だいたい精度がガクッと落ちるねん。

7 謝辞

VNUHCM工科大学のOanh Tranさんには、論文の下書き準備でめっちゃお世話になりました。ほんまにありがとうございます!

参考文献

2024. Qwen2テクニカルレポート。

Tareq Al-Moslmi, Marc Gallofré Ocaña, Andreas L Opdahl, and Csaba Veres. 2020. ナレッジグラフのための固有表現抽出:文献レビューやで。IEEE Access, 8:32862–32881.

Houda Alberts, Ningyuan Huang, Yash Deshpande, Yibo Liu, Kyunghyun Cho, Clara Vania, and Iacer Calixto. 2021. VisualSem:視覚と言語のための高品質ナレッジグラフやねん。多言語表現学習に関する第1回ワークショップ論文集, pages 138–152.

Arun Babu, Changhan Wang, Andros Tjandra, Kushal Lakhotia, Qiantong Xu, Naman Goyal, Kritika Singh, Patrick von Platen, Yatharth Saraf, Juan Pino, et al. 2022. XLS-R:大規模な自己教師あり多言語音声表現学習やで。Interspeech.

Alexei Baevski, Henry Zhou, Abdelrahman Mohamed, and Michael Auli. 2020a. Wav2vec 2.0:音声表現の自己教師あり学習のフレームワークやねん。第34回ニューラル情報処理システム国際会議論文集, NIPS'20.

Alexei Baevski, Yuhao Zhou, Abdelrahman Mohamed, and Michael Auli. 2020b. wav2vec 2.0:音声表現の自己教師あり学習のフレームワーク。Advances in neural information processing systems, 33:12449–12460.

Ankur Bapna, Colin Cherry, Yu Zhang, Ye Jia, Melvin Johnson, Yong Cheng, Simran Khanuja, Jason Riesa, and Alexis Conneau. 2022. mSLAM:音声とテキストの超大規模多言語事前学習やで。arXiv preprint arXiv:2202.01374.

Maximilian Bisani and Hermann Ney. 2008. 書記素から音素への変換のための結合系列モデル。Speech communication, 50(5):434–451.

Antoine Caubrière, Sophie Rosset, Yannick Estève, Antoine Laurent, and Emmanuel Morin. 2020. 音声からの固有表現認識、今どこまで来てるん?第12回言語資源評価会議論文集, pages 4514–4520.

Boli Chen, Guangwei Xu, Xiaobin Wang, Pengjun Xie, Meishan Zhang, and Fei Huang. 2022. AISHELL-NER:中国語音声からの固有表現認識やねん。ICASSP 2022-2022 IEEE国際音響・音声・信号処理会議 (ICASSP), pages 8352–8356. IEEE.

Qi Chen, Wei Wang, Kaizhu Huang, and Frans Coenen. 2021. ソーシャルメディアデータのためのナレッジグラフ埋め込みを使ったゼロショットテキスト分類。IEEE Internet of Things Journal, 9(12):9205–9213.

Xiaojun Chen, Shengbin Jia, and Yang Xiang. 2020. レビュー論文:ナレッジグラフ上の知識推論について。Expert systems with applications, 141:112948.

Alexis Conneau, Alexei Baevski, Ronan Collobert, Abdelrahman Mohamed, and Michael Auli. 2021. 音声認識のための教師なし多言語表現学習やで。Proc. Interspeech 2021, pages 2426–2430.

Thierry Desot, François Portet, and Michel Vacher. 2019. スマートホームの音声コマンド用SLU:パイプラインとエンドツーエンドアプローチの比較やねん。2019 IEEE自動音声認識・理解ワークショップ (ASRU), pages 822–829. IEEE.

Jacob Devlin, Ming-Wei Chang, Kenton Lee, and Kristina Toutanova. 2019. BERT:言語理解のための深層双方向トランスフォーマーの事前学習。2019年北米計算言語学会会議論文集:人間言語技術, 第1巻 (Long and Short Papers), pages 4171–4186.

Pranay Dighe, Saurabh Adya, Nuoyu Li, Srikanth Vishnubhotla, Devang Naik, Adithya Sagar, Ying Ma, Stephen Pulman, and Jason Williams. 2020. グラフニューラルネットワークを使った音声トリガーのためのラティスベースの改善手法。ICASSP 2020-2020 IEEE国際音響・音声・信号処理会議 (ICASSP), pages 7459–7463. IEEE.

Leo Breiman. 2017. 分類木と回帰木。Routledge.

Tu Anh Dinh. 2021. ゼロショット音声翻訳やで。arXiv preprint arXiv:2107.06010.

Chen Cai, Truong Son Hy, Rose Yu, and Yusu Wang. 2023. MPNNとグラフトランスフォーマーの関係について。第40回機械学習国際会議論文集, volume 202 of Proceedings of Machine Learning Research, pages 3408–3430. PMLR.

Vijay Prakash Dwivedi, Ladislav Rampášek, Mikhail Galkin, Ali Parviz, Guy Wolf, Anh Tuan Luu, and Dominique Beaini. 2022. 長距離グラフベンチマーク。第36回ニューラル情報処理システム会議 データセット・ベンチマークトラック.

9

---

## Page 10

[](/attach/db6fabe5ad8a3edf90dfcbd09dabf0ba6410e571d6ea4fec2777279b885884d0_p010.png)

### 和訳

Ellen EideとHerbert Gishが1996年に発表した研究やねんけど、声道の長さを正規化するパラメトリックな方法について書いてんねん。IEEE国際音響・音声・信号処理会議で発表されて、1巻の346〜348ページに載っとるで。

Hao Feiらが2021年に出した論文は、バイオ医療の情報抽出のために、知識グラフから文脈化された言語モデルを充実させるっていう内容やねん。Briefings in bioinformaticsの22巻3号に掲載されとるで。

Dieter Fenselらが2020年に書いた「知識グラフって何やねん?」っていう導入部分やな。知識グラフの方法論、ツール、選りすぐりの活用事例についての本の1〜10ページに載っとるで。

G.D. Forneyが1973年に発表したビタビアルゴリズムの論文や。Proceedings of the IEEEの61巻3号、268〜278ページやで。これ、めっちゃ有名な論文やねん。

Xiaoyi Fuらが2021年に発表したのは、音声から知識グラフを構築するシステムについてやねん。国際人工知能合同会議の論文集、5303〜5305ページに載っとるで。

福島邦彦先生が1979年に発表した論文は、位置ズレに影響されないパターン認識メカニズムのためのニューラルネットワークモデル、つまりネオコグニトロンについてやねん。IEICE技術報告Aの62巻10号、658〜665ページや。

同じく福島先生が1980年に出したネオコグニトロンの論文は、位置ズレに影響されないパターン認識の仕組みのための自己組織化ニューラルネットワークモデルについて書いとんねん。Biological cyberneticsの36巻4号、193〜202ページやで。これ、ディープラーニングの元祖みたいな研究やから、めっちゃ重要やねん。

Justin Gilmerらが2017年に発表したのは、量子化学のためのニューラルメッセージパッシングについてやねん。国際機械学習会議の論文集70巻、1263〜1272ページに載っとるで。分子の性質を予測するのに使えるんや。

Will Hamiltonらが2017年に発表したのは、大規模グラフでの帰納的表現学習についてやねん。Neural Information Processing Systemsの30巻に収録されとるで。グラフのノードの表現を学習する新しい方法を提案しとんねん。

Bin Heらが2020年に発表したBERT-MKは、グラフで文脈化された知識を事前学習済み言語モデルに統合するっていう研究やねん。計算言語学会EMNLP 2020のFindingsの2281〜2290ページに載っとるで。

Liang Heらが2024年に発表したのは、話者認識のためのグラフ埋め込みの研究やねん。IEEE ICASSP 2024で発表されて、10741〜10745ページに載っとるで。誰が喋ってるか識別するのにグラフを使うっていうアイデアや。

Aidan Hoganらが2021年にまとめた知識グラフについての包括的なサーベイ論文やねん。ACM Computing Surveysの54巻4号、1〜37ページに載っとるで。知識グラフについてガッツリ知りたかったら、まずこれ読んどき。

Haozhe Jiらが2020年に発表したのは、常識知識グラフ上でマルチホップ推論を使った言語生成についてやねん。EMNLP 2020で発表されて、725〜736ページに載っとるで。なんでかっていうと、AIに常識を教えるのってめっちゃ難しいから、知識グラフ使って何段階も推論させようっていう発想やねん。

Shaoxiong Jiらが2021年に出した知識グラフのサーベイ論文は、表現、獲得、応用についてまとめとんねん。IEEE Transactions on Neural Networks and Learning Systemsの33巻2号、494〜514ページやで。

Yan Jiaらが2018年に発表したのは、サイバーセキュリティのための知識グラフを構築する実践的なアプローチやねん。Engineeringの4巻1号、53〜60ページに載っとるで。セキュリティ分野でも知識グラフ使えるんやで。

Abhinav Joshiらが2022年に発表したCOGMENは、文脈化されたGNNベースのマルチモーダル感情認識についての研究やねん。NAACL 2022で発表されて、4148〜4164ページに載っとるで。言葉だけやなくて、色んな情報使って感情を読み取ろうっていう研究や。

Katrine Juel Vangが2013年に書いたのは、Googleの知識グラフの倫理についての考察やねん。Journal of Information, Communication and Ethics in Societyの11巻4号、245〜260ページに載っとるで。便利やけど、倫理的にどうなん?っていう視点も大事やからな。

Jee-weon Jungらが2022年に発表したAASISTは、統合されたスペクトル時間グラフアテンションネットワークを使った音声のなりすまし検出についてやねん。IEEE ICASSP 2022で発表されて、6367〜6371ページに載っとるで。偽物の音声を見破るための研究やねん。

同じくJee-weon Jungらが2021年に発表したのは、話者認証のためのグラフアテンションネットワークについてやねん。IEEE ICASSP 2021で発表されて、6149〜6153ページに載っとるで。

Dongkwan KimとAlice Ohが2021年に発表したのは、自己教師あり学習を使ったグラフアテンションの設計方法についてやねん。ICLR(国際学習表現会議)で発表されとるで。

Jinwoo Kimらが2024年に発表した研究は、純粋なTransformerがめっちゃ強力なグラフ学習器になれるっていう内容やねん。NeurIPS 2022の論文集に収録されとるで。Transformerだけでグラフも学習できるんや、すごいやろ?

---

## Page 11

[](/attach/db6fabe5ad8a3edf90dfcbd09dabf0ba6410e571d6ea4fec2777279b885884d0_p011.png)

### 和訳

Diederik P KingmaとJimmy Baの2014年の研究やねん。「Adam」っていう確率的最適化の手法について書いてはるんやけど、これがめっちゃ便利なやつでな、機械学習でパラメータを調整するときに使う最適化アルゴリズムのことやねん。arXivっていうプレプリントサーバーに載ってるで。

Thomas N KipfとMax Wellingは2016年にグラフ畳み込みネットワーク(GCN)を使った半教師あり分類について発表してはんねん。なんでかっていうと、データの一部にしかラベルがついてなくても、グラフ構造を使ってうまく分類できるようにする手法やからな。これもarXivのプレプリントや。

同じKipfとWellingが2017年にICLRっていう国際学会でも同じテーマで発表してはるで。学会にも認められたってことやな。

Léa-Marie Lam-Yee-Muiらは2023年に、言語埋め込みを使った多言語モデルで、リソースが少ない言語の音声認識をする研究を発表してはんねん。要するに、データがあんまりない言語でも音声認識できるようにしようって話や。SIGUL 2023っていうリソースの少ない言語を扱う研究会で発表されとるで。

Khai Le-Ducは2023年に、HYKISTプロジェクトでベトナム語の自動音声認識のための教師なし事前学習についての論文を出してはるねん。これはFHアーヘン応用科学大学での学士論文やったらしいで。

同じKhai Le-Ducが2024年には「VietMed」っていうベトナム語の医療分野の音声認識用データセットとベンチマークを作った論文を発表してはんねん。LREC-COLING 2024っていう計算言語学と言語資源の国際会議で発表されとるで。

Khai Le-Ducらは2024年に医療分野の音声からの固有表現認識についても研究してはるねん。音声から病名とか薬の名前とかを抽出する技術やな。

Jens Lehmannらは2015年にDBpediaについての論文を出してはんねん。これ、Wikipediaから抽出した大規模で多言語対応の知識ベースのことやねん。めっちゃ便利なリソースで、いろんな研究で使われとるで。Semantic webっていうジャーナルに載ってるわ。

Jing Liらは2020年に固有表現認識のための深層学習についてのサーベイ論文を書いてはんねん。固有表現認識っていうのは、テキストから人名とか地名とか組織名とかを見つけ出す技術のことやで。IEEE transactions on knowledge and data engineeringに載っとるで。

Jingye Liらは2022年に、固有表現認識を単語と単語の関係分類として統一的に扱う手法を提案してはんねん。AAAI 2022で発表されとるで。

Xin Liらは2024年に「GraphAdapter」っていう、二つの知識グラフを使って視覚言語モデルをチューニングする手法を発表してはんねん。NeurIPSに載っとるで。

Yan Liらは2023年に、グラフLSTMニューラルネットワークを使った音声感情認識の研究を発表してはんねん。声から感情を読み取る技術やな。EURASIP Journal on Audio, Speech, and Music Processingに載っとるで。

Zehan Liらは2023年に、多段階の対照学習を使って汎用的なテキスト埋め込みを作る方法について研究してはんねん。テキストをベクトルに変換する技術をより汎用的にしようって話やな。arXivのプレプリントやで。

Yinhan Liuらは2019年に「RoBERTa」っていうBERTの改良版を発表してはんねん。BERTの事前学習をもっと頑健に最適化したアプローチやねん。めっちゃ有名なモデルやで。arXivのプレプリントや。

Christoph Lüscherらは2023年に、リソースの少ない医療分野の会話電話音声のためのハイブリッド音声認識システムの開発について発表してはんねん。ITG Conferenceで発表されとるで。

Rao Maらは2023年に、生成型の大規模言語モデルで音声認識のエラー修正ができるかどうかを調べた研究を発表してはんねん。ChatGPTみたいなモデルで音声認識の間違いを直せるかって話やな。arXivのプレプリントやで。

Yajie Miaoらは2015年に、i-vectorを使った深層ニューラルネットワーク音響モデルの話者適応学習について研究してはんねん。特定の話者に合わせてモデルを調整する技術やな。IEEE/ACM Transactions on Audio, Speech, and Language Processingに載っとるで。

Hermann Neyらは1994年に、確率的言語モデリングにおける確率的依存関係の構造化について研究してはんねん。言語モデルの基礎的な研究やな。Computer Speech & Languageに載っとるで。

Nhat Khang Ngoらは2023年に、マルチ解像度グラフトランスフォーマーとウェーブレット位置エンコーディングを使って、長距離と階層構造を学習する方法を提案してはんねん。The Journal of Chemical Physicsに載っとるで。

Dat Quoc NguyenとAnh Tuan Nguyenは2020年に「PhoBERT」っていうベトナム語用の事前学習済み言語モデルを発表してはんねん。EMNLP 2020のFindingsに載っとるで。

Binling Nieらは2021年に「KA-NER」っていう知識を活用した固有表現認識の手法を提案してはんねん。CCKS 2021っていう中国の知識グラフとセマンティックコンピューティングの会議で発表されとるで。

Giannis Nikolentzosらは2020年に「K-hopグラフニューラルネットワーク」について研究してはんねん。グラフ上でK個先のノードまで情報を集約する手法やな。Neural Networksっていうジャーナルに載っとるで。

---

## Page 12

[](/attach/db6fabe5ad8a3edf90dfcbd09dabf0ba6410e571d6ea4fec2777279b885884d0_p012.png)

### 和訳

Motoi Omachiら(2021年)は、音声認識のEnd-to-Endモデルで文字起こしと言語的な注釈を同時に予測する方法を提案してんねん。これ、北米計算言語学会の2021年の会議で発表されてて、1861から1871ページに載ってるで。

Stefan Ortmannsら(1997年)は、大語彙の連続音声認識のためのワードグラフアルゴリズムっていうのを考えてん。要するにめっちゃたくさんの単語を扱える音声認識のための手法やな。Computer Speech & Language誌の11巻1号、43から72ページに掲載されてるで。

Myle Ottら(2019年)は「fairseq」っていう、系列モデリングのための高速で拡張しやすいツールキットを作ってん。これ、めっちゃ便利なやつで、北米計算言語学会2019年のデモセッションで発表されてるねん。

Shirui Panら(2024年)は、大規模言語モデルと知識グラフを統合するロードマップを示してん。なんでかっていうと、両方の強みを活かしたらもっとすごいことできるやろってことやな。IEEE Transactions on Knowledge and Data Engineeringに載ってるで。

Daniel S Parkら(2019年)は「SpecAugment」っていう、自動音声認識のためのシンプルなデータ拡張手法を提案してん。めっちゃシンプルやのに効果抜群っていう、ほんまにええ方法やねん。Interspeechで発表されたで。

Adam Paszkeら(2019年)は「PyTorch」を作ってん。これ、命令型スタイルで高性能な深層学習ライブラリやねん。今やみんな使ってる超有名なやつやな。Neural Information Processing Systemsの32巻に載ってるで。

Alec Radfordら(2023年)は、大規模な弱教師あり学習を使った頑健な音声認識の方法を示してん。要するに、完璧じゃないラベルでもめっちゃたくさん使ったら、強い音声認識ができるっていう話やな。機械学習の国際会議で発表されて、28492から28518ページに載ってるで。

Ladislav Rampášekら(2022年)は、汎用的で強力でスケーラブルなグラフTransformerのレシピを提案してん。Neural Information Processing Systemsの35巻、14501から14515ページやで。

David Rybachら(2011年)は「RASR」っていう、アーヘン工科大学のオープンソース音声認識ツールキットを発表してん。2011年のIEEE自動音声認識・理解ワークショップで紹介されたで。

Takaaki Saekiら(2023年)は「Virtuoso」っていう、大規模多言語の音声テキスト共同半教師あり学習による音声合成の手法を提案してん。ICASSP 2023で発表されてるで。

Noam Shazeer(2020年)は、GLUの変種がTransformerを改善するっていう論文を出してん。arXivのプレプリント(arXiv:2002.05202)で読めるで。

Prachi Singhら(2023年)は、話者ダイアライゼーション(誰がいつ喋ってるか分ける技術やな)のために、グラフニューラルネットワークを使った教師あり階層的クラスタリングを提案してん。ICASSP 2023で発表されたで。

Thomas Pellissier Tanonら(2016年)は「FreebaseからWikidataへ:大移行」っていう論文を書いてん。要するに、でっかい知識ベースの引っ越し作業の話やな。第25回WWW国際会議の1419から1428ページに載ってるで。

Nitish Srivastavaら(2014年)は「Dropout」っていう、ニューラルネットワークの過学習を防ぐシンプルな方法を提案してん。これ、めっちゃ有名な手法で、機械学習研究ジャーナルの15巻1号、1929から1958ページに載ってるで。

Ciyuan Pengら(2023年)は、知識グラフの機会と課題についてまとめてん。Artificial Intelligence Review誌の56巻11号、13071から13102ページやで。

Anastasia Pentariら(2024年)は、グラフベースの表現を使った音声感情認識を提案してん。Scientific Reports誌の14巻1号、4484ページに載ってるで。

Alina Petukhovaら(2024年)は、大規模言語モデルの埋め込みを使ったテキストクラスタリングについて書いてん。arXivプレプリント(arXiv:2403.15112)で読めるで。

Trang Phamら(2017年)は、仮想ノードを使った深層学習によるグラフ分類を提案してん。arXivプレプリント(arXiv:1708.04357)やで。

Thomas Steinerら(2012年)は、Googleの知識グラフにリアルタイムカバレッジを追加する方法を示してん。第11回国際セマンティックWeb会議の914巻、65から68ページに載ってるで。

Jianlin Suら(2024年)は「RoFormer」っていう、回転位置埋め込みで強化されたTransformerを提案してん。Neurocomputing誌の568巻、127063やで。

Dianbo Suiら(2021年)は、音声の手がかりを含む大規模中国語マルチモーダル固有表現認識データセットを作ってん。計算言語学会と自然言語処理国際共同会議の第59回年次大会で発表されたで。

---

## Page 13

[](/attach/db6fabe5ad8a3edf90dfcbd09dabf0ba6410e571d6ea4fec2777279b885884d0_p013.png)

### 和訳

言語処理(第1巻:長編論文)、2807-2818ページ

Guangzhi Sun、Chao Zhang、Philip C Woodland。2022年。文脈対応の音声認識のための、グラフニューラルネットワークエンコーディングを使った木構造制約付きポインタジェネレータ。Interspeech。

Mukuntha Narayanan Sundararaman、Ayush Kumar、Jithendra Vepa。2021年。Phoneme-BERT:音素列とASR書き起こしの同時言語モデリング。Interspeech。

Piotr Szymański、Lukasz Augustyniak、Mikolaj Morzy、Adrian Szymczak、Krzysztof Surdyk、Piotr Żelasko。2023年。なんでワイらまだNERできてへんねん?自発発話の書き起こしにおける固有表現認識でのASRエラーの影響について。計算言語学会第61回年次大会論文集(第1巻:長編論文)、1746-1761ページ。

Anjali Thukral、Shivani Dhiman、Ravi Meher、Punam Bedi。2023年。医療応用のためのNLP、NER、バイオメディカルオントロジーを使った臨床記述からの知識グラフ拡充。International Journal of Information Technology、15(1):53-65。

Ahmet UyarとFarouk Musa Aliyu。2015年。Googleナレッジグラフとbing Satoriの検索機能の評価:エンティティタイプ、リスト検索、クエリインターフェース。Online Information Review、39(2):197-213。

Ashish Vaswani、Noam Shazeer、Niki Parmar、Jakob Uszkoreit、Llion Jones、Aidan N Gomez、Łukasz Kaiser、Illia Polosukhin。2017年。Attentionがあればええねん。Advances in neural information processing systems、30。

Petar Veličković、Guillem Cucurull、Arantxa Casanova、Adriana Romero、Pietro Lio、Yoshua Bengioら。2017年。グラフアテンションネットワーク。stat、1050(20):10-48550。

Petar Veličković、Guillem Cucurull、Arantxa Casanova、Adriana Romero、Pietro Liò、Yoshua Bengio。2018年。グラフアテンションネットワーク。International Conference on Learning Representations。

Peter Vieting、Christoph Lüscher、Julian Dierkes、Ralf Schlüter、Hermann Ney。2023年。リソースが少ないASRのための大規模事前学習モデルの効率的活用。2023 IEEE国際音響・音声・信号処理ワークショップ(ICASSPW)、1-5ページ。IEEE。

Rohit Voleti、Julie M Liss、Visar Berisha。2019年。単語置換エラーが文埋め込みに与える影響の調査。ICASSP 2019-2019 IEEE国際音響・音声・信号処理会議(ICASSP)、7315-7319ページ。IEEE。

Bo Wang、Tao Shen、Guodong Long、Tianyi Zhou、Ying Wang、Yi Chang。2021年。効率的な知識グラフ補完のための構造拡張テキスト表現学習。The Web Conference 2021論文集、1737-1748ページ。

Jixuan Wang、Xiong Xiao、Jian Wu、Ranjani Ramamurthy、Frank Rudzicz、Michael Brudno。2020年。グラフニューラルネットワークを使ったセッションレベル話者埋め込み精緻化による話者ダイアライゼーション。ICASSP 2020-2020 IEEE国際音響・音声・信号処理会議(ICASSP)、7109-7113ページ。IEEE。

Liang Wang、Nan Yang、Xiaolong Huang、Linjun Yang、Rangan Majumder、Furu Wei。2023年。大規模言語モデルによるテキスト埋め込みの改善。arXivプレプリント arXiv:2401.00368。

Liang Wang、Nan Yang、Xiaolong Huang、Linjun Yang、Rangan Majumder、Furu Wei。2024年。多言語E5テキスト埋め込み:技術レポート。arXivプレプリント arXiv:2402.05672。

Zhen Wang、Jianwen Zhang、Jianlin Feng、Zheng Chen。2014年。知識グラフとテキストの同時埋め込み。2014年自然言語処理における経験的手法会議(EMNLP)論文集、1591-1601ページ。

Tongtong Wu、Guitao Wang、Jinming Zhao、Zhaoran Liu、Guilin Qi、Yuan-Fang Li、Gholamreza Haffari。2022年。音声からの関係抽出に向けて。arXivプレプリント arXiv:2210.08759。

Hemant Yadav、Sreyan Ghosh、Yi Yu、Rajiv Ratn Shah。2020年。英語音声からのエンドツーエンド固有表現認識。Interspeech、2299(1473):3772。

Michihiro Yasunaga、Hongyu Ren、Antoine Bosselut、Percy Liang、Jure Leskovec。2021年。QA-GNN:質問応答のための言語モデルと知識グラフによる推論。北米計算言語学会(NAACL)。

Chengxuan Ying、Tianle Cai、Shengjie Luo、Shuxin Zheng、Guolin Ke、Di He、Yanming Shen、Tie-Yan Liu。2021年。Transformerってほんまにグラフ表現に弱いんか?Advances in neural information processing systems、34:28877-28888。

Fei Yu、Jiji Tang、Weichong Yin、Yu Sun、Hao Tian、Hua Wu、Haifeng Wang。2021年。ERNIE-ViL:シーングラフによる知識強化された視覚言語表現。AAAI人工知能会議論文集、第35巻、3208-3216ページ。

Albert Zeyer、Tamer Alkhouli、Hermann Ney。2018年。翻訳と音声に応用できる汎用的で柔軟なニューラルツールキットとしてのRETURNN

13

---

## Page 14

[](/attach/db6fabe5ad8a3edf90dfcbd09dabf0ba6410e571d6ea4fec2777279b885884d0_p014.png)

### 和訳

Yu Zhang, Wei Han, James Qin, Yongqiang Wang, Ankur Bapna, Zhehuai Chen, Nanxin Chen, Bo Li, Vera Axelrod, Gary Wangら。2023年。Google USM:自動音声認識を100言語以上に拡張するっちゅう話やねん。arXivプレプリント arXiv:2303.01037。

Yu Zhang, Ron J Weiss, Heiga Zen, Yonghui Wu, Zhifeng Chen, RJ Skerry-Ryan, Ye Jia, Andrew Rosenberg, Bhuvana Ramabhadran。2019年。外国語をペラペラ喋れるようになる方法:多言語音声合成と言語をまたいだ声のクローン技術やで。Interspeech。

Lingfeng Zhong, Jia Wu, Qian Li, Hao Peng, Xindong Wu。2023年。知識グラフを自動で作る技術についてめっちゃ詳しくまとめた総説やねん。ACM Computing Surveys、56巻4号、1-62ページ。

Xiangru Zhu, Zhixu Li, Xiaodan Wang, Xueyao Jiang, Penglei Sun, Xuwu Wang, Yanghua Xiao, Nicholas Jing Yuan。2022年。マルチモーダル知識グラフの構築と応用:サーベイ論文やで。なんでかっていうと、テキストだけじゃなくて画像とかいろんなデータを組み合わせた知識グラフがほんまに大事になってきてるからやねん。IEEE Transactions on Knowledge and Data Engineering、36巻2号、715-735ページ。

14

---

## Page 15

[](/attach/db6fabe5ad8a3edf90dfcbd09dabf0ba6410e571d6ea4fec2777279b885884d0_p015.png)

### 和訳

目次

1 はじめに

2 データ

2.1 データの集め方

2.2 データの統計情報

3 wav2graph(音声からグラフ作るやつ)

3.1 ASRモデル(音声認識のやつやな)

3.2 ノード埋め込み(グラフの点をベクトルにするやつ)

3.3 ノード分類とリンク予測(点の種類当てと、つながり予測やな)

3.4 GNNモデル(グラフ用のニューラルネットワークやで)

4 実験のセットアップ

4.1 ASRモデル

4.2 知識グラフとGNNモデル

4.3 評価指標(どうやって性能測るかやな)

5 実験結果

5.1 人が書き起こしたやつでノード分類

5.1.1 帰納学習(新しいデータにも対応できるやつ)

5.1.2 転導学習(学習時に見たデータだけ対象のやつ)

5.2 人が書き起こしたやつでリンク予測

5.2.1 帰納学習

5.2.2 転導学習

5.3 ASRの書き起こしでノード分類

5.3.1 単言語の音響事前学習(WER=29.0%、つまり認識エラー率やな)

5.3.2 多言語の音響事前学習(WER=28.8%)

5.4 ASRの書き起こしでリンク予測

5.4.1 単言語の音響事前学習(WER=29.0%)

5.4.2 多言語の音響事前学習(WER=28.8%)

5.5 エラー分析(どこでミスったか見るやつ)

6 まとめ

7 謝辞

付録A 関連研究

付録B 実験セットアップの詳細

B.1 ASRモデル

B.2 知識グラフとGNNモデル

B.3 ノード埋め込み

B.4 評価指標の詳細

付録C 追加の実験結果

C.1 人が書き起こしたやつでノード分類

C.2 人が書き起こしたやつでリンク予測

C.3 ASRの書き起こしでノード分類

C.3.1 単言語の音響事前学習(WER=29.0%)

C.3.2 多言語の音響事前学習(WER=28.8%)

C.4 ASRの書き起こしでリンク予測

---

## Page 16

[](/attach/db6fabe5ad8a3edf90dfcbd09dabf0ba6410e571d6ea4fec2777279b885884d0_p016.png)

### 和訳

C.4.1 単言語の音声事前学習(WER=29.0%). . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

C.4.2 多言語の音声事前学習(WER=28.8%)

29

31

16

---

ちょっと待って、これ目次やん!説明しとくと、WERっていうのは「単語誤り率」のことで、数字が小さいほど音声認識の精度がええってことやねん。単言語より多言語で事前学習した方がちょっとだけ精度ええ(29.0%→28.8%)っていう結果が載ってるページ番号を示してるんやな。

---

## Page 17

[](/attach/db6fabe5ad8a3edf90dfcbd09dabf0ba6410e571d6ea4fec2777279b885884d0_p017.png)

### 和訳

A 関連研究

ここからは、うちらのwav2graphフレームワークに関係ある研究について説明していくで。

**音声からナレッジグラフを作る話:** ナレッジグラフ(知識をつなげた図みたいなやつやな)を作る研究って、これまでずっとテキストから情報を抜き出すのがメインやったんよ(Zhong et al., 2023; Wang et al., 2021, 2014; Chen et al., 2021)。画像とテキストを組み合わせたマルチモーダル(複数の情報源を使うってことやな)の研究も進んできてはおるけど(Zhu et al., 2022; Li et al., 2024; Alberts et al., 2021; Yu et al., 2021)、音声データから直接ナレッジグラフを作るっていう課題は、ほとんど手つかずの状態やねん。うちらが調べた限りで見つかった数少ない関連研究の中で、Fu et al.(2021)が「音声から自動でナレッジグラフを作る初めてのシステムや」って主張しとるのがあったわ。あと、Wu et al.(2022)は「音声関係抽出」っていう新しい情報抽出タスクを提案して、ASR(音声認識のことやな)で作った合成テキストから関係性を抜き出してナレッジグラフを構築したんや。でもな、うちらが知る限り、そういうナレッジグラフを使って学習させた研究はまだないんよ。なんでナレッジグラフの学習が大事かっていうと、GNNモデル(グラフニューラルネットワークっていう、グラフ構造を学習できるAIやな)がナレッジグラフの中のデータから複雑なパターンや関係性を学んで一般化できるようになって、まだ見たことないデータに対しても予測できるようになるからやねん。これはルールベースの方法だけじゃ絶対できへんことなんよ。

**音声からの情報抽出:** めっちゃ膨大で構造化されてないデータの中から、エンティティ(人とか場所とか、識別できる対象のことやな)とその関係性を正確に見つけ出すのって、テキストベースのナレッジグラフがもっと広まるのを阻んでる大きな壁なんよ(Peng et al., 2023)。こういう関係性は普通、NERシステム(固有表現認識っていう、テキストから人名とか地名を見つけるやつやな)で抽出するんやけど(Li et al., 2022, 2020)、音声に対してNERをやるのは、音声ベースのナレッジグラフを作るのに必要やのに、まだまだめっちゃ難しい課題として残っとるんや(Chen et al., 2022; Sui et al., 2021; Szymański et al., 2023; Yadav et al., 2020; Caubrière et al., 2020)。

**音声応用でのGNN:** GNNは音声関連のいろんな応用でええ結果を出しとるで。例えば、Wang et al.(2020)とSingh et al.(2023)はスピーカーダイアリゼーション(誰がいつ喋ったかを識別するやつやな)を改善するのにGNNを使っとるし、Pentari et al.(2024)、Joshi et al.(2022)、Li et al.(2023a)は音声感情認識に使っとる。あと、話者検証タスク(Jung et al., 2021; He et al., 2024; Jung et al., 2022)やASR仮説デコーディング(Dighe et al., 2020; Sun et al., 2022)にもGNNが使われとるんや。でもな、こういう進歩があっても、既存のGNNベースのアプローチは音声データから直接ナレッジグラフを構築して学習するっていうことには取り組んでへんのよ。それができたら、発話間の属性や関係性を予測できるようになるのにな。

**GNNについて:** グラフ表現学習はここ数年でめっちゃ進化しとって、グラフ構造を意味のあるノード特徴量に組み込むいろんなアプローチが考案されてきたんや。例えば、グラフ畳み込みネットワーク(GCN)(Kipf and Welling, 2016)とメッセージパッシングニューラルネットワーク(MPNN)(Gilmer et al., 2017)がこの分野を開拓して、メッセージパッシングっていう仕組みを提案したんや。これは各ノードが隣接ノードから特徴を集約するってやり方やな。その後のグラフアテンションネットワーク(GAT)(Velickovic et al., 2017)では、重要なノードを優先する仕組みが導入されたんや。でもな、これらの古典的なアプローチは遠く離れたノード間の関係を捉えるのが苦手なことが多いんよ(Dwivedi et al., 2022)。この限界を解決するために、研究者たちはメッセージパッシングの枠組みの中で仮想ノード(Pham et al., 2017; Cai et al., 2023)やk-ホップ近傍(Nikolentzos et al., 2020)を探求してきたわ。もっと最近では、グラフトランスフォーマーが注目されとって、TokenGT(Kim et al., 2024)やGraphormer(Ying et al., 2021)みたいなモデルが中心性とか空間情報みたいな洗練されたエンコーディングを取り入れとるんや。GraphGPSはこのアプローチをさらに進めて、いろんな位置エンコーディングや構造エンコーディングを複数のグラフブロックタイプと組み合わせたんや(Rampášek et al., 2022)。さらに、Ngo et al.(2023)は階層的なグラフ粗視化を学習して、位置エンコーディングにグラフウェーブレット変換を使うマルチスケールグラフトランスフォーマーを提案しとる。こういうグラフ表現学習の進歩によって、局所的にもグローバルにもグラフ構造を捉える能力がめっちゃ向上して、より効果的なグラフベースの機械学習モデルへの道が開かれたってわけや。

B 実験設定の詳細

このセクションでは、実験の再現性のために実験設定の詳細を説明するで。本論文のセクション4を拡張した内容になっとるわ。

---

## Page 18

[](/attach/db6fabe5ad8a3edf90dfcbd09dabf0ba6410e571d6ea4fec2777279b885884d0_p018.png)

### 和訳

[翻訳エラー: 実行エラー: [Errno 2] No such file or directory: 'claude']

---

## Page 19

[](/attach/db6fabe5ad8a3edf90dfcbd09dabf0ba6410e571d6ea4fec2777279b885884d0_p019.png)

### 和訳

## w2v2-Vietモデルとか事前学習の話

w2v2-Vietっていうモデルはな、1204時間分のラベルなしベトナム語データで事前学習してんねん。一方でXLSR-53-Vietの方もおんなじ1204時間のベトナム語データ使ってんねんけど、こっちは多言語対応のXLSR-53っていう既存モデルを土台にしてスタートしとんねん(Conneauらが2021年に出したやつやな)。両方とも1億1800万個のパラメータ持っとって、おんなじトレーニングセットでファインチューニングしてんねん。テストセットでの単語誤り率はそれぞれ29.0%と28.8%やったで。

## B.2 知識グラフとGNNモデルの話

ここは本文のセクション4.2をもうちょい詳しく説明するとこやで。

**知識グラフの前処理について:** 知識グラフはな、まず前処理せなあかんねん。具体的には、エンティティ(実体)と関係のタイプを特定して、属性を正規化して、エッジの特徴量をええ感じに設計したりすんねん。この知識グラフには2種類のノードがあんねん:発話ノード(例えば「医者が病院に行く」みたいなやつ)と固有表現ノード(例えば「医者」は人物、「病院」は場所、みたいな感じやな)。固有表現は発話文から抽出してんねん。

**ハイパーパラメータのチューニングについて:** ハイパーパラメータのチューニングではな、各GNNモデルの隠れ層の組み合わせとメッセージパッシングの集約関数を最適化することに集中すんねん。最初の設定では、固定のハイパーパラメータで学習すんねん:250エポック(SAGEだけは10エポック)、学習率0.005、重み減衰0.05、Adamオプティマイザ(KingmaとBaが2014年に出したやつ)、ドロップアウト率はノード分類タスクで0.2、リンク予測タスクで0.5やな(Srivastavaらが2014年に出したやつ)。2番目と3番目の設定でもおんなじハイパーパラメータ使うで。

## B.3 ノード埋め込みの話

ここも本文のセクション4.2の詳細説明やで。

ワイらはエンコーダベースの埋め込みとデコーダベースの埋め込み、両方使ってんねん。エンコーダベースには英語用のAlibaba-NLP/gte-large-en-v1.5(Liらが2023年に出したやつ)、多言語対応のintfloat/multilingual-e5-large-instruct(Wangらが2024年に出したやつ)、ベトナム語用のvinai/phobert-base-v2(NguyenとNguyenが2020年に出したやつ)を使ってん。デコーダベースには多言語LLMのAlibaba-NLP/gte-Qwen2-7B-instruct(2024年のやつ)を使ってんねん。あと比較用にランダム埋め込み(Paszkeらが2019年に出したやつ)も使ってるで。埋め込み取得に使ったモデルは以下の通りやで:

- **ランダム埋め込み:** 特徴量をランダムに初期化すんねん(Paszkeらが2019年に出したやつ)。平均0、分散1の正規分布から取った乱数でテンソル埋めるんやな。これは埋め込み比較のベースラインとして使うねん。

- **Alibaba-NLP/gte-large-en-v1.5:** 汎用的なテキスト埋め込みモデルやねん。多段階の対照学習で作られとって、エンコーダのバックボーン(BERTにRoPEとGLU足したやつ)の上に構築されとんねん(DevlinらのBERTは2019年、SuらのRoPEは2024年、ShazeerのGLUは2020年やな)。

- **intfloat/multilingual-e5-large-instruct:** オープンソースの多言語E5テキスト埋め込みモデルで、2023年中頃にリリースされたやつやねん。学習手順は英語E5モデルのレシピに従っとって、まず10億個の多言語テキストペアで対照学習の事前学習して、その後ラベル付きデータセットを組み合わせてファインチューニングしてんねん。

- **vinai/phobert-base-v2:** ベトナム語用に事前学習されたRoBERTa言語モデルやねん(Liuらが2019年に出したRoBERTaベースやで)。

- **Alibaba-NLP/gte-Qwen2-7B-instruct:** これがgte(汎用テキスト埋め込み)モデルファミリーの最新モデルで、70億パラメータもあんねん。

## B.4 評価指標の詳細

**AP指標について:** AP(平均適合率)っちゅうのはな、適合率-再現率曲線をひとつの数値にまとめたもんやねん。各閾値での適合率を、前の閾値からの再現率の増加分で重み付けした平均値やな。要するに、分類器の性能をひとつの数字で表してくれるから、めっちゃ便利やねん。特にクラスの偏りがあるデータセット、つまり一方のクラスのサンプル数がめっちゃ少ないような状況で役立つで。

---

## Page 20

[](/attach/db6fabe5ad8a3edf90dfcbd09dabf0ba6410e571d6ea4fec2777279b885884d0_p020.png)

### 和訳

ノード分類タスクの話やねんけど、ĉvってのはノードvの本当のラベル(正解データやな)で、cvはそのノードvが「このクラスに属してるで〜」っていう予測確率のことやねん。リンク予測タスクの方は、êu,vがノードuとvの間にエッジ(つながり)があるかないかの正解ラベルで、eu,vはその2つのノード間にエッジがありそうかどうかの予測確率やな。ほんで、予測確率cvとeu,vを大きい順にソートしていくねん。最終的にAPスコア(平均適合率)はこう計算するで:

AP = Σn (Rn − Rn−1)Pn (16)

ここでPnとRnは、n番目の閾値(しきい値)での適合率と再現率のことやねん。めっちゃ簡単に言うと、「どんだけ正確に当てられたか」と「どんだけ見つけ出せたか」やな。

AUC指標:AUCってのは分離度、つまりモデルがクラスをどんだけ上手に見分けられるかを表す指標やねん。ROC曲線っていうのは、二値分類器(「これかあれか」を判定するやつ)の判別能力を、閾値を変えながらグラフで見せてくれるもんやな。TPR(t)とFPR(t)は閾値tでの真陽性率と偽陽性率のことや。なんでかっていうと、真陽性率は「本当に正解のやつをどんだけ正解って言えたか」で、偽陽性率は「間違ってるのに正解って言うてもうた割合」やねん。AUCはこう計算するで:

AUC = ∫₀¹ TPR(FPR⁻¹(x)) dx (17)

この積分は、ROC曲線の下の面積を計算してるってことや。面積がでかいほど、モデルの性能がええってことやな!

---

## Page 21

[](/attach/db6fabe5ad8a3edf90dfcbd09dabf0ba6410e571d6ea4fec2777279b885884d0_p021.png)

### 和訳

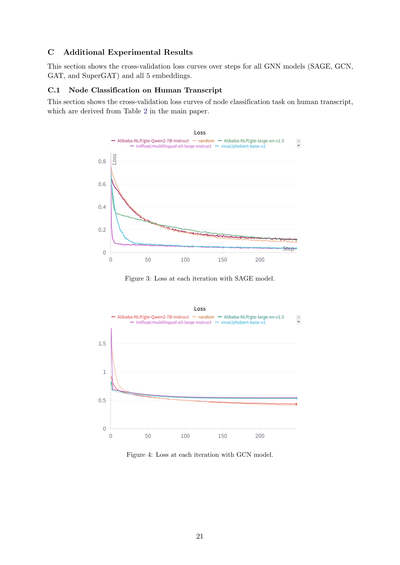

C 追加の実験結果について

このセクションではな、交差検証の損失曲線ってやつを全部のGNNモデル(SAGE、GCN、GAT、SuperGAT)と5種類の埋め込みについて見せていくで。

C.1 ヒト転写物のノード分類について

このセクションでは、ヒト転写物を使ったノード分類タスクの交差検証の損失曲線を載せてるねん。これ、本文の表2から導き出したやつやで。

図3:SAGEモデルでの各イテレーションごとの損失やで。

図4:GCNモデルでの各イテレーションごとの損失やで。

21

---

## Page 22

[](/attach/db6fabe5ad8a3edf90dfcbd09dabf0ba6410e571d6ea4fec2777279b885884d0_p022.png)

### 和訳

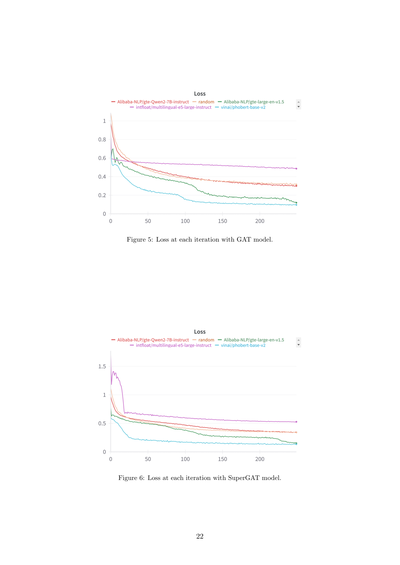

Figure 5: GATモデル使ったときの各イテレーションでの損失やで。

Figure 6: SuperGATモデル使ったときの各イテレーションでの損失やで。

22

---

## Page 23

[](/attach/db6fabe5ad8a3edf90dfcbd09dabf0ba6410e571d6ea4fec2777279b885884d0_p023.png)

### 和訳

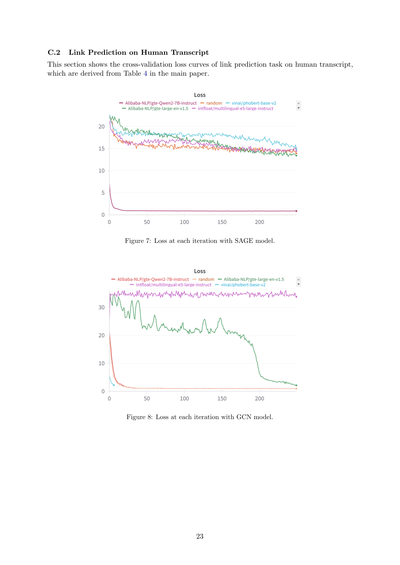

C.2 ヒトの遺伝子発現データでのリンク予測

このセクションでは、ヒトの遺伝子発現データを使ったリンク予測タスクの交差検証の損失曲線を見せるで。これ、本文のTable 4から導き出したやつやねん。

図7:SAGEモデルでの各イテレーションごとの損失やで。

図8:GCNモデルでの各イテレーションごとの損失やで。

23

---

## Page 24

[](/attach/db6fabe5ad8a3edf90dfcbd09dabf0ba6410e571d6ea4fec2777279b885884d0_p024.png)

### 和訳

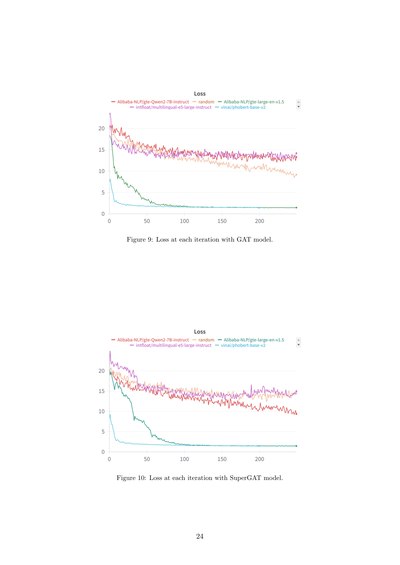

**図9: GATモデルでの各イテレーションごとの損失やで**

**図10: SuperGATモデルでの各イテレーションごとの損失やで**

24

---

ちなみにこれ、めっちゃシンプルな図のキャプションやねん。「損失(Loss)」ってのは、ようするにAIモデルがどんだけ間違えてるかの指標やな。イテレーション(繰り返し学習)するたびにこの損失がどう変わっていくか見せてるグラフってことやで。GATもSuperGATも「グラフアテンションネットワーク」っていうタイプのAIモデルで、SuperGATはGATをパワーアップさせたやつやねん。

---

## Page 25

[](/attach/db6fabe5ad8a3edf90dfcbd09dabf0ba6410e571d6ea4fec2777279b885884d0_p025.png)

### 和訳

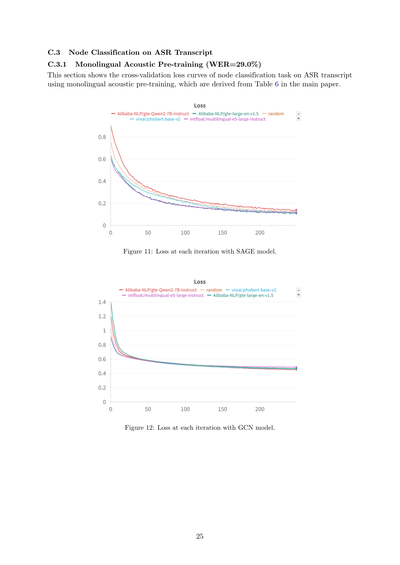

C.3 ASR文字起こしでのノード分類

C.3.1 単一言語の音声事前学習(WER=29.0%)

ここではな、ASR(音声認識)で文字起こしした結果を使ってノード分類タスクをやった時の、クロスバリデーションの損失曲線を見せるで。これ、本文のTable 6から出してきたやつやねん。

ちょっと説明しとくと、「単一言語の音声事前学習」っていうのは、一つの言語だけでモデルを先に訓練しとくやり方のことや。で、WER=29.0%っていうのは「単語誤り率」のことで、音声認識がどんだけ間違えたかの数字やな。29%間違えとるってことは、まあまあミスあるけど、そこそこ聞き取れとるレベルやで。

図11:SAGEモデルでの各イテレーションにおける損失

図12:GCNモデルでの各イテレーションにおける損失

SAGEもGCNもグラフニューラルネットワークの一種やねん。SAGEは近所のノードの情報をサンプリングして集めてくるやつで、GCNはもうちょい古典的に近傍全部を平均化して使うタイプや。どっちがええかは場合によるけど、ここでは両方試して比較しとるわけやな。

25

---

## Page 26

[](/attach/db6fabe5ad8a3edf90dfcbd09dabf0ba6410e571d6ea4fec2777279b885884d0_p026.png)

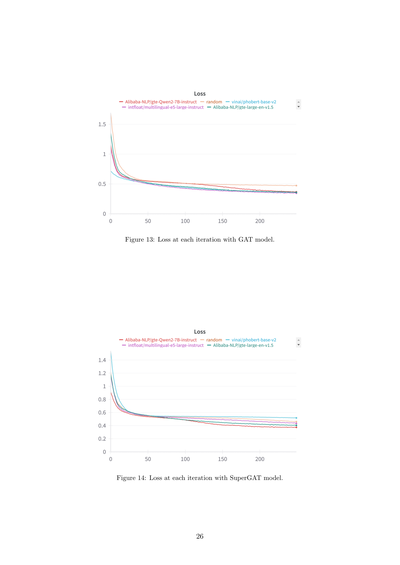

### 和訳

Figure 13: GATモデル使った時の各イテレーションごとのロスやで。

Figure 14: SuperGATモデル使った時の各イテレーションごとのロスやな。

26

---

## Page 27

[](/attach/db6fabe5ad8a3edf90dfcbd09dabf0ba6410e571d6ea4fec2777279b885884d0_p027.png)

### 和訳

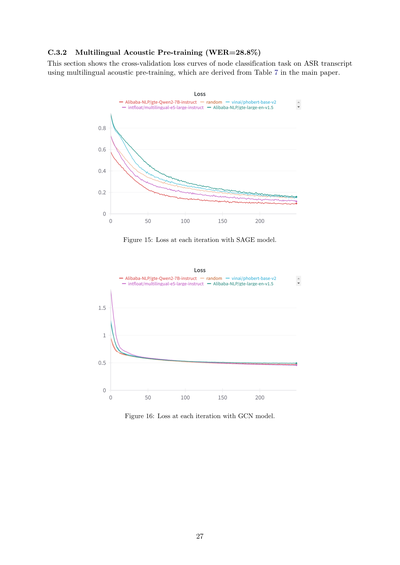

C.3.2 多言語音響事前学習(WER=28.8%)

このセクションでは、多言語音響事前学習を使った音声認識の書き起こしデータで、ノード分類タスクのクロスバリデーション損失曲線を見せるで。これは本論文の表7から導き出したもんやねん。

図15:SAGEモデルでの各イテレーションごとの損失やで。

図16:GCNモデルでの各イテレーションごとの損失やで。

27

---

## Page 28

[](/attach/db6fabe5ad8a3edf90dfcbd09dabf0ba6410e571d6ea4fec2777279b885884d0_p028.png)

### 和訳

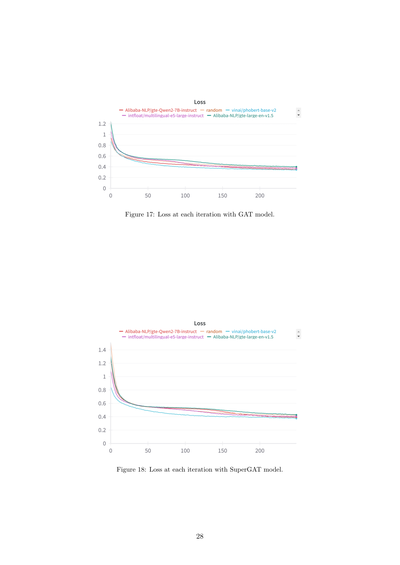

Figure 17: GATモデル使ったときの各イテレーションでのロスやで。

Figure 18: SuperGATモデル使ったときの各イテレーションでのロスやで。

28

---

## Page 29

[](/attach/db6fabe5ad8a3edf90dfcbd09dabf0ba6410e571d6ea4fec2777279b885884d0_p029.png)

### 和訳

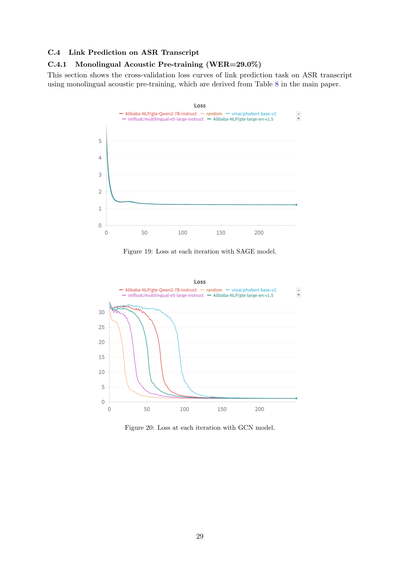

C.4 音声認識の書き起こしデータでリンク予測やってみた話

C.4.1 ひとつの言語だけで音声の事前学習したやつ(文字の認識ミス率は29.0%やで)

このセクションではな、音声認識で書き起こしたテキストを使ってリンク予測っていうタスクをやった時の、交差検証の損失曲線を見せるで。ちなみにこれ、本文のTable 8から持ってきたデータやねん。

なんの話かっていうとな、ひとつの言語だけで事前に学習させたモデルを使って、「このノード(データの点やな)とこのノード、つながってるかどうか予測してみ?」っていうタスクをやらせたわけや。

Figure 19: SAGEモデルで学習を繰り返すたびに損失がどう変わったかのグラフ

Figure 20: GCNモデルで学習を繰り返すたびに損失がどう変わったかのグラフ

めっちゃざっくり言うとな、SAGEもGCNもグラフニューラルネットワークの一種で、データのつながり方を学習するのが得意なモデルやねん。損失が下がっていくほど「ええ感じに学習できてるで〜」ってことやな。

29

---

## Page 30

[](/attach/db6fabe5ad8a3edf90dfcbd09dabf0ba6410e571d6ea4fec2777279b885884d0_p030.png)

### 和訳

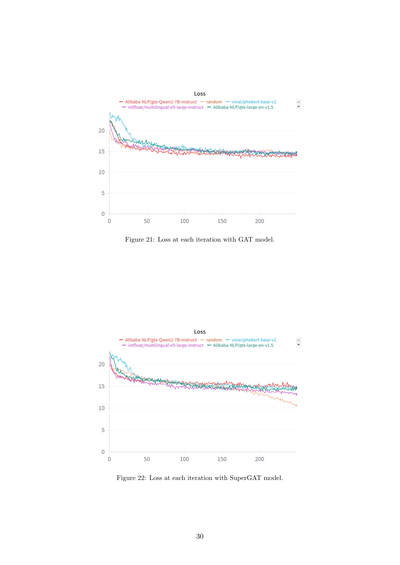

Figure 21: GATモデルで学習させた時の、各イテレーションごとの損失の変化やで。

Figure 22: SuperGATモデルで学習させた時の、各イテレーションごとの損失の変化やねん。

30

---

## Page 31

[](/attach/db6fabe5ad8a3edf90dfcbd09dabf0ba6410e571d6ea4fec2777279b885884d0_p031.png)

### 和訳

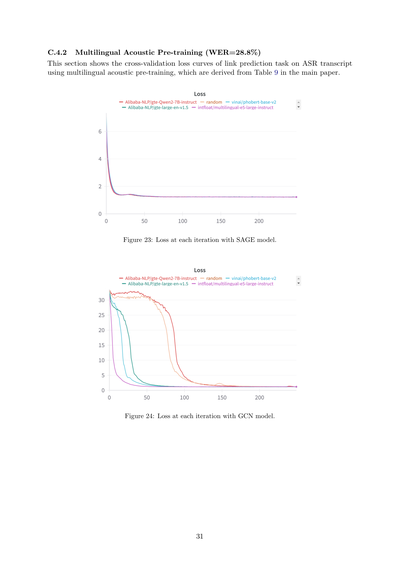

## C.4.2 多言語の音響事前学習(単語誤り率=28.8%)

このセクションでは、多言語の音響事前学習を使った音声認識の書き起こしデータで、リンク予測タスクの交差検証の損失曲線を見せてくで。これは本文のTable 9から出てきたデータやねん。

図23:SAGEモデルでの各イテレーションごとの損失やで。

図24:GCNモデルでの各イテレーションごとの損失やで。

31

---

## Page 32

[](/attach/db6fabe5ad8a3edf90dfcbd09dabf0ba6410e571d6ea4fec2777279b885884d0_p032.png)

### 和訳

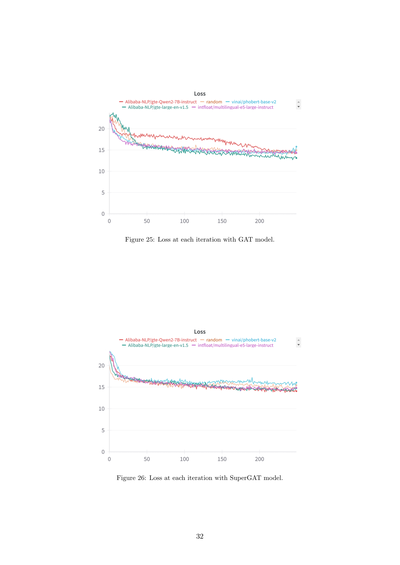

**Figure 25:** GATモデル使った時の各イテレーションでのロスの変化やで。

**Figure 26:** SuperGATモデル使った時の各イテレーションでのロスの変化やな。

32ページ目

---

![]()

1 / 1