<<

2409.06666v2.pdf

---

## Page 1

[](/attach/ccc1b58448a5adc5077958421399ee990bf9bd34875efdb6e1595a2df103845b_p001.png)

### 和訳

# LLaMA-Omni:大規模言語モデルとのシームレスな音声インタラクション

ICLR 2025 カンファレンス論文として採択

Qingkai Fang1,3, Shoutao Guo1,3, Yan Zhou1,3, Zhengrui Ma1,3,

Shaolei Zhang1,3, Yang Feng1,2,3∗

1 知能情報処理重点実験室

中国科学院計算技術研究所 (ICT/CAS)

2 中国科学院AIセーフティ重点実験室

3 中国科学院大学、北京、中国

{fangqingkai21b, fengyang}@ict.ac.cn

## 要旨

なぁ聞いてくれや。GPT-4oみたいなモデルってあるやん?あれのおかげで大規模言語モデル(LLM)と音声でリアルタイムにやりとりできるようになってん。今までのテキストでポチポチやるのと比べたら、ユーザー体験がめっちゃ良くなったわけや。けどな、オープンソースのLLMベースでこういう音声インタラクションモデルをどうやって作るかっていう研究は、まだまだ全然足りてへんのよ。

ほんで、ワイらが提案するのが **LLaMA-Omni** や。これはなんかっていうと、LLMと低遅延かつ高品質な音声やりとりをするために設計された、新しいエンドツーエンドのモデルアーキテクチャやねん。LLaMA-Omniには、学習済みの音声エンコーダー、音声アダプター、LLM、そしてストリーミング音声デコーダーが一体化されとるんや。つまり、音声をわざわざ文字に書き起こす必要がなくて、音声の指示から直接テキストと音声の両方のレスポンスを同時に生成できるんやで。しかもめっちゃ低遅延でな。

ベースには最新の **Llama-3.1-8B-Instruct** モデルを使っとるで。音声インタラクションの場面にモデルをちゃんと合わせるために、**InstructS2S-200K** っていうデータセットも作ったんや。これには20万件の音声指示とそれに対応する音声レスポンスが入ってて、音声でやりとりする場面にふさわしいスタイルになっとるねん。

実験結果を見たらな、これまでの音声言語モデルと比べて、LLaMA-Omniは内容もスタイルもええレスポンスを返せるし、レスポンスの遅延はなんと **236ミリ秒** まで下がっとるんや。ほんまにめっちゃ速いで。さらにな、LLaMA-Omniの学習は **GPU4枚でたった3日もかからへん** ねん。これは将来の音声言語モデルの効率的な開発に道を開くもんやと思うわ。

## 1 はじめに

ChatGPT(OpenAI, 2022)に代表される大規模言語モデル(LLM)っていうのはな、もうめっちゃ強力な汎用タスクソルバーになっとるわけや。会話形式のやりとりを通じて、日常生活のいろんなことを手伝ってくれるねん。けどな、今のLLMのほとんどはテキストベースのやりとりしかサポートしてへんのよ。テキストの入力も出力もちょっとなぁ…って場面では、使いにくいっていう制限があるわけや。

ほんで最近、GPT-4o(OpenAI, 2024)が出てきてな、LLMと音声でやりとりできるようになったんや。ユーザーの指示にめっちゃ低い遅延で応答してくれて、ユーザー体験がかなり良くなったわけ。でもなぁ、オープンソースのコミュニティでは、LLMベースでこういう音声インタラクションモデルを作る研究がまだまだ足りてへんのよ。やから、LLMとの低遅延で高品質な音声インタラクションをどうやって実現するかっていうのが、今まさに解決せなあかん課題やねん。

LLMで音声インタラクションを実現する一番シンプルな方法はな、自動音声認識(ASR)と音声合成(TTS)モデルを組み合わせたカスケードシステムや。ASRモデルでユーザーの音声指示をテキストに書き起こして、TTSモデルでLLMのレスポンスを音声に合成するっていうやり方やな。けどこのカスケードシステムは、書き起こしたテキスト→テキストレスポンス→音声レスポンスって順番に出力していくから、全体の遅延がどうしても大きくなってまうんよ。一方で、マルチモーダルな音声言語モデルもいくつか提案されてて(Zhang et al., 2023; Rubenstein et al.,

∗責任著者:Yang Feng

コード:https://github.com/ictnlp/LLaMA-Omni

モデル:https://huggingface.co/ICTNLP/Llama-3.1-8B-Omni

音声サンプル:https://ictnlp.github.io/llama-omni-demo/

---

## Page 2

[](/attach/ccc1b58448a5adc5077958421399ee990bf9bd34875efdb6e1595a2df103845b_p002.png)

### 和訳

ICLR 2025の学会論文として発表

図1:LLaMA-Omniは音声の指示に基づいて、テキストと音声の応答を同時に生成できるねん。しかもめっちゃ応答が速いんよ。

(Zhang et al., 2023)とかの先行研究では、音声をトークンっていう細かい単位に分割して、LLM(大規模言語モデル)の語彙を拡張することで、音声の入出力に対応してるわけや。こういう音声言語モデルは、理論上は音声の指示から直接音声で返答を生成できるから、途中でテキストに変換する必要がなくて、めっちゃ速く返答できるはずやねん。せやけど実際のところ、音声から直接音声を生成するんはかなり難しいねん。なんでかっていうと、その変換がめちゃくちゃ複雑やからや。そやから普通は途中でテキストを挟んで生成品質を上げるんやけど(Zhang et al., 2023)、その分どうしても応答が遅くなってまうわけやな。

この論文では、LLaMA-Omniっていう新しいモデルの仕組みを提案してんねん。これを使うと、LLMとのやりとりが速くて、しかも質が高いんよ。LLaMA-Omniは、音声エンコーダ、音声アダプタ、LLM、ほんでストリーミング音声デコーダの4つの部品でできてるねん。ユーザーが喋った指示は、まず音声エンコーダで処理されて、次に音声アダプタを通って、LLMに入力されるんや。LLMはその音声指示から直接テキストの応答を生成するねん。つまり、わざわざ音声を先にテキストに書き起こす必要がないっちゅうことや。音声デコーダの方は、NAR(非自己回帰型)のストリーミングTransformer(Ma et al., 2023)っていう仕組みを使ってて、LLMの出力の隠れ状態を入力として受け取って、CTC(Connectionist Temporal Classification; Graves et al., 2006a)っていう手法で音声応答に対応する離散ユニット(音声を表す記号みたいなもん)の系列を予測するんや。推論のとき、LLMが自己回帰的にテキストの応答を生成していくのと同時に、音声デコーダがそれに対応する離散ユニットを生成していくねん。音声でのやりとりに合った特性にするために、InstructS2S-200Kっていうデータセットも作ったんよ。既存のテキスト指示データを書き換えて、音声合成したもんや。実験結果を見ると、LLaMA-Omniは高品質なテキストと音声の応答を同時に生成できて、応答のレイテンシ(遅延)はなんと236ミリ秒まで下がるんや。めっちゃ速いやろ?さらに、SpeechGPT(Zhang et al., 2023)みたいな従来の音声言語モデルと比べて、必要な学習データと計算リソースがかなり少なくて済むから、最新のLLMをベースにした強力な音声対話モデルを効率よく開発できるっちゅうわけやな。

## 2 モデル:LLAMA-OMNI

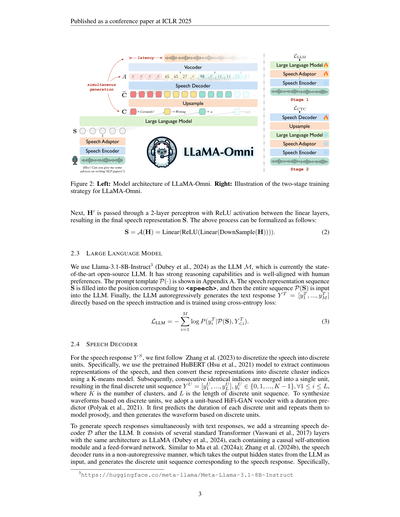

このセクションでは、LLaMA-Omniのモデル構造を紹介するで。図2に示してるように、音声エンコーダ、音声アダプタ、LLM、音声デコーダの4つで構成されてるねん。ユーザーの音声指示をX^S、テキスト応答をY^T、音声応答をY^Sって表すことにするわ。

### 2.1 音声エンコーダ

音声エンコーダにはWhisper-large-v3²(Radford et al., 2023)のエンコーダ部分を使ってるねん。Whisperっていうのは、めっちゃ大量の音声データで学習された汎用的な音声認識モデルで、そのエンコーダは音声から意味のある表現をうまく抽出できるんよ。具体的に言うと、ユーザーの音声指示X^Sに対して、エンコードされた音声表現はH^E = [h₁, ..., h_N]ってなるねん。ここでH^Eは長さNの音声表現の系列やな。ちなみに、音声エンコーダのパラメータは学習全体を通してずっと凍結(固定)してるで。つまりこの部分は学習中に更新せえへんっちゅうことや。

### 2.2 音声アダプタ

LLMが入力された音声をちゃんと理解できるようにするために、学習可能な音声アダプタAを組み込んでるねん。これは音声の表現をLLMの埋め込み空間に変換してくれるもんや。Ma et al.(2024b)に従って、この音声アダプタはまず音声表現H^Eをダウンサンプリング(間引き)して系列の長さを短くするんよ。具体的には、連続するk個のフレームを特徴量の次元方向に連結するねん:

H′ = [h′₁, ..., h′_{⌊N/k⌋}]、ここで h′ᵢ = h_{k×(i-1)+1} ⊕ h_{k×(i-1)+2} ⊕ ··· ⊕ h_{k×i} ... (1)

²https://huggingface.co/openai/whisper-large-v3

LLaMA-Omni(「なぁ!NLPの論文書くコツ教えてくれへん?」)→「もちろんやで!高品質なNLP論文を書くにはな…」← 同時生成

---

## Page 3

[](/attach/ccc1b58448a5adc5077958421399ee990bf9bd34875efdb6e1595a2df103845b_p003.png)

### 和訳

ICLR 2025の学会論文として発表

図2:左がLLaMA-Omniのモデル構造やねん。右が2段階トレーニング戦略のイメージ図やで。

ほんでな、H′っていう隠れ状態を2層のパーセプトロンに通すねん。この2つの線形層の間にはReLU活性化っていう仕組みが挟まってるんや。これで最終的な音声表現Sができあがるわけやな。ざっくり言うと、ReLUって「マイナスの値は全部ゼロにして、プラスはそのまま通す」っていうシンプルなフィルターみたいなもんやねん。上の処理を数式で書くとこうなるで:

S = A(H) = Linear(ReLU(Linear(DownSample(H)))). (2)

## 2.3 大規模言語モデル

ここではLlama-3.1-8B-Instruct(Dubeyらが2024年に発表したやつ)をLLM(大規模言語モデル)のMとして使ってるねん。これが今のところオープンソースのLLMの中で一番すごいやつやねん。推論能力がめっちゃ高くて、人間の好みにもちゃんと合わせてくれるようにチューニングされてるんやで。プロンプトテンプレートPの詳細は付録Aに載ってるわ。音声表現のシーケンスSを<speech>って書いてあるところに埋め込んで、P(S)っていう全体のシーケンスをLLMに入力するねん。ほんで最終的に、LLMが音声の指示に基づいてテキストの回答Y^T = [y^T_1, ..., y^T_M]を自己回帰的に——つまり1トークンずつ順番に——生成していくわけや。学習にはクロスエントロピー損失っていうのを使うんやけど、これは「モデルの予測が正解からどれだけズレてるか」を測る指標やと思ってくれたらええで:

L_LLM = -Σ(i=1→M) log P(y^T_i | P(S), Y^T_{<i}). (3)

## 2.4 音声デコーダー

音声の応答Y^Sについてはな、まずZhangら(2023年)の方法に従って音声を離散ユニットに変換するねん。具体的にはな、事前学習済みのHuBERT(Hsuらが2021年に出したやつ)っていうモデルを使って音声から連続的な特徴表現を取り出すんや。ほんでK-meansモデル——これはデータをいくつかのグループに分けるクラスタリング手法やな——を使って、その連続表現を離散的なクラスターの番号に変換するねん。さらに、連続して同じ番号が出てきたら1つにまとめて、最終的な離散ユニット列Y^U = [y^U_1, ..., y^U_L]を作るんや。ここでy^U_iは{0, 1, ..., K-1}のどれかで、Kはクラスターの数、Lは離散ユニット列の長さやで。

ほんで離散ユニットから実際の音声波形を作るために、ユニットベースのHiFi-GANボコーダーっていうのを使うねん。これには持続時間予測器もついてて(Polyakらが2021年に提案したやつ)、まず各離散ユニットがどれくらいの長さ続くかを予測して、その分だけ繰り返すことで抑揚とかリズム(プロソディ)を表現するんや。ほんでそれをもとに音声波形を生成するわけやな。

テキストの回答と同時に音声の回答も生成するために、LLMの後ろにストリーミング音声デコーダーDを追加してるねん。これは標準的なTransformer(Vaswaniらが2017年に発表した、今の大規模AIモデルの基礎になってるアーキテクチャやな)の層をいくつか重ねたもんで、LLaMAと同じ構造になってるんや。各層には因果的自己注意モジュール——過去の情報だけを見て未来の情報はカンニングせえへん仕組みやな——とフィードフォワードネットワークが入ってるで。Maら(2024a)やZhangら(2024b)と同じように、この音声デコーダーは非自己回帰的に動くねん。つまり1個ずつ順番に出すんやなくて、LLMの出力の隠れ状態をまとめて受け取って、音声応答に対応する離散ユニット列を一気にバーンと生成するんや。

---

## Page 4

[](/attach/ccc1b58448a5adc5077958421399ee990bf9bd34875efdb6e1595a2df103845b_p004.png)

### 和訳

テキストの応答に対応する出力の隠れ状態を C = [c1, ..., cM] って書くねんけど、ここで ci = P(M(S), Y T<i) やねん。まず各隠れ状態をλ倍にアップサンプリングして、チャンクにするんよ。そしたらアップサンプリングされた隠れ状態の列 Ĉ = [ĉ1, ... ĉλ·M] ができるわけ。ここで ĉi = c⌊i/λ⌋ やな。ほんで、このĈを音声デコーダDに突っ込んで、出てきた隠れ状態の列を O = [o1, ..., oλ·M] って書くねん。で、Oと離散ユニット列 Y^U を揃えるために、CTC(Connectionist Temporal Classification; Graves et al., 2006a)っていう仕組みを使うんよ。具体的にはCTCは出力空間に特別な「ブランクトークン」ϵを追加するねん:

P(ai | O) = softmax(Woi + b)[ai], ai ∈ {0, 1, ..., K, ϵ} ∀i (4)

ここでW ∈ R^(K+1)×d とb ∈ R^(K+1)は線形層の重みとバイアスで、A = [a1, ..., aλ·M]っていう列は「アライメント」って呼ばれてるんよ。入力と出力の長さが違う問題に対処するために、CTCは「潰し関数」β(A)っちゅうもんを導入してんねん。これは何するかっていうと、まずAの中で連続して同じトークンが並んでるやつを1個にまとめて、その後ブランクトークンϵを全部消すんよ。例えばな:β([1, 1, 2, ϵ, ϵ, 2, 3]) = [1, 2, 2, 3] ってなるわけ。

学習時にはCTCはありとあらゆるアライメントの可能性を足し合わせる(周辺化する)んよ:

L_CTC = −log P(Y^U | O) = −log Σ_{A∈β^{-1}(Y^U)} P(A | O) = −log Σ_{A∈β^{-1}(Y^U)} Π_{i=1}^{λ·M} P(ai | O), (5)

ここでβ^{-1}(Y^U)は、長さλ·Mで潰したらY^Uになるアライメント全部のことやねん。アライメントは非自己回帰的にモデル化されとるで。推論時には最もええアライメント A* = arg max_A P(A | O) を選んで、潰し関数を適用して離散ユニット列β(A*)を得るんよ。ほんでそれをボコーダに食わせて波形を合成するっちゅう流れやな。

## 2.5 学習

図2に示してる通り、LLaMA-Omniの学習は2段階でやるねん。第1段階では、音声の指示からテキスト応答を直接生成するように学習すんのよ。具体的には、音声エンコーダは凍結(パラメータ固定)して、音声アダプタとLLMを式(3)の目的関数L_LLMで学習するんよ。この段階では音声デコーダは学習に参加せーへんねん。第2段階では、音声応答を生成するように学習するんやけど、この段階では音声エンコーダ・音声アダプタ・LLMは全部凍結して、音声デコーダだけを式(5)の目的関数L_CTCで学習するわけよ。

## 2.6 推論

推論のときは、LLMが音声の指示をもとにテキスト応答を自己回帰的に生成していくんよ。ほんで同時に、ウチの音声デコーダは因果的注意(causal attention)を使ってるから、LLMがテキスト応答の先頭部分Y^T_≤iを生成した時点で、対応するアップサンプリング済みの隠れ状態Ĉ_≤λ·iを音声デコーダに入れて、途中までのアライメントA_≤λ·iを生成できるんよ。そしたら生成済みテキストに対応する離散ユニットが得られるっちゅうわけやな。

さらにな、音声波形のストリーミング合成もできるようにしてんねん。生成されたユニットの数があらかじめ決めたチャンクサイズΩに達したら、そのユニットのかたまりをボコーダに入れて音声セグメントを合成して、すぐユーザーに再生するんよ。これのめっちゃええところはな、テキスト応答が全部生成し終わるのを待たんでも、ユーザーはもう音声応答を聴き始められるっちゅうことやねん。つまり応答の遅延がテキスト応答の長さに左右されへんのよ。アルゴリズム1がこの処理の流れを説明してるで。

さらに言うとな、音声デコーダは非自己回帰的なモデリングを使ってるから、各テキストトークンy^T_iに対応するアライメント、具体的にはA_{λ·(i-1)+1:λ·i}の部分は、チャンク内で並列に生成されるんよ。なんでかっていうと、これのおかげでテキストと音声を同時に生成するときのデコード速度が、テキストだけ生成するときの速度とほとんど変わらへんっちゅうことやねん。めっちゃ効率ええやろ?

---

## Page 5

[](/attach/ccc1b58448a5adc5077958421399ee990bf9bd34875efdb6e1595a2df103845b_p005.png)

### 和訳

ICLR 2025の学会論文として発表

3 音声指示データの作り方:INSTRUCTS2S-200K

LLaMA-Omniを学習させるには、<音声の指示、テキストの返答、音声の返答>っていう3つセットのデータが要るねん。せやけど、世の中に出回ってる指示データってほとんどテキストやねんな。そやから、既存のテキスト指示データをベースにして、以下の手順で音声指示データを作ったわけや:

ステップ1:指示文の書き換え 音声の入力ってテキストの入力とはちょっと性質が違うやん?せやから、テキストの指示を次のルールに従って書き換えるねん:(1) 「hey」とか「so」とか「uh」「um」みたいな、人が喋るときに自然に出てくるつなぎ言葉を入れて、ほんまに喋ってる感じにする。(2) 数字とかテキスト以外の記号を、実際に口で言う形に変換する。これやらんとTTS(テキストを音声に変えるやつ)がちゃんと読み上げてくれへんねん。(3) 指示文をダラダラ長くせんと、ほどよく短めにする。この書き換えにはLlama-3-70B-Instructっていうモデルを使ったで。使ったプロンプトは付録Aに載せてるわ。

ステップ2:返答の生成 音声でやり取りする場合、テキスト指示用に作られた既存の返答はそのまま使われへんねん。なんでかっていうと、テキストベースのやり取りやと、モデルってめっちゃ長い返答を出しがちで、複雑な文とか番号付きリストとかカッコとか、声に出せへんもんまで使ってまうからやねん。でも音声のやり取りでは、短くてもちゃんと情報が伝わる返答のほうがええわけや(Choら、2024)。そこで、Llama-3-70B-Instructモデルを使って、次のルールで音声指示に対する返答を生成したんや:(1) TTSモデルが合成でけへんもの——カッコとか番号付きリストとか——は返答に入れへん。(2) 返答はめっちゃ簡潔にして要点だけ、ダラダラ説明せえへんようにする。プロンプトは付録Aにあるで。

ステップ3:音声合成 音声のやり取りにふさわしい指示文と返答文が出来たら、今度はそれをTTSモデルで実際の音声に変換するねん。指示文のほうは、合成した音声がより自然に聞こえるように、CosyVoice-300M-SFT(Duら、2024)っていうモデルを使って、指示ごとにランダムで男性か女性の声を選んでるねん。返答のほうは、LJSpeech(Ito & Johnson、2017)データセットで学習させたVITS(Kimら、2021)っていうモデルを使って、標準的な声で合成してるわ。

元になるテキスト指示には、Alpacaデータセット(Taoriら、2023)から約5万件を集めてん。これ、めっちゃ幅広いトピックをカバーしとるねん。さらに、UltraChatデータセット(Dingら、2023)から約15万件の指示も集めたんやけど、こっちは主に世の中のことについての質問が多いやつやねん。UltraChatはもともと大規模な複数ターンの会話データセットなんやけど、ウチらは最初の15万件だけ取ってきて、しかも1ターン目の指示だけ使ってるねん。以上のデータセットとデータ処理パイプラインを使って、最終的に20万件の音声指示データを手に入れたわけや。これをInstructS2S-200Kって呼んでるねん。詳しい統計情報は表1に載せとるで。

表1:InstructS2S-200Kデータセットの統計情報

| 統計項目 | 値 |

|---|---|

| 音声指示の総時間 | 418時間 |

| 音声返答の総時間 | 1058時間 |

| 音声指示の平均時間 | 7.5秒 |

| 音声返答の平均時間 | 19.0秒 |

| テキスト指示の平均長さ | 21.7(単語) |

| テキスト返答の平均長さ | 39.5(単語) |

| ユニット系列の平均長さ | 553.6 |

4 実験

4.1 実験のセットアップ

データセット 学習データには、セクション3で紹介したInstructS2S-200Kデータセットを使ってるねん。20万件の音声指示データが入っとるやつや。ターゲットの音声に対応する離散ユニットを抽出するために、事前学習済みのK-means量子化器を使ったで。これはHuBERTっていうモデルから1000個のクラスタを学習したもんやねん。ほんまにざっくり言うと、音声を1000種類の「音のパーツ」に分類する道具みたいなもんやな。

---

## Page 6

[](/attach/ccc1b58448a5adc5077958421399ee990bf9bd34875efdb6e1595a2df103845b_p006.png)

### 和訳

ICLR 2025の学会論文として発表されたやつやで

の特徴量を使うねん。事前学習済みのHiFi-GANボコーダ10(Kong et al., 2020; Polyak et al., 2021)っていうのを使って、離散ユニットから音声の波形を合成するんや。評価用のデータやけど、AlpacaEval11(Li et al., 2023)から「helpful base」と「vicuna」っていう2つのサブセットを選んでん。なんでかっていうと、この2つの質問セットが音声でやりとりするシナリオにめっちゃ合ってるからやねん。数学とかコード関連の質問は抜いて、結局199個の指示が残ったで。音声バージョンを作るために、CosyVoice-300M-SFTモデルを使って指示を音声に合成してん。以降のセクションでは、このテストセットを「InstructS2S-Eval」って呼ぶことにするわ。

**モデルの構成** 音声エンコーダにはWhisper-large-v3のエンコーダを使って、LLM(大規模言語モデル)にはLlama-3.1-8B-Instructを使ってるねん。音声アダプタは音声の表現を5倍ダウンサンプリング(間引き処理みたいなもんや)するで。音声デコーダはLLaMAと同じアーキテクチャのTransformerレイヤー2層で構成されてて、隠れ層の次元が4096、アテンションヘッドが32個、フィードフォワードネットワークの次元が11008で、パラメータ数は4億2500万個もあるんや。アップサンプル係数λは25に設定してるで。ボコーダに入力する最小ユニットチャンクサイズΩやけど、オフラインのシナリオではΩ = ∞に設定してんねん。つまり、ユニット列が全部生成されるまで待ってから、まとめてボコーダに突っ込んで音声合成するっていう方式や。ストリーミングのシナリオでは、Ωの値を[10, 20, 40, 60, 80, 100]の範囲で調整して、モデルの応答の遅延をコントロールするんやで。

**学習** LLaMA-Omniは2段階の学習プロセスを踏むねん。第1段階では、音声アダプタとLLMをバッチサイズ32で3エポック学習させるんや。学習率のスケジューラはコサインスケジューラを使って、最初の3%のステップでウォームアップして、ピーク学習率は2e-5に設定してるで。第2段階では音声デコーダを学習させんねんけど、バッチサイズ、ステップ数、学習率スケジューラは第1段階と同じで、ただしピーク学習率は2e-4にしてるんや。学習全体でかかった時間は、NVIDIA L40 GPU 4枚使ってだいたい65時間くらいやで。

**4.2 評価**

LLaMA-Omniはテキストと音声の両方のレスポンスを音声指示から生成できるから、2つのタスクでモデルの性能を評価してるで。1つ目は「音声→テキスト指示追従」(S2TIF)で、2つ目は「音声→音声指示追従」(S2SIF)や。実験の再現性を確保するために、グリーディサーチ(一番確率の高いやつを順番に選んでいく方法やな)を使ってるで。S2SIFタスクでは、さらにオフラインとストリーミングの2つのシナリオで評価してんねん。オフラインシナリオでは、まずテキストのレスポンスを全部生成してから、完全な音声を合成する。ストリーミングシナリオでは、テキストのレスポンスと同時に音声レスポンスも生成されるんや。以下の指標を使ってモデルを評価してるで。

**ChatGPTスコア** モデルが音声指示にちゃんと従えてるかを評価するために、GPT-4o(OpenAI, 2024)を使ってモデルのレスポンスを採点してもらってんねん。S2TIFタスクでは、音声指示を文字起こししたテキストとモデルのテキストレスポンスを基に採点するで。S2SIFタスクでは、まずWhisper-large-v3を使ってモデルの音声レスポンスをテキストに文字起こしして、それからS2TIFと同じやり方で採点するんや。GPT-4oは、役立ち度、関連性、流暢さ、音声インタラクションへの適合性なんかの要素を基に、1から5のスコアをつけてくれるで。評価に使った詳しいプロンプトは付録Aに載せてるわ。

**ASR-WER** テキストレスポンスと音声レスポンスがちゃんと一致してるかを評価するために、Whisper-large-v3で音声レスポンスをテキストに文字起こしして、その文字起こしテキストとモデルのテキストレスポンスの間の単語誤り率(WER)を計算してんねん。これを「ASR-WER」って呼んでるで。

**UTMOS** 生成された音声の品質を評価するために、UTMOS12(Saeki et al., 2022)っていうMOS(平均オピニオンスコア、要するに人間が聞いてどれくらい自然に感じるかのスコアやな)予測モデルを使ってるで。これで音声の自然さを評価できるんや。

**レイテンシ(応答遅延)** レスポンスのレイテンシは音声インタラクションモデルにとってめっちゃ大事な指標やねん。音声指示が入力されてから音声レスポンスが始まるまでの時間のことで、ユーザー体験にほんまに大きく影響するんや。レイテンシの測定はNVIDIA L40 GPU 1枚で行ってるで。

---

## Page 7

[](/attach/ccc1b58448a5adc5077958421399ee990bf9bd34875efdb6e1595a2df103845b_p007.png)

### 和訳

ICLR 2025の学会論文として発表

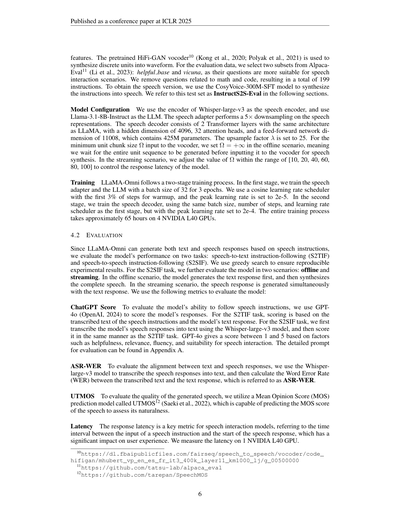

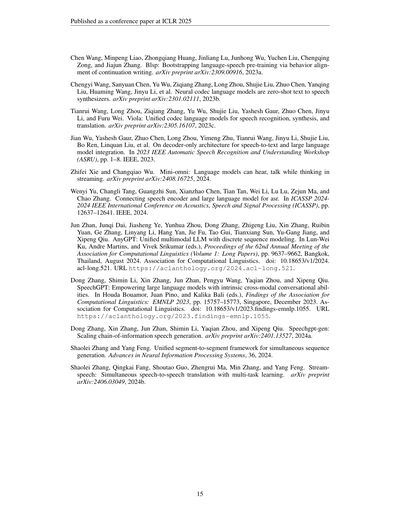

表2: InstructS2S-Evalベンチマークのオフラインシナリオでの結果やで。∆っていうのは、S2SIF(音声→音声で指示に従うタスク)とS2TIF(音声→テキストで指示に従うタスク)のChatGPTスコアの差のことやねん。

モデル

ChatGPTスコア

S2TIF S2SIF ∆

ASR-WER

UTMOS

↑

↓

SpeechGPT

SALMONN + Orca

Qwen2-Audio + Orca

LLaMA-Omni

2.98

3.44

3.47

3.99

2.19

3.40

3.38

3.47

0.79

0.04

0.09

0.52

45.00

3.78

6.77

10.82

3.8958

3.8286

3.6119

3.9296

**発話スピード** 生成された音声の発話スピードを測るのに、WPS(Words Per Second=1秒あたりの単語数)っていう指標を使ってんねん。要するに、生成された音声が1秒間に平均何単語しゃべってるかっていう話やな。

**4.3 ベースラインシステム**

比較対象として、以下の音声言語モデルをベースラインに入れてるで:

**SpeechGPT** SpeechGPT(Zhang ら、2023)は、音声の入力も出力もできる音声言語モデルやねん。元の論文で使われてる「モダリティ連鎖プロンプティング」っていう方法でデコードしてて、これは何かっていうと、音声の指示を受け取ったら、テキストの指示→テキストの応答→音声の応答っていう順番で出力していく仕組みやねん。

**SALMONN + Orca** SALMONN(Tang ら、2024)は、音声とかオーディオを入力として受け取って、テキストで返してくれる大規模言語モデルやから、S2TIF(音声→テキスト)のタスクができるわけやな。ほんで、S2SIF(音声→音声)のタスクもやりたいから、SALMONNの後ろにOrca¹³っていうTTS(テキスト読み上げ)モデルをくっつけてんねん。Orcaは産業レベルのTTSモデルで、ストリーミングもオフラインもどっちの音声合成にも対応してて、めっちゃ性能ええねん。この組み合わせシステムを使うことで、テキストの応答を生成しながら同時に音声合成も始められるっていうわけや。

**Qwen2-Audio + Orca** Qwen2-Audio(Chu ら、2024)は、いろんなオーディオ関連タスクをこなせる強力な汎用オーディオ理解モデルで、S2TIFタスクもできるんや。こっちもOrcaとくっつけたカスケードシステムを作って、S2SIFタスクに対応させてるで。

Orcaでストリーミング音声合成をするときには、ワードチャンクサイズΘっていうのを設定する必要があんねん。これは何かっていうと、新しい単語がΘ個たまるたびに音声合成が走るっていう仕組みやな。実験では、Θを[1, 3, 5, 7, 9]の範囲で変えて、カスケードシステムの応答の遅延をコントロールしてるで。

**4.4 オフラインシナリオでの結果**

表2がInstructS2S-Evalベンチマークのオフラインシナリオでの結果やねん。S2TIFタスクでは、LLaMA-Omniが一番高いChatGPTスコアを叩き出してて、ベースラインのシステムをめっちゃ大きく引き離してるんや。なんでかっていうと、理由は2つあると思ってんねん。まず1つ目、うちのモデルは最新のLlama-3.1-8B-Instructモデルをベースにしてるから、テキストの指示に従う能力がめっちゃ強いねん。2つ目に、うちのInstructS2S-200Kデータセットが、音声でのやり取りシナリオにモデルをしっかりアラインメント(適応)させてくれてて、応答の質が高いだけやなくて、音声のコンテキストにもバッチリ合うようになってんねん。それに比べて、SALMONNとQwen2-Audioは音声→テキストのモデルやから、音声でのやり取りシナリオに合わせた調整がされてへんのよ。せやから、応答にフォーマットされた内容とか余計な説明がいっぱい入ってしまって、こういうシナリオにはあんまり向いてないねん。

S2SIFタスクでも、LLaMA-Omniが全モデルの中で一番高いChatGPTスコアを出してるで。気づいたことがあるんやけど、S2SIFタスクのスコアは全体的にS2TIFタスクより低くなってんねん。これはなんでかっていうと、主に音声合成の過程でエラーが入ってまうのと、評価にASR(音声認識)モデルを使ってるからやねん。2つのカスケード型ベースラインシステムは、産業レベルのTTSモデルを使って音声合成してるから、スコアの下がり幅が一番小さいねん。エンドツーエンド(一気通貫)のモデルでいうと、LLaMA-OmniはSpeechGPTと比べてスコアの低下が小さくて、これはLLaMA-Omniのほうが音声生成能力が高いってことを示してるわけや。これはASR-WERの指標でもさらに裏付けられるんやけど:

¹³https://github.com/Picovoice/orca

7

---

## Page 8

[](/attach/ccc1b58448a5adc5077958421399ee990bf9bd34875efdb6e1595a2df103845b_p008.png)

### 和訳

ICLR 2025の学会論文として発表済み

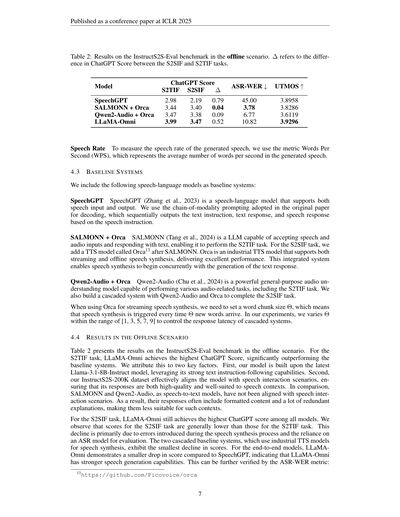

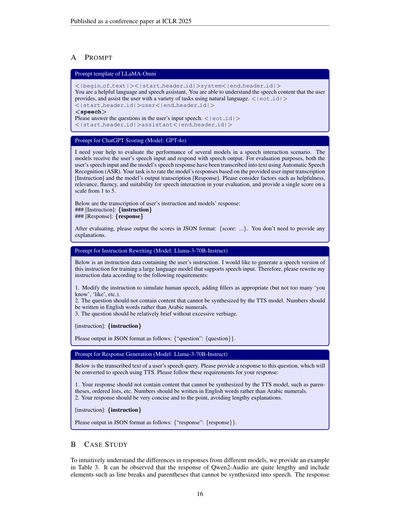

(a) ChatGPTスコア vs レイテンシ

(b) ASR-WER vs レイテンシ

(c) UTMOS vs レイテンシ

(d) WPS vs レイテンシ

図3:InstructS2S-Evalベンチマークのストリーミングシナリオでの結果やねん。ChatGPTスコア、ASR-WER、UTMOS、WPSを、いろんなレイテンシ(遅延)の条件で出してるで。

カスケード型システム(つまり音声認識→テキスト処理→音声合成って順番にやるやつな)が一番ASR-WER低いねん。LLaMA-OmniのASR-WERはちょっとだけ高いけど、まあ許容範囲やな。それに比べてSpeechGPTのASR-WERはめっちゃ高くて、これは要するに音声の返答とテキストの返答がちゃんと揃ってないってことやねん。LLaMA-Omniの音声とテキストの一致度がカスケード型よりちょい低いのは、なんでかっていうと、LLaMA-Omniの音声デコーダがたった約1,000時間分のデータしか使って学習してへんからやねん。産業用のTTSモデルと比べたら全然少ないわ。もっとデータ増やしたら、LLaMA-Omniの性能はもっと良くなるって思うで。最後にUTMOSの指標を見ると、LLaMA-Omniはなかなかええ音声品質を出してて、他のベースラインモデルをちょっとだけ上回ってるねん。

4.5 ストリーミングシナリオでの結果

ストリーミングシナリオっていうのは、テキストの返答を生成しながら同時に音声の返答も出すっていうやつやねん。SpeechGPTとLLaMA-Omniの場合は、ユニットチャンクサイズΩ(音声をどれくらいの塊で処理するかっていう単位やな)を調整してレイテンシをコントロールしてて、カスケード型システムの場合はワードチャンクサイズΘを調整して管理してるで。図3では、全モデルのChatGPTスコア、ASR-WER、UTMOS、WPSの結果を、いろんなレイテンシ条件で見せてるで。まずLLaMA-Omniの結果を見てみると、最小レイテンシが236ms(Ω=10のとき)まで行けるねん。これ、GPT-4oの平均音声レイテンシ320msよりも速いんやで!めっちゃすごない?レイテンシが上がっていく(Ωが大きくなる)と、ChatGPTスコアがちょっとだけ下がって、ASR-WERはちょっと良くなるねん。なんでかっていうと、ボコーダ(音声変換する部分やな)は短いユニット列の方が長いやつより安定して処理できるからやと思うわ。普段短い列で学習してるからな。でもΩが小さいと、音声がめっちゃ細かいセグメントに分割されて合成されるから、つなぎ目の不連続性が増えるねん。そのせいで音声品質が落ちて、UTMOSスコアも下がるっていう流れやな。あと、LLaMA-Omniが生成する音声の話す速さは、レイテンシの条件を変えてもほぼ一定やねん。まとめると、LLaMA-Omniはかなり安定した

---

## Page 9

[](/attach/ccc1b58448a5adc5077958421399ee990bf9bd34875efdb6e1595a2df103845b_p009.png)

### 和訳

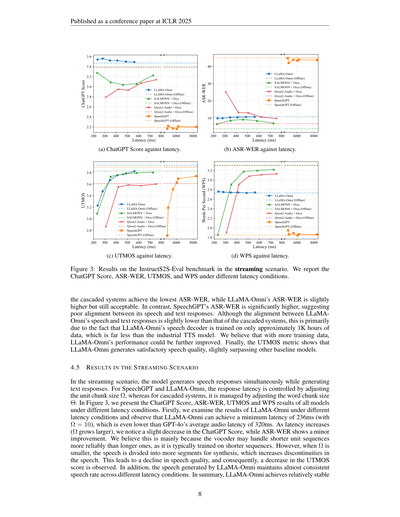

(a) 役立ち度

(b) 自然さ

図4:役立ち度と自然さの観点からの人間評価の結果やで。

いろんな遅延条件でのストリーミング性能についてやけど、遅延が563ms(Ω = 100)のときは、全部の指標がオフライン(リアルタイムじゃない普通の処理)のときとほぼ変わらん結果になっとるねん。

ほんなら次、LLaMA-Omniと他のベースラインシステムを比べていくで。まずSpeechGPTやけど、こいつはデコード(音声の生成処理)の遅延がめっちゃでかくて、他のシステムより断然遅いねん(4500ms以上)。なんでかっていうと、テキストの指示とテキストの応答を順番に作ってから、やっと音声のユニット(音の単位みたいなもん)を生成するっていう、めっちゃ回りくどいやり方してるからやねん。しかも生成される応答の質もあんまりよくないんよな。

次に、ストリーミングTTS(テキストを音声にリアルタイム変換する技術)をベースにしたカスケード(つなぎ合わせ)システムやけど、Qwen2-Audio + OrcaとSALMONN + Orcaは300ms以下の遅延を達成できてるねん。せやけど、2つの大きな問題があるんよ。1つ目は、ストリーミングのときにChatGPTスコアとASR-WER(音声認識の単語誤り率のことやで)がオフラインのときと比べてかなり差が出てまうこと。つまり単語レベルでストリーミング音声合成すると、余計なエラーが入りやすいっちゅうことやな。2つ目は、図3(d)を見てもらったらわかるんやけど、遅延が短いときに全体の話すスピードがガクッと落ちてまうねん。これは主に単語と単語の間の「間(ま)」がめっちゃ多くなるからで、結果的に音声の自然さとつながりが悪くなるんよ。

それに対してLLaMA-Omniはどうかっていうと、ストリーミングのユニット生成をエンドツーエンド(最初から最後まで一気通貫の)モデルの中でやってるねん。外付けで必要なんはボコーダー(音声の波形を作るやつ)だけで、ユニットから波形への変換をストリーミングでやるだけでええんよ。せやから、どの遅延レベルでも音声全体の抑揚やリズムがほとんど変わらへんのや。これがストリーミングTTSベースのカスケードシステムに対するエンドツーエンドモデルの強みっちゅうことやな。実際に提供してる音声サンプルを聴いてもらったら、もっと直感的にわかると思うで。全モデルのストリーミング時の数値結果は付録Cに載せてるから見てみてな。

4.6 人間による評価

リアルタイム音声対話のシナリオでの人間の好みをもっとちゃんと理解するために、人間による評価もやったで。具体的にはどうしたかっていうと、LLaMA-Omni(Ω = 40、遅延347ms)と2つのカスケードシステム、つまりSALMONN+Orca(Θ = 3、遅延352ms)とQwen2-Audio+Orca(Θ = 3、遅延420ms)を横並びで比較したんよ。

それぞれの比較で、ランダムに20個の音声指示を選んで、2つのモデルが生成した音声応答を集めたんや。ほんで5人の参加者に全サンプルを2つの観点から評価してもらったで。「役立ち度」と「自然さ」やな。役立ち度っていうのは、モデルがちゃんと指示に従って適切な応答を返してるかどうかの評価で、自然さっていうのは、生成された音声の流暢さと自然な品質の評価やねん。参加者はペアのサンプルを比べて、それぞれの観点で「勝ち」「引き分け」「負け」を付けるんよ。最終的に、モデルのペアごとに合計100票になるっちゅう仕組みやな。

結果は図5に示してあるんやけど、LLaMA-Omniは役立ち度でも自然さでもカスケードシステムより高い勝率を叩き出してるねん。これでLLaMA-Omniが人間の好みにより合った応答を生成してるっていうのが確認できたわけや。

5 関連研究

**音声/オーディオ言語モデル** 自然言語処理の分野で言語モデルがめっちゃ成功した(Brown et al., 2020)のを受けて、研究者たちは音声やオーディオを言語モデルで扱う方法を探り始めたんよ。初期の研究では、オーディオの意味トークン(音声の意味を表す単位)や音響トークン(音の特徴を表す単位)に対して言語モデルを学習させて、テキストなしで音声を生成できるようにしたんやな(Lakhotia et al., 2021; Nguyen et al., 2023; Borsos et al., 2023)。さらに、音声トークンとテキストを一緒に学習させることで、VALL-E(Wang et al., 2023b)やVioLA(Wang et al., 2023c)みたいなデコーダーのみのモデルが、音声認識とか音声翻訳とか音声合成とかのタスクをこなせるようになったんや。

せやけどな、上で挙げたモデルはLLM(大規模言語モデル)の上に構築されたもんやないねん。LLMのパワーをちゃんと活かすために、多くの研究がLLaMAみたいなLLMをベースにした音声言語モデルの構築方法を模索してるんよ。これはさらに2つのタイプに分けられるんやけど、1つ目のタイプは、SpeechGPT(Zhang et al., 2023; 2024a)、AudioPaLM(Rubenstein et al., 2023)、AnyGPT(Zhan et al., 2024)に代表されるやつで、LLMの語彙に音声トークンを追加して音声データを使って追加学習することで、ネイティブなマルチモーダル(音声とテキスト両方扱える)モデルを作るっちゅうアプローチやねん。

---

## Page 10

[](/attach/ccc1b58448a5adc5077958421399ee990bf9bd34875efdb6e1595a2df103845b_p010.png)

### 和訳

ほな、音声データとテキストデータを使うアプローチなんやけど、これってめっちゃ大量のデータと計算リソースが必要になるのが普通やねん。で、2つ目のタイプは、LLM(大規模言語モデル)の前に音声エンコーダーをくっつけて、モデル全体をファインチューニングすることで、音声を理解する力を持たせるっていうやり方やな(Shu et al., 2023; Deshmukh et al., 2023)。具体的に言うと、音声認識(Fathullah et al., 2024a; Yu et al., 2024; Ma et al., 2024b; Hono et al., 2024)とか、音声翻訳(Wu et al., 2023; Wang et al., 2023a; Chen et al., 2024)とか、その他の音声からテキストに変換する一般的なタスク(Chu et al., 2023; Tang et al., 2024; Chu et al., 2024; Fathullah et al., 2024b; Das et al., 2024; Hu et al., 2024)なんかがあるわけや。せやけど、こういうアプローチは音声や音の「理解」だけに集中してて、音声を「生成」する能力がないんよな。それに比べて、LLaMA-Omniは音声の理解と生成の両方の能力をLLMに持たせてるから、一般的な音声指示に従うタスクをこなせるようになっとるねん。最近やと、Mini-Omni(Xie & Wu, 2024)とかMoshi(Défossez et al., 2024)みたいな同時期の研究も、LLMとの音声対話に注目してて、テキストと音声を同時に生成することで音声応答の品質を上げようとしてるわけや。それらと比べて、ワイらの強みはこういうところやねん:(1)LLaMA-Omniは最新のLlama-3.1-8B-Instructモデルをベースにしてるから、推論能力がめっちゃ強い;(2)CTCっていう技術を使って、音声とテキストの応答の対応関係を適応的に学習するから、トレーニング中にあらかじめ音声とテキストを揃えとく必要がない;(3)トレーニングに使うデータはたったの20万サンプルで、他の研究と比べたら桁違いに少ないし、GPUも4台で3日間あれば十分やから、トレーニングコストがめちゃくちゃ低いねん。

**同時生成** ストリーミング生成っていうのは、入力全部を受け取る前にもう出力を作り始めるっていう技術やねん。なんでこれが大事かっていうと、ストリーミング音声認識とか同時通訳みたいな場面で、話してる人と聞いてる人の同期を保つのにめっちゃ重要やからやな。大規模言語モデルの場合、ストリーミングの音声合成コンポーネントがあると、モデルとユーザーの間の遅延をめっちゃ減らせるわけや。人気のあるストリーミング生成の方法は大きく3つのカテゴリに分かれるねん:モノトニックアテンションベースの方法(Raffel et al., 2017)、CTCベースの方法(Graves et al., 2006b)、そしてトランスデューサーベースの方法(Graves, 2012)や。モノトニックアテンションベースの方法は、従来のアテンションベースのシーケンス対シーケンスのフレームワーク(Bahdanau, 2014)をいじって、ストリーミング生成に対応させたもんやねん。これらの方法は、READ(読む)かWRITE(書く)かを決めるポリシーを管理する外部モジュールに頼ってて、固定式のもの(例えばWait-k(Ma et al., 2018))もあれば、適応式のもの(例えばMMA(Ma et al., 2019)、EDAtt(Papi et al., 2022)、Seg2Seg(Zhang & Feng, 2024))もあるねん。CTCベースの方法は、ターゲットの語彙にブランク記号(空白マーク)を追加して、これを「WAIT(待て)」アクションとして使うんや。ストリーミング推論は、隣り合った重複トークンとブランク記号を取り除くことで実現されてて、同時通訳やストリーミング音声合成でめっちゃ効果的やってことが証明されとる(Ma et al., 2023; Zhang et al., 2024b; Ma et al., 2024a)。トランスデューサーベースの方法は、CTCベースの方法の非自己回帰的な性質と、ターゲットトークン間の自己回帰的な依存関係のギャップを埋めるために設計されたもんやねん。これらのアプローチは、トークンの依存関係を捉えるための追加の予測器を導入してて、そのバリエーションは同時通訳(Liu et al., 2021; Tang et al., 2023)やストリーミング音声合成(Chen et al., 2021)でもめっちゃええ性能を見せとるわ。ストリーミングTTS(テキスト読み上げ)タスクについては、Tacotron 2(Shen et al., 2018)みたいなモデルをベースにした、シンプルな先読み戦略を使う研究がぎょうさんあるねん。例えば、数語先を待つ方法(Ma et al., 2020; Stephenson et al., 2020)とか、言語モデルを使って数語先を予測する方法(Saeki et al., 2021a;b; Liu et al., 2022)とかがあって、ストリーミング音声合成をよりええ感じにしとるわけや。Dekel et al.(2024)は、2つのカスケード(直列)型のストリーム可能なモデルを使って、音素と音声をリアルタイムで順番に生成することで、LLMの出力ストリームと同時にストリーミング音声合成を実現しとるねん。

**6 結論**

この論文では、LLMとの低遅延かつ高品質な音声対話を実現する革新的なモデルアーキテクチャ、LLaMA-Omniを提案しとるねん。LLaMA-Omniは最新のLlama-3.1-8B-Instructモデルをベースにしてて、音声理解のための音声エンコーダーと、テキストと音声の応答を同時に生成できるストリーミング音声デコーダーを追加しとるわけや。モデルを音声対話のシナリオに合わせるために、InstructionS2S-200Kっていう音声指示データセットを作ったねん。これには20万件の音声指示とそれに対応する音声応答が入っとる。実験結果を見ると、従来の音声言語モデルと比べて、LLaMA-Omniは内容もスタイルもめっちゃ優れた応答を返せて、応答の遅延はなんとたったの236ミリ秒やねん。しかもや、LLaMA-OmniのトレーニングはGPU 4台でたった3日もかからへんから、最新のLLMをベースにした音声対話モデルをサクッと開発できるっていうわけや。将来的には、生成する音声応答の表現力をもっと豊かにすることと、リアルタイム対話の能力をさらに向上させることを計画しとるで。

---

## Page 11

[](/attach/ccc1b58448a5adc5077958421399ee990bf9bd34875efdb6e1595a2df103845b_p011.png)

### 和訳

ICLR 2025の学会論文として発表済み

**謝辞**

匿名の査読者のみなさん、めっちゃ鋭くて貴重なコメントほんまにありがとうございました。この論文は中国国家自然科学基金(助成番号 No.62376260)の支援を受けてるねん。

**参考文献**

Dzmitry Bahdanau. ニューラル機械翻訳で、アライメント(どの単語に注目するか)と翻訳を一緒に学習するっちゅう話やねん。arXivプレプリント arXiv:1409.0473, 2014.

Zalán Borsos, Raphaël Marinier, Damien Vincent, Eugene Kharitonov, Olivier Pietquin, Matt Sharifi, Dominik Roblek, Olivier Teboul, David Grangier, Marco Tagliasacchi, ほか. AudioLM:言語モデルのやり方で音声を生成するっちゅうアプローチやねん。IEEE/ACM transactions on audio, speech, and language processing, 31:2523–2533, 2023.

Tom Brown, Benjamin Mann, Nick Ryder, Melanie Subbiah, Jared D Kaplan, Prafulla Dhariwal, Arvind Neelakantan, Pranav Shyam, Girish Sastry, Amanda Askell, Sandhini Agarwal, Ariel Herbert-Voss, Gretchen Krueger, Tom Henighan, Rewon Child, Aditya Ramesh, Daniel Ziegler, Jeffrey Wu, Clemens Winter, Chris Hesse, Mark Chen, Eric Sigler, Mateusz Litwin, Scott Gray, Benjamin Chess, Jack Clark, Christopher Berner, Sam McCandlish, Alec Radford, Ilya Sutskever, and Dario Amodei. 言語モデルって、ほんの数例見せるだけでめっちゃ色んなタスクできるようになるねん(few-shot学習ってやつや)。H. Larochelle, M. Ranzato, R. Hadsell, M.F. Balcan, and H. Lin (編), Advances in Neural Information Processing Systems, volume 33, pp. 1877–1901. Curran Associates, Inc., 2020. URL https://proceedings.neurips.cc/paper_files/paper/2020/file/1457c0d6bfcb4967418bfb8ac142f64a-Paper.pdf.

Jiawei Chen, Xu Tan, Yichong Leng, Jin Xu, Guihua Wen, Tao Qin, and Tie-Yan Liu. SpeechT:テキストから音声への変換、さらにそれ以上のことができるトランスデューサーやねん。Advances in Neural Information Processing Systems, 34:6621–6633, 2021.

Xi Chen, Songyang Zhang, Qibing Bai, Kai Chen, and Satoshi Nakamura. LLaST:大規模言語モデルの力を借りて、エンドツーエンドの音声翻訳システムをめっちゃ改良したやつやねん。Lun-Wei Ku, Andre Martins, and Vivek Srikumar (編), Findings of the Association for Computational Linguistics ACL 2024, pp. 6976–6987, バンコク(タイ)およびオンライン, 2024年8月. Association for Computational Linguistics. URL https://aclanthology.org/2024.findings-acl.416.

Hyundong Justin Cho, Nicolaas Paul Jedema, Leonardo F. R. Ribeiro, Karishma Sharma, Pedro Szekely, Alessandro Moschitti, Ruben Janssen, and Jonathan May. 話し言葉にふさわしいように指示チューニングされた言語モデルの話やで。Yaser Al-Onaizan, Mohit Bansal, and Yun-Nung Chen (編), Proceedings of the 2024 Conference on Empirical Methods in Natural Language Processing, pp. 10652–10670, マイアミ(フロリダ州、アメリカ), 2024年11月. Association for Computational Linguistics. URL https://aclanthology.org/2024.emnlp-main.595.

Yunfei Chu, Jin Xu, Xiaohuan Zhou, Qian Yang, Shiliang Zhang, Zhijie Yan, Chang Zhou, and Jingren Zhou. Qwen-Audio:統一された大規模音声言語モデルで、いろんな種類の音声理解をまとめてレベルアップさせるっちゅう研究やねん。arXivプレプリント arXiv:2311.07919, 2023.

Yunfei Chu, Jin Xu, Qian Yang, Haojie Wei, Xipin Wei, Zhifang Guo, Yichong Leng, Yuanjun Lv, Jinzheng He, Junyang Lin, Chang Zhou, and Jingren Zhou. Qwen2-Audio テクニカルレポートやで。arXivプレプリント arXiv:2407.10759, 2024.

Nilaksh Das, Saket Dingliwal, Srikanth Ronanki, Rohit Paturi, David Huang, Prashant Mathur, Jie Yuan, Dhanush Bekal, Xing Niu, Sai Muralidhar Jayanthi, ほか. SpeechVerse:めっちゃ大規模でいろんなタスクに汎用的に使える音声言語モデルやねん。arXivプレプリント arXiv:2405.08295, 2024.

Alexandre Défossez, Laurent Mazaré, Manu Orsini, Amélie Royer, Patrick Pérez, Hervé Jégou, Edouard Grave, and Neil Zeghidour. Moshi:リアルタイムの対話ができる音声とテキストの基盤モデルやねん。テクニカルレポート, Kyutai, 2024年9月. URL http://kyutai.org/Moshi.pdf.

11

---

## Page 12

[](/attach/ccc1b58448a5adc5077958421399ee990bf9bd34875efdb6e1595a2df103845b_p012.png)

### 和訳

ICLR 2025の学会論文として発表済み

Avihu Dekel、Slava Shechtman、Raul Fernandez、David Haws、Zvi Kons、Ron Hoory。「考えながらしゃべれ:テキスト生成中のストリーミング音声合成」。ICASSP 2024 - 2024年IEEE国際音響・音声・信号処理会議(ICASSP)、pp. 11931–11935。IEEE、2024年。

→ これな、テキスト作ってる最中にリアルタイムで音声も一緒に作っちゃおうっていう研究やねん。待たんでええから、めっちゃスムーズに喋れるようになるんやで。

Soham Deshmukh、Benjamin Elizalde、Rita Singh、Huaming Wang。「Pengi:音声タスク向けの音声言語モデル」。Advances in Neural Information Processing Systems、36:18090–18108、2023年。

→ Pengiっていう、音声に関するいろんなタスクをこなせる言語モデルの話やな。音声を理解して色々できるAIを作ったで、っていう研究やねん。

Ning Ding、Yulin Chen、Bokai Xu、Yujia Qin、Zhi Zheng、Shengding Hu、Zhiyuan Liu、Maosong Sun、Bowen Zhou。「高品質な指示付き会話データをスケールさせてチャット言語モデルを強化する」。arXivプレプリント arXiv:2305.14233、2023年。

→ ようは、ええ感じの会話データをめっちゃ大量に用意したら、チャットAIがもっと賢くなるでーっていう研究やな。質の高いデータが大事やねんっていうことやで。

Zhihao Du、Qian Chen、Shiliang Zhang、Kai Hu、Heng Lu、Yexin Yang、Hangrui Hu、Siqi Zheng、Yue Gu、Ziyang Ma、ほか。「CosyVoice:教師あり意味トークンに基づくスケーラブルな多言語ゼロショットテキスト音声合成器」。arXivプレプリント arXiv:2407.05407、2024年。

→ CosyVoiceっていう、一回も聞いたことない声でもいきなり喋れる(ゼロショット)音声合成システムやねん。しかも多言語対応でスケールもするっていう、なかなかすごいやつやで。

Abhimanyu Dubey、Abhinav Jauhri、Abhinav Pandey、Abhishek Kadian、Ahmad Al-Dahle、Aiesha Letman、Akhil Mathur、Alan Schelten、Amy Yang、Angela Fan、ほか。「Llama 3モデル群」。arXivプレプリント arXiv:2407.21783、2024年。

→ これはMetaが出したLlama 3っていう大規模言語モデルのファミリーの論文やな。色んなサイズのモデルをまとめて紹介してるんやで。

Yassir Fathullah、Chunyang Wu、Egor Lakomkin、Junteng Jia、Yuan Shangguan、Ke Li、Jinxi Guo、Wenhan Xiong、Jay Mahadeokar、Ozlem Kalinli、ほか。「大規模言語モデルに音声認識能力を持たせるプロンプティング」。ICASSP 2024 - 2024年IEEE国際音響・音声・信号処理会議(ICASSP)、pp. 13351–13355。IEEE、2024a。

→ でっかい言語モデルに「音声も聞けるようにしたろ!」ってプロンプトの工夫で音声認識能力を付け加えた研究やねん。なんでかっていうと、わざわざ一から作り直さんでも、プロンプトでいけるんちゃうかっていう発想やな。

Yassir Fathullah、Chunyang Wu、Egor Lakomkin、Ke Li、Junteng Jia、Yuan Shangguan、Jay Mahadeokar、Ozlem Kalinli、Christian Fuegen、Mike Seltzer。「AudioChatLlama:大規模言語モデルに汎用的な音声能力を持たせる試み」。2024年北米計算言語学会(NAACL):人間言語技術会議論文集(第1巻:ロングペーパー)、pp. 5522–5532、2024b。

→ AudioChatLlamaっていう、LLMに音声を扱う汎用的な能力を持たせようっていうプロジェクトやな。テキストだけやなくて、音声もまとめて処理できるようにしたいねんっていう話やで。

Alex Graves。「リカレントニューラルネットワークによる系列変換」。arXivプレプリント arXiv:1211.3711、2012年。

→ RNN(リカレントニューラルネットワーク)を使って、ある系列データを別の系列データに変換する方法の研究やな。これ、めっちゃ基礎的で重要な論文やで。

Alex Graves、Santiago Fernández、Faustino Gomez、Jürgen Schmidhuber。「コネクショニスト時系列分類:リカレントニューラルネットワークによるセグメント化されていない系列データのラベリング」。第23回国際機械学習会議(ICML '06)論文集、pp. 369–376、ニューヨーク、NY、USA、2006a。Association for Computing Machinery。ISBN 1595933832。doi: 10.1145/1143844.1143891。URL https://doi.org/10.1145/1143844.1143891。

→ CTC(コネクショニスト時系列分類)っていう、ほんまに画期的な手法を提案した論文やねん。何がすごいかっていうと、データに「ここからここまでがこの文字」みたいな区切り情報がなくても、RNNでちゃんとラベル付けできるようにしたんやで。音声認識とかでめっちゃ使われてる技術やな。

Alex Graves、Santiago Fernández、Faustino Gomez、Jürgen Schmidhuber。「コネクショニスト時系列分類:リカレントニューラルネットワークによるセグメント化されていない系列データのラベリング」。第23回国際機械学習会議論文集、pp. 369–376、2006b。

→ 上と同じCTCの論文やけど、別の会議録として引用されてるバージョンやな。

Yukiya Hono、Koh Mitsuda、Tianyu Zhao、Kentaro Mitsui、Toshiaki Wakatsuki、Kei Sawada。「事前学習済み音声・言語モデルを統合したエンドツーエンド音声認識」。Lun-Wei Ku、Andre Martins、Vivek Srikumar(編)、計算言語学会ACL 2024 Findings、pp. 13289–13305、バンコク(タイ)およびオンライン、2024年8月。Association for Computational Linguistics。URL https://aclanthology.org/2024.findings-acl.787。

→ すでに学習済みの音声モデルと言語モデルをガッチャンコして、端から端まで(エンドツーエンドで)音声認識するシステムを作った研究やな。別々に作ったモデルをうまいこと組み合わせるのがミソやで。

Wei-Ning Hsu、Benjamin Bolte、Yao-Hung Hubert Tsai、Kushal Lakhotia、Ruslan Salakhutdinov、Abdelrahman Mohamed。「HuBERT:隠れユニットのマスク予測による自己教師あり音声表現学習」。IEEE/ACM Transactions on Audio, Speech, and Language Processing、29:3451–3460、2021年。

→ HuBERTっていう、音声の表現を自己教師あり学習で獲得する手法やねん。なんでかっていうと、音声データの一部を隠して「ここ何やった?」って予測させることで、音声の特徴をめっちゃうまく学習できるようにしたんやで。BERTの音声版みたいなもんやな。

Shujie Hu、Long Zhou、Shujie Liu、Sanyuan Chen、Hongkun Hao、Jing Pan、Xunying Liu、Jinyu Li、Sunit Sivasankaran、Linquan Liu、ほか。「WavLLM:頑健で適応的な音声大規模言語モデルに向けて」。arXivプレプリント arXiv:2404.00656、2024年。

→ WavLLMっていう、ノイズとかにも強くて色んな場面に適応できる音声向けの大規模言語モデルを目指した研究やな。ほんまに実用的なもん作ろうとしてるのがええ感じやで。

Keith ItoとLinda Johnson。「LJ Speechデータセット」。https://keithito.com/LJ-Speech-Dataset/、2017年。

→ LJ Speechっていう、音声合成の研究でめっちゃよく使われてる有名なデータセットやな。一人の女性が英語の文章を読み上げたデータで、音声合成のベンチマークとしてはド定番やで。

---

## Page 13

[](/attach/ccc1b58448a5adc5077958421399ee990bf9bd34875efdb6e1595a2df103845b_p013.png)

### 和訳

Jaehyeon Kim, Jungil Kong, Juhee Son. 「敵対的学習付き条件付き変分オートエンコーダでエンドツーエンドのテキスト音声合成やるで」っていう研究や。要するに、文字から音声を一気に作る仕組みに、VAEっていう生成モデルとGANっていう敵対的な学習をガッチャンコして使ったやつやねん。International Conference on Machine Learning, pp. 5530–5540. PMLR, 2021.

Jungil Kong, Jaehyeon Kim, Jaekyoung Bae. 「HiFi-GAN:効率よくてめっちゃ高品質な音声合成のための敵対的生成ネットワーク」や。GAN使うて、めちゃくちゃリアルな音声をサクッと作れるようにしたやつやな。H. Larochelle, M. Ranzato, R. Hadsell, M.F. Balcan, H. Lin(編), Advances in Neural Information Processing Systems, volume 33, pp. 17022–17033. Curran Associates, Inc., 2020. URL https://proceedings.neurips.cc/paper_files/paper/2020/file/c5d736809766d46260d816d8dbc9eb44-Paper.pdf.

Kushal Lakhotia, Eugene Kharitonov, Wei-Ning Hsu, Yossi Adi, Adam Polyak, Benjamin Bolte, Tu-Anh Nguyen, Jade Copet, Alexei Baevski, Abdelrahman Mohamed, ほか. 「生の音声データから生成型の音声言語モデリングやってみた」っていう論文やねん。つまり、テキストとか使わんと、音声そのものから言語モデル作ろうっていうチャレンジやな。Transactions of the Association for Computational Linguistics, 9:1336–1354, 2021.

Xuechen Li, Tianyi Zhang, Yann Dubois, Rohan Taori, Ishaan Gulrajani, Carlos Guestrin, Percy Liang, Tatsunori B. Hashimoto. 「AlpacaEval:命令に従うモデルの自動評価ツール」や。LLMがちゃんと指示通り動けてるかを自動で採点してくれるやつやねん。めっちゃ便利やで。https://github.com/tatsu-lab/alpaca_eval, 5 2023.

Dan Liu, Mengge Du, Xiaoxi Li, Ya Li, Enhong Chen. 「同時翻訳のためのクロスアテンション強化トランスデューサネットワーク」や。同時通訳みたいに、相手が喋ってる最中にリアルタイムで翻訳する仕組みに、クロスアテンションっていう「どこに注目するか」の仕組みをパワーアップさせたやつやねん。Proceedings of the 2021 Conference on Empirical Methods in Natural Language Processing, pp. 39–55, 2021.

Danni Liu, Changhan Wang, Hongyu Gong, Xutai Ma, Yun Tang, Juan Pino. 「最初から最後まで:同時音声間翻訳におけるインクリメンタル音声合成の遅延削減戦略」や。なんでかっていうと、同時通訳で音声から音声に変換するとき、どうしても遅延が出るやん?そのタイムラグをいかに減らすかっていう工夫をまとめた研究やねん。Interspeech 2022, pp. 1771–1775, 2022. doi: 10.21437/Interspeech.2022-10568.

Mingbo Ma, Liang Huang, Hao Xiong, Renjie Zheng, Kaibo Liu, Baigong Zheng, Chuanqiang Zhang, Zhongjun He, Hairong Liu, Xing Li, ほか. 「STACL:プレフィックス同士の枠組みを使った、暗黙的な先読みと制御可能な遅延による同時翻訳」や。同時翻訳で、まだ来てない部分をうまいこと予測しながら、遅延もコントロールできるっていうめっちゃ賢いフレームワークやねん。arXiv preprint arXiv:1810.08398, 2018.

Mingbo Ma, Baigong Zheng, Kaibo Liu, Renjie Zheng, Hairong Liu, Kainan Peng, Kenneth Church, Liang Huang. 「プレフィックス同士のフレームワークによるインクリメンタルなテキスト音声合成」や。文章がちょっとずつ入ってくる状況で、途中からでも音声をどんどん作っていくっていう仕組みやねん。Findings of the Association for Computational Linguistics: EMNLP 2020, pp. 3886–3896, 2020.

Xutai Ma, Juan Pino, James Cross, Liezl Puzon, Jiatao Gu. 「モノトニックマルチヘッドアテンション」や。アテンション機構をモノトニック、つまり「前に戻らへん」ように制約つけたバージョンで、しかもマルチヘッドで複数の注目点を同時に扱えるようにしたやつやな。arXiv preprint arXiv:1909.12406, 2019.

Zhengrui Ma, Shaolei Zhang, Shoutao Guo, Chenze Shao, Min Zhang, Yang Feng. 「同時翻訳のための非自己回帰ストリーミングTransformer」や。普通の翻訳モデルは一個ずつ順番に単語出すけど、これは非自己回帰、つまり一気にバッと出力できるタイプで、しかもストリーミングに対応してるっていうほんまにすごいやつやねん。Proceedings of the 2023 Conference on Empirical Methods in Natural Language Processing, pp. 5177–5190, 2023.

Zhengrui Ma, Qingkai Fang, Shaolei Zhang, Shoutao Guo, Yang Feng, Min Zhang. 「エンドツーエンドの同時音声からなんでも翻訳のための非自己回帰生成フレームワーク」や。音声入力をリアルタイムで受け取って、テキストにも音声にも一気に変換できるっていう、めっちゃ欲張りなフレームワークやねん。arXiv preprint arXiv:2406.06937, 2024a.

Ziyang Ma, Guanrou Yang, Yifan Yang, Zhifu Gao, Jiaming Wang, Zhihao Du, Fan Yu, Qian Chen, Siqi Zheng, Shiliang Zhang, ほか. 「LLMにめっちゃ強い音声認識能力つけるびっくりするくらいシンプルなやり方」っていう論文や。ほんまにタイトル通りで、大規模言語モデルに音声認識の力をつけるのに、めっちゃ簡単な方法でいけたでっていう話やねん。arXiv preprint arXiv:2402.08846, 2024b.

Tu Anh Nguyen, Eugene Kharitonov, Jade Copet, Yossi Adi, Wei-Ning Hsu, Ali Elkahky, Paden Tomasello, Robin Algayres, Benoît Sagot, Abdelrahman Mohamed, Emmanuel Dupoux. 「生成型の音声対話言語モデリング」や。人間同士の会話みたいに、音声でやり取りできる対話モデルを生成的に作ろうっていう研究やねん。Transactions of the Association for Computational Linguistics, 11:250–266, 2023. doi: 10.1162/tacl_a_00545. URL https://aclanthology.org/2023.tacl-1.15.

OpenAI. 「ChatGPTの紹介」や。みんな知ってるあのChatGPTが初めて世に出た時の発表やで。2022. URL https://openai.com/blog/chatgpt.

OpenAI. 「GPT-4oこんにちは」や。マルチモーダルに対応したGPT-4oのお披露目発表やな。2024. URL https://openai.com/index/hello-gpt-4o/.

Sara Papi, Matteo Negri, Marco Turchi. 「同時音声翻訳のガイドとしてのアテンション」や。同時通訳するときに、アテンション機構を道しるべみたいに使って、「今どこに注目したらええか」を導いてあげるっていうアイデアの研究やねん。arXiv preprint arXiv:2212.07850, 2022.

---

## Page 14

[](/attach/ccc1b58448a5adc5077958421399ee990bf9bd34875efdb6e1595a2df103845b_p014.png)

### 和訳

ICLR 2025の学会論文として発表済み

Adam Polyakら。「離散的に分離した自己教師あり表現からの音声再合成」。要するに、音声をバラバラの部品みたいに分けて学習させた表現から、もっかい音声を組み立て直すっちゅう研究やねん。Interspeech 2021で発表されとるで。

Alec Radfordら。「大規模な弱教師ありデータを使ったロバストな音声認識」。めっちゃ大量のデータ使って、ちょっとくらいノイズがあっても頑丈に音声認識できるようにしたっちゅう話やな。国際機械学習会議(ICML)、28492–28518ページ、PMLR、2023年。

Colin Raffelら。「単調アライメントを強制することによるオンライン・線形時間アテンション」。なんでかっていうと、普通のアテンションって計算コストえぐいねんけど、「前にしか進まへん」っていう制約つけることで、リアルタイムで処理できるようにしたんやで。ICML、2837–2846ページ、PMLR、2017年。

Paul K Rubensteinら。「AudioPaLM:喋れて聞けるデカい言語モデル」。ほんまにそのまんまやねんけど、大規模言語モデルに音声の入出力つけて、聞いたり喋ったりできるようにしたっちゅうやつや。arXivプレプリント arXiv:2306.12925、2023年。

Takaaki Saekiら。「大規模事前学習済み言語モデルを使った擬似先読みによる逐次テキスト音声合成」。ちょっと先の文章を予測しながらリアルタイムで音声合成していくっちゅう仕組みやねん。IEEE信号処理レター、28巻、857–861ページ、2021年a。

Takaaki Saekiら。「蒸留されたコンテキスト予測ネットワークによる低遅延逐次テキスト音声合成」。さっきのやつをさらに軽くして、もっと遅延少なくしたバージョンやな。2021年IEEE自動音声認識・理解ワークショップ(ASRU)、749–756ページ、IEEE、2021年b。

Takaaki Saekiら。「UTMOS:VoiceMOSチャレンジ2022のための東大猿渡研システム」。音声の品質を自動で評価するシステムのコンペに出したやつやねん。Interspeech 2022、4521–4525ページ、2022年。doi: 10.21437/Interspeech.2022-439。

Jonathan Shenら。「メルスペクトログラム予測を条件としたWaveNetによる自然な音声合成」。めっちゃざっくり言うと、まず音声の「設計図」みたいなメルスペクトログラムを予測して、それをWaveNetっちゅうモデルに食わせて自然な音声を作るっちゅう二段構えの方法やねん。2018年IEEE ICASSP、4779–4783ページ、2018年。doi: 10.1109/ICASSP.2018.8461368。

Yu Shuら。「LLaSM:大規模言語・音声モデル」。言語モデルと音声モデルをガッチャンコして一つにしたやつや。arXivプレプリント arXiv:2308.15930、2023年。

Brooke Stephensonら。「未来が何をもたらすか:逐次ニューラルTTSにおける先読みの影響の調査」。リアルタイム音声合成するとき、ちょっと先の文章が見えてたらどんだけ品質変わるんか調べたっちゅう研究やな。Interspeech、2020年。URL https://api.semanticscholar.org/CorpusID:221507498。

Changli Tangら。「SALMONN:大規模言語モデルに汎用的な聴覚能力を持たせる」。名前がサーモンみたいでおもろいけど、LLMに「なんでも聞ける耳」をつけようっちゅう研究やねん。ICLR 2024。URL https://openreview.net/forum?id=14rn7HpKVk。

Yun Tangら。「音声テキスト変換タスクのためのハイブリッドトランスデューサーとアテンションベースのエンコーダ・デコーダモデリング」。トランスデューサーとアテンション方式のええとこ取りしたハイブリッドモデルやねん。ACL 2023(第1巻:長編論文)、12441–12455ページ、2023年。

Rohan Taoriら。「Stanford Alpaca:指示に従うLlamaモデル」。Llamaっちゅうモデルに「人間の指示に従え」って学習させたやつやな。https://github.com/tatsu-lab/stanford_alpaca、2023年。

Ashish Vaswaniら。「Attention Is All You Need(アテンションさえあればええねん)」。これはほんまに歴史変えた論文やで。それまで使われてたRNNとかCNNとか全部捨てて、アテンション機構だけでモデル組んだら、めっちゃ性能良かったっちゅう話や。Transformerっちゅう今のAIの基盤になっとるアーキテクチャはここから生まれたんやで。NeurIPS、第30巻、Curran Associates, Inc.、2017年。URL https://proceedings.neurips.cc/paper_files/paper/2017/file/3f5ee243547dee91fbd053c1c4a845aa-Paper.pdf。

---

## Page 15

[](/attach/ccc1b58448a5adc5077958421399ee990bf9bd34875efdb6e1595a2df103845b_p015.png)

### 和訳

ICLR 2025の学会論文として発表

Chen Wangら(2023a)。BLSP:続き書きの振る舞いを揃えることで、言語と音声の事前学習をブートストラップする方法やねん。要するに、「続きを書く」っていうタスクで言語と音声の学習をうまいこと合わせましょう、っちゅう話やな。arXivプレプリント arXiv:2309.00916。

Chengyi Wangら(2023b)。ニューラルコーデック言語モデルは、ゼロショットでテキストから音声を合成できるで、っちゅう論文やねん。つまり、一回も見たことない声でも、学習なしにいきなり喋れるようになるっちゅうめっちゃすごい話や。arXivプレプリント arXiv:2301.02111。

Tianrui Wangら(2023c)。VIOLA:音声認識も音声合成も翻訳も、全部まとめて一つのコーデック言語モデルでやったろうやないか、っちゅう統合型のモデルやねん。arXivプレプリント arXiv:2305.16107。

Jian Wuら(2023)。音声からテキストへの変換と大規模言語モデルの統合について、デコーダだけのアーキテクチャでいけるんちゃう?っちゅう研究やねん。なんでかっていうと、デコーダだけのシンプルな構造でも十分うまくいくことがわかったからやな。2023 IEEE自動音声認識・理解ワークショップ(ASRU)、pp. 1–8。

Zhifei XieとChangqiao Wu(2024)。Mini-Omni:言語モデルが、ストリーミングで考えながら聞いて喋れるようになったで、っちゅうほんまにびっくりする話やねん。リアルタイムで音声のやり取りができるモデルってことやな。arXivプレプリント arXiv:2408.16725。

Wenyi Yuら(2024)。音声エンコーダと大規模言語モデルをつないで、音声認識(ASR)をやろうっちゅう研究やねん。ICASSP 2024、IEEE国際音響・音声・信号処理学会、pp. 12637–12641。

Jun Zhanら(2024)。AnyGPT:離散的な系列モデリングで、いろんなモダリティ(テキストも音声も画像も)を全部まとめて扱える統合型マルチモーダル大規模言語モデルやねん。めっちゃ欲張りなモデルやけど、ちゃんと動くからすごいわ。第62回計算言語学会年次大会(ACL)、長論文部門、pp. 9637–9662、バンコク、タイ。

Dong Zhangら(2023)。SpeechGPT:大規模言語モデルに、生まれつきのクロスモーダル会話能力を持たせたろう、っちゅう研究やねん。つまり、テキストだけちゃうて、音声でも自然に会話できるようにしたモデルやな。計算言語学会EMNLP 2023 Findings、pp. 15757–15773、シンガポール。

Dong Zhangら(2024a)。SpeechGPT-Gen:情報の連鎖(Chain-of-Information)を使って、音声生成をスケールアップさせたろう、っちゅう話やねん。前のSpeechGPTをさらにパワーアップさせたバージョンやな。arXivプレプリント arXiv:2401.13527。

Shaolei ZhangとYang Feng(2024)。同時系列生成のための統一的なセグメント間フレームワークやねん。要するに、入力が来るのを全部待たんでも、区切り(セグメント)ごとにリアルタイムで出力を生成できる仕組みをまとめたったで、っちゅうことやな。Advances in Neural Information Processing Systems(NeurIPS)、36。

Shaolei Zhangら(2024b)。StreamSpeech:マルチタスク学習を使った同時音声間翻訳やねん。聞きながらリアルタイムで別の言語に翻訳して喋る、っちゅうめっちゃ実用的な研究やな。arXivプレプリント arXiv:2406.03049。

15

---

## Page 16

[](/attach/ccc1b58448a5adc5077958421399ee990bf9bd34875efdb6e1595a2df103845b_p016.png)

### 和訳

ICLR 2025の学会論文として発表済み

## 付録A

### LLaMA-Omniのプロンプトテンプレート

<|begin of text|><|start header id|>system<|end header id|>

あんたは言葉と音声の両方がわかる便利なアシスタントやで。ユーザーが喋った内容をちゃんと理解して、自然な言葉でいろんなタスクをお手伝いするんや。<|eot id|>

<|start header id|>user<|end header id|>

<speech>

ユーザーが喋った質問にちゃんと答えたってな。<|eot id|>

<|start header id|>assistant<|end header id|>

### ChatGPTでスコアリングするためのプロンプト(モデル:GPT-4o)

ちょっと手伝ってほしいことがあんねん。音声でやりとりするシナリオで、いくつかのモデルの性能を評価してほしいんや。モデルはユーザーの音声入力を受け取って、音声で返事を返すっていう仕組みやねん。評価するために、ユーザーの音声入力もモデルの音声応答も、両方とも自動音声認識(ASR)でテキストに書き起こしてあるで。あんたにやってほしいのは、ユーザーの入力の書き起こし[Instruction]とモデルの出力の書き起こし[Response]を見て、モデルの応答を評価することや。役に立ってるか、的を射てるか、流暢か、音声のやりとりとしてふさわしいかとか、そういうポイントを考慮して、1から5のスケールでスコアを1つつけてな。

以下がユーザーの指示とモデルの応答の書き起こしやで:

### [Instruction]: {instruction}

### [Response]: {response}

評価が終わったら、スコアをJSON形式で出力してな:{score: ...}。説明はいらんで。

### 指示文の書き換え用プロンプト(モデル:Llama-3-70B-Instruct)

下に、ユーザーの指示が入った指示データがあるねん。これを音声入力に対応した大規模言語モデルの学習用に、音声バージョンに作り変えたいんや。せやから、以下の要件に従って指示データを書き換えてくれへん?

1. 人が実際に喋ってるみたいに指示を修正して、適度にフィラー(つなぎ言葉)を入れてな(ただし「you know」とか「like」とかを入れすぎんようにな)。

2. TTSモデル(テキスト読み上げモデルのことやで)で合成でけへん内容は含めんといてな。数字はアラビア数字やなくて英語の単語で書くこと。

3. 質問はだらだら長くせんと、比較的短くまとめてな。

[instruction]: {instruction}

以下のJSON形式で出力してな:{"question": {question}}。

### 応答生成用プロンプト(モデル:Llama-3-70B-Instruct)

下にユーザーが喋った質問を書き起こしたテキストがあるで。この質問に対する応答を作ってほしいんやけど、作った応答はTTS(テキスト読み上げ)で音声に変換されるねん。せやから以下の要件を守ってな:

1. 応答にはTTSモデルで合成でけへん内容を入れんといてな。カッコとか番号付きリストとかはアカンで。数字はアラビア数字やなくて英語の単語で書くこと。

2. 応答はめっちゃ簡潔に要点だけにして、長々とした説明は避けてな。

[instruction]: {instruction}

以下のJSON形式で出力してな:{"response": {response}}。

## 付録B ケーススタディ

いろんなモデルの応答の違いを直感的にわかってもらうために、表3に例を載せてるで。見てもらったらわかるけど、Qwen2-Audioの応答はめっちゃ長いし、改行とかカッコみたいに音声に合成でけへん要素が入ってしまってるんや。応答は

16

---

## Page 17

[](/attach/ccc1b58448a5adc5077958421399ee990bf9bd34875efdb6e1595a2df103845b_p017.png)

### 和訳

せやなぁ、ほなこの論文の内容を翻訳していくで!

---

ICLR 2025の学会論文として発表されたやつやで

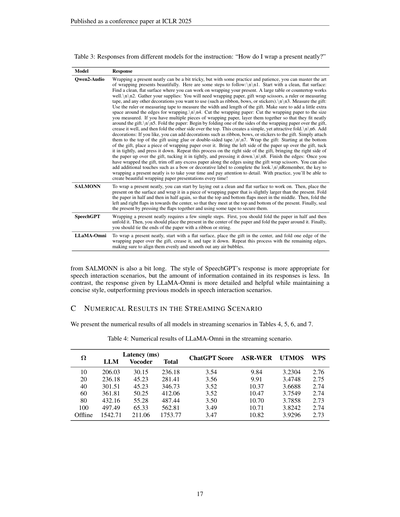

**表3:「プレゼントをきれいに包むにはどうしたらいい?」っていう指示に対する、いろんなモデルの回答**

| モデル | 回答 |

|--------|------|

**Qwen2-Audio** の回答:プレゼントをきれいに包むんはちょっとコツがいるけど、練習と根気があればめっちゃ上手に包めるようになるで。手順はこんな感じや:

1. まずきれいで平らな場所を確保するんや。大きいテーブルとかカウンターがええな。

2. 必要なもんを揃えるで:包装紙、ハサミ、定規かメジャー、あと飾りに使いたいもん(リボンとかリボン飾り、シールとかな)。

3. プレゼントのサイズを測るんや。幅と長さを測って、端っこの折り返し分もちょっと余裕持たせてな。

4. 包装紙を測ったサイズに切るで。何枚か使う場合は、プレゼントにぴったり合うように重ねるとええ。

5. 紙を折っていくで:まず包装紙の片方をプレゼントの上に被せて、しっかり折り目つけて、もう片方も上から被せる。シンプルやけどきれいな仕上がりになるで。

6. 飾り付けしたかったらここでやるんや。リボンとかリボン飾り、シールをのりか両面テープで上につけるとええ。

7. プレゼントを包んでいくで:下から包装紙を被せて、左側を持ち上げてぴっちり押さえ込む。右側も同じようにやるんや。

8. 最後に端っこを仕上げるで:余った紙をハサミで切り揃えて、リボン飾りとか名前ラベルとかつけたら完成や。

大事なんは焦らんとじっくりやることやで。練習すればするほどめっちゃきれいに包めるようになるで!

**SALMONN** の回答:プレゼントをきれいに包むには、まずきれいで平らな場所を用意するんや。ほんでプレゼントよりちょい大きめの包装紙を敷いて、紙を半分に折って、さらにもう半分折って、上と下のヒラヒラが真ん中で合わさるようにするねん。ほんで左右のヒラヒラを中心に向かって折り込んで、上下で合わさるようにする。最後にヒラヒラ同士を押さえつけてテープで留めたら完成や。

**SpeechGPT** の回答:プレゼントをきれいに包むには、まず紙を半分に折ってから広げるんや。ほんでプレゼントを紙の真ん中に置いて、紙で包む。最後にリボンか紐で端っこを結んだらおしまいや。

**LLaMA-Omni** の回答:プレゼントをきれいに包むには、まず平らな場所にプレゼントを置いて、包装紙の片端をプレゼントの上に被せて折り目つけてテープで留める。残りの端も同じようにやって、ちゃんと揃えて、空気のシワを伸ばすとええで。

---

SALMONNの回答もちょっと長めやな。SpeechGPTの回答は音声でやり取りするシーンにはスタイル的にちょうどええねんけど、情報量がちょっと少ないんよな。それに比べてLLaMA-Omniの回答は、簡潔なスタイルを保ちつつ中身もしっかりしてて、音声でやり取りするような場面では今までのモデルよりも優れてるっちゅうことやねん。

---

**C ストリーミング環境での数値結果**

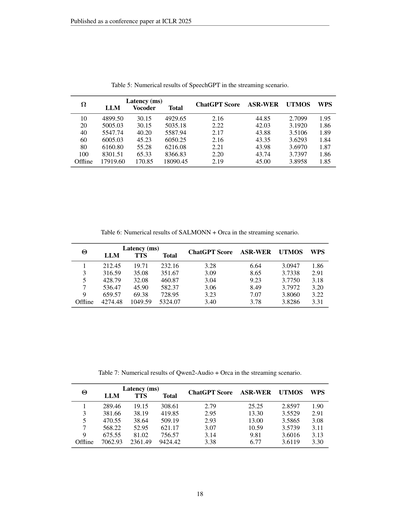

ストリーミング環境でのすべてのモデルの数値結果を表4、5、6、7に載せてるで。

**表4:ストリーミング環境でのLLaMA-Omniの数値結果**

| Ω | レイテンシ(ミリ秒) | | | ChatGPTスコア | ASR-WER | UTMOS | WPS |

|---|---|---|---|---|---|---|---|

| | LLM | ボコーダー | 合計 | | | | |

| 10 | 206.03 | 30.15 | 236.18 | 3.54 | 9.84 | 3.2304 | 2.76 |

| 20 | 236.18 | 45.23 | 281.41 | 3.56 | 9.91 | 3.4748 | 2.75 |

| 40 | 301.51 | 45.23 | 346.73 | 3.52 | 10.37 | 3.6688 | 2.74 |

| 60 | 361.81 | 50.25 | 412.06 | 3.52 | 10.47 | 3.7549 | 2.74 |

| 80 | 432.16 | 55.28 | 487.44 | 3.50 | 10.70 | 3.7858 | 2.73 |

| 100 | 497.49 | 65.33 | 562.81 | 3.49 | 10.71 | 3.8242 | 2.74 |

| オフライン | 1542.71 | 211.06 | 1753.77 | 3.47 | 10.82 | 3.9296 | 2.73 |

ちょっとこの表の見方を説明するとな、Ωっちゅうのはストリーミングの設定パラメータで、数字が小さいほどリアルタイム性が高いっちゅうことやねん。レイテンシは応答が返ってくるまでの遅延時間のことで、LLMっちゅうのは大規模言語モデルの処理時間、ボコーダーっちゅうのはテキストを音声に変換する部分の時間や。ChatGPTスコアは回答の質の評価、ASR-WERは音声認識の誤り率(低いほどええ)、UTMOSは音声の自然さスコア(高いほどええ)、WPSは1秒あたりの単語数やで。

見てみると面白いんやけど、Ωを小さくしてリアルタイム性を上げると遅延はめっちゃ減るんやけど、音声の質(UTMOS)はちょっと下がる傾向にあるねん。でもChatGPTスコアで見た回答の質はほとんど変わらんっちゅうのがポイントやな。つまりリアルタイムでもちゃんとした回答が出せるっちゅうことやで!

---

## Page 18

[](/attach/ccc1b58448a5adc5077958421399ee990bf9bd34875efdb6e1595a2df103845b_p018.png)

### 和訳

ICLR 2025の学会論文として発表

表5:ストリーミング環境でのSpeechGPTの数値結果やで。

まずΩっていうのは、ざっくり言うたら「どれくらいの単位で区切って処理するか」みたいなパラメータやねん。

Ω=10のとき、LLMの処理に4899.50ミリ秒、音声合成(ボコーダー)に30.15ミリ秒、合計4929.65ミリ秒かかってんねん。ChatGPTスコアは2.16、音声認識の誤り率(ASR-WER)は44.85%、音声の自然さスコア(UTMOS)は2.7099、1秒あたりの単語数(WPS)は1.95や。

Ω=20やと、合計5035.18ミリ秒で、ChatGPTスコア2.22、ASR-WER 42.03%、UTMOS 3.1920、WPS 1.86。Ω=40やと合計5587.94ミリ秒、スコア2.17、WER 43.88%、UTMOS 3.5106、WPS 1.89。Ω=60で合計6050.25ミリ秒、スコア2.16、WER 43.35%、UTMOS 3.6293、WPS 1.84。Ω=80で合計6216.08ミリ秒、スコア2.21、WER 43.98%、UTMOS 3.6970、WPS 1.87。Ω=100で合計8366.83ミリ秒、スコア2.20、WER 43.74%、UTMOS 3.7397、WPS 1.86。

ほんでオフライン(全部まとめて処理するパターン)やと、LLMだけで17919.60ミリ秒、ボコーダー170.85ミリ秒、合計18090.45ミリ秒もかかるねん。スコアは2.19、WER 45.00%、UTMOS 3.8958、WPS 1.85や。

要するにな、Ωを小さくするほどめっちゃ速くなるけど、音声の質(UTMOS)はちょっと落ちるっていうトレードオフがあるわけやな。ChatGPTスコアとWERはあんまり変わらへんのがおもろいとこやで。

---

表6:SALMONN + Orcaのストリーミング環境での数値結果や。

こっちのΘっていうパラメータは、何文ごとに区切って音声にするかっていう設定やねん。

Θ=1(1文ずつ処理)のとき、LLM 212.45ミリ秒、TTS(テキストから音声への変換)19.71ミリ秒、合計232.16ミリ秒。めっちゃ速いやろ?ChatGPTスコアは3.28、WER 6.64%、UTMOS 3.0947、WPS 1.86や。

Θ=3で合計351.67ミリ秒、スコア3.09、WER 8.65%、UTMOS 3.7338、WPS 2.91。Θ=5で合計460.87ミリ秒、スコア3.04、WER 9.23%、UTMOS 3.7750、WPS 3.18。Θ=7で合計582.37ミリ秒、スコア3.06、WER 8.49%、UTMOS 3.7972、WPS 3.20。Θ=9で合計728.95ミリ秒、スコア3.23、WER 7.07%、UTMOS 3.8060、WPS 3.22。

オフラインやと合計5324.07ミリ秒で、スコア3.40、WER 3.78%、UTMOS 3.8286、WPS 3.31。

SpeechGPTと比べたらほんまに桁違いに速いし、音声認識の誤り率もめっちゃ低いやろ?なんでかっていうと、こっちはSALMONNっていう別のモデルとOrcaっていうTTSを組み合わせたパイプライン方式やからやねん。Θを小さくすると速くなるけど、UTMOSがちょっと下がるのは同じ傾向やな。

---

表7:Qwen2-Audio + Orcaのストリーミング環境での数値結果やで。

Θ=1で、LLM 289.46ミリ秒、TTS 19.15ミリ秒、合計308.61ミリ秒。ChatGPTスコア2.79、WER 25.25%、UTMOS 2.8597、WPS 1.90や。

Θ=3で合計419.85ミリ秒、スコア2.95、WER 13.30%、UTMOS 3.5529、WPS 2.91。Θ=5で合計509.19ミリ秒、スコア2.93、WER 13.00%、UTMOS 3.5865、WPS 3.08。Θ=7で合計621.17ミリ秒、スコア3.07、WER 10.59%、UTMOS 3.5739、WPS 3.11。Θ=9で合計756.57ミリ秒、スコア3.14、WER 9.81%、UTMOS 3.6016、WPS 3.13。

オフラインやと合計9424.42ミリ秒、スコア3.38、WER 6.77%、UTMOS 3.6119、WPS 3.30。

こいつはSALMONN + Orcaと比べると、Θ=1のときのWERが25.25%ってめっちゃ高いのが気になるとこやな。つまり1文ずつ区切ると、まだ文脈が足りひんから変な回答になりがちっていうことやねん。Θを増やしていくとWERがぐんぐん下がるから、ある程度まとめて処理した方が品質ええっちゅうことやな。

---

18

---

![]()

1 / 1