<<

2601.21803v1_RAG-E_Quantifying_Retriever-Generator_Alignment_an.pdf

---

## Page 1

[](/attach/b934713d77b3a1a9885d64e3966e41d53906549a91fe342dde6fc09be80c38f9_p001.png)

### 和訳

RAG-E: 検索器と生成器の連携具合と失敗パターンを数値化する話

Korbinian Randl 1 Guido Rocchietti 2 Aron Henriksson 1 Ziawasch Abedjan 2 Tony Lindgren 1

John Pavlopoulos 3 4 1

6

2

0

2

n

a

J

9

2

]

L

C

.

s

c

[

1

v

3

0

8

1

2

.

1

0

6

2

:

v

i

X

r

a

要約

検索拡張生成(RAG)システムっていうんは、密なベクトル検索器と言語モデルを組み合わせて、LLMの出力を検索してきた文書に基づかせる仕組みやねん。せやけど、この2つの部品がどないに連携してるんかがブラックボックスやから、医療とか法律みたいな重要な分野で使うときに困るわけや。ほんで俺らが提案するんがRAG-Eっていう、端から端まで説明できるフレームワークやねん。数学的にちゃんと根拠のある帰属手法を使って、検索器と生成器がどれくらいうまく連携してるかを数値化するんや。俺らのアプローチでは、検索器の分析用にIntegrated Gradientsっていう手法を適応させて、生成器の帰属分析にはPMCSHAPっていうモンテカルロ法で安定化させたシャプレイ値の近似手法を新しく導入してるねん。ほんで、Weighted Attribution-Relevance Gap(WARG)っていう指標も新たに提案して、生成器の文書の使い方が検索器のランキングとどれくらい一致してるかを測れるようにしたんや。TREC CAsTとFoodSafeSumっていうデータセットで実験したら、えらいこっちゃな結果が出てきてん。クエリの47.4%から66.7%で、生成器が検索器のトップランクの文書をガン無視してることがわかったんや。さらに48.1%から65.9%では、関連性が低いってランク付けされた文書に頼ってしもてるねん。こういう失敗パターンを見ると、RAGの出力品質っていうんは個々の部品の性能だけやなくて、その連携具合にかかってるっていうことがわかるわけや。ほんでその連携具合をRAG-Eで監査できるっちゅうわけやねん。

1. はじめに

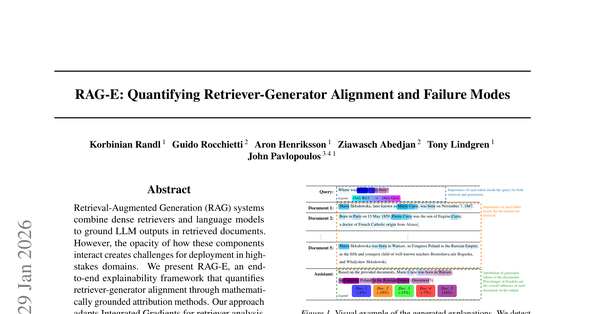

検索拡張生成(Lewis et al., 2020, RAG)っていうんは、今どきの質問応答タスクではスタンダードになってきてるねん。日常的にChatGPT使うところから、医療とか法律みたいな重要な分野での応用まで幅広く使われてるんや(Amugongo et al., 2025; Brown et al., 2025)。標準的なRAGパイプラインは2段階で動くねん。まず検索器(RET)がユーザーのクエリに対して文書を関連度順にランク付けするんや。ほんで生成器(GEN)がトップkの文書に含まれる情報をまとめて、自然言語で回答を生成するっちゅう仕組みやねん。RAGのおかげで大規模言語モデル(LLM)の不透明さは減るんやけど、具体的なソースに基づいて回答できるようになるからな。せやけど内部の推論過程が本質的に透明っちゅうわけやないねん。一方では、検索された文書全部をソースとして考慮すると、どの文書に実際に関連する情報が入ってるんかわからんっていう不確実性が残るわけや。もう一方では、LLMが生成する帰属情報っていうんは統計的な性質のもんやから、必ずしも忠実やないねん(Randl et al., 2025)。この研究では、この不確実性に対処するためにRAG-Eっていう数学的に根拠のあるRAG用の説明可能性フレームワークを紹介するねん。図1に俺らのフレームワークが提供する説明の例を示してるで。そこでは検索器の入力と生成器のクエリ入力に対するトークンの重要度、それから文書への帰属を計算してるんや。RAG-Eを使って、俺らはRAGをもっとよう理解しようとしてるわけや:

RQ1: トランスフォーマーベースの最新の検索器と生成器モデルは何に注目してるんや?

俺らの結果を見ると、ニューラルネットワークベースの検索器モデルでさえ、クエリにも出てくるキーワードがあるかどうかで文書を選んでることがわかるねん。さらに、生成器は統計的にプロンプトの前の方にある文書を後ろの方にある文書より好む傾向があるんや。これはRAGが検索された文書の順序を明示的に活用してるから、ある意味予想通りやねん。とはいえ、プロンプト内の情報の位置が出力に出てくる確率に影響するっていうんは、RAGやないLLMでも知られてる現象やねん(Liu et al., 2024)。これは

---

## Page 2

[](/attach/b934713d77b3a1a9885d64e3966e41d53906549a91fe342dde6fc09be80c38f9_p002.png)

### 和訳

RAG-E: 検索器と生成器のズレを数値化して、どこでコケてるか見つけようって話

これがなんで問題になるかっていうと、生成器(GEN)が大事な情報源をガン無視して、ランキング上位のやつばっかり見てまうことがあるねん。

実際に調べてみたんよ。LLama 3.1 8Bとか Gemma 3 13Bっていうモデルを使って、一般的な質問と専門的な質問の2種類のデータで実験したんやけど、えぐいことがわかったわ。専門的なデータやと、なんと60%のケースで生成器が検索器のトップランクの文書をシカトしてんねん。しかも57%のケースでは、検索器が「これそんな関係ないで」って言うてる文書に頼ってまうんよ。これって2つの失敗パターンがあるってことを示してて、僕らはこれを「せっかく検索したのに無駄になるパターン」と「ノイズに惑わされるパターン」って呼んでんねん。つまりRAGの出力って、各パーツ単体の性能だけやなくて、パーツ同士の連携がめっちゃ大事やってことがわかったんや。

ほんで、このズレを測る指標が今までなかったから、次の研究課題が出てきたわけよ。

研究課題2: 検索器と生成器の一致度をどうやって数値化するん?

RAGシステムが医療とか法律とか、ミスったらヤバい分野でどんどん使われるようになってきてるやん?そうなると検索器と生成器のズレ問題はほんまに重要になってくんねん。例えばや、医療系のRAGが一番ええエビデンスを無視したり、法律系のRAGがどうでもええ判例にフォーカスしたりしたら、まじで実害出るような信頼できん出力になってまうやろ?せやのに、今までの研究って検索器か生成器どっちか片方だけを説明するやつばっかりやったんよ。例えばZhuangらとかFernandoらは検索器の説明を研究して、QiらとかCohen-Wangらは生成器のソース帰属をやってる(詳しくは第6節見てな)。でも両方のパーツを情報がどう流れてるかとか、どこでズレてるかを数値化する方法はなかったんや。これができるようになったら、RAGシステムの透明性が上がるだけやなくて、2つのパーツの連携も良くなるし、もしかしたら計算コストも減らせるかもしれん。例えば「どうせ生成器が使わへんし」って分かってたら、取ってくる文書減らせるやん?このギャップを埋めるために、僕らはエンドツーエンドのRAG監査フレームワークを3つのパーツで提案するで:

RAG向けにカスタマイズした帰属手法:PMCSHAPっていうのを紹介するわ。これはKernelSHAP(Lundbergらが2017年に提案したやつ、KSHAPって略すで)のモンテカルロ安定化バージョンで、自己回帰型の生成器に対してシャプレイ値(1953年にShapleyさんが提案した概念、SVって略す)をめっちゃ正確に、しかも再現可能な形で近似できんねん。これはKSHAPの根本的な弱点を解決してんねん。何かっていうと、文書が重複してて特徴量が依存し合ってる状態で、長さが変わる文章生成に適用すると不安定になるっていう問題や。あとIntegrated Gradients(Sundararajanらが2017年に提案、IGって略す)を密な検索器に使うときのベースライン埋め込みを、ちゃんとした実験分析で確立したで。特殊トークン以外を[unk]埋め込みに置き換えると、他のベースラインよりめっちゃ良くなることがわかったんや。

ズレを診断する指標:WARG(Weighted Attribution-Relevance Gap、重み付き帰属-関連性ギャップ)っていう新しい指標を提案するで。これはRank-Biased Overlap(Webberらが2010年に提案、RBOって略す)をベースにしてて、生成器の文書の使い方が検索器のランキングとどれくらい合ってるかを数値化できんねん。バイアスパラメータpを0から1の間で動かすことで、ズレが上位に集中してるか(初頭効果バイアスのサイン)、ランキング全体に散らばってるかを分析できるんや。

失敗モードの実証的発見:僕らのフレームワークで、構造的なズレが蔓延してて、しかもモデルによって違うことがわかったで。Llama 3.1 8Bは初頭効果バイアスがあって、プロンプトの順番をシャッフルしてもその順番を信じてまうねん。一方Gemma 3 12Bはもっと意味ベースの動きをするんやけど、それでも57%のケースで下位ランクの文書に頼ってまうんよ。僕らはオープンソースのツール(RAG-Eパッケージ)も公開してるから、みんなでRAGの監査と改善ができるようにしてるで。

この論文の残りの構成はこんな感じや。まず重要な背景情報(第2節)と、僕らのフレームワークの技術的な実装の詳細(第3節)を説明するで。ほんで2つの検索モデル、2つの生成モデル、2つのデータセットを使った包括的な実証分析(第4節と第5節)で、失敗モードと洞察を見せるわ。最後に関連研究の紹介と議論(第6節)をして、結論(第7節)で締めくくるで。

2. 背景

Lewisらが2020年にRAGを最初に提案してから、いろんな拡張版が出てきてんねん。例えばSelf-RAG(Asaiらが2024年に提案)は必要に応じて検索するっていう機能を導入してるし、ATLAS(Izacardらが2023年に提案)はRAGを使ってfew-shot学習を改善してんねん。僕らは元祖のフレームワークにフォーカスしてるで。これがほとんどのRAGアプローチの概念的な土台になってるからな。RAGパイプラインの中で検索モデルと生成モデルを情報がどう流れてるか評価するために、顕著性ベースの局所的説明可能性技術を使ってんねん。

定義2.1(顕著性ベースの局所的説明):機械学習モデルf: Rn → Rmがあって、入力ベクトルx = [x1, x2, ..., xn]を出力ベクトルy = [y1, y2, ..., ym]に写像するとするやん。このとき行列B ∈ Rn×mが特定の入出力ペアȳ = f(x̄)の局所的説明になるんは、その要素βi,jが全てのインデックスi ∈ 1, 2, ..., nとj ∈ 1, 2, ..., mに対して、特徴x̄iが出力ȳjに与える影響を記述してる場合やで。

この論文で使う言語モデル(LM)はRとかじゃなくてトークン集合Tから写像したりTに写像したりするから、普通は埋め込み関数Φ: Tn → Rnとかデコーダ関数Ω: Rn → Tnをこれらのステップで使うんや。

一般的に、機械学習モデルを説明する手法は大きく2つに分けられんねん。内在的手法はモデルの内部状態から説明を導くやつで、外在的手法またはモデル非依存手法は、モデルの内部を見んと入出力の関係から統計的に説明を推測するやつや。僕らは内在的手法の方がええと思ってんねん。なんでかっていうと、その出力が説明対象のモデルの関数に直接結びついてるからや。一方、外在的手法は統計的に正しいだけやねん。とはいえ、外在的手法はモデルの設計に依存せんから、より柔軟やけどな。このへんの詳しい背景は付録Aを見てな。

---

## Page 3

[](/attach/b934713d77b3a1a9885d64e3966e41d53906549a91fe342dde6fc09be80c38f9_p003.png)

### 和訳

RAG-E: 検索エンジンと生成AIの連携具合と、どこでコケるかを測る話

手法について言うけど、今回の論文では「足し算できる系」の手法だけに絞ってんねん。

**定義2.2(加法性)**

定義2.1に当てはまる線形の特徴帰属法が「加法的」って言われるのは、こういう時やねん。ベースラインとなる入力 x⁰ = [x⁰₁, x⁰₂, ..., x⁰ₙ] と、それに対応するモデル出力 y⁰ = [y⁰₁, y⁰₂, ..., y⁰ₘ] があったとして、帰属スコア βᵢ,ⱼ を全部足したら、モデルの予測値 ȳⱼ とベースラインの予測値 y⁰ⱼ の差になるっちゅうことやねん:

ȳⱼ − y⁰ⱼ = Σⁿᵢ₌₁ βᵢ,ⱼ (j ∈ {1, 2, ..., m} の全部に対して) (1)

つまり定義2.2に当てはまる手法は、出力の特定の部分を各入力の特徴に直接紐付けられるわけやねん。(x⁰, y⁰)を明示的に指定せなあかん手法もあれば(Sundararajanらの2017年のやつとか、Shrikumarらの2017年のやつとか)、暗黙的に仮定してる手法もあんねん(1953年のShapleyとか、Lundberg & Leeの2017年のやつとか)。

理論上はどんな顕著性マップでも正規化したら加法性の条件満たせるんやけど、使う手法全部に理論的な加法性を求めるのには2つええ理由があんねん:(i) 作られる顕著性マップ全部がスケールも解釈の仕方も比較できるようになる、(ii) Σⁿᵢ₌₁ βᵢ,ⱼ / (ȳⱼ − ȳ⁰ⱼ) っていう誤差の比率が、説明Bの品質指標として使えるねん。

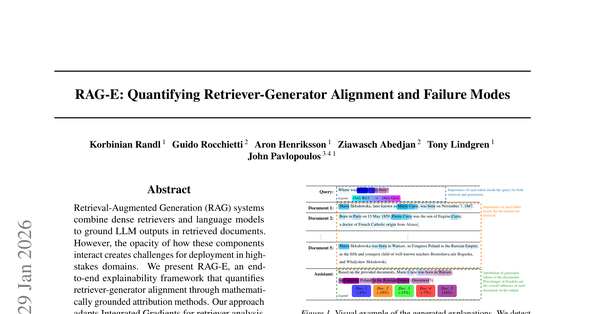

**図2. RAG-Eの概要**

説明は、検索エンジン(RET)には内在的なIG(点線)、生成AI(GEN)には外在的なShapley(点線)を使ってるで。

## 3. 手法

研究の問いに答えるために、RAG用の説明可能性フレームワークを提案すんねん。¹ 図2見てもらったらわかるけど、このフレームワークはRETとGENそれぞれで顕著性を追跡する別々の手法に頼ってんねん。具体的には、RETにはIG(Integrated Gradients、Sundararajanら2017年)の帰属を計算して、GENの出力にはSV(Shapleyの1953年のやつ)ベースの帰属を計算してんねん。

なんでこの2つを使い分けるかっていうと、説明の信頼性と実行時間のバランスを最適化するためやねん。今回はトランスフォーマーベースのエンコーダーオンリーのRETに焦点当ててて、これらは比較的小さいニューラルネットワークベースの言語モデルやから、内在的な手法が使えんねん。さらに、IGの時間計算量は入力トークンの数に比例して増えへんねん(ドキュメントやと入力トークンめっちゃ多くなりがちやけど)。これが、似たような外在的手法(Shapley 1953年、Lundberg & Lee 2017年、Ribeiroら2016年)と違うとこやねん。最近のLLMはアーキテクチャがめっちゃ多様化してるから、GENには外在的手法を選んだわ。クエリのトークン数とコンテキストドキュメントの数は普通そんな多くないから、さっき言うた時間計算量の問題はそこまで気にならへんねん。

¹ ソースコードはGitHubで公開してるで。k-randl/Interpretable_RAG で見れるわ。

### 3.1. 検索エンジンの説明:Integrated Gradients

RETを説明するために、IGをRAG向けに適応させたんや。RETはクエリqとドキュメントdを、トランスフォーマーベースのエンコーダー eqry(·) と ectx(·) でエンコードして、内積でドキュメントをランキングすんねん:

sret(q, d) = eqry(q) · ectx(d) (2)

ほんで、類似度の合計が最大になるk個のドキュメントを取ってくんねん。両方のエンコーダーは、トークン埋め込み Φqry(·) と Φctx(·) に適用される事前学習済みトランスフォーマー f(·) やねん:

eqry(q) = f^qry(Φqry(q)), ectx(d) = f^ctx(Φctx(d)) (3)

IGの計算はクエリとコンテキストで似てるから、以下では「qry」と「ctx」の区別は省略して、qもdも両方xって呼ぶことにするわ。IGはモデル y = f(x) を、選んだベースライン x⁰ᵢ から始めて、各入力特徴 xᵢ に対する勾配を xᵢ に沿って積分することで近似すんねん。IGに従って、埋め込みに基づく帰属 βret,x を、Lステップのリーマン積分で計算すんねん。

検索パイプラインは複数の入力を受け取るから、クロス効果を避けるために他の入力は全部固定したまま、クエリと取得した各ドキュメントの顕著性を別々に計算すんねん。[ϕ₁, ..., ϕₙ] = Φ(x) として、ベースライン埋め込み [ϕ⁰₁, ..., ϕ⁰ₙ] = Φ⁰(x) があったとき、顕著性はこう計算すんねん:

βret,x_i = (ϕᵢ − ϕ⁰ᵢ) · (1/L) Σᴸₗ₌₀ ∂s/∂ϕᵢ (4)

ここで s = sret(δ(q, l), d) はクエリ用で、sret(q, δ(d, l)) は各ドキュメント用やねん。δ(x, l) はこうなってる:

δ(x, l) = f(Φ(x) + (l/L) · (Φ(x) − Φ⁰(x))) (5)

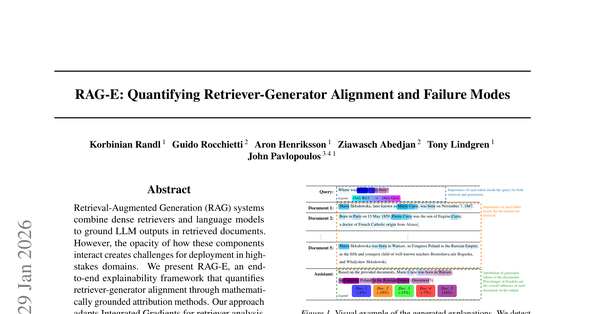

ベースライン埋め込み Φ⁰(x) の選び方は§4.1で比較してて、一番ええやつを使ってんねん:特殊トークン以外をモデルの[unk]トークンに置き換えるやつや。残りの論文でもこれ使ってるで。図3がこのプロセスを図解してるわ。

### 3.2. 生成AIの説明:Shapleyスタイルの帰属

一般的に、GEN y = g(q, D) は2つのパートに分けられんねん:(i) 関数 [t^D₀, t^D₁, ..., t^D_n] = create_prompt(q, D) がクエリqと取得したドキュメントの集合 D =

---

## Page 4

[](/attach/b934713d77b3a1a9885d64e3966e41d53906549a91fe342dde6fc09be80c38f9_p004.png)

### 和訳

RAG-E:リトリーバーとジェネレーターの連携具合と失敗パターンを数値化する話

x [sot]

↓

Φ(x) ϕ[sot]

1

↓

Φ0(x) ϕ[sot]

1

t2

↓

ϕ2

↓

ϕ[unk]

2

t3

↓

ϕ3

↓

ϕ[unk]

3

. . .

. . .

tm′−1

↓

ϕm′−1

↓

. . . ϕ[unk]

m′−1

[eot] [pad] . . . [pad]

↓

ϕ[eot]

m′

↓

ϕ[eot]

m′

↓

ϕ[pad]

m′+1

↓

ϕ[pad]

m′+1

. . .

. . .

↓

ϕ[pad]

m

↓

ϕ[pad]

m

図3. IGのベースライン作成方法やねん。特殊トークン以外のトークンに対応する埋め込みベクトルを、同じ入力位置でモデルの[unk]トークンに対応する埋め込みベクトルに置き換えてるんや。

[XXX]は特殊トークンを表してて、ϕ[XXX]は入力位置iにおけるその特殊トークンの埋め込みベクトルのことやで。

i

{d1, d2, ..., dk}(関連度が高い順に並んでる)を1つのトークン列にまとめるんや。この論文で使ってる関数は付録Bに載せてるで。(ii) 自己回帰型の(大規模)言語モデルがこのプロンプト列を繰り返し補完していくわけや:

具体的に言うと、素のKSHAPと、モンテカルロ方式でKSHAPを繰り返しサンプリングする方法(これをMCSHAPって呼んでる)を比較してるねん。

あと、Covert & Lee(2021)が提案した相補的サンプリング(対になる入力ペア(D′1, D′2)をサンプリングするやつで、D′1 ∩ D′2 = ∅かつD′1 ∪ D′2 = Dになるやつ)もKSHAPで試してみたで。MCSHAPでは、ペア方式(各MCサンプルで相補的な入出力ペアを使う)とランダムなモンテカルロサンプリングの両方を試したんや。ペア方式のやつをPMCSHAPって呼んでる。Algorithm 1に正確な手順を示してるで。LLMの呼び出し回数を固定数Nに制限することで、この手順の実行時間が素のKSHAPと同程度に収まるようにしてるねん。§4.1で示すように、PMCSHAPを使うと、再現性もそこそこ改善しつつ、近似精度がめっちゃ良くなるんや。

tD

i+1 = LLM

0 , tD

[ tD

(cid:124)

1 , . . . , tD

n ,

(cid:123)(cid:122)

(cid:125)

プロンプト x

n+1, . . . , tD

tD

i

(cid:124)

(cid:125)

(cid:123)(cid:122)

前に生成したやつ

]

(6)

この(大規模)言語モデルの出力は、プロンプトを除いた生成トークンの列やねん:y = [tD

n+1, . . . , tD

q、D、そしてGEN関数[tD′

n ] = g(q, D′)(文書のサブセットD′ ⊆ Dに基づいてトークン列を返す関数な)が与えられたとき、入力文書diと出力トークンtD′

jに対するシャープレイ値は、全ての順列にわたる限界貢献度の平均で計算するんや(Shapley, 1953):

m]やで。

0 , . . . , tD′

βgen

i,j =

(cid:88)

D′⊆D\{di}

|D′|!(|D| − |D′| − 1)!

|D|!

(cid:123)(cid:122)

ランダムな順列でD′が

出現する確率

(cid:124)

(cid:125)

(cid:104)

(cid:124)

− tD′

j

j

tD′∪{di}

(cid:123)(cid:122)

限界貢献度

(cid:105)

(cid:125)

(7)

この正確なシャープレイ値を計算するには指数的な時間計算量O(2|D|)がかかるんや。なんでかっていうと、GENモデルg(·)を可能な全てのサブセットD′ ⊆ Dに対して呼び出さなあかんからやねん。せやから、文書数が少ない場合(例えば|D| = 6とか)だけ現実的に計算できるわけや。

|D|がでかい時のシャープレイ値の近似方法として、KSHAPがよく知られてるねん。Lundberg & Lee(2017)が示したんやけど、以下の損失関数を最小化するように学習した線形代理モデルg′(·)は、

(cid:18) |D|

|D′|

(cid:19)−1

·

|D| − 1

|D′| · (|D| − |D′|)

(cid:88)

D′⊆D

·(g(q, D′) − g′(q, D′))2

(8)

シャープレイ値を近似する係数を出してくれて、その数学的性質とも一貫性があるんや。これは時間計算量と忠実度のトレードオフやねん。より少ない数N ≤ 2|D|の学習サンプルD′で済むようになるからな。注意してほしいんやけど、正確なシャープレイ値とは違って、KSHAPは文書が独立やって仮定してるねん。この仮定は現実的やないで。なんでかっていうと、同じ質問に答えるために集められた文書は内容が重複しがちやからや。

KSHAP帰属のモンテカルロ(MC)安定化:

この問題の解決策として、KSHAPに対する摂動入出力ペアの独立サンプリング戦略を提案して評価してるで。

アルゴリズム1 (P)MCSHAP

必要なもの:クエリq

必要なもの:コンテキスト文書の集合D

必要なもの:摂動の数N ≤ 2|D|

必要なもの:MCサンプルの数M

必要なもの:MCサンプルのサイズN ′ < N

P ⇐ {}

while |P| < N do

D′ ⇐ Dからサンプルを取る

x ⇐ プロンプト作成(q, D′)

y ⇐ LLM(x)

P ⇐ {(x, y)} ∪ P

end while

A ⇐ {}

while |A| < M do

{摂動を作成}

{ペア方式(PMCSHAP)か

ランダム(MCSHAP)か}

{帰属をサンプリング}

A ⇐ {カーネルシャープ(P ′ ⊆ P | |P ′| = N ′)} ∪ A

end while

return 1

M

(cid:80) A

{平均帰属を返す}

制約付きトークン生成:シャープレイ値もKSHAPも、もともとは分類タスク用に開発されたもんやねん。分類やと、MLモデルを1回呼び出すと、1つの入力xに対して1つの出力yが出てくる(つまりy = f(x))。でもさっき言うたように、RAGのGENモデルは自己回帰型の(大規模)言語モデルであることが多くて、最初のプロンプトx = [t0, t1, . . . , tn]から始まるトークン列を繰り返し補完していくんや。異なるD′に対してGENの出力を比較可能にするために、まず摂動なしの文書セットDで出力を生成するねん

n+1, . . . , tD

i

1 , . . . , tD

んで、摂動を加えた文書セットD′に対する生成出力は、D′に基づくプロンプトと組み合わせた元の出力で制約をかけるんや:

i+1 = LLM(cid:0) [ tD

tD

n , tD

] (cid:1)

(9)

tD′

i+1 = LLM

(cid:16)

[ tD′

1 , . . . , tD′

n′ , tD

n′+1, . . . , tD

i

(cid:17)

.

]

(10)

この制約付き生成は、文献でも実績のあるアプローチやで(Cohen-Wang et al., 2024; Qi et al., 2024)。

4

---

## Page 5

[](/attach/b934713d77b3a1a9885d64e3966e41d53906549a91fe342dde6fc09be80c38f9_p005.png)

### 和訳

# 3.3. 検索器と生成器の一致度を測る話

RQ2に答えるために、ワイが考えたんが「重み付き帰属-関連性ギャップ(WARG)」っちゅうメトリックやねん。これで検索器(RET)と生成器(GEN)がどんだけ仲良く協力してるかを数値化できるんや。

このメトリック、クエリに対してはトークンレベルで、コンテキスト文書に対しては文書レベルで定義されとるんやで。文書の方で言うと、Dは検索された文書の順序付き集合やな。せやから、検索器にとっての文書の重要度ランキングは単純にRret = Dになるわけや。

一方、生成器にとっての文書の重要度は、全出力トークンの帰属度の平均で決まるねん。ほんで生成器のランキングは、その重要度が高い順にDを並べ替えたもんになる:

Rgen = argsort(式11:全文書iについて、j=1からmまでのβgen_i,jの平均を降順ソート)

このメトリックの土台になっとるんがRBO(Rank-Biased Overlap)っちゅうやつでな、情報検索の世界でめっちゃよう使われとる、上位に重みを置いた類似度の指標なんや。相関係数みたいに「両方のリストに共通してないとアカン」みたいな制約がなくて、「持続性」パラメータpでランキング下位への重み減衰を調整できるんがミソやねん。

**定義3.1(重み付き帰属-関連性ギャップ)**

WARGは、検索器のランキングRretと生成器のランキングRgenのRBOの補数として定義するで:

WARG(p) = 1 − RBO(Rret, Rgen; p)

= 1 − (1-p) × Σ(d=1からk) p^(d-1) × |Rret_1:d ∩ Rgen_1:d| / d (式12)

ここでp∈(0,1)は重みの急峻さをコントロールするパラメータや。

p=0.5にすると、めっちゃ上位重視になるねん。実際、1位だけで全体の重みの約50%を占めるんや。これ、初頭バイアス(最初の方ばっか見ちゃう問題)を検出するんにピッタリでな、最上位でのランク逆転(例えば、生成器が注目した文書が検索器的には3位やったのに1位扱いしとった、みたいな)があると、ごっつい大きなペナルティがかかるんや。

一方、p=0.9やと穏やかな減衰になって、全体的な一致度を見るんに向いとる。pを色々変えてスイープすれば感度分析ができるわけや:もしWARGが低いpで高くて、高いpで低かったら、ズレがリストの最上位に集中しとるっちゅうことや。これ、まさに初頭バイアスの特徴やねん。

---

# 4. 実験のセットアップ

ワイらのフレームワークが色んなRAGアーキテクチャにどう影響するか評価するために、エンコーダーだけの密検索モデル2つと、今の最先端を代表するオープンウェイトの生成モデル2つを使ったで。

検索フェーズでは、DRAGON(BERT-baseベースの双エンコーダーモデル、パラメータ1.1億個)と、Snowflake Arctic Embed 2(多言語XLM-R Largeからファインチューニングした単一エンコーダーモデル、パラメータ5.68億個)を使ったんや。

生成フェーズでは、Llama 3.1 8BとGemma 3 12Bを採用したで。この2つは計算効率と推論の深さのバランスがええねん。リソース節約のために、生成モデルはbfloat16に圧縮しとるで。

## 4.1. 設計選択の分析

ワイらのアプローチが信頼できるか、設計選択が妥当かを検証するために、小規模な実験をいくつかやったんや。MS-Marco v2.1 Q&Aデータセットからランダムに200サンプルを選んで、各クエリに対してランダムな5つのコンテキスト文書を用意したで。実験は24GBメモリのNVIDIA RTX A5500 GPU 8枚で実行したんや。

忠実性の測定には、入力摂動による「摂動曲線の内側面積(AIPC)」を使ったで。クエリのテキストは自然と短いし、トークン1個いじっただけで、そのトークンの判断への影響とは関係なく全体の意味が歪んでまうから、忠実性のテストはコンテキスト文書だけでやったんや。ただ、コンテキストでもクエリでも使う手法は同じやから、結果は転用できると考えとるで。詳細は付録Dを見てな。

## 4.2. 実験

メインの分析は以下の2つのデータセットでやったで:

**TREC CAsT 2019(TC)**:会話型情報検索のベンチマークや(テキスト38,636,520件)。MS-MARCO、TREC CAR、WAPOで構成されとって、評価用トピックと人間による関連性判定がついとるんや。

**FoodSafeSum(FSS)**:食品安全ドメインのデータセットで、文書12.4万件と評価用トピック133件があって、人間が文書の関連性をアノテーションしとる。著作権の関係で公開されとらんから、LLMが未見のデータでどうなるかテストするんにピッタリなんや。このデータセットの一部はBakagianni et al.(2025)が分析しとるで。

各データセットについて、文書埋め込みからフラットFAISSインデックスを構築して、クエリごとにトップ10文書を検索したんや。文書は2つのプロンプト設定で生成器に渡したで:(i)検索ランク順のまま、(ii)文書をランダムにシャッフル。これで文書の順序に対する感度を分析できるわけや。これらの実験はIntel Xeon Platinum 8480CLと、80GBメモリのNVIDIA H100 8枚で実行したで。

---

# 5. 結果

実験結果を以下の3つのセクションで報告するで:§5.1ではRAG-Eフレームワークの設計選択の根拠を示して、§5.2ではRAG-Eを使ったRAG説明の探索的分析(RQ1)を紹介して、§5.3ではWARGメトリックの有用性を実証的に評価(RQ2)するんや。

---

## Page 6

[](/attach/b934713d77b3a1a9885d64e3966e41d53906549a91fe342dde6fc09be80c38f9_p006.png)

### 和訳

RAG-E: レトリーバーとジェネレーターの連携具合と失敗パターンを数値化する話

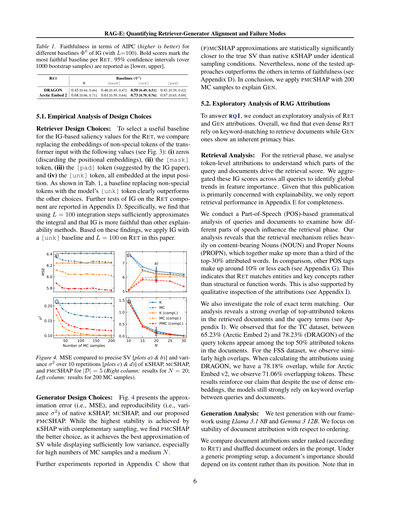

表1. IG(L=100で計算)の色んなベースラインΦ0に対する忠実度をAIPCで見たやつ(高いほどええねん)。太字はそのRETで一番忠実やったベースラインやで。95%信頼区間は1000回ブートストラップサンプリングして[下限, 上限]で書いてるわ。

RET

ベースライン (Φ0)

0

[mask]

[unk]

[pad]

DRAGON

Arctic Embed 2

0.45 [0.44, 0.46]

0.68 [0.66, 0.71]

0.46 [0.45, 0.47]

0.61 [0.59, 0.64]

0.50 [0.49, 0.51]

0.73 [0.70, 0.76]

0.41 [0.39, 0.42]

0.67 [0.65, 0.69]

5.1. 設計の選び方を実験で検証してみた話

レトリーバーの設計選択について:RETのIG(統合勾配法)ベースの重要度を計算するのに使うベースラインを選ぶために、トランスフォーマーの入力で特殊トークン以外の埋め込みを以下の値に置き換えて比較してみたんや(図3見てな):(i) ゼロ(位置埋め込みは捨てる)、(ii) [mask]トークン、(iii) [pad]トークン(元のIG論文で提案されてたやつ)、(iv) [unk]トークン、全部その入力位置に埋め込んでるで。表1見たらわかるけど、特殊トークン以外を[unk]トークンに置き換えるベースラインが他の選択肢をめっちゃ上回ってるねん。RETに対するIGのさらなるテストは付録Dに書いてあるで。具体的に言うと、積分を十分近似するにはL=100の統合ステップで足りることと、IGが他の説明可能性手法より忠実やってことがわかったんや。これらの結果に基づいて、この論文ではRETに対して[unk]ベースラインとL=100でIGを適用してるで。

図4. 正確なシャープレイ値と比較したMSE[プロットa)とb)]と、KSHAP、MCSHAP、PMCSHAPの10回繰り返しでの分散σ²[プロットc)とd)]やで。|D|=5の場合(右列:N=20の結果、左列:200MCサンプルの結果)。

ジェネレーターの設計選択について:図4は、素のKSHAP、MCSHAP、そしてワイらが提案したPMCSHAPの近似誤差(つまりMSE)と再現性(つまり分散σ²)を示してるんや。一番安定してるのは相補サンプリング付きのKSHAPやねんけど、PMCSHAPの方がええ選択やと思うねん。なんでかっていうと、シャープレイ値の近似が一番正確で、しかも分散も十分低いからや。特にMCサンプル数が多くてNが中くらいの時にええ感じやねん。

付録Cで報告してる追加実験では、

6

(P)MCSHAPの近似は、同じサンプリング条件下で素のKSHAPより統計的に有意に真のシャープレイ値に近いことがわかったで。せやけど、忠実度の面ではテストしたどのアプローチも他を上回ってないんや(付録D見てな)。結論として、GENを説明するのに200MCサンプルでPMCSHAPを適用することにしたで。

5.2. RAGの寄与度を探索的に分析してみた話

RQ1に答えるために、RETとGENの寄与度の探索的分析をやってみたんや。全体的に見て、密なRETでもキーワードマッチングに頼って文書を取得してて、GENの方は本質的に最初の方を重視するバイアス(プライマシーバイアス)があることがわかったで。

検索の分析:検索フェーズでは、クエリと文書のどの部分が検索スコアを左右してるんか理解するために、トークンレベルの寄与度を分析したんや。これらのIGスコアを全クエリで集計して、特徴量の重要度のグローバルな傾向を特定したで。この論文は主に説明可能性に焦点当ててるから、検索性能は完全性のために付録Eだけで報告してるわ。

品詞(POS)に基づく文法分析をクエリと文書に対してやって、異なる品詞が検索フェーズにどう影響するか調べたんや。分析の結果、検索メカニズムは内容を表す名詞(NOUN)と固有名詞(PROPN)にめっちゃ依存してることがわかったで。これらを合わせると上位30%の寄与度を持つ単語の3分の1以上を占めてるねん。比較すると、他の品詞タグはそれぞれ約10%以下やで(付録G見てな)。これはRETがエンティティと重要な概念をマッチングしてて、構造的な語や機能語はマッチングしてないってことを示してるんや。これは寄与度の定性的検査でも裏付けられてるで(付録I見てな)。

完全一致の役割も調べてみたんや。分析の結果、取得された文書の上位寄与トークンとクエリ用語の間に強い重複があることがわかったで(付録I見てな)。TCデータセットでは、クエリトークンの65.23%(Arctic Embed 2)から78.23%(DRAGON)が、文書の上位50%寄与トークンの中に現れてたんや。FSSデータセットでも同様に高い重複が観察されたで。DRAGONで寄与度を計算すると78.18%の重複があって、Arctic Embed v2では71.06%の重複トークンが観察されたんや。これらの結果は、密な埋め込みを使ってるにもかかわらず、モデルはまだクエリと文書の間のキーワードの重複にめっちゃ依存してるっていうワイらの主張を裏付けてるで。

生成の分析:ワイらのフレームワークを使ってLlama 3.1 8BとGemma 3 12Bで生成をテストしたんや。順序に対する文書寄与度の安定性に焦点当てたで。

プロンプト内での文書の順序について、ランク付け順(RETによる)とシャッフル順で文書寄与度を比較したんや。一般的なプロンプト設定では、文書の重要度はその位置やなくて内容に依存すべきやねん。注意してほしいのは、

5.86.06.26.4 MSE a)567b)a)50100150200 MCサンプル数 0.100.150.202c)1015202530N0.00.51.01.5d)c)KMCK (相補)MC (相補)PMC (相補)

---

## Page 7

[](/attach/b934713d77b3a1a9885d64e3966e41d53906549a91fe342dde6fc09be80c38f9_p007.png)

### 和訳

# RAG-E: 検索器と生成器のアライメントと失敗モードの定量化

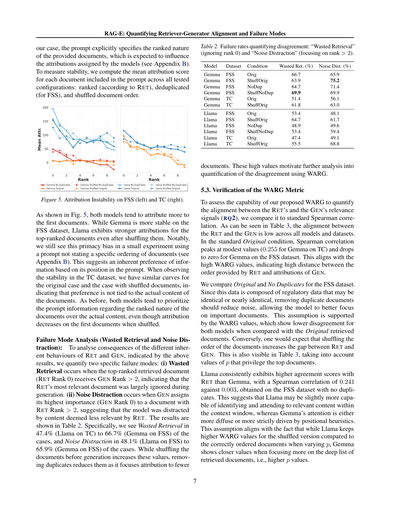

うちらの実験ではな、プロンプトに「ドキュメントは順位付けされてますよ」って明示的に書いてるねん。これがモデルの帰属度(どのドキュメントを重視するか)に影響するって予想してるわけや(詳しくは付録Bを見てな)。

安定性を測るために、プロンプトに含まれる各ドキュメントの平均帰属スコアを計算したんや。テストした条件は、RETによる順位付け版、FSSでの重複削除版、あとドキュメントの順番をシャッフルしたやつやな。

**図5. FSSデータセット(左)とTCデータセット(右)での帰属の不安定性**

図5を見てもらったらわかるんやけど、両方のモデルとも最初の方のドキュメントに高い帰属度を与える傾向があるねん。FSSデータセットではGemmaの方が安定してるんやけど、Llamaはシャッフルした後でも上位ドキュメントにめっちゃ強い帰属度を示すんや。注目すべきはな、ドキュメントの順位について特に言及してないプロンプトを使った小規模実験でも、この「最初のやつを優先する」バイアスが見られるってことやねん(付録B参照)。これはプロンプト内の位置に基づいて情報を優先するっていう、モデルの生まれつきの好みがあるってことを示唆してるわけや。TCデータセットでの安定性を見ると、オリジナル版とシャッフル版で似たような曲線が出てて、この好みはドキュメントの実際の中身とは関係ないってことがわかるねん。前と同様に、両モデルとも「ドキュメントは順位付けされてます」っていうプロンプトの情報を、実際のコンテンツよりも優先する傾向があるんや。ただし、シャッフルすると最初のドキュメントへの帰属度は下がるけどな。

**失敗モード分析(無駄な検索とノイズによる注意散漫):** 上の結果からわかるRETとGENの異なる本質的な振る舞いの影響を分析するために、2つの具体的な失敗モードを定量化したで。(i) **無駄な検索(Wasted Retrieval)** っていうのは、検索で1位になったドキュメント(RET Rank 0)が、生成時にGEN Rank > 2を受けるケースやねん。つまり、検索器が「これが一番関連性高いで!」って言ったドキュメントが、生成時にほぼ無視されてるってことや。(ii) **ノイズによる注意散漫(Noise Distraction)** は、生成器が一番重要(GEN Rank 0)と判断したドキュメントが、RET Rank > 2のやつやった場合やねん。検索器的には「あんまり関連ないで」って思ってた内容に、モデルが気を取られてるってことや。

結果は表2に示してるで。具体的には、無駄な検索は47.4%(LlamaのTC)から66.7%(GemmaのFSS)のケースで発生してて、ノイズによる注意散漫は48.1%(LlamaのFSS)から65.9%(GemmaのFSS)のケースで起きてるねん。生成前にドキュメントをシャッフルするとこれらの値は上がるんやけど、重複を削除すると下がるんや。なんでかっていうと、帰属度がより少ないドキュメントに集中するからやねん。これらの高い数値が、WARGを使った不一致のさらなる分析の動機付けになってるわけや。

**表2. 不一致を定量化する失敗率:「無駄な検索」(ランク0を無視)と「ノイズによる注意散漫」(ランク2より下に注目)**

| モデル | データセット | 条件 | 無駄な検索 (%) | ノイズ注意散漫 (%) |

|--------|-------------|------|---------------|-------------------|

| Gemma | FSS | Orig | 66.7 | 65.9 |

| Gemma | FSS | ShuffOrig | 63.9 | 75.2 |

| Gemma | FSS | NoDup | 64.7 | 71.4 |

| Gemma | FSS | ShuffNoDup | 69.9 | 69.9 |

| Gemma | TC | Orig | 51.4 | 56.1 |

| Gemma | TC | ShuffOrig | 61.8 | 63.0 |

| Llama | FSS | Orig | 53.4 | 48.1 |

| Llama | FSS | ShuffOrig | 64.7 | 61.7 |

| Llama | FSS | NoDup | 48.9 | 49.6 |

| Llama | FSS | ShuffNoDup | 53.4 | 59.4 |

| Llama | TC | Orig | 47.4 | 49.1 |

| Llama | TC | ShuffOrig | 55.5 | 68.8 |

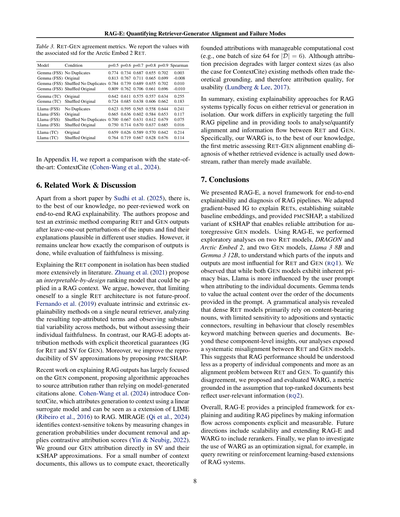

## 5.3. WARG指標の検証

提案するWARGがRETとGENの関連性シグナル間のアライメントを定量化できるか評価するために(RQ2)、標準的なスピアマン相関と比較したで。表3を見てもらったらわかるように、RETとGENの間のアライメントは全モデル・全データセットで低いねん。標準的なOriginal条件では、スピアマン相関は最大でも控えめな値(GemmaのTCで0.255)で、GemmaのFSSデータセットではゼロまで落ちるんや。これは高いWARG値と一致してて、RETが提供する順序とGENの帰属度の間に大きな距離があることを示してるわけやな。

FSSデータセットでOriginalとNo Duplicates(重複なし)を比較してみたで。このデータは規制関連のデータで、同一または非常に似たドキュメントが含まれてることがあるから、重複ドキュメントを削除したらノイズが減って、モデルが重要なドキュメントにより集中できるはずやねん。この仮定はWARG値によって裏付けられてて、両モデルともOriginalの検索ドキュメントと比較して低い不一致を示してるんや。逆に、ドキュメントの順序をシャッフルするとRETとGENのギャップが広がると予想されるやろ?これも表3で見られるで、上位ドキュメントを優先するpの値を考慮するとな。

LlamaはGemmaよりも一貫してRETとの一致度が高いねん。重複なしのFSSデータセットでスピアマン相関は、Llamaが0.241に対してGemmaは0.003やったんや。これはLlamaの方が、コンテキストウィンドウ内の関連コンテンツを識別して注目する能力がちょっと高いかもしれんってことを示唆してるねん。一方Gemmaの注意は、より分散してるか、位置ベースのヒューリスティクス(経験則)によってより厳密に駆動されてるかのどっちかやな。この仮定は以下の事実とも一致するで:pを変化させたとき、Llamaは正しく順序付けられたドキュメントと比べてシャッフル版で高いWARG値を維持するんやけど、Gemmaは検索ドキュメントの深いリスト(つまりより高いp値)に焦点を当てると、より近い値を示すんや。

---

## Page 8

[](/attach/b934713d77b3a1a9885d64e3966e41d53906549a91fe342dde6fc09be80c38f9_p008.png)

### 和訳

# RAG-E: リトリーバーとジェネレーターの相性と失敗パターンを数値化する話

## 表3. RETとGENの一致度を測る指標やで

Arctic Embed 2のRETを使った時の値と標準偏差を載せてんねん。

| モデル | 条件 | p=0.5 | p=0.6 | p=0.7 | p=0.8 | p=0.9 | スピアマン相関 |

|--------|------|-------|-------|-------|-------|-------|----------------|

| Gemma (FSS) | 重複なし | 0.774 | 0.734 | 0.687 | 0.655 | 0.702 | 0.003 |

| Gemma (FSS) | オリジナル | 0.813 | 0.767 | 0.711 | 0.665 | 0.699 | -0.008 |

| Gemma (FSS) | シャッフル重複なし | 0.784 | 0.739 | 0.689 | 0.655 | 0.702 | 0.010 |

| Gemma (FSS) | シャッフルオリジナル | 0.809 | 0.762 | 0.706 | 0.661 | 0.696 | -0.010 |

| Gemma (TC) | オリジナル | 0.642 | 0.611 | 0.575 | 0.557 | 0.634 | 0.255 |

| Gemma (TC) | シャッフルオリジナル | 0.724 | 0.685 | 0.638 | 0.606 | 0.662 | 0.183 |

| Llama (FSS) | 重複なし | 0.623 | 0.595 | 0.565 | 0.558 | 0.644 | 0.241 |

| Llama (FSS) | オリジナル | 0.665 | 0.636 | 0.602 | 0.584 | 0.653 | 0.117 |

| Llama (FSS) | シャッフル重複なし | 0.700 | 0.667 | 0.631 | 0.612 | 0.679 | 0.075 |

| Llama (FSS) | シャッフルオリジナル | 0.750 | 0.714 | 0.670 | 0.637 | 0.685 | 0.016 |

| Llama (TC) | オリジナル | 0.659 | 0.626 | 0.589 | 0.570 | 0.642 | 0.214 |

| Llama (TC) | シャッフルオリジナル | 0.764 | 0.719 | 0.667 | 0.628 | 0.676 | 0.114 |

付録Hでは、最先端手法のContextCite(Cohen-Wangら、2024年)との比較も載せてるで。

## 6. 関連研究と議論

Sudhiら(2025年)の短い論文以外、査読付きでRAGの端から端までの説明可能性を扱った研究って、正直ウチらが知る限りあらへんねん。この人らは、入力を一個ずつ抜いて変化を見るっていう外部的な手法を提案して、RET(検索)とGEN(生成)の出力を比べてテストしてん。ユーザー調査ではまあまあ納得できる説明やったらしいけど、出力の比較を具体的にどうやってるんかはっきりせえへんし、「その説明がほんまに正しいんか」っていう忠実性の評価もないねん。

RET(検索の部分)だけを説明しようっていう研究は、もうちょっと色々あんねん。Zhuangら(2021年)は、RAGにも使えそうな「設計段階から解釈しやすいランキングモデル」を提案してんねん。せやけど、一つのRET構造だけに縛られるのは将来性ないやろって思うわ。Fernandoら(2019年)は、一つのニューラル検索モデルで内部的・外部的な説明手法を評価して、重要とされた単語を分析してんねん。手法によってめっちゃバラつきあるって発見したんやけど、それぞれの忠実性はチェックしてへんねん。それに対してウチらのRAG-Eは、ちゃんと理論的な保証がある帰属手法を採用してん(RETにはIG、GENにはSVっていう手法やな)。しかも、SV(シャプレイ値)の近似計算を再現しやすくするために、PMCSHAPっていう新しい方法も提案してんねん。

最近のRAG出力の説明研究は、ほとんどGEN(生成の部分)に集中してて、モデルが勝手につける引用に頼らんと、アルゴリズムで情報源を特定しようっていうアプローチが多いねん。Cohen-Wangら(2024年)が提案したContextCiteは、線形の代理モデルを使って生成結果をコンテキストに帰属させる方法で、LIME(Ribeiroら、2016年)をRAG向けに拡張したみたいなもんやな。MIRAGE(Qiら、2024年)は、文書を抜いた時に生成確率がどう変わるか測って、文脈に敏感なトークンを特定してんねん。対照的な帰属スコア(YinとNeubig、2022年)も使ってるで。ウチらはGENの帰属を直接SV(シャプレイ値)とそのKSHAP近似に基づかせてんねん。コンテキスト文書が少なければ、計算コストもそこそこで正確な、理論的に裏付けのある帰属が計算できんねん(例えば文書6個やったらバッチサイズ64で一発やで)。コンテキストが大きくなると帰属の精度が落ちるのはContextCiteも同じやけど、既存の手法は使いやすさのために理論的な裏付け、つまり帰属の質を犠牲にしてることが多いねん(LundbergとLee、2017年)。

まとめるとな、既存のRAG説明手法って、だいたい検索か生成のどっちか片方だけに注目してんねん。ウチらの研究は、RAGパイプライン全体を明確にターゲットにして、RETとGENの間の相性や情報の流れを分析・数値化するツールを提供してるとこが違うねん。特にウチらのWARGは、知る限り初めて「RETとGENの相性」を評価する指標やねん。これで、取ってきた証拠が実際に下流で使われてるんか、ただ「用意しただけ」なんかを診断できるようになるわけや。

## 7. 結論

ウチらはRAG-Eっていう、RAGパイプラインを端から端まで説明・診断できる新しいフレームワークを発表したで。勾配ベースのIG(積分勾配法)をRET(検索)の説明に適用して、ちゃんとしたベースライン埋め込みも設定したし、自己回帰型GEN(生成)モデルで信頼できる帰属ができるように安定化させたKSHAPの変種、PMCSHAPも提供したで。RAG-Eを使って、2つのRETモデル(DRAGONとArctic Embed 2)と2つのGENモデル(Llama 3 8BとGemma 3 12B)で探索的な分析をやって、入力と出力のどの部分がRETとGENに一番影響してるんか調べてん(研究課題1)。

わかったことやけどな、両方のGENモデルとも生まれつき「最初に来たもん優先」のバイアスがあるねん。せやけどLlamaは個々の文書に帰属する時、ユーザーのプロンプトにより影響されやすいねん。一方Gemmaは、文書の順番より実際の中身を重視する傾向があんねん。文法的な分析をしたら、密なRETモデルは主に内容を持った名詞に頼ってて、前置詞とか文をつなぐ言葉にはあんまり敏感やないってわかってん。結果的に、クエリと文書の間でキーワードマッチングしてるのとほぼ変わらん動きしてんねん。

こういう部品レベルの知見に加えて、ウチらの分析でRETモデルとGENモデルの間に「システム的なズレ」があることがバレてん。これが示唆してるのは、RAGの性能って個々の部品の問題やなくて、RETとGENの「相性問題」として理解すべきやってことやな。このズレを数値化するために、WARGっていう指標を提案して評価したで。これは「上位にランクされた文書がユーザーにとって一番関連性高い情報を反映してる」っていう仮定に基づいてんねん(研究課題2)。

全体的に見て、RAG-Eは部品間の情報の流れを明示的に測れるようにして、RAGパイプラインを説明・監査するための原理的なフレームワークを提供してるで。今後の方向性としては、スケーラビリティの向上と、RAG-EとWARGをリランカーにも対応させることやな。最後に、WARGを最適化のシグナルとして使うことも調べる予定やで。例えばクエリの書き換えとか、強化学習ベースのRAGシステム拡張とかに使えるんちゃうかなって思ってんねん。

---

## Page 9

[](/attach/b934713d77b3a1a9885d64e3966e41d53906549a91fe342dde6fc09be80c38f9_p009.png)

### 和訳

RAG-E: レトリーバーと生成器の相性を数値化して、どこでコケるかを解明するで

謝辞

この研究な、一部は「ギリシャ2.0国家復興・強靭化計画」のMIS 5154714プロジェクトから支援もろてんねん。これはEUのNextGenerationEUプログラムからの資金やで。あと、EUのホライズン・ヨーロッパっていう研究・イノベーションプログラムのEFRA(助成金番号101093026)からも研究資金出してもろてるわ。ただな、ここで書いてる意見とか見解は著者らのもんであって、EUとか欧州委員会の公式見解とは限らんで。EUも助成機関も、この内容に責任は持てへんからな。

⋆⋆⋆

⋆ ⋆ ⋆

⋆

⋆

⋆

⋆

⋆

⋆

社会への影響について

RAGシステムってな、最近めっちゃいろんなとこで使われるようになってきてんねん。特に医療とか法律とか、ミスったらあかん分野での意思決定をサポートするアプリケーションでな(Amugongoら、2025年;PipitoneとAlami、2024年)。この研究はな、RAGパイプラインを監査したり説明したりするためのツールを提供してんねん。検索と生成がどう絡み合ってるかを、はっきり見えるようにして測定できるようにしたわけや。レトリーバー(検索するやつ)と生成器がどれだけズレてるかを数値化して、システマチックにどこでコケるかを特定することで、ワイらのフレームワークは、より信頼できるシステム設計とか、後から振り返る分析とか、人間がちゃんと監視するのを助けられるんやで。

せやけどな、正直に言うとこの論文で提案してる方法は、ある程度の技術的な知識がないと解釈するの難しいねん。素人さんが結果を誤解するかもしれへんし、例えばWARGっていう指標が低いのを「事実として正しい」とか「真実や」って直接示してると勘違いするかもしれん。こういう指標を間違って使うと、「相性ええけど実は間違ってるシステム」を過信しちゃう危険があるんや。それにな、帰属ベースの説明(どの情報源から来たか示すやつ)を、専門家やない人が「完全な因果関係」やと誤解するかもしれへん。やから、慎重に解釈することと、他の評価方法と組み合わせて使うことがほんまに大事やねん。

全体的に見てな、ワイらはこの研究がRAGシステムをより透明で説明責任のある形で使えるようにするもんやと思ってるわ。ただし、説明可能性のツールは慎重に使わなあかんし、その分野の専門知識とか外部からの検証と一緒に使う必要があるってことも認識してるで。

参考文献

Abnar, S. and Zuidema, W. Transformerにおけるアテンションの流れを定量化する研究。ACL論文集、pp. 4190–4197。ACL、2020年。

Amugongo, L. M., Mascheroni, P., Brooks, S., Doering, S., and Seidel, J. 医療分野における大規模言語モデルのための検索拡張生成:システマティックレビュー。PLOS Digital Health、4(6):1–33、2025年6月。

Angiulli, F., De Luca, F., Fassetti, F., and Nisticò, S. LLiMe:

9

大規模言語モデルでテキスト分類器の説明を強化する研究。Machine Learning、114(12):271、2025年。

Asai, A., Wu, Z., Wang, Y., et al. Self-RAG:自己振り返りを通じて検索・生成・批評を学習する手法。ICLR論文集、2024年。

Bakagianni, J., Randl, K., Rocchietti, G., et al. FoodSafeSum:食品安全文書の要約と分析のための自然言語処理アプリケーションを実現する研究。EMNLP Findings、pp. 16786–16804。ACL、2025年。

Brown, A., Roman, M., and Devereux, B. 検索拡張生成のシステマティック文献レビュー:技術、評価指標、課題。Big Data and Cognitive Computing、9(12)、2025年。ISSN 2504-2289。

Cohen-Wang, B., Shah, H., Georgiev, K., and Madry, A. ContextCite:モデル生成をコンテキストに帰属させる手法。NeurIPS Advances。Curran Associates Inc.、2024年。

Covert, I. and Lee, S.-I. KernelSHAPの改善:線形回帰を用いた実用的なShapley値推定。Machine Learning Research論文集、第130巻、pp. 3457–3465。PMLR、2021年。

Dietz, L., Verma, M., Radlinski, F., and Craswell, N. TREC複雑回答検索の概要。TREC論文集、pp. 13、2017年。

Douze, M., Guzhva, A., Deng, C., et al. FAISSライブラリ、2024年。プレプリント:https://arxiv.org/abs/2401.08281

Edin, J., Motzfeldt, A. G., Christensen, C. L., et al. 正規化AOPC:特徴帰属の説明可能性における誤解を招く忠実度指標の修正。ACL論文集、pp. 1715–1730。ACL、2025年。

Fernando, Z. T., Singh, J., and Anand, A. DeepSHAPを用いたニューラル検索モデルの解釈可能性に関する研究。SIGIR論文集、pp. 1005–1008。ACM、2019年。

Grattafiori, A., Dubey, A., Jauhri, A., et al. Llama 3モデル群、2024年。プレプリント:https://arxiv.org/abs/2407.21783 Huggingfaceモデル:meta-llama/Llama-3.1-8B。

Izacard, G., Lewis, P. S. H., Lomeli, M., Hosseini, L., Petroni, F., Schick, T., Dwivedi-Yu, J., Joulin, A., Riedel, S., and Grave, E. Atlas:検索拡張言語モデルによる少数ショット学習。Journal of Machine Learning Research、24:251:1–251:43、2023年。

Jain, S. and Wallace, B. C. アテンションは説明ちゃうで。NACL論文集、pp. 3543–3556。ACL、2019年。

---

## Page 10

[](/attach/b934713d77b3a1a9885d64e3966e41d53906549a91fe342dde6fc09be80c38f9_p010.png)

### 和訳

RAG-E: リトリーバーとジェネレーターのアライメントと失敗モードの定量化

大規模言語モデルにおける研究やな。Machine Learning, 114(10): 220, 2025.

Ribeiro, M. T.らの研究「なんでこれ信用せなあかんの?」:任意の分類器の予測を説明するっちゅう話や。KDDの論文集、pp. 1135-1144, 2016.

Shapley, L. S.の「n人ゲームの価値」。これはめっちゃ有名な理論でな、複数人が協力したときの貢献度をどう分けるかっちゅう話や。Kuhn, H. W.とTucker, A. W.編のゲーム理論への貢献第2巻、pp. 307-318。プリンストン大学出版、1953年。

Shrikumar, A.らの「活性化の差分を伝播させて重要な特徴を学習する」。ICMLの論文集、第70巻、pp. 3145-3153, 2017.

Sudhi, V.らの「RAGシステムのためのエンドツーエンドでモデル非依存な説明に向けて」、2025年。プレプリントはhttps://arxiv.org/abs/2509.07620にあるで。

Sundararajan, M.らの「ディープネットワークのための公理的帰属」。ICMLの論文集、第70巻、pp. 3319-3328, 2017.

Tan, Z.らの「GLIME:汎用的で安定したローカルなLIME説明」。NeurIPSの論文集、第36巻、pp. 36250-36277。Curran Associates, Inc., 2023.

Webber, W.らの「不定ランキングのための類似度指標」。ACM Trans. Inf. Syst., 28(4), 2010.

Yin, K.とNeubig, G.の「対照的説明による言語モデルの解釈」。EMNLPの論文集、pp. 184-198。ACL、2022年。

Yu, P.らの「Arctic-Embed 2.0:妥協なしの多言語検索」。COLMの論文集、2025年10月。HuggingfaceモデルはSnowflake/snowflake-arctic-embed-l-v2.0やで。

Zhuang, H.らの「一般化加法モデルによる解釈可能なランキング」。WSDMの論文集、2021年。

Kamath, A.らの「Gemma 3技術レポート」、2025年。プレプリントはhttps://arxiv.org/abs/2503.19786にあるで。Huggingfaceモデルはgoogle/gemma-3-12b-itや。

Kuratomi, A.らの「ORANGE:異種空間における接線説明のための逆ラベルソーティング」。DSAAの論文集、pp. 1-10。IEEE、2023年。なんでかっていうと、異なる種類のデータ空間で説明を生成する新しい方法を提案してるねん。

Lewis, P.らの「知識集約型NLPタスクのための検索拡張生成」。これがめっちゃ有名なRAGの元論文やねん。NeurIPSの論文集、第33巻、pp. 9459-9474。Curran Associates Inc., 2020.

Lin, S.-C.らの「DRAGONの訓練方法:汎化可能な密検索に向けた多様な拡張」、2023年。プレプリントはhttps://arxiv.org/abs/2302.07452にあるで。Huggingfaceモデルはfacebook/dragon-plus-[context|query]-encoderや。

Liu, N. F.らの「真ん中で迷子:言語モデルが長いコンテキストをどう使うか」。TACL、12:157-173, 2024. ほんまにおもろい研究でな、長い文書の真ん中の情報が無視されがちやっていう問題を指摘してんねん。

Liu, S.らの「テキスト分類におけるTransformerモデルのアテンションベース説明の探求について」。Big Dataの論文集、pp. 1193-1203, 2021.

Lundberg, S. M.とLee, S.-I.の「モデル予測を解釈するための統一的アプローチ」。NeurIPSの論文集、第30巻、pp. 4765-4774。Curran Associates, Inc., 2017. これがSHAPの元論文やで。

Mitchell, R.らの「GPUTreeShap:ツリーアンサンブルのSHAPスコアの大規模並列厳密計算」。PeerJ Computer Science、8:e880、2022年。doi: 10.7717/peerj-cs.880.

Nguyen, T.らの「MS MARCO:人間が生成した機械読解データセット」。CEUR Workshop Proceedings、第1773巻。CEUR-WS.org、2016年。これめっちゃ有名なベンチマークやねん。

Pipitone, N.とAlami, G. H.の「LegalBench-RAG:法律ドメインにおける検索拡張生成のベンチマーク」、2024年。プレプリントはhttps://arxiv.org/abs/2408.10343にあるで。

Qi, J.らの「信頼できる検索拡張生成のためのモデル内部ベースの回答帰属」。EMNLPの論文集、pp. 6037-6053。ACL、2024年。

Randl, K.らの「ギャップに注意:もっともらしい自己説明から妥当な自己説明へ」

10

---

## Page 11

[](/attach/b934713d77b3a1a9885d64e3966e41d53906549a91fe342dde6fc09be80c38f9_p011.png)

### 和訳

RAG-E:取得装置と生成装置の連携具合と失敗パターンを数値化する話

A. 背景の詳しい説明

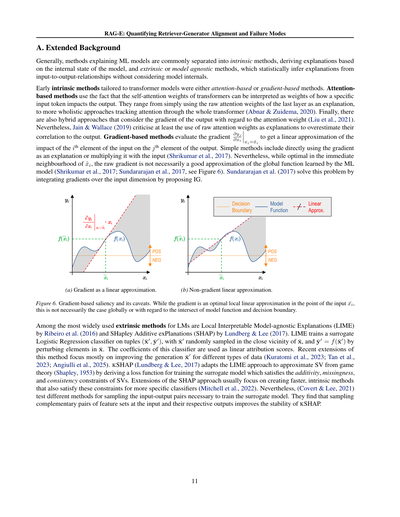

まずな、機械学習モデルを説明する方法って大きく2つに分かれるねん。1つ目は「内在的手法」っていうて、モデルの内部状態から説明を導き出すやつ。2つ目は「外在的手法」とか「モデル不可知手法」って呼ばれるやつで、これはモデルの中身は見んと、入力と出力の関係から統計的に説明を推測するやり方やねん。

トランスフォーマーモデル向けの初期の内在的手法は、アテンションベースか勾配ベースのどっちかやったんよ。アテンションベースの手法ってのは、トランスフォーマーの自己アテンション重みを「特定の入力トークンが出力にどれくらい影響してるか」の重みとして解釈できるって事実を利用してんねん。一番シンプルなんは最後の層の生のアテンション重みをそのまま説明に使うやつで、もうちょい本格的なんはトランスフォーマー全体を通してアテンションを追跡するアプローチもあるで(Abnar & Zuidema, 2020)。ほんで、出力のアテンション重みに対する勾配も考慮するハイブリッドなアプローチもあんねん(Liu et al., 2021)。せやけどな、Jain & Wallace(2019)は、少なくとも生のアテンション重みを説明に使うんは、出力との相関を過大評価しすぎやって批判してるわ。

勾配ベースの手法は、∂yj/∂xi っていう勾配を評価して、i番目の入力要素がj番目の出力要素にどう影響するかの線形近似を得るんやな。シンプルな方法としては、勾配をそのまま説明に使うか、入力と掛け算するやつがあるねん(Shrikumar et al., 2017)。せやけどな、生の勾配はx̄iのすぐ近くでは最適やけど、機械学習モデルが学習したグローバルな関数の良い近似とは限らんのよ(Shrikumar et al., 2017; Sundararajan et al., 2017、図6見てな)。Sundararajan et al.(2017)はこの問題を、入力次元にわたって勾配を積分するIG(Integrated Gradients)を提案することで解決したんや。

(a) 線形近似としての勾配

(b) 勾配を使わへん線形近似

図6. 勾配ベースの顕著性とその落とし穴。勾配は入力点x̄iでは最適な局所線形近似やねんけど、グローバルに見たらそうとは限らんし、モデル関数と決定境界の交点に関してもそうやないことがあるんよ。

言語モデルでめっちゃよく使われる外在的手法の中には、Ribeiro et al.(2016)のLIME(Local Interpretable Model-agnostic Explanations)と、Lundberg & Lee(2017)のSHAP(SHapley Additive exPlanations)があるんや。LIMEは(x̄′, ȳ′)っていうタプルで代理のロジスティック回帰分類器を学習すんねん。ここでx̄′はx̄のすぐ近くからランダムにサンプリングされて、ȳ′はx̄の要素を摂動させてf(x̄′)で計算するんよ。この分類器の係数が線形寄与スコアとして使われんねん。最近のこの手法の拡張は、主に異なるタイプのデータに対してx̄′の生成を改善することに焦点当ててるわ(Kuratomi et al., 2023; Tan et al., 2023; Angiulli et al., 2025)。

KSHAP(Lundberg & Lee, 2017)はLIMEのアプローチを応用して、ゲーム理論のシャープレイ値(Shapley, 1953)を近似すんねん。加法性、欠損性、一貫性っていうシャープレイ値の制約を満たす損失関数を代理モデルの学習用に導出してるんや。SHAPアプローチの拡張は、普通はもっと特定の分類器に対してこれらの制約を満たす、より速い内在的手法を作ることに焦点当ててるで(Mitchell et al., 2022)。せやけどな、Covert & Lee(2021)は代理モデル学習に必要な入出力ペアをサンプリングする異なる方法をテストしてんねん。ほんで彼らが見つけたんは、入力で特徴セットの相補的なペアとそれぞれの出力をサンプリングすると、KSHAPの安定性が向上するってことやったわ。

---

## Page 12

[](/attach/b934713d77b3a1a9885d64e3966e41d53906549a91fe342dde6fc09be80c38f9_p012.png)

### 和訳

RAG-E: レトリーバーとジェネレーターの相性と失敗パターンを数値化するで

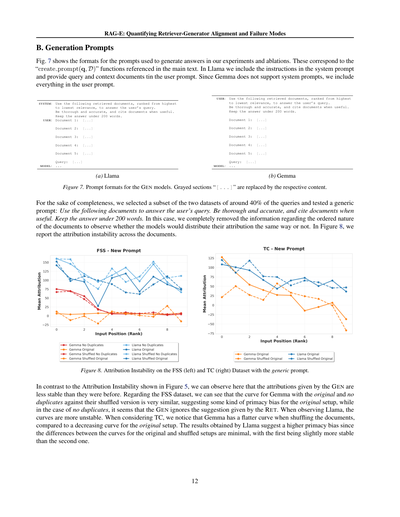

B. 生成プロンプトについて

図7は、俺らの実験とか追加検証で回答生成するときに使ったプロンプトのフォーマットを見せとるねん。これは本文で出てきた「create prompt(q, D)」っていう関数に対応しとるやつやで。Llamaの場合は、指示の部分をシステムプロンプトに入れて、質問と参照ドキュメントはユーザープロンプトに入れとるねん。一方Gemmaはシステムプロンプトに対応してへんから、全部ユーザープロンプトにまとめて入れとるで。

SYSTEM: 以下の取得したドキュメントを使ってユーザーの質問に答えてな。

関連度が高い順に並んどるで。

正確で詳しく答えて、役立つときはドキュメントを引用してな。

回答は200語以内でよろしく。

USER: ドキュメント1: [...]

ドキュメント2: [...]

ドキュメント3: [...]

ドキュメント4: [...]

ドキュメント5: [...]

質問:

[...]

MODEL: ...

USER: 以下の取得したドキュメントを使ってユーザーの質問に答えてな。

関連度が高い順に並んどるで。

正確で詳しく答えて、役立つときはドキュメントを引用してな。

回答は200語以内でよろしく。

ドキュメント1: [...]

ドキュメント2: [...]

ドキュメント3: [...]

ドキュメント4: [...]

ドキュメント5: [...]

質問: [...]

MODEL: ...

(a) Llama

(b) Gemma

図7. GENモデル用のプロンプトフォーマットやで。グレーの部分「[...]」はそれぞれの内容に置き換えるんやで。

ちゃんと比較するために、2つのデータセットから約40%の質問を抜き出して、汎用的なプロンプトでもテストしたんよ:「以下のドキュメントを使ってユーザーの質問に答えてな。正確で詳しく答えて、役立つときはドキュメントを引用してな。回答は200語以内でよろしく。」って感じや。このとき、ドキュメントが順番に並んどるっていう情報を完全に消して、モデルが同じように引用を配分するかどうか見てみたねん。図8では、ドキュメント間での引用の不安定さを報告しとるで。

図8. 汎用プロンプトを使ったときのFSSデータセット(左)とTCデータセット(右)での引用不安定性。

図5で見せた引用不安定性と比べると、ここではGENの引用がさっきより不安定になっとるのがわかるやろ。FSSデータセットについて言うと、オリジナルと重複なしのGemmaの曲線をシャッフル版と比べたら結構似とるねん。これはオリジナル設定で何かしらの「最初の方を優先しがち」なバイアスがあることを示唆しとるな。一方、重複なしの場合は、レトリーバーの提案をGENが無視しとるっぽいねん。Llamaを見ると、曲線がもっと不安定になっとるわ。TCの方を見ると、Gemmaはドキュメントをシャッフルしたとき曲線がフラットになるんやけど、オリジナル設定では右肩下がりになっとるねん。Llamaの結果は「最初の方優先バイアス」がもっと強いことを示唆しとるで。なんでかっていうと、オリジナルとシャッフルした設定の曲線の差がめっちゃ小さくて、オリジナルの方がちょっとだけ安定しとるくらいやからな。

12

---

## Page 13

[](/attach/b934713d77b3a1a9885d64e3966e41d53906549a91fe342dde6fc09be80c38f9_p013.png)

### 和訳

RAG-E:リトリーバーとジェネレーターの整合性と失敗パターンの定量化

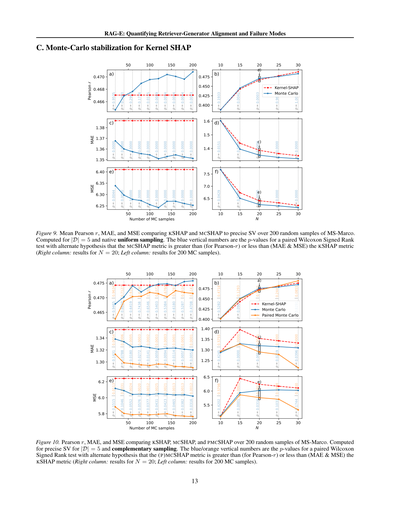

C. カーネルSHAPのモンテカルロ安定化について

図9の説明やで。

MS-Marcoっていうデータセットから200個ランダムにサンプル取ってきて、KSHAPとMCSHAPを正確なシャープレイ値(SV)と比べた結果を示してんねん。ピアソンのr(相関係数)、MAE(平均絶対誤差)、MSE(平均二乗誤差)の平均値をグラフにしてるで。計算条件は文書数|D|=5で、普通の一様サンプリング使ってんねん。青色の縦の数字はp値やねん。これはウィルコクソンの符号順位検定っていう対応のある検定で出した値で、「MCSHAPの方がKSHAPよりピアソンrは高いんちゃうか」とか「MAEとMSEは低いんちゃうか」っていう対立仮説で検定してんねん。右の列がモンテカルロサンプル数N=20の結果で、左の列がN=200の結果やで。

図10の説明な。

こっちもMS-Marcoから200サンプル取ってきて、KSHAP、MCSHAP、PMCSHAPの3つを正確なシャープレイ値と比較してんねん。ピアソンr、MAE、MSEをグラフにしてるで。計算条件は|D|=5で、こっちは補完サンプリングを使ってんねん。青とオレンジの縦の数字がp値で、さっきと同じウィルコクソンの符号順位検定で出してるわ。「(P)MCSHAPの方がKSHAPよりピアソンrは高いんちゃうか」「MAEとMSEは低いんちゃうか」っていう対立仮説での検定やねん。右の列がN=20、左の列がモンテカルロサンプル200個の結果やで。

なんでこんな比較してるかっていうと、要するにモンテカルロ法で安定化させた手法(MCSHAPとかPMCSHAP)が、従来のカーネルSHAPよりほんまにええんかどうかを統計的に検証したかってん。p値見たら分かるけど、めっちゃ小さいやつは「これは偶然ちゃうで、ほんまに差があるんやで」ってことを示してるわけやな。特にMAEとMSEのとこ見たら、モンテカルロサンプル増やすほどp値がガンガン下がってて、安定化の効果がはっきり出てるのが分かるやろ?

---

## Page 14

[](/attach/b934713d77b3a1a9885d64e3966e41d53906549a91fe342dde6fc09be80c38f9_p014.png)

### 和訳

RAG-E: レトリーバーと生成モデルのアラインメント評価と失敗パターンの数値化

図9と図10で、生成モデル(GEN)に対するKSHAPと(P)MCSHAPの方法を比べてるねん。ネイティブな一様サンプリング(図9)と補完サンプリング(図10)の両方の比較を出してるで。ノンパラメトリックなウィルコクソン符号順位検定っていう統計テストをやってみたら、おもろいことがわかったんや。同じサンプリング条件で比べた時、MCサンプル40個以上でN=20の時、もしくはMCサンプル200個でN=15〜25の範囲やと、一様サンプリングのMCSHAPと補完サンプリングのPMCSHAPがKSHAPより有意に良くなってんねん。一様サンプリングの場合やと、シャープレイ値(SV)とMCSHAPの相関もこの条件でめっちゃ良くなってるのが見えるわ。

D. 忠実性の評価指標

忠実性ってのは、入力をいじくって「摂動曲線の内側の面積」(AIPC)で測るねん。具体的に何するかっていうと、モデルを何回も呼び出しながら、重要度に応じて入力トークンを徐々にマスク(隠していく)んや。全部のトークンが隠れるまでやるわけ。で、両方向からいじるねん。まず「最も重要なやつから先に消す」(MoRF)パターンと、「一番どうでもええやつから先に消す」(LeRF)パターンや。

ちゃんとした説明(忠実な説明っていうんやけど)やったら、MoRFの時はすぐにモデルの出力が変わらなあかんねん。なんでかっていうと、めっちゃ影響力あるトークンを最初に消してるからな。逆にLeRFの時は、最初のほうは出力があんまり変わらんはずやねん。最初に消すのは別にどうでもええトークンやから、予測にそんな影響せえへんはずやろ?

この指標は論文でよう使われとるけど、実は標準化されてへんねん(Liu et al., 2021; Edin et al., 2025; Randl et al., 2025)。ワイらは入力シーケンスxごとにAIPCを計算してるで。0個からn個のトークン全部まで、1トークンずつマスクしていくねん。maskdir(x, i)っていうのは、入力xのiトークンを「dir」の方向に従ってマスクしたものを表してるわ。摂動曲線の間の面積を測定するんやけど、

クエリに対しては:

AIPCqry = |∫₀ⁿ g(maskMoRF(q, i), d) − g(q, d) di| − |∫₀ⁿ g(maskLeRF(q, i), d) − g(q, d) di| (式13)

コンテキスト文書に対しては:

AIPCctx = |∫₀ⁿ g(q, d) − g(d, maskMoRF(d, i)) di| − |∫₀ⁿ g(q, d) − g(d, maskLeRF(d, i)) di| (式14)

RET(レトリーバー)の場合はg(q, d) = sret(q, d)にして、GEN(生成モデル)の場合はg(q, d)がモデルの出力になるねん。ほんでサンプルごとに最小-最大正規化して、全入力の平均AIPCを報告するわ。結果として、AIPC値は理論上0(全然忠実やない)から1(めっちゃ忠実)の範囲になるねん。ただし現実的な最大値はモデルによって変わって、常に1より小さいで。

RET説明の評価:ワイらのIG(積分勾配)によるRET説明の忠実性を、生の勾配(Grad: βi = ∂f(x)/∂xi)、gradient×input(Shrikumar et al., 2017)、アテンション勾配(AGrad)(Liu et al., 2021)をベースラインとして比較したで。

eqry(·)とectx(·)はどっちもエンコーダーのみのTransformerで、埋め込みΦ(x) = Wx + p(pは位置埋め込み)の上に乗っかったy = f(Φ(x))っていう構造やねん。ってことは、Φ(x)に対する勾配も計算せなあかんのやけど、これがPyTorchのautogradでサポートされてへんねん。せやから、入力に対する勾配は手動で計算したで:

∂e(x)/∂x = [∂f(Φ(x))/∂Φ(x)]_{x=x̄} · W (式15)

↑これはautogradで計算

クエリのテキストはもともと短いもんやから、トークン1個いじるだけでテキスト全体の意味がごっそり変わってまうことがあるねん。それってそのトークンが判断にどんだけ影響してるかとは関係ないやん。せやから、忠実性のテストはコンテキスト文書だけでやったで。でも、使ってるIG方式はコンテキストでもクエリでも同じやから、結果は転用できるって主張してるねん。このテストの結果は表4に載せてるわ。テストした両方のRETで、IGが一番ええ成績やった。びっくりしたんやけど、DRAGONのRETではAGradがIGと同じくらい忠実やったんや。でも全体的にはIGがベストやな。

IG説明で使った設計の選択をテストするために、リーマン積分のステップ数Lを忠実性と加法性比率の観点でアブレーション(削除実験)したで。結果は表5に載せてるけど、L=100ステップで積分を十分に近似できてることがわかったわ。帰属値の合計が出力の90%以上になってるし、コンテキスト帰属の忠実性も横ばいになってるからな。

---

## Page 15

[](/attach/b934713d77b3a1a9885d64e3966e41d53906549a91fe342dde6fc09be80c38f9_p015.png)

### 和訳

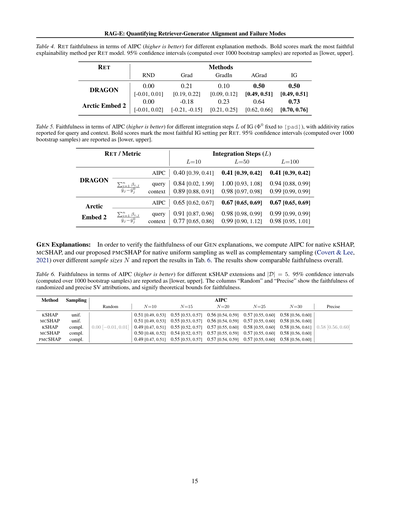

RAG-E: RetrieverとGeneratorがちゃんと噛み合ってるか、どこでコケてるかを数値化する話

表4. RET(検索モデル)の忠実度をAIPC(高いほどええ)で見たときの、説明手法ごとの比較やで。太字は各RETモデルで一番忠実やった説明手法を示してるねん。95%信頼区間(1000回のブートストラップサンプルから計算)は[下限, 上限]で書いてあるで。

| RET | RND | Grad | GradIn | AGrad | IG |

|-----|-----|------|--------|-------|-----|

| DRAGON | 0.00 [-0.01, 0.01] | 0.21 [0.19, 0.22] | 0.10 [0.09, 0.12] | 0.50 [0.49, 0.51] | 0.50 [0.49, 0.51] |

| Arctic Embed 2 | 0.00 [-0.01, 0.02] | -0.18 [-0.21, -0.15] | 0.23 [0.21, 0.25] | 0.64 [0.62, 0.66] | 0.73 [0.70, 0.76] |

表5. IG(Integrated Gradients)の積分ステップ数Lを変えたときの忠実度をAIPC(高いほどええ)で見た結果やねん。Φ0は[pad]で固定してるで。加法性比率はクエリとコンテキスト両方について載せてあるわ。太字は各RETで一番忠実やったIG設定を示してるねん。95%信頼区間(1000回のブートストラップサンプルから計算)は[下限, 上限]で書いてあるで。

| RET / 指標 | L=10 | L=50 | L=100 |

|------------|------|------|-------|

| **DRAGON** | | | |

| AIPC | 0.40 [0.39, 0.41] | 0.41 [0.39, 0.42] | 0.41 [0.39, 0.42] |

| Σβi,j/(ȳj−ȳ0j) クエリ | 0.84 [0.02, 1.99] | 1.00 [0.93, 1.08] | 0.94 [0.88, 0.99] |

| Σβi,j/(ȳj−ȳ0j) コンテキスト | 0.89 [0.88, 0.91] | 0.98 [0.97, 0.98] | 0.99 [0.99, 0.99] |

| **Arctic Embed 2** | | | |

| AIPC | 0.65 [0.62, 0.67] | 0.67 [0.65, 0.69] | 0.67 [0.65, 0.69] |

| Σβi,j/(ȳj−ȳ0j) クエリ | 0.91 [0.87, 0.96] | 0.98 [0.98, 0.99] | 0.99 [0.99, 0.99] |

| Σβi,j/(ȳj−ȳ0j) コンテキスト | 0.77 [0.65, 0.86] | 0.99 [0.90, 1.12] | 0.98 [0.95, 1.01] |

**GEN(生成モデル)の説明について:**

ワイらのGEN説明がほんまに忠実かどうか確かめるために、普通のKSHAP、MCSHAP、それからワイらが提案したPMCSHAPのAIPCを計算したんや。サンプリング方法は普通の一様サンプリングと、補完サンプリング(Covert & Lee, 2021)の両方で試してみて、サンプルサイズNもいろいろ変えて実験した結果が表6に載ってるで。結果見たら、全体的にどの手法も似たような忠実度やったわ。

表6. KSHAPの各拡張手法の忠実度をAIPC(高いほどええ)で見た結果。文書数|D|=5の場合やで。95%信頼区間(1000回のブートストラップサンプルから計算)は[下限, 上限]で書いてあるわ。「Random」列はランダム化したシャープレー値の帰属スコア、「Precise」列は正確なシャープレー値の帰属スコアの忠実度を示してて、これが忠実度の理論的な上限と下限になってるねん。

| 手法 | サンプリング | Random | N=10 | N=15 | N=20 | N=25 | N=30 | Precise |

|------|------------|--------|------|------|------|------|------|---------|

| KSHAP | 一様 | 0.00 [−0.01, 0.01] | 0.51 [0.49, 0.53] | 0.55 [0.53, 0.57] | 0.56 [0.54, 0.59] | 0.57 [0.55, 0.60] | 0.58 [0.56, 0.60] | 0.58 [0.56, 0.60] |

| MCSHAP | 一様 | | 0.51 [0.49, 0.53] | 0.55 [0.53, 0.57] | 0.56 [0.54, 0.59] | 0.57 [0.55, 0.60] | 0.58 [0.56, 0.60] | |

| KSHAP | 補完 | | 0.49 [0.47, 0.51] | 0.55 [0.52, 0.57] | 0.57 [0.55, 0.60] | 0.58 [0.55, 0.60] | 0.58 [0.56, 0.61] | |

| MCSHAP | 補完 | | 0.50 [0.48, 0.52] | 0.54 [0.52, 0.57] | 0.57 [0.55, 0.59] | 0.57 [0.55, 0.60] | 0.58 [0.56, 0.60] | |

| PMCSHAP | 補完 | | 0.49 [0.47, 0.51] | 0.55 [0.53, 0.57] | 0.57 [0.54, 0.59] | 0.57 [0.55, 0.60] | 0.58 [0.56, 0.60] | |

15

---

## Page 16

[](/attach/b934713d77b3a1a9885d64e3966e41d53906549a91fe342dde6fc09be80c38f9_p016.png)

### 和訳

RAG-E: 検索器と生成器の連携度合いと失敗パターンを数値化する話

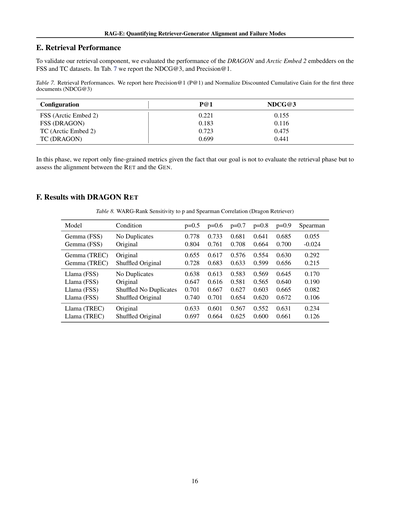

E. 検索の性能について

ほな、うちの検索コンポーネントがちゃんと動いてるか確かめるために、DRAGONとArctic Embed 2っていう埋め込みモデルの性能をFSSとTCっていうデータセットで評価したんや。表7にNDCG@3とPrecision@1っていう指標を載せとるで。

表7. 検索の性能やで。Precision@1(P@1)と、最初の3つの文書に対する正規化割引累積ゲイン(NDCG@3)を報告しとるわ

| 設定 | P@1 | NDCG@3 |

|------|-----|--------|

| FSS (Arctic Embed 2) | 0.221 | 0.155 |

| FSS (DRAGON) | 0.183 | 0.116 |

| TC (Arctic Embed 2) | 0.723 | 0.475 |

| TC (DRAGON) | 0.699 | 0.441 |

このフェーズでは細かい指標だけ報告しとるんやけど、なんでかっていうと、うちらの目的は検索フェーズを評価することやなくて、検索器(RET)と生成器(GEN)の連携がうまいこといってるかを見たいからなんや。

F. DRAGON検索器を使った結果

表8. WARG-Rankのpに対する感度とスピアマン相関(Dragon検索器使用時)

| モデル | 条件 | p=0.5 | p=0.6 | p=0.7 | p=0.8 | p=0.9 | スピアマン |

|--------|------|-------|-------|-------|-------|-------|------------|

| Gemma (FSS) | 重複なし | 0.778 | 0.733 | 0.681 | 0.641 | 0.685 | 0.055 |

| Gemma (FSS) | オリジナル | 0.804 | 0.761 | 0.708 | 0.664 | 0.700 | -0.024 |

| Gemma (TREC) | オリジナル | 0.655 | 0.617 | 0.576 | 0.554 | 0.630 | 0.292 |

| Gemma (TREC) | シャッフルしたオリジナル | 0.728 | 0.683 | 0.633 | 0.599 | 0.656 | 0.215 |

| Llama (FSS) | 重複なし | 0.638 | 0.613 | 0.583 | 0.569 | 0.645 | 0.170 |

| Llama (FSS) | オリジナル | 0.647 | 0.616 | 0.581 | 0.565 | 0.640 | 0.190 |

| Llama (FSS) | シャッフルした重複なし | 0.701 | 0.667 | 0.627 | 0.603 | 0.665 | 0.082 |

| Llama (FSS) | シャッフルしたオリジナル | 0.740 | 0.701 | 0.654 | 0.620 | 0.672 | 0.106 |

| Llama (TREC) | オリジナル | 0.633 | 0.601 | 0.567 | 0.552 | 0.631 | 0.234 |

| Llama (TREC) | シャッフルしたオリジナル | 0.697 | 0.664 | 0.625 | 0.600 | 0.661 | 0.126 |

---

## Page 17

[](/attach/b934713d77b3a1a9885d64e3966e41d53906549a91fe342dde6fc09be80c38f9_p017.png)

### 和訳

RAG-E: リトリーバーとジェネレーターの連携度とうまいこといかんパターンの数値化

G. 品詞分析

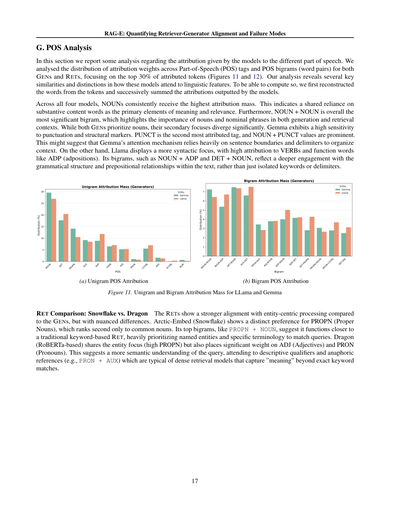

このセクションではな、モデルがどの品詞にどんだけ重みを置いてるかっていう分析を報告するで。品詞タグと品詞の2連続(単語のペアやな)について、アトリビューション(モデルがどこに注目してるかの重み)がどう分布してるか調べたんや。これ、ジェネレーター(文章生成モデル)とリトリーバー(検索モデル)の両方で、上位30%の重みがついたトークンに絞って分析してん(図11と図12見てな)。この分析でわかったんは、言語の特徴への注目の仕方に似てるとこと違うとこがあるってことやな。計算するためにまず、トークンから元の単語を復元して、モデルが出したアトリビューションを足し合わせてん。

4つのモデル全部で、名詞が一番アトリビューションの重みをもらってんねん。これはつまり、意味とか関連性を判断するときに、中身のある内容語に頼ってるってことやな。ほんで、名詞+名詞の組み合わせが全体的に一番重要なバイグラム(2語の組み合わせ)やってん。これは文章生成でも検索でも、名詞とか名詞フレーズがめっちゃ大事ってことを示してるわけや。

ジェネレーター2つとも名詞を優先してるんやけど、その次に何を重視するかがだいぶ違うねん。Gemmaは句読点とか文の構造を示すマーカーにめっちゃ敏感やねん。句読点(PUNCT)が2番目に重みついてるし、名詞+句読点の値も目立ってる。これはGemmaの注意機構が文の区切りとか区切り記号に頼って文脈を整理してるんちゃうかなって示唆してるわけや。一方でLlamaはもっと文法構造重視やねん。動詞とか、前置詞(ADP)みたいな機能語にめっちゃ重みつけてる。名詞+前置詞とか冠詞+名詞みたいなバイグラムから見ても、単なるキーワードとか区切りじゃなくて、文法構造とか前置詞の関係性をちゃんと理解しようとしてるってことがわかるねん。

(a) 単語単体の品詞アトリビューション

(b) 2語組の品詞アトリビューション

図11. LlamaとGemmaの単語単体と2語組のアトリビューション分布

リトリーバーの比較:Snowflake vs. Dragon

リトリーバーはジェネレーターと比べて、もっとエンティティ(固有名詞とか特定の言葉)中心の処理をしてるんやけど、細かいところで違いがあるねん。

Arctic-Embed(Snowflake)は固有名詞(PROPN)をめっちゃ好んでて、普通の名詞の次に重みついてる。固有名詞+名詞みたいなトップのバイグラムを見ても、昔ながらのキーワードベースの検索モデルに近い動きしてて、クエリとマッチさせるために固有名詞とか専門用語をめっちゃ優先してるってことやな。

Dragon(RoBERTaベース)も固有名詞重視なんは同じやねんけど、形容詞(ADJ)とか代名詞(PRON)にもけっこう重みつけてるねん。これはクエリをもっと意味的に理解しようとしてるってことやな。描写的な修飾語とか、代名詞で前の言葉を指し示すやつ(例えば代名詞+助動詞みたいな)にも注目してて、キーワード完全一致を超えて「意味」を捉えようとする密ベクトル検索モデルの特徴が出てるわけや。

---

## Page 18

[](/attach/b934713d77b3a1a9885d64e3966e41d53906549a91fe342dde6fc09be80c38f9_p018.png)

### 和訳

RAG-E: 検索器と生成器の連携度合いとエラーパターンを数値化する話

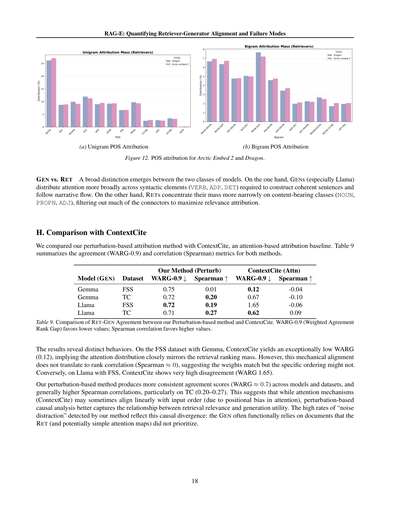

(a) ユニグラムPOS帰属分析

(b) バイグラムPOS帰属分析

図12. Arctic Embed 2とDragonのPOS帰属分析やで。

**GENとRETの違い**

この2種類のモデルには、めっちゃはっきりした違いがあるねん。まずGEN(生成モデル、特にLlama)は、ちゃんとした文章を組み立てたり話の流れについていくために必要な文法要素(動詞、前置詞、冠詞とか)に注意を幅広く配分してるんや。一方でRET(検索モデル)は、中身のある単語クラス(名詞、固有名詞、形容詞)にめっちゃ集中してて、つなぎ言葉とかはバッサリ切り捨てて、関連性の評価を最大化しようとしてるんやな。

## H. ContextCiteとの比較

うちらの摂動ベースの帰属手法を、ContextCiteっていうアテンションベースの帰属手法と比べてみたで。表9に、両方の手法の一致度(WARG-0.9)と相関(スピアマン)の指標をまとめてるわ。

[表9の内容]

表9. うちらの摂動ベース手法とContextCiteでのRET-GEN一致度の比較や。WARG-0.9(重み付き一致ランクギャップ)は低いほどええ。スピアマン相関は高いほどええで。

結果見たら、めっちゃ違う動きしてるのがわかるねん。FSSデータセットでGemma使った時、ContextCiteはWARGがめちゃくちゃ低い(0.12)んや。これは、アテンションの分布が検索ランキングの重みとほぼ一致してるってことやねん。でもな、この機械的な一致がランクの相関につながってへんのよ(スピアマン≈0)。つまり重み自体は合ってるけど、具体的な順番は合ってへんかもしれんってことや。逆に、LlamaでFSS使った時は、ContextCiteはめっちゃ不一致が高い(WARG 1.65)んや。

うちらの摂動ベース手法は、どのモデルでもどのデータセットでも、もっと安定した一致スコア(WARG≈0.7くらい)を出してて、スピアマン相関も全般的に高いんや。特にTCでは0.20〜0.27やな。なんでかっていうと、アテンションの仕組み(ContextCite)は入力の順番と線形に一致することがあるんやけど(アテンションの位置バイアスのせいでな)、摂動ベースの因果分析の方が、検索の関連性と生成の有用性の関係をうまく捉えられるからやねん。うちらの手法で検出された「ノイズ気を取られ」率が高いのも、この因果的な乖離を反映してるんや。要するに、GENは実際にはRET(あと単純なアテンションマップも)が優先せんかった文書に機能的に依存してることが多いってことやで。

---

## Page 19

[](/attach/b934713d77b3a1a9885d64e3966e41d53906549a91fe342dde6fc09be80c38f9_p019.png)

### 和訳

RAG-E:リトリーバーとジェネレーターの連携度と失敗パターンを数値化する研究

I. 帰属パターンの比較分析

このセクションでは、各データセットから2つずつ例を見せるで。両方のデータセットでWARG帰属の極端なケースをピックアップしてるねん。各クエリについて、クエリ自体と取得されたドキュメントへの帰属、それから各ドキュメントが生成テキスト(アシスタント)にどれだけ影響したかも報告してるで。表10では、§5で議論した通り、取得ドキュメントの上位50%に帰属されたトークンの中にクエリのトークンがどれくらい含まれてるかのパーセンテージも示してるねん。

表10. 取得ドキュメントの上位50%帰属トークンにクエリトークンが出現する割合

| データセット | モデル(RET) | クエリ重複率(%) |

|---|---|---|

| TC | Arctic Embed 2 | 65.23% |

| TC | DRAGON | 78.23% |

| FSS | Arctic Embed 2 | 71.06% |

| FSS | DRAGON | 78.18% |

I.1. ケーススタディ1:一致度が低いパターン

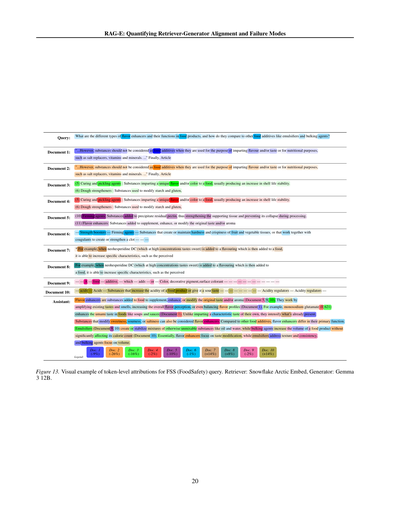

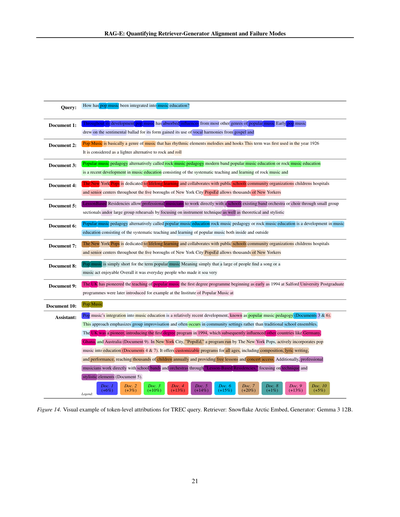

図13と14では、リトリーバーとジェネレーターの間で一致度が低かった2つのクエリの帰属パターンを示してるで。

見てもらったらわかるけど、どっちのケースでも、クエリの中で意味のある重要な単語が、ドキュメントの中でも高く帰属されてる部分に入ってるねん(FSSの例やったらfood、flavor、agentsやし、TCの例やったらpop、music、educationやな)。面白いことに、RET(リトリーバー)は意味的に関連してる単語も高く帰属してんねん(例えばlesson based、popular、pedagogyとかな)。

GEN(ジェネレーター)の帰属を見てみると、図13の場合は全部のドキュメントが回答生成に貢献してて、しかもドキュメント9と10はリトリーバーの順位から予想されるよりも貢献度高いねん。TCの例に注目したら、ドキュメント5、6、7、9が最初にランク付けされたドキュメントよりも生成テキストにめっちゃ貢献してるのがはっきりわかるで。なんでかっていうと、取得されたドキュメント同士が似すぎてる(完全に重複してるケースもある)からやと思われるねん。

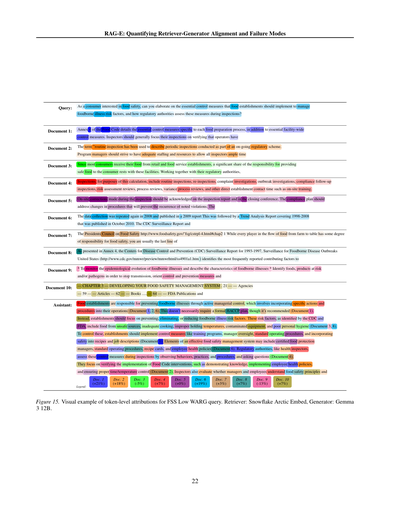

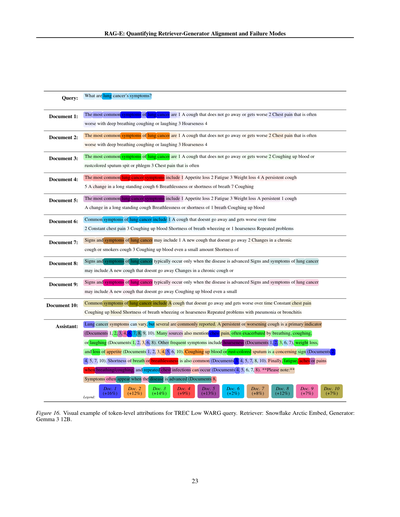

I.2. ケーススタディ2:一致度が高いパターン

ケーススタディ1と同じように、図15と16でRETとGEN両方の帰属を示してるで。RET側については前に観察したのと同じで、クエリに出てくる単語に強い帰属が見られるねん。これは特に図16で顕著やねん。なんでかっていうと、クエリが短くて意味のある単語が少ないからやな。

生成テキストの帰属を見ると、またまた似たような傾向が見えるねん。FSSデータセットの結果を見たら、帰属のばらつきは大きいけど、最も帰属度の高い単語(intense colorとか)の多くは最初のドキュメントに属してることがわかるで。一方、TCデータセットについての図16を見たら、ドキュメント1と3が最も帰属度高いグループに入ってるのがはっきりわかるねん。

19

---

## Page 20

[](/attach/b934713d77b3a1a9885d64e3966e41d53906549a91fe342dde6fc09be80c38f9_p020.png)

### 和訳

RAG-E: 検索器と生成器のアライメントと失敗パターンの定量化

めっちゃざっくり言うとな、これはAIがどう情報を検索して回答を作り出すかってのを分析した研究やねん。

クエリ(質問):食品に使われる風味増強剤ってどんな種類があって、どんな働きするん?他の食品添加物、例えば乳化剤とか増量剤と比べてどう違うん?

文書1:

文書2:

文書3:

文書4:

文書5:

「...せやけど、風味やら味をつけるため、あるいは栄養目的で使われる物質は食品添加物とは見なさんで、例えば塩の代替品とかビタミン、ミネラルとかな...」最後に、第〇条では

「...せやけど、風味やら味をつけるため、あるいは栄養目的で使われる物質は食品添加物とは見なさんで、例えば塩の代替品とかビタミン、ミネラルとかな...」最後に、第〇条では

(5) 塩漬け・ピクルス剤:食品に独特の風味やら色をつける物質やで、大体の場合、保存期間を長くする効果もあるねん。

(6) 生地強化剤:デンプンとグルテンを改質するための物質やな、

(5) 塩漬け・ピクルス剤:食品に独特の風味やら色をつける物質やで、大体の場合、保存期間を長くする効果もあるねん。

(6) 生地強化剤:デンプンとグルテンを改質するための物質やな、

(10) 硬化剤:残留ペクチンを沈殿させるために加える物質やねん。これで支持組織を強化して、加工中に潰れんようにするわけや。

(11) 風味増強剤:元々の味やら香りを補強したり、強めたり、変えたりするために加える物質やで

文書6: — 強度増強剤 — 硬化剤 — 果物や野菜の組織の硬さやパリパリ感を作ったり維持したりする物質、あるいは凝固剤と一緒に働いて凝塊を作ったり強化したりする物質やな — — —

文書7:

文書8:

例えばな、ネオヘスペリジンDC(高濃度やと甘い味がするやつ)をフレーバーに添加して、そのフレーバーを食品に加えると、特定の特性、例えば知覚される

例えばな、ネオヘスペリジンDC(高濃度やと甘い味がするやつ)をフレーバーに添加して、そのフレーバーを食品に加えると、特定の特性、例えば知覚される

文書9: — — ある — 食品 — 添加物は、— 加えたり — あるいは — 色やな、装飾顔料、表面着色料 — — — — — — — — — — — —

文書10: — 酸 — 酸類 — 食品の酸性度を上げたり、酸っぱい味をつけたりする物質やで — — — — — — — — — 酸度調整剤 — 酸度調整剤 —

回答:

風味増強剤っていうのはな、元々の味やら香りを補強したり、強めたり、変えたりするために食品に加える物質のことやねん(文書5、9、10)。既存の味や匂いを増幅したり、全体的な風味の感じ方を強めたり、風味のバランスを整えたりする働きをするんや(文書1)。例えばな、グルタミン酸ナトリウム(E 621)はスープとかソースのうま味を強めるやろ(文書1)。こいつらは自分自身の特徴的な味を持つんやなくて、もともとあるもんを強調するんがポイントやねん。

甘み、酸味、塩味を調整する物質も風味増強剤として考えられることがあるで。他の食品添加物と比べると、風味増強剤は主な機能がちゃうねん。

乳化剤(文書9、10)は油と水みたいに普通やったら混ざらへん物質の混合物を作ったり安定させたりするんや。増量剤はカロリーにあんまり影響与えへんまま食品の量(かさ)を増やすもんやねん(文書10)。要するにな、風味増強剤は味の調整に集中してて、乳化剤は食感とか一貫性を扱うて、増量剤は量に焦点当ててるっちゅうことや。

文書1(-9%)文書2(-26%)文書3(-16%)文書4(-2%)文書5(-10%)文書6(-1%)文書7(+14%)文書8(+8%)文書9(-2%)文書10(+14%)

凡例:

図13. FSS(食品安全)クエリに対するトークンレベルの帰属の視覚的な例やで。検索器:Snowflake Arctic Embed、生成器:Gemma 3 12B。

20

---

## Page 21

[](/attach/b934713d77b3a1a9885d64e3966e41d53906549a91fe342dde6fc09be80c38f9_p021.png)

### 和訳

RAG-E: 検索と生成のアライメント、そして失敗パターンの定量化

質問: ポップミュージックって音楽教育にどうやって取り入れられてきたん?

ドキュメント1:

ドキュメント2:

ドキュメント3:

ドキュメント4:

ドキュメント5:

ドキュメント6:

ドキュメント7:

ドキュメント8:

ドキュメント9:

ポップミュージックってな、発展していく中で他のポピュラー音楽ジャンルからめっちゃ影響受けてきてん。初期のポップミュージックは

センチメンタルなバラードから形式を借りて、ゴスペルからボーカルハーモニーの使い方を取り入れたんやで

ポップミュージックってのは基本的にリズム要素とメロディとフックがあるジャンルのことやねん。この言葉が最初に使われたんは1926年やで

ロックンロールのちょっと軽めの代替として考えられとったんやな

ポピュラーミュージック教育学ってな、ロックミュージック教育とかモダンバンドとかポピュラーミュージック教育とも呼ばれとって、

音楽教育の中では比較的新しい分野やねん。ロックミュージックを体系的に教えて学ぶっていう

ニューヨーク・ポップスってのは生涯学習に力入れとって、公立学校とかコミュニティ組織とか子供病院とか

ニューヨーク市の5つの行政区にある高齢者センターとか色んなとこと連携しとんねん。PopsEdっていうプログラムで何千人ものニューヨーカーが

レッスンベースのレジデンシーってのはな、プロのミュージシャンが学校の既存のバンドとかオーケストラとか合唱団と直接一緒に活動できるプログラムやねん。小グループの

セクショナルとか大人数でのリハーサルを通して、楽器のテクニックとか理論的・スタイル的な

ポピュラーミュージック教育学ってな、ポピュラーミュージック教育とかロックミュージック教育とも呼ばれとって、音楽

教育の一分野で、ポピュラーミュージックを学校の中でも外でも体系的に教えて学ぶことやねん

ニューヨーク・ポップスは生涯学習に力入れとって、公立学校とかコミュニティ組織とか子供病院とか

ニューヨーク市の5つの行政区にある高齢者センターと連携しとんねん。PopsEdで何千人ものニューヨーカーが

ポップミュージックってのは単純にポピュラーミュージックの略やねん。つまりめっちゃ多くの人がその曲とか

アーティストを楽しいと思うってことや。結局のところ、それを作り上げたんは普通の人たちやねん

イギリスはポピュラーミュージック教育の先駆者やったんやで。最初の学位プログラムは1994年にサルフォード大学で始まったんや。大学院

プログラムはその後に導入されて、例えばインスティテュート・オブ・ポピュラーミュージックとかで

ドキュメント10:

ポップミュージック

回答:

ポップミュージックが音楽教育に取り入れられたんは比較的最近のことでな、ポピュラーミュージック教育学って呼ばれとんねん(ドキュメント3と6)。

このアプローチはグループでの即興を重視しとって、従来の学校のアンサンブルやなくてコミュニティの場で行われることが多いんやで。

イギリスが先駆者やって、1994年に最初の学位プログラムを始めて、それがドイツとかガーナとか

オーストラリアみたいな他の国にも影響与えたんや(ドキュメント9)。ニューヨーク市では「PopsEd」っていうニューヨーク・ポップスが運営するプログラムが積極的にポップ

ミュージックを教育に取り入れとんねん(ドキュメント4と7)。作曲とか作詞とかパフォーマンスを含む全年齢向けのカスタマイズできるプログラムを提供しとって、

毎年何千人もの子供たちに届いて、無料レッスンとかコンサートへのアクセスを提供しとんや。さらにプロの

ミュージシャンが「レッスンベースのレジデンシー」を通じて学校のバンドやオーケストラと直接活動して、テクニックとか

スタイル的な要素に焦点当てとんねん(ドキュメント5)。

ドキュメント1(+6%) ドキュメント2(+3%) ドキュメント3(+10%) ドキュメント4(+13%) ドキュメント5(+14%) ドキュメント6(+15%) ドキュメント7(+20%) ドキュメント8(+1%) ドキュメント9(+13%) ドキュメント10(+5%)

凡例:

図14. TRECクエリに対するトークンレベルの帰属の視覚的な例やで。検索器: Snowflake Arctic Embed、生成器: Gemma 3 12B。

21

---

## Page 22

[](/attach/b934713d77b3a1a9885d64e3966e41d53906549a91fe342dde6fc09be80c38f9_p022.png)

### 和訳

# RAG-E: 検索器と生成器のズレを定量化して、どこでコケるか分析するで

**クエリ**: 食の安全に興味ある消費者として聞きたいんやけど、飲食店が食中毒のリスク要因を管理するために絶対やらなあかん対策ってなんなん?あと、規制当局が検査のときにそういう対策をどうやって評価しとるん?

**文書1**: フードコードの付録4には、施設全体で絶対やらなあかん対策に加えて、それぞれの調理工程に特化した必須の管理対策が詳しく書いてあんねん。検査官は基本的に、事業者がちゃんとやっとるか確認することに集中すべきやねん

**文書2**: (内容なし)

**文書3**: (内容なし)

**文書4**: 「定期検査」っていう言葉は、継続的な規制の仕組みの一環として定期的にやる検査のことを指すのに使われとんねん。プログラムマネージャーは、全検査官が十分な時間とれるように、スタッフと資源をちゃんと確保するよう頑張らなあかんねん。ほとんどの消費者は小売店とか飲食店から食べ物もらうから、安全な食品を消費者に届ける責任のかなりの部分はこういう施設にあんねん。規制当局と一緒に協力してやな... 検査には、この計算上、定期検査、再検査、苦情調査、アウトブレイク調査、コンプライアンスフォローアップ検査、リスク評価レビュー、プロセスレビュー、バリアンスプロセスレビュー、あと現場でのトレーニングみたいな直接施設と接触する時間も含まれるで

**文書5**: 検査中にその場で修正したもんは、検査報告書と終了時のカンファレンスでちゃんと記録せなあかんねん。コンプライアンスプランでは、指摘された違反が再発せんように手順の変更を盛り込まなあかんで

**文書6**: (内容なし)

**文書7**: データ収集は2008年にまたやって、2009年のレポートで公表されたんや。その後、1998年から2008年をカバーするトレンド分析レポートが2010年10月に出版されたんや。CDCのサーベイランスレポートと... 大統領食品安全評議会 http://www.foodsafety.gov/˜fsg/cstrpl-4.html#chap2 1 農場から食卓までの食の流れの中で、誰もがある程度は食品安全に責任あるんやけど、普通はあんたが最後の砦なんやで

**文書8**: 付録4で示されとるように、疾病対策予防センター(CDC)の1993-1997年サーベイランスレポート「米国の食中毒アウトブレイクサーベイランス」(http://www.cdc.gov/mmwr/preview/mmwrhtml/ss4901a1.htm) には、最も頻繁に報告される食中毒の要因が特定されとるんや

**文書9**: *食中毒の疫学的な動向をモニターして、食中毒の特徴を記述するため *リスクのある食品・製品やら病原体を特定して、伝播を止めて、管理・予防対策の方向性を決めるため

**文書10**: — 第3章 — 食品安全管理システムの構築 . 21 — — 機関 — 59 — — 記事 — 62 — — 書籍 ..... — 64 — — FDA出版物と

**回答**:

飲食店には、能動的な経営管理を通じて食中毒を予防する責任があんねん。これは具体的な行動や手順を業務に組み込むことを意味するんや(文書1、2、6)。必ずしも正式なHACCPプランが必要ってわけやないけど、あった方がええで(文書1)。むしろ、施設は食中毒リスク要因を予防・排除・低減することに集中すべきやねん。CDCとFDAが特定したこれらのリスク要因には、安全でない供給源からの食品、不十分な加熱調理、不適切な保持温度、汚染された機器、そして不衛生な個人衛生が含まれるんや(文書3、8)。これらを管理するために、施設はトレーニングプログラム、管理者の監督、標準作業手順、レシピや職務記述書への安全組み込みといった管理対策を実施すべきやねん(文書1)。効果的な食品安全管理システムの要素としては、認定食品保護マネージャー、標準作業手順、レシピカード、従業員健康ポリシーなんかがあるで(文書6)。保健検査官みたいな規制当局は、検査中に行動、実践、手順を観察して質問することで、これらの管理対策を評価するんや(文書4)。フードコード介入策の実施確認に焦点当てて、知識の実証、従業員健康ポリシーの実施、適切な時間/温度管理の確保なんかをチェックするんや(文書2)。検査官はまた、管理者と従業員が食品安全の原則を理解しとるかも評価するんやで

文書1 (+21%) | 文書2 (+18%) | 文書3 (-5%) | 文書4 (+7%) | 文書5 (+0%) | 文書6 (+19%) | 文書7 (+3%) | 文書8 (+7%) | 文書9 (-13%) | 文書10 (+7%)

凡例:

**図15.** FSSが低いWARGクエリに対するトークンレベルの帰属の視覚的な例やで。検索器: Snowflake Arctic Embed、生成器: Gemma 3 12B。

---

## Page 23

[](/attach/b934713d77b3a1a9885d64e3966e41d53906549a91fe342dde6fc09be80c38f9_p023.png)

### 和訳

RAG-E:リトリーバーとジェネレーターの連携度合いと失敗パターンを数値化する話

質問:肺がんの症状って何?

ドキュメント1:

ドキュメント2:

ドキュメント3:

ドキュメント4:

ドキュメント5:

ドキュメント6:

ドキュメント7:

ドキュメント8:

ドキュメント9:

ドキュメント10:

回答:

肺がんでめっちゃよくある症状はな、①ずっと治らへん咳、もしくはどんどん悪化する咳、②深く息吸ったり咳したり笑ったりすると悪化する胸の痛み、③声がかれる、④

肺がんでめっちゃよくある症状はな、①ずっと治らへん咳、もしくはどんどん悪化する咳、②深く息吸ったり咳したり笑ったりすると悪化する胸の痛み、③声がかれる、④

肺がんでめっちゃよくある症状はな、①ずっと治らへん咳、もしくはどんどん悪化する咳、②血とか錆びた色の痰を咳で吐く、③深く息吸うと悪化する胸の痛み

肺がんでよくある症状としてはな、①食欲なくなる、②だるい・疲れやすい、③体重減る、④しつこい咳、⑤長いこと続いてた咳の様子が変わる、⑥息切れとか息苦しさ、⑦血を咳で吐く

肺がんでよくある症状としてはな、①食欲なくなる、②だるい・疲れやすい、③体重減る、①しつこい咳、長いこと続いてた咳の様子が変わる、①息切れとか息苦しさ、血を咳で吐く

肺がんのよくある症状としてはな、①ずっと治らへんくてどんどん悪化していく咳、②ずっと続く胸の痛み、③血を咳で吐く、①息切れ、ゼーゼーいう、声がかれる、繰り返し肺炎とか気管支炎になる

肺がんのサインと症状としてはな、①新しく出てきた治らへん咳、②長期間の咳とかヘビースモーカー咳の変化、③血を咳で吐く(ちょっとの量でも)、息切れ

肺がんのサインと症状ってな、普通は病気がかなり進行してからじゃないと出てこーへんねん。肺がんのサインと症状としては、新しく出てきた治らへん咳、長期間の咳の変化とか

肺がんのサインと症状ってな、普通は病気がかなり進行してからじゃないと出てこーへんねん。肺がんのサインと症状としては、新しく出てきた治らへん咳、血を咳で吐く(ちょっとの量でも)

肺がんのよくある症状としてはな、ずっと治らへんくてどんどん悪化する咳、ずっと続く胸の痛み、血を咳で吐く、息切れ・ゼーゼーいう・声がかれる、何回も肺炎とか気管支炎になる

肺がんの症状はいろいろあるんやけど、よく報告されるのがいくつかあるねん。しつこい咳とかどんどん悪化する咳が一番の目印やな(ドキュメント1、2、3、4、6、7、8、9、10)。多くの情報源で胸の痛みも挙げられてて、息したり咳したり笑ったりすると悪化することが多いねん(ドキュメント1、2、3、6、8)。他によくある症状としては、声がかれる(ドキュメント1、2、3、6、7)、体重減少、食欲不振(ドキュメント1、2、3、4、5、6、10)やな。血とか錆びた色の痰を咳で吐くのは心配なサインやで(ドキュメント2、4、5、7、10)。息切れとか息苦しさもよくあるな(ドキュメント3、4、5、7、8、10)。最後に、だるさ、息したり咳したりする時の痛み、繰り返す胸の感染症も起こりうるで(ドキュメント4、5、6、7、8)。**注意してほしいんやけど:** 症状は病気が進行してから出ることが多いねん(ドキュメント8、

ドキュメント1

(+16%)

ドキュメント2

(+12%)

ドキュメント3

(+14%)

ドキュメント4

(+9%)

ドキュメント5

(+13%)

ドキュメント6

(+2%)

ドキュメント7

(+8%)

ドキュメント8

(+12%)

ドキュメント9

(+7%)

ドキュメント10

(+7%)

凡例:

図16. TRECの低WARGクエリに対するトークンレベルの帰属の視覚的な例やで。リトリーバー:Snowflake Arctic Embed、ジェネレーター:Gemma 3 12B。

23

---

![]()

1 / 1