<<

2601.21937v1_Retrieval-Infused_Reasoning_Sandbox_A_Benchmark_fo.pdf

---

## Page 1

[](/attach/325500d0629d756bef3669db4970a06ba8b6953c1be9cc8ae2650b0e6cba8543_p001.png)

### 和訳

最近の基盤モデルってめっちゃ進化してきてん、ただ流暢に喋れるアシスタントから、ほんまに問題解決できるやつになってきたんや。コンペ形式の数学(例えばAIMEみたいなやつ)とか、現場のソフトウェアエンジニアリング(SWE-benchとか)みたいな難しいタスクでも、客観的に採点される問題でめっちゃ高いスコア出せるようになってきてんねん [14, 22]。それと並行して、エージェントっていう——インターネット自分で回って証拠集めて統合する自律システム——がどんどん使われるようになってきてん。これでモデルが持ってる知識(パラメトリック知識っていうねん)の外にも手が届くようになって、外部検索と内部推論くっつけて、いろんな情報源からの情報まとめられるようになったんや [8, 20]。この大きな流れの中で、ディープサーチっていうのが基本的な評価シナリオとして出てきてん。これはエージェントの能力をめっちゃ試すやつで、見つけにくい事実とかエンティティを何段階も探索して、ノイズ取り除いて、証拠ベースで統合する力が問われるねん。こういう要求に応えようと、最近の研究ではもっと強力なエージェント設計が提案されてるし [13, 17–19, 28]、ディープリサーチの振る舞いをちゃんと捉えられる、もっと難しいベンチマークも出てきてん。見つけにくいウェブ閲覧タスク用のBrowseCompとか、最先端の専門家レベルのクローズドエンドな質問用のHLEとかな [24, 32]。

せやけどな、今のディープリサーチの評価のやり方には大きな問題が3つあんねん。

(1)

---

## Page 2

[](/attach/325500d0629d756bef3669db4970a06ba8b6953c1be9cc8ae2650b0e6cba8543_p002.png)

### 和訳

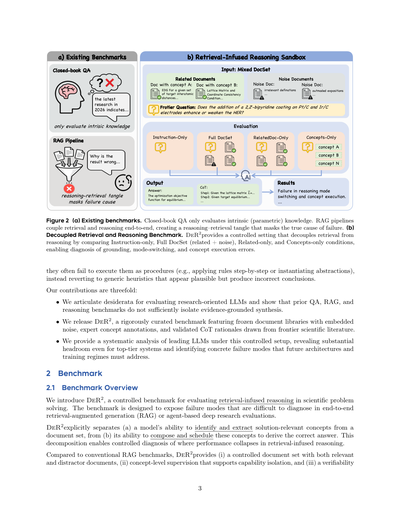

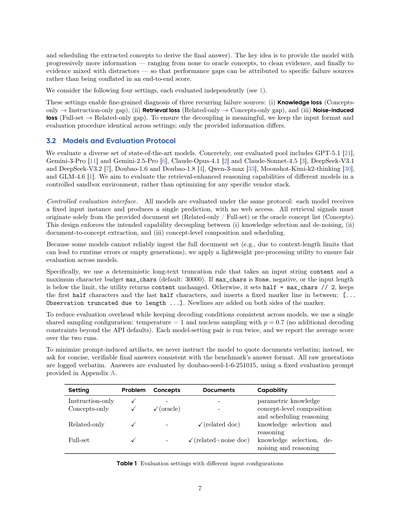

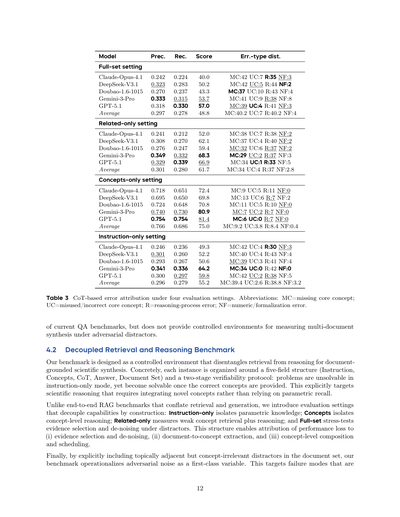

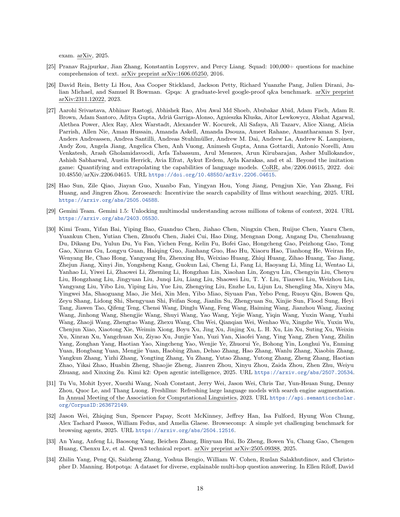

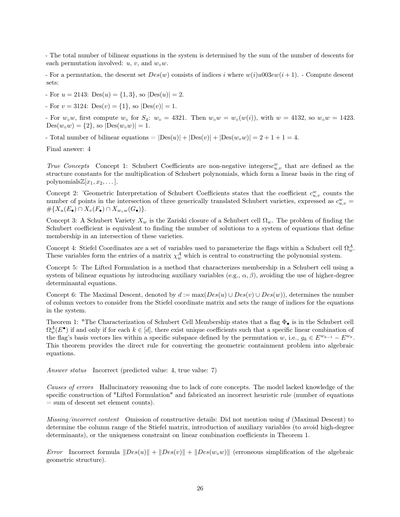

図1の説明やで!クローズドブック(本見んと答える)QAっていうのは、モデルが元々持っとる知識を測るもんやねん。一方で普通のRAGは検索と推論がごっちゃになってもうてて、邪魔な情報(ディストラクター)が入ると、エラーの原因が検索がアカンかったんか、それとも証拠を使った推論がコケたんか、わからんくなるねん。DeR2はその二つを分けて、同じ質問を制御された入力(指示だけ/コンセプト/関連情報/全部入り)で評価することで、どこで失敗したんかをちゃんと特定できるようにしとるんや。

**エンドツーエンドのパイプラインがごちゃまぜになって、診断がイマイチな問題やねん**:ぎょうさんのベンチマークは全部まとめて点数つけてまうねん——検索、リランキング、要約・圧縮、コンテキストの繋ぎ合わせ、推論、全部ひっくるめてな。せやから、バラつきの原因がツールチェーンの選び方なんか、モデルが本来持っとる研究的推論能力なんか、わからんようになってまうねん。しかも、ほとんどの設定では「正解か不正解か」の二択しか見せてくれへんから、エラーの種類を区別するんがめっちゃ難しいねん。例えば、大事なコンセプトを見逃したんか、コンセプトは見つけたけど使い方間違えたんか、それとも話題が似てるだけのノイズに引っ張られて推論のスタート地点がズレて脱線してもうたんか、みたいなことやな。結果として、こういう評価ではモデル選びとかデバッグとか、ピンポイントのトレーニングには使えるガイダンスがあんまり得られへんねん。(2) **パラメトリック漏洩/暗記問題**:もしタスクが暗記した事実とか、広い百科事典的な知識とか、簡単に推測できる数字の形式で解けてまうんやったら、正解したからって「モデルがちゃんと重要な証拠を参照して推論した」とは言えんやろ?評価のシグナルが汚染されてまうねん。(3) **Webの変動と再現性の無さ**:オープンウェブの検索に頼っとるベンチマークは、時間とか地域とかインデックスの更新とかページの不安定さ(移動したり消えたり内容が変わったり)の影響をモロに受けるから、何回やっても結果がバラバラで、ちゃんとした比較とか検証ができへんねん[32]。

こういう問題に対処するために、ワイらはDeR2っていうのを提案したんや。これは制御された研究用サンドボックスで、ドキュメントに基づいた推論を切り離しつつ、ディープサーチの核心的な難しさ——複数ステップの統合、ノイズのフィルタリング、証拠に基づいた結論の導出——はちゃんと残しとるねん。(1) **パイプラインのごちゃまぜと弱い診断**の問題は、証拠へのアクセスと推論を4つの評価モードで分けることで解決しとるで:指示だけモード(パラメトリック知識)、コンセプトモード(指示+正解のコンセプトセット;ドキュメントからの抽出なしでコンセプトの組み合わせとスケジューリングを見る)、関連文書だけモード(指示+関連するドキュメントだけ;明確な証拠のもとでの抽出と推論)、フルセットモード(関連ドキュメント+話題が似とるディストラクター;ノイズ除去と推論)。この設計やと、モード間のギャップが解釈可能になって、「検索ロス」と「推論ロス」を数値化できるし、コンセプトの見落とし、コンセプトの誤用、ノイズに誘発されたモード切り替えみたいなエラーの原因特定もできるねん。(2) **パラメトリック漏洩**は、厳格な2段階の検証プロトコルで軽減しとるで:各問題は、パラメトリック失敗(ドキュメントなしやと正答率が低い)を示しつつ、ドキュメントがあれば解ける(正解のコンセプトが与えられたら正しい解答にたどり着ける)ことが条件やねん。これで新規性(暗記した知識だけでは答えられへん)と解決可能性(想定された証拠があれば答えられる)の両方を担保しとるんや。最後に、(3) **Webの変動**は、オープンウェブへの依存をやめて、各インスタンスごとに固定されたドキュメントライブラリ(平均6.5文書)を使うことで対処しとるで。このライブラリは2023〜2025年の理論論文から取っとって、必要な証拠と、現実のちょっと不完全な文献収集を模倣するように慎重に選ばれたディストラクターの両方が入っとるねん。さらに各インスタンスには、専門家がアノテーションしたコンセプトセットと検証済みの思考過程(Chain-of-Thought)の根拠も付いとるから、最終回答の正確さだけやなく、証拠の使い方をプロセスレベルで評価できるんや。

ワイらの実験で、2つの一貫した失敗パターンが見つかったで。(1) **モード切り替えの脆弱性**:いくつかのモデルは、フルセットモードよりも指示だけモードの方がええ成績を出すねん。これは、追加のドキュメントが入ると、パラメトリック推論から証拠に基づく推論への切り替えを担当するコントローラーが混乱して、パフォーマンスが落ちてまうことを示しとるんや。(2) **構造的なコンセプト誤用**:モデルが正しいコンセプトを特定して言い直したとしても、

---

## Page 3

[](/attach/325500d0629d756bef3669db4970a06ba8b6953c1be9cc8ae2650b0e6cba8543_p003.png)

### 和訳

図2 (a) 今までのベンチマーク。クローズドブックQAは内在知識(パラメトリック知識)しか評価できへんねん。RAGパイプラインは検索と推論をエンドツーエンドで結合してまうから、「推論と検索の絡み合い」が起きて、ほんまの失敗原因がわからんくなるんや。(b) 検索と推論を分離したベンチマーク。DeR2は、「指示のみ」「フルDocSet(関連+ノイズ)」「関連文書のみ」「概念のみ」の条件を比較することで、検索と推論を分離したコントロール環境を提供してんねん。これによって、グラウンディングエラー、モード切り替えエラー、概念実行エラーを診断できるようになるんや。

---

LLMって、概念自体は理解できてるように見えるんやけど、それを手順として実行すること(例えばルールを一歩ずつ適用したり、抽象を具体化したり)がめっちゃ苦手やねん。代わりに、なんか「それっぽい」一般的なヒューリスティックに頼ってしまって、間違った結論出してまうんや。

ワイらの貢献は3つあるで:

• 研究志向のLLMを評価するための「こうあるべきやで」っていう要件を明確にして、従来のQA、RAG、推論ベンチマークが**証拠に基づいた統合**を十分に分離できてへんことを示したんや。

• DeR2をリリースしたで。これは厳密にキュレーションされたベンチマークで、ノイズを埋め込んだ固定文書ライブラリ、専門家による概念アノテーション、最先端の科学文献から引っ張ってきた検証済みのCoT(思考連鎖)根拠を含んでるんや。

• このコントロールされた設定で主要なLLMの体系的な分析を提供してん。トップクラスのシステムでさえかなり改善の余地があることが明らかになって、将来のアーキテクチャやトレーニング方式が取り組むべき具体的な失敗パターンを特定したんや。

## 2 ベンチマーク

### 2.1 ベンチマーク概要

DeR2を紹介するで。これは科学的問題解決における**検索を取り入れた推論**を評価するためのコントロールされたベンチマークやねん。このベンチマークは、エンドツーエンドの検索拡張生成(RAG)やエージェントベースの深層研究評価では診断しにくい失敗モードを明らかにするために設計されてんねん。

DeR2は明確に分離してるんや:(a) モデルが文書セットから解決に必要な概念を特定・抽出する能力と、(b) それらの概念を組み立てて順序立てて正解を導き出す能力をな。この分解によって、検索を取り入れた推論のどこでパフォーマンスが崩壊するかをコントロールしながら診断できるようになるんや。

従来のRAGベンチマークと比較して、DeR2が提供するんは:(i) 関連文書と邪魔文書(ディストラクター)の両方を含むコントロールされた文書セット、(ii) 能力の分離をサポートする概念レベルの教師データ、(iii) 検証可能性やねん。

---

a) 従来のベンチマーク b) 検索を取り入れた推論のサンドボックス

クローズドブックQA → 内在知識しか評価できへん

RAGパイプライン → 推論と検索の絡み合いが失敗原因を隠してまう

入力:混合DocSet → 評価 → 出力

「なんで結果間違ってるん...2026年の最新研究によると...」

関連文書 / ノイズ文書

最先端の質問:Pt/CとIr/C電極に2,2′-ビピリジンコーティングを加えると、HER(水素発生反応)は強化されるん?弱まるん?

EDG:与えられた目標原子間距離のセットに対して...

概念Aを含む文書:格子行列と座標整合性条件...

概念Bを含む文書:

ノイズ文書:関係ない定義...

ノイズ文書:時代遅れの説明...

指示のみ / フルDocSet / 関連文書のみ / 概念のみ

概念A、概念B、概念N

回答:平衡のための最適化目的関数は...

CoT:ステップ1:格子行列�=...が与えられたとき ステップ2:目標平衡...

結果 → 推論モード切り替えと概念実行での失敗

---

## Page 4

[](/attach/325500d0629d756bef3669db4970a06ba8b6953c1be9cc8ae2650b0e6cba8543_p004.png)

### 和訳

このプロトコルのおかげでな、パラメトリック記憶だけで解けるような問題は排除されてんねん。せやけど、ちゃんと正しい概念が与えられたら解けるようになる、そういう仕組みやねんな。

## 2.2 タスクの定義

ベンチマークの各例題はな、モデルに対して最先端の科学的な質問に答えてもらうんやけど、その時に与えられた文書セットを根拠にして推論せなあかんねん。ここで求められてる能力は、単に定義を思い出すことちゃうで。複数の概念を選び出して、それを具体的な形にして、うまいこと組み合わせて、何段階もの導出をせなあかんねん。

各例題は以下の要素のセットで定義されてるで:

• **指示(Instruction)**:最先端の科学論文から導かれた、ハイレベルな学術的質問やねん。この質問はな、正しい概念が与えられた時だけ解けるように設計されてて、関連する知識なしには絶対に答えられへんようになってんねん。

• **概念(Concepts)**:指示を解くのに必要な概念、定理、公式を全部まとめたもんや。あんまり特定の実験データに偏りすぎたらあかんくて、一般化できる科学的知識であることが大事やねん。

• **CoT(思考の連鎖)**:概念から最終的な答えにどうやってたどり着くか、その推論プロセスを示すもんやねん。モデルが与えられた知識をステップバイステップでどう使うべきか、そのお手本みたいなもんや。

• **答え(Answer)**:指示に対する答えやな。概念と推論から導き出された、成果物やったり、数値やったり、結論やったりするで。

• **文書セット(Doc Set)**:質問に答えるのに必要な概念や理論を提供する文書の集まりやねん。ここにはタスクと関係ないノイズ文書も混ぜてあって、モデルにとってバランスの取れた難しさになるようにしてんねん。

DeR2が重視してんのは研究スタイルの推論やねん。モデルは文書から得た理論的知識を、複雑な科学的問題を解くための実行可能なステップに変換せなあかんねん。このタスクは概念の運用化(例えば定理の具体化とかアルゴリズムの実行とか)に焦点を当ててて、単に表面的な内容を要約するだけとはちゃうねん。

## 2.3 データ収集

アノテーターとレビュアーはな、めっちゃ厳選されたプールから採用したで。全員が中国のトップ大学(985プロジェクト指定校)に在籍中の博士課程の学生やねん。専門分野のズレによるエラーを減らすために、アノテーターもレビュアーも自分の専門学術分野でしか作業したらあかんという厳格なルールを設けたんや。トップレベルのアノテーターを集めるために、競争力のある報酬パッケージを用意してな、1問アノテーションするごとに2500人民元、レビュアーは1件監査するごとに350人民元を支払ったで。様々な科学分野から計81人のアノテーターがデータ収集に参加してくれたんや。

**ステップ1:ソース論文の取得とスクリーニング** 各アノテーションは、2023年から2025年の間に出版されたソース論文を集めるところから始まんねん。出所には特にこだわってて、arXivプレプリントがある論文の場合は、資格判定のためにarXiv URLの日付を出版タイムスタンプとして使うねん。応用論文は除外してんねん。具体的には物理・化学の実験、社会調査、数値シミュレーションとかやな。なんでかっていうと、こういう論文の結論は主に実験的なもんで、概念駆動の論理的導出で解ける指示にはならへんからや。対象となるソース論文は理論志向でなあかんくて、(i)理論的基礎分野、(ii)理論的工学分野、(iii)理論駆動の学際的分野にまたがってんねん。一般的にアノテーターは、各分野の主要な研究グループを追跡したり、その分野の著名な教授が出してる資料を参考にしたりしてソース論文を選んでるんや。

**ステップ2:4つ組(指示、答え、概念、CoT)の構築** アノテーターがアブストラクトレベルのスクリーニングで適格なソース論文を見つけたら、論文全体を読んで問題設定、仮定、核心的な議論を理解すんねん。ほんで以下を構築するんや:(i)論文の主要な研究課題に沿った**指示**。範囲は広すぎず(複数の有効な答えを許容するような)、狭すぎず(その特定の論文でしか成り立たないような)という塩梅が大事やねん;(ii)指示を直接解決する完全な**答え**。短い成果物、数値、または簡潔な結論が優先されるで。もし答えがどうしても長くなる場合は、検証を客観的にするために、採点項目の厳密なチェックリストを提供せなあかんねん;(iii)

---

## Page 5

[](/attach/325500d0629d756bef3669db4970a06ba8b6953c1be9cc8ae2650b0e6cba8543_p005.png)

### 和訳

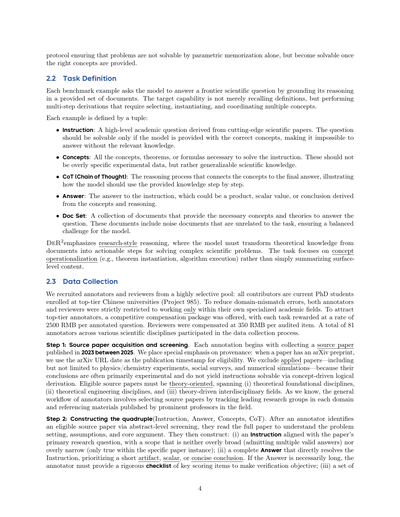

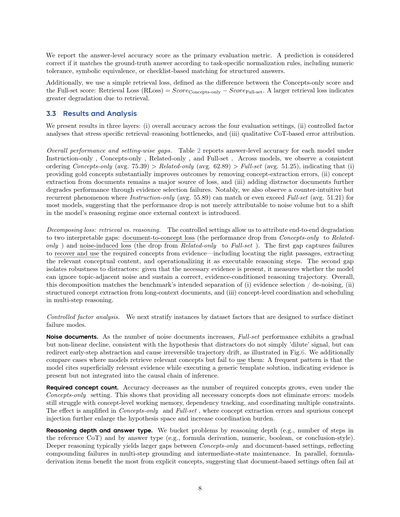

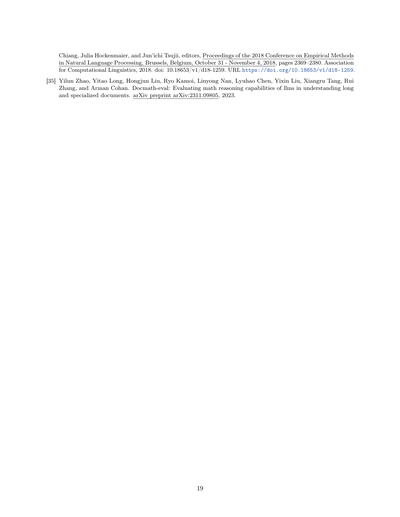

図3 DeR2dataを作るパイプラインやで:博士号持ってるアノテーターさんらが学術プラットフォームから理論系の論文を集めてきて、指示文とか概念とか思考の流れ(CoT)とか簡潔な答えを抽出していくねん。この問題らはめっちゃ難しくて、最先端の学術的な課題を表現するように設計されてるんや。難易度コントロールの段階では、オフラインのAIモデルが概念なしやと3回連続で不正解にならなあかんねんけど、関連する概念を与えたら正解できるチャンスがあるようにしてるんや。難易度コントロールの条件をクリアしたら、元論文の参考文献から関連文書とノイズ文書を取ってくるねん。最後にレビュアーが提出されたデータの論理的な品質チェックとフォーマットの品質チェックをして、難易度コントロールの条件をもう一回確認するんや。

**概念(Concepts)**っていうのは、指示文を解くのに必要な理論的概念とか定理とか形式的な記述を全部、でも必要なものだけを捉えたもんやねん(たまたま出てきた実験データとかは含まへんで)。それから(iv)指示文から答えに至るまでの段階的なCoT(推論の過程)があって、これは論文の理論的議論から導き出されてて、CoTで使われる知識は全部概念リストに入ってなあかんねん。

アノテーターはブレストとか要約にはAIツール使ってもええんやけど、指示文と答えは論文を完全に理解した上でアノテーター自身が最終決定せなあかんねん。なんでかっていうと、AIには2つの典型的な失敗パターンがあることがわかったからや:(a)答えとして周辺的な中間量を選んでまうパターン。これやとその特定の論文の文脈でしか成り立たへん指示文になってまうねん。(b)めっちゃオープンエンドな指示文を生成してまうパターン。これやと用意した答えが多くのありえる解答の一つに過ぎんくなってまうねん。せやから、最終的な指示文と答えのペアは人間が作らなあかんのや。

**ステップ3:オフラインLLMテストによる難易度調整**。各アイテムが十分に最先端で自明やないことを確認するために、オフラインモデル(DeepSeek-R1-0528とか、ネットワーク無効にしたDoubaoウェブクライアントとか)を使って難易度チェックをコントロールしながらやるねん。各条件を3回試して正解かどうか記録するんや:

• **指示文のみ**:モデルが概念なしで指示文に答える。3回とも全部不正解やなあかん。

• **概念のみ**:モデルが概念ありで答える。3回のうち、最低1回は正解で最低1回は不正解やなあかん。

もし指示文+概念の試行で3回とも全部正解やった場合は、2つの対処法のどっちかを適用するねん。**オプションA**は深い検証ステップを追加して、概念の代わりに文書セット(関連文書+ノイズ文書)を使って再テストするんや。それでもモデルが全部正解のままやったらそのアイテムは破棄、2回以上失敗したら保持してもええ(ただし文書セットがPDF3つ超える場合は、一般的なLLMインターフェースのコンテキスト制限があるから非推奨やで)。この時点で**オプションB**もまだ採用できて、アノテーターが繰り返し

5

[図の説明]

レビュアー「難問か?」「正確な解答か?」

アノテーター

ステップ1:元論文を探す

最先端の元論文(2023-2025年)

指示文、概念、CoT、答え

ステップ2:アイテムを作成

オフラインAIテスト

概念なし ❌ ❌ ❌

概念あり ✅ ✅ ❌

ステップ3:難易度コントロール

ステップ4:文書セットを収集

参考文献→関連文書、ノイズ文書

「その論文の年度はあかんで」「おっけー、元論文変えるわ」

「実験データは概念として認められへんで」

---

## Page 6

[](/attach/325500d0629d756bef3669db4970a06ba8b6953c1be9cc8ae2650b0e6cba8543_p006.png)

### 和訳

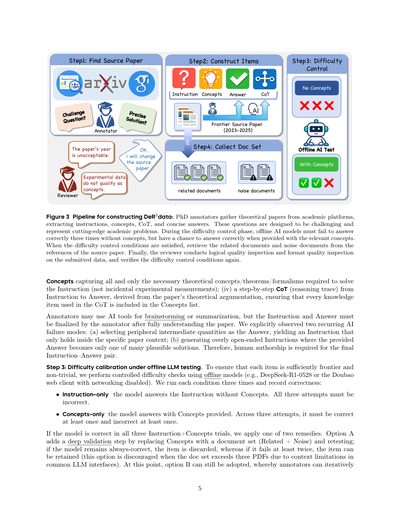

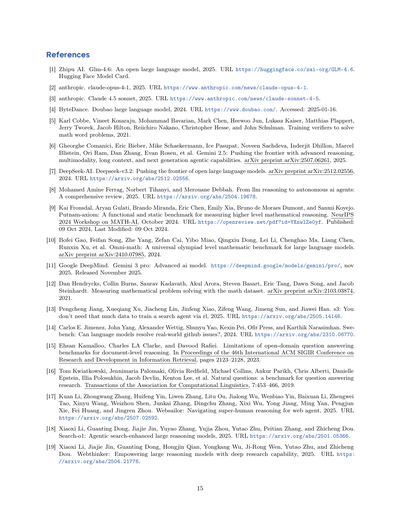

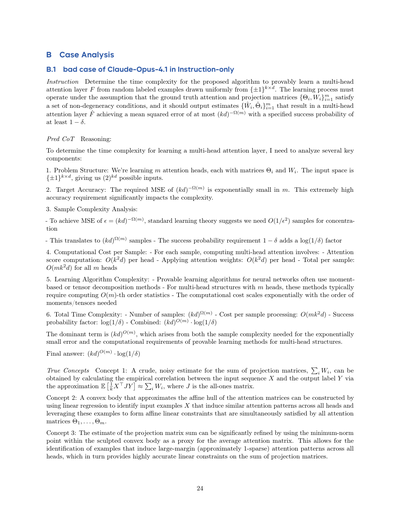

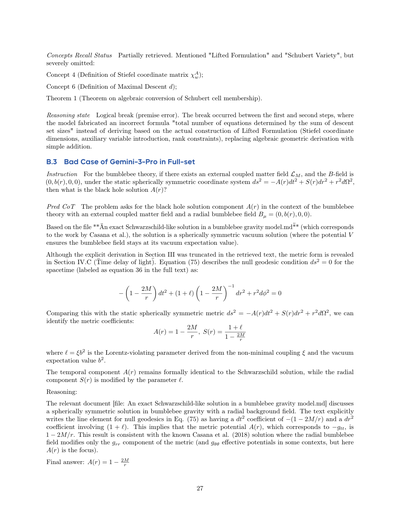

図4のやつは、問題がどんな分野に分布しとるかと、答えがどんなタイプかっていう分布を見せとんねん。要するに、このベンチマークがどれくらい幅広い学問分野をカバーしとるかと、求められる答えの形式がどんだけバラエティに富んでるかが分かるようになっとるわけや。

ステップ4は「文書セットの構築」やで。4つ組(さっき作った問題・答え・概念・思考の連鎖のセット)が難易度の調整をパスしたら、次はアノテーターが文書セットを作っていくねん。まず元論文の参考文献リストからスタートして、それぞれの概念に対して少なくとも1つは「関連文書」を見つけてくるんや。ちなみに1つの関連文書で複数の概念をカバーしてもOKやで。で、その後「ノイズ文書」っちゅうのも何個か選ぶねん。これは問題のテーマとは近いけど、答えを導くのに必要な概念は含んでへん文書のことや。全部の文書について、アノテーターは次の3つをちゃんと確認せなあかん:(i)関連文書には必要な概念がほんまに入っとるか、(ii)ノイズ文書には答えに必要な概念が一切入ってへんけど、テーマ的にはちゃんと関係あるか、(iii)どの文書にも答えがそのまんま書いてあったり、簡単に導き出せる形で書いてあったりせえへんか、っちゅうことやな。

レビューと品質保証(QA)のとこやけど、レビュアーになれるんは、アノテーターとして3つ以上の注釈が採用された人だけやねん。レビューされる項目は、フォーマットがちゃんとしとるかと、科学的にも正しいかの両方をチェックされるで。具体的に言うと:(i)問題が2023年から2025年の理論系の元論文に基づいた最先端の学術的な問いになっとって、それだけで完結しとって、範囲も適切か、(ii)答えが一意で曖昧さがなくて、確認しやすいか(長い場合は厳密なチェックリスト付き)、(iii)概念が問題を解くのに必要な知識項目で、関係ないもんが混じってへんか、あと論文特有の実験値やなくて理論的な構成要素になっとるか、(iv)思考の連鎖が概念に基づいた一貫した導出になっとって、全部の概念を使っとるか(抜けがないか)、実験データを前提にしてへんか、そして答えと矛盾のない一意の結論に至っとるか、(v)難易度調整のテストをレビュアーがもっかいやって、文書セットも再チェックして答えが漏れてへんか確認しとるか、っちゅうことやな。

コラボレーションのループについてやけど、アノテーターとレビュアーはオンラインの共有ドキュメントでめっちゃ頻繁にフィードバックしながら一緒に作業しとったんや。この繰り返しのワークフローのおかげで、曖昧なとこ、範囲の問題、概念の漏れ、文書の汚染とかを素早く修正できて、結果として一貫性が上がって、採用されたもんは全部このベンチマークの構造的・科学的な要件を満たすようになっとるっちゅうわけや。

## 3. 実験

### 3.1 評価の設定

モデルの評価は4つのコントロールされた入力設定でやっとんねん。これ何でかっていうと、検索能力(長いコンテキストの中から答えに関係ある証拠を選んで抽出する力)と推論能力(見つけた情報を組み合わせて答えを出す力)を明確に分けて測りたいからやねん。

---

## Page 7

[](/attach/325500d0629d756bef3669db4970a06ba8b6953c1be9cc8ae2650b0e6cba8543_p007.png)

### 和訳

ほな説明するで!これ何がポイントかっていうと、モデルにちょっとずつ情報を増やして渡していくねん。最初は何もなしの状態から、正解のコンセプト、きれいな証拠、ほんでノイズ混じりの証拠まで段階的に増やしていく。こうすることで、どこで性能が落ちてるかがはっきりわかるようになるねん。全部まとめて一発で評価しちゃうと、何が原因かさっぱりわからんくなるからな。

4つの設定を用意してて、それぞれ別々に評価するんやで(表1見てな)。

この設定のおかげで、よくある3つの失敗パターンをめっちゃ細かく診断できるようになるねん:(i)知識ロス(コンセプトのみ→指示のみの差)、(ii)検索ロス(関連のみ→コンセプトのみの差)、(iii)ノイズ起因ロス(フルセット→関連のみの差)。ちゃんと切り分けできるように、入力フォーマットと評価手順は全部同じにしてあって、違うのは渡す情報だけやねん。

## 3.2 モデルと評価プロトコル

いろんな最先端モデルを評価したで。具体的に言うと、GPT-5.1、Gemini-3-ProとGemini-2.5-Pro、Claude-Opus-4.1とClaude-Sonnet-4.5、DeepSeek-V3.1とDeepSeek-V3.2、Doubao-1.6とDoubao-1.8、Qwen-3-max、Moonshot-Kimi-k2-thinking、あとGLM-4.6やな。目的はな、特定のベンダーに最適化するんじゃなくて、コントロールされた環境で各モデルの検索強化推論能力を評価することやねん。

**統制された評価インターフェース**

全部のモデルを同じルールで評価するねん。各モデルには固定の入力を渡して、予測は1回だけ。ネットアクセスは禁止やで。検索シグナルは、渡されたドキュメントセット(関連のみ/フルセット)か、正解コンセプトリストからしか使えへんねん。これによって、(i)知識の選択とノイズ除去、(ii)ドキュメントからコンセプトへの抽出、(iii)コンセプトレベルの組み合わせとスケジューリング、この3つの能力をちゃんと分けて評価できるようにしてるわけや。

ただな、全部のドキュメントセットを一気に読めへんモデルもあるねん(コンテキスト長の制限でエラーになったり、何も出力せんかったりする)。そやから、公平に評価するために軽い前処理をかけてるで。

具体的には、決定論的な長文切り詰めルールを使ってるねん。入力文字列contentと最大文字数max_chars(デフォルトは30000)を受け取って、max_charsがNoneか負の値か、入力がその制限以下やったらそのまま返す。超えてたら、half = max_chars // 2 を計算して、最初のhalf文字と最後のhalf文字を残して、間に固定のマーカー行を挟むねん:「[... Observation truncated due to length ...]」って感じで。マーカーの両側には改行を入れるで。

評価のコストを減らしつつ、全モデルでデコード条件を揃えるために、共通のサンプリング設定を使ってるねん:temperature = 1、nucleus samplingでp = 0.7(APIのデフォルト以外の追加制約はなし)。各モデルと設定の組み合わせは2回ずつ実行して、その平均スコアを報告してるで。

プロンプト由来のアーティファクトを最小限にするために、ドキュメントをそのまま引用せえとは絶対言わへんねん。代わりに、ベンチマークの回答フォーマットに沿った、簡潔で検証可能な最終回答を求めてる。生の出力は全部そのまま記録してるで。回答の評価にはdoubao-seed-1-6-251015を使ってて、評価プロンプトは付録Aに載せてるわ。

| 設定 | 問題 | コンセプト | ドキュメント | 能力 |

|------|------|------------|--------------|------|

| 指示のみ | ✓ | | | パラメトリック知識 |

| コンセプトのみ | ✓ | ✓(正解) | | コンセプトレベルの組み合わせとスケジューリング推論 |

| 関連のみ | ✓ | | ✓(関連doc) | 知識選択と推論 |

| フルセット | ✓ | | ✓(関連+ノイズdoc) | 知識選択、ノイズ除去、推論 |

**表1** 異なる入力構成での評価設定

---

## Page 8

[](/attach/325500d0629d756bef3669db4970a06ba8b6953c1be9cc8ae2650b0e6cba8543_p008.png)

### 和訳

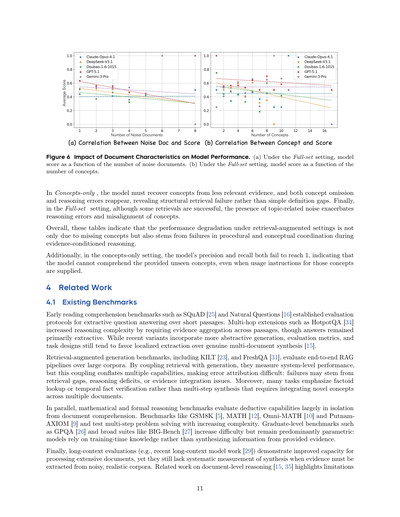

答え合わせの精度スコアを主な評価指標として報告してるねん。予測が正解かどうかは、タスクごとの正規化ルールに従って正解と一致してるかで判断するんやけど、数値の許容誤差とか、記号的な同値性とか、構造化された答えに対するチェックリスト方式のマッチングとかが含まれてるで。

あと、シンプルな検索ロスっていうのも使ってて、これは「概念のみ」スコアと「フルセット」スコアの差として定義されてるねん:検索ロス(RLoss)= 概念のみスコア − フルセットスコア。検索ロスが大きいほど、検索による性能劣化がひどいってことやな。

3.3 結果と分析

結果を3層に分けて示してるで:(i) 4つの評価設定全体での精度、(ii) 特定の検索-推論ボトルネックに負荷をかける統制要因分析、(iii) 思考連鎖(CoT)ベースの定性的エラー帰属、や。

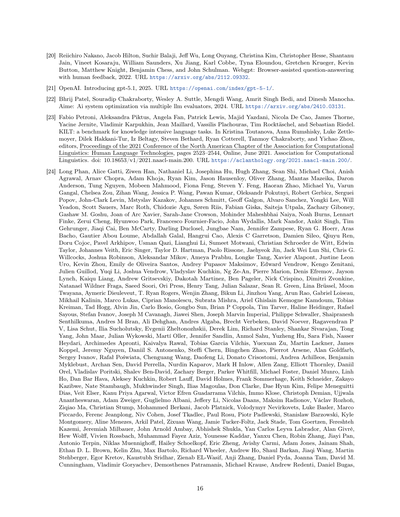

全体的なパフォーマンスと設定間のギャップ。表2に、「指示のみ」「概念のみ」「関連のみ」「フルセット」の各設定でのモデルごとの答えレベル精度を載せてるねん。モデル全体で一貫した順序が見られて、「概念のみ」(平均75.39)>「関連のみ」(平均62.89)>「フルセット」(平均51.25)ってなってるんや。これが意味するのは、(i) 正解の概念を与えると概念抽出エラーがなくなって結果がめっちゃ良くなる、(ii) 文書からの概念抽出が依然として主要なロス源になってる、(iii) 邪魔な文書を追加すると証拠選択の失敗でさらに性能が落ちる、ってことやねん。注目すべきは、直感に反するけど繰り返し見られる現象があって、「指示のみ」(平均55.89)がほとんどのモデルで「フルセット」(平均51.21)と同等かそれ以上になれるってことなんや。これは性能低下が単にノイズの量のせいやなくて、外部コンテキストが導入されるとモデルの推論モード自体が変わってまうってことを示唆してるねん。

ロスの分解:検索 vs 推論。統制された設定のおかげで、エンドツーエンドの劣化を2つの解釈可能なギャップに帰属させられるんや:文書から概念へのロス(「概念のみ」から「関連のみ」への性能低下)とノイズ誘発ロス(「関連のみ」から「フルセット」への低下)やな。最初のギャップは、証拠から必要な概念を回復して使うことの失敗を捉えてるねん—適切なパッセージを見つけること、関連する概念的内容を抽出すること、それを実行可能な推論ステップとして運用することが含まれてる。2番目のギャップは邪魔なものへのロバスト性を分離してるんや:必要な証拠が存在する場合に、モデルがトピック隣接ノイズを無視して正しい証拠条件付き推論軌道を維持できるかを測ってるねん。全体として、この分解はベンチマークが意図した(i) 証拠選択/ノイズ除去、(ii) 長いコンテキスト文書からの構造化概念抽出、(iii) 多段階推論における概念レベルの調整とスケジューリング、の分離と一致してるで。

統制要因分析。次に、異なる失敗モードを浮き彫りにするよう設計されたデータセット要因でインスタンスを層別化してるねん。

ノイズ文書。ノイズ文書の数が増えると、フルセットのパフォーマンスは緩やかやけど非線形に低下するんや。これは邪魔なものが単に信号を「薄める」んやなくて、初期段階の抽象化をリダイレクトして取り返しのつかない軌道ドリフトを引き起こす可能性があるって仮説と一致してるねん(図6に示してある通りや)。さらに、モデルが関連概念を検索できてるのに使えへん場合も比較してるで:よく見られるパターンは、モデルが表面的に関連する証拠を引用しながら汎用テンプレート解法を実行するってやつで、証拠は存在するけど推論の因果連鎖に統合されてへんってことを示してるんや。

必要概念数。必要な概念の数が増えると、「概念のみ」設定でも精度が下がるねん。これは必要な概念を全部与えてもエラーがなくならへんってことを示してて、モデルは依然として概念レベルのワーキングメモリ、依存関係追跡、複数の制約の調整に苦労してるんや。この効果は「概念のみ」と「フルセット」で増幅されて、概念抽出エラーと偽の概念注入が仮説空間をさらに広げて調整負担を増やしてまうねん。

推論の深さと答えのタイプ。推論の深さ(例:参照CoTのステップ数)と答えのタイプ(例:公式導出、数値、ブール値、結論スタイル)で問題をバケット分けしてるで。より深い推論は通常、「概念のみ」と文書ベース設定の間のギャップが大きくなって、多段階の接地と中間状態維持における複合的な失敗を反映してるんや。同時に、公式導出項目は明示的な概念から最も恩恵を受けてて、文書ベース設定は

---

## Page 9

[](/attach/325500d0629d756bef3669db4970a06ba8b6953c1be9cc8ae2650b0e6cba8543_p009.png)

### 和訳

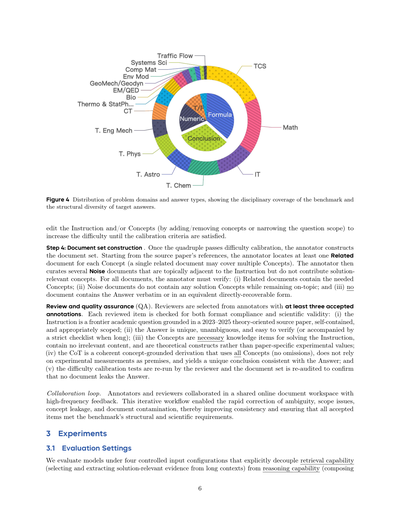

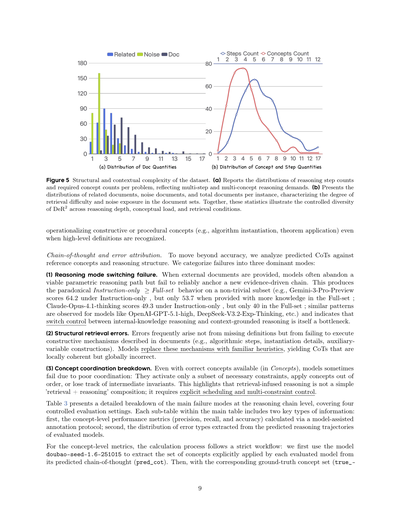

図5 データセットの構造的・文脈的な複雑さについてやで。(a)は問題ごとの推論ステップ数と必要な概念数の分布を示してて、要するに「何段階考えなアカンか」「いくつの知識を組み合わせなアカンか」っていう、マルチステップ・マルチコンセプト推論の難しさを表してるねん。(b)は各問題に対する関連文書、ノイズ文書(関係ない文書やな)、総文書数の分布を示してて、検索がどんだけ難しいか、どんだけノイズにさらされるかを表してるわけや。この統計データ全部合わせると、DeR2っていうデータセットが推論の深さ、概念の負荷、検索条件において、ちゃんとコントロールされた多様性を持ってることがわかるねん。

構成的・手続き的概念の運用化(アルゴリズムを実際に動かすとか、定理を適用するとかやな)は、高レベルの定義がわかっててもうまくいかへんことが多いねん。

**思考連鎖とエラーの原因分析**について。精度だけ見るんやなくて、予測された思考連鎖(CoT)を参照概念や推論構造と比較して分析したんや。ほんで失敗パターンを大きく3つに分類したで:

(1) **推論モード切り替えの失敗**。外部文書を渡すと、モデルはせっかくうまくいきそうやったパラメトリック推論(自分の知識だけで考えるやつ)を捨ててまうねん。でも新しいエビデンスベースの推論チェーンをちゃんと構築できへん。これが原因で「指示だけ」の条件が「フルセット」より良いっていう逆転現象が起きるねん。例えばGemini-3-Pro-Previewは指示だけやと64.2点やのに、知識いっぱい渡したフルセットやと53.7点に下がるねん。Claude-Opus-4.1-thinkingも指示だけで49.3点、フルセットで40点。OpenAI-GPT-5.1-high、DeepSeek-V3.2-Exp-Thinkingとかでも同じパターンが見られるわ。これが意味するんは、内部知識での推論と文脈に基づいた推論の切り替え制御自体がボトルネックになってるってことやねん。

(2) **構造的な検索エラー**。エラーは定義が見つからへんから起きるんやなくて、文書に書いてある構成的なメカニズム(アルゴリズムのステップとか、具体化の詳細とか、補助変数の構築とか)を実行できへんから起きることが多いねん。モデルはこれらのメカニズムを馴染みのあるヒューリスティック(経験則みたいなもんや)に置き換えてまうから、局所的には筋が通ってるけど全体としては間違ってる思考連鎖ができてまうねん。

(3) **概念の連携崩壊**。正しい概念が利用可能(Concepts条件)でも、連携がうまくいかへんで失敗することがあるねん。必要な制約の一部しか使わへんとか、概念を適用する順番がおかしいとか、中間的な不変条件を見失うとかや。これが示してるんは、検索を組み込んだ推論は単純な「検索+推論」の足し算やないってことやねん。明示的なスケジューリングと複数制約のコントロールが必要やねんな。

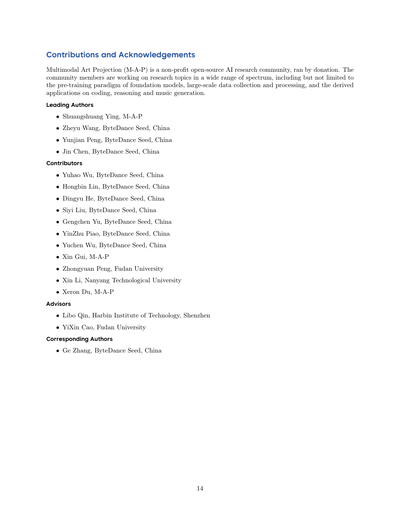

表3は推論チェーンレベルでの主要な失敗モードの詳細な内訳を示してて、4つの統制された評価設定をカバーしてるで。メインテーブル内の各サブテーブルには2種類の重要な情報が含まれてるねん:1つ目はモデル支援アノテーションプロトコルで計算した概念レベルの性能指標(適合率、再現率、精度)、2つ目は評価されたモデルの予測推論軌跡から抽出したエラータイプの分布や。

概念レベルの指標の計算プロセスは厳密なワークフローに従ってるで:まずdoubao-seed-1.6-251015っていうモデルを使って、評価対象モデルが予測した思考連鎖(pred_cot)から、そのモデルが明示的に適用した概念のセットを抽出するねん。ほんで、対応する正解概念セット(true_

(a) 文書数の分布 (b) 概念数とステップ数の分布

---

## Page 10

[](/attach/325500d0629d756bef3669db4970a06ba8b6953c1be9cc8ae2650b0e6cba8543_p010.png)

### 和訳

# モデル

| | 指示だけ | フルセット | 関連だけ | コンセプトだけ | RLoss |

|---|---|---|---|---|---|

| OpenAI-GPT-5.2-high | 65.8 | 71.1 | 71.4 | 83.8 | 12.7 |

| Gemini-3-Pro-Preview | 64.2 | 53.7 | 68.3 | 80.9 | 27.2 |

| Gemini-3-Flash-Preview | 60.5 | 66.0 | 64.8 | 78.3 | 12.3 |

| OpenAI-GPT-5.1-high | 59.8 | 57.0 | 66.9 | 81.4 | 24.4 |

| DeepSeek-V3.2-Exp-Thinking | 57.6 | 49.3 | 61.3 | 75.3 | 26.0 |

| Moonshot-kimi-k2-thinking | 55.9 | 52.7 | 65.0 | 74.4 | 21.7 |

| Gemini-2.5-Pro | 54.0 | 51.5 | 66.6 | 78.5 | 27.0 |

| GLM-4-6 | 53.9 | 43.2 | 57.7 | 70.8 | 27.6 |

| QwenAPI-3-max-0923 | 53.2 | 41.8 | 61.1 | 70.6 | 28.8 |

| Claude-Sonnet-4.5 | 53.2 | 45.2 | 59.1 | 74.1 | 28.9 |

| Doubao-1.8-1228-high | 52.3 | 52.0 | 64.8 | 74.3 | 22.3 |

| DeepSeek-V3.1-terminus-thinking | 52.2 | 50.2 | 62.1 | 69.8 | 19.6 |

| Doubao-1.6-1015-high | 50.6 | 43.3 | 59.4 | 70.8 | 27.5 |

| Claude-Opus-4.1-thinking | 49.3 | 40.0 | 52.0 | 72.4 | 32.4 |

| **平均スコア** | **55.9** | **51.2** | **62.9** | **75.4** | **24.2** |

**表2** 4つの統制された評価設定における回答レベルの正解率(%)。REスコア順にランキングしてるで。**太字**は各列で一番ええ成績、<u>下線</u>は2番目にええ成績を示してるねん。「指示だけ」はモデルが元から持ってる知識(パラメトリック知識っていうやつ)を反映してて、「コンセプトだけ」はコンセプトレベルの推論の経験的な上限みたいなもんやねん。「関連だけ」と「フルセット」は、弱い証拠とノイズの多い証拠の下での検索条件付き推論を評価してるわけや。

---

正解コンセプトを参照として使って、同じdoubao-seed-1.6-251015モデルに予測コンセプトと参照コンセプトを突き合わせさせて、真陽性(TP)、偽陽性(FP)、偽陰性(FN)の数を出力させんねん。精度と再現率は、これらのカウントに基づいて標準的な公式で計算して、コンセプト精度はデータセット全体でインスタンスごとのパフォーマンス結果を集約して導出するんや。

エラータイプの分布については、ターゲットを絞ったサンプリングと分析プロセスでデータを収集してんねん。評価した各モデルと4つの評価設定それぞれについて、モデルの最終回答が間違ってる50個のインスタンスを均等にサンプリングするんや(単純なコンセプト漏れ以外の失敗パターンに焦点を当てるためやで)。ほんで、doubao-seed-1.6-251015を構造化された評価者として使って、サンプリングした各インスタンスに4つの入力を与えるねん — 予測コンセプト(pred_concept)、予測された思考連鎖(pred_cot)、正解コンセプト(true_concept)、参照推論(true_cot)— そして失敗の根本原因を診断するようにプロンプトするんや。間違ったインスタンスそれぞれに、事前定義された4つのエラーカテゴリのうち1つ以上がラベル付けされるねん:(1) 推論プロセスエラー(推論の論理的な流れの欠陥)、(2) 数値または形式化エラー(計算や記号表現のミス)、(3) 核心コンセプトの欠落(正解に必要なキーコンセプトを含めてへん)、(4) 核心コンセプトの誤解または誤用(コンセプトを誤解してるか、不適切な文脈で適用してる)。エラー診断プロセス中にdoubao-seed-1.6-251015評価者をガイドするために使われた完全なプロンプトは、再現性のために付録Aに載せてあるで。

「指示だけ」では、エラーは主に核心コンセプトの欠落と一般的な推論ヒューリスティクスの問題として現れてて、これは純粋なパラメトリック知識の限界を反映してるねん。「コンセプトだけ」になると、全体的な精度がめっちゃ向上して、コンセプトに関連するエラーはほぼなくなるんや。残ってる失敗は主に手続き的なもんで、これは単に正しいコンセプトを検索するだけでは、複数ステップの推論を正しく実行できることを保証せえへんってことを示してるねん。

さらに観察されたんは、「フルセット」、「関連だけ」、「指示だけ」の設定では、核心コンセプトの欠落(MC)が最も頻繁なエラーやってことやねん。これは知識入力のスケーリング関係と一致してるんやけど、注目すべきは「指示だけ」と知識を提供する設定(「フルセット」と「関連だけ」)の間で、核心コンセプト欠落の数のギャップがそんなに大きくないってことやねん。全部だいたい40前後をウロウロしてて、これはモデルが正しい知識ポイントを検索する能力の限界を反映してるか、あるいはモデルが現在の質問に答えるためにどのコンセプトを抽出すべきかすら分かってへん場合があることを示してるんや。加えて、Gemini-3-Proは「関連だけ」設定で29個しかエラーを出さへんかったし、「指示だけ」で最高のパフォーマンスを発揮した(たった34個のミスやで)。これはGeminiがより多くの内在的な知識を持ってる可能性を示唆してて、限られた背景情報でも効果的にコンセプトを検索して理解できるってことやねん。

---

## Page 11

[](/attach/325500d0629d756bef3669db4970a06ba8b6953c1be9cc8ae2650b0e6cba8543_p011.png)

### 和訳

## 図6 ドキュメントの特徴がモデル性能に与える影響

(a) Full-set設定での、ノイズ文書の数とモデルスコアの関係やねん。(b) Full-set設定での、コンセプト数とモデルスコアの関係を示してるで。

Concepts-only(コンセプトだけ与える設定)やと、モデルは関連性の薄い証拠からコンセプトを復元せなあかんねん。ほんでコンセプトの見落としとか推論ミスがまた出てきてまうんや。これは単に定義がわからんっていう問題やなくて、構造的な検索(情報を体系的に見つけ出す能力)がうまいこといってへんってことを示してるねん。最後にFull-set設定やけど、検索がうまくいくケースもあるんやけど、トピックに関連したノイズ(余計な情報)があることで、推論エラーとかコンセプトのズレがめっちゃ悪化してまうんや。

全体的に見て、これらの表が示してるんは、検索で補強する設定(RAG)でパフォーマンスが落ちるんは、単にコンセプトが抜けてるからだけやないってことやねん。証拠を条件にした推論をするときの、手順的な処理と概念的な整合性を取るところで失敗してるっていうのも原因なんや。

さらに言うと、concepts-only設定では、モデルの精度(precision)と再現率(recall)の両方が1に達してへんねん。これ何を意味してるかっていうと、未知のコンセプトの使い方を説明してあげても、モデルはそのコンセプトをちゃんと理解できてへんってことやで。

## 4 関連研究

### 4.1 既存のベンチマーク

初期の読解ベンチマークであるSQuAD [25]とNatural Questions [16]は、短い文章から答えを抜き出す「抽出型質問応答」の評価方法を確立したんや。マルチホップ拡張版のHotpotQA [34]は、複数の文章から証拠を集めなあかんようにして推論の複雑さを上げたんやけど、答え自体は主に抽出型のままやったんや。最近のバリエーションではより抽象的な生成も取り入れてるけど、評価指標やタスク設計は依然として、本当の意味での複数文書の統合よりも、局所的な情報抽出を重視する傾向があるねん [15]。

検索拡張生成(RAG)のベンチマーク、KILT [23]やFreshQA [31]なんかは、大規模コーパスを使ったエンドツーエンドのRAGパイプラインを評価してるんや。検索と生成を組み合わせることでシステム全体の性能を測れるんやけど、この組み合わせのせいで複数の能力がごっちゃになってまうねん。ほんでエラーの原因特定が難しくなるんや:失敗が検索のギャップなんか、推論能力の不足なんか、証拠の統合の問題なんかわからんくなるってことやな。しかも、多くのタスクは事実の検索とか時間に関する事実の検証に重点置いてて、複数の文書から新しいコンセプトを統合する必要があるマルチステップの統合はあんまり重視されてへんねん。

一方で、数学的・形式的な推論ベンチマークは、文書理解とはほぼ切り離された形で演繹的能力を評価してるんや。GSM8K [5]、MATH [12]、Omni-MATH [10]、PutnamAXIOM [9]みたいなベンチマークは、複雑さを増しながらマルチステップの問題解決をテストしてるで。GPQA [26]みたいな大学院レベルのベンチマークとかBIG-Bench [27]みたいな幅広いスイートは難易度を上げてるけど、主にパラメトリック(モデルが学習時に覚えた知識に頼る形式)なままなんや:つまり、与えられた証拠から情報を統合するんやなくて、訓練時の知識に頼ってるってことやねん。

最後に、ロングコンテキスト評価(例えば最近のロングコンテキストモデルの研究 [29])は、長い文書を処理する能力が向上してることを示してるんやけど、ノイズの多い現実的なコーパスから証拠を抽出する必要があるときの統合能力を体系的に測定することはまだできてへんねん。文書レベルの推論に関する関連研究 [15, 35]は、この辺の限界を明らかにしてるで。

---

(a) ノイズ文書数とスコアの相関 (b) コンセプト数とスコアの相関

横軸:ノイズ文書の数 / コンセプトの数

縦軸:平均スコア

---

## Page 12

[](/attach/325500d0629d756bef3669db4970a06ba8b6953c1be9cc8ae2650b0e6cba8543_p012.png)

### 和訳

モデル

精度

再現率

スコア

エラータイプの分布

Full-set設定(全部入り設定)

Claude-Opus-4.1

DeepSeek-V3.1

Doubao-1.6-1015

Gemini-3-Pro

GPT-5.1

平均

0.242

0.323

0.270

0.333

0.318

0.297

Related-only設定(関連文書だけ設定)

Claude-Opus-4.1

DeepSeek-V3.1

Doubao-1.6-1015

Gemini-3-Pro

GPT-5.1

平均

0.241

0.308

0.276

0.349

0.329

0.301

Concepts-only設定(概念だけ設定)

Claude-Opus-4.1

DeepSeek-V3.1

Doubao-1.6-1015

Gemini-3-Pro

GPT-5.1

平均

0.718

0.695

0.724

0.740

0.754

0.766

Instruction-only設定(指示だけ設定)

Claude-Opus-4.1

DeepSeek-V3.1

Doubao-1.6-1015

Gemini-3-Pro

GPT-5.1

平均

0.246

0.301

0.293

0.341

0.300

0.296

0.224

0.283

0.237

0.315

0.330

0.278

0.212

0.270

0.247

0.332

0.339

0.280

0.651

0.650

0.648

0.730

0.754

0.686

0.236

0.260

0.267

0.336

0.297

0.279

40.0

50.2

43.3

53.7

57.0

48.8

52.0

62.1

59.4

68.3

66.9

61.7

72.4

69.8

70.8

80.9

81.4

75.0

MC:42 UC:7 R:35 NF:3

MC:42 UC:5 R:44 NF:2

MC:37 UC:10 R:43 NF:4

MC:41 UC:9 R:38 NF:8

MC:39 UC:4 R:41 NF:3

MC:40.2 UC:7 R:40.2 NF:4

MC:38 UC:7 R:38 NF:2

MC:37 UC:4 R:40 NF:2

MC:32 UC:6 R:37 NF:2

MC:29 UC:2 R:37 NF:3

MC:34 UC:1 R:33 NF:5

MC:34 UC:4 R:37 NF:2.8

MC:9 UC:5 R:11 NF:0

MC:13 UC:6 R:7 NF:2

MC:11 UC:5 R:10 NF:0

MC:7 UC:2 R:7 NF:0

MC:6 UC:0 R:7 NF:0

MC:9.2 UC:3.8 R:8.4 NF:0.4

49.3

52.2

50.6

64.2

59.8

55.2 MC:39.4 UC:2.6 R:38.8 NF:3.2

MC:42 UC:4 R:30 NF:3

MC:40 UC:4 R:43 NF:4

MC:39 UC:3 R:41 NF:4

MC:34 UC:0 R:42 NF:0

MC:42 UC:2 R:38 NF:5

表3 4つの評価設定でのCoTベースのエラー帰属分析やで。略語の説明しとくな:MC=核心概念の欠落、UC=核心概念の誤用・間違い、R=推論プロセスのエラー、NF=数値・形式化のエラーやねん。

今のQAベンチマーク、つまり質問応答の評価基準のことやけど、これらにはめっちゃ重要な限界があんねん。なんでかっていうと、複数の文書から情報をまとめる能力を、わざと邪魔になる情報(adversarial distractorsって言うねんけど)を入れた環境でちゃんと測れる仕組みがないんよな。

4.2 検索と推論を分離したベンチマーク

ワイらのベンチマークは、文書に基づいた科学的な情報統合において、検索と推論をきっちり分けて測れる管理された環境として設計されてんねん。具体的に言うとな、各問題は5つの要素(指示、概念、思考連鎖、答え、文書セット)で構成されてて、2段階の検証プロトコルがあんねん。どういうことかっていうと、指示だけやと問題は解けへんけど、正しい概念が与えられたら解けるようになる、っていう設計やねん。これによって、単にAIが元々持ってる知識(パラメトリックリコールって言うねんけど)に頼るんやなくて、新しい概念を統合して推論する科学的な能力をピンポイントで狙い撃ちできるわけや。

普通のRAG(検索拡張生成)ベンチマークって、検索と生成をごっちゃにして評価してまうやろ?せやけどワイらは、設計上これらの能力をちゃんと分離できる評価設定を導入してんねん。Instruction-onlyは元々持ってる知識だけを、Concepts-onlyは概念レベルの推論だけを、Related-onlyは弱い概念検索プラス推論を、そしてFull-setは邪魔な情報が混じった状態でのエビデンス選別とノイズ除去をストレステストすんねん。この構造のおかげで、性能が落ちた時にその原因を(i)エビデンスの選別とノイズ除去の問題、(ii)文書から概念を抽出する問題、(iii)概念レベルでの組み合わせとスケジューリングの問題、っていう風にちゃんと切り分けて特定できるわけやな。

最後にめっちゃ大事なポイントやねんけど、文書セットの中にわざと「トピック的には似てるけど概念的には関係ない」邪魔な文書を入れてんねん。これによって、敵対的なノイズっていうものを一級市民の変数として扱えるようにしてんのや。これが狙ってんのは、今までのベンチマークでは見逃されがちやった失敗パターンやねん。

12

---

## Page 13

[](/attach/325500d0629d756bef3669db4970a06ba8b6953c1be9cc8ae2650b0e6cba8543_p013.png)

### 和訳

これまでのベンチマークやと見落とされがちやった問題点がめっちゃ浮き彫りになってん。特にな、パラメトリック推論(モデルが自分の中に持ってる知識で考えるやつ)からエビデンスに基づいた推論(外部の証拠を使って考えるやつ)に切り替えるんがめっちゃ難しいってことと、証拠が多すぎると複数の概念をうまく組み合わせて考えるんが脆くなるってことがわかったんや。

5 結論

ワイらはDeR2っていう、検索と推論を分けて評価できるベンチマークを作ったで。検索を使った問題解決において、それぞれの要素がどう影響してるか調べられるようになってんねん。各問題は2段階の検証プロトコルで作られてて、関連文書とノイズになる文書(ディストラクター)がセットになってるから、性能が落ちる原因を安定して特定できるんや。具体的には、(i)証拠の選択とノイズ除去、(ii)文書から概念を抽出すること、(iii)概念レベルでの組み立てとスケジューリング、この3つのどこで躓いてるかがわかるようになってるで。

強力な商用モデルとオープンモデルを色々試した結果、一貫してけっこう深刻な失敗パターンが見つかったんや:(1)推論モードの切り替え失敗。なんとな、「指示だけ」の条件の方が「全文書あり」より良い結果になることがあんねん。つまり、文書を追加することで、もともとうまくいってたパラメトリック推論の道筋が壊れてまうってことや。(2)構造的(手続き的)な検索の失敗。定義は認識できるのに、それを実際に使って組み立てる仕組みがちゃんと動かへんねん。(3)「概念だけ」の条件が上限にならへん。これは複数の概念をうまく調整することと、長距離の依存関係を追跡することにボトルネックがあるってことを示してるわ。(4)ノイズの非線形効果。ノイズが初期の推論の構造を変えてまって、そこから軌道がズレて、もう元に戻されへん状態になるんや。

これらの結果からわかるんは、「深い研究」ができる能力っていうんは、エンドツーエンドのRAG(検索拡張生成)の精度をちょっと伸ばすだけでは全然足らんってことや。ほんまに頑健なシステムを作るには、エビデンスに基づくモードの制御を明示的にサポートせなあかんし、抽出した概念を実際に使える形で活用できなあかんし、ノイズだらけの文脈でも仮説をうまく管理できるようにせなあかんねん。ワイらはDeR2を公開するで。検索を使った推論においてモデルをちゃんと選んだり診断したりするのに使ってもらえるし、将来の学習や評価の具体的な目標にもなると思うわ。

---

## Page 14

[](/attach/325500d0629d756bef3669db4970a06ba8b6953c1be9cc8ae2650b0e6cba8543_p014.png)

### 和訳

**貢献と謝辞**

Multimodal Art Projection(M-A-P)っちゅうのは、非営利のオープンソースAI研究コミュニティやねん。寄付で運営されとるんやで。コミュニティのメンバーらは、めっちゃ幅広い分野で研究しとって、例えば基盤モデルの事前学習のやり方とか、大規模なデータの収集と処理とか、そっから派生したコーディングとか推論とか音楽生成のアプリケーションとか、ほんまに色々やっとるわけや。

**主著者**

• Shuangshuang Ying、M-A-P

• Zheyu Wang、ByteDance Seed、中国

• Yunjian Peng、ByteDance Seed、中国

• Jin Chen、ByteDance Seed、中国

**貢献者**

• Yuhao Wu、ByteDance Seed、中国

• Hongbin Lin、ByteDance Seed、中国

• Dingyu He、ByteDance Seed、中国

• Siyi Liu、ByteDance Seed、中国

• Gengchen Yu、ByteDance Seed、中国

• YinZhu Piao、ByteDance Seed、中国

• Yuchen Wu、ByteDance Seed、中国

• Xin Gui、M-A-P

• Zhongyuan Peng、復旦大学

• Xin Li、南洋理工大学

• Xeron Du、M-A-P

**アドバイザー**

• Libo Qin、ハルビン工業大学深セン校

• YiXin Cao、復旦大学

**責任著者**

• Ge Zhang、ByteDance Seed、中国

---

## Page 15

[](/attach/325500d0629d756bef3669db4970a06ba8b6953c1be9cc8ae2650b0e6cba8543_p015.png)

### 和訳

参考文献

[1] Zhipu AI. Glm-4.6: オープンな大規模言語モデルやで、2025年。URL https://huggingface.co/zai-org/GLM-4.6

Hugging Faceのモデルカードやねん。

[2] anthropic. claude-opus-4-1、2025年。URL https://www.anthropic.com/news/claude-opus-4-1

[3] anthropic. Claude 4.5 sonnet、2025年。URL https://www.anthropic.com/news/claude-sonnet-4-5

[4] ByteDance. Doubao大規模言語モデル、2024年。URL https://www.doubao.com/ アクセス日:2025年1月16日。

[5] Karl Cobbeら。算数の文章問題を解くための検証器をトレーニングする話やで、2021年。

これな、要するに「AIが算数の問題解いたとき、その答えが合ってるかどうかをチェックする別のAI」を作ろうっていう研究やねん。

[6] Gheorghe Comaniciら。Gemini 2.5:めっちゃ賢い推論能力と、いろんなデータ形式に対応できる力と、長い文章も読めて、次世代の自律エージェント機能まで持った最先端モデルやで。arXivプレプリント arXiv:2507.06261、2025年。

[7] DeepSeek-AI. Deepseek-v3.2:オープンな大規模言語モデルの限界を押し広げるで。arXivプレプリント arXiv:2512.02556、2024年。URL https://arxiv.org/abs/2512.02556

[8] Mohamed Amine Ferragら。LLMの推論から自律型AIエージェントへ:めっちゃ包括的なレビューやで、2025年。URL https://arxiv.org/abs/2504.19678

これな、要するに「考えるAI」から「自分で動くAI」への進化を全部まとめた総説論文やねん。

[9] Kai Fronsdal ら。Putnam-axiom:高度な数学的推論を測るための機能的かつ静的なベンチマークやで。NeurIPS 2024のMATH-AIワークショップ、2024年10月。URL https://openreview.net/pdf?id=YXnwlZe0yf 公開日:2024年10月9日、最終更新:2024年10月9日。

Putnamってな、アメリカの大学生向けのめっちゃ難しい数学コンテストやねんけど、それレベルの問題でAIをテストしようって話や。

[10] Bofei Gaoら。Omni-math:大規模言語モデル向けの世界レベルの数学オリンピック級ベンチマークやで。arXivプレプリント arXiv:2410.07985、2024年。

数オリレベルの問題でAIの実力を測ろうってことやな。

[11] Google DeepMind. Gemini 3 pro:先進的AIモデル。https://deepmind.google/models/gemini/pro/ 2025年11月リリース。

[12] Dan Hendrycksら。MATHデータセットで数学の問題解決能力を測定するで。arXivプレプリント arXiv:2103.03874、2021年。

これがな、AIの数学力を測る有名なベンチマークの論文やねん。

[13] Pengcheng Jiangら。s3:強化学習で検索エージェントをトレーニングするのに、そんなに大量のデータはいらんで、2025年。URL https://arxiv.org/abs/2505.14146

ほんまにこれ画期的でな、「少ないデータでも賢い検索AIが作れるで」って証明した研究やねん。

[14] Carlos E. Jimenezら。SWE-bench:言語モデルは実際のGitHubのイシュー(問題報告)を解決できるんか?、2024年。URL https://arxiv.org/abs/2310.06770

これな、実際のプログラミングの問題をAIに解かせてみようっていうベンチマークやで。

[15] Ehsan Kamalloo、Charles LA Clarke、Davood Rafiei。オープンドメイン質問応答ベンチマークの文書レベル推論における限界。SIGIR 2023の論文集、2123-2128ページ、2023年。

要するに「今ある質問応答のテストって、長い文章をちゃんと理解する力を測れてへんのちゃう?」って問題提起した研究やねん。

[16] Tom Kwiatkowskiら。Natural Questions:質問応答研究のためのベンチマークやで。Transactions of the Association for Computational Linguistics、7巻、453-466ページ、2019年。

Googleが作った、実際のユーザーが検索で聞いた質問を集めたデータセットやな。

[17] Kuan Liら。WebSailor:Webエージェントのための超人的推論をナビゲートするで、2025年。URL https://arxiv.org/abs/2507.02592

インターネット上を自由に動き回って情報集めるAIの研究やねん。

[18] Xiaoxi Liら。Search-o1:検索機能を強化したエージェント型大規模推論モデルやで、2025年。URL https://arxiv.org/abs/2501.05366

考える力と検索する力を合体させたAIの話やな。

[19] Xiaoxi Liら。WebThinker:大規模推論モデルに深い調査能力を与えるで、2025年。URL https://arxiv.org/abs/2504.21776

これめっちゃおもろくてな、AIが自分で調べ物して深く考えられるようになる研究やねん。

---

## Page 16

[](/attach/325500d0629d756bef3669db4970a06ba8b6953c1be9cc8ae2650b0e6cba8543_p016.png)

### 和訳

[20] Reiichiro Nakanoさんら。WebGPT:人間のフィードバック付きのブラウザ支援型質問応答システム、2022年。これな、めっちゃ画期的やねん。AIがブラウザ使ってネット検索しながら質問に答えるっていう仕組みで、しかも人間からの「これええで」「これあかんで」っていうフィードバックを学習に使ってるんよ。URL https://arxiv.org/abs/2112.09332.

[21] OpenAI。GPT-5.1の発表、2025年。ほんまについに来たって感じやな。URL https://openai.com/index/gpt-5-1/.

[22] Bhrij Patelさんら。AIME:複数のLLM評価者によるAIシステム最適化、2024年。なんでかっていうと、AI一個で評価するより複数のAIに評価させた方がええんちゃうかっていう発想やねん。めっちゃ賢い考え方やろ?URL https://arxiv.org/abs/2410.03131.

[23] Fabio Petroniさんら。KILT:知識集約型言語タスクのためのベンチマーク。2021年の北米計算言語学会議の論文集、2523-2544ページ。オンライン開催やったで。これ何かっていうと、AIがどんだけちゃんと知識を使ってタスクこなせるか測るための基準を作ったんよ。いろんな知識が必要なタスクをまとめて評価できるようにしたってわけや。URL https://aclanthology.org/2021.naacl-main.200/.

[24] Long Phanさんら。これめっちゃ著者多いで!ざっと見ても100人以上おるやん。Alice Gatti、Ziwen Han、Nathaniel Li、Josephina Hu、Hugh Zhang、Sean Shi、Michael Choi、Anish Agrawal、Arnav Chopra、Adam Khoja、Ryan Kim、Jason Hausenloy、Oliver Zhang、Mantas Mazeika、Daron Anderson、Tung Nguyen、Mobeen Mahmood、Fiona Feng、Steven Y. Feng、Haoran Zhao、Michael Yu、Varun Gangal、Chelsea Zou、Zihan Wang、Jessica P. Wang、Pawan Kumar、Oleksandr Pokutnyi、Robert Gerbicz、Serguei Popov、John-Clark Levin、Mstyslav Kazakov、Johannes Schmitt、Geoff Galgon、Alvaro Sanchez、Yongki Lee、Will Yeadon、Scott Sauers、Marc Roth、Chidozie Agu、Søren Riis、Fabian Giska、Saiteja Utpala、Zachary Giboney、Gashaw M. Goshu、Joan of Arc Xavier、Sarah-Jane Crowson、Mohinder Maheshbhai Naiya、Noah Burns、Lennart Finke、Zerui Cheng、Hyunwoo Park、Francesco Fournier-Facio、John Wydallis、Mark Nandor、Ankit Singh、Tim Gehrunger、Jiaqi Cai、Ben McCarty、Darling Duclosel、Jungbae Nam、Jennifer Zampese、Ryan G. Hoerr、Aras Bacho、Gautier Abou Loume、Abdallah Galal、Hangrui Cao、Alexis C Garretson、Damien Sileo、Qiuyu Ren、Doru Cojoc、Pavel Arkhipov、Usman Qazi、Lianghui Li、Sumeet Motwani、Christian Schroeder de Witt、Edwin Taylor、Johannes Veith、Eric Singer、Taylor D. Hartman、Paolo Rissone、Jaehyeok Jin、Jack Wei Lun Shi、Chris G. Willcocks、Joshua Robinson、Aleksandar Mikov、Ameya Prabhu、Longke Tang、Xavier Alapont、Justine Leon Uro、Kevin Zhou、Emily de Oliveira Santos、Andrey Pupasov Maksimov、Edward Vendrow、Kengo Zenitani、Julien Guillod、Yuqi Li、Joshua Vendrow、Vladyslav Kuchkin、Ng Ze-An、Pierre Marion、Denis Efremov、Jayson Lynch、Kaiqu Liang、Andrew Gritsevskiy、Dakotah Martinez、Ben Pageler、Nick Crispino、Dimitri Zvonkine、Natanael Wildner Fraga、Saeed Soori、Ori Press、Henry Tang、Julian Salazar、Sean R. Green、Lina Brüssel、Moon Twayana、Aymeric Dieuleveut、T. Ryan Rogers、Wenjin Zhang、Bikun Li、Jinzhou Yang、Arun Rao、Gabriel Loiseau、Mikhail Kalinin、Marco Lukas、Ciprian Manolescu、Subrata Mishra、Ariel Ghislain Kemogne Kamdoum、Tobias Kreiman、Tad Hogg、Alvin Jin、Carlo Bosio、Gongbo Sun、Brian P Coppola、Tim Tarver、Haline Heidinger、Rafael Sayous、Stefan Ivanov、Joseph M Cavanagh、Jiawei Shen、Joseph Marvin Imperial、Philippe Schwaller、Shaipranesh Senthilkuma、Andres M Bran、Ali Dehghan、Andres Algaba、Brecht Verbeken、David Noever、Ragavendran P V、Lisa Schut、Ilia Sucholutsky、Evgenii Zheltonozhskii、Derek Lim、Richard Stanley、Shankar Sivarajan、Tong Yang、John Maar、Julian Wykowski、Martí Oller、Jennifer Sandlin、Anmol Sahu、Yuzheng Hu、Sara Fish、Nasser Heydari、Archimedes Apronti、Kaivalya Rawal、Tobias Garcia Vilchis、Yuexuan Zu、Martin Lackner、James Koppel、Jeremy Nguyen、Daniil S. Antonenko、Steffi Chern、Bingchen Zhao、Pierrot Arsene、Alan Goldfarb、Sergey Ivanov、Rafał Poświata、Chenguang Wang、Daofeng Li、Donato Crisostomi、Andrea Achilleos、Benjamin Myklebust、Archan Sen、David Perrella、Nurdin Kaparov、Mark H Inlow、Allen Zang、Elliott Thornley、Daniil Orel、Vladislav Poritski、Shalev Ben-David、Zachary Berger、Parker Whitfill、Michael Foster、Daniel Munro、Linh Ho、Dan Bar Hava、Aleksey Kuchkin、Robert Lauff、David Holmes、Frank Sommerhage、Keith Schneider、Zakayo Kazibwe、Nate Stambaugh、Mukhwinder Singh、Ilias Magoulas、Don Clarke、Dae Hyun Kim、Felipe Meneguitti Dias、Veit Elser、Kanu Priya Agarwal、Victor Efren Guadarrama Vilchis、Immo Klose、Christoph Demian、Ujjwala Anantheswaran、Adam Zweiger、Guglielmo Albani、Jeffery Li、Nicolas Daans、Maksim Radionov、Václav Rozhoň、Ziqiao Ma、Christian Stump、Mohammed Berkani、Jacob Platnick、Volodymyr Nevirkovets、Luke Basler、Marco Piccardo、Ferenc Jeanplong、Niv Cohen、Josef Tkadlec、Paul Rosu、Piotr Padlewski、Stanislaw Barzowski、Kyle Montgomery、Aline Menezes、Arkil Patel、Zixuan Wang、Jamie Tucker-Foltz、Jack Stade、Tom Goertzen、Fereshteh Kazemi、Jeremiah Milbauer、John Arnold Ambay、Abhishek Shukla、Yan Carlos Leyva Labrador、Alan Givré、Hew Wolff、Vivien Rossbach、Muhammad Fayez Aziz、Younesse Kaddar、Yanxu Chen、Robin Zhang、Jiayi Pan、Antonio Terpin、Niklas Muennighoff、Hailey Schoelkopf、Eric Zheng、Avishy Carmi、Adam Jones、Jainam Shah、Ethan D. L. Brown、Kelin Zhu、Max Bartolo、Richard Wheeler、Andrew Ho、Shaul Barkan、Jiaqi Wang、Martin Stehberger、Egor Kretov、Kaustubh Sridhar、Zienab EL-Wasif、Anji Zhang、Daniel Pyda、Joanna Tam、David M. Cunningham、Vladimir Goryachev、Demosthenes Patramanis、Michael Krause、Andrew Redenti、Daniel Bugas...

16ページ目で途切れとるけど、ほんまにえげつない数の研究者が集まっとるで。世界中から参加しとるのがわかるやろ?

---

## Page 17

[](/attach/325500d0629d756bef3669db4970a06ba8b6953c1be9cc8ae2650b0e6cba8543_p017.png)

### 和訳

David Aldous、Jesyin Lai、Shannon Coleman、Mohsen Bahaloo、Jiangnan Xu、Sangwon Lee、Sandy Zhao、Ning Tang、Michael K. Cohen、Micah Carroll、Orr Paradise、Jan Hendrik Kirchner、Stefan Steinerberger、Maksym Ovchynnikov、Jason O. Matos、Adithya Shenoy、Benedito Alves de Oliveira Junior、Michael Wang、Yuzhou Nie、Paolo Giordano、Philipp Petersen、Anna Sztyber-Betley、Priti Shukla、Jonathan Crozier、Antonella Pinto、Shreyas Verma、Prashant Joshi、Zheng-Xin Yong、Allison Tee、Jérémy Andréoletti、Orion Weller、Raghav Singhal、Gang Zhang、Alexander Ivanov、Seri Khoury、Hamid Mostaghimi、Kunvar Thaman、Qijia Chen、Trần Quốc Khánh、Jacob Loader、Stefano Cavalleri、Hannah Szlyk、Zachary Brown、Jonathan Roberts、William Alley、Kunyang Sun、Ryan Stendall、Max Lamparth、Anka Reuel、Ting Wang、Hanmeng Xu、Sreenivas Goud Raparthi、Pablo Hernández-Cámara、Freddie Martin、Dmitry Malishev、Thomas Preu、Tomek Korbak、Marcus Abramovitch、Dominic Williamson、Ziye Chen、Biró Bálint、M Saiful Bari、Peyman Kassani、Zihao Wang、Behzad Ansarinejad、Laxman Prasad Goswami、Yewen Sun、Hossam Elgnainy、Daniel Tordera、George Balabanian、Earth Anderson、Lynna Kvistad、Alejandro José Moyano、Rajat Maheshwari、Ahmad Sakor、Murat Eron、Isaac C. McAlister、Javier Gimenez、Innocent Enyekwe、Andrew Favre D.O.、Shailesh Shah、Xiaoxiang Zhou、Firuz Kamalov、Ronald Clark、Sherwin Abdoli、Tim Santens、Khalida Meer、Harrison K Wang、Kalyan Ramakrishnan、Evan Chen、Alessandro Tomasiello、G. Bruno De Luca、Shi-Zhuo Looi、Vinh-Kha Le、Noam Kolt、Niels Mündler、Avi Semler、Emma Rodman、Jacob Drori、Carl J Fossum、Milind Jagota、Ronak Pradeep、Honglu Fan、Tej Shah、Jonathan Eicher、Michael Chen、Kushal Thaman、William Merrill、Carter Harris、Jason Gross、Ilya Gusev、Asankhaya Sharma、Shashank Agnihotri、Pavel Zhelnov、Siranut Usawasutsakorn、Mohammadreza Mofayezi、Sergei Bogdanov、Alexander Piperski、Marc Carauleanu、David K. Zhang、Dylan Ler、Roman Leventov、Ignat Soroko、Thorben Jansen、Pascal Lauer、Joshua Duersch、Vage Taamazyan、Wiktor Morak、Wenjie Ma、William Held、Trần Đức Huy、Ruicheng Xian、Armel Randy Zebaze、Mohanad Mohamed、Julian Noah Leser、Michelle X Yuan、Laila Yacar、Johannes Lengler、Hossein Shahrtash、Edson Oliveira、Joseph W. Jackson、Daniel Espinosa Gonzalez、Andy Zou、Muthu Chidambaram、Timothy Manik、Hector Haffenden、Dashiell Stander、Ali Dasouqi、Alexander Shen、Emilien Duc、Bita Golshani、David Stap、Mikalai Uzhou、Alina Borisovna Zhidkovskaya、Lukas Lewark、Mátyás Vincze、Dustin Wehr、Colin Tang、Zaki Hossain、Shaun Phillips、Jiang Muzhen、Fredrik Ekström、Angela Hammon、Oam Patel、Nicolas Remy、Faraz Farhidi、George Medley、Forough Mohammadzadeh、Madellene Peñaflor、Haile Kassahun、Alena Friedrich、Claire Sparrow、Taom Sakal、Omkar Dhamane、Ali Khajegili Mirabadi、Eric Hallman、Mike Battaglia、Mohammad Maghsoudimehrabani、Hieu Hoang、Alon Amit、Dave Hulbert、Roberto Pereira、Simon Weber、Stephen Mensah、Nathan Andre、Anton Peristyy、Chris Harjadi、Himanshu Gupta、Stephen Malina、Samuel Albanie、Will Cai、Mustafa Mehkary、Frank Reidegeld、Anna-Katharina Dick、Cary Friday、Jasdeep Sidhu、Wanyoung Kim、Mariana Costa、Hubeyb Gurdogan、Brian Weber、Harsh Kumar、Tong Jiang、Arunim Agarwal、Chiara Ceconello、Warren S. Vaz、Chao Zhuang、Haon Park、Andrew R. Tawfeek、Daattavya Aggarwal、Michael Kirchhof、Linjie Dai、Evan Kim、Johan Ferret、Yuzhou Wang、Minghao Yan、Krzysztof Burdzy、Lixin Zhang、Antonio Franca、Diana T. Pham、Kang Yong Loh、Joshua Robinson、Shreen Gul、Gunjan Chhablani、Zhehang Du、Adrian Cosma、Colin White、Robin Riblet、Prajvi Saxena、Jacob Votava、Vladimir Vinnikov、Ethan Delaney、Shiv Halasyamani、Syed M. Shahid、Jean-Christophe Mourrat、Lavr Vetoshkin、Renas Bacho、Vincent Ginis、Aleksandr Maksapetyan、Florencia de la Rosa、Xiuyu Li、Guillaume Malod、Leon Lang、Julien Laurendeau、Fatimah Adesanya、Julien Portier、Lawrence Hollom、Victor Souza、Yuchen Anna Zhou、Yiğit Yalın、Gbenga Daniel Obikoya、Luca Arnaboldi、Rai (Michael Pokorny)、Filippo Bigi、Kaniuar Bacho、Pierre Clavier、Gabriel Recchia、Mara Popescu、Nikita Shulga、Ngefor Mildred Tanwie、Thomas C.H. Lux、Ben Rank、Colin Ni、Alesia Yakimchyk、Huanxu (Quinn) Liu、Olle Häggström、Emil Verkama、Himanshu Narayan、Hans Gundlach、Leonor Brito-Santana、Brian Amaro、Vivek Vajipey、Rynaa Grover、Yiyang Fan、Gabriel Poesia Reis e Silva、Linwei Xin、Yosi Kratish、Jakub Łucki、Wen-Ding Li、Justin Xu、Kevin Joseph Scaria、Freddie Vargus、Farzad Habibi、Long (Tony) Lian、Emanuele Rodolà、Jules Robins、Vincent Cheng、Declan Grabb、Ida Bosio、Tony Fruhauff、Ido Akov、Eve J. Y. Lo、Hao Qi、Xi Jiang、Ben Segev、Jingxuan Fan、Sarah Martinson、Erik Y. Wang、Kaylie Hausknecht、Michael P. Brenner、Mao Mao、Yibo Jiang、Xinyu Zhang、David Avagian、Eshawn Jessica Scipio、Muhammad Rehan Siddiqi、Alon Ragoler、Justin Tan、Deepakkumar Patil、Rebeka Plecnik、Aaron Kirtland、Roselynn Grace Montecillo、Stephane Durand、Omer Faruk Bodur、Zahra Adoul、Mohamed Zekry、Guillaume Douville、Ali Karakoc、Tania C. B. Santos、Samir Shamseldeen、Loukmane Karim、Anna Liakhovitskaia、Nate Resman、Nicholas Farina、Juan Carlos Gonzalez、Gabe Maayan、Sarah Hoback、Rodrigo De Oliveira Pena、Glen Sherman、Hodjat Mariji、Rasoul Pouriamanesh、Wentao Wu、Gözdenur Demir、Sandra Mendoza、Ismail Alarab、Joshua Cole、Danyelle Ferreira、Bryan Johnson、Hsiaoyun Milliron、Mohammad Safdari、Liangti Dai、Siriphan Arthornthurasuk、Alexey Pronin、Jing Fan、Angel Ramirez-Trinidad、Ashley Cartwright、Daphiny Pottmaier、Omid Taheri、David Outevsky、Stanley Stepanic、Samuel Perry、Luke Askew、Raúl Adrián Huerta Rodríguez、Abdelkader Dendane、Sam Ali、Ricardo Lorena、Krishnamurthy Iyer、Sk Md Salauddin、Murat Islam、Juan Gonzalez、Josh Ducey、Russell Campbell、Maja Somrak、Vasilios Mavroudis、Eric Vergo、Juehang Qin、Benjámin Borbás、Eric Chu、Jack Lindsey、Anil Radhakrishnan、Antoine Jallon、I.M.J. McInnis、Alex Hoover、Sören Möller、Song Bian、John Lai、Tejal Patwardhan、Summer Yue、Alexandr Wang、そしてDan Hendrycks。人類最後の

17

---

## Page 18

[](/attach/325500d0629d756bef3669db4970a06ba8b6953c1be9cc8ae2650b0e6cba8543_p018.png)

### 和訳

試験問題集やねん。arXiv、2025年や。

[25] Pranav Rajpurkarさんら。Squad:テキスト読解のための10万問以上の質問集やで。これ、機械にちゃんと文章読めてるか確認するためのデータセットやねん。arXivプレプリント、arXiv:1606.05250、2016年。

[26] David Reinさんら。GPQA:大学院レベルのGoogle検索しても解けへん難問ベンチマークや。なんでかっていうと、ネットでカンニングしても答え見つからんように作ってあるねん。めっちゃムズいやつやで。arXivプレプリント、arXiv:2311.12022、2023年。

[27] Aarohi Srivastavaさんと、ほんまにめっちゃ大勢の研究者たち(et al.って書いてあるけど、実際100人以上おるで)。Beyond the Imitation Game:言語モデルの能力を数値化して、どこまでできるか見極めようって研究やねん。要するに「AIってほんまにどこまで賢いねん?」を調べた論文や。CoRR、abs/2206.04615、2022年。doi: 10.48550/arXiv.2206.04615。URLはhttps://doi.org/10.48550/arXiv.2206.04615やで。

[28] Hao Sunさんら。ZeroSearch:検索せんでもLLMに検索能力持たせる方法やねん。なんかズルいけどすごいな。2025年。URLはhttps://arxiv.org/abs/2505.04588や。

[29] Geminiチーム。Gemini 1.5:数百万トークンっていうめっちゃ長いコンテキストでもマルチモーダル(文章も画像もいける的な)理解ができるようになったで、って論文やねん。2024年。URLはhttps://arxiv.org/abs/2403.05530や。

[30] Kimiチームと、これまためっちゃ大勢の研究者たち(Yifan Baiさんからずらーっと名前並んでるで)。Kimi K2:オープンなエージェント型AIやねん。エージェントってのは、自分で考えて行動できるAIのことや。2025年。URLはhttps://arxiv.org/abs/2507.20534やで。

[31] Tu Vuさんら。FreshLLMs:検索エンジンと組み合わせて大規模言語モデルを新鮮な情報でアップデートする方法やねん。古い知識しかないAIに最新情報教えたろ、って話や。計算言語学会年次大会、2023年。URLはhttps://api.semanticscholar.org/CorpusID:263672149やで。

[32] Jason Weiさんら。BrowseComp:シンプルやけどめっちゃ難しいブラウジングエージェント向けベンチマークやねん。ネット検索してくるAIがほんまに賢いか試すやつや。2025年。URLはhttps://arxiv.org/abs/2504.12516やで。

[33] An Yangさんら。Qwen3技術レポートやで。Qwenってのは中国発のすごいAIモデルやねん。arXivプレプリント、arXiv:2505.09388、2025年。

[34] Zhilin Yangさんら。HotpotQA:多様で説明可能なマルチホップ質問応答のためのデータセットやねん。マルチホップってのは、一個の情報だけじゃなくて複数の情報を組み合わせて答えを導き出さなあかん問題のことや。Ellen Riloffさん、David

18

---

## Page 19

[](/attach/325500d0629d756bef3669db4970a06ba8b6953c1be9cc8ae2650b0e6cba8543_p019.png)

### 和訳

Chiang, Julia Hockenmaier, Jun'ichi Tsujii編、2018年自然言語処理における経験的手法に関する学会論文集、ベルギー・ブリュッセル、2018年10月31日〜11月4日、2369〜2380ページ。計算言語学会発行、2018年。doi: 10.18653/v1/d18-1259。URL https://doi.org/10.18653/v1/d18-1259。

[35] Yilun Zhao, Yitao Long, Hongjun Liu, Ryo Kamoi, Linyong Nan, Lyuhao Chen, Yixin Liu, Xiangru Tang, Rui Zhang, Arman Cohan。DocMath-Eval:長くて専門的な文書を理解する時のLLMの数学的推論能力を評価するやつやねん。めっちゃ長い文書とか専門的な内容を読んで、ちゃんと数学の問題解けるかどうかテストする評価基準を作ったってわけや。arXivプレプリント arXiv:2311.09805、2023年。

19

---

## Page 20

[](/attach/325500d0629d756bef3669db4970a06ba8b6953c1be9cc8ae2650b0e6cba8543_p020.png)

### 和訳

あ、これな、論文の付録に載ってるプロンプト集やねん!AIエージェントにどうやって指示出すかっていう、いわば「指示書のテンプレート」みたいなもんやな。

**「Related-only」と「Full-set」で答えを推論させるためのプロンプト**

「あんたは文献分析エージェントやで。」

問題:{{Instruction}}(←ここに実際の質問が入るねん)

情報源について:

- fetch_mdっていう組み込み関数を使って、{{local_dir}}の下にあるローカルのマークダウンファイルを一覧表示したり読んだりしてな。

- まず最初に、fetch_mdをinstance_id: "{{local_dir}}"で呼び出して、ファイル名は指定せんといて。そしたらファイルのリストが取れるから。

- その後、ファイル名を指定してfetch_md呼び出したら、選んだファイルの中身が読めるで。

ルール:

- ツール呼び出しのルール:1回のアシスタントのターンで、fetch_mdは最大1回だけな。1回のツール呼び出しで読めるドキュメントも1つだけ(ファイル名1個)やで。もっとドキュメント必要やったら、次のターンで続きを読んでな。

- 十分性のルール:答えが1つのドキュメントに全部載ってるとは限らへんねん。読んだ後で、今取ってきたドキュメントで正しい答え出せそうか判断してな。自信ないんやったら、最終回答出す前にもっとドキュメント読み続けてや。

- 最終回答の前に、段階的な推論プロセス(Reasoning)を出力してな。取ってきたドキュメントがどうやって各主張を裏付けてるか説明して、[file: xxx.md]みたいな引用も文中に入れてや。

- 当てずっぽうはあかんで。読んだ資料でちゃんと正当化できて、自信持てるようになってから最終回答出してな。

- めっちゃ大事:最後の行は絶対にこの形式にしてや:

Final answer: <あんたの最終回答>

---

**「Concepts-only」で答えを推論させるためのプロンプト**

「あんたは概念ベースの推論エージェントやで。」

問題:{{Instruction}}

概念:{{Concepts}}(←ここに関連する概念が入るねん)

出力の決まり:

- まず、正確にこのヘッダーで始まるセクションを出力してな:Reasoning:

各主張を裏付ける段階的な推論を書いてや。

- ほんで、最後の行に簡潔な結論をこの形式で書いてな:

Final answer: <あんたの最終回答>

---

## Page 21

[](/attach/325500d0629d756bef3669db4970a06ba8b6953c1be9cc8ae2650b0e6cba8543_p021.png)

### 和訳

よっしゃ、これ説明するわな!

---

**指示だけ与えられた問題で答えを推測するためのプロンプト**

あんた、めっちゃ難しい問題解くんが得意なエージェントやねん。

問題:{{Instruction}}

出力するときのルール:

• まず最初に、こういうヘッダーをそのまま書いてな:「Reasoning:」

ほんで、それぞれの主張を裏付けるために、ステップバイステップで考えた道筋を書くんやで。

• その後、最後の行にこのフォーマットでズバッと結論を書いてな:

Final answer: <あんたの最終的な答え>

---

**CoT(思考の連鎖)から概念を抽出するためのプロンプト**

# やることの手順

1. 概念の特定:モデルが出した思考の連鎖(CoT)をじっくり読んでな。モデルが推論の過程で「実際に使った」核心となる概念、定理、公式を全部、一個も漏らさんと見つけて抜き出すんや。

2. 使用概念リストを作る:抜き出したやつを「Used Concepts(使った概念)」としてリストにするんやで。

3. 比較と計算:使った概念リストを正解の概念リスト(Standard Concepts)と照らし合わせて、以下を判定するんや:

- True Positives(TP・真陽性):使った概念リストにあって、かつ正解リストにもあるやつ。(必要な概念をちゃんと使えてるってことやな)

- False Positives(FP・偽陽性):使った概念リストにはあるけど、正解リストにはないやつ。(間違って使ったか、関係ない概念を使ってもうたってことやな)

- False Negatives(FN・偽陰性):使った概念リストにはないけど、正解リストにはあるやつ。(必要やったのに見落としたか、使わんかった概念やな)

---

# 入力データ

1. モデルの思考の連鎖(CoT):モデルが生成したステップバイステップの推論やで。

2. 正解の概念リスト(Standard Concepts):正しい解答に「必要な」核心概念、定理、公式の権威あるリストやねん。

# 入力

[モデルの思考の連鎖(CoT)]

{{pred_cot}}

[正解の概念リスト(Standard Concepts)]

{{concepts}}

---

# 出力

以下の構造を持つJSONオブジェクトを出力してな。その後に最終的な計算結果も書いてや。

```json

{

"Used Concepts": [ "概念A", "概念B", ... ],

"True Positives (TP)": 数,

"False Positives (FP)": 数,

"False Negatives (FN)": 数

}

```

---

## Page 22

[](/attach/325500d0629d756bef3669db4970a06ba8b6953c1be9cc8ae2650b0e6cba8543_p022.png)

### 和訳

# タスク

モデルの全体的な推論プロセス(pred_cot)と使った概念(pred_concepts)を見て、正解の核心概念(true_concepts)と推論プロセス(true_cot)と照らし合わせて比較・マッチングして、モデルがなんでミスったんか原因を特定して、詳しく説明してな。

---

# めっちゃ大事なルール

エラータイプのラベル付けルール:マッチングの質がイマイチやったときは、エラーの原因は絶対に以下のラベルから選んでな(文字は完全一致させてや):

- Errors in reasoning process(推論プロセスのエラー)- Numerical or formal errors(数値とか形式のエラー)- Missing core concepts(核心概念の欠落)- Errors in understanding or using core concepts(核心概念の理解とか使い方のエラー)

複数のエラータイプが同時に起こってる場合は、最大2つまでラベルを組み合わせてええで、「/」で区切ってな。

具体的な根拠:

- pred_concepts / pred_cotの具体的にどこがアカンかったか、ちゃんと指摘してや - なんでtrue_conceptsと効果的にマッチできへんかったか、はっきり説明してな - ふわっとした言い方はあかんで;説明は検証可能なものにしてや

---

# 入力

true_concepts: {{true_concepts}}

true_cot:{{true_cot}}

pred_concepts: {{pred_concepts}}

pred_cot: {{pred_cot}}

---

# 出力

出力は以下のフォーマットの有効なJSONにしてな。余計なフィールドとか説明文は入れんといてや。

```json { "error reason": "error in reasoning process", "specific reason": "pred_conceptsの〇〇がこうで、pred_cotの推論プロセスは〇〇やから..." } ```

---

## Page 23

[](/attach/325500d0629d756bef3669db4970a06ba8b6953c1be9cc8ae2650b0e6cba8543_p023.png)

### 和訳

# LLM生成回答の採点用プロンプト

この評価は、以下のルーブリックにきっちり従わなあかんで。3つの観点で評価するねん:A) 事実と論理の正確さ、B) 完全性、C) 推論の質(思考連鎖に基づく)。

---

【ルーブリック:正確性スコア(0〜1)】

**1(めっちゃ優秀)**

A: 正確性:答えが完璧に正しくて、論理的にもカッチリしてて、正解の核心部分とバッチリ一致しとるねん。

B: 完全性:指示の全部の側面にちゃんと答えてて、正解に含まれる重要ポイントも全部カバーしとるで。

C: 推論:思考連鎖が明確で構造もしっかりしてて、必要な概念を正しく効果的に全部使えとるねん。

**0.75(ええ感じ)**

A: 正確性:ほぼ正解やけど、核心の結論には影響せえへん程度の軽い問題があるねん。

B: 完全性:メインの部分はカバーしとるけど、二次的な詳細が抜けとるかもしれへん。

C: 推論:だいたい正しくて理解できるけど、ステップ飛ばしてたり、ちょっと曖昧なとこがあるかもな。

**0.5(まあまあ)**

A: 正確性:核心のアイデアは掴めとるけど、目立つ事実の間違いとか論理的な欠陥があるねん。

B: 完全性:核心部分しかカバーしてなくて、重要なポイントが複数抜けとるで。

C: 推論:理解はできるけどゴチャゴチャしとるか、キーになる概念を十分に使えてへんねん。

**0.25(あかんやつ)**

A: 正確性:根本的に間違っとるか、おかしな論理に基づいとるねん。

B: 完全性:指示の要件からめっちゃ外れてて、有効な情報がほとんどあらへん。

C: 推論:深刻な論理的誤謬があるか、問題と全然関係あらへんねん。

**0.0(話にならへん)**

A: 正確性:完全に間違っとるか、的外れか、意味不明やねん。

B: 完全性:指示に全く答えてへんで。

C: 推論:推論がないか、完全に間違っとるねん。

---

【入力データ】

指示(解くべき問題):{{instruction}}

正解(ベンチマーク基準):{{true_answer}}

予測回答(評価対象のモデル出力):{{pred_answer}}

概念(知識ベース):{{concepts}}

思考連鎖(モデルの推論プロセス):{{pred_cot}}

---

【評価タスク】

予測回答と思考連鎖を、正解と指示に照らし合わせて分析してな。

提供されたルーブリックに基づいて、0から1の間のスコアを1つ付けてくれ。

最終スコアだけを、以下の形式そのまんまで出力してや:

score: <0から1の間の小数>

重要:最後の行は必ず「score: <0から1の間の小数>」やで、この行の後には何も書いたらあかんで。

---

## Page 24

[](/attach/325500d0629d756bef3669db4970a06ba8b6953c1be9cc8ae2650b0e6cba8543_p024.png)

### 和訳

B ケース分析

B.1 Claude-Opus-4.1のInstruction-onlyでのあかんかったケース

**指示** 多頭注意層Fを、{±1}^{k×d}から一様にランダムサンプリングしたラベル付き例から証明可能に学習するアルゴリズムの時間計算量を求めなあかんねん。この学習プロセスは、真の注意行列と射影行列{Θi, Wi}(i=1からm)が非縮退条件を満たすっていう仮定のもとで動かなあかんし、推定値{Ŵi, Θ̂i}(i=1からm)を出力して、その結果できる多頭注意層F̂が平均二乗誤差(kd)^{-Ω(m)}以下を達成して、成功確率が少なくとも1-δになるようにせなあかんねん。

**予測の思考過程:**

多頭注意層を学習する時間計算量を求めるには、いくつかの重要なポイントを分析せなあかんねん:

1. **問題の構造**:m個の注意ヘッドを学習するんやけど、各ヘッドには行列ΘiとWiがあるねん。入力空間は{±1}^{k×d}やから、可能な入力は(2)^{kd}通りもあるわけや。

2. **目標精度**:要求されるMSEの(kd)^{-Ω(m)}っていうのは、mに関して指数的にめっちゃ小さいねん。この超高精度の要求が計算量にごっつい影響を与えるんやで。

3. **サンプル計算量の分析**:

- MSEがε = (kd)^{-Ω(m)}を達成するには、標準的な学習理論やと集中不等式のためにO(1/ε²)個のサンプルが必要やねん

- これは(kd)^{Ω(m)}個のサンプルに相当するで

- 成功確率の要件1-δがlog(1/δ)の因子を追加するんや

4. **1サンプルあたりの計算コスト**:

- 各サンプルで多頭注意を計算するには:

- 注意スコアの計算:1ヘッドあたりO(k²d)

- 注意重みの適用:1ヘッドあたりO(k²d)

- m個全ヘッドの合計:O(mk²d)

5. **学習アルゴリズムの計算量**:

- ニューラルネットワークの証明可能な学習アルゴリズムは、よくモーメントベースかテンソル分解法を使うねん

- m個のヘッドを持つ多頭構造やと、これらの方法は典型的にO(m)次の統計量を計算する必要があるんや

- 計算コストは必要なモーメント/テンソルの次数に対して指数的にスケールするで

6. **総時間計算量**:

- サンプル数:(kd)^{Ω(m)}

- サンプル処理あたりのコスト:O(mk²d)

- 成功確率の因子:log(1/δ)

- 合わせると:(kd)^{O(m)} · log(1/δ)

支配的な項は(kd)^{O(m)}で、これは指数的に小さい誤差に必要なサンプル計算量と、多頭構造の証明可能な学習法の計算要件の両方から来てるねん。

**最終回答:** (kd)^{O(m)} · log(1/δ)

**正解の概念たち**

**概念1:** 射影行列の和Σ_i W_iの大雑把でノイジーな推定値は、入力系列Xと出力ラベルYの経験的相関を計算することで得られるねん。具体的には、E[(1/k)X^⊤JY] ≈ Σ_i W_iっていう近似を使うんや。ここでJは全部1の行列やで。

**概念2:** 注意行列のアフィン包を近似する凸体は、線形回帰を使って、全ヘッドで似たような注意パターンを引き起こす入力例Xを特定することで構築できるねん。これらの例を活用して、全ての注意行列Θ_1, ..., Θ_mが同時に満たすアフィン線形制約を形成するんや。

**概念3:** 射影行列の和の推定値は、「彫刻された」凸体の中の最小ノルム点を平均注意行列の代理として使うことで、めっちゃ精度よく改善できるねん。これにより、全ヘッドで大きなマージン(ほぼ1-スパース)の注意パターンを引き起こす例を特定できて、その結果、射影行列の和に対する超高精度な線形制約が得られるっちゅうわけや。

---

## Page 25

[](/attach/325500d0629d756bef3669db4970a06ba8b6953c1be9cc8ae2650b0e6cba8543_p025.png)

### 和訳

コンセプト4:凸体の削り出しプロセスってのは、射影行列の和の推定値をもっと精密にしたやつを使って、もう一回やり直せるねん。そしたら、新しい凸体K*ができるんやけど、これがめっちゃ精度高くて、真のアテンション行列のアフィン包にかなり近くなるってわけや。

コンセプト5:候補のアテンション行列を含むイプシロンネットってのを作るんやけど、これがポイントやねん。全部のd×d空間で作るんやなくて、真のアテンション行列{Θi}(iは1からm)の推定されたm次元の線形張空間の中だけで作るんや。この次元削減がめっちゃ重要でな、なんでかっていうと、次のブルートフォース(しらみつぶし)探索の探索空間が、d²の指数オーダーからmの指数オーダーにガクッと減るからやねん。

コンセプト6:最後はブルートフォース探索や。低次元のイプシロンネットから候補行列をm個選ぶ全ての組み合わせを調べて、それぞれに線形回帰を解くねん。で、最良モデルの最終選択は、別に取っておいた検証用データセットで確認するんや。標準的な汎化誤差の理論を使って、この選択が少なくとも1-δの確率で正しいって保証するわけやな。この検証ステップのおかげで、全体の実行時間に1/δの対数依存性が入ってくるねん。

---

**回答ステータス**

不正解

**エラーの原因** 特定の専門知識が足りんかったせいで、手法を勝手に作っちゃった(ハルシネーション)

**欠落・誤りのある内容** コアなアルゴリズムの仕組みが丸ごと抜けとるねん。「凸体(Convex Body)」「イプシロンネット(ε-net)」「線形張空間(Linear Span)」「ブルートフォース探索」みたいな重要ステップが全然触れられてへんかった。

**推論の誤り** 「標準的な学習理論」の集中不等式 O(1/ε²) を複雑性の根拠として間違って持ち出してもうた。あと、1サンプルあたりの計算コスト O(mk²d) を全体の時間計算量の倍数として使ってしもて、アルゴリズムの訓練・探索フェーズでかかる膨大なオーバーヘッドを無視してもうてるねん。

**コンセプト想起状態** 未取得・完全に欠落。コアなアルゴリズムのステップが一個も取れてへん。凸体の幾何学と部分空間の列挙に基づくアルゴリズムプロセスが丸ごと抜け落ちとる。

**推論状態** ロジックが完全にあさっての方向いってもうた。

**正しいロジック** 時間計算量は構成的アルゴリズムに基づいて計算せなあかんねん。ブルートフォース探索ステップ(m次元部分空間でm個の行列を探す)が計算量を支配してて、被覆数の計算か組み合わせ探索から O(m³) の指数項が出てくるんや。

**モデルのロジック** 「統計的学習理論」のテンプレートを使ってしもて、間違って「サンプル複雑性 × 単一順伝播の計算コスト」に単純化してもうた。モーメント推定やテンソル分解で解けると思い込んで、サンプルサイズ (kd)^Ω(m) が支配項やと考えて、アルゴリズムの探索空間の複雑性を無視してもうたんやな。

---

**B.2 DeepSeek-V3.1のコンセプトのみ条件での失敗例**

**指示** A型の証明可能シューベルト計算のリフテッド定式化を使って、S₄の特定ケース(置換 u = 2143、v = 3124、w = 4132)でシューベルト係数が非ゼロかどうかをテストするのに必要な、システム SA(u, v, w◦w) の双線形方程式の総数を求めてや。ここでシューベルト係数っていうのは、シューベルト多項式の環における構造定数のことやで。リフテッド定式化っていうのは、シューベルト多様体の交叉という幾何学的問題の解に対応する解を持つ多項式方程式系を作る方法のことやねん。

**予測されたCoT推論:**

- A型の証明可能シューベルト計算のリフテッド定式化は、双線形方程式系 SA(u, v, w◦w) を作ることを含んでて、その解がシューベルト多様体の交叉に対応するねん。

---

## Page 26

[](/attach/325500d0629d756bef3669db4970a06ba8b6953c1be9cc8ae2650b0e6cba8543_p026.png)

### 和訳

この連立方程式に出てくる双線形方程式の総数は、関係する各順列(u、v、w◦w)の降下の数を全部足したもんで決まるねん。

順列でいう降下集合Des(w)っていうのは、w(i)がw(i+1)より大きくなるような添え字iの集まりのことやねん。ほな降下集合を計算してみよか:

- u = 2143の場合:Des(u) = {1, 3}やから、|Des(u)| = 2やな。

- v = 3124の場合:Des(v) = {1}やから、|Des(v)| = 1やな。

- w◦wについては、まずS4のw◦を計算するねん:w◦ = 4321や。ほんでw◦w = w◦(w(i))で、w = 4132やから、w◦w = 1423になるねん。Des(w◦w) = {2}やから、|Des(w◦w)| = 1やな。

双線形方程式の総数 = |Des(u)| + |Des(v)| + |Des(w◦w)| = 2 + 1 + 1 = 4

最終回答:4

---

「シューベルト係数の幾何学的解釈」によると、係数c^w_{u,v}は...

**正しい概念たち**

**概念1**:シューベルト係数c^w_{u,v}は非負整数やねん。これはシューベルト多項式の掛け算の構造定数として定義されてて、シューベルト多項式は多項式環Z[x1, x2, ...]の線形基底を作るんや。

**概念2**:シューベルト係数の幾何学的解釈っていうのは、一般的な位置に平行移動させた3つのシューベルト多様体の交わりの中の点の数を数えるってことやねん。式で書くと c^w_{u,v} = #{Xu(E•) ∩ Xv(F•) ∩ Xw◦w(G•)} みたいな感じや。

**概念3**:シューベルト多様体Xwっていうのは、シューベルトセルΩwのザリスキ閉包のことやねん。シューベルト係数を求める問題は、これらの多様体の交わりに属するかどうかを定義する連立方程式の解の数を求めることと同じなんや。

**概念4**:スティーフェル座標っていうのは、シューベルトセルΩ^A_wの中のフラッグをパラメータ化するのに使う変数の集まりやねん。この変数らは行列χ^A_wの成分を作ってて、多項式系を構成する上でめっちゃ中心的な役割を果たすんや。

**概念5**:持ち上げ定式化っていうのは、補助変数(例えばα、βとか)を導入することで、シューベルトセルに属するかどうかを双線形方程式の系で特徴づける方法やねん。これを使うと、次数の高い行列式方程式を使わんで済むんや。

**概念6**:最大降下(d := max(Des(u) ∪ Des(v) ∪ Des(w))で表される)は、スティーフェル座標行列から考慮すべき列ベクトルの数を決めて、連立方程式の添え字の範囲を設定するんや。

**定理1**:「シューベルトセル帰属の特徴づけ」によると、フラッグΦ•がシューベルトセルΩ^A_w(E•)に属するのは、各k ∈ [d]に対して、フラッグの基底ベクトルの特定の線形結合が順列wで定義される特定の部分空間に入る(つまりgk ∈ Ew_{k-1} − Ew_k)ような一意的な係数が存在するとき、かつそのときに限るねん。この定理があるおかげで、幾何的な包含問題を代数方程式に変換する直接的なルールが得られるんや。

---

**回答の状態**

不正解(予測値:4、正解値:7)

**誤りの原因**:核心的な概念の欠如による幻覚的推論やな。モデルは「持ち上げ定式化」の具体的な構成についての知識が足りんかったから、間違ったヒューリスティックなルール(方程式の数 = 降下集合の要素数の合計)をでっち上げてしもたんや。

**欠落・誤りのある内容**:構成的な詳細の省略やな。d(最大降下)を使ってスティーフェル行列の列の範囲を決めること、補助変数の導入(高次の行列式を避けるため)、定理1における線形結合係数の一意性制約について言及してへんかったんや。

**誤り**:間違った公式 ∥Des(u)∥ + ∥Des(v)∥ + ∥Des(w◦w)∥(代数的・幾何的構造の誤った単純化やな)。

---

## Page 27

[](/attach/325500d0629d756bef3669db4970a06ba8b6953c1be9cc8ae2650b0e6cba8543_p027.png)

### 和訳

**概念の思い出しステータス** 部分的にしか取り出せてへんかったわ。「持ち上げ定式化」と「シューベルト多様体」は一応触れてんねんけど、めっちゃ大事なとこが抜けとるねん:

概念4(スティーフェル座標行列 χA_w の定義)、

概念6(最大降下 d の定義)、

定理1(シューベルト胞体への所属性を代数的に変換する定理)

**推論の状態** ロジックがぶっ壊れとる(前提からしてミスっとる)。どこでおかしなったかっていうと、最初のステップと2番目のステップの間やねん。モデルが「方程式の総数は降下集合のサイズを足したら決まる」っていうでたらめな公式を勝手に作り出してしもうたんや。本来は持ち上げ定式化(スティーフェル座標の次元とか、補助変数の導入とか、ランク制約とか)にちゃんと基づいて導出せなあかんのに、代数幾何学的な導出を単純な足し算に置き換えてしまっとるわけや。

**B.3 Gemini-3-Proのフルセットにおけるダメな例**

**問題** バンブルビー理論において、外部結合した物質場 LM が存在して、B場が (0, b(r), 0, 0) で、静的球対称座標系 ds² = −A(r)dt² + S(r)dr² + r²dΩ² のもとでは、ブラックホール解 A(r) はどないなるん?

**モデルの思考過程(予測)** この問題は、外部結合した物質場と動径方向のバンブルビー場 Bμ = (0, b(r), 0, 0) があるバンブルビー理論で、ブラックホール解の成分 A(r) を求めろっていう話やな。

**「バンブルビー重力モデルにおける厳密なシュワルツシルト様解」**(Casanaらの研究に対応するやつ)っていうファイルによると、この解は球対称な真空解やねん(ポテンシャル V がバンブルビー場を真空期待値に留めとくやつな)。

セクションIIIの詳しい導出は取り出したテキストでは途中で切れとったけど、セクションIV.C(「光の時間遅延」)でメトリックの形がわかるんや。式(75)で、時空のヌル測地線条件 ds² = 0 が(本文では式36として)こう書かれとる:

−(1 − 2M/r)dt² + (1 + ℓ)(1 − 2M/r)⁻¹dr² + r²dφ² = 0

これを静的球対称メトリック ds² = −A(r)dt² + S(r)dr² + r²dΩ² と比べたら、メトリック係数が特定できるわけや:

A(r) = 1 − 2M/r, S(r) = (1 + ℓ)/(1 − 2M/r)

ここで ℓ = ξb² がローレンツ破れパラメータやねん。非最小結合 ξ と真空期待値 b² から出てくるやつな。

時間成分 A(r) は形式的にはシュワルツシルト解とまったく同じなんやけど、動径成分 S(r) の方はパラメータ ℓ で修正されとるんや。

**推論:**

関連文書 [ファイル: バンブルビー重力モデルにおける厳密なシュワルツシルト様解.md] では、動径方向のバックグラウンド場があるバンブルビー重力における球対称解を議論しとる。テキストでは式(75)のヌル測地線の線素を明示的に書いとって、dt² の係数が −(1 − 2M/r) で、dr² の係数には (1 + ℓ) が入っとる。これが意味するんは、メトリックポテンシャル A(r)(−gtt に対応するやつやな)は 1 − 2M/r やってことや。この結果は、Casanaら(2018)の既知の解と一致しとる。動径方向のバンブルビー場がメトリックの grr 成分だけを修正するやつやな(gθθ の有効ポテンシャルも文脈によっては影響受けるけど、ここでは A(r) が焦点やからな)。

**最終回答:A(r) = 1 − 2M/r**

---

## Page 28

[](/attach/325500d0629d756bef3669db4970a06ba8b6953c1be9cc8ae2650b0e6cba8543_p028.png)

### 和訳

[翻訳エラー: ]

---

![]()

1 / 1