<<

2308.03279v2.pdf

---

## Page 1

[](/attach/2868ef9ba3f0132a2eaf2b47cdebe7580755dbcb03dda1f06a022baf3a959a04_p001.png)

### 和訳

UniversalNER:でっかい言語モデルから「ええとこ取り」して、なんでも固有表現認識できるようにしたで

Wenxuan Zhou、Sheng Zhang、Yu Gu、Muhao Chen、Hoifung Poon

南カリフォルニア大学、Microsoft Research、カリフォルニア大学デービス校

---

**要旨**

でっかい言語モデル(LLMっていうやつな)って、めっちゃ賢くて、どんなエンティティとか関係性でも理解できるぐらいすごい汎用性持ってるねん。ほんで「指示チューニング」っていう手法を使ったら、LLMの知識をAlpacaとかVicunaみたいなコスパのええ小さいモデルに移せるってわかってん。でもな、こういう弟子モデルって、実際のタスクで使うと元のLLMにはまだまだ全然かなわへんのよ。

ほなこの論文では何したかっていうとな、**「目的特化型の蒸留」**っていうアプローチを試してん。つまり、特定のミッションに絞った指示チューニングで弟子モデルを鍛えて、オープン情報抽出みたいな幅広い応用分野でバリバリ活躍できるようにしたってわけや。固有表現認識(NER)をケーススタディにして、ChatGPTからもっとちっちゃい**UniversalNER**モデルに知識を蒸留する方法を見せたるで。

評価用にな、今までで最大のNERベンチマーク作ってん。バイオ医療、プログラミング、SNS、法律、金融とか**9つの分野にまたがる43個ものデータセット**や。直接の教師データなしで、UniversalNERは何万種類ものエンティティタイプに対してめっちゃ高い精度を叩き出してん。AlpacaとかVicunaみたいな汎用の指示チューニングモデルと比べたら、**平均F1スコアで30ポイント以上**ぶっちぎりで勝ってるねん。パラメータ数はほんの一部なのに、UniversalNERはChatGPTのどんなエンティティでも認識できる能力をしっかり受け継いで、しかもNER精度では**平均F1で7〜9ポイントもChatGPTを上回ってる**んやで。もっとすごいんは、教師ありNERデータを使ってるInstructUIEみたいな最先端のマルチタスク指示チューニングシステムにも大差で勝ってるっちゅうことや。蒸留のいろんな要素がどう効いてるかのアブレーション実験もがっつりやったで。蒸留のレシピ、データ、UniversalNERモデルは公開してるから、今後の研究に使ってや。

---

**1 はじめに**

ChatGPTみたいなでっかい言語モデル(LLM)ってな、めっちゃ賢くていろんなことできるんやけど、学習にも推論にもエグいコストかかるねん。しかもな、バイオ医療みたいな「ミスったらシャレにならん」分野では、モデルの中身が見えて、推論の確率もわかる「ホワイトボックス」なアクセスが、説明責任とか信頼性の面でめっちゃ大事やねん。そやから、指示チューニングでLLMの知識をもっとコスパ良くて中身の見えるモデルに移す、いわゆる「蒸留」がめっちゃ流行ってるわけや。AlpacaとかVicunaみたいな弟子モデルは、ChatGPTをそこそこ真似できるようにはなってん。でもな、よーく見たら、特に狙ったタスクでは元のLLMにまだまだ大きく負けてるねん(Gudibandeらの研究でも指摘されてるわ)。限られた計算資源の中で、全方位的にLLMをコピーしようとしたら、どうしても浅いモノマネにしかならへんのは当たり前やわな。

ほんで、この論文ではアプローチを変えてん。オープン情報抽出みたいな幅広い応用分野に**目的を絞った蒸留**をやるねん。ミッションに特化した指示チューニングで弟子モデルを鍛えることで、その分野でのLLMの能力を最大限に再現できるっちゅうことを示したるで。

---

## Page 2

[](/attach/2868ef9ba3f0132a2eaf2b47cdebe7580755dbcb03dda1f06a022baf3a959a04_p002.png)

### 和訳

ICLR 2024の学会論文として発表されてんで

クラス(カテゴリ)についてめっちゃ深く学習しつつも、いろんな意味のタイプやドメイン(分野)にも広く対応できる汎用性はちゃんとキープするっちゅう話やねん。今回のケーススタディには固有表現認識(NER)を選んでん。なんでかっていうと、これが自然言語処理の中でもほんまに基本中の基本のタスクやからや(Wu et al., 2017; Perera et al., 2020)。最近の研究(Wei et al., 2023; Li et al., 2023)によると、あるエンティティタイプ(つまり「人名」とか「地名」みたいな固有表現の種類のことやな)についてアノテーション済みのデータ(人間がラベル付けしたお手本データ)がめっちゃたくさんある場合は、大規模言語モデル(LLM)はまだ最先端の教師あり学習システムに負けてまうねん。せやけどな、大多数のエンティティタイプについては、ラベル付きデータなんてほとんどあらへんのが現実やねん。新しいエンティティタイプは次から次へと出てくるし、アノテーション済みデータを作るんはめっちゃお金も時間もかかるんや。特にバイオメディシン(生物医学)みたいな高度な専門知識が必要な分野やと、もうほんまに大変やで。あらかじめ決められたエンティティタイプとドメインで学習された教師ありNERモデルは、新しいドメインやエンティティタイプへの汎用性がどうしても限られてまうんや。

そこでワイらは、LLMからのターゲット蒸留(特定のタスクに絞って知識を抽出すること)の一般的なレシピを提案して、オープンドメインNERでそれを実証したんや。ChatGPTを使って、幅広くカバーしたラベルなしのウェブテキストからNER用のインストラクションチューニングデータ(指示に従って学習するためのデータ)を生成して、LLaMA(Touvron et al., 2023a)にインストラクションチューニングを施すことで、UniversalNERモデル(略してUniNER)を蒸留したんやで。

しっかり評価するために、これまでで最大かつ最も多様なNERベンチマーク(UniversalNERベンチマーク)を組み立てたで。生物医学、プログラミング、ソーシャルメディア、法律、金融とか9つのドメインにまたがる43個のデータセットで構成されてんねん。ゼロショットNER(事前にそのタスクの例を見せずにいきなりやらせるやつ)では、LLaMAとAlpacaはこのベンチマークでめっちゃ成績悪かってん(F1スコアがほぼゼロに近いレベル)。Vicunaはそれに比べたらだいぶマシやったけど、それでもChatGPTに平均F1で20ポイント以上差をつけられてたんや。ところがやで、UniversalNERはUniversalNERベンチマークの何万種類もあるエンティティタイプ全体で最先端のNER精度を叩き出して、Vicunaを平均F1で30ポイント以上も上回ったんや。パラメータ数はごくわずかやのに、UniversalNERはChatGPTの任意のエンティティタイプを認識する能力を再現するだけやなくて、NER精度で平均F1を7〜9ポイントも上回ったんやで。さらにすごいことに、UniversalNERは教師ありNERの例を使っているInstructUIE(Wang et al., 2023a)みたいな最先端のマルチタスクインストラクションチューニングシステムすら大差で超えてもうたんや。あと、蒸留の各要素(インストラクションのプロンプトやネガティブサンプリングとか)がどれくらい影響するんかも、徹底的なアブレーション研究(要素を一つずつ外して効果を検証するやつ)で評価してるで。

## 2 関連研究

**知識蒸留。** ChatGPTみたいなLLMはええ結果出すんやけど、こういうモデルはブラックボックス(中身が見えへん)やし、計算コストもめっちゃ高いんよな。この問題に対処するために、LLMのタスク処理能力をもっと小さくて扱いやすいモデルに蒸留するっちゅうアプローチが有望な方向性として出てきたんや。知識蒸留(Hinton et al., 2015)は基本的に、デカくて複雑なモデルの知識を小さいモデルに移すっちゅう話やねん。最近の研究(Taori et al., 2023; Chiang et al., 2023; Peng et al., 2023)は、LLMの汎用的な能力を蒸留して、元のLLMの性能に匹敵する、あわよくば超えることを目指してるんや。特にAlpaca(Taori et al., 2023)は、インストラクション(指示)の生成を自動化して(Wang et al., 2023c)、教師役のLLMから知識を蒸留してんねん。Vicuna(Chiang et al., 2023)はShareGPTのデータを使ってて、これはユーザーがChatGPTと実際に会話したリアルなデータやから、蒸留にとってもっと本物っぽい文脈を提供してくれるんやで。もう一つの研究の流れ(Smith et al., 2022; Jung et al., 2023; Hsieh et al., 2023; Gu et al., 2023)は、LLMからタスクレベルの能力を蒸留することに注力してるんや。特にJung et al.(2023)は、GPT-3よりも桁違いに小さいモデルを蒸留して、特定のドメインでの要約やパラフレーズ(言い換え)のタスクでGPT-3を上回る効率的な方法を提案してんねん。Hsieh et al.(2022)は、Chain-of-Thought(思考の連鎖)蒸留っちゅう方法で、LLMの推論能力を小さいモデルに蒸留することを提案してるんや。せやけどな、これらの研究は特定のデータセットやドメインでしか蒸留やってへんねん。ワイらの研究はもっと一般的な定式化に焦点を当てて、いろんなドメインに適用できるようにしてるところがちゃうんやで。

**インストラクションチューニング。** 言語モデルをいろんなタスクに対応させる効果的な方法として、インストラクションチューニングにはコミュニティからめっちゃ注目が集まってんねん。FLAN(Chung et al., 2022)、T0(Sanh et al., 2021)、Tk-Instruct(Wang et al., 2022)は、既存の大量の教師あり学習データセットをインストラクション(指示に従う)形式に変換して、エンコーダ・デコーダモデルをファインチューニングすることで、NLPベンチマークでのゼロショットとフューショット性能がめっちゃ高いことを示したんや。Ouyang et al.(2022)はクラウドソーシングで高品質なインストラクションデータを集めて、GPT-3をInstructGPTにファインチューニングして、ユーザーの意図を理解して指示に従う能力を強化してんねん。最近の進歩(Taori et al., 2023; Chiang et al., 2023; Peng et al., 2023)によって、ChatGPTやGPT-4みたいなLLMが生成したインストラクションデータでファインチューニングすることで、タスクに従う能力を持つもっと小さいモデルも登場してきてんねん。せやけど、こういう小さいモデルは

---

## Page 3

[](/attach/2868ef9ba3f0132a2eaf2b47cdebe7580755dbcb03dda1f06a022baf3a959a04_p003.png)

### 和訳

ICLR 2024の学会論文として発表

モデルってな、いろんなタスクに対して質の高い回答を出すのがほんまに苦手やねん(Wang et al., 2023b)。ちゃんとベンチマークで調べてみたら、こういうモデルとChatGPTの間にはめっちゃデカい差があることがバレてもうてんねん(Gudibande et al., 2023)。ほんで、ワイらが提案する方法はな、逆の発想で、特定の種類のタスクをめっちゃ得意になるようにモデルをチューニングするっちゅうアプローチやねん。ワイらの指示チューニングにおける「多様性」っちゅうのは、指示文そのものの多様性やなくて、タスクのラベル(例えば関係抽出やったら関係タイプ、固有表現認識やったらエンティティタイプ)の多様性から来てるんや。タスクレベルの能力に特化して、固有表現認識(NER)をケーススタディにすることで、ChatGPTとの性能差を埋めるどころか追い越すチューニングレシピが作れるってことを示したんや。Wang et al.(2023a)も情報抽出タスク向けの指示チューニングを研究してるんやけど、あっちは教師ありデータセットだけに頼ってて、ChatGPTと比べるとイマイチな性能やねん。

# 3 ミッション特化型の指示チューニング

指示チューニング(Ouyang et al., 2022; Wei et al., 2021)っちゅうのはな、事前学習済みの自己回帰型言語モデルを、自然言語の指示に従って回答を生成できるようにファインチューニングする手法やねん。今までの研究は、いろんなタスクをこなせるようにモデルをチューニングすることに力を入れてきたんや(Taori et al., 2023; Chiang et al., 2023)。それに対してワイらはな、「ミッション特化型指示チューニング」っちゅう汎用的なレシピを提案するで。これはな、事前学習モデルをオープン情報抽出みたいな幅広いアプリケーションのカテゴリに特化してチューニングするっちゅうもんや。

この論文ではな、NERタスクをケーススタディとして取り上げてるで。なんでかっていうと、テキストから知識を抽出する上でめっちゃ基本的なタスクやからや。目標はな、モデル f : (X × T) → Y を学習することやねん。ここでXは入力の集合、Tはあらかじめ決められたエンティティタイプの集合、Yは与えられた入力の中で特定のタイプに該当するエンティティの集合を表してるで。

## 3.1 データの作り方

典型的な指示チューニングの例ってのは、「指示」「入力」「出力」の3つのパーツでできてるねん。ほんで、指示の多様性があることで、モデルがいろんなタスクの指示に対応できるようになるわけや。せやけどな、ミッション特化型の指示チューニングでは、狙ったアプリケーションカテゴリの中で、意味的なタイプやドメインをめっちゃ幅広くカバーできるようにモデルを汎化させるのが目標やねん。やから、指示の多様性やなくて、入力の多様性を増やすことに力を入れてるんや。

以前の研究(Jung et al., 2023)では言語モデルを使って入力を生成してたんやけど、この手法はテストデータのドメインが事前にわかってる前提で、各ドメイン用にデータを生成するようにプロンプトしてたんや。でもな、幅広いアプリケーションクラス向けの蒸留に使おうとすると、テストデータの分布がわからへんから、この方法はうまくいかへんねん。結果的に、テストドメインを幅広くカバーするような入力を言語モデルから生成するのがめっちゃ難しいっちゅう問題があるわけや。

---

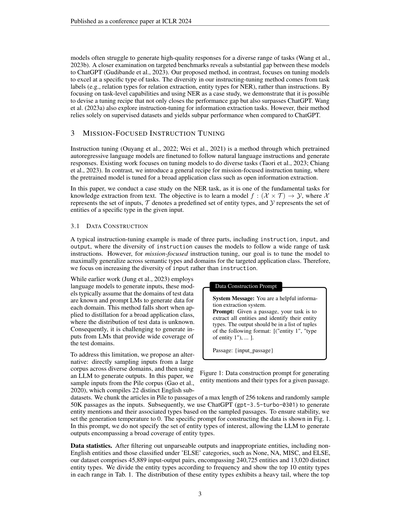

**データ構築プロンプト**

システムメッセージ:あなたは有能な情報抽出システムです。

プロンプト:文章が与えられたら、すべてのエンティティを抽出して、そのエンティティタイプを特定してな。出力は以下の形式のタプルのリストにしてや:[("エンティティ1", "エンティティ1のタイプ"), ...]。

文章:{input_passage}

---

この問題を解決するためにな、ワイらは別のアプローチを提案するで。いろんなドメインにまたがる大規模コーパスから直接入力をサンプリングして、ほんでLLMに出力を生成させるっちゅうやり方や。この論文ではな、Pileコーパス(Gao et al., 2020)から入力をサンプリングしてるで。Pileは22種類の異なる英語サブデータセットを集めたもんやねん。Pileの記事を最大256トークンのパッセージに分割して、そこからランダムに5万パッセージをサンプリングして入力にしたんや。ほんで、ChatGPT(gpt-3.5-turbo-0301)を使って、サンプリングしたパッセージに基づいてエンティティの言及とそのタイプを生成させたんやで。安定性を確保するために、生成温度は0に設定してるで。データ構築用の具体的なプロンプトは図1に載せてるで。このプロンプトではな、対象とするエンティティタイプの集合をあえて指定してへんねん。そうすることで、LLMがめっちゃ幅広いエンティティタイプをカバーする出力を生成できるようにしとるんや。

図1:与えられた文章に対してエンティティの言及とそのタイプを生成するためのデータ構築プロンプト。

**データの統計情報。** パースできへん出力とか、不適切なエンティティ(英語以外のエンティティや、None、NA、MISC、ELSEみたいな「その他」カテゴリに分類されるもん)をフィルタリングした結果、データセットは45,889個の入出力ペアで構成されてて、240,725個のエンティティと13,020種類の異なるエンティティタイプを含んでるで。エンティティタイプを頻度ごとに分けて、各範囲のトップ10を表1に載せてるで。これらのエンティティタイプの分布はめっちゃロングテール(一部がドカンと多くて、大半はちょびっとしかない)になってて、上位の

---

## Page 4

[](/attach/2868ef9ba3f0132a2eaf2b47cdebe7580755dbcb03dda1f06a022baf3a959a04_p004.png)

### 和訳

ICLR 2024の学会論文として発表

出現頻度

上位1%(全体の74%)

1%〜10%(全体の19%)

10%〜100%(全体の7%)

エンティティの種類

人名、組織、場所、日付、概念、製品、イベント、技術、グループ、病名…

特徴、研究、郡、モジュール、単位、特徴量、細胞、パッケージ、解剖学的構造、機器…

属性値、ポケモン、免疫応答、生理学、動物、細胞の特徴、施設、入力デバイス、区、放送…

表1:出現頻度ごとのエンティティの例 — 上位1%、1〜10%、10〜100%の3段階と、それぞれの頻度が全体に占める割合。

ほな説明していくで!まずな、たった1%のエンティティが全体の出現頻度の74%を占めてんねん。めっちゃ偏ってるやろ?ほんで生成されたデータには、一般的な分野(例えば「人名」とか)から臨床系の専門分野(「病名」とか)まで、いろんなドメインのエンティティタイプが含まれとるんよ。さらにな、エンティティタイプの粒度にもバラつきがあんねん。例えば「郡」は「場所」の一部やし、「入力デバイス」は「製品」の一部やな。こういうデータの特徴があるおかげで、エンティティタイプをめっちゃ幅広くカバーできるから、いろんな分野でLLM(大規模言語モデル)の能力を蒸留するのにピッタリなデータになってるっちゅうわけや。

**定義ベースのデータ構築。** エンティティタイプだけちゃうくて、ChatGPTにエンティティの表現(メンション)も生成させて、そのタイプを短い文で定義させるっていうこともやっとるねん。やり方はシンプルで、図1のプロンプトを「すべてのエンティティを抽出して、エンティティタイプを特定して」から「すべてのエンティティと概念を抽出して、そのタイプを短い文で定義して」に変えるだけやねん。この方法やと、353,092種類ものめっちゃ多様なエンティティタイプが生成されるんよ。ほんで、このデータで学習したモデルはエンティティタイプの言い換えに対してもブレにくくなる(セクション5.5参照)んやけど、標準的なNERベンチマークでのスコアはちょっと下がるねん(セクション5.2参照)。トレードオフってやつやな。

3.2 インストラクションチューニング

データが手に入ったら、次は小さいモデルにインストラクションチューニング(指示に従う学習)をかけて、幅広い用途に使えるように蒸留していくで。例えばNER(固有表現認識)やったら、多様なエンティティタイプに対応できるようにするってことやな。

図2に示してるテンプレートは、会話スタイルのチューニング形式を採用してるねん。このアプローチでは、言語モデルに文章 Xpassage を入力として渡すやろ。ほんで、出力に出てくる各エンティティタイプ ti ごとに、「tiを表すものは何?」っていう自然言語のクエリに変換するんよ。そしたら、モデルがその文章中の ti に該当する全エンティティを JSON リストの形で出力するように学習させるっちゅうわけや。y1, ..., yT を正解トークンとして、これらのトークンに対して言語モデリングの目的関数を適用するんやで。予備実験の結果やと、この会話スタイルのチューニングの方が、Wang et al. (2023a) や Sun et al. (2023) が使ってた従来のNERスタイルのチューニングよりええ結果が出てんねん。

**会話スタイルのインストラクションチューニング用テンプレート**

バーチャルアシスタントが、提供されたテキストに基づいてユーザーの質問に回答します。

ユーザー:テキスト:Xpassage

アシスタント:このテキストを読みました。

ユーザー:テキスト中の t1 を表すものは何ですか?

アシスタント:y1

…

ユーザー:テキスト中の tT を表すものは何ですか?

アシスタント:yT

図2:文章とNERアノテーションを会話形式に変換するテンプレート。Xpassage が入力文章、[t1, ..., tT] が考慮するエンティティタイプ、yi が ti に該当するエンティティのリストやで。この会話データを使って言語モデルをチューニングするんやけど、ハイライトされてる部分だけがロス計算に使われるってのがポイントやな。

1つのクエリに1つのエンティティタイプっていう形式の他に、全エンティティタイプを1つのクエリにまとめて、モデルに一発で全エンティティを出力させるっていう方法も試しとるで。詳しい結果と議論はセクション5.2を見てな。

**ネガティブサンプリング。** データ構築のプロセスは、オープンワールド仮定っていう考え方に従っとるねん。つまり、文章中に出てきたエンティティタイプをモデルが自由に生成してOKっていうスタンスやな。でもな、ここに落とし穴があるんよ。生成されたデータには、文章中に**存在しない**エンティティタイプ、つまりネガティブなエンティティタイプが含まれてへんねん。そうすると、クローズドワールドの設定 — つまり「この文章にこのタイプのエンティティある?」って聞かれて「ないで」って答えなあかん場面 — にうまく対応できへんっちゅう問題が出てくるんよ。このギャップを埋めるために、文章中に出てこないエンティティタイプの集合からネガティブなエンティティタイプをサンプリングして、クエリとして投げて、期待される出力を空のJSONリストに設定するっていう方法を使ってるんや。ネガティブエンティティタイプのサンプリングは

---

## Page 5

[](/attach/2868ef9ba3f0132a2eaf2b47cdebe7580755dbcb03dda1f06a022baf3a959a04_p005.png)

### 和訳

ICLR 2024の学会論文として発表されたやつやで

これはな、データセット全体でのエンティティタイプの出現頻度に比例した確率でやるねん。このやり方がめっちゃ効くっていうのは、セクション5.4で見せたるわ。

**教師ありファインチューニング**。人間がつけたアノテーション(ラベル付けのことやな)が追加であるときは、その教師データ使ったらモデルの性能もっと上げられるねん。でもな、複数のデータセットで学習するときに厄介な問題があるんよ。データセットごとにラベルの定義がちゃうことがあって、ラベル同士が矛盾してまうねん。たとえばな、ACE(Walker et al., 2006)みたいなデータセットやと「she」とか「he」みたいな人称代名詞もPERSON扱いにするんやけど、multiNERD(Tedeschi & Navigli, 2022)みたいなやつやと代名詞は含めへんのよ。

この問題に対処するためにな、俺らは**データセット固有のインストラクションチューニングテンプレート**っちゅうもんを提案するねん。Fig. 3に描いてるやつやな。具体的にはな、入力にデータセット名Dっていうフィールドを追加するねん。こうすることで、モデルが「このデータセットではこのラベルはこういう意味やねんな」っていうのを学習できるようになるわけ。推論のときはな、教師あり設定ではそれぞれのデータセット名をプロンプトに入れて、ゼロショット設定(学習データなしでいきなりやるやつな)ではデータセットのフィールドを省略するねん。

## 4 ユニバーサルNERベンチマーク

**データセット固有のインストラクションチューニングテンプレート**

```

バーチャルアシスタントが、提示されたテキストに基づいて

ユーザーの質問に回答するで。

ユーザー: Dataset: D \n Text: Xpassage

アシスタント: このテキスト読んだで。

ユーザー: テキストの中でt1を表してるもんは何?

アシスタント: y1

...

ユーザー: テキストの中でtTを表してるもんは何?

アシスタント: yT

```

Figure 3: データセット固有のインストラクションチューニングテンプレートやで。ラベル定義の矛盾を解消するために、入力の一部としてデータセット名D(赤色のとこやな)を追加してるねん。

いろんなドメインとエンティティタイプにまたがるNERモデルを徹底的に評価するためにな、今までで一番でかいNERベンチマークを集めたんよ。このベンチマークはな、9つのドメインにわたる43個のNERデータセットを網羅してるねん。ドメインっていうのは、一般、バイオメディカル(生物医学)、臨床、STEM(理系全般やな)、プログラミング、ソーシャルメディア、法律、金融、交通の9つや。データの分布はFig. 4に載せてるで。データセットの詳しい統計はAppendixのTab. 6を見てな。

**データセットの前処理**。エンティティタイプをLLM(大規模言語モデルやな)にとって意味がわかるようにするためにな、ラベルを手作業で確認して、自然言語の形式に変換したんよ。たとえば、PERをPERSONに変えるとかな。幅広くNERデータセットを集めるようにしたんやけど、全部のエンティティタイプを使ってるわけちゃうねん。なんでかっていうと、一部のエンティティタイプ(たとえばELSEとか)は、データセット間で一貫したソースから来てへんのよ。それぞれのアノテーションが別々のオントロジー(知識体系みたいなもんやな)に基づいてて、目的もバラバラやねん。エンティティタイプの選び方やアノテーションのガイドラインが、全体的・包括的な評価のために最適化されてへんから、ユニバーサルNERモデルを評価するための「正解データ」として使うにはちょっとイマイチやねん。やから、そういうラベルはデータセットから外したんよ。あとな、文書レベルのデータセットの中にはめっちゃ長い文脈を含むやつがあって、モデルの入力長の上限を超えてまうことがあるねん。やから、文書レベルのデータセットのインスタンスは全部、文レベルに分割したで。

## 5 実験

Figure 4: UniNERベンチマークの分布やで。

このセクションではUniversalNERの実験的な評価を紹介するで。まず実験設定を説明して(セクション5.1)、そのあと蒸留設定と教師あり設定の両方の結果を見せたるわ。

---

## Page 6

[](/attach/2868ef9ba3f0132a2eaf2b47cdebe7580755dbcb03dda1f06a022baf3a959a04_p006.png)

### 和訳

ICLR 2024の学会論文として発表されたで

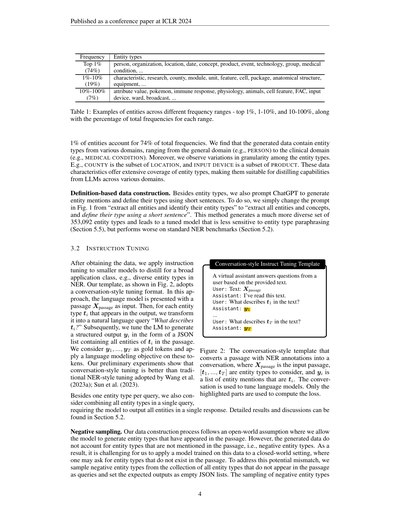

(a) ゼロショットモデルをいろんな分野で比べてみた結果やねん。ゼロショットっていうのは、事前に「こういうの見つけてな」って教えんでもいきなり本番で使えるモデルのことやな。ウチらが蒸留したモデル、なんとChatGPTよりも全部の分野でええ結果出してんで!

(b) UniNER-7Bと、そのバリエーション2つを比べた結果やな。UniNER-7B-definitionっていうのは、Pileっていうデータを使って、エンティティタイプ(要は「人名」とか「地名」とかのカテゴリ)の定義文をプロンプトに入れて蒸留したやつ。UniNER-7B-all-in-oneは、全部のエンティティタイプを一回のクエリでまとめて聞くテンプレートで学習させたやつやねん。

(5.2節と5.3節でそれぞれ説明するで)。最後に分析(5.4節)とケーススタディ(5.5節)もやって、モデルの性能についてもっと深く掘り下げていくわ。

5.1 実験の設定

**モデルの構成**:公平に比べるために、LLaMA2(Touvronら、2023a)をベースにして、Chiangら(2023)の学習スケジュールに合わせてモデルを訓練したで。テストデータがめっちゃデカいやつもあるから、各データセットから最大20万件の文章とクエリのペアをサンプリングして評価してん。評価にはエンティティレベルの厳密マイクロF1っていう指標を使ってて、エンティティのタイプと境界、つまり「これは人名で、ここからここまでが名前やで」っていうのが正解とピッタリ一致せなあかんっていう厳しい基準やねん。

**比較したモデル**:ウチらのモデル(UniNER)と以下のモデルを比べたで。(1) ChatGPT(gpt-3.5-turbo-0301)。NER(固有表現認識)にはYeら(2023)のプロンプトテンプレートを使ってん。(2) Vicuna(Chiangら、2023)はChatGPTとの会話データでファインチューニングしたやつで、ベースモデルはLLaMA。(3) InstructUIE(Wangら、2023a)は教師あり学習モデルで、いろんな情報抽出データセットでファインチューニングされてて、統一的な自然言語生成の目的関数を使ってんねん。ベースモデルにはFlan-T5 11B(Chungら、2022)を採用してるで。

5.2 蒸留

まずゼロショット設定でモデルを評価したで。ChatGPT、Vicuna、ほんでウチらのUniNERを比べてん。UniNERは、人手でラベル付けしたデータは一切使わんと、PileデータにChatGPTでNERアノテーションつけたもんから蒸留したモデルやねん。結果は図5aに載せてるで。³ 見てみたら、ウチらの蒸留モデルがめっちゃ

²LLaMA 2(Touvronら、2023b)をベースにしたモデルも訓練したんやけど、実験では大きな差は見られへんかったわ。

³スペースの都合で、全データセットの平均F1と各分野の平均F1だけ載せてるで。全部の結果は付録の図9を見てな。

6

---

## Page 7

[](/attach/2868ef9ba3f0132a2eaf2b47cdebe7580755dbcb03dda1f06a022baf3a959a04_p007.png)

### 和訳

ICLR 2024の学会論文として発表

うちらのモデル、UniNER-7BとUniNER-13Bやけど、平均F1スコアでChatGPTをぶち抜いとんねん。UniNER-7Bが41.7%、UniNER-13Bが43.4%で、ChatGPTは34.9%やからな。これが何を意味するかっていうと、うちらが提案した「いろんな入力からピンポイントで蒸留する」っていう方法で、モデルのサイズはそこそこコンパクトに抑えながら、幅広い用途でめっちゃ高い性能を叩き出せるってことやねん。しかもUniNER-13Bの方がUniNER-7Bより成績ええから、でかいモデルでファインチューニングした方が汎化性能が上がるっていう傾向も見えとるわけや。分野別に見ても、UniNER-7BもUniNER-13Bも全部の分野でChatGPTを上回っとって、特定の分野だけやなくて全方位的に改善できとるんやで。

ほんでさらに、UniNERのバリエーションも比較してみたんや。具体的には、(1) UniNER-all-in-one:全部のエンティティタイプの抽出を1回のやり取りにまとめるやつ、と(2) UniNER-definition:指示チューニングデータのクエリにエンティティタイプそのものやなくて、ChatGPTが生成したエンティティタイプの定義文を使うやつ、の2パターンや。結果は図5bに載せとるで。見てみると、UniNER-all-in-oneもUniNER-definitionも、UniNER-type(タイプ名をそのまま使うやつ)より平均でそれぞれ3.3%と11.8%低かったんや。UniNER-definitionの成績が落ちた理由やけど、たぶん評価データセットとの相性の問題やねん。評価データセットはラベルに単語とか短いフレーズを使っとるのに、定義文は長い文やから、そこでズレが生じてもうたんやろな。UniNER-all-in-oneの方の成績差は、注意力の分散とタスクの複雑さが原因やと考えられるわ。1回のクエリで複数のエンティティタイプを同時に処理せなあかんと、モデルの注意があっちこっちに散ってまって、個々のタイプの識別精度が落ちるんちゃうかと。逆に、タスクを「1回につき1タイプだけ」っていうシンプルなやつに分解したら、モデルが複雑さをうまく捌けて、より正確な結果が出せるってことやな。

5.3 教師ありファインチューニング

うちらのモデルが、人間のアノテーション(手作業でつけたラベルデータ)をさらに追加したら性能上がるんかっていうのを調べたんや。ChatGPT、Vicuna、InstructUIE(Wangら、2023a)⁴、そしてUniNERを比較しとるで。

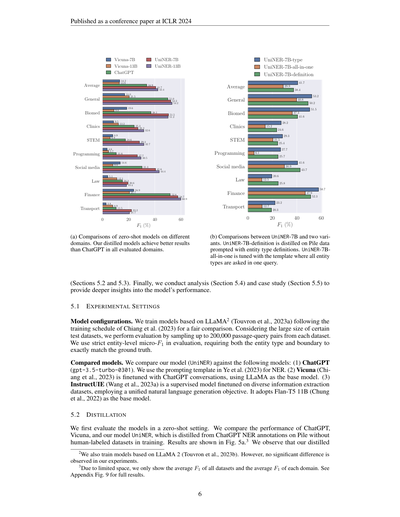

| データセット | BERT-base | InstructUIE 11B | UniNER 7B |

|---|---|---|---|

| ACE05 | 87.30 | 79.94 | 86.69 |

| AnatEM | 85.82 | 88.52 | 88.65 |

| bc2gm | 80.90 | 80.69 | 82.42 |

| bc4chemd | 86.72 | 87.62 | 89.21 |

| bc5cdr | 85.28 | 89.02 | 89.34 |

| Broad Twitter | 58.61 | 80.27 | 81.25 |

| CoNLL03 | 92.40 | 91.53 | 93.30 |

| FabNER | 64.20 | 78.38 | 81.87 |

| FindVehicle | 87.13 | 87.56 | 98.30 |

| GENIA | 73.3 | 75.71 | 77.54 |

| HarveyNER | 82.26 | 74.69 | 74.21 |

| MIT Movie | 88.78 | 89.58 | 90.17 |

| MIT Restaurant | 81.02 | 82.59 | 82.35 |

| MultiNERD | 91.25 | 90.26 | 93.73 |

| ncbi | 80.20 | 86.21 | 86.96 |

| OntoNotes | 91.11 | 88.64 | 89.91 |

| PolyglotNER | 75.65 | 53.31 | 65.67 |

| TweetNER7 | 56.49 | 65.95 | 65.77 |

| WikiANN | 70.60 | 64.47 | 84.91 |

| wikiNeural | 82.78 | 88.27 | 93.28 |

| 平均 | 80.09 | 81.16 | 84.78 |

表2:Wangら(2023a)で使われた20データセットでのF1スコアや。BERT-baseの結果はWangら(2023a)から引用。InstructUIEの結果はうちらが再評価したやつやで。

**ドメイン外評価**:まず、教師ありファインチューニングで未知のデータに対する汎化性能が上がるかを調べたんや。InstructUIEと同じやり方で、CrossNER(Liuら、2021)とMIT(Liuら、2013)の2つのデータセットをドメイン外評価用に除外して、残りのユニバーサルNERベンチマークの訓練データでモデルをファインチューニングしたで。結果は表3に載せとる。注目してほしいのは、ファインチューニングなしの状態でも、指示チューニング済みのUniNER 7Bと13Bが、ChatGPT、Vicuna、教師ありファインチューニング済みのInstructUIE-11Bをめっちゃ大差で上回っとることやねん。教師ありデータだけでゼロからモデルを学習させた場合は平均F1が57.2%やったけど、UniNER-7Bをベースに教師ありデータで追加ファインチューニングしたら、平均F1が60.0%で最高記録を達成しとるんや。つまり、人間が手作業でつけたアノテーションデータを足すことで、モデルの汎化性能はさらに伸ばせるっていうことやな。

**ドメイン内評価**:次に、ドメイン内の教師あり設定でのUniNERの性能を見たんや。InstructUIE(Wangら、2023a)と同じ訓練データでUniNER-7Bをファインチューニングしたで。結果は表2に載せとる。うちらのUniNER-7Bは20データセットで平均F1が84.78%を達成して、BERT-baseを4.69%、InstructUIE-11Bを3.62%それぞれ上回っとんねん。この実験で、教師あり設定でもうちらのモデルがめっちゃ有効やってことが証明されたわけや。

⁴ちょっと注意してほしいんやけど、InstructUIEのオリジナルの評価スクリプトにはけっこうヤバいバグがあってん。エンティティが1個も含まれてないパッセージに対して、スクリプトがNONEっていうプレースホルダーのエンティティを追加して、F1計算のときにそれも含めてしまっとったんや。このエラーを正すために、うちらはInstructUIEの公開チェックポイントを使って再評価したで。

---

## Page 8

[](/attach/2868ef9ba3f0132a2eaf2b47cdebe7580755dbcb03dda1f06a022baf3a959a04_p008.png)

### 和訳

ICLR 2024の学会論文として発表されたで

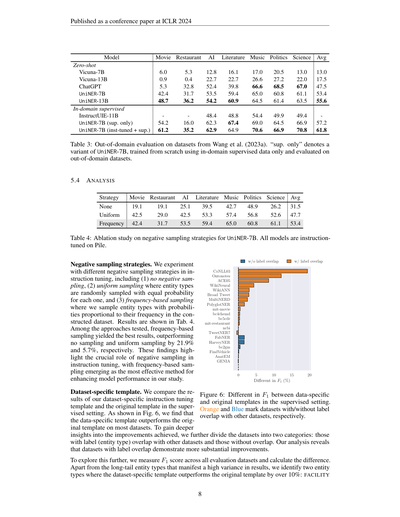

**モデル**

| | 映画 | レストラン | AI | 文学 | 音楽 | 政治 | 科学 | 平均 |

|---|---|---|---|---|---|---|---|---|

| **ゼロショット(事前学習なしでいきなりやらせるやつ)** | | | | | | | | |

| Vicuna-7B | 6.0 | 5.3 | 12.8 | 16.1 | 17.0 | 20.5 | 13.0 | 13.0 |

| Vicuna-13B | 0.9 | 0.4 | 22.7 | 22.7 | 26.6 | 27.2 | 22.0 | 17.5 |

| ChatGPT | 5.3 | 32.8 | 52.4 | 39.8 | 66.6 | 68.5 | 67.0 | 47.5 |

| UniNER-7B | 42.4 | 31.7 | 53.5 | 59.4 | 65.0 | 60.8 | 61.1 | 53.4 |

| UniNER-13B | 48.7 | 36.2 | 54.2 | 60.9 | 64.5 | 61.4 | 63.5 | 55.6 |

| **ドメイン内の教師あり学習(ちゃんと正解データで訓練したやつ)** | | | | | | | | |

| InstructUIE-11B | 54.2 | 16.0 | 48.4 | 48.8 | 54.4 | 49.9 | 49.4 | 57.2 |

| UniNER-7B(教師ありだけ) | 61.2 | 35.2 | 62.3 | 67.4 | 69.0 | 64.5 | 66.9 | 61.8 |

| UniNER-7B(指示チューニング+教師あり) | | | 62.9 | 64.9 | 70.6 | 66.9 | 70.8 | |

表3:Wang et al. (2023a) のデータセットを使ったドメイン外評価やねん。「教師ありだけ」っていうのは、UniNER-7Bの亜種で、ドメイン内の教師ありデータだけでゼロから訓練して、ドメイン外のデータセットで評価したバージョンのことやで。

---

### 5.4 分析

| 戦略 | 映画 | レストラン | AI | 文学 | 音楽 | 政治 | 科学 | 平均 |

|---|---|---|---|---|---|---|---|---|

| なし | 19.1 | 19.1 | 25.1 | 39.5 | 42.7 | 48.9 | 26.2 | 31.5 |

| 均一サンプリング | 42.5 | 29.0 | 42.5 | 53.3 | 57.4 | 56.8 | 52.6 | 47.7 |

| 頻度ベース | 42.4 | 31.7 | 53.5 | 59.4 | 65.0 | 60.8 | 61.1 | 53.4 |

表4:UniNER-7Bのネガティブサンプリング戦略のアブレーション研究(どの要素がどれくらい効いてるか調べるやつ)やで。全モデルともPileデータセットで指示チューニングしてるねん。

**ネガティブサンプリング戦略について**

指示チューニングの時に、ネガティブサンプリング(要するに「これは違うで」っていう例も混ぜて学習させるやり方)をどうするかで実験してみたんやけど、やり方は3つ試したで。(1) ネガティブサンプリングなし、(2) 均一サンプリング(エンティティタイプをどれも同じ確率でランダムに選ぶやつ)、(3) 頻度ベースのサンプリング(作ったデータセットの中で出てくる頻度に比例した確率でエンティティタイプを選ぶやつ)の3つや。結果は表4に載せてるで。

試した中で一番ええ成績やったんは頻度ベースのサンプリングやねん。サンプリングなしより21.9%、均一サンプリングより5.7%も上回ったんや。この結果からわかるんは、指示チューニングにおいてネガティブサンプリングがめっちゃ重要な役割を果たしてるっていうことやねん。ほんまに、頻度ベースのサンプリングがモデルの性能を引き上げるのに一番効果的な方法やったわ。

**データセット固有のテンプレートについて**

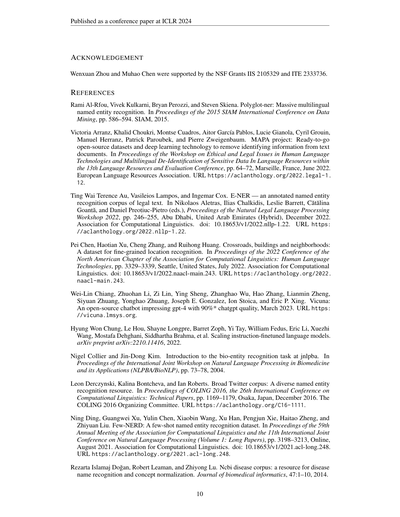

教師あり設定で、ワイらが作ったデータセット固有の指示チューニングテンプレートと、元々のテンプレートを比べてみたで。図6に示す通り、データセット固有のテンプレートの方がほとんどのデータセットで元のテンプレートより成績がええことがわかったんや。もうちょっと深掘りするために、データセットを2つのカテゴリに分けてみたんやけど、他のデータセットとラベル(エンティティタイプ)が被ってるやつと、被ってないやつや。分析してみたら、ラベルが被ってるデータセットの方がめっちゃ大きく改善してることがわかったで。

図6:教師あり設定でのデータセット固有テンプレートと元のテンプレートのF1スコアの差やねん。オレンジは他のデータセットとラベルが被ってるやつ、青は被ってないやつを示してるで。

さらに掘り下げるために、全評価データセットでF1スコアを測って、その差を計算したんや。出現頻度が低いロングテールのエンティティタイプは結果のバラつきが大きいから除外して、データセット固有テンプレートが元のテンプレートより10%以上上回ったエンティティタイプを2つ特定したで:それがFACILITY(施設)やねん。

---

## Page 9

[](/attach/2868ef9ba3f0132a2eaf2b47cdebe7580755dbcb03dda1f06a022baf3a959a04_p009.png)

### 和訳

ICLR 2024の学会論文として発表されたやつやで

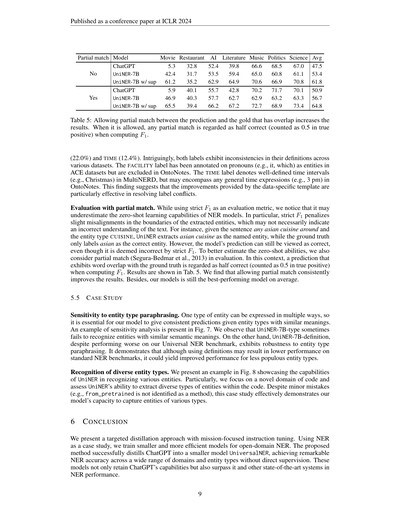

部分一致モデル

いいえ

はい

ChatGPT

UniNER-7B

UniNER-7B w/ sup(教師ありバージョンな)

ChatGPT

UniNER-7B

UniNER-7B w/ sup

映画 レストラン AI 文学 音楽 政治 科学 平均

47.5

53.4

61.8

50.9

56.7

64.8

39.8

59.4

64.9

42.8

62.7

67.2

66.6

65.0

70.6

70.2

62.9

72.7

68.5

60.8

66.9

71.7

63.2

68.9

52.4

53.5

62.9

55.7

57.7

66.2

67.0

61.1

70.8

70.1

63.3

73.4

5.3

42.4

61.2

5.9

46.9

65.5

32.8

31.7

35.2

40.1

40.3

39.4

表5:予測と正解の間で部分的に重なってるやつも認めたら、結果がようなるねん。部分一致を認める場合は、ちょっとでもかぶってたら半分正解(真陽性で0.5としてカウント)としてF1を計算するんやで。

(22.0%)とTIME(12.4%)やねん。おもろいことに、この2つのラベルはデータセットによって定義がバラバラやねん。FACILITYラベルはな、ACEデータセットやと代名詞(itとかwhichとか)もエンティティとしてアノテーションしてるんやけど、OntoNotesやと除外されてるんよ。TIMEラベルはMultiNERDやときっちり決まった時間の区切り(クリスマスとか)を指すんやけど、OntoNotesやと何でもありの時間表現(午後3時とか)も含んだりするねん。この発見からわかるんは、データに特化したテンプレートの改善効果は、こういうラベルの定義がぶつかるところで特にバチっと効くっちゅうことやな。

**部分一致での評価。** 厳密なF1を評価指標に使ってると、NERモデルのゼロショット学習の実力を過小評価してまうかもしれんねん。なんでかっていうと、厳密なF1は抽出したエンティティの境界がちょっとズレてるだけでもペナルティかけるんやけど、それは別にテキストの理解を間違えてるわけちゃうやん。例えばな、「any asian cuisine around」っていう文でCUISINE(料理の種類)っていうエンティティタイプを抽出する場合、UniNERは「asian cuisine」を固有表現として抽出するんやけど、正解ラベルは「asian」だけが正解になってんねん。でもな、モデルの予測はどう見ても合ってるやん?なのに厳密なF1やと不正解扱いされてまうんよ。ゼロショットの実力をもっとちゃんと見積もるために、部分一致(Segura-Bedmarら、2013年)も評価に入れたんやで。この場合、正解とちょっとでも単語がかぶってる予測は半分正解(真陽性で0.5カウント)としてF1を計算するねん。結果は表5に載せてるで。部分一致を認めると、めっちゃ安定して結果が良くなんねん。しかもな、ワイらのモデルは平均でやっぱり一番ええ成績やったで。

**5.5 ケーススタディ**

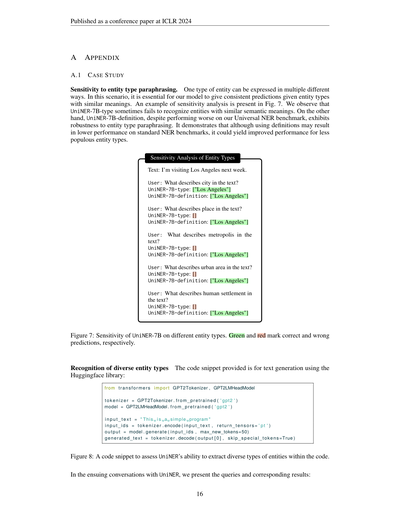

**エンティティタイプの言い換えに対する敏感さ。** 1つのタイプのエンティティはいろんな言い方で表現できるから、意味が似てるエンティティタイプを与えた時に一貫した予測を返すことがめっちゃ大事やねん。感度分析の例を図7に示してるで。見てみると、UniNER-7B-typeは意味的に似てるエンティティをうまく認識でけへん時があるんよ。一方で、UniNER-7B-definitionは、Universal NERベンチマークでの成績は落ちるんやけど、エンティティタイプの言い換えに対してめっちゃ頑健やねん。つまりな、定義を使うと標準的なNERベンチマークでは成績下がるかもしれんけど、あんまり出てこーへんエンティティタイプに対してはむしろ性能が上がる可能性があるっちゅうことやな。

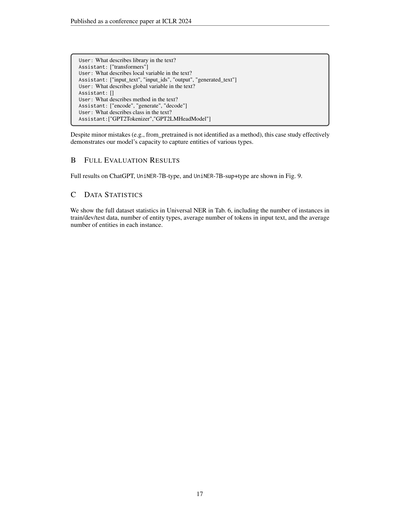

**多様なエンティティタイプの認識。** 図8にUniNERがいろんなエンティティを認識する能力を見せる例を載せてるで。特に注目したんは、コードっていう新しいドメインで、コードの中から多様なタイプのエンティティを抽出できるかどうかやねん。ちょっとしたミスはあるんよ(例えば from_pretrained がメソッドとして認識されてへんとか)、でもこのケーススタディで、ワイらのモデルがいろんなタイプのエンティティをちゃんと捉えられることがバッチリ示されとるで。

**6 結論**

ワイらは、ミッションに特化した指示チューニングによるターゲット蒸留アプローチを提案したで。NERをケーススタディとして使って、オープンドメインNER向けのもっと小さくて効率的なモデルを学習させたんや。提案手法はChatGPTをUniversalNERっていう小さいモデルにうまく蒸留することに成功して、直接の教師データなしで幅広いドメインとエンティティタイプにわたってめっちゃ高いNER精度を達成したんやで。しかもこれらのモデルは、ChatGPTの能力をキープするだけちゃうくて、ChatGPTや他の最先端システムをNER性能で上回っとるんやから、ほんまにすごいことやで。

9

---

## Page 10

[](/attach/2868ef9ba3f0132a2eaf2b47cdebe7580755dbcb03dda1f06a022baf3a959a04_p010.png)

### 和訳

ICLR 2024の学会論文として発表済み

**謝辞**

Wenxuan ZhouとMuhao Chenは、NSFの助成金IIS 2105329とITE 2333736のサポートを受けとるで。

**参考文献**

Rami Al-Rfouら(2015)の「Polyglot-NER」っていうのは、めっちゃようけの言語に対応した固有表現認識(名前とか場所とかを文章から見つけ出す技術やな)の研究やねん。2015年のSIAMデータマイニング国際会議で発表されとるで。pp. 586–594。

Victoria Arranzら(2022)の「MAPAプロジェクト」は、文書から個人を特定できる情報を消し去るためのオープンソースのデータセットとディープラーニング技術を、すぐ使える状態で提供しとるやつやねん。なんでかっていうと、プライバシー保護がほんまに大事やからな。第13回言語資源評価会議の中の、倫理・法的課題ワークショップで発表されとる。マルセイユ開催やで。pp. 64–72。URL: https://aclanthology.org/2022.legal-1.12

Ting Wai Terence Auら(2022)の「E-NER」は、法律文書のための固有表現認識コーパス(要するに、法律の文章に出てくる人名とか組織名とかにラベル付けしたデータ集やな)やねん。自然言語法律処理ワークショップ2022で発表。アブダビでのハイブリッド開催やったで。pp. 246–255。doi: 10.18653/v1/2022.nllp-1.22。URL: https://aclanthology.org/2022.nllp-1.22

Pei Chenら(2022)の「Crossroads, Buildings and Neighborhoods」は、交差点とか建物とか近所とか、めっちゃ細かい粒度で場所を認識するためのデータセットやねん。NAACL 2022で発表されとって、シアトル開催や。pp. 3329–3339。doi: 10.18653/v1/2022.naacl-main.243。URL: https://aclanthology.org/2022.naacl-main.243

Wei-Lin Chiangら(2023)の「Vicuna」は、オープンソースのチャットボットで、なんとGPT-4も驚くくらいChatGPTの90%の品質を叩き出したっていう話やねん。2023年3月の発表や。URL: https://vicuna.lmsys.org

Hyung Won Chungら(2022)は、指示に従うようにファインチューニングした言語モデルのスケーリング(でっかくしていくこと)について研究しとるねん。arXivプレプリント、arXiv:2210.11416。

Nigel CollierとJin-Dong Kim(2004)は、JNLPBAっていうバイオ関連の固有表現認識タスク(生物学の文章から遺伝子名とかタンパク質名とかを見つけ出すコンテストみたいなもんやな)の紹介をしとるねん。バイオメディシンにおける自然言語処理の国際合同ワークショップで発表。pp. 73–78。

Leon Derczynskiら(2016)の「Broad Twitter Corpus」は、Twitterのツイートを使った多様な固有表現認識のリソースやねん。ほんまに色んな種類のツイートが入っとるのがミソやで。COLING 2016で発表、大阪開催や。pp. 1169–1179。URL: https://aclanthology.org/C16-1111

Ning Dingら(2021)の「Few-NERD」は、少ないデータでも固有表現認識ができるようにするためのデータセットやねん。要するに、ちょっとの例を見ただけで新しいタイプの名前とかを認識できるようにしよう、っていう研究やな。ACL 2021で発表されとる。pp. 3198–3213。doi: 10.18653/v1/2021.acl-long.248。URL: https://aclanthology.org/2021.acl-long.248

Rezarta Islamaj Doğanら(2014)の「NCBI Disease Corpus」は、病気の名前を認識して正しい概念に紐づける(正規化っていうやつやな)ためのリソースやねん。Journal of Biomedical Informatics掲載、47巻、pp. 1–10。

---

## Page 11

[](/attach/2868ef9ba3f0132a2eaf2b47cdebe7580755dbcb03dda1f06a022baf3a959a04_p011.png)

### 和訳

ICLR 2024の学会論文として発表済みやで

Oren Etzioni、Michele Banko、Stephen Soderland、Daniel S Weld。ウェブからのオープン情報抽出。Communications of the ACM、51(12):68–74、2008年。

→ これはな、ウェブ上のテキストから構造化された情報を自動で引っこ抜く「オープン情報抽出」っちゅう技術の話やねん。ACMっていうコンピュータサイエンスのめっちゃ有名な学会誌に載った論文やで。

Annemarie Friedrich、Heike Adel、Federico Tomazic、Johannes Hingerl、Renou Benteau、Anika Maruscyk、Lukas Lange。SOFC-Expコーパスと材料科学分野における情報抽出のためのニューラルアプローチ、2020年。

→ SOFC(固体酸化物形燃料電池)っていう材料科学の分野でな、実験データをAIで自動抽出するためのデータセットとニューラルネットワークの手法を作ったっちゅう研究やねん。

Leo Gao、Stella Biderman、Sid Black、Laurence Golding、Travis Hoppe、Charles Foster、Jason Phang、Horace He、Anish Thite、Noa Nabeshimaほか。The Pile:言語モデル用の多様なテキスト800GBデータセット。arXivプレプリント arXiv:2101.00027、2020年。

→ 「The Pile」ってのはな、なんと800ギガバイトもある超巨大なテキストデータセットやねん。いろんなジャンルのテキストを集めてきて、言語モデルの学習に使えるようにしたもんやで。めっちゃデカいやろ?

Felix Grezes、Sergi Blanco-Cuaresma、Thomas Allen、Tirthankar Ghosal。天体物理学文献におけるエンティティ検出に関する初の共有タスク(DEAL)の概要。科学出版物からの情報抽出に関する第1回ワークショップ予稿集、pp. 1–7、オンライン、2022年11月。計算言語学会。

→ 天体物理学の論文から、星の名前とか物理量とか、そういう重要な「エンティティ」を自動で見つけ出すコンペの概要報告やねん。天文学×自然言語処理っていう、なかなかニッチやけどおもろい組み合わせやな。

Yu Gu、Sheng Zhang、Naoto Usuyama、Yonas Woldesenbet、Cliff Wong、Praneeth Sanapathi、Mu Wei、Naveen Valluri、Erika Strandberg、Tristan Naumann、Hoifung Poon。バイオメディカル知識抽出のための大規模言語モデルの蒸留:薬の副作用に関するケーススタディ、2023年。

→ でっかい言語モデル(LLM)の知識をギュッと小さいモデルに移す「蒸留」っちゅうテクニックを使って、薬の副作用情報を自動抽出する研究やねん。大きいモデルの賢さを小さいモデルにも分けたろうっていう発想やな。

Runwei Guan、Ka Lok Man、Feifan Chen、Shanliang Yao、Rongsheng Hu、Xiaohui Zhu、Jeremy Smith、Eng Gee Lim、Yutao Yue。FindVehicleとVehicleFinder:自然言語ベースの車両検索用NERデータセットとキーワードベースのクロスモーダル車両検索システム。arXivプレプリント arXiv:2304.10893、2023年。

→ 「赤いSUVで前が凹んでる車」みたいな自然言語の説明から車を探し出すためのデータセットと検索システムを作った研究やで。NER(固有表現認識)っていう技術を車両検索に応用してるねん。なかなか実用的やろ?

Arnav Gudibande、Eric Wallace、Charlie Snell、Xinyang Geng、Hao Liu、Pieter Abbeel、Sergey Levine、Dawn Song。独自LLMの模倣という偽りの約束、2023年。

→ これはめっちゃ辛辣なタイトルやねんけどな、ChatGPTみたいな高性能LLMの出力を真似して学習させても、ほんまの実力はつかへんで、っていう研究やねん。表面だけ似せても中身が伴わへんってことを示してるわけや。なんでかっていうと、模倣モデルは見た目の流暢さは真似できても、本質的な推論能力までは獲得でけへんからやねん。

Sam Henry、Kevin Buchan、Michele Filannino、Amber Stubbs、Ozlem Uzuner。2018 n2c2共有タスク:電子カルテにおける薬の副作用と薬剤情報の抽出。Journal of the American Medical Informatics Association、27(1):3–12、2020年。

→ 電子カルテ(病院の記録やな)から、薬の名前とか副作用とかを自動で抜き出すコンペティションの報告やねん。医療AIの分野ではめっちゃ重要なタスクやで。

Geoffrey Hinton、Oriol Vinyals、Jeff Dean。ニューラルネットワークにおける知識の蒸留。arXivプレプリント arXiv:1503.02531、2015年。

→ これは「知識蒸留」の元祖みたいな論文やねん!でっかい先生モデル(teacher)の知識を小さい生徒モデル(student)に教え込むっちゅう手法を提案したんや。Hinton先生はノーベル賞も取ったAI界のレジェンドやで。ほんまにこの論文は後の研究にめちゃくちゃ影響与えとる。

Cheng-Yu Hsieh、Chun-Liang Li、Chih-kuan Yeh、Hootan Nakhost、Yasuhisa Fujii、Alex Ratner、Ranjay Krishna、Chen-Yu Lee、Tomas Pfister。ステップバイステップの蒸留!少ない学習データと小さいモデルサイズでより大きな言語モデルを上回る。計算言語学会ACL 2023 Findings、pp. 8003–8017、カナダ・トロント、2023年7月。

→ これはめっちゃおもろい研究でな、蒸留のやり方を工夫して「推論の途中経過」も一緒に教えたることで、小さいモデルがでっかいモデルに勝ってしまうっちゅう話やねん。データも少なくて済むし、モデルも小さくて済む。一石二鳥どころの話ちゃうで!

Yu-Ming Hsieh、Yueh-Yin Shih、Wei-Yun Ma。中国語マンダリンの中央研究院ツリーバンクをUniversal Dependenciesに変換。第16回言語アノテーションワークショップ(LAW-XVI)予稿集(LREC2022内)、pp. 23–30、フランス・マルセイユ、2022年6月。欧州言語資源協会。

→ 台湾の中央研究院が作った中国語の構文解析データを、世界共通の文法フレームワーク「Universal Dependencies」に変換した研究やねん。要するに、中国語の文法データを国際標準に合わせて使いやすくしたろうっちゅう話や。

Sarthak Jain、Madeleine van Zuylen、Hannaneh Hajishirzi、Iz Beltagy。SciREX:文書レベル情報抽出のためのチャレンジデータセット。計算言語学会第58回年次大会予稿集、pp. 7506–7516、オンライン、2020年7月。

→ 科学論文まるごと1本から、エンティティ(人名・手法名とか)やその関係性を抽出するっていう、かなり難しいタスク用のデータセットやねん。文の一部だけやなくて、論文全体を見なあかんから、これがなかなかの難題なんやで。

Jaehun Jung、Peter West、Liwei Jiang、Faeze Brahman、Ximing Lu、Jillian Fisher、Taylor Sorensen、Yejin Choi。不可能な蒸留:低品質モデルから高品質データセット&モデルへ — 要約と言い換えについて、2023年。

→ タイトルからしてパンチ効いてるやろ?しょぼいモデルから出発して、工夫次第で高品質なデータセットとモデルを作れるっちゅう、ちょっと逆説的な研究やねん。「えっ、そんなんできるん?」ってなるやろ?それが「不可能な蒸留」っていう名前の由来やな。

J-D Kim、Tomoko Ohta、Yuka Tateisi、Jun'ichi Tsujii。GENIAコーパス — バイオテキストマイニングのための意味アノテーション付きコーパス。Bioinformatics、19(suppl_1):i180–i182、2003年。

→ 生物医学の論文から情報を掘り出す「バイオテキストマイニング」のための、めっちゃ有名なデータセットやねん。タンパク質とか遺伝子とか、生物学の重要な用語に意味的なラベルを付けた、この分野の草分け的な存在やで。

Martin Krallinger、Obdulia Rabal、Florian Leitner、Miguel Vazquez、David Salgado、Zhiyong Lu、Robert Leaman、Yanan Lu、Donghong Ji、Daniel M Loweほか。CHEMDNERコーパス:化学物質・薬物のコーパスとそのアノテーション原則。Journal of Cheminformatics、7(1):1–17、2015年。

→ 化学物質とか薬の名前を論文テキストから自動認識するためのデータセットやねん。どうやってラベル付けしたか、そのルールも詳しく説明してるで。創薬とか化学の研究でAIを使うときには欠かせへんリソースやな。

11ページ目

---

## Page 12

[](/attach/2868ef9ba3f0132a2eaf2b47cdebe7580755dbcb03dda1f06a022baf3a959a04_p012.png)

### 和訳

ICLR 2024の学会論文として発表済み

Chaitanya Kulkarni、Wei Xu、Alan Ritter、Raghu Machiraju。実験プロトコル(ウェットラボの手順書みたいなもんやな)を機械に読ませるための、ちゃんとアノテーション付けたコーパスの話やねん。2018年にニューオーリンズで開かれたNAACL-HLT(北米の計算言語学の学会やで)のショートペーパー部門で発表されとって、97〜106ページに載ってるわ。doi: 10.18653/v1/N18-2016。URLはhttps://aclanthology.org/N18-2016 やで。

Aman KumarとBinil Starly。「FabNER」っていう、製造プロセスの科学論文から固有表現認識(NERっちゅうやつやな)を使って情報を引っこ抜く研究やねん。Journal of Intelligent Manufacturingの33巻8号、2393〜2407ページ、2022年の論文やで。

Bo Li、Gexiang Fang、Yang Yang、Quansen Wang、Wei Ye、Wen Zhao、Shikun Zhang。ChatGPTの情報抽出能力をガッツリ評価した研究やねん。性能だけやなくて、説明可能性とか、キャリブレーション(予測の自信度がどんだけ当たってるか)とか、忠実性(元の情報にちゃんと忠実かどうか)まで調べとるで。arXivプレプリント、arXiv:2304.11633、2023年。

Jiao Li、Yueping Sun、Robin J Johnson、Daniela Sciaky、Chih-Hsuan Wei、Robert Leaman、Allan Peter Davis、Carolyn J Mattingly、Thomas C Wiegers、Zhiyong Lu。BioCreative Vっていうバイオ系のコンペのCDRタスク用コーパスやねん。化学物質と病気の関係を抽出するためのリソースやで。Databaseっていうジャーナルの2016年号に載ってるわ。

Jingjing Liu、Panupong Pasupat、Scott Cyphers、Jim Glass。Asgardっちゅう、多言語対話システムのためのポータブルなアーキテクチャの話やねん。2013年のIEEE ICASSP(音声と信号処理の国際学会やで)で発表されて、8386〜8390ページに載ってるわ。

Zihan Liu、Yan Xu、Tiezheng Yu、Wenliang Dai、Ziwei Ji、Samuel Cahyawijaya、Andrea Madotto、Pascale Fung。CrossNERっていう、ドメインをまたいだ固有表現認識(つまり、ある分野で学習したモデルが別の分野でもちゃんと動くか評価するやつやな)の研究やで。2021年のAAAI学会の第35巻、13452〜13460ページに載ってるわ。

Yi Luan、Luheng He、Mari Ostendorf、Hannaneh Hajishirzi。科学的な知識グラフを作るために、エンティティ(固有の概念やな)、関係性、共参照(同じもんを指してる表現の紐付けやで)をマルチタスクでいっぺんに識別する研究やねん。2018年にブリュッセルで開かれたEMNLP(経験的自然言語処理の学会やで)で発表されて、3219〜3232ページに載ってるわ。doi: 10.18653/v1/D18-1360。URLはhttps://aclanthology.org/D18-1360 やで。

Ling Luo、Po-Ting Lai、Chih-Hsuan Wei、Cecilia N Arighi、Zhiyong Lu。BioREDっていう、バイオ医学分野のリッチな関係抽出データセットの話やねん。めっちゃ充実した中身になっとるで。Briefings in Bioinformaticsの23巻5号、bbac282、2022年の論文やわ。

Alexis Mitchell、Stephanie Strassel、Shudong Huang、Ramez Zakhary。ACE 2004多言語トレーニングコーパスやねん。Linguistic Data Consortium(フィラデルフィアにあるデータ提供組織やで)から2005年に出とるわ。

Danielle L Mowery、Sumithra Velupillai、Brett R South、Lee Christensen、David Martinez、Liadh Kelly、Lorraine Goeuriot、Noemie Elhadad、Sameer Pradhan、Guergana Savovaほか。ShARe/CLEF eHealth評価ラボ2014のタスク2の話やねん。要するに、医療テキストから情報を引っ張り出す共通タスクの評価やで。CLEF 2014の論文集に載ってるわ。

Benjamin Nye、Junyi Jessy Li、Roma Patel、Yinfei Yang、Iain J Marshall、Ani Nenkova、Byron C Wallace。医学文献の言語処理を支援するために、患者・介入・アウトカム(PICOっちゅう臨床研究の基本要素やな)をマルチレベルでアノテーションしたコーパスの話やで。2018年のACL学会の論文集、第2018巻、197ページに載ってるわ。NIH Public Accessから出とるで。

OpenAI。GPT-4のテクニカルレポートやねん。2023年に出たやつやで。

Long Ouyang、Jeffrey Wu、Xu Jiang、Diogo Almeida、Carroll Wainwright、Pamela Mishkin、Chong Zhang、Sandhini Agarwal、Katarina Slama、Alex Grayほか。人間のフィードバックを使って言語モデルに指示に従うように学習させる研究やねん。めっちゃ有名なRLHF(人間フィードバックからの強化学習)の論文やで。NeurIPS 2022に載ってるわ。

Xiaoman Pan、Boliang Zhang、Jonathan May、Joel Nothman、Kevin Knight、Heng Ji。なんと282言語もの言語横断的な固有表現タグ付けとリンキングの研究やねん。ほんまにスケールがえげつないで。2017年にバンクーバーで開かれたACL(計算言語学のトップ学会やな)のロングペーパー部門で発表されて、1946〜1958ページに載ってるわ。doi: 10.18653/v1/P17-1178。URLはhttps://aclanthology.org/P17-1178 やで。

Baolin Peng、Chunyuan Li、Pengcheng He、Michel Galley、Jianfeng Gao。GPT-4を使ったインストラクションチューニング(モデルに指示に従う力をつけさせるファインチューニングやな)の研究やで。arXivプレプリント、arXiv:2304.03277、2023年の論文やわ。

---

## Page 13

[](/attach/2868ef9ba3f0132a2eaf2b47cdebe7580755dbcb03dda1f06a022baf3a959a04_p013.png)

### 和訳

ICLR 2024の学会論文として発表

Nadeesha Pereraら(2020)。固有表現認識と関係検出を使ったバイオ情報の抽出についての研究やねん。生物医学のテキストから「これは薬の名前やな」「これは遺伝子やな」って見つけ出して、さらにそいつら同士の関係まで引っ張り出すっていう話や。Frontiers in Cell and Developmental Biologyに載っとるで。

Sampo PyysaloとSophia Ananiadou(2014)。めっちゃ大量の論文から体の部位の名前を自動で見つけ出すっていう研究やな。文献レベルのスケールでやっとるから、ほんまにえげつない量のテキストを処理しとんねん。Bioinformaticsの30巻に掲載や。

Victor Sanhら(2021)。これはめっちゃ大事な研究やで。いろんなタスクをプロンプト付きでまとめて学習させたら、見たことないタスクでもゼロショット——つまり一切お手本なしでもこなせるようになるっていう話やねん。なんでかっていうと、いろんな種類の課題をプロンプト形式で食わせることで、モデルが「タスクの解き方」そのものを学ぶからやな。ICLRで発表されとるで。

David Schindlerら(2021)。科学論文の中で「このソフトウェア使いました」って書いてあるところを見つけ出して、それをナレッジグラフっていう知識のネットワークにまとめたんや。しかも5つ星オープンデータのゴールドスタンダード——つまりお手本中のお手本レベルの品質やねん。ACMの情報・知識管理の国際会議で発表されとる。

Isabel Segura-Bedmarら(2013)。SemEval-2013のタスク9で、バイオ医学のテキストから薬同士の相互作用を抜き出すっていうコンペやな。「この薬とあの薬を一緒に飲んだらどうなるん?」っていう情報を自動で見つける、めっちゃ実用的な研究やで。

Agam Shahら(2023)。金融分野の固有表現認識、つまり金融テキストから会社名とか金額とかを見つけ出すためのデータセットと、弱教師ありモデルを作った研究やねん。FINERって名前で、arXivに上がっとるで。

Larry Smithら(2008)。BioCreative IIっていうコンペの遺伝子名認識タスクの概要報告やな。遺伝子の名前をテキストから見つけ出すっていう、バイオ系NLPのめっちゃ基本的やけど大事なタスクについてまとめとるで。Genome Biologyに載っとる。

Ryan Smithら(2022)。プロンプティングを弱教師あり学習に組み込むっていう研究やねん。弱教師あり学習って何かっていうと、完璧なラベル付きデータがなくても、ざっくりしたルールとかでラベルを自動生成してモデルを学習させる方法やな。そこに言語モデルのプロンプトを絡めて、ループの中に入れたろうっていう発想がおもろいねん。

Amber Stubbsら(2015)。臨床の長期カルテから個人情報を自動で消すシステムについてのコンペの概要やで。i2b2/UTHealthの2014年共有タスクのトラック1やな。患者さんのプライバシーを守るためにめっちゃ重要な研究やねん。Journal of Biomedical Informaticsに掲載。

Weiyi Sunら(2013)。臨床テキストの中の時間関係——「いつ何が起きたか」「この症状はあの治療の前?後?」みたいなのを評価する2012年のi2b2チャレンジについての報告やで。Journal of the American Medical Informatics Associationに載っとる。

Xiaofei Sunら(2023)。ChatGPTをNLP(自然言語処理)のいろんなタスクでどこまでイケるか限界まで試したろう!っていう研究やな。ほんまにどこまでできるんか、ガチで検証しとるで。

Jeniya Tabasumら(2020)。StackOverflow——プログラマーがよう使う質問サイトやな——の投稿からプログラミングコードと固有表現を認識する研究やで。普通のテキストとちゃうて、コードが混ざっとるからめっちゃ難しいんやけど、そこにチャレンジしとるねん。ACL 2020で発表。

Rohan Taoriら(2023)。Stanford Alpacaっていう、Meta社のLLaMAモデルをベースに指示に従えるように仕上げたモデルやねん。GitHubで公開されとって、LLMの民主化にめっちゃ貢献した有名なプロジェクトやで。

Simone TedeschiとRoberto Navigli(2022)。MultiNERDっていう、多言語・多ジャンル・めっちゃ細かい粒度の固有表現認識(ついでに曖昧性解消もできる)データセットを作った研究やな。NAACL 2022のFindingsで発表されとる。いろんな言語に対応しとるから、グローバルに使えるデータセットやで。

---

## Page 14

[](/attach/2868ef9ba3f0132a2eaf2b47cdebe7580755dbcb03dda1f06a022baf3a959a04_p014.png)

### 和訳

ICLR 2024の学会論文として発表

Simone Tedeschi、Valentino Maiorca、Niccolò Campolungo、Francesco Cecconi、Roberto Navigli。WikiNEuRal:多言語の固有表現認識(NER)のためのニューラルと知識ベースを組み合わせたシルバーデータ作成。ほんで、これ何かっていうと、AIの学習データを自動で作る方法を提案してんねん。計算言語学会(ACL)の研究成果発表:EMNLP 2021、pp. 2521–2533、プンタカナ(ドミニカ共和国)、2021年11月。計算言語学会。doi: 10.18653/v1/2021.findings-emnlp.215. URL https://aclanthology.org/2021.findings-emnlp.215.

Hugo Touvronら。Llama:オープンで効率的な基盤言語モデル、2023a。これめっちゃ有名なやつやねん。Metaが出した、誰でも使えるオープンソースの大規模言語モデルやで。

Hugo Touvronら(めっちゃ著者おるな)。Llama 2:オープンな基盤モデルとファインチューニング済みチャットモデル、2023b。Llamaの進化版で、チャット用にも調整されたバージョンやねん。ほんまにえげつない数の研究者が関わってるのが見てわかるやろ。

Asahi Ushio、Leonardo Neves、Vitor Silva、Francesco Barbieri、Jose Camacho-Collados。Twitterにおける固有表現認識:短期的な時間変化に関するデータセットと分析。要するに、Twitterのテキストから人名とか地名とかを見つけ出す技術で、時間が経つとどう変わるかを調べてんねん。アジア太平洋地域計算言語学会第2回大会および第12回自然言語処理国際合同会議、オンライン、2022年11月。計算言語学会。

Özlem Uzuner、Yuan Luo、Peter Szolovits。自動匿名化処理の最先端技術の評価。米国医療情報学会誌、14(5):550–563、2007年。これは医療データから個人情報を自動で消す技術がどんだけイケてるか評価したやつやな。

Özlem Uzuner、Brett R South、Shuying Shen、Scott L DuVall。2010年i2b2/vaチャレンジ:臨床テキストにおける概念・主張・関係。米国医療情報学会誌、18(5):552–556、2011年。病院のカルテとかの文章から大事な情報を抜き出すコンペティションの話やねん。

Christopher Walker、Stephanie Strassel、Julie Medero、Kazuaki Maeda。ACE 2005多言語学習コーパス。言語データコンソーシアム、フィラデルフィア、57:45、2006年。いろんな言語のテキストデータを集めた、自然言語処理の研究に使う定番のデータセットやで。

Xiao Wangら。InstructUIE:統合的な情報抽出のためのマルチタスク指示チューニング、2023a。なんでかっていうと、いろんな情報抽出タスクを一つのモデルでまとめてやろうっていう発想やねん。めっちゃ効率ええやろ。

Yizhong Wangら(これもめっちゃ著者おるわ)。Super-NaturalInstructions:1600以上の自然言語処理タスクに対する宣言的指示による汎化。EMNLP 2022の論文集、pp. 5085–5109、アブダビ(アラブ首長国連邦)、2022年12月。計算言語学会。URL https://aclanthology.org/2022.emnlp-main.340. これ、AIに「こういう風にやってな」って指示書きを大量に用意して、いろんなタスクに対応できるようにしたっていう研究やねん。

Yizhong Wang、Hamish Ivison、Pradeep Dasigi、Jack Hessel、Tushar Khot、Khyathi Raghavi Chandu、David Wadden、Kelsey MacMillan、Noah A. Smith、Iz Beltagy、Hannaneh Hajishirzi。ラクダはどこまで行けるんか?オープンリソースでの指示チューニングの現状を探る、2023b。タイトルがおもろいねんけど、オープンソースのデータや手法でAIの指示学習がどこまでイケるか調べた研究やで。

14

---

## Page 15

[](/attach/2868ef9ba3f0132a2eaf2b47cdebe7580755dbcb03dda1f06a022baf3a959a04_p015.png)

### 和訳

ICLR 2024の学会論文として発表

Yizhong Wangさん、Yeganeh Kordiさん、Swaroop Mishraさん、Alisa Liuさん、Noah A. Smithさん、Daniel Khashabiさん、Hannaneh Hajishirziさん。Self-instruct:言語モデルを自分で作った指示で揃えていく方法やねん。Anna Rogersさん、Jordan Boyd-Graberさん、Naoaki Okazakiさんが編集した、第61回計算言語学会(ACL)の年次大会論文集(第1巻:長い論文のやつ)に載ってて、13484〜13508ページ、2023年7月にカナダのトロントで発表されたやつやで。計算言語学会が出してんねん。doi: 10.18653/v1/2023.acl-long.754。URLはこっち→ https://aclanthology.org/2023.acl-long.754

Zihan Wangさん、Jingbo Shangさん、Liyuan Liuさん、Lihao Luさん、Jiacheng Liuさん、Jiawei Hanさん。CrossWeigh:ちょっと微妙なアノテーション、つまり不完全なラベル付けデータからでも固有表現認識のモデルをうまいこと学習させる方法やねん。2019年の自然言語処理における経験的手法に関する学会(EMNLP-IJCNLP)の論文集、5157〜5166ページに載ってるで、2019年発表や。

Jason Weiさん、Maarten Bosmaさん、Vincent Zhaoさん、Kelvin Guuさん、Adams Wei Yuさん、Brian Lesterさん、Nan Duさん、Andrew M Daiさん、Quoc V Leさん。ファインチューニングした言語モデルはゼロショット学習者になれるっちゅう話やねん。つまり、ちゃんと微調整したモデルは、見たことないタスクでもいきなりこなせるようになるっちゅうことや。表現学習の国際学会(ICLR)、2021年発表。

Xiang Weiさん、Xingyu Cuiさん、Ning Chengさん、Xiaobin Wangさん、Xin Zhangさん、Shen Huangさん、Pengjun Xieさん、Jinan Xuさん、Yufeng Chenさん、Meishan Zhangさんら。ChatGPTとおしゃべりするだけでゼロショットの情報抽出ができるっちゅう研究やねん。なんもお手本見せんでも、チャットするだけで必要な情報を引っ張り出せるんやで。arXivプレプリント、arXiv:2302.10205、2023年。

Ralph Weischedelさん、Martha Palmerさん、Mitchell Marcusさん、Eduard Hovyさん、Sameer Pradhanさん、Lance Ramshawさん、Nianwen Xueさん、Ann Taylorさん、Jeff Kaufmanさん、Michelle Franchiniさんら。OntoNotes リリース5.0、LDC2013T19。これはめっちゃ有名な言語データのコーパスやねん。Linguistic Data Consortium、フィラデルフィア、PA、23巻170ページ、2013年。

Ania Wróblewskaさん、Agnieszka Kaliskaさん、Maciej Pawłowskiさん、Dawid Wiśniewskiさん、Witold Sosnowskiさん、Agnieszka Ławrynowiczさん。TasteSet:レシピのデータセットと食べ物の固有表現を認識するためのベンチマークやねん。つまり料理のレシピから食材とか料理名とかを見つけ出すタスクのデータセットを作ったっちゅう話や。arXivプレプリント、arXiv:2204.07775、2022年。

Yonghui Wuさん、Min Jiangさん、Jun Xuさん、Degui Zhiさん、Hua Xuさん。深層学習モデルを使った臨床テキストからの固有表現認識やねん。医療のカルテとかから病名とか薬の名前とかをディープラーニングで抜き出す研究や。AMIA年次シンポジウム論文集、2017巻、1812ページ。アメリカ医療情報学会、2017年。

Junjie Yeさん、Xuanting Chenさん、Nuo Xuさん、Can Zuさん、Zekai Shaoさん、Shichun Liuさん、Yuhan Cuiさん、Zeyang Zhouさん、Chao Gongさん、Yang Shenさんら。GPT-3とGPT-3.5シリーズのモデルの能力をめっちゃ徹底的に分析したっちゅう論文やねん。ほんまにいろんな角度からこのモデルらが何ができて何があかんのかを調べ尽くしてるんやで。arXivプレプリント、arXiv:2303.10420、2023年。

15

---

## Page 16

[](/attach/2868ef9ba3f0132a2eaf2b47cdebe7580755dbcb03dda1f06a022baf3a959a04_p016.png)

### 和訳

ICLR 2024の学会論文として発表

A 付録

A.1 ケーススタディ

**エンティティタイプの言い換えに対する敏感さについて**

ひとつのエンティティタイプって、いろんな言い方ができるやん?こういう場面では、意味が似てるエンティティタイプを入れても、モデルがちゃんとブレずに同じ予測を返してくれるんが大事やねん。Fig. 7に感度分析の例を載せとるで。見てみると、UniNER-7B-typeは意味がよう似たエンティティでも認識に失敗することがあるんよ。一方で、UniNER-7B-definitionの方は、ワイらのUniversal NERベンチマークではスコア的にはイマイチやったけど、エンティティタイプの言い換えにはめっちゃ強いねん。なんでかっていうと、定義文を使うと標準的なNERベンチマークのスコアは下がるかもしれんけど、あんまり数が多くないマイナーなエンティティタイプに対しては逆にええ結果が出る可能性があるっちゅうことやな。

**エンティティタイプの感度分析**

テキスト:I'm visiting Los Angeles next week.(来週ロサンゼルスに行くねん。)

ユーザー:テキスト中の「city(都市)」を教えて?

UniNER-7B-type: ["Los Angeles"]

UniNER-7B-definition: ["Los Angeles"]

ユーザー:テキスト中の「place(場所)」を教えて?

UniNER-7B-type: [](何も見つけられへん…)

UniNER-7B-definition: ["Los Angeles"]

ユーザー:テキスト中の「metropolis(大都市)」を教えて?

UniNER-7B-type: [](またスカや…)

UniNER-7B-definition: ["Los Angeles"]

ユーザー:テキスト中の「urban area(都市圏)」を教えて?

UniNER-7B-type: [](あかんわ…)

UniNER-7B-definition: ["Los Angeles"]

ユーザー:テキスト中の「human settlement(人が住んでるとこ)」を教えて?

UniNER-7B-type: [](全然あかん…)

UniNER-7B-definition: ["Los Angeles"]

Figure 7:UniNER-7Bの、いろんなエンティティタイプに対する感度をまとめたやつ。緑が正解で、赤が不正解やで。

見てわかる通り、typeモデルは「city」ってドンピシャで聞いたら答えられるけど、「place」とか「metropolis」みたいにちょっと言い方変えたらもうアカンねん。definitionモデルはその辺ほんまにしっかりしとるわ。

**いろんなエンティティタイプの認識能力について**

下のコードはHuggingfaceライブラリを使ってテキスト生成するやつやで:

```python

from transformers import GPT2Tokenizer, GPT2LMHeadModel

tokenizer = GPT2Tokenizer.from_pretrained('gpt2')

model = GPT2LMHeadModel.from_pretrained('gpt2')

input_text = "This is a simple program"

input_ids = tokenizer.encode(input_text, return_tensors='pt')

output = model.generate(input_ids, max_new_tokens=50)

generated_text = tokenizer.decode(output[0], skip_special_tokens=True)

```

Figure 8:UniNERがコードの中からいろんな種類のエンティティをちゃんと抜き出せるか試すためのコードスニペットやで。

ほんで、このコードについてUniNERとやりとりした結果を次に載せとるで:

---

## Page 17

[](/attach/2868ef9ba3f0132a2eaf2b47cdebe7580755dbcb03dda1f06a022baf3a959a04_p017.png)

### 和訳

ICLR 2024の学会論文として発表済みやで

ユーザー:このテキストの中で「ライブラリ」を表してるもんは何?

アシスタント:["transformers"]

ユーザー:「ローカル変数」を表してるもんは?

アシスタント:["input_text", "input_ids", "output", "generated_text"]

ユーザー:「グローバル変数」を表してるもんは?

アシスタント:[]

ユーザー:「メソッド」を表してるもんは?

アシスタント:["encode", "generate", "decode"]

ユーザー:「クラス」を表してるもんは?

アシスタント:["GPT2Tokenizer", "GPT2LMHeadModel"]

ちょっとした間違いはあるねん(例えば、from_pretrainedがメソッドとして認識されてへんとか)、けどこのケーススタディ見てもらったらわかるように、うちのモデルはいろんな種類のエンティティをちゃんと捉える力があるっていうのがバッチリ示されとるわけよ。

B 全評価結果

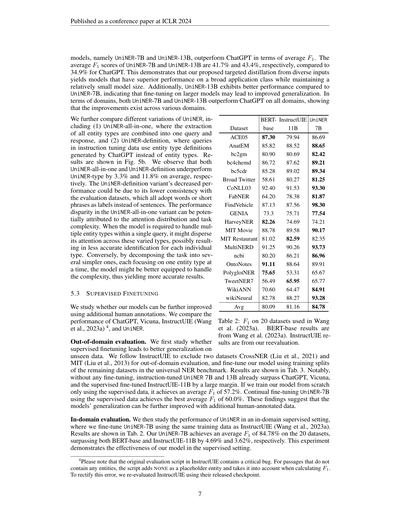

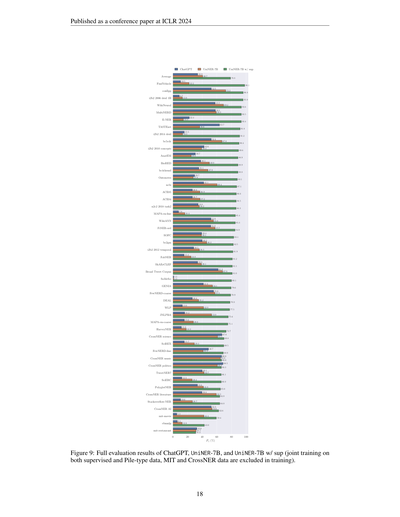

ChatGPT、UniNER-7B-type、UniNER-7B-sup+typeの全結果は図9に載せとるから見てな。

C データの統計情報

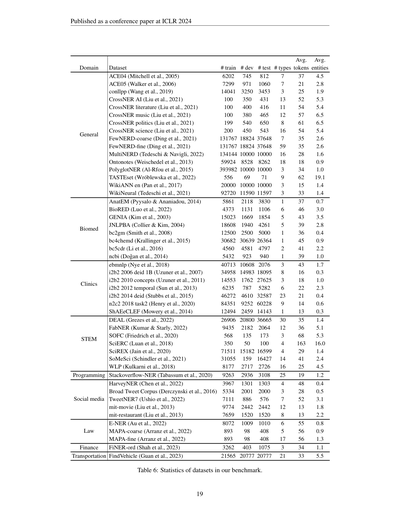

Universal NERの全データセットの統計情報を表6にまとめとるで。訓練データ・開発データ・テストデータのインスタンス数、エンティティタイプの数、入力テキストの平均トークン数、それから各インスタンスあたりの平均エンティティ数が入っとるねん。

17

---

## Page 18

[](/attach/2868ef9ba3f0132a2eaf2b47cdebe7580755dbcb03dda1f06a022baf3a959a04_p018.png)

### 和訳

ほな見てってな!これはICLR 2024っていう、AI系のめっちゃ有名な学会で発表された論文の図やねん。

**図9**: ChatGPT、UniNER-7B、それからUniNER-7B w/ sup(これは教師ありデータとPileタイプのデータを一緒に使って学習させたやつやねんけど、MITとCrossNERのデータは学習から外してるで)の、全部の評価結果をまとめた図やな。

18ページ目やで。

で、この棒グラフなんやけど、横軸にめっちゃたくさんのデータセット(固有表現認識、つまり文章の中から人名とか地名とかを見つけ出すタスクのベンチマークやな)が並んでて、縦軸がF1スコア(精度みたいなもんやと思ってくれたらええで、100%に近いほど優秀ってことや)になってんねん。

結果を見たらな、まず**平均スコア**のとこやけど:

- ChatGPT(緑)が **33.9%**

- UniNER-7B(オレンジ)が **40.7%**

- UniNER-7B w/ sup(青)が **98.1%**

ほんまにえぐいのが、UniNER-7B w/ supの青いやつやねん。ほとんどのデータセットで**80%〜96%**くらい叩き出してて、めっちゃ強いねん。右側に行くほどスコア下がっていくんやけど、それでも大体のとこで60%以上はキープしとるわ。

一方でChatGPTとUniNER-7B(教師なし版)は、データセットによってバラバラで、ええとこもあるけど10%台とか一桁のとこもあって、なかなか安定せえへんねん。例えばFindVehicleとかconllみたいなデータセットやと50〜70%くらい出してるけど、CrossNER系とかStackoverflow-NERとかmit-restaurantみたいなやつやと10%前後まで落ちてまうねん。

つまり何が言いたいかっていうとな、**教師ありデータを混ぜて学習させたら(w/ sup)、めっちゃ性能上がるで**ってことやねん。ChatGPTと比べても、パラメータ数は7Bで全然小さいのに、ちゃんとしたデータで鍛えたらぶっちぎりの性能出せるっちゅう話や。ほんま、データの質と学習の仕方が大事やなって思わされる結果やで。

---

## Page 19

[](/attach/2868ef9ba3f0132a2eaf2b47cdebe7580755dbcb03dda1f06a022baf3a959a04_p019.png)

### 和訳

せやねん、これはICLR 2024っていうめっちゃ有名な学会で発表された論文やねん。

ほんで、ここに載ってるんは「ベンチマーク」っちゅう、いろんなデータセットの統計情報をまとめた表(表6)やで。

要するにな、固有表現認識(NER)っていう、テキストの中から人名とか地名とか組織名みたいな「特定の名前」を見つけ出すタスクに使うデータセットを、ドメイン(分野)ごとにまとめてるねん。

ドメインはこんな感じで分かれてるで:

- **一般(General)**:ACE04、ACE05、CoNLLpp、CrossNER(AI・文学・音楽・政治・科学)、FewNERD(粗い粒度・細かい粒度)、MultiNERD、Ontonotes、PolyglotNER、TASTEset、WikiANN英語版、WikiNeuralとか。普通のニュースとかWikipediaみたいなテキストが多いやつやな。

- **バイオメディカル(Biomed)**:AnatEM、BioRED、GENIA、JNLPBA、bc2gm、bc4chemd、bc5cdr、ncbi、ebmnlp、i2b2シリーズ(2006年の匿名化、2010年の概念、2012年の時間表現、2014年の匿名化)、n2c2 2018タスク2、ShAReCLEFとか。医学とか生物学の論文やカルテから作ったやつやねん。

- **STEM(理系全般)**:DEAL、FabNER、SOFC、SciERC、SciREX、SoMeSci、WLPとか。科学技術系のテキストやな。

- **プログラミング**:Stackoverflow-NERだけやけど、プログラマーがよう使うStack Overflowから作ったデータやで。

- **ソーシャルメディア**:HarveyNER、Broad Tweet Corpus、TweetNER7とか。ツイッターみたいなSNSの投稿から作ったやつやな。

- **臨床(Clinics)**:mit-movie、mit-restaurantとか。映画やレストランの口コミ的なテキストやで。

- **法律(Law)**:E-NER、MAPA-coarse(粗い分類)、MAPA-fine(細かい分類)とか。法律文書からのデータやな。

- **金融(Finance)**:FiNER-ordっちゅう、金融関連のテキストから固有表現を見つけるやつ。

- **交通(Transportation)**:FindVehicleっていう、車両を見つけるためのデータセットや。

表の各列が何を意味してるかっていうとな:

- **# train**:学習に使うデータの数

- **# dev**:開発(チューニング)に使うデータの数

- **# test**:テストに使うデータの数

- **# types**:固有表現の種類の数(例えば「人名」「地名」とかが何種類あるかってこと)

- **Avg. tokens**:1つのデータあたりの平均トークン数(だいたい単語数みたいなもんやな)

- **Avg. entities**:1つのデータあたりの平均固有表現数(名前とかがいくつ見つかるかってこと)

なんでかっていうと、この表を見たら各データセットの規模感とか難しさがパッと分かるようになってるねん。例えばMultiNERDは学習データが13万4千もあってめっちゃデカいけど、SOFCは100しかなくてちっちゃいとか。固有表現の種類も、FewNERD-fineは59種類もあってめっちゃ細かいけど、bc2gmとかbc4chemdは1種類だけとか。データセットによって全然性格が違うんが分かるやろ?

ほんまにようまとまった一覧表やで!

---

![]()

1 / 1