<<

Knowledge Injection via Prompt Distillation

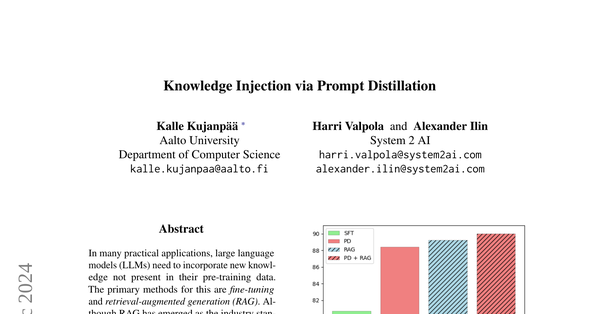

- RAGは業界標準となっているが、fine-tuningはまだRAGと同等の性能を達成できていない

起:研究の背景と問題点

現在、言語モデル(LLMs)は特定の知識を取り入れる必要がありますが、主にファインチューニングと呼ばれる手法が用いられています。しかし、この方法では、最新の知識を効果的に取り入れることが難しいという問題があります。

承:新しいアプローチの提案

この論文では、「プロンプト蒸留」という新しいファインチューニング手法を提案します。これにより、モデルが新しい知識をより効率的に吸収できることを示しました。具体的には、質問と答えのペアを生成し、教師モデルから学生モデルに知識を蒸留することで、モデルの能力を向上させます。

転:実験結果と比較

実験により、提案したプロンプト蒸留手法は、従来のファインチューニング手法よりも優れた性能を発揮し、Retrieval-Augmented Generation(RAG)と同等の結果を出すことができました。この結果は、プロンプト蒸留が新しい知識の吸収において非常に効果的であることを示しています。

結:研究の新規性と今後の展望

この研究の新規性は、ファインチューニング技術がRAGと肩を並べられるレベルに達したことです。これにより、モデルは新しい知識を自身の内部に蓄積できるようになり、将来的には自己改善するエージェント的なLLMの開発が期待されます。想像してみてください、モデルが自ら経験から学び、進化し続ける姿を!これは、まるでAIが学校に通う学生のように、どんどん賢くなっていくという未来を示唆しています。

![]()

1 / 1

100%