<<

2510.20345v1.pdf

---

## Page 1

[](/attach/15ee9247f9042f177a9e516338a77d3209ed0118a907940805adc8087501d7b2_p001.png)

### 和訳

LLM使ったナレッジグラフ構築についてのサーベイ論文やで

ICAIS 2025で発表された論文

LLMで進化するナレッジグラフ構築:サーベイ論文

Haonan Bian

西安電子科技大学(中国・西安)

---

**要旨(アブストラクト)**

ナレッジグラフ(KG)ってのはな、構造化された知識を表現したり推論したりするための、めっちゃ基本的なインフラとしてずっと使われてきたもんやねん。ほんで最近、大規模言語モデル(LLM)が出てきたことで、KGの作り方がガラッと変わってきてん。今まではルールベースとか統計的な手法でやってたんやけど、言語ドリブンで生成ベースのフレームワークに移ってきとるんよ。

このサーベイではな、LLMを使ったナレッジグラフ構築の最新の進歩をまるっとまとめてんねん。具体的には、LLMが従来の3層パイプライン——オントロジー設計、知識抽出、知識統合——をどないして変えていっとるかを体系的に分析しとるで。

まずは従来のKG手法をおさらいして基礎固めして、そっからLLMベースの新しいアプローチを2つの視点で見ていくで。ひとつは**スキーマベースのパラダイム**で、これは構造とか正規化とか一貫性を重視するやつ。もうひとつは**スキーマフリーのパラダイム**で、こっちは柔軟性とか適応力、新しい知識の発見を重視するやつやな。各段階ごとに代表的なフレームワークをまとめて、その技術的な仕組みを分析して、どこに限界があるかも指摘してるで。

最後に、今後の重要なトレンドと研究の方向性も示してんねん。LLMのためのKGベース推論とか、エージェントシステム向けの動的な知識メモリとか、マルチモーダルKG構築とかやな。この体系的なレビューを通じて、LLMとナレッジグラフの間で進化し続ける関係性を明確にして、記号的な知識工学とニューラルな意味理解を橋渡しして、適応的で説明可能な賢い知識システムの開発につなげたいっちゅう話やねん。

---

**1 はじめに**

ナレッジグラフ(KG)っちゅうのはな、構造化された知識を表現して、統合して、推論するための土台としてずーっと活躍してきたもんやねん。意味検索とか質問応答とか科学的発見とか、いろんな知的アプリケーションを支える統一的な意味基盤を提供してくれとるんよ。

従来のKG構築パイプラインは、大きく分けて3つの要素でできてんねん:**オントロジー設計**、**知識抽出**、**知識統合**や。大規模な知識整理ではそれなりに成果出してきたんやけど、従来の手法(Zhong et al. (2023)とかZhao et al. (2024)とか)にはずっと3つの課題がつきまとっとるんよ。

**(1) スケーラビリティとデータの希薄さ**——ルールベースや教師あり学習のシステムは、ドメインをまたいだ汎化がなかなかうまくいかへんのよ。

**(2) 専門家への依存と硬直性**——スキーマとかオントロジーの設計には人間の専門家の手がめっちゃかかるし、柔軟に変えにくいんよ。

**(3) パイプラインの分断**——構築の各段階がバラバラに処理されるから、エラーがどんどん積み重なっていくねん。

この辺の問題があるから、自己進化型で大規模でダイナミックなKGの開発がなかなか進まへんかったんよな。

ほんでここに、大規模言語モデル(LLM)の登場や!これがまさに革命的なパラダイムをもたらしてくれとるんよ。大規模な事前学習と驚異的な汎化能力によって、LLMは3つの重要なメカニズムを実現してくれるんやで。

**(1) 生成的な知識モデリング**——非構造化テキストから直接、構造化された表現を生み出せるんよ。

**(2) 意味的な統合**——自然言語を基盤にして、バラバラな知識ソースをまとめてくれるんや。

**(3) 指示ドリブンのオーケストレーション**——プロンプトベースのやり取りで、複雑なKG構築のワークフロー全体を指揮してくれるんやで。

つまりな、LLMはもはや単なるテキスト処理ツールの枠を超えて、自然言語と構造化された知識をシームレスにつなぐ認知エンジンへと進化しとるっちゅうことやねん(Zhu et al. (2024b)、Zhang & Soh (2024)とか参照)。

---

## Page 2

[](/attach/15ee9247f9042f177a9e516338a77d3209ed0118a907940805adc8087501d7b2_p002.png)

### 和訳

ICAIS 2025の学会論文として発表

この流れはな、めっちゃ大きなパラダイムシフトやねん。今まではルールベースで、パイプライン式にガチガチ組んでたシステムやったんやけど、それがLLM(大規模言語モデル)が引っ張る、統合的で柔軟なフレームワークに変わっていってんねん。つまり、知識を集めること、整理すること、推論することが、お互いに関係し合いながら、自分で生み出して自分で磨き上げるエコシステムの中で動くようになったっちゅうわけや(Pan et al., 2024)。

こういう急速な進歩を踏まえて、この論文ではLLMで知識グラフ(ナレッジグラフ)を作る研究の包括的なサーベイを出してんねん。オントロジーの設計から、知識の抽出、統合まで、最近の研究を体系的にレビューして、新しい手法のパラダイムを分析して、LLMと知識表現が交わるところの未解決の課題とか将来の方向性を示してるで。

この論文の構成はこんな感じやで:

- **セクション2**では、LLM登場前の従来の知識グラフ構築の基礎を紹介してるで。オントロジーの設計、知識の抽出、統合の技術をカバーしてんねん。

- **セクション3**では、LLMを使ったオントロジー構築をレビューしてるで。トップダウン型(LLMがオントロジー作りのアシスタントになるやつ)とボトムアップ型(知識グラフをLLMのために使うやつ)の両方のパラダイムを含んでるで。

- **セクション4**では、LLM主導の知識抽出について紹介してるで。スキーマ(型)ありの方法とスキーマなしの方法を比較してんねん。

- **セクション5**では、LLMを活用した知識の統合(フュージョン)について議論してるで。スキーマレベル、インスタンスレベル、それからハイブリッドなフレームワークに焦点を当ててるで。

- **セクション6**では、将来の研究の方向性を探ってるで。知識グラフベースの推論、動的な知識メモリ、マルチモーダル(テキスト以外もいける)知識グラフ構築とかやな。

## 2 前提知識

知識グラフ(KG)の構築は、伝統的には3層のパイプラインで進めてたんや。オントロジーの設計、知識の抽出、知識の統合の3つやな。大規模言語モデル(LLM)が登場する前は、これらの段階はルールベース、統計的手法、記号的アプローチで実装されとったんや。このセクションでは、その従来の方法論をざっくり振り返って、この後のLLMを使った知識グラフ構築の話につなげるための下地を作るで。

### 2.1 オントロジー設計

オントロジー設計(OE)っていうのは、ある分野の概念とか関係性とか制約を正式に定義する作業のことやねん。LLM以前の時代は、基本的にその分野の専門家が手作業で作ってたんや。Protégéみたいなセマンティックウェブのツールを使ったり、METHONTOLOGYとかOn-To-Knowledgeみたいな確立された方法論に沿ったりしてな。こういう体系的なプロセスは、概念の正確さと論理的な整合性をめっちゃ重視してたんやけど、専門家がガッツリ介入せなあかんかったんや。

Zouaq & Nkambou (2010)がまとめてるけど、この時期のオントロジー設計は、人間がガチで監督するスタイルで、スケーラビリティ(規模の拡大対応)がほんまに限られとったんや。その後、半自動的なアプローチ、いわゆるオントロジー学習っていうやつが出てきて、テキストデータからオントロジーの構造を導き出そうとしたんや(Asim et al., 2018のレビュー参照)。せやけど、NeOnみたいな進んだフレームワークでも、オントロジーの進化とか、モジュールの再利用とか、動的な適応にはなかなか苦戦してたんやな。Kotis et al. (2020)が指摘してるけど、従来のオントロジー設計のフレームワークは精密さと形式的な健全さはあったんやけど、大規模やったり常に変化し続ける知識領域に対しては、柔軟性と効率性がイマイチやってんな。

### 2.2 知識抽出

知識抽出(KE)は、構造化されてないデータとか半構造化データからエンティティ(実体)とか関係とか属性を見つけ出すことが目的やねん。初期のアプローチは、人間が手作業で作った言語ルールとかパターンマッチングに頼ってたんや。解釈しやすいのはええんやけど、もろくて特定の分野にしか使えへんかったんやな。記号的・ルールベースのシステムから統計的・ニューラルな手法への進化は、Pai et al. (2024)が体系的にまとめてるで。

ディープラーニングのアーキテクチャ、たとえばBiLSTM-CRFとかTransformerベースのモデルが出てきたことで、データ駆動型の特徴学習へのパラダイムシフトが起きたんや。これはYang et al. (2022b)が議論してるとこやな。Detroja et al. (2023)の包括的な分析では、教師あり、弱教師あり、教師なしの関係抽出のパラダイムをさらに分類してて、アノテーション(ラベル付け)されたデータへの依存度とか、分野をまたいだ汎化性能の限界を強調してるで。

---

## Page 3

[](/attach/15ee9247f9042f177a9e516338a77d3209ed0118a907940805adc8087501d7b2_p003.png)

### 和訳

ICAIS 2025の学会論文として発表

まとめると、昔ながらの知識抽出(KE)の手法ってのは、今のデータ抽出パイプラインの技術的な土台を作ってくれたんやけど、結局のところデータが足りへん問題、応用力の弱さ、それからエラーがどんどん積み重なっていく問題――こういう限界からは抜け出せへんかったんよな。ほんで、この限界があったからこそ、後のセクションで出てくるLLM(大規模言語モデル)ベースのアプローチが求められるようになったっちゅうわけや。

2.3 知識融合

知識融合(KF)ってのは何かっていうと、バラバラの知識ソースをひとつのまとまりのある、矛盾のないグラフにまとめ上げることやねん。重複とか、情報同士のぶつかり合いとか、形式がバラバラやとか、そういう問題を解決していくんやな。特に大事なサブタスクが「エンティティアライメント」ってやつで、これは異なるデータセットに出てくるエンティティ(実体)が、現実世界で同じものを指してるかどうかを判定する作業やねん。

昔ながらのアプローチは、文字の見た目や構造の似てる度合いに頼ってたんや。Zengら(2021)のレビューにまとまっとるで。そこに表現学習が登場して、埋め込みベースの技術が使えるようになったわけや。これは共有ベクトル空間の中でエンティティを揃えるっちゅう手法で、スケーラビリティと自動化がめっちゃ向上したんよ。Zhuら(2024a)のサーベイに詳しいで。特定の分野への応用例としては、Yangら(2022a)が構造・属性・関係の類似性を組み合わせたマルチ特徴量融合の戦略を見せてくれとる。あとLiuら(2022)みたいなグラフレベルのモデルは、意味的な手がかりもさらに取り込んで、アライメントの頑健さを高めてるんやな。

こういう進歩はあったんやけど、従来の融合パイプラインはいまだに意味の違い(セマンティック異質性)、大規模な統合、そして知識の動的な更新っていう課題に苦しんどるんよ。ほんで今、LLMベースの融合フレームワークがまさにこういう課題を解決しようとして設計されてきとるっちゅうわけや。

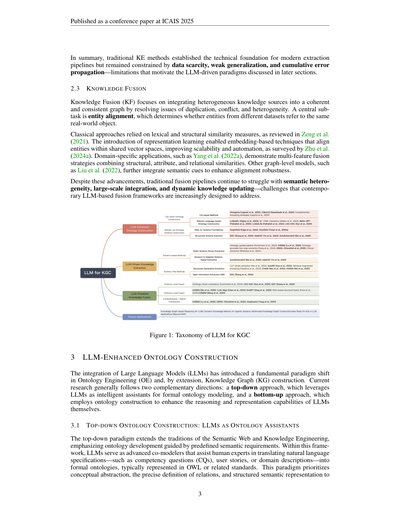

図1:LLMによるナレッジグラフ構築(KGC)の分類体系

3 LLMを活用したオントロジー構築

大規模言語モデル(LLM)の統合によって、オントロジー工学(OE)、ひいてはナレッジグラフ(KG)構築において根本的なパラダイムシフトが起きとるんよ。今の研究は大きく分けて2つの方向性があるんやけど、これがお互い補い合う関係になっとる。ひとつはトップダウンアプローチで、LLMを賢いアシスタントとして使って形式的なオントロジーをモデリングするやり方。もうひとつはボトムアップアプローチで、オントロジー構築を通じてLLM自体の推論能力や表現力を強化するっちゅうやり方やな。

3.1 トップダウンのオントロジー構築:LLMをオントロジーのアシスタントとして使う

トップダウンのパラダイムは、セマンティックウェブとナレッジエンジニアリングの伝統を引き継いどって、あらかじめ決められた意味的な要件に沿ってオントロジーを開発していくんやな。この枠組みの中で、LLMは高度な「共同モデラー」として働くんよ。つまり、人間の専門家が自然言語で書いた仕様書――コンピテンシークエスチョン(CQ)とかユーザーストーリーとかドメインの説明文とか――を、OWLとかその関連規格で表現された形式的なオントロジーに変換するのを手伝うわけや。このパラダイムで大事にされとるのは、概念の抽象化、関係の正確な定義、そして構造化された意味表現やねん。

---

## Page 4

[](/attach/15ee9247f9042f177a9e516338a77d3209ed0118a907940805adc8087501d7b2_p004.png)

### 和訳

ICAIS 2025の学会論文として発表

後に続く知識の抽出やインスタンスの投入が、ちゃんと筋の通った論理的な制約に沿うようにするんが大事やねん。

3.1.1 コンピテンシー・クエスチョン(CQ)ベースのオントロジー構築

CQベースの方法っちゅうのは、「こういうことが知りたいねん」っていう要求から出発して、自動的にオントロジー(知識の体系図みたいなもんやな)を作っていくやり方やねん。ここではLLM(大規模言語モデル、つまりめっちゃ賢いAIのことや)が、CQとかユーザーストーリーを読み解いて、その分野特有の概念とか属性、関係性を見つけ出して、分類して、きちっと形式化してくれるわけや。

先駆けとなったフレームワークのOntogenia(Lippolisら、2025a)は、メタ認知プロンプティングっちゅう手法をオントロジー生成に持ち込んだんやけど、これがなかなかすごくてな、モデルが自分自身で「あ、ここおかしいな」って振り返って構造を直す、いわば自己反省機能を持たせたんや。オントロジー設計パターン(ODP)も組み込むことで、Ontogeniaは生成されるオントロジーの一貫性と複雑さの両方をレベルアップさせたんやで。同じような流れで、CQbyCQフレームワーク(Saeedizade & Blomqvist、2024)は、LLMがCQやユーザーストーリーをOWL準拠のスキーマ(知識を記述するための標準的なフォーマットやな)に直接変換できることを実証して、要求から構造化されたオントロジーモデルへの移行を自動化できるって示したんや。

これらの進展を踏まえて、Lippolisら(2025b)は2つの補完的なプロンプト戦略を提案してん。一つは「記憶なし」アプローチでモジュールごとにバラバラに作っていく方法、もう一つはOntogeniaにヒントを得た振り返り型の反復手法や。実験で検証してみたら、LLMは自律的にクラス(カテゴリみたいなもん)、オブジェクトプロパティ(モノ同士の関係)、データプロパティ(モノの属性)を特定できて、それに対応する論理的な公理(ルールみたいなもんやな)も生成できることがわかったんや。しかもその品質が、駆け出しの人間のモデラーと同レベルっちゅうから驚きやろ。総合すると、これらの研究によって、CQの作成・検証からオントロジーの実体化まで、ライフサイクル全体をカバーする半自動のオントロジー構築パイプラインが出来上がってきたんや。人間の専門家は重要なチェックポイントだけ口出しすればええっちゅう仕組みやな。こうした進化を通じて、LLMは受け身の分析ツールから、オントロジー設計における能動的なモデリングの相棒へと変貌を遂げたわけや。

3.1.2 自然言語ベースのオントロジー構築

CQ駆動型のやり方を超えて、自然言語ベースのオントロジー構築っちゅうのは、整理されてないテキストとか半分だけ構造化されたテキストの山から、意味的なスキーマ(枠組みやな)を直接引き出そうっていうアプローチやねん。わざわざ質問を用意せんでもええっちゅうのがミソや。目指してるのは、LLMが自然言語から概念の階層構造とか関係のパターンを自力で見つけ出して、テキストの記述から形式的な論理表現へダイレクトに変換することやな。

この分野の基礎となる研究——Saeedizade & Blomqvist(2024)やLippolisら(2025b)——では、GPT-4の性能を体系的に評価して、その出力が初心者レベルの人間モデラーの品質に迫ることを確認したんや。つまり「知的オントロジーアシスタント」が現実的に使えるってことを裏付けたわけやな。LLMs4OLフレームワーク(Giglouら、2023)は、汎用的な分野でLLMが概念の特定、関係の抽出、意味パターンの導出をちゃんとできることをさらに検証してん。同様に、Mateiu & Groza(2023)は、ファインチューニング(追加学習やな)したモデルを使って、自然言語をProtégéみたいな既存のオントロジーエディタ上でOWLの公理に直接変換できることを示したんや。

最近のシステムでは、NeOn-GPT(Fathallahら、2025)やLLMs4Life(Fathallahら、2024)が、オントロジーの再利用と適応的な改良を統合した、エンドツーエンドのプロンプト駆動型ワークフローを導入して、複雑な科学分野(ライフサイエンスとかな)で深くて一貫性のあるオントロジー構造を構築できるようにしたんや。一方で、LKD-KGC(Sunら、2025)みたいな軽量フレームワークは、文書の要約から抽出したエンティティタイプをクラスタリングすることで、オープンドメインのナレッジグラフ用スキーマをサクッと作れるようにしてるんやで。

まとめると、LLM支援によるオントロジー構築のトップダウン研究は、意味的な一貫性、構造の完全性、そして人間とAIの協働を重視してて、従来の知識工学がもっと賢い、言語駆動型のパラダイムへと大きく進化してきたことを示してるんやな。

3.2 ボトムアップ型オントロジースキーマ構築:LLMのためのナレッジグラフ

ボトムアップの方法論は、大規模言語モデル(LLM)時代の到来によるパラダイムシフト、特にRAG(検索拡張生成、つまりAIが回答する前にまず関連情報を検索してくる仕組みやな)フレームワークの中でめっちゃ注目されてきてるんや。このパラダイムでは、ナレッジグラフはもはや人間が見るための静的な構造化知識の倉庫やないねん。むしろ、LLMに事実に基づいた裏付けと構造化されたメモリを提供する動的なインフラとして機能するようになったんや。なんでかっていうと、

---

## Page 5

[](/attach/15ee9247f9042f177a9e516338a77d3209ed0118a907940805adc8087501d7b2_p005.png)

### 和訳

ICAIS 2025の学会論文として発表

研究のフォーカスがな、人間が手作業でオントロジー(知識の体系図みたいなもんや)の階層構造を設計するんやなくて、整理されてないデータとか半端に整理されたデータから自動的にスキーマ(データの設計図やな)を作り出す方向にシフトしてきてんねん。この進化はな、3つの段階に分けて説明できるで。

初期の研究やと、GraphRAG(Edgeら、2024)とかOntoRAG(Tiwariら、2025)がデータ駆動型のオントロジー構築の土台を作ったんや。こいつらのアプローチはな、まず生のテキストからオープン情報抽出っていう方法で個々の事実レベルのグラフを作って、ほんでそこからクラスタリングとか一般化をして、抽象的な概念とか関係性を引っ張り出すねん。この「データからスキーマへ」っていうプロセスがな、現場の知識を再利用できる概念的な構造に変換するわけや。要するに、大量のデータからオントロジーの青写真が自然と生まれてくるっちゅうことを示したんやな。

この土台の上にな、EDC(Extract–Define–Canonicalize:抽出して、定義して、正規化する)フレームワーク(Zhang & Soh、2024)が来て、パイプラインを3段階のプロセスに進化させたんや。オープン抽出、意味の定義、ほんでスキーマの正規化っちゅう流れやな。これによって、自動的に作られたスキーマを既存のオントロジーに合わせたり、既存の構造がない場合は新しいのを作ったりできるようになったんや。さらにこの柔軟性を広げたのがAdaKGC(Yeら、2023)で、こっちはスキーマが動的に変わっていく問題に取り組んでんねん。モデルを一から学習し直さんでも、新しい関係性とかエンティティの種類を追加できるようにしたんや。まとめるとな、これらの進歩は静的なスキーマ構築から、変化し続ける知識環境の中での継続的なスキーマ適応へとフォーカスを移したっちゅうことやな。

もっと最近の取り組みはな、アルゴリズムの試作品レベルを超えて、実際に使えるナレッジシステムへと進んでんねん。例えばAutoSchemaKG(Baiら、2025)は、スキーマベースとスキーマフリーの両方のやり方を一つの統合アーキテクチャに組み込んで、企業規模のナレッジグラフをリアルタイムで生成・進化させることをサポートしてんねん。この段階ではな、ナレッジグラフはLLM(大規模言語モデル)にとっての外部知識メモリみたいな役割を果たすわけや。意味的な完全性よりも、事実のカバー範囲、スケーラビリティ、メンテナンスのしやすさを優先してるんやな。この変化はオントロジー構築の実用的な方向転換を示してて、知識をめっちゃ使うアプリケーションでのLLMの推論力と解釈可能性に貢献することを重視してるんや。

まとめるとな、ボトムアップ型のオントロジースキーマ構築は、LLMと知識工学の関係性を再定義してるんやで。フォーカスが「オントロジー工学のためのLLM」から「LLMのためのオントロジーとナレッジグラフ」へと進化してんねん。トップダウン型のアプローチが意味モデリング、論理的一貫性、専門家のガイドに基づく整合性を重視して、LLMをオントロジー設計の賢いアシスタントとして位置づけてるのに対してな、ボトムアップ型は自動抽出、スキーマの帰納的生成、動的進化を優先してるんや。この流れはな、自己更新できて、解釈可能で、スケーラブルな知識エコシステムへと進んでいって、LLMの根拠付けと推論能力を強化するっちゅう方向に向かってるんやな。

4 LLMによる知識抽出

最近の研究の進歩を体系的に調べてみるとな、LLMによる知識抽出の方法論は2つの大きなパラダイムに沿って進化してきたことがようわかるねん。一つはスキーマベースの抽出で、これは明確な構造的ガイドラインに従って動くやつや。もう一つはスキーマフリーの抽出で、あらかじめ決められたテンプレートの制約を超えていくやつやな。前者は正規化、構造の一貫性、意味的な整合性を重視してて、後者は適応性、オープンさ、探索的な発見を優先してるんや。この2つのパラダイムを合わせることで、LLMベースの知識抽出における現代の研究の全体像が見えてくるっちゅうわけや。

4.1 スキーマベースの手法

スキーマベース抽出の中心的な考え方はな、明確なナレッジスキーマに頼るっちゅうことやねん。このスキーマが構造的なガイダンスと意味的な制約の両方を抽出プロセスに与えてくれるんや。このパラダイムの中ではな、研究の流れに明確な進化が見られるで。静的なオントロジーの青写真を使うところから、適応的で動的に進化するスキーマフレームワークへと移ってきてんねん。

4.1.1 静的スキーマ駆動型の抽出

LLMによる知識抽出の初期の研究ではな、あらかじめ定義された静的なスキーマを使って、抽出プロセスをガチガチに制約するやり方が主流やったんや。このパラダイムではな、オントロジーが固定された意味的な背骨みたいな役割を果たして、LLMに対して厳格な構造的監督のもとでナレッジベースを埋めていくよう指示するんやな。この研究ラインの進展はな、大きく3つの発展段階で特徴づけられるで。

---

## Page 6

[](/attach/15ee9247f9042f177a9e516338a77d3209ed0118a907940805adc8087501d7b2_p006.png)

### 和訳

ICAIS 2025の学会論文として発表

最初の取り組みとしてな、Kommineniら(2024)は、あらかじめガッチリ決めたオントロジー(知識の枠組みのことやな)の構造を使って、正確さと解釈のしやすさを担保しようとしたんや。彼らのやり方はこうやねん——まずLLM(大規模言語モデル)に「コンピテンシー・クエスチョン(CQ)」っちゅう、知識の範囲を決めるための質問を作らせて、それに対応するオントロジー(TBox、いわば知識の設計図やな)を組み立てて、その後で明確なスキーマ(型の定義)の監督のもとにABox(具体的なデータの入れ物)を埋めていくんや。これやと一貫性はめっちゃ高いんやけど、柔軟性はちょっと限られるわけやな。同じようにKARMAフレームワーク(Lu & Wang, 2025)も、マルチエージェント構成を採用してて、各エージェントがスキーマに従った抽出タスクをこなすことで、決められたオントロジーの枠内でエンティティ(実体)の正規化やリレーション(関係)の分類を正確にやるんや。

こういうガチガチの枠組みをベースにしてな、次の研究では「段階的プロンプティング」っちゅうやり方で、モジュール性と再利用性を高めようとしたんや。たとえばFengら(2024)は二段階の「オントロジーに基づく抽出」アプローチを提案してん。まずテキストからドメイン特化のオントロジーを直接生成して、それをRDFトリプル(主語・述語・目的語の三つ組みで知識を表現する形式やな)の抽出を導くプロンプトとして使うんや。これで構造的な整合性を強化しつつ、ある程度の適応力も保てるようになったんやで。

もっと最近の研究になるとな、基本は固定のフレームワークなんやけど、部分的に柔軟性を入れるようになってきたんや。ODKE+(Khorshidiら, 2025)は「オントロジー・スニペット」っちゅうアイデアを提案してん。これは何かっていうと、オントロジーの一部分を動的に選んできて、特定のエンティティに合わせた文脈対応のプロンプトを作るんや。そうすることで、実行時にちょっとだけスキーマを適応させられるっちゅうわけやな。同じようにBhattaraiら(2024)はUMLSっていう医療オントロジーを使って、臨床情報の抽出用にタスク特化のプロンプトを動的に生成してるんや。これらの手法は局所的な適応力は入ってきてるんやけど、大枠のスキーマには縛られたままやから、スキーマの動的化に向けた過渡期の段階っちゅうことやな。

まとめるとな、静的なスキーマ駆動の抽出いうのは、LLMを使った知識抽出の基本パラダイム(考え方の枠組み)で、正確さ・論理的一貫性・解釈しやすさを重視してるんや。でもな、ガチガチのオントロジーのテンプレートに依存してるから、スケーラビリティ(規模拡大への対応力)やドメインを跨いだ汎用性には限界があんねん。固定スキーマから、選択的で文脈対応のスキーマプロンプティングへの進化は、この分野がもっと適応的でデータ応答型のフレームワークへとじわじわ移行してることを示してるんやで。

4.1.2 動的かつ適応的なスキーマベースの抽出

最近のアプローチはな、スキーマを固定テンプレートやなくて、抽出プロセスと一緒に動的に進化するもんとして捉え直してるんや。つまり「スキーマが抽出を導く」から「スキーマが抽出と一緒に共進化する」へのシフトやねん。

AutoSchemaKG(Baiら, 2025)がまさにこのトレンドの代表格で、大規模コーパス(テキストの大量データ)から教師なしクラスタリングと関係発見を使ってスキーマを帰納的に導き出すんや。リレーションのタイプごとに調整されたマルチステージのプロンプトを使うことで、スキーマが抽出された内容と一緒に反復的に進化していけるようになって、オープンドメインでのスケーラビリティが向上するんやで。この考えをさらに発展させたAdaKGC(Yeら, 2023)は、スキーマドリフト(スキーマがだんだんズレてくる問題やな)に対して二つの仕組みで対処してん。一つは「スキーマ強化プレフィックス指示(SPI)」で文脈対応のプロンプティングを行うやつ、もう一つは「スキーマ制約付き動的デコーディング(SDD)」で再学習なしにスキーマを適応させるやつや。

これらの手法を合わせることで、適応的なスキーマ学習が可能になって、記号的な構造とデータ駆動の柔軟性の橋渡しができるんや。抽出とスキーマの進化が相乗的に進む、継続的で自己更新型のナレッジグラフ構築への土台を築いてるっちゅうわけやな。

4.2 スキーマフリーな手法

外部で定義された設計図に頼るパラダイムとは対照的にな、スキーマフリー抽出は、あらかじめ決められたオントロジーやリレーションスキーマに一切頼らんと、非構造化テキストから直接構造化された知識を獲得しようっちゅうもんやねん。核となるアイデアは、LLMを自律的な抽出装置として活用して、高度なプロンプトエンジニアリング、インストラクションチューニング(指示微調整)、自己組織化推論を通じてエンティティやリレーションを特定することなんや。このパラダイムの進化は大きく二つの方向に分かれてるで——構造化生成抽出とオープン情報抽出や。

4.2.1 構造化生成抽出

一つ目の方向性、構造化生成抽出はな、LLMにプロンプトを与えて、生成の過程で暗黙的な、もしくはその場でスキーマを作らせるっちゅうアプローチやねん。外部のオントロジーは一切提供せえへんのやけど、構造化された推論パターンと生成テンプレートがモデルを導いて、一貫性のあるまとまった知識生成に向かわせるんや。

---

## Page 7

[](/attach/15ee9247f9042f177a9e516338a77d3209ed0118a907940805adc8087501d7b2_p007.png)

### 和訳

ICAIS 2025の学会論文として発表

初期の研究やねんけど、Nieら(2024)がやったんは、抽出プロセスをChain-of-Thought(CoT)プロンプティング——つまり「順番に考えていこうや」っていう推論のやり方——と組み合わせたことやねん。エンティティ(実体)とリレーション(関係)を見つけるのに、ステップバイステップで考えさせたわけや。これでわかったんが、「明示的なスキーマ(データの型や構造を事前にカッチリ決めたやつ)がなくても、推論ベースで整理すればいけるやん!」ってことやねん。この発見をさらに発展させたんがAutoRE(Xueら、2024)で、インストラクション・ファインチューニング(指示に従う訓練)を通じてRHF(リレーション→ヘッド→ファクト)っていうパイプラインを導入したんや。これでモデルが関係性のパターンを内面化できるようになって、文書をまたいでも一貫性とスケーラビリティがめっちゃ向上したわけやな。

その後の研究では、検索機能とか対話型のアプローチを取り入れて、スキーマなし抽出をさらにパワーアップさせとるで。たとえばPapalucaら(2024)は、Retrieval-Augmented(検索で補強する)プロンプティングの枠組みを提案して、意味的に関連する事例をコンテキストウィンドウ(モデルが一度に見れる範囲)にダイナミックに追加することで、事実の正確さを上げたんや。一方でChatIE(Weiら、2024)は、抽出作業を「マルチターンの対話」——つまりモデルと何回もやりとりする形——に作り変えて、質問応答を連鎖させながらエンティティとリレーションの候補をどんどん磨いていく方法を取ったんやな。同じようにKGGEN(Moら、2025)は、抽出を2段階のLLM呼び出しに分解して——まずエンティティを検出して、次にリレーションを生成する——っていうやり方で、モデルの認知的な負荷を減らしてエラーの連鎖を防いどる。

まとめるとやな、これらの研究が明らかにしたんは、明示的なスキーマがなくても、ガイド付きの推論・モジュール化されたプロンプティング・対話的な改善を組み合わせれば、LLMは潜在的な関係構造を内面化できるっていうことやねん。これが、オープンエンドで自己組織化する知識生成の土台になっとるわけや。

4.2.2 オープン情報抽出(OIE)

オープン情報抽出(OIE)は、構造化された生成手法をさらにスキーマフリーの方向に拡張したもんで、事前に定義された型に頼らずに、テキストからありとあらゆる「エンティティ−リレーション−オブジェクト」のトリプル(三つ組)を発見することを目指しとるねん。EDCフレームワーク(Zhang & Soh, 2024)がまさにこのパラダイムの代表例で、最初のExtract(抽出)ステージでは少数ショットプロンプティング(ちょっとだけ例を見せて「こんな感じでやってな」ってやるやつ)を使って、自然言語のトリプルを網羅的に生成して、生のオープンナレッジグラフを作るんや。その後で定義づけと正規化をやるっていう流れやな。OIEが重視するんは、構造のキレイさよりもカバレッジ(網羅性)と発見やねん。スキーマ誘導や正規化と組み合わせると、非構造化テキストと自然発生的なオントロジー(概念体系)の組織化をつなぐ橋渡しになって——スキーマフリーからスキーマ生成型の知識構築まで、連続的なスペクトラムを完成させるわけや。

5 LLMを活用した知識融合

最近の進展と先駆的な研究を見てみると、LLMを使った知識融合の方法論は、主に2つの根本的なレベルの課題に取り組んどるねん。(1) スキーマ層で統一的かつ正規化された「知識の骨格」を構築すること、(2) インスタンス層で具体的な「知識の肉付け」を統合・整列させること、この2つや。この区分に従うと、既存のアプローチは大きく3つに分けられるで。スキーマレベルの融合、インスタンスレベルの融合、そしてその両方を統合するハイブリッドフレームワークや。

5.1 スキーマレベルの融合

スキーマレベルの融合っていうのは、ナレッジグラフの構造的な背骨——概念、エンティティタイプ、リレーション、属性——を、一貫性があって意味的にも整合性のとれたスキーマに統一することやねん。バラバラな要素を揃えることで、すべての知識が統一された概念仕様に従うようにするわけや。この分野の研究は、大きく3つのフェーズを経て進化してきとる。

(1) オントロジー駆動の一貫性。初期の研究は、明示的なオントロジー(概念体系の定義)をグローバルな制約として使っとった。たとえばKommineniら(2024)は、抽出されたトリプルと事前定義されたオントロジーの定義をきっちり合わせることで、めっちゃ高い意味的一貫性を実現したんやけど、ドメインをまたぐ柔軟性には限界があったんやな。

(2) データ駆動の統一。この硬さを乗り越えるために、LKD-KGC(Sunら、2025)は適応的な埋め込みベースのスキーマ統合を導入したんや。同じ意味のエンティティタイプをベクトルクラスタリングとLLMベースの重複排除で自動的に抽出・統合することで、スキーマの整列がデータから自然に立ち上がってくる仕組みやねん。

(3) LLMによる正規化。最近のアプローチ、たとえばEDC(Zhang & Soh, 2024)は、融合を意味的な正規化の方向に拡張しとる。LLMにスキーマの構成要素の自然言語定義を生成させて、それをベクトル類似度で比較するっていうやり方で、自己整列もクロススキーマのマッピングも、より自動化されてかつ意味的にも精度が高い形でサポートしとるんや。

---

## Page 8

[](/attach/15ee9247f9042f177a9e516338a77d3209ed0118a907940805adc8087501d7b2_p008.png)

### 和訳

ICAIS 2025の学会論文として発表

まとめると、スキーマレベルの融合っちゅうのは、オントロジー駆動型からデータ駆動型、ほんでLLM活用型へと進化してきてん。要するに、ガチガチのルールベースで合わせてたやり方から、LLMの推論を使った柔軟でセマンティクス重視の融合にシフトしてきたっちゅうことやな。

5.2 インスタンスレベルの融合

インスタンスレベルの融合っちゅうのは、具体的な知識の実体(インスタンス)を統合する話やねん。エンティティの整合、曖昧さの解消、重複の除去、矛盾の解決とか、そういうのを全部やるわけ。目的は何かっていうと、バラバラやったり被ってたりするエンティティをうまいことまとめて、整合性のある意味的に正確なナレッジグラフを保つことやな。最近の研究を見てると、ヒューリスティックなクラスタリングから、構造化された推論ベースのフレームワークへとはっきり進化してるのがわかるで。

初期の研究やと、KGGEN(Mo ら、2025)が反復的にLLMガイドのクラスタリングを使って、表面的なマッチングを超えて同等のエンティティや関係を統合してたんや。このフレームワークは段階的にトリプルを抽出してからセマンティックなグルーピングをするんやけど、これでLLMが明示的なルールやなくて暗黙の推論で意味的に関連するエンティティを集約できるポテンシャルが見えてきたわけや。その後、LLM-Align(Chen ら、2024)とEntGPT(Ding ら、2025)は、整合を文脈的な推論タスクとして再定義して、マルチステップのプロンプティングで意味の識別力を高めたんや。LLM-Alignは整合を制約付きの多肢選択問題として扱って、EntGPTは2段階のリファインメントパイプラインを導入してん——まず候補エンティティを生成して、次にターゲットを絞った推論で最終選択するっちゅう流れで、整合の精度がめっちゃ上がったんや。さらに最近の取り組みでは、構造的な手がかりや検索の手がかりも組み込んでて——例えばPons ら(2025)はRAGベースの融合を活用して、クラス・サブクラスの階層構造やエンティティの説明文をゼロショットの曖昧性解消に使ってるねん。このグラフの構造情報を統合することで、見たことないエンティティや曖昧なエンティティに対してもより頑健な推論ができるようになったわけや。効率面でもCOMEM(Wang ら、2024)みたいな階層的設計で改善が進んでて、軽量なフィルタリングときめ細かい推論を組み合わせてるんや。小さいLLMと大きいLLMをマルチステージのパイプラインでカスケードさせることで、大規模な融合タスクでも高いセマンティック精度を保ちながら、めっちゃ効率が良くなってるねん。

全体的に見ると、LLMは単純なマッチャーから、文脈・構造・検索シグナルを統合する適応的な推論エージェントへと進化してきてん。スケーラブルで自己修正できる融合ができるようになって、自律的なナレッジグラフ構築への道が開かれつつあるっちゅうことやな。

5.3 包括的・ハイブリッドフレームワーク

包括的・ハイブリッドフレームワークっちゅうのは、スキーマレベルとインスタンスレベルの融合を一つのエンドツーエンドのワークフローに統合するもんで、従来のモジュール型パイプラインを超えて、統合的でプロンプト駆動のアーキテクチャに向かってるんや。

KARMAフレームワーク(Lu & Wang、2025)はマルチエージェント設計の好例で、専門化されたエージェントが協力してスキーマの整合、矛盾の解決、品質評価を担当して、スケーラビリティとグローバルな一貫性を実現してるんや。これをさらに発展させたODKE+(Khorshidi ら、2025)は、オントロジーガイドのワークフローを採用して、スキーマの監督とインスタンスレベルの裏付けを組み合わせることで、意味的な忠実度を向上させてるねん。ほんで一番最近のGraphusion(Yang ら、2024)は、統一的なプロンプトベースのパラダイムを導入して、整合・統合・推論っちゅう全ての融合サブタスクを一回の生成サイクルの中でやってまうんや。

これらのフレームワークを合わせて見ると、統合的で適応的で生成的な融合システムへの転換を示してて、LLM駆動のエコシステムの中で継続的に構築・推論できる、自律的で自己進化するナレッジグラフに向けた重要な一歩やと言えるな。

6 今後の応用

大規模言語モデル(LLM)とナレッジグラフ(KG)の交差点にある研究は、知識表現と推論において、より深い知的インタラクションとより高い自律性に向けて着実に前進してるんや。こういう動きを踏まえると、今後の探求に向けていくつかの有望な方向性が見えてきてるで。

---

## Page 9

[](/attach/15ee9247f9042f177a9e516338a77d3209ed0118a907940805adc8087501d7b2_p009.png)

### 和訳

ICAIS 2025 カンファレンス論文として発表

6.1 知識グラフベースの推論をLLMに組み込む話

今後の研究では、ちゃんと構造化された知識グラフ(KG)をLLMの推論の仕組みにもっとガッツリ組み込んでいくことが期待されてんねん。これによって、論理的な一貫性とか、因果関係の推論とか、「なんでその答えになったん?」っていう説明のしやすさがめっちゃ向上するわけや。この研究の方向性は、単に推論能力が上がるだけやなくて、「知識を作る」段階から「知識を使って考える」段階への概念的なシフトを意味してんねん。質の高い、きっちり構造化されたKGが、説明可能で検証もできるモデル推論の土台になるっちゅうことやな。既存の研究やと、KGベースのランダムウォーク推論(Kim et al., 2024)とかKG-RAR(Wu et al., 2025)が、このパラダイムのポテンシャルをバッチリ示してるで。ただな、ここでめっちゃ大事な補完的課題があって、それは「推論能力が上がったら、その力を逆にKGの構築をもっと頑丈に自動化するのに活かせへんか?」っちゅうことやねん。つまり、知識の構築と推論がお互いを高め合う、ええ感じの好循環を作ろうって話や。

6.2 エージェントシステムのための動的な知識メモリ

LLMで動くエージェントが自律的に動けるようになるには、有限なコンテキストウィンドウ——要は「一度に覚えておける量に限りがある」っていう制約——を、持続的で構造化されたメモリで乗り越えなあかんねん。最近のアーキテクチャでは、知識グラフ(KG)を動的なメモリの基盤として捉えてて、過去のやりとりをただ静的に保存するんやなくて、エージェントとのやりとりに応じて常に進化し続けるもんとして設計されてんねん。例えばA-MEM(Xu et al., 2025)っていうフレームワークは、メモリを文脈的なメタデータ付きの相互接続された「ノート」としてモデル化してて、継続的に整理し直したり成長させたりできるようになってるんや。同じようにZep(Rasmussen et al., 2025)は時間的知識グラフ(TKG)を使って、事実の有効期限を管理したり、時間を意識した推論や更新をサポートしてるで。こういう進歩が示してるのは、動的KGが長期的で解釈しやすいメモリシステムとして、継続学習・マルチエージェント連携・自己反省的な推論を可能にするっちゅうことやな。今後の研究では、スケーラビリティ、時間的な整合性、マルチモーダル統合の改善に焦点が当てられて、完全自律型で知識に根ざしたエージェントを目指していくことになるで。

6.3 マルチモーダル知識グラフの構築

マルチモーダル知識グラフ(MMKG)の構築は、テキスト・画像・音声・動画みたいなバラバラの種類のデータを、統一された構造化表現にまとめ上げることを目指してんねん。これができると、より豊かな推論やモダリティ間の整合が可能になるわけや。代表的な研究としてはVaLiK(Vision-align-to-Language integrated KG)(Liu et al., 2025)があって、これは事前学習済みのビジョン・ランゲージモデル(VLM)を連鎖的に使って、視覚的な特徴をテキスト形式に変換して、その後にクロスモーダル検証モジュールでノイズをフィルタリングしてMMKGを組み立てるっちゅう仕組みやねん。これで、人手のアノテーションなしにエンティティと画像の紐づけができるようになるんや。構造だけやなくて、表現学習の方面ではKG-MRI(Lu et al., 2024)が、対照学習の目的関数を使ったマルチモーダル埋め込みで、異なるモダリティを一貫した意味空間に揃えるっていうアプローチをとってるで。課題として残ってるのは、モダリティの異質性、整合時のノイズ、スケーラビリティ、それからデータが欠けてたり偏ってたりする状況での頑健性やな。LLMとVLMがどんどん一緒に進化していく中で、MMKGは知覚的な入力と記号的な推論をモダリティ横断で橋渡しする、めっちゃ重要な基盤になっていくで。

6.4 KGのLLMアプリケーションにおける新しい役割:RAGを超えて

RAGシステムで検索のバックボーンとして使われるだけやなくて、知識グラフ(KG)は今や、生の入力とLLMの推論を橋渡しする「認知的な中間層」としての役割がどんどん期待されてきてんねん。このパラダイムでは、KGがクエリ・計画・意思決定のための構造化された足場を提供して、より解釈しやすくて根拠のある生成を可能にするんや。最近の研究がこのシフトをよう示してるで。CogER(Bing et al., 2023)は、レコメンデーションを認知を意識したKG推論として定式化して、直感的な推論とパスベースの推論を統合することで説明可能性を実現してるんや。バイオメディカル領域では、PKG-LLM(Sarabadani et al., 2025)が、メンタルヘルス診断における知識の拡張と予測モデリングにドメインKGを活用してるで。こういったアプローチは総じて、KGをインタラクティブな推論基盤として扱ってて、科学・コード・ヘルスケアみたいな分野で、よりロバストで説明可能な生成を実現する可能性を示してるんやな。

7 結論

この調査論文では、大規模言語モデル(LLM)がオントロジーエンジニアリング・知識抽出・知識融合にわたって、知識グラフ(KG)の構築をどないに変革してきたかの包括的な概要を示してるで。LLMによって、ルールベースやモジュール式のパイプラインから、統一的で適応的、そして生成的なフレームワークへとパラダイムが移行してんねん。これらの段階を通じて、3つのトレンドが浮かび上がってきてるんやけど:(1)

---

## Page 10

[](/attach/15ee9247f9042f177a9e516338a77d3209ed0118a907940805adc8087501d7b2_p010.png)

### 和訳

ICAIS 2025 学会論文として発表

(1)固定スキーマから動的な帰納への進化、(2)パイプラインのモジュール方式から生成的な統合への移行、(3)記号的なガチガチの仕組みから意味ベースの柔軟な対応への転換、この3つの変化がめっちゃ大事やねん。要するにな、これらの流れが合わさって、ナレッジグラフ(知識をネットワーク状にまとめたもんやな)の定義自体が変わってきとんねん。もはや固定されたデータベースやなくて、言語の理解と構造化された推論を融合させた「生きた認知インフラ」になってきとるわけや。めっちゃすごい進歩があったんやけど、スケーラビリティ(でっかくしたときにちゃんと動くかって話)、信頼性、それから継続的な適応っていう課題はまだ残っとるんよな。今後はプロンプト設計、マルチモーダル統合(テキストとか画像とかいろんな情報を組み合わせるやつ)、そして知識に基づいた推論の進歩が、自律的で説明可能な知識中心のAIシステムを実現するカギになるで。

参考文献

Muhammad Nabeel Asimら。「オントロジー学習(知識の体系を自動で学ぶ技術やな)の手法と応用に関するサーベイ」Database誌、2018年。

Jiaxin Baiら。「AutoSchemaKG:ウェブ規模のコーパス(大量のテキストデータのことや)から動的にスキーマを導き出して、自動でナレッジグラフを構築するシステム」。なんでかっていうと、従来は人間がスキーマ(データの設計図みたいなもん)を手作りしとったんやけど、これを自動化したろうっちゅう研究やねん。arXivプレプリント arXiv:2505.23628、2025年8月。

Kriti Bhattaraiら。「知識ベースをガイドにした生成方式による、文書レベルの臨床エンティティおよび関係抽出」。ほんまに医療テキストから病名とか治療法とかの関係をごっそり抜き出す話やな。第23回バイオメディカル自然言語処理ワークショップ予稿集、318–327頁、バンコク、タイ、2024年。計算言語学会。

Qingyu Bingら。「説明可能なレコメンデーションのための認知を考慮したナレッジグラフ推論」。つまりな、おすすめシステムが「なんでこれおすすめしたん?」って説明できるように、人間の認知の仕組みを取り入れたナレッジグラフの推論方法を考えたんやで。第16回ACM国際ウェブ検索・データマイニング会議予稿集、402–410頁、シンガポール、2023年2月。

Xuan Chenら。「LLM-Align:大規模言語モデルを使ったナレッジグラフのエンティティアラインメント」。要は、別々のナレッジグラフにある「同じもんを指してる項目」をLLM(大規模言語モデル、ChatGPTみたいなやつや)で揃えましょうっちゅう話やねん。arXivプレプリント arXiv:2412.04690、2024年12月。

Kartik Detrojaら。「関係抽出に関するサーベイ」。テキストから「AとBはこういう関係や」っちゅう情報を引っ張り出す技術の全体像をまとめた論文やな。Intelligent Systems with Applications誌、19巻、200244、2023年。

Yifan Dingら。「EntGPT:生成型大規模言語モデルによるエンティティリンキング」。エンティティリンキングっていうのは、文中の「アップル」が会社のことなんか果物のことなんかを特定して、知識ベースの正しい項目に紐づける技術やねん。それをGPTみたいな生成モデルでやったろうっちゅうわけや。arXivプレプリント arXiv:2402.06738、2025年5月。

Darren Edgeら。「ローカルからグローバルへ:クエリに焦点を当てた要約のためのGraph RAGアプローチ」。ほんまにこれ面白くてな、グラフ構造の知識とRAG(検索拡張生成)を組み合わせて、質問に合わせた要約をうまいこと作る方法やねん。arXivプレプリント arXiv:2404.16130、2024年4月。

Nadeen Fathallahら。「LLMs4Life:ライフサイエンス分野のオントロジー学習のための大規模言語モデル」。生命科学の知識体系を、LLMの力を借りて自動で構築しようっちゅう研究やな。arXivプレプリント arXiv:2412.02035、2024年12月。

Nadeen Fathallahら。「NeOn-GPT:大規模言語モデルを活用したオントロジー学習パイプライン」。The Semantic Web: ESWC 2024 サテライトイベント、第15344巻、36–50頁、Springer Nature Switzerland、2025年。

10

---

## Page 11

[](/attach/15ee9247f9042f177a9e516338a77d3209ed0118a907940805adc8087501d7b2_p011.png)

### 和訳

ICAIS 2025の会議論文として発表されたやつやで

Xiaohan Feng, Xixin Wu, Helen Meng. 「Wikidataのスキーマ使って、LLMでオントロジーに基づいた知識グラフを自動で作ろうぜ」って論文や。arXivプレプリント arXiv:2412.20942、2024年12月。doi: 10.48550/arXiv.2412.20942. URL http://arxiv.org/abs/2412.20942.

Hamed Babaei Giglou, Jennifer D'Souza, Sören Auer. 「LLMs4OL:でっかい言語モデルでオントロジー学習しよう」っていう研究やねん。arXivプレプリント arXiv:2307.16648、2023年8月。doi: 10.48550/arXiv.2307.16648. URL http://arxiv.org/abs/2307.16648.

Samira Khorshidi, Azadeh Nikfarjam, Suprita Shankar, Yisi Sang, Yash Govind, Hyun Jang, Ali Kasgari, Alexis McClimans, Mohamed Soliman, Vishnu Konda, Ahmed Fakhry, Xiaoguang Qi. 「ODKE+:オントロジーをガイドにして、LLMでオープンドメインの知識をごっそり抜き出す方法」や。arXivプレプリント arXiv:2509.04696、2025年9月。doi: 10.48550/arXiv.2509.04696. URL http://arxiv.org/abs/2509.04696.

Yejin Kim, Eojin Kang, Juae Kim, H. Howie Huang. 「大規模言語モデルで因果推論やるで〜知識グラフを使ったアプローチ」っていう話やな。arXivプレプリント arXiv:2410.11588、2024年10月。doi: 10.48550/arXiv.2410.11588. URL http://arxiv.org/abs/2410.11588.

Vamsi Krishna Kommineni, Birgitta König-Ries, Sheeba Samuel. 「大規模言語モデル使って知識グラフの構築を自動化していこうやないか」って論文。2024年発表やで。

Konstantinos I. Kotis, George A. Vouros, Dimitris Spiliotopoulos. 「生きてるオントロジーとか再利用されるオントロジーを進化させるための、オントロジーエンジニアリングの方法論について〜今どうなってて、どんなトレンドがあって、何がわかって、これからどうしたらええんか〜」っていうレビュー論文やねん。The Knowledge Engineering Review誌、35巻、e4、2020年。doi: 10.1017/S0269888920000065.

Anna Sofia Lippolis, Miguel Ceriani, Sara Zuppiroli, Andrea Giovanni Nuzzolese. 「Ontogenia:大規模言語モデルでメタ認知プロンプティング使ってオントロジーを自動生成するで!」って研究や。Albert Meroño Peñuela, Oscar Corcho, Paul Groth, Elena Simperl, Valentina Tamma, Andrea Giovanni Nuzzolese, Maria Poveda-Villalón, Marta Sabou, Valentina Presutti, Irene Celino, Artem Revenko, Joe Raad, Bruno Sartini, Pasquale Lisena(編)、The Semantic Web: ESWC 2024 Satellite Events、第15344巻、259〜265頁。Springer Nature Switzerland、Cham、2025a年。doi: 10.1007/978-3-031-78952-6_38. URL https://link.springer.com/10.1007/978-3-031-78952-6_38.

Anna Sofia Lippolis, Mohammad Javad Saeedizade, Robin Keskisärkkä, Sara Zuppiroli, Miguel Ceriani, Aldo Gangemi, Eva Blomqvist, Andrea Giovanni Nuzzolese. 「大規模言語モデルでオントロジーをガッツリ生成する方法」や。arXivプレプリント arXiv:2503.05388、2025年3月。doi: 10.48550/arXiv.2503.05388. URL http://arxiv.org/abs/2503.05388.

Junming Liu, Siyuan Meng, Yanting Gao, Song Mao, Pinlong Cai, Guohang Yan, Yirong Chen, Zilin Bian, Ding Wang, Botian Shi. 「ビジョンと言語を揃えよう〜アノテーションなしでマルチモーダル知識グラフ作って、LLMの推論をめっちゃ強化する方法」やで。arXivプレプリント arXiv:2503.12972、2025年7月。doi: 10.48550/arXiv.2503.12972. URL http://arxiv.org/abs/2503.12972.

Shuang Liu, Man Xu, Yufeng Qin, Niko Lukač. 「ノードレベルでガッチリ融合する知識グラフアラインメントネットワーク」っていう論文やな。なんでかっていうと、知識グラフ同士をうまく揃えるのがほんまに大事やからやねん。Applied Sciences誌、12巻19号、2022年。doi: 10.3390/app12199434. URL https://www.mdpi.com/2076-3417/12/19/9434.

Yuxing Lu, Jinzhuo Wang. 「KARMA:マルチエージェントLLMを活用して知識グラフをめっちゃ豊かにしていく手法」や。arXivプレプリント arXiv:2502.06472、2025年2月。doi: 10.48550/arXiv.2502.06472. URL http://arxiv.org/abs/2502.06472.

Yuxing Lu, Weichen Zhao, Nan Sun, Jinzhuo Wang. 「トリプル対照学習でマルチモーダル知識グラフの表現学習をパワーアップさせるで」っていう研究やねん。Kate Larson(編)、第33回国際人工知能合同会議(IJCAI-24)の論文集、5963〜5971頁。International Joint Conferences on Artificial Intelligence Organization、2024年8月。doi: 10.24963/ijcai.2024/659. URL https://doi.org/10.24963/ijcai.2024/659. メイントラックの発表やで。

---

## Page 12

[](/attach/15ee9247f9042f177a9e516338a77d3209ed0118a907940805adc8087501d7b2_p012.png)

### 和訳

ICAIS 2025の会議論文として発表

Patricia MateiuとAdrian Groza。大規模言語モデルを使ったオントロジー工学っていう研究やねん。要するに、AIの言語モデルでオントロジー(知識を体系的に整理する仕組みのことやな)を作ろうっていう話や。arXivプレプリント arXiv:2307.16699、2023年7月。doi: 10.48550/arXiv.2307.16699。URL http://arxiv.org/abs/2307.16699.

Belinda Mo、Kyssen Yu、Joshua Kazdan、Proud Mpala、Lisa Yu、Chris Cundy、Charilaos Kanatsoulis、Sanmi Koyejo。KGGen:言語モデルで普通の文章からナレッジグラフ(知識のつながりを図にしたやつやな)を抜き出す手法やで。arXivプレプリント arXiv:2502.09956、2025年2月。doi: 10.48550/arXiv.2502.09956。URL http://arxiv.org/abs/2502.09956.

Jixuan Nie、Xia Hou、Wenfeng Song、Xuan Wang、Xinyu Zhang、Xingliang Jin、Shuozhe Zhang、Jiaqi Shi。ナレッジグラフの効率的な構築:Chain-of-Thought(段階的に考える仕組みやな)をLLMに埋め込むっていうアプローチやねん。Proceedings of the VLDB Endowment。ISSN 2150:8097、2024年。

Liu Pai、Wenyang Gao、Wenjie Dong、Lin Ai、Ziwei Gong、Songfang Huang、Li Zongsheng、Ehsan Hoque、Julia Hirschberg、Yue Zhang。オープン情報抽出に関するサーベイやで。ルールベースのモデルから大規模言語モデルまでの流れをめっちゃ網羅的にまとめとるねん。Yaser Al-Onaizan、Mohit Bansal、Yun-Nung Chen(編)、Findings of the Association for Computational Linguistics: EMNLP 2024、pp. 9586–9608、アメリカのマイアミ、フロリダ州、2024年。Association for Computational Linguistics。doi: 10.18653/v1/2024.findings-emnlp.560。URL https://aclanthology.org/2024.findings-emnlp.560/.

Shirui Pan、Linhao Luo、Yufei Wang、Chen Chen、Jiapu Wang、Xindong Wu。大規模言語モデルとナレッジグラフを統合するためのロードマップやねん。なんでかっていうと、この2つを組み合わせたらほんまに強力になるからや。IEEE Transactions on Knowledge and Data Engineering、36(7):3580–3599、2024年。

Andrea Papaluca、Daniel Krefl、Sergio Rodríguez Méndez、Artem Lensky、Hanna Suominen。大規模言語モデルを使ったゼロショット・少数ショットでのナレッジグラフのトリプル抽出やで。トリプルっていうのは「AはBという関係でCとつながってる」みたいな知識の基本単位のことやな。学習データがほぼなくてもいけるっていうのがめっちゃすごいポイントやねん。Proceedings of the 1st Workshop on Knowledge Graphs and Large Language Models (KaLLM 2024)、pp. 12–23、タイのバンコク、2024年。Association for Computational Linguistics。doi: 10.18653/v1/2024.kallm-1.2。URL https://aclanthology.org/2024.kallm-1.2.

Gerard Pons、Besim Bilalli、Anna Queralt。エンティティの曖昧性解消(同じ名前でも違うもんを区別するやつやな)を強化するためにナレッジグラフを使うっていう研究やで。arXivプレプリント arXiv:2505.02737、pp. 162–179、2025年。doi: 10.1007/978-3-031-77844-5_9。URL http://arxiv.org/abs/2505.02737.

Preston Rasmussen、Pavlo Paliychuk、Travis Beauvais、Jack Ryan、Daniel Chalef。Zep:AIエージェントの記憶のための時間的ナレッジグラフのアーキテクチャやねん。時間の流れも考慮してナレッジグラフを作るっていう発想がおもろいやろ。arXivプレプリント arXiv:2501.13956、2025年1月。doi: 10.48550/arXiv.2501.13956。URL http://arxiv.org/abs/2501.13956.

Mohammad Javad SaeedizadeとEva Blomqvist。大規模言語モデルを使ってオントロジー開発をナビゲートするっていう研究や。Albert Meroño Peñuela、Anastasia Dimou、Raphaël Troncy、Olaf Hartig、Maribel Acosta、Mehwish Alam、Heiko Paulheim、Pasquale Lisena(編)、The Semantic Web、第14664巻、pp. 143–161。Springer Nature Switzerland、Cham、2024年。doi: 10.1007/978-3-031-60626-7_8。URL https://link.springer.com/10.1007/978-3-031-60626-7_8.

Ali Sarabadani、Hadis Taherinia、Niloufar Ghadiri、Ehsan Karimi Shahmarvandi、Ramin Mousa。PKG-LLM:認知神経科学の分野で、ナレッジグラフと大規模言語モデルを使ってGAD(全般性不安障害やな)とMDD(うつ病のことやで)を予測するフレームワークやねん。ほんまに医療とAIの融合って感じやな。Preprints、2025年2月。doi: 10.20944/preprints202502.0982.v1。URL https://www.preprints.org/manuscript/202502.0982/v1.

Jiaqi Sun、Shiyou Qian、Zhangchi Han、Wei Li、Zelin Qian、Dingyu Yang、Jian Cao、Guangtao Xue。LKD-KGC:LLMを使った知識依存関係の解析によるドメイン特化型ナレッジグラフ構築やで。特定の分野に特化したナレッジグラフを効率よく作れるっていう話やねん。arXivプレプリント arXiv:2505.24163、2025年5月。doi: 10.48550/arXiv.2505.24163。URL http://arxiv.org/abs/2505.24163.

Yash Tiwari、Owais Ahmad Lone、Mayukha Pal。OntoRAG:整理されてない知識ベースから自動でオントロジーを導き出して質問応答をめっちゃ強化するっていう手法やねん。RAGっていうのは検索で補強した生成のことで、それにオントロジーを組み合わせたらもっと賢くなるやろっていう発想や。arXivプレプリント arXiv:2506.00664、2025年5月。doi: 10.48550/arXiv.2506.00664。URL http://arxiv.org/abs/2506.00664.

12

---

## Page 13

[](/attach/15ee9247f9042f177a9e516338a77d3209ed0118a907940805adc8087501d7b2_p013.png)

### 和訳

ICAIS 2025の学会論文として発表

Tianshu Wang、Xiaoyang Chen、Hongyu Lin、Xuanang Chen、Xianpei Han、Hao Wang、Zhenyu Zeng、Le Sun。「マッチさせる?比べる?それとも選ぶ?大規模言語モデルでエンティティマッチングどうやるんがええか調べてみたで」。arXivプレプリント arXiv:2405.16884、2024年。

Xiang Wei、Xingyu Cui、Ning Cheng、Xiaobin Wang、Xin Zhang、Shen Huang、Pengjun Xie、Jinan Xu、Yufeng Chen、Meishan Zhang、Yong Jiang、Wenjuan Han。「ChatIE:ChatGPTとおしゃべりするだけでゼロショット情報抽出できるねん」。arXivプレプリント arXiv:2302.10205、2024年5月。doi: 10.48550/arXiv.2302.10205。URL http://arxiv.org/abs/2302.10205。

Wenjie Wu、Yongcheng Jing、Yingjie Wang、Wenbin Hu、Dacheng Tao。「グラフで推論力アップ:ナレッジグラフを段階的に取ってきてLLMの推論をめっちゃ賢くする方法」。arXivプレプリント arXiv:2503.01642、2025年3月。doi: 10.48550/arXiv.2503.01642。URL http://arxiv.org/abs/2503.01642。

Wujiang Xu、Zujie Liang、Kai Mei、Hang Gao、Juntao Tan、Yongfeng Zhang。「A-MEM:LLMエージェントのための自律型メモリシステム。要はAIが自分で記憶を管理できるようにしたったって話やねん」。arXivプレプリント arXiv:2502.12110、2025年10月。doi: 10.48550/arXiv.2502.12110。URL http://arxiv.org/abs/2502.12110。

Lilong Xue、Dan Zhang、Yuxiao Dong、Jie Tang。「AutoRE:大規模言語モデルで文書レベルの関係抽出を自動でやっちゃおうぜって研究やで」。第62回計算言語学会年次大会(Volume 3:システムデモ)論文集、pp. 211–220、バンコク(タイ)、2024年。計算言語学会。doi: 10.18653/v1/2024.acl-demos.20。URL https://aclanthology.org/2024.acl-demos.20。

Linyao Yang、Chen Lv、Xiao Wang、Ji Qiao、Weiping Ding、Jun Zhang、Fei-Yue Wang。「電力系統の運用で使うナレッジグラフをうまいこと統合するためのエンティティアライメント手法。ほんまに電力インフラの知識融合に特化した研究やな」。IEEE/CAA Journal of Automatica Sinica、9(11):1990–2004、2022a。doi: 10.1109/JAS.2022.105947。

Rui Yang、Boming Yang、Sixun Ouyang、Tianwei She、Aosong Feng、Yuang Jiang、Freddy Lecue、Jinghui Lu、Irene Li。「Graphusion:大規模言語モデルを活用して自然言語処理教育向けの科学ナレッジグラフをめっちゃ上手に融合・構築する手法やで」。arXivプレプリント arXiv:2407.10794、2024年7月。doi: 10.48550/arXiv.2407.10794。URL http://arxiv.org/abs/2407.10794。

Yang Yang、Zhilei Wu、Yuexiang Yang、Shuangshuang Lian、Fengjie Guo、Zhiwei Wang。「ディープラーニング使った情報抽出のサーベイ論文や。なんでかっていうと、深層学習ベースの情報抽出がめっちゃ進化してるから全体像をまとめたかったんやな」。Applied Sciences、12(19):9691、2022b。

Hongbin Ye、Honghao Gui、Xin Xu、Xi Chen、Huajun Chen、Ningyu Zhang。「スキーマに柔軟に対応できるナレッジグラフ構築。つまり、決まった型にとらわれんと色んなスキーマに適応できるKG構築法ってことやねん」。arXivプレプリント arXiv:2305.08703、2023年11月。doi: 10.48550/arXiv.2305.08703。URL http://arxiv.org/abs/2305.08703。

Kaisheng Zeng、Chengjiang Li、Lei Hou、Juanzi Li、Ling Feng。「ナレッジグラフのエンティティアライメントについての包括的サーベイ。ようは、別々のナレッジグラフで同じモン指してるエンティティをどうやってマッチさせるかっていう研究を全部まとめたったで」。AI Open、2:1–13、2021年。doi: https://doi.org/10.1016/j.aiopen.2021.02.002。URL https://www.sciencedirect.com/science/article/pii/S2666651021000036。

Bowen Zhang、Harold Soh。「抽出して、定義して、正規化する:LLMベースのナレッジグラフ構築フレームワーク。3ステップでKG作れるっちゅうスマートなやり方やねん」。2024年自然言語処理における経験的手法に関する会議(EMNLP)論文集、pp. 9820–9836、マイアミ(アメリカ)、2024年。計算言語学会。doi: 10.18653/v1/2024.emnlp-main.548。URL https://aclanthology.org/2024.emnlp-main.548。

Zhigang Zhao、Xiong Luo、Maojian Chen、Ling Ma。「機械学習使ったナレッジグラフ構築のサーベイ。ML技術でKGをどう作るかの全体像をバーッとまとめた論文やで」。CMES-Computer Modeling in Engineering & Sciences、139(1)、2024年。

Lingfeng Zhong、Jia Wu、Qian Li、Hao Peng、Xindong Wu。「ナレッジグラフの自動構築に関する包括的サーベイ。ほんまにこの分野のこと全部網羅しとるから、入門にもめっちゃええ論文やな」。ACM Computing Surveys、56(4):1–62、2023年。

Beibei Zhu、Ruolin Wang、Junyi Wang、Fei Shao、Kerun Wang。「グラフ埋め込みベースのナレッジグラフエンティティアライメント研究のサーベイ。グラフをベクトル空間に埋め込んでからエンティティ同士をマッチさせるアプローチをまとめとるで」。Artificial Intelligence Review、57(9):229、2024a。

---

## Page 14

[](/attach/15ee9247f9042f177a9e516338a77d3209ed0118a907940805adc8087501d7b2_p014.png)

### 和訳

ICAIS 2025の学会論文として発表されてんで。

Yuqi Zhu, Xiaohan Wang, Jing Chen, Shuofei Qiao, Yixin Ou, Yunzhi Yao, Shumin Deng, Huajun Chen, Ningyu Zhang. 「LLMをナレッジグラフの構築と推論に使う話:今できることとこれからの可能性」World Wide Web, 27(5):58, 2024b.

→ これはな、大規模言語モデル(LLM)を使って知識グラフ——つまり情報同士のつながりをネットワークみたいに整理したやつ——をどう作って、どう推論に活かすかっていう話やねん。今どこまでできてて、これからどんなことができるようになるんか、っていう展望をまとめた論文やで。

Amal ZouaqとRoger Nkambou. 「ドメインオントロジー工学のサーベイ:手法とツール」Roger Nkambou, Jacqueline Bourdeau, Riichiro Mizoguchi(編)『Advances in Intelligent Tutoring Systems』, 308巻, pp. 103–119. Springer Berlin Heidelberg, 2010.

→ こっちはな、「ドメインオントロジー」——要するにある専門分野の知識を体系的に整理するための設計図みたいなもんやな——を作るための方法とかツールをめっちゃ幅広く調べてまとめたサーベイ論文やねん。賢い教育システム(知的チュータリングシステム)の本の中に入ってる章やで。

14

---

![]()

1 / 1