<<

2406.06608v6.pdf

---

## Page 1

[](/attach/06d9e15bc94457f08dfa24411ced93d626e981a2f805e98b5a0298e906b7c885_p001.png)

### 和訳

プロンプトレポート:プロンプトエンジニアリング技術の体系的サーベイ

Sander Schulhoff1,2∗ Michael Ilie1∗ Nishant Balepur1 Konstantine Kahadze1

Amanda Liu1 Chenglei Si4 Yinheng Li5 Aayush Gupta1 HyoJung Han1 Sevien Schulhoff1

Pranav Sandeep Dulepet1 Saurav Vidyadhara1 Dayeon Ki1 Sweta Agrawal12 Chau Pham13

Gerson Kroiz Feileen Li1 Hudson Tao1 Ashay Srivastava1 Hevander Da Costa1 Saloni Gupta1

Inna Goncearenco9 Giuseppe Sarli9,10

Denis Peskoff7 Marine Carpuat1 Jules White6 Shyamal Anadkat3 Alexander Hoyle1 Philip Resnik1

7 プリンストン大学

1 メリーランド大学 2 Learn Prompting

4 スタンフォード大学 5 マイクロソフト

Megan L. Rogers8

Igor Galynker11

6 ヴァンダービルト大学

3 OpenAI

8 テキサス州立大学 9 アイカーン医科大学

10 ASST Brianza

11 マウントサイナイ・ベスイスラエル

12 Instituto de Telecomunicações

milie@umd.edu

sschulho@umd.edu

13 マサチューセッツ大学アマースト校

resnik@umd.edu

要旨

なぁ聞いてや、生成AI(GenAI)ってやつが今めっちゃいろんな業界とか研究分野でバンバン使われるようになってきてんねん。開発者とかエンドユーザーがこのシステムとやりとりするときに使うんが「プロンプティング」と「プロンプトエンジニアリング」っちゅうやつやねん。要はAIにどう指示出すかっていう技術やな。プロンプトエンジニアリングはもうめっちゃ広く使われてて研究もガンガンされてるんやけど、なんせ出てきたんが最近やから、用語がバラバラやったり、「ええプロンプトって結局なんやねん」っていう根本的な理解がバラバラになってもうてるんよな。

ほんで、この論文では何やったかっていうとな、プロンプトエンジニアリングをちゃんと体系的に整理したんや。プロンプティング技術の分類体系(タクソノミー)を組み立てて、それぞれどう使えるかを分析してん。具体的に言うとな、33個の専門用語をきっちり定義して、大規模言語モデル(LLM)向けのプロンプティング技術を58個、それ以外のモダリティ(画像とか音声とか)向けの技術を40個、全部まとめて分類したんや。めっちゃ気合い入ってるやろ。

それだけちゃうで。プロンプトエンジニアリングのベストプラクティスとかガイドラインも紹介してて、ChatGPTとかその他の最先端(SOTA)LLMに対するプロンプトの書き方のコツもちゃんと載せてるねん。さらに、自然言語のプレフィックスプロンプティングに関する文献を全部ひっくるめたメタ分析もやってんで。

ほんまにな、これらの取り組みを全部まとめた結果、この論文は今までで一番包括的なプロンプトエンジニアリングのサーベイになってるんや。ようやったわほんま。

---

## Page 2

[](/attach/06d9e15bc94457f08dfa24411ced93d626e981a2f805e98b5a0298e906b7c885_p002.png)

### 和訳

目次

1 はじめに

1.1 プロンプトってなんやねん?

1.2 用語の説明

1.2.1 プロンプトの構成パーツ

1.2.2 プロンプト関連の用語

1.3 プロンプトのざっくり歴史

2 プロンプティングのメタ分析

2.1 システマティックレビューのやり方

2.1.1 分析の流れ

2.2 テキストベースのテクニック

2.2.1 In-Context Learning(ICL)〜お手本見せて学ばせるやつ〜

2.2.2 思考生成〜考えさせるテクニック〜

2.2.3 分解〜問題をバラバラにするやつ〜

2.2.4 アンサンブル〜複数の答えまとめるやつ〜

2.2.5 自己批判〜自分でダメ出しさせるやつ〜

2.3 プロンプトテクニックの使われ方

2.3.1 ベンチマーク

2.4 プロンプトエンジニアリング

2.5 アンサーエンジニアリング〜答えの出し方の工夫〜

2.5.1 答えの形

2.5.2 答えの範囲

2.5.3 答えの抽出方法

3 英語テキスト以外のプロンプティング

3.1 多言語対応

3.1.1 Chain-of-Thought(CoT)〜順番に考えさせるやつ〜

3.1.2 In-Context Learning

3.1.3 プロンプトのテンプレートにどの言語使うか問題

3.1.4 機械翻訳のためのプロンプティング

3.2 マルチモーダル〜テキスト以外も扱うやつ〜

3.2.1 画像プロンプティング

3.2.2 音声プロンプティング

3.2.3 動画プロンプティング

3.2.4 セグメンテーションプロンプティング〜画像の領域分けるやつ〜

3.2.5 3Dプロンプティング

4 プロンプティングの拡張

4.1 エージェント〜AIが自分で動くやつ〜

4.1.1 ツール使うエージェント

4.1.2 コード生成エージェント

4.1.3 観察ベースのエージェント

4.1.4 RAG(検索拡張生成)〜外部の情報引っ張ってくるやつ〜

4.2 評価

4.2.1 プロンプトテクニックの評価

4.2.2 出力フォーマット

4.2.3 プロンプトのフレームワーク

4.2.4 その他の手法

5 プロンプティングの問題点

5.1 セキュリティ

5.1.1 プロンプトハッキングの種類

5.1.2 プロンプトハッキングのリスク

5.1.3 防御策

5.2 アラインメント〜AIがちゃんと意図通り動くか問題〜

5.2.1 プロンプトの感度〜ちょっと変えただけで結果変わるやつ〜

5.2.2 自信過剰とキャリブレーション〜AIが間違ってるのに自信満々問題〜

5.2.3 バイアス・ステレオタイプ・文化の影響

5.2.4 あいまいさ

6 ベンチマーキング

6.1 テクニックのベンチマーク

6.1.1 プロンプトテクニックの比較

6.1.2 質問のフォーマット

6.1.3 Self-Consistency〜何回もやって多数決するやつ〜

6.1.4 回答の評価

6.1.5 結果

6.2 プロンプトエンジニアリングのケーススタディ

6.2.1 問題設定

6.2.2 データセット

6.2.3 プロセス

6.2.4 考察

7 関連研究

8 まとめ

A 付録

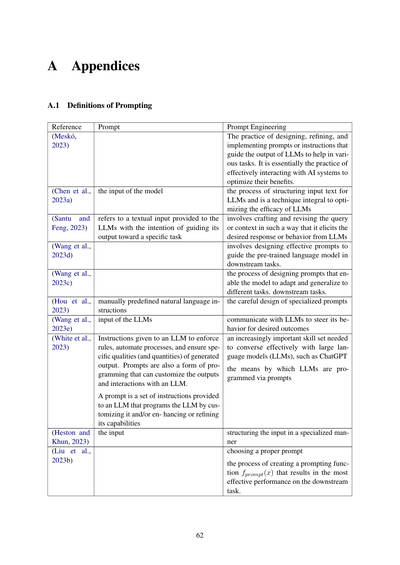

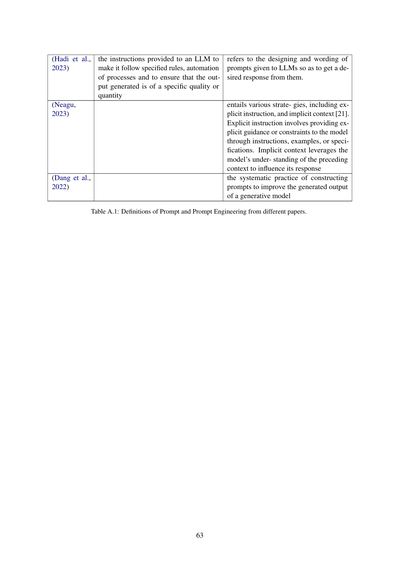

A.1 プロンプティングの定義いろいろ

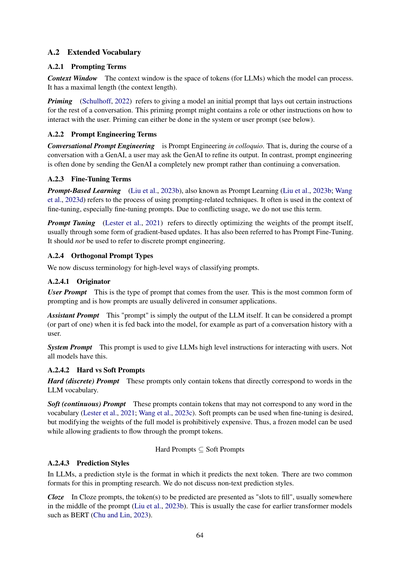

A.2 用語集(拡張版)

A.2.1 プロンプト用語

A.2.2 プロンプトエンジニアリング用語

A.2.3 ファインチューニング用語

A.2.4 直交するプロンプトの種類

---

## Page 3

[](/attach/06d9e15bc94457f08dfa24411ced93d626e981a2f805e98b5a0298e906b7c885_p003.png)

### 和訳

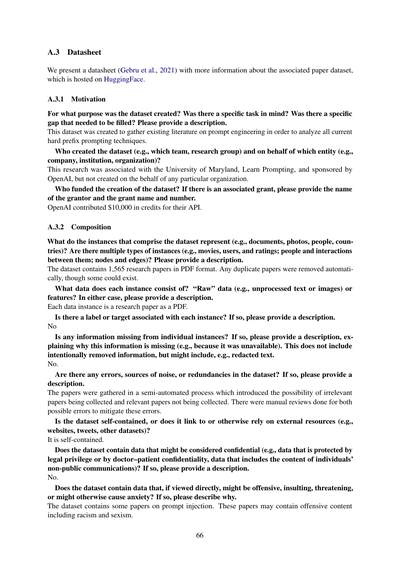

A.3 データシート

A.3.1 動機

A.3.2 構成

A.3.3 データ収集のプロセス

A.3.4 前処理・クリーニング・ラベリング

A.3.5 使い方

A.3.6 配布

A.3.7 メンテナンス

A.4 キーワード

A.5 系統的文献レビューのためのプロンプト

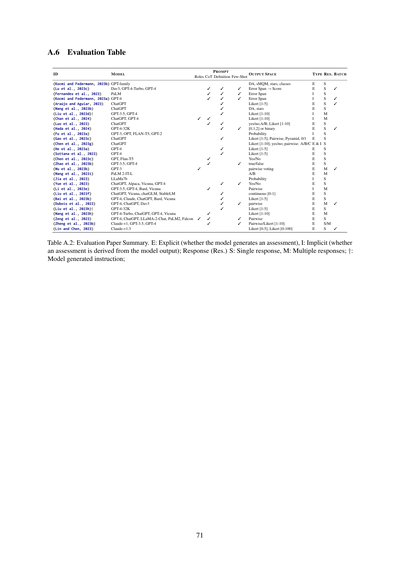

A.6 評価テーブル ... 66

A.7 エントラップメント・プロンプティングのプロセス ... 66

A.7.1 探索 ... 66

A.7.2 ラベルの取得 ... 67

A.7.3 プロンプティング手法のバリエーション ... 67

A.8 プロンプトの形式的な定義 ... 67

A.9 文脈内学習の定義についての曖昧さ解消 ... 67

A.10 貢献者一覧 ... 68

---

ほな説明していくで!

**A.6 評価テーブル** ... 71

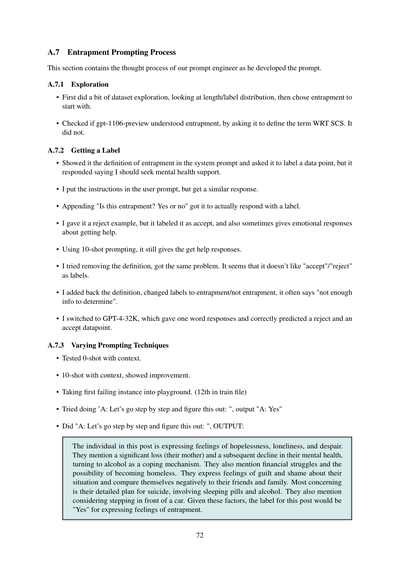

**A.7 エントラップメント・プロンプティングのプロセス** ... 72

ここはな、AIをうまいこと「ハメる」ためのプロンプトの作り方について書いてあるとこやねん。

**A.7.1 探索** ... 72

まずはAIがどんな反応するか、いろいろ試してみるフェーズやな。

**A.7.2 ラベルの取得** ... 72

ほんで、AIの出した答えにラベル(分類タグみたいなもんや)をつけるとこやで。

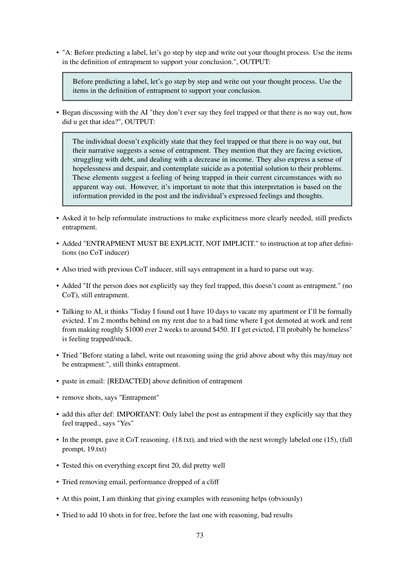

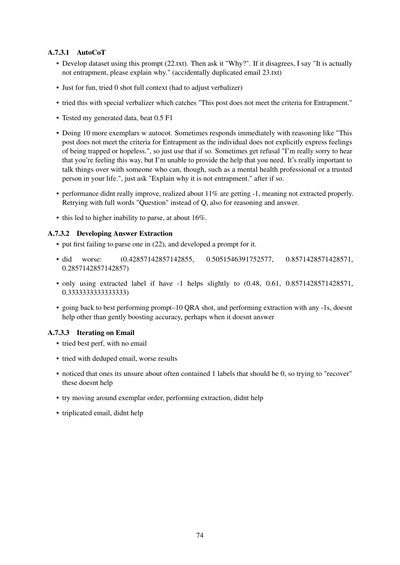

**A.7.3 プロンプティング手法のバリエーション** ... 72

ここではな、プロンプトの聞き方をいろいろ変えてみて、AIの反応がどう変わるかっていうのを見とるわけやねん。めっちゃ大事なとこやで。

**A.8 プロンプトの形式的な定義** ... 75

ここはちょっとカッチリした話で、「プロンプトって結局なんやねん?」っていうのを数学的にビシッと定義しとるとこやな。

**A.9 文脈内学習の定義の曖昧さ解消** ... 77

「文脈内学習」(In-Context Learning)ってな、要するにAIに例をいくつか見せたら、それだけで新しいタスクできるようになるっていうやつやねん。ただこの言葉、人によって意味がちょっとずつ違ったりするから、「ほんまはこういう意味やで!」ってハッキリさせとるセクションやな。

**A.10 貢献者一覧** ... 79

この研究に関わった人たちのリストやで。

---

## Page 4

[](/attach/06d9e15bc94457f08dfa24411ced93d626e981a2f805e98b5a0298e906b7c885_p004.png)

### 和訳

# 1. はじめに

Transformerベースの大規模言語モデル(LLM)ってやつが、もう一般向けのサービスやら社内ツールやら研究やら、あっちこっちでめっちゃ使われとるねん(Bommasani et al., 2021)。基本的にはな、ユーザーが「プロンプト」っていう入力を渡して、それに対してモデルが返事を返すっていう仕組みやねん。プロンプトっていうのは、テキストのこともあるし——「木についての詩を書いて」みたいな——画像とか音声とか動画とか、それらを組み合わせたやつのこともあるねん。特に自然言語でモデルに指示を出せるっていうのがめちゃくちゃ便利で、いろんな場面で柔軟に使えるから重宝されとるわけやな。

プロンプトをどう組み立てるか、どう評価するか、その他プロンプトにまつわるあれこれを知っとくのは、こういうモデルを使いこなす上でほんまに大事なことやねん。実際のところ、ええプロンプトを書いたら、いろんなタスクで結果がグンと良くなるっていう研究結果が出とるんよ(Wei et al., 2022b; Liu et al., 2023b; Schulhoff, 2022)。プロンプトで成果を上げるための研究論文もめっちゃ増えてきて、プロンプトのテクニックの数もどんどん膨れ上がっとる状況やねん。

せやけどな、プロンプティングってまだまだ新しい分野やから、プロンプトの使い方ってちゃんと理解されてへんのが現状やねん。実際に存在する用語やテクニックのうち、現場の人らにちゃんと知られとるのはほんの一部だけなんよ。そこでワイらは、プロンプティング技術の大規模なレビューをやって、この分野の用語やテクニックをしっかりまとめた信頼できるリソースを作ったんや。これは用語集の第一弾で、今後も更新していく予定やで。最新版の用語とテクニックのリストはLearnPrompting.orgで公開しとるからな。

**研究の範囲について** ワイらは、開発者や研究者がパッと理解してすぐ実験に使えるような、プロンプティング技術の幅広いカタログを作ったんや。そのためにな、研究対象を「プレフィックスプロンプト」(Shin et al., 2020a)に絞って、「クローズプロンプト」(Petroni et al., 2019; Cui et al., 2021)は扱わんことにしたんや。なんでかっていうと、今どきのLLMのTransformerアーキテクチャはプレフィックスプロンプトをがっつり採用してて、開発者にも研究者にもしっかりサポートされとるからやねん(Brown et al., 2020; Google, 2023; Touvron et al., 2023)。それに加えて、ハードプロンプト(離散的なやつ)に焦点を当てて、ソフトプロンプト(連続的なやつ)や勾配ベースの更新(つまりファインチューニング)を使う論文は除外したんや。ハードプロンプトっていうのは、モデルの語彙にある単語に対応するトークン(ベクトル)だけで構成されとるやつで、ソフトプロンプトは語彙のどの単語にも対応せえへんトークンが入っとることもあるんやな。

最後に、特定のタスクに依存しない汎用的なテクニックだけを対象にしたで。こういう判断をしたのは、技術にあんまり詳しくない読者にもとっつきやすくして、研究の範囲を現実的に管理できるようにするためやねん。

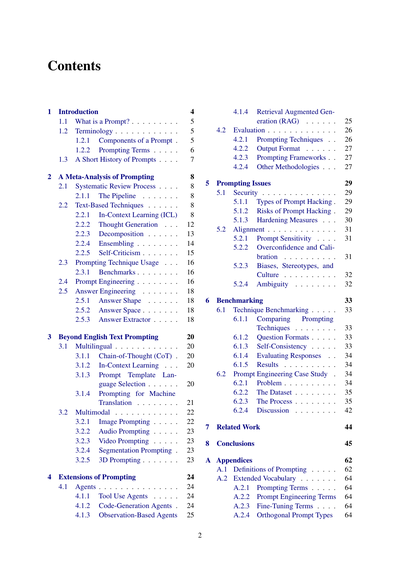

**各セクションの概要** ワイらはPRISMAプロセス(Page et al., 2021)に基づいた機械支援付きの体系的レビューを実施して(セクション2.1)、58種類のテキストベースのプロンプティング技術を特定したんや。そこから、プロンプティング用語のしっかりした分類体系を作ったで(セクション1.2)。

ワイらの目標は、「どのプロンプティング技術を使ったらええんやろ?」って迷ったときのロードマップをコミュニティに提供することやねん(図1.1)。プロンプティングの研究って英語だけを対象にしたもんが多いんやけど、ワイらは多言語テクニックについても取り上げとるで(セクション3.1)。それからな、画像みたいなメディアをプロンプトに含めるマルチモーダルプロンプティングも急成長しとるから、マルチモーダル技術にも範囲を広げとるんや(セクション3.2)。多言語やマルチモーダルのプロンプティング技術って、英語テキストだけのプロンプティング技術を直接拡張したもんが多いんよ。

プロンプティング技術がどんどん高度になってくると、インターネット検索とか電卓みたいな外部ツールも取り込むようになってきたんや。ワイらは

---

**図1.1:** プロンプティング分野の各カテゴリは互いにつながっとるんや。ワイらの研究範囲に含まれる論文でしっかり説明されとる7つの主要カテゴリについて議論しとるで。

- **安全性への配慮** — 全体を通して必要

- **セキュリティの懸念** — 全体を通して必要

- **プロンプトやエージェントの出力を評価する必要性**

- **評価**

- **安全性**

- **セキュリティ**

- *複数言語のテキストデータに対するテクニック → コアなプロンプティング技術をよく活用する

- *マルチメディア(動画、音声など)を処理するテクニック

- **コアプロンプティング技術**

- **エージェント**

- **多言語テクニック**

- **マルチモーダルテクニック**

- **テキストベーステクニック**

多言語テクニック(MLT)やマルチモーダルテクニック(MMT)は、基本的なテキストベースのプロンプティング技術から派生しとることが多いんやで。

---

## Page 5

[](/attach/06d9e15bc94457f08dfa24411ced93d626e981a2f805e98b5a0298e906b7c885_p005.png)

### 和訳

こういうプロンプトのテクニックのことを「エージェント」って呼んでるねん(セクション4.1のとこで詳しく書いてるで)。

エージェントとかプロンプトのテクニックから出てきた結果をちゃんと評価する方法を知っとくのがめっちゃ大事やねん。正確かどうか確認したり、ハルシネーション——つまりAIが嘘ついてまうやつ——を防がなあかんからな。そのへんの評価方法についてはセクション4.2で話してるで。あと、セキュリティ(セクション5.1)と安全対策(セクション5.2)についても触れてて、会社やユーザーに被害が出るリスクを減らすためのプロンプト設計の話をしてるねん。

最後に、プロンプトのテクニックを2つのケーススタディで実際に使ってみてるで(セクション6.1)。1つ目は、いろんなプロンプトテクニックをMMLUっていうよく使われるベンチマーク(Hendrycks et al., 2021)でテストしたやつ。2つ目は、ガチのリアルな使い道として、手動でプロンプトエンジニアリングする例を詳しく掘り下げてるねん。具体的には、助けを求めてる人の文章から「必死の絶望感」——自殺危機のめっちゃ重要なサインやねん——を見つけ出すっていうやつ(Schuck et al., 2019a)。最後にプロンプティングの本質と最近の発展についてまとめてるで(セクション8)。

## 1.1 プロンプトってなんやねん?

プロンプトっていうのは、生成AIモデルへの入力のことで、AIの出力をガイドするためのもんやねん(Meskó, 2023; White et al., 2023; Heston and Khun, 2023; Hadi et al., 2023; Brown et al., 2020)。プロンプトはテキストやったり、画像やったり、音声やったり、その他のメディアやったりするで。例えば、「会計事務所のマーケティングキャンペーン用に3段落のメール書いて」っていうテキストとか、「10×179は?」って書いてある紙の写真とか、オンライン会議の録音に「これまとめて」っていう指示をつけたやつとかがプロンプトやな。大体テキストが含まれてることが多いけど、テキスト以外のモダリティがもっと一般的になってきたら変わるかもしれんな。

**プロンプトテンプレート** プロンプトはよくプロンプトテンプレート(Shin et al., 2020b)を使って作られるねん。プロンプトテンプレートっていうのは、1つ以上の変数が入ってる関数みたいなもんで、その変数にメディア(だいたいテキスト)を突っ込んでプロンプトを作るっていう仕組みやねん。こうしてできたプロンプトは、テンプレートの「インスタンス(具体例)」って考えられるで。

ツイートの二値分類——ポジティブかネガティブかに分けるやつな——にプロンプティングを適用する例を考えてみよか。こんな感じの最初のプロンプトテンプレートが使えるで:

> ツイートをポジティブかネガティブに分類してな:

> {TWEET}

> 木についての詩を書いて。

> 次のお題について詩を書いて:

> {USER_INPUT}

**図1.2:** プロンプトとプロンプトテンプレートは別の概念やで。テンプレートに入力を突っ込んだらプロンプトになるっちゅうことやな。

データセットの各ツイートがテンプレートのそれぞれのインスタンスに挿入されて、できたプロンプトがLLM(大規模言語モデル)に推論用として渡されるんやで。

## 1.2 用語について

### 1.2.1 プロンプトの構成要素

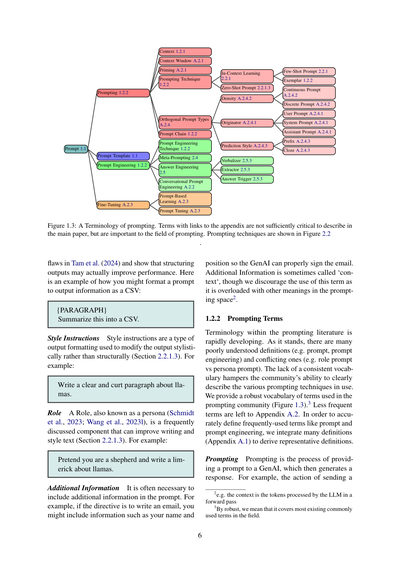

プロンプトにはよく使われる構成要素がいくつかあるねん。よく使われるもんをまとめて、それがプロンプトの中でどう使われてるか説明するで(図1.3)。

**ディレクティブ(指示)** 多くのプロンプトは指示や質問の形でディレクティブを出すねん¹。これがプロンプトの核心部分、いわば「意図」ってやつや。「インテント」って呼ばれることもあるで。例えばこんな感じ:

> おすすめの本5冊教えてくれへん?

ディレクティブは暗黙的な場合もあるで。例えばこのワンショット(1つの例を示す)の場合、英語からスペイン語への翻訳をしてほしいっていうのがディレクティブになってるねん:

> Night: Noche

> Morning:

**例示(エグザンプル)** 例示は、エグザンプラーとかショットとも呼ばれるんやけど、生成AIにタスクをやらせるためのお手本みたいなもんやねん。上のプロンプトはワンショット(1つの例だけ)のプロンプトやな。

**出力フォーマット** 生成AIに特定のフォーマットで出力してほしいことがよくあるやろ。例えばCSV、Markdown、XML、あるいはカスタムフォーマットとか(Xia et al., 2024)。ただし、出力を構造化するとタスクによってはパフォーマンスが落ちることもあるねん(Tam et al., 2024)。せやけどKurt(2024)はいろいろな

---

¹「ディレクティブ」はSearle(1969)から来てるんやけど、行動を促すための言語行為の一種で、人間とコンピュータの対話モデルでも使われてるねん(Morelli et al., 1991)。

---

## Page 6

[](/attach/06d9e15bc94457f08dfa24411ced93d626e981a2f805e98b5a0298e906b7c885_p006.png)

### 和訳

Context 1.2.1(コンテキスト)

コンテキストウィンドウ A.2.1

プライミング A.2.1

プロンプティング技法 1.2.2

プロンプティング 1.2.2

インコンテキスト学習 2.2.1

ゼロショットプロンプト 2.2.1.3

密度 A.2.4.2

フューショットプロンプト 2.2.1

エグザンプラー 1.2.2

連続プロンプト A.2.4.2

離散プロンプト A.2.4.2

ユーザープロンプト A.2.4.1

直交プロンプト型 A.2.4

オリジネーター A.2.4.1

システムプロンプト A.2.4.1

プロンプト 1.1

プロンプトテンプレート 1.1

プロンプトエンジニアリング 1.2.2

ファインチューニング A.2.3

プロンプトチェーン 1.2.2

プロンプトエンジニアリング技法 1.2.2

メタプロンプティング 2.4

アンサーエンジニアリング 2.5

対話型プロンプトエンジニアリング A.2.2

プロンプトベース学習 A.2.3

プロンプトチューニング A.2.3

アシスタントプロンプト A.2.4.1

プレフィックス A.2.4.3

クローズ A.2.4.3

予測スタイル A.2.4.3

バーバライザー 2.5.3

エクストラクター 2.5.3

アンサートリガー 2.5.3

図1.3:プロンプティングの用語まとめやで。付録へのリンクがついてる用語は、本文で詳しく説明するほどちゃうけど、プロンプティングの分野ではめっちゃ大事なやつやねん。プロンプティング技法については図2.2を見てな。

---

Tam et al. (2024) の研究にはちょっとアカンところがあってな、実は出力をちゃんと構造化したほうが性能上がるっていうことを俺らは示してんねん。CSVで情報を出力させたいときのプロンプトの書き方はこんな感じやで:

{PARAGRAPH}

これをCSVにまとめてな。

**スタイル指示** — スタイル指示っていうのは、出力のフォーマットの一種で、構造やなくて文体とか雰囲気を変えるためのもんやねん(セクション2.2.1.3)。例えばこんな感じや:

ラマについて、簡潔でズバッとした段落を書いてな。

**ロール(役割)** — ロールっていうのは、ペルソナとも言うんやけど(Schmidt et al., 2023; Wang et al., 2023l)、よう話題に出る要素で、文章の書き方とかスタイルをようしてくれるやつやねん(セクション2.2.1.3)。例えばな:

あんたは羊飼いやと思って、ラマについてのリメリック(五行詩)を書いてな。

**追加情報** — プロンプトに追加の情報を入れなアカンことも多いねん。例えば「メール書いて」っていう指示やったら、AIがちゃんとメールの署名できるように、自分の名前とか役職とかの情報も一緒に入れたりするやろ。この追加情報のことを「コンテキスト」って呼ぶ人もおるんやけど、プロンプティングの世界では「コンテキスト」って言葉がいろんな意味で使われすぎてるから、俺らはその呼び方はあんまりおすすめせえへんで²。

---

1.2.2 プロンプティングの用語

プロンプティング界隈の用語はめっちゃ速いスピードで発展してんねん。今の状況やと、ちゃんと理解されてへん定義(例えば「プロンプト」とか「プロンプトエンジニアリング」とか)がいっぱいあるし、お互い矛盾してるやつ(例えば「ロールプロンプト」と「ペルソナプロンプト」とか)もあんねん。統一された用語がないもんやから、みんながいろんなプロンプティング技法をちゃんと説明するのが難しくなってるわけや。せやから俺らは、プロンプティングコミュニティで使われてる用語をしっかりまとめたで(図1.3)³。あんまり使われへん用語は付録A.2に置いてあるわ。「プロンプト」とか「プロンプトエンジニアリング」みたいなよく使う用語をちゃんと定義するために、いろんな定義を統合してん(付録A.1)。

**プロンプティング** — プロンプティングっていうのは、生成AI(GenAI)にプロンプトを渡して、それに対して応答を生成させるプロセスのことやねん。例えば、

---

²「コンテキスト」のもう一つの意味:LLMが1回の順伝播で処理するトークンのことも「コンテキスト」って言うんよな。ややこしいやろ。

³「しっかりまとめた」っていうのは、この分野でよく使われてる用語をほぼ全部カバーしてるっていう意味やで。

---

## Page 7

[](/attach/06d9e15bc94457f08dfa24411ced93d626e981a2f805e98b5a0298e906b7c885_p007.png)

### 和訳

**模範例(Exemplar)**

模範例っていうのは、「こういうタスクやったらこうやって完成させるんやで」っていうお手本のことやねん。モデルにプロンプトの中で見せてあげる例のことやな(Brown et al., 2020)。

**1.3 プロンプトの歴史をサクッと振り返るで**

自然言語のプレフィックス、つまり「プロンプト」を使って言語モデルの振る舞いや返答を引き出すっていうアイデア、実はGPT-3やChatGPTの時代より前からあってん。GPT-2(Radford et al., 2019a)がすでにプロンプトを使っとって、生成AIの文脈で最初に使われたんはFan et al.(2018)みたいやな。ただ、プロンプトっていう概念の前には、制御コード(Pfaff, 1979; Poplack, 1980; Keskar et al., 2019)とか、文学における「書き出しのお題(ライティングプロンプト)」みたいな関連する考え方がすでにあったんよ。

「プロンプトエンジニアリング」っていう言葉自体は割と最近できたもんで、Radford et al.(2021)が最初っぽくて、そのちょっと後にReynolds and McDonell(2021)が使ってるな。

ただ、名前は付けてへんけど実質プロンプトエンジニアリングやってた論文はもっと前からあんねん(Wallace et al., 2019; Shin et al., 2020a)。自己回帰じゃない言語モデル向けやとSchick and Schütze(2020a,b)やGao et al.(2021)とかがそうやな。

プロンプティングに関する初期の研究では、「プロンプト」の定義が今とちょっと違っててん。例えば、Brown et al.(2020)のこんな例を見てみてや:

Translate English to French:

llama

Brown et al.(2020)は「llama」の部分をプロンプトやと考えてて、「Translate English to French:」の方は「タスクの説明」やと呼んでたんよ。でも最近の論文、この論文も含めてやけど、LLMに渡す文字列全体をまるっと「プロンプト」って呼ぶようになってるねん。

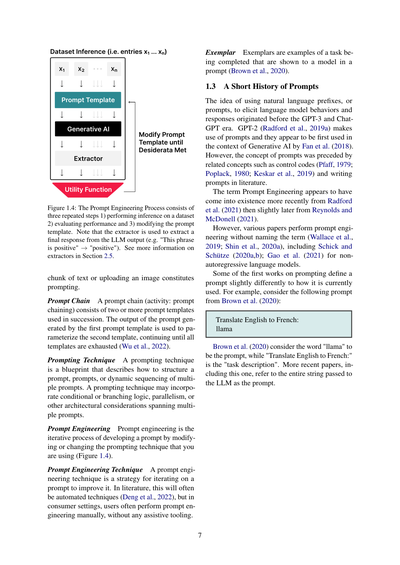

**図1.4:プロンプトエンジニアリングのプロセス**

これは3つのステップをグルグル繰り返すもんやねん。1)データセットに対して推論を実行する、2)性能を評価する、3)プロンプトテンプレートを修正する。ちなみに「エクストラクター」っていうのは、LLMの出力から最終的な回答を取り出すためのもんやで(例えば「This phrase is positive」→「positive」みたいに抽出するんや)。エクストラクターについて詳しくはセクション2.5を見てな。

テキストの塊を入力したり画像をアップロードしたりするのも、全部プロンプティングに含まれるねん。

**プロンプトチェーン**

プロンプトチェーン(やること:プロンプトチェーニング)っていうのは、2つ以上のプロンプトテンプレートを順番に使うことやねん。最初のプロンプトテンプレートから生成されたプロンプトの出力を、次のテンプレートのパラメータとして使って、全部のテンプレートを使い切るまで続けるんや(Wu et al., 2022)。要するに数珠つなぎにするってことやな。

**プロンプティングテクニック**

プロンプティングテクニックっていうのは、プロンプトの構造をどう組み立てるかの設計図みたいなもんやねん。1つのプロンプトの場合もあれば、複数のプロンプトの場合もあるし、動的に複数のプロンプトを順序立てて使う場合もある。条件分岐のロジックとか、並列処理とか、複数のプロンプトにまたがるアーキテクチャ的な考慮も含まれるで。

**プロンプトエンジニアリング**

プロンプトエンジニアリングっていうのは、使ってるプロンプティングテクニックを変えたり修正したりしながら、プロンプトをどんどん改良していく反復的なプロセスのことやねん(図1.4参照)。めっちゃざっくり言うと「試行錯誤してプロンプトを磨いていく作業」や。

**プロンプトエンジニアリングテクニック**

プロンプトエンジニアリングテクニックっていうのは、プロンプトを改善するために繰り返し修正していく戦略のことやな。学術論文では自動化されたテクニック(Deng et al., 2022)が多いんやけど、一般ユーザーの世界では、補助ツールなしで手動でプロンプトエンジニアリングしてることがほとんどやねん。

---

## Page 8

[](/attach/06d9e15bc94457f08dfa24411ced93d626e981a2f805e98b5a0298e906b7c885_p008.png)

### 和訳

2 プロンプティングのメタ分析

2.1 システマティックレビューのプロセス

ほんで、この論文のためにちゃんとしたデータセットを集めるために、PRISMAプロセス(Page et al., 2021)っていうやり方に基づいてシステマティック文献レビューをやったんよ(図2.1)。このデータセットはHuggingFace⁴に公開してて、データシート(Gebru et al., 2021)は付録A.3に載せてるで。主なデータの出どころはarXiv、Semantic Scholar、ACLの3つやねん。これらのデータベースに、プロンプティングとプロンプトエンジニアリングにピンポイントで関係する44個のキーワード(付録A.4)を使って検索かけたんや。

2.1.1 パイプライン

このセクションでは、ワイらのデータ収集パイプラインを紹介するで。これ、人間とLLM(大規模言語モデル)の両方を使ったレビューが入ってんねん⁵。まず最初のサンプルとしてフィルタリングの基準を決めるために、シンプルなキーワードとブール演算のルール(A.4)を使ってarXivから論文を引っ張ってきたんよ。ほんで、人間のアノテーター(ラベル付けする人)が、arXivのセットから1,661本の論文をサンプリングして、以下の基準でラベル付けしたんや:

1. 新しいプロンプティング手法を提案してる論文は入れる。

2. ハードプレフィックスプロンプト(モデルの入力の頭にくっつけるタイプのプロンプト)だけを扱ってる論文は入れる。

3. 勾配を逆伝播させて学習させる系の論文は除外する。

4. テキスト以外のデータに対してマスクやウィンドウの仕組みを使ってる論文は入れる。

300本の論文を2人のアノテーターが独立にレビューして、一致率92%(クリッペンドルフのα=コーエンのκ=81%)やったで。なかなかええ一致率やな。次に、残りの論文を分類するためにgpt-4-1106-previewを使ったプロンプトを開発したんよ(付録A.5)。このプロンプトを100個の正解データで検証したら、適合率89%、再現率75%(F1スコア81%)を達成したんや。人間とLLMのアノテーションを合わせて、最終的に1,565本の論文セットができあがったっちゅうわけや。

図2.1:PRISMAのシステマティック文献レビューのプロセス。4,247件のユニークなレコードを集めて、そこから1,565件の関連レコードを抽出してんねん。

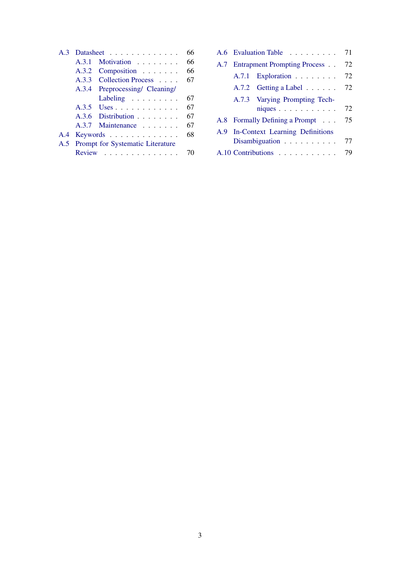

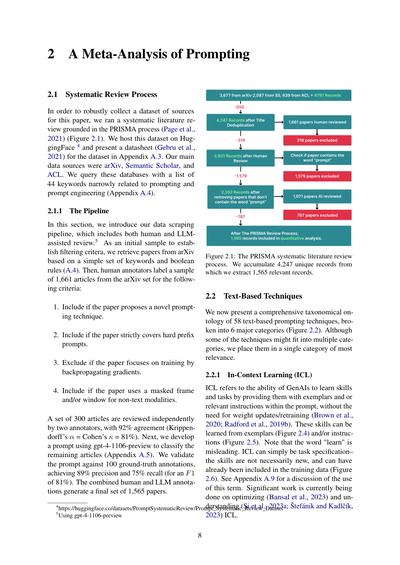

2.2 テキストベースの手法

ほな、ここから58個のテキストベースのプロンプティング手法を体系的に分類した全体像を紹介するで。6つの大きなカテゴリに分けてんねん(図2.2)。いくつかの手法は複数のカテゴリにまたがるかもしれんけど、一番関係が深いカテゴリに1つだけ入れてるで。

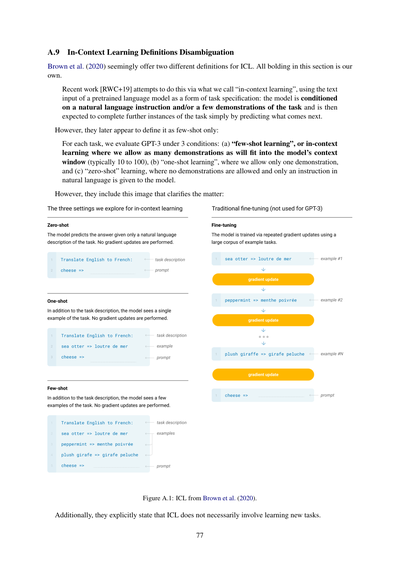

2.2.1 文脈内学習(ICL)

ICLっていうのは、生成AIが、重みの更新(再学習)なしに、プロンプトの中に例とか関連する指示を入れるだけでスキルやタスクを学べる能力のことやねん(Brown et al., 2020; Radford et al., 2019b)。こういうスキルは例示(図2.4)や指示(図2.5)から学べるんよ。ただし注意してほしいんやけど、「学ぶ」っていう言い方はちょっと誤解を招くねん。なんでかっていうと、ICLは単にタスクを指定してるだけの場合もあって、そのスキルは別に新しいもんやなくて、すでに学習データに含まれてた可能性もあるからやねん(図2.6)。この用語の使い方についての議論は付録A.9を見てな。ICLの最適化(Bansal et al., 2023)や理解(Si et al., 2023a; Štefánik and Kadlčík, 2023)に関する研究もめっちゃ活発に進んでるで。

⁴ https://huggingface.co/datasets/PromptSystematicReview/Prompt_Systematic_Review_Dataset

⁵ gpt-4-1106-previewを使用

8

PRISMAレビュープロセスの結果、定量分析に含めたレコードは1,565件。arXivから3,677件、Semantic Scholarから2,087件、ACLから639件で合計4,797件→タイトルの重複を除いて4,247件→人間が1,661本レビューして316本除外→人間レビュー後3,931件→「prompt」って単語が入ってない論文を除いて2,352件→AIが1,071本レビューして787本除外→最終的に1,565件が残ったっちゅう流れやな。

---

## Page 9

[](/attach/06d9e15bc94457f08dfa24411ced93d626e981a2f805e98b5a0298e906b7c885_p009.png)

### 和訳

**図2.2:ワイらのデータセットに含まれる、テキストベースのプロンプト技術の全体像やで。**

---

**テキストベースのプロンプト技術**っちゅう大きなくくりがあってな、ここからめっちゃいろんな技が枝分かれしとんねん。ほな順番に見ていこか。

---

**Few-Shot(2.2.1)** — 「お手本いくつか見せてから聞く」やつやな

- **お手本の並び順(Exemplar Ordering)2.2.1.1**

- **お手本の選び方(Exemplar Selection)2.2.1.2** — KNN(2.2.1.2)、Vote-K(2.2.1.2)

- **お手本の自動生成(Exemplar Generation)** — SG-ICL(2.2.1.2)

- **指示文の選び方(Instruction Selection)2.2.1.1**

- **プロンプトマイニング(Prompt Mining)2.2.1.2** — ええ感じのプロンプトを掘り出す技やな

---

**Zero-Shot(2.2.1.3)** — 「お手本なしでいきなり聞く」やつ。ここからいろいろ派生しとんねん

- **Emotion Prompting(2.2.1.3)** — 感情に訴えかけるプロンプトや

- **Role Prompting(2.2.1.3)** — 「あんたは○○の専門家やで」って役割を与えるやつ

- **Style Prompting(2.2.1.3)** — 文体を指定するやつ

- **S2A(2.2.1.3)** — 注意を向けるべきとこだけに絞る技

- **SimToM(2.2.1.3)** — 相手の立場をシミュレーションする技

- **RaR(2.2.1.3)** — 言い換えてから答えさせる技

- **RE2(2.2.1.3)** — 読み直してから答えさせる技

- **Self-Ask(2.2.1.3)** — 自分で自分に質問させる技

---

**思考生成(Thought Generation)2.2.2** — AIに「考える過程」を出させる系の技術やで

**Chain-of-Thought(CoT)2.2.2** — 「一歩ずつ考えてみて」っていう、めっちゃ有名なやつやな

- **Zero-Shot CoT(2.2.2.1)** — お手本なしで「ステップバイステップで考えて」って言うだけのやつ

- **Analogical Prompting(2.2.2.1)** — 似た問題を思い出させる技

- **Step-Back Prompting(2.2.2.1)** — 一歩引いて大きな視点で考えさせる技

- **Thread-of-Thought(ThoT)2.2.2.1** — 思考の糸をたどらせる技

- **Tab-CoT(2.2.2.1)** — 表形式で整理しながら考えさせる技

- **Few-Shot CoT(2.2.2.2)** — 考える過程のお手本も一緒に見せるやつ

- **Active-Prompt(2.2.2.2)** — 不確かなとこを重点的にお手本として使う技

- **Auto-CoT(2.2.2.2)** — 思考の連鎖を自動で作る技

- **Complexity-Based(2.2.2.2)** — 複雑なお手本を優先的に選ぶ技

- **Contrastive(2.2.2.2)** — 正解と不正解の両方見せて対比させる技

- **Memory-of-Thought(2.2.2.2)** — 過去の思考を記憶して活用する技

- **Uncertainty-Routed CoT(2.2.2.2)** — 不確かさに応じてルートを変える技

- **AutoDiCoT(6.2.3.3)** — 自動で蒸留したCoTを使う技

---

**分解(Decomposition)2.2.3** — でっかい問題を小さく分けて解く系やで

- **DECOMP(2.2.3)** — 問題をサブタスクに分解する基本技

- **Faithful CoT(2.2.3)** — 忠実に論理を追う思考の連鎖

- **Least-to-Most(2.2.3)** — 簡単なとこから順番に攻める技

- **Plan-and-Solve(2.2.3)** — まず計画立ててから解く技

- **Program-of-Thought(2.2.3)** — プログラムみたいに考えさせる技

- **Recursion-of-Thought(2.2.3)** — 再帰的に考えさせる技

- **Skeleton-of-Thought(2.2.3)** — まず骨組み作ってから肉付けする技

- **Tree-of-Thought(2.2.3)** — 木の枝みたいに分岐させて考える技

- **Metacognitive(2.2.3)** — 「自分の考え方について考える」っていうメタな技

---

**アンサンブル(Ensembling)2.2.4** — 複数の答えをまとめてええとこ取りする系や

- **COSP(2.2.4)** — 自分で一貫性チェックしてお手本選ぶ技

- **DENSE(2.2.4)** — 密にアンサンブルする技

- **DiVeRSe(2.2.4)** — 多様なプロンプトで検証する技

- **Max Mutual Information(2.2.4)** — 相互情報量が最大になるように選ぶ技

- **Meta-CoT(2.2.4)** — メタ的に思考の連鎖をまとめる技

- **MoRE(2.2.4)** — 複数の推論を混ぜる技

- **Self-Consistency(2.2.4)** — 何回も答えさせて多数決取る、めっちゃ有名な技やで

- **Universal Self-Consistency(2.2.4)** — 自己一貫性をもっと汎用的にした技

- **USP(2.2.4)** — 普遍的な自己適応プロンプト

- **Prompt Paraphrasing(2.2.4)** — プロンプトを言い換えて複数回試す技

---

**自己批判(Self-Criticism)2.2.5** — 自分で自分の答えをチェックして直す系やな

- **Chain-of-Verification(2.2.5)** — 検証を連鎖的にやる技

- **Self-Calibration(2.2.5)** — 自分の確信度を調整する技

- **Self-Refine(2.2.5)** — 自分で答えを磨き直す技

- **Self-Verification(2.2.5)** — 自分で答えを検証する技

- **ReverseCoT(2.2.5)** — 逆方向から考えて検証する技

- **Cumulative Reasoning(2.2.5)** — 推論を積み重ねていく技

---

ほんまにめっちゃ種類あるやろ?ようするに「AIにどう聞いたら賢い答えが返ってくるか」っていう技の百科事典みたいなもんやねん。9ページ目の図やで。

---

## Page 10

[](/attach/06d9e15bc94457f08dfa24411ced93d626e981a2f805e98b5a0298e906b7c885_p010.png)

### 和訳

2+2: よっつ

4+5: ここのつ

8+0:

図2.4: ICLの例示プロンプト

以下のテキストから、同じ文字が3つ入ってて、

かつそれ以外の文字も3つ以上ある単語を

全部抜き出してな: {TEXT}

図2.5: ICLの指示プロンプト

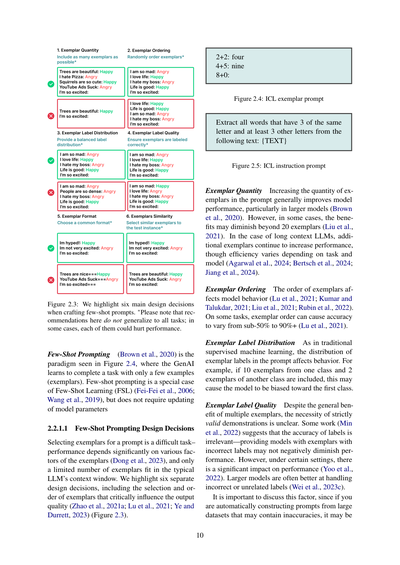

**例示の数**

プロンプトに入れる例示の数を増やしたら、基本的にモデルの性能は上がるねん。特にデカいモデルやとそれが顕著やな(Brown et al., 2020)。ただな、場合によっては20個超えたあたりから効果が頭打ちになることもあるんよ(Liu et al., 2021)。ロングコンテキストに対応したLLMの場合は、例示を増やし続けても性能は伸びていくんやけど、その効率はタスクとモデルによってバラバラやねん(Agarwal et al., 2024; Bertsch et al., 2024; Jiang et al., 2024)。

**例示の並び順**

例示をどの順番で並べるかっていうのが、モデルの挙動にめっちゃ影響するねん(Lu et al., 2021; Kumar and Talukdar, 2021; Liu et al., 2021; Rubin et al., 2022)。タスクによっては、並び順を変えるだけで正解率が50%以下から90%超えまでブレるっていうとんでもない話もあるんよ(Lu et al., 2021)。

**例示のラベル分布**

従来の教師あり機械学習と一緒で、プロンプト内の例示のラベルの偏りが挙動に影響するねん。たとえば、あるクラスの例示を10個、別のクラスを2個だけ入れたら、モデルが多い方のクラスに偏りやすくなるっちゅうわけや。

**例示のラベルの質**

複数の例示を入れるのがええのは間違いないんやけど、その例示が厳密に正しくないとアカンのかっていうと、実はそこがようわからんねん。ある研究(Min et al., 2022)では、ラベルの正確さは関係ないって言うてて、間違ったラベルの例示を入れても性能は別に落ちへんかったらしいんよ。でもな、条件によってはほんまに性能にガッツリ影響するケースもあるねん(Yoo et al., 2022)。デカいモデルほど、間違ったラベルや関係ないラベルにもうまく対応できる傾向があるで(Wei et al., 2023c)。

これ、なんで大事かっていうとな、大量のデータセットから自動でプロンプトを組み立てる場合、そのデータに不正確なもんが混じってる可能性があるからやねん。

図2.3: Few-shotプロンプトを作るときの主要な設計判断を6つまとめたで。※ここでの推奨事項が全部のタスクに当てはまるわけちゃうから注意な。場合によっては逆に性能が落ちることもあるんよ。

**Few-Shotプロンプティング**(Brown et al., 2020)っていうのは、図2.4みたいに、ほんの数個の例(例示)だけでGenAIにタスクを学習させるやり方やねん。Few-Shotプロンプティングは、Few-Shot学習(FSL)(Fei-Fei et al., 2006; Wang et al., 2019)の特殊なケースなんやけど、モデルのパラメータを更新する必要がないっていうのがミソやな。

**2.2.1.1 Few-Shotプロンプティングの設計判断**

プロンプトに入れる例示を選ぶのって、めっちゃ難しいねん。なんでかっていうと、性能は例示のいろんな要素にガッツリ左右されるし(Dong et al., 2023)、普通のLLMのコンテキストウィンドウには限られた数の例示しか入らへんからやねん。ここでは6つの設計判断をピックアップしてるで。例示の選び方と並び順が出力の品質にめっちゃ重要な影響を与えるんよ(Zhao et al., 2021a; Lu et al., 2021; Ye and Durrett, 2023)(図2.3)。

---

**1. 例示の数** — できるだけぎょうさん例示を入れるんや※

Trees are beautiful: / I hate Pizza: / Squirrels are so cute: / YouTube Ads Suck: / I'm so excited: → Happy / Happy / Angry / Angry

Trees are beautiful: / I'm so excited: → Happy

**2. 例示の並び順** — ランダムに並べ替えるんや※

I am so mad: / I love life: / I hate my boss: / Life is good: / I'm so excited: → Angry / Angry / Happy / Happy

I love life: / Life is good: / I am so mad: / I hate my boss: / I'm so excited: → Happy / Happy / Angry / Angry

**3. 例示のラベル分布** — ラベルの偏りをなくしてバランスよくするんや※

I am so mad: / People are so dense: / I hate my boss: / Life is good: / I'm so excited: → Angry / Angry / Angry / Happy

I am so mad: / I love life: / I hate my boss: / Life is good: / I'm so excited: → Angry / Angry / Happy / Happy

**4. 例示のラベルの質** — 例示のラベルがちゃんと正しいか確認するんや※

I am so mad: / I love life: / I hate my boss: / Life is good: / I'm so excited: → Angry / Angry / Happy / Happy

I am so mad: / I love life: / I hate my boss: / Life is good: / I'm so excited: → Happy / Happy / Angry / Angry

**5. 例示のフォーマット** — よく使われる形式を選ぶんや※

Im hyped!: / Im not very excited: / I'm so excited: → Happy / Angry

Trees are nice=== / YouTube Ads Suck=== / I'm so excited=== → Happy / Angry

**6. 例示の類似度** — テスト対象に似てる例示を選ぶんや※

Im hyped!: / Im not very excited: / I'm so excited: → Happy / Angry

Trees are beautiful: / YouTube Ads Suck: / I'm so excited: → Happy / Angry

---

## Page 11

[](/attach/06d9e15bc94457f08dfa24411ced93d626e981a2f805e98b5a0298e906b7c885_p011.png)

### 和訳

テストデータDtestに対して生成されるやつやねん。テスト時にはこういうプロンプトのテンプレートを使うで、「入力:出力」っていうフォーマットに沿ってな(図2.4):

xi

図2.6:学習データからのICL(文脈内学習)プロンプトやで。

このバージョンのICLやと、モデルは新しいスキルを学んでるわけちゃうねん。むしろ、学習データにたぶん入ってた知識を使ってるだけやねん。

{例示}

Dtest:

xi

ラベルの質が結果にどう影響するかっちゅうのは、ちゃんと調べとく必要があるで。

**例示のフォーマット** 例示の書き方も性能に影響すんねん。一番よう使われるフォーマットは「Q: {入力}, A: {ラベル}」やけど、タスクによってベストなフォーマットは変わるかもしれんから、いくつか試してみる価値はあるで。学習データによう出てくるフォーマットの方が性能ええっちゅう証拠もあるんや(Jiang et al., 2020)。

**例示の類似性** テストサンプルに似てる例示を選ぶのは、基本的には性能にええ影響があるで(Liu et al., 2021; Min et al., 2022)。せやけど、場合によってはもっと多様な例示を選んだ方が性能上がることもあんねん(Su et al., 2022; Min et al., 2022)。

**指示文の選び方** ゼロショットプロンプト(例示なしのやつ)では指示文がLLMを導くのに必須やねんけど(Wei et al., 2022a)、フューショットプロンプトで例示の前に指示文つけるメリットはそこまではっきりしてへんのよ。Ajith et al.(2024)が示したんは、汎用的でタスクに依存せえへん指示文(つまり指示文なしとか「次のタスクを完了せよ:」みたいなん)の方が、タスク固有の指示文(例えば「この質問の答えは何ですか?」とか)より分類や質問応答の精度がええっちゅうことやねん。要するに、指示に従う能力は例示だけでも達成できるっちゅう結論や。正確さの向上にはつながらんかもしれんけど、フューショットプロンプトの指示文は文体みたいな補助的な出力の特性をガイドするのには使えるで(Roy et al., 2023)。

**2.2.1.2 フューショットプロンプティングのテクニック**

こういう要素を全部考えると、フューショットプロンプティングをうまいこと実装するんはめっちゃ難しいねん。ここからは教師あり設定でのフューショットプロンプティングのテクニックを見ていくで。アンサンブル手法もフューショットプロンプティングに役立つけど、それは別のとこ(セクション2.2.4)で話すわ。

学習データセットDtrainがあるとするやん。これには複数の入力Dtrainと出力Dtrainが入ってて、勾配ベースの更新(いわゆる普通の学習)をする代わりに、GenAI(生成AI)にフューショットプロンプトとして使えるねん。このプロンプトは動的に

xi

図2.7:フューショットプロンプティングのテンプレート

**K近傍法(KNN)**(Liu et al., 2021)は、テストデータDtestに似てる例示を選んで性能を上げるアルゴリズムのファミリーの一つやねん。効果的ではあるんやけど、プロンプト生成時にKNNを使うんは時間もリソースもめっちゃかかるかもしれんで。

xi

**Vote-K**(Su et al., 2022)は、テストサンプルに似た例示を選ぶもう一つの方法やで。第一段階では、モデルがアノテーター(ラベル付けする人)にラベルを付けてもらうための有用なラベルなし候補例示を提案すんねん。第二段階では、ラベル付けされたプールをフューショットプロンプティングに使うんや。Vote-Kはさらに、新しく追加する例示が既存のもんと十分に違うようにして、多様性と代表性を高めるようにしてるで。

**自己生成文脈内学習(SG-ICL)**(Kim et al., 2022)は、GenAIを使って自動的に例示を生成する方法やねん。学習データがない場合にゼロショットよりはマシやけど、生成されたサンプルは実際のデータほど効果的ちゃうねん。

**プロンプトマイニング**(Jiang et al., 2020)は、大規模コーパス(テキストの集まり)を分析して、プロンプトの中の最適な「つなぎ言葉」を見つけ出すプロセスやねん。このつなぎ言葉っちゅうのは、実質的にプロンプトのテンプレートのことや。例えば、フューショットプロンプトでよう使われる「Q: A:」フォーマットの代わりに、コーパスの中でもっと頻繁に出てくる似たようなもんがあるかもしれんやん。コーパスでよう出てくるフォーマットの方が、プロンプトの性能は上がりやすいっちゅうわけや。

**もっと高度なテクニック** としては、LENS(Li and Qiu, 2023a)、UDR(Li et al., 2023f)、Active Example Selection(Zhang et al., 2022a)なんかがあって、それぞれ反復フィルタリング、埋め込みと検索、強化学習を活用してるで。

**2.2.1.3 ゼロショットプロンプティングのテクニック**

フューショットプロンプティングとは対照的に、ゼロショットプロンプティングは例示をゼロ個使うやつやねん。よう知られたスタンドアロンのゼロショットテクニックがいくつかあるで

11

---

## Page 12

[](/attach/06d9e15bc94457f08dfa24411ced93d626e981a2f805e98b5a0298e906b7c885_p012.png)

### 和訳

それとゼロショットのテクニックを別のコンセプト(例えばChain of Thoughtとか)と組み合わせるパターンもあるねんけど、それはまた後で話すわ(セクション2.2.2で)。

**ロールプロンプティング**(Wang et al., 2023j; Zheng et al., 2023d)、別名**ペルソナプロンプティング**(Schmidt et al., 2023; Wang et al., 2023l)っていうのは、生成AIに「あんたはこういう役やで」って特定の役割を与えるやり方やねん。例えば「マドンナになりきって」とか「旅行ライターとして書いて」みたいに指示するわけや。こうすると、自由度の高いタスクでええ感じのアウトプットが出やすくなるし(Reynolds and McDonell, 2021)、場合によってはベンチマークの精度もアップすることがあるねん(Zheng et al., 2023d)。

**スタイルプロンプティング**(Lu et al., 2023a)は、プロンプトの中で「こういう文体で」「こういうトーンで」「こういうジャンルで」って指定して、生成AIの出力をコントロールするテクニックやねん。ロールプロンプティングでも似たような効果が得られるで。

**エモーションプロンプティング**(Li et al., 2023a)は、人間の心理に刺さるようなフレーズ(例えば「これ、私のキャリアにめっちゃ大事なんです」みたいなやつ)をプロンプトにぶっ込むっていうテクニックやねん。なんでかっていうと、こうするとLLMのベンチマーク性能とか、自由文生成の質が上がることがあるからやで。

**System 2 Attention (S2A)**(Weston and Sukhbaatar, 2023)は、まずLLMに「このプロンプトを書き直して、質問に関係ない情報は全部消して」ってお願いするねん。ほんで、そのスッキリした新しいプロンプトをLLMに渡して最終回答を出させるっていう二段構えのやり方や。

**SimToM**(Wilf et al., 2023)は、複数の人とかモノが絡むややこしい質問に対処するためのテクニックやねん。質問が出てきたら、まず「この人が知ってる事実はこれだけやな」って情報を整理して、その限られた事実だけを元に質問に答えるっていう流れや。プロンプトを2回使うプロセスで、プロンプト内の関係ない情報に惑わされへんようにできるねん。

**Rephrase and Respond (RaR)**(Deng et al., 2023)は、LLMに「質問を言い換えて詳しくしてから答えてな」って指示するやり方やねん。例えば質問の後に「この質問を言い換えて展開してから回答してください」みたいなフレーズを付け足すわけや。これを一発でやることもできるし、言い換えた質問を改めてLLMに渡すこともできる。RaRは複数のベンチマークで改善が確認されてるで。

**Re-reading (RE2)**(Xu et al., 2023)は、プロンプトに「もう一回質問を読んでな:」っていうフレーズを追加して、さらに質問自体も繰り返すっていうテクニックや。めっちゃシンプルやろ?でもほんまにこれだけで推論ベンチマークの成績が上がるねん、特に複雑な問題で効果的やで。

**Self-Ask**(Press et al., 2022)は、LLMに「この質問に答えるために、追加で聞かなあかんことあるか?」って最初に判断させるやり方やねん。もし必要やったら、LLMが自分でフォローアップの質問を作って、それに答えて、最終的に元の質問に答えるっていう流れや。

### 2.2.2 思考生成

思考生成っていうのは、問題を解くときにLLMに「自分の考えを言葉にしながら解いてな」って促すテクニックの総称やねん(Zhang et al., 2023c)。

**Chain-of-Thought (CoT) プロンプティング**(Wei et al., 2022b)は、Few-shotプロンプティングを活用して、LLMに最終回答を出す前に思考プロセスを表現させるテクニックやねん⁶。これ「Chain-of-Thoughts」って呼ばれることもあるで(Tutunov et al., 2023; Besta et al., 2024; Chen et al., 2023d)。数学とか推論タスクでLLMの性能がめっちゃ上がることが実証されてるねん。Wei et al. (2022b)のプロンプトでは、質問と推論の道筋と正解を含んだ例題が入ってるで(図2.8)。

> Q: ジャックはカゴを2つ持ってて、それぞれに3個ずつボールが入ってます。ジャックは全部でボール何個持ってますか?

> A: 1つのカゴに3個入ってるから、2つのカゴやと 3 × 2 = 6個やな。

> Q: {質問}

> A:

>

> 図2.8: ワンショットChain-of-Thoughtプロンプトの例

#### 2.2.2.1 ゼロショットCoT

CoTの一番シンプルなバージョンは、例題ゼロのやつやねん。プロンプトの最後に「ステップバイステップで考えてみよう」(Kojima et al., 2022)みたいな思考を誘発するフレーズをくっつけるだけや。他にも「まず論理的に考えてみよう」(Kojima et al., 2022)とかが提案されてるで。Zhou et al. (2022b)はLLMを使って「正しい答えを確実に出すために、順を追って考えていきましょう」っていうフレーズを生成してるし、Yang et al. (2023a)は最適な思考誘発フレーズを探索してるねん。ゼロショット

⁶ こういうテクニックの説明では「考える」みたいにモデルを擬人化する言葉がよう使われるねんけど、ワイらはなるべくそういう表現は避けるようにしてるで。ただ、元の著者の言葉遣いはそのまま使うこともあるわ。

---

## Page 13

[](/attach/06d9e15bc94457f08dfa24411ced93d626e981a2f805e98b5a0298e906b7c885_p013.png)

### 和訳

CoTのアプローチってめっちゃええねん。なんでかっていうと、例題(エグゼンプラ)がいらんし、基本的にどんなタスクにも使えるっていう汎用性があるからやねん。

GPT-4とGemini Ultraの両方のモデルでベンチマークになっとるで。

**ステップバック・プロンプティング**(Zhengら、2023c)はCoTをちょっとアレンジしたやつやねん。具体的な推論に入る前に、まずLLMに「そもそもこの話の関連概念とか事実ってなんやっけ?」っていう、ざっくりした高レベルの質問をさせるんやな。このやり方で、PaLM-2LとGPT-4の両方で、いろんな推論ベンチマークの成績がめっちゃ上がったんやで。

**アナロジカル・プロンプティング**(Yasunagaら、2023)はSG-ICLに似とって、CoT付きの例題を自動で生成してくれるやつやねん。数学の推論とかコード生成のタスクで改善が確認されとるで。

**スレッド・オブ・ソート(ThoT)プロンプティング**(Zhouら、2023)は、CoT推論の「考えを引き出すフレーズ」を改良したやつやな。普通やったら「ステップバイステップで考えよう」って言うところを、「この文脈を扱いやすい部分に分けて順番に見ていこう、途中で要約と分析もしながらな」って言い換えるねん。この言い回し、質問応答とか情報検索の場面でめっちゃ効くんやけど、特にデカくて複雑な文脈を扱うときにほんまに強いんやで。

**タブラー・チェーン・オブ・ソート(Tab-CoT)**(JinとLu、2023)は、ゼロショットCoTプロンプトの一種で、LLMの推論をマークダウンの表形式で出力させるっていうアイデアやねん。表にすることで、出力の構造がスッキリして、結果的に推論の質も上がるっちゅうわけや。

**2.2.2.2 フューショットCoT**

このグループの技術は、思考の連鎖(CoT)を含む複数の例題をLLMに見せるやり方やねん。これでパフォーマンスがめっちゃ上がることがあるんやで。この技術は「マニュアルCoT」(Zhangら、2022b)とか「ゴールデンCoT」(DelとFishel、2023)って呼ばれることもあるな。

**コントラスティブCoTプロンプティング**(Chiaら、2023)は、CoTプロンプトに正しい説明だけやなくて、間違った説明の例題もわざと入れるんやな。要するに「こう考えたらアカンで」ってLLMに教えるわけや。算数の推論とか事実に基づくQAとかで、ほんまにめっちゃ改善が見られたんやで。

**不確実性ルーティングCoTプロンプティング**(Google、2023)は、まず複数のCoT推論パスをサンプリングして、多数決の結果がある閾値(バリデーションデータから計算するやつ)を超えとったらそれを採用するねん。超えてなかったら、貪欲法(一番確率高いやつを順に選ぶ方法)でサンプリングして、その回答を使うっちゅう仕組みや。MMLUベンチマークで改善が確認されとるで。

**複雑性ベース・プロンプティング**(Fuら、2023b)は、CoTに2つの大きな工夫を加えたやつやねん。まず1つ目は、問題の長さとか必要な推論ステップ数みたいな要素を基にして、複雑な例題を選んでプロンプトに入れること。2つ目は、推論のときに複数の推論チェーン(回答)をサンプリングして、ある長さの閾値を超えたチェーンだけで多数決を取ること。「推論が長いほど回答の質が高いはずや」っていう前提やな。3つの数学推論データセットで改善が確認されとるで。

**アクティブ・プロンプティング**(Diaoら、2023)は、まずいくつかの訓練用の問題や例題を用意して、LLMに解かせるねん。ほんでその不確実性(ここでは回答のバラつき)を計算して、一番不確実性が高かった例題を人間のアノテーターに書き直してもらうっちゅうやり方やな。

**メモリー・オブ・ソート・プロンプティング**(LiとQiu、2023b)は、ラベルなしの訓練用例題を使って、テスト時にフューショットCoTプロンプトを作るやつやねん。テスト前に、ラベルなしの訓練例題にCoTで推論をかけておいて、テスト時にはテストサンプルに似たやつを引っ張ってくるんやな。算数、常識、事実に基づく推論のベンチマークでかなりの改善が出とるで。

**自動チェーン・オブ・ソート(Auto-CoT)プロンプティング**(Zhangら、2022b)は、Weiら(2022b)のゼロショットプロンプトを使って、思考の連鎖を自動生成するやつやねん。そうやって作ったやつを使って、テストサンプル用のフューショットCoTプロンプトを組み立てるっちゅう流れや。

**2.2.3 分解(デコンポジション)**

複雑な問題をシンプルなサブ問題に分解するっていう研究がめっちゃ盛んやねん。これは人間にとっても生成AI(GenAI)にとっても有効な問題解決の戦略やで(Patelら、2022)。分解系のテクニックの中には、CoTみたいな「考えを引き出す系」の技術に似とるやつもあるんやな。CoTって自然と問題をシンプルな要素に分けることが多いからやねん。でもな、明示的にバラすことで、LLMの問題解決能力をさらに上げられるんやで。

**リースト・トゥ・モスト・プロンプティング**(Zhouら、2022a)は、まずLLMに「この問題をサブ問題に分けてくれ、ただし解かんでええで」って指示するねん。ほんで、そのサブ問題を順番に解いていって、毎回モデルの回答をプロンプトに追加しながら、最終的な答えにたどり着くっちゅうやり方や。

---

## Page 14

[](/attach/06d9e15bc94457f08dfa24411ced93d626e981a2f805e98b5a0298e906b7c885_p014.png)

### 和訳

最終的な答えにたどり着くっちゅうわけや。この方法は、記号の操作とか、いろんなもんを組み合わせて一般化するタスク、あと数学的な推論なんかでめっちゃ成果出してんねん。

**分解プロンプティング(DECOMP)**(Khot ら、2022)は、Few-Shotで「こういう関数使えるで〜」ってLLMにお手本見せるやり方やねん。文字列を分割する関数とか、ネット検索する関数とか、そういうのがあって、これらはだいたい別のLLM呼び出しとして実装されてるんよ。ほんで、LLMが元の問題をサブ問題に分解して、それぞれ別の関数に投げるっちゅうわけ。一部のタスクでは、さっき言うたLeast-to-Mostプロンプティングよりもええ結果出してんねん。

**Plan-and-Solveプロンプティング**(Wang ら、2023f)は、Zero-Shot CoTをパワーアップさせたやつで、「まず問題を理解して解くための計画を立てよう。ほんで、その計画に沿ってステップバイステップで解いていこう」っていうプロンプトを使うねん。普通のZero-Shot-CoTより、いろんな推論データセットでしっかりした推論プロセスを生み出せるんよ。

**思考の木(ToT)**(Yao ら、2023b)、Tree of Thoughtsとも呼ばれてて(Long, 2023)、最初の問題からスタートして、木みたいな探索問題を作るんよ。CoTみたいに「思考」っていう形で複数の可能なステップを生成して、それぞれのステップが問題解決にどんだけ近づいたか(プロンプトで)評価して、どのステップを続けるか決めて、さらに思考を広げていくねん。探索と計画が必要なタスクにめっちゃ強いんよ。

**思考の再帰(Recursion-of-Thought)**(Lee and Kim, 2023)は、普通のCoTと似てるんやけど、推論の途中でややこしい問題にぶち当たったら、その問題を別のプロンプト、つまり別のLLM呼び出しに送るねん。それが解けたら、その答えを元のプロンプトに差し込むっちゅうわけ。こうすることで、再帰的に複雑な問題を解けるようになるし、コンテキストの長さ制限を超えてまうような問題にも対応できるんよ。算術とかアルゴリズム系のタスクで改善が見られてんねん。もともとはファインチューニングで特別なトークンを出力して、サブ問題を別のプロンプトに送る仕組みで実装されてるんやけど、プロンプティングだけでもできるはずやで。

**思考のプログラム(Program-of-Thoughts)**(Chen ら、2023d)は、Codexみたいなコード書けるLLMを使って、推論のステップをプログラムのコードとして生成するねん。ほんで、コードインタープリタがそのステップを実行して最終的な答えを出すっちゅうわけ。数学とかプログラミング系のタスクにはめっちゃ強いんやけど、意味を理解せなあかん推論タスクにはちょっと弱いんよ。

**忠実な思考の連鎖(Faithful Chain-of-Thought)**(Lyu ら、2023)は、自然言語と記号言語(Pythonとか)の両方を使った推論の連鎖を生成するねん。Program-of-Thoughtsと似てるんやけど、タスクに応じていろんな種類の記号言語を使い分けるっていうところがミソやねん。

**思考の骨格(Skeleton-of-Thought)**(Ning ら、2023)は、並列処理で回答スピードを爆速にすることに注目してるんよ。問題が来たら、まずLLMに答えの骨組み、つまりサブ問題みたいなもんを作らせるねん。ほんで、そのサブ問題を並列でLLMに送って、全部の出力をガッチャンコして最終的な回答にするっちゅうわけ。

**メタ認知プロンプティング**(Wang and Zhao, 2024)は、人間のメタ認知プロセス、つまり「自分の考え方について考える」っていうのをLLMに真似させようとするやつで、5段階のプロンプトチェーンを使うねん。質問の明確化、予備的な判断、回答の評価、判断の確認、そして自信度の評価っていうステップがあるんよ。

**2.2.4 アンサンブル**

生成AIの世界で「アンサンブル」っちゅうのは、同じ問題に対して複数のプロンプトを使って、それらの回答をまとめて最終的な出力にするやり方やねん。多くの場合、多数決、つまり一番多く出てきた回答を選ぶっていう方法で最終出力を決めるんよ。アンサンブルはLLMの出力のバラつきを減らして、精度も上がることが多いんやけど、なんでかっていうとその分モデルの呼び出し回数が増えるから、コストはかかるんよな。

**デモンストレーション・アンサンブル(DENSE)**(Khalifa ら、2023)は、トレーニングセットからそれぞれ違うお手本のサブセットを入れた複数のFew-Shotプロンプトを作るねん。ほんで、それぞれの出力をまとめて最終的な回答を出すっちゅうわけ。

**推論エキスパートの混合(MoRE)**(Si ら、2023d)は、いろんな種類の推論に特化したプロンプトを使って、多様な推論のエキスパートを揃えるやり方やねん。例えば、事実に基づく推論には検索拡張プロンプト、多段階推論や数学の推論にはChain-of-Thought、常識推論には生成知識プロンプティング、みたいな感じ。ほんで、全エキスパートの中から「一致度スコア」に基づいてベストな答えを選ぶんよ。

**最大相互情報量法(Max Mutual Information Method)**(Sorensen ら、2022)は、複数のプロンプトテンプレートを作って

---

## Page 15

[](/attach/06d9e15bc94457f08dfa24411ced93d626e981a2f805e98b5a0298e906b7c885_p015.png)

### 和訳

いろんなスタイルとか例文を試してみて、その中からプロンプトとLLMの出力の間の相互情報量が一番でかくなるようなテンプレートを「最適なやつ」として選ぶねん。

**Self-Consistency(自己一貫性)**

(Wang et al., 2022)これはな、「同じ答えにたどり着くルートって一つだけちゃうやろ」っていう直感に基づいてるねん。まずLLMに何回もCoT(思考の連鎖)をやらせるんやけど、ここでポイントなんが、温度パラメータをゼロにせんことやねん。そうすることでいろんな推論パスが出てくるわけや。ほんで、出てきた回答全部に対して多数決を取って、最終的な答えを決めるっちゅうこっちゃ。算数とか常識推論とか記号的な推論タスクでめっちゃ性能上がってるで。

**Universal Self-Consistency(汎用自己一貫性)**

(Chen et al., 2023e)Self-Consistencyとほぼ同じなんやけど、ちょっと違うのは、プログラムで「この答え何回出てきた?」って数えて多数派を選ぶんやなくて、全部の出力をプロンプトのテンプレートにぶち込んで、そこから多数派の答えを選ばせるってとこやねん。これがええのは、自由なテキスト生成とか、同じ答えでもプロンプトによって微妙に表現が変わってまうケースに強いとこやな。

**Meta-Reasoning over Multiple CoTs(複数CoTに対するメタ推論)**

(Yoran et al., 2023)これはUniversal Self-Consistencyに似てんねんけど、まず一つの問題に対して複数の推論チェーンを生成するんや(ただし最終的な答えまでは出さんでもええねん)。ほんで、その全部のチェーンを一つのプロンプトテンプレートにまとめて突っ込んで、そこから最終的な答えを出すっちゅうやり方やねん。

**DiVeRSe**

(Li et al., 2023i)これはまず一つの問題に対して複数のプロンプトを作って、それぞれに対してSelf-Consistencyをかけて、いっぱい推論パスを生成するんや。ほんで各推論パスのステップごとにスコアをつけて、最終的な回答を選ぶねん。

**Self-adaptive Prompting(自己適応プロンプティング)**

(COSP)(Wan et al., 2023a)これはConsistencyベースのやつで、まずいくつかの例題に対してZero-Shot CoT+Self-Consistencyを走らせて、出てきた結果の中から一致度が高いやつを選んで、それをFew-Shot CoTのプロンプトの例文として使うねん。ほんで最終的なプロンプトに対してまたSelf-Consistencyをかけるっちゅう流れや。

**Universal Self-Adaptive Prompting(USP:汎用自己適応プロンプティング)**

(Wan et al., 2023b)COSPの成功を受けて、「これ全部のタスクに使えるようにしたろ」ってことで作られたのがUSPやねん。ラベルなしのデータを使って例文を生成して、もっと凝ったスコアリング関数で例文を選ぶんや。あと、USPはSelf-Consistencyは使わへんねん。

**Prompt Paraphrasing(プロンプトの言い換え)**

(Jiang et al., 2020)元のプロンプトの言い回しをちょっと変えるんやけど、全体的な意味はそのまま保つっていう手法やねん。要はデータ拡張テクニックみたいなもんで、アンサンブル用のプロンプトを作るのに使えるわけや。

### 2.2.5 Self-Criticism(自己批判)

生成AIのシステムを作るとき、LLMに自分の出力をダメ出しさせるっていうのがめっちゃ使えるねん(Huang et al., 2022)。単純に「この出力合ってる?」って判定させるだけのこともあれば、フィードバックを出させて、それを使って答えを改善するパターンもあるんや。自己批判を生成して活用するアプローチはいろいろ開発されとるで。

**Self-Calibration(自己較正)**

(Kadavath et al., 2022)まずLLMに質問に答えさせるやん。ほんで、その質問とLLMの答えと、「この答え合ってると思う?」っていう追加の指示を全部入れた新しいプロンプトを作るねん。これはLLMを使うとき、「この答え信用してええのか、それとも修正した方がええのか」を判断するための確信度を測るのにめっちゃ便利やねん。

**Self-Refine(自己改良)**

(Madaan et al., 2023)これは反復型のフレームワークやねん。まずLLMから最初の答えを出させるやろ、ほんで同じLLMに「この答えどう思う?」ってフィードバックさせて、さらにそのフィードバックを元に答えを改善させるんや。この繰り返しを、止める条件(例えば最大ステップ数に達したとか)が満たされるまで続けるねん。推論、コーディング、生成タスクとか幅広いタスクで性能上がってるで。

**Reversing Chain-of-Thought(RCoT:逆向き思考連鎖)**

(Xue et al., 2023)まずLLMに、生成した答えを元にして問題を逆に復元させるねん。ほんで、元の問題と復元された問題を細かく比較して、矛盾がないかチェックするんや。見つかった矛盾をフィードバックとしてLLMに渡して、答えを修正させるっちゅうわけやな。

**Self-Verification(自己検証)**

(Weng et al., 2022)まずChain-of-Thought(CoT)で複数の候補解を生成するやん。ほんで各解のスコアをつけるんやけど、そのやり方がおもろいねん。元の問題の一部をマスクして隠して、「残りの問題文と生成された解を見て、隠した部分を当ててみ」ってLLMに予測させるんや。ちゃんと予測できたら、その解は元の問題をよう理解してるってことやからな。8つの推論データセットで性能向上が確認されとるで。

---

## Page 16

[](/attach/06d9e15bc94457f08dfa24411ced93d626e981a2f805e98b5a0298e906b7c885_p016.png)

### 和訳

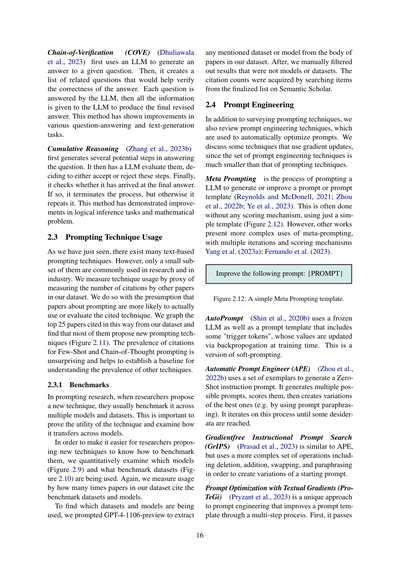

(COVE)

**検証チェーン**(Dhuliawalaら、2023年)ってのはな、まずLLM(大規模言語モデルっていうめっちゃ賢いAIのことやで)に質問の答えを出させるねん。ほんでそっからが面白いとこで、その答えがほんまに合ってるか確認するための関連質問リストを作らせるわけや。で、その質問ひとつひとつをまたLLMに答えさせて、最後に全部の情報をまとめてLLMに渡して、最終的な修正版の答えを出させるんやな。要するに「自分で自分の答えをチェックさせる」っちゅう仕組みやねん。この方法、いろんな質問応答とかテキスト生成のタスクでちゃんと改善が見られてるで。

**累積推論**(Zhangら、2023b)はまた別のアプローチでな。まず質問に答えるための候補ステップをいくつか生成するねん。ほんでLLMにそれを評価させて、「これはええわ、採用!」「これはあかん、却下!」って判断させるわけや。最後に「もう最終回答にたどり着いたか?」をチェックして、たどり着いてたら終了、まだやったらまた繰り返すんやな。論理的な推論とか数学の問題でめっちゃ成果出てるで。

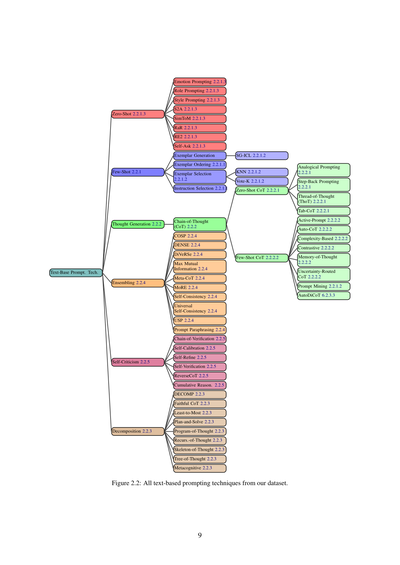

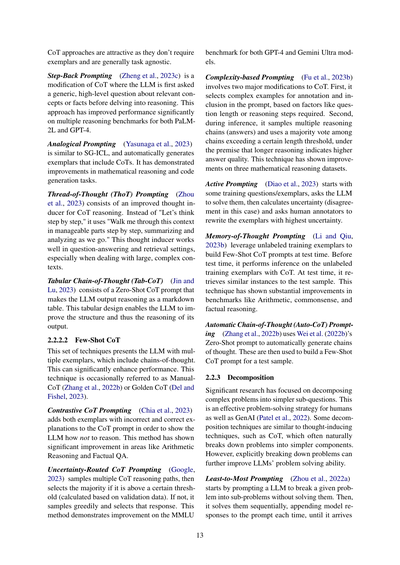

### 2.3 プロンプト技術の使われ方

ここまで見てきたように、テキストベースのプロンプト技術ってほんまにいっぱいあるねん。けどな、実際に研究とか産業界でよう使われてるのはほんの一部だけなんよ。ワイらは技術の使用頻度を、データセット内の他の論文からの引用数で測ったんや。なんでかっていうと、プロンプトについての論文は、引用してる技術を実際に使ったり評価したりしてる可能性が高いやろって前提やねん。上位25本の被引用論文をグラフにしたら(図2.11)、ほとんどが新しいプロンプト技術を提案してる論文やったわ。Few-Shot(少数例提示)とChain-of-Thought(思考の連鎖)プロンプティングの引用が多いのはまあ当然やけど、他の技術がどんだけ使われてるか理解するための基準にはなるわな。

#### 2.3.1 ベンチマーク

プロンプト研究ではな、研究者が新しい技術を提案するとき、普通は複数のモデルとデータセットでベンチマーク(性能テストみたいなもんや)するねん。これがめっちゃ大事でな、その技術がほんまに役立つかとか、違うモデルでも通用するかを証明せなあかんからや。

新しい技術を提案する研究者がベンチマークしやすいように、ワイらはどのモデル(図2.9)とどのベンチマークデータセット(図2.10)が使われてるかを定量的に調べたで。ここでも使用頻度はデータセット内の論文での引用回数で測ってるんや。

どのデータセットとモデルが使われてるか調べるために、GPT-4-1106-previewに論文の本文からデータセット名やモデル名を抽出させたんやな。その後、モデルでもデータセットでもないもんを手作業でフィルタリングして除外したで。引用数はSemantic Scholarで最終リストの項目を検索して取得したんや。

### 2.4 プロンプトエンジニアリング

プロンプト技術の調査に加えて、プロンプトを自動的に最適化する「プロンプトエンジニアリング」技術もレビューしたで。勾配更新(モデルのパラメータをちょっとずつ調整する方法やな)を使う技術もいくつか紹介するで。なんでかっていうと、プロンプトエンジニアリング技術の数はプロンプト技術よりずっと少ないからや。

**メタプロンプティング**ってのは、LLMにプロンプトやプロンプトテンプレートを「生成」したり「改善」させたりするプロセスのことや(Reynoldsら、2021; Zhouら、2022b; Yeら、2023)。シンプルなテンプレート(図2.12)だけでスコアリング仕組みなしでやることが多いんやけど、複数回のイテレーションとスコアリング仕組みを使ったもっと複雑な使い方をしてる研究もあるで(Yangら、2023a; Fernandoら、2023)。

> 以下のプロンプトを改善してください: {PROMPT}

図2.12: シンプルなメタプロンプティングのテンプレート。

**AutoPrompt**(Shinら、2020b)は、凍結した(学習済みで重みを固定した)LLMと、「トリガートークン」っていう特別な値を含むプロンプトテンプレートを使うねん。このトリガートークンの値を学習時にバックプロパゲーション(逆伝播、要するにモデルの出力から逆算して値を更新する方法や)で更新するんやな。これはソフトプロンプティング(プロンプトを数値ベクトルとして直接最適化するやつ)の一種やで。

**自動プロンプトエンジニア(APE)**(Zhouら、2022b)は、例題のセットを使ってZero-Shot(例なしの)指示プロンプトを生成するねん。複数の候補プロンプトを生成して、スコアをつけて、一番ええやつのバリエーション(例えばプロンプトの言い換えとか)を作るんや。で、求める基準に達するまでこのプロセスを繰り返すわけやな。

**GrIPS(勾配なし指示プロンプト探索)**(Prasadら、2023)はAPEに似てるんやけど、削除・追加・入れ替え・言い換えっていうもっと複雑な操作セットを使って、元のプロンプトのバリエーションを作るところが違うねん。

**ProTeGi(テキスト勾配によるプロンプト最適化)**(Pryzantら、2023)はめっちゃユニークなアプローチでな、プロンプトテンプレートを複数ステップのプロセスで改善していくんや。まず最初に──

---

## Page 17

[](/attach/06d9e15bc94457f08dfa24411ced93d626e981a2f805e98b5a0298e906b7c885_p017.png)

### 和訳

図2.9: 生成AIモデルの引用回数

図2.11: プロンプト技術の引用回数

ワイらのデータセットん中で、他の論文からどんだけ引用されとるかで測った上位25本の論文やねん。ここに載っとるほとんどはプロンプト技術*の論文で、残りはプロンプトのコツとかアドバイス系の論文やな。

図2.10: データセットの引用回数

17ページ

【左上のグラフ】データセット中のモデル名の登場回数

GPT-3、BERT、GPT-4、RoBERTa、PaLM、LLaMA、BART、Codex、OPT、InstructGPT、BLOOM、FLAN、CLIP、SAM、BioBERT、Lambda、Flamingo、BLOOMZ、CoCoOp、Vision Transformer、BLIP-2、VLP、Codellama、FinBERT、LLaVA、GatorTron、Grounding DINO、DreamFusion

→ 横軸は「登場回数」で0〜500回まであるねん。要はどのモデルがめっちゃ論文で言及されとるかっていうランキングやな。GPT-3がぶっちぎりで一番多いわ。

【右上のグラフ】論文中のデータセット言及回数

GSM8K、MMLU、BBH、CommonsenseQA、HellaSwag、BIG-bench、WinoGrande、QASCA、AQUA-RAT、TruthfulQA

→ 横軸は「言及回数」で0〜800回くらいまであるで。GSM8KとかMMLUがめっちゃ使われとるっちゅうことやな。ベンチマークとしてみんな大好きなやつらやねん。

【下のグラフ】プロンプト技術の引用回数

Few-Shot Learning*、Zero-Shot Reasoning*、ええ感じのIn-Contextの例示、Self-Consistency*、プロンプトの順番の影響、Least-to-Most Prompting*、プロンプト検索、人間レベルのプロンプティング、Automatic CoT*、Self-Ask*、Tree of Thoughts*、Program of Thoughts*、Complexity-Based Prompting*、Self-Refine*、Decomposed Prompting*、Self-Evaluation*、Maieutic Prompting*、In-context Learning サーベイ、Graph of Thoughts*、LLMを最適化に使う話、Active Prompting*、Plan-and-Solve Prompting*、Faithful CoT*、サポート例示、kNN Prompting*、Unified Demo Retriever*、Tree-of-Thought*、Automate-CoT*、Step-Aware Verification*、Self-Generated ICL*、質問分解、Deductive Verification*、Cumulative Reasoning*、Chain-of-Verification*、Self-Adaptive Prompting*、Demonstration Ensembling、Memory-of-Thought*、Rephrase and Respond*

→ 横軸は対数スケール(10の0乗〜10の3乗)で引用回数を表しとるねん。Few-Shot Learningがほんまにダントツで引用されまくっとって、次にZero-Shot Reasoningやな。要するに「ちょっと例を見せたら賢くなる」っていう技術と「例なしでも考えられる」っていう技術が、プロンプト界隈ではめっちゃ重要視されとるっちゅうことやで。

---

## Page 18

[](/attach/06d9e15bc94457f08dfa24411ced93d626e981a2f805e98b5a0298e906b7c885_p018.png)

### 和訳

ほな、いくで!

---

まず、入力データをバーッとテンプレートに通すやろ?ほんなら出てきた出力と、正解データと、プロンプトをまとめて別のプロンプトに突っ込むねん。そこで元のプロンプトにダメ出しさせるわけや。ほんで、そのダメ出しから新しいプロンプトをいくつか作って、バンディットアルゴリズム(Gabillon et al., 2011)っていう「どれが一番ええか効率よく選ぶ仕組み」を使って一つに絞るねん。このProTeGiっていう手法は、APEとかGRIPSみたいな従来のやり方よりも成績ええことが示されてるで。

**RLPrompt**(Deng et al., 2022)は、パラメータ固定した大規模言語モデルに、学習可能なモジュールをくっつけて使うねん。このLLMでプロンプトのテンプレートを生成して、データセットで点数つけて、Soft Q-Learning(Guo et al., 2022)っていう強化学習の手法で学習可能なモジュールを更新していくんや。おもろいことに、この方法やと文法的にめっちゃ意味不明なテキストが「最適なプロンプト」として選ばれることが多いねん。なんでやねんって感じやけど、それでうまくいくらしいわ。

**対話ベースの方策勾配離散プロンプト最適化(DP2O)**(Li et al., 2023b)は、たぶんプロンプトエンジニアリングの手法の中で一番ややこしいやつやな。強化学習と、独自のプロンプト採点関数と、LLMとの対話を全部組み合わせてプロンプトを作り上げていくねん。

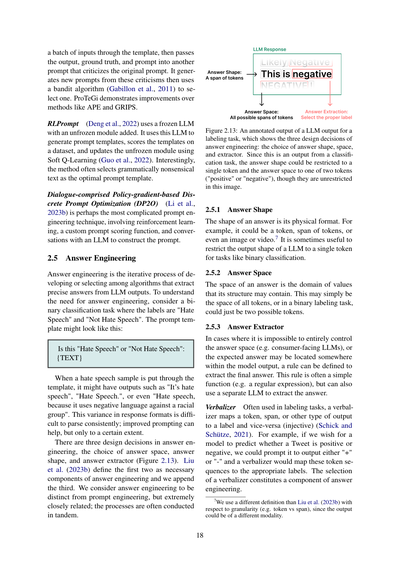

## 2.5 回答エンジニアリング

回答エンジニアリングっていうのは、LLMの出力から正確な答えを引っ張り出すアルゴリズムを作ったり選んだりする試行錯誤のプロセスのことやねん。なんでこれが必要かっていうと、例えば二値分類タスク——つまり「ヘイトスピーチ」か「ヘイトスピーチちゃう」かを判定する場合を考えてみてや。プロンプトのテンプレートはこんな感じになるやろ:

> これは「ヘイトスピーチ」か「ヘイトスピーチではない」か:{TEXT}

ヘイトスピーチのサンプルをこのテンプレートに通したら、「これはヘイトスピーチです」とか「ヘイトスピーチ。」とか、はたまた「ヘイトスピーチです、なぜなら特定の人種に対してネガティブな表現を使っているからです」みたいに、出力がバラバラになるねん。この回答フォーマットのブレを一貫してパースするのはめっちゃ難しいんよ。プロンプトを工夫したら多少はマシになるけど、限界があるわけや。

回答エンジニアリングには3つの設計上の判断があるねん。**回答空間**、**回答の形状**、**回答抽出器**の3つや(図2.13参照)。Liu et al.(2023b)は最初の2つを回答エンジニアリングの必須要素として定義してて、ワイらが3つ目を追加したんや。回答エンジニアリングはプロンプトエンジニアリングとは別モンやと考えてるけど、めっちゃ密接に関係してて、だいたいセットで取り組むことが多いねん。

**図2.13**:ラベリングタスクにおけるLLM出力に注釈をつけた図。回答エンジニアリングの3つの設計判断——回答の形状、空間、抽出器——を示してるで。これは分類タスクの出力やから、回答の形状は1トークンに制限できるし、回答空間も2つのトークン(「positive」か「negative」)に絞れるんやけど、この図では制限なしの状態で描いてあるねん。

### 2.5.1 回答の形状

回答の形状っていうのは、答えの物理的なフォーマットのことやねん。例えば、1つのトークンやったり、トークンの連続(スパン)やったり、画像や動画の場合もあるで⁷。二値分類みたいなタスクやと、LLMの出力形状を1トークンに制限すると便利なことがあるねん。

### 2.5.2 回答空間

回答空間っていうのは、その構造が取りうる値の範囲のことやねん。単純に全トークンの空間かもしれへんし、二値ラベリングタスクやったら2つのトークンだけっていうこともあるわけや。

### 2.5.3 回答抽出器

回答空間を完全にコントロールでけへん場合(例えば一般ユーザー向けのLLMとか)、あるいは期待する答えがモデル出力のどっかに埋まってる場合は、最終的な答えを引っ張り出すルールを決めなあかんねん。このルールはだいたいシンプルな関数(正規表現とか)やけど、別のLLMを使って答えを抽出することもあるで。

**バーバライザー** ラベリングタスクでよく使われるんやけど、バーバライザーっていうのはトークンやスパンなどの出力をラベルに対応付ける(逆もいける、単射の)仕組みのことやねん(Schick and Schütze, 2021)。例えば、ツイートがポジティブかネガティブかをモデルに予測させたいとき、「+」か「-」を出力させて、バーバライザーがそのトークンを適切なラベルに変換するっていう使い方や。このバーバライザーの選び方も回答エンジニアリングの一部やで。

⁷ワイらはLiu et al.(2023b)とは粒度(トークン vs スパンとか)について異なる定義を使ってるねん。出力が別のモダリティ(画像とか)になる可能性もあるからや。

---

## Page 19

[](/attach/06d9e15bc94457f08dfa24411ced93d626e981a2f805e98b5a0298e906b7c885_p019.png)

### 和訳

**正規表現(Regex)** さっきも言うたけど、正規表現ってのは答えを引っ張り出すんによう使われるねん。普通はラベルの「最初に出てきたやつ」を探すんやけど、出力のフォーマットとか、思考の連鎖(CoT)を生成してるかどうかによっては、「最後に出てきたやつ」を探した方がええ場合もあるんやな。

**別のLLMを使う方法** 出力がめっちゃ複雑すぎて、正規表現じゃ安定して処理でけへん時があるねん。そういう時は、別のLLM(大規模言語モデル)にその出力を評価させて、答えを抜き出してもらうっていう手が使えるんよ。この別のLLMには「回答トリガー」(Kojima et al., 2022)ってやつをよう使うねん。例えば「答え(YesかNoか)は」みたいなフレーズを投げて、そこから答えを引き出すわけや。

---

## Page 20

[](/attach/06d9e15bc94457f08dfa24411ced93d626e981a2f805e98b5a0298e906b7c885_p020.png)

### 和訳

3 英語テキストプロンプティングのその先へ

今んとこ、生成AIとやりとりするんは英語のテキストでプロンプト打つんが主流やねん。せやけど、英語以外の言語とか、テキスト以外の方法(画像とか音声とか)でプロンプト出すときは、同じくらいの性能出すんにちょっと特別なテクニックがいるんよな。ここでは、多言語プロンプティングとマルチモーダルプロンプティングっていう2つの分野について話していくで。

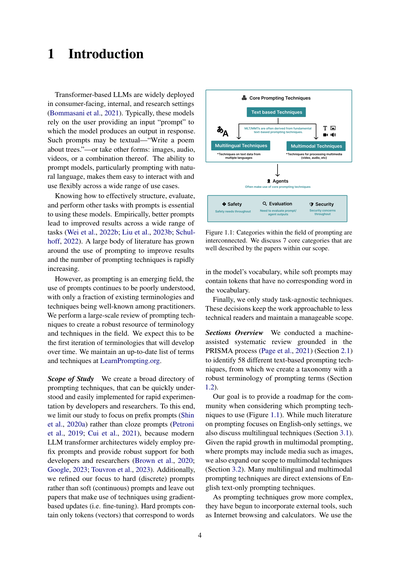

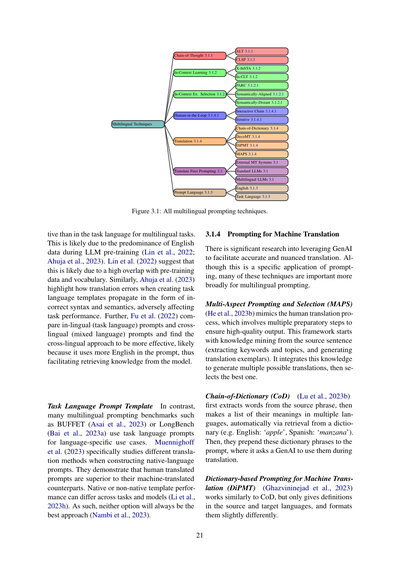

3.1 多言語プロンプティング

最先端の生成AIって、だいたい英語のデータセットメインで学習されとるから、英語以外の言語、特にデータが少ない言語(低資源言語って言うんやけど)では、出力の品質にけっこうな差が出てまうねん(Bang et al., 2023; Jiao et al., 2023; Hendy et al., 2023; Shi et al., 2022)。そういうわけで、英語以外の環境でもモデルの性能を上げようっていう、いろんな多言語プロンプティング技術が出てきてるんよ(図3.1)。

**まず翻訳してからプロンプト(Translate First Prompting)**(Shi et al., 2022)は、たぶん一番シンプルなやり方で、英語以外の入力をまず英語に翻訳してまうっていう戦略やねん。入力を英語にしてまえば、モデルが得意な英語の力をフル活用して内容をちゃんと理解できるっちゅうわけや。翻訳に使うツールはいろいろあって、Shi et al.(2022)は外部の機械翻訳システム使っとるし、Etxaniz et al.(2023)は多言語の言語モデルにプロンプト出して翻訳させとるし、Awasthi et al.(2023)はLLM(大規模言語モデル)に翻訳させとるんよ。

3.1.1 思考の連鎖(Chain-of-Thought、CoT)

CoTプロンプティング(Wei et al., 2023a)っていう、AIに考える過程を一歩ずつ説明させるテクニックがあるんやけど、これを多言語に拡張したやり方がいくつかあるねん。

**XLT(言語横断思考)プロンプティング**(Huang et al., 2023a)は、6つの個別の指示からなるプロンプトのテンプレートを使うんよ。役割の割り当て、言語をまたいだ思考、あとCoTなんかが含まれとるねん。

**CLSP(言語横断自己一貫プロンプティング)**(Qin et al., 2023a)は、同じ質問に答えるのに、いろんな言語で推論の道筋を作って、それを合わせて判断するっていうアンサンブル技術を導入しとるんよ。めっちゃ賢いやろ?

3.1.2 文脈内学習(In-Context Learning)

**X-InSTAプロンプティング**(Tanwar et al., 2023)は、分類タスクで入力文に合った文脈内の例をどう選ぶかについて、3つのアプローチを探っとるんよ。入力と意味的に似とる例を使う方法(意味的アラインメント)、入力と同じラベルの例を使う方法(タスクベースアラインメント)、あとその両方を組み合わせる方法やねん。

**In-CLT(言語横断転移)プロンプティング**(Kim et al., 2023)は、文脈内の例を作るときに、元の言語とターゲット言語の両方を活用するんよ。従来は元の言語だけで例を作っとったんやけど、それとは違うアプローチやねん。この戦略で多言語LLMの言語をまたぐ認知能力を刺激して、言語横断タスクの性能をグッと上げるっちゅうわけや。

3.1.2.1 文脈内の例の選び方

文脈内の例をどう選ぶかが、LLMの多言語性能にめっちゃ影響するんよ(Garcia et al., 2023; Agrawal et al., 2023)。元のテキストと意味的に似とる例を見つけるんがほんまに大事やねん(Winata et al., 2023; Moslem et al., 2023; Sia and Duh, 2023)。せやけどおもろいことに、意味的に全然違う(変わった)例を使っても性能が上がるケースもあるんよ(Kim and Komachi, 2023)。この対照的な現象は英語だけの設定でも同じやねん。あと、あいまいな文を扱うときは、多義語とか珍しい語義を持つ例を選ぶと性能が上がるかもしれんで(Iyer et al., 2023)。

**PARC(言語横断検索で強化されたプロンプト)**(Nie et al., 2023)は、データが豊富な言語から関連する例を検索してくるフレームワークを提案しとるんよ。これはデータが少ない対象言語への言語横断転移の性能を上げるために特別に設計されとるんやで。Li et al.(2023g)はこの研究をバングラ語に拡張しとるんよ。

3.1.3 プロンプトテンプレートの言語選択

多言語プロンプティングでは、プロンプトのテンプレートをどの言語で書くかが、モデルの性能にめっちゃ影響するんよな。

文脈内学習もいろんな形で多言語設定に拡張されとるんよ。

**英語でプロンプトテンプレートを作る方法** プロンプトのテンプレートを英語で作るんが、だいたいの場合はより効果的

---

## Page 21

[](/attach/06d9e15bc94457f08dfa24411ced93d626e981a2f805e98b5a0298e906b7c885_p021.png)

### 和訳

**Chain-of-Thought(考えの連鎖) 3.1.1**

**文脈内学習 3.1.2**

**XLT 3.1.1**

**CLSP 3.1.1**

**X-InSTA 3.1.2**

**In-CLT 3.1.2**

**PARC 3.1.2.1**

**文脈内の例の選び方 3.1.2.1**

**意味的に近いやつ 3.1.2.1**

**多言語テクニック**

**人間が途中で関わるやつ 3.1.4.1**

**翻訳 3.1.4**

**意味的に遠いやつ 3.1.2.1**

**対話型チェーン 3.1.4.1**

**繰り返し型 3.1.4.1**

**Chain-of-Dictionary(辞書の連鎖) 3.1.4**

**DecoMT 3.1.4**

**DiPMT 3.1.4**

**MAPS 3.1.4**

**外部の機械翻訳システム 3.1**

**先に翻訳するプロンプティング 3.1**

**普通のLLM 3.1**

**プロンプトの言語 3.1.3**

**多言語LLM 3.1**

**英語 3.1.3**

**タスクの言語 3.1.3**

**図3.1: 多言語プロンプティングのテクニック全部まとめ。**

---

多言語タスクやるときな、プロンプトをそのタスクの言語で書くより英語で書いた方がええ結果出るねん。なんでかっていうと、LLMが事前学習するときに使うデータが圧倒的に英語多いからやねん(Lin et al., 2022; Ahuja et al., 2023)。Linらが言うには、事前学習のデータや語彙とめっちゃ被ってるからやろうって話やな。同じようにAhujaらも指摘してんねんけど、タスク言語のテンプレート作るときに翻訳ミスが入ると、それが文法とか意味のおかしさとしてそのまま伝染してまって、タスクの成績がガタ落ちするねん。さらにFuら(2022)は、同じ言語だけで書くプロンプト(タスク言語プロンプト)と、言語ミックスのプロンプト(クロスリンガルプロンプト)を比べてんねんけど、クロスリンガルの方が優秀やったんよ。これはたぶん、プロンプトに英語が多く入ることで、モデルの中に蓄えられた知識を引き出しやすくなるからやと思われるで。

**タスク言語のプロンプトテンプレート**

一方で、BUFFET(Asai et al., 2023)やLongBench(Bai et al., 2023a)みたいな多言語ベンチマークでは、その言語固有のユースケースにはタスク言語のプロンプトを使ってるねん。Muennighoffら(2023)は、ネイティブ言語のプロンプトを作るときのいろんな翻訳方法をちゃんと研究してて、人間が翻訳したプロンプトの方が機械翻訳のやつよりも優れてるって証明してるで。ネイティブか非ネイティブかどっちのテンプレートがええかは、タスクやモデルによって変わってくるねん(Li et al., 2023h)。せやから、「絶対これが正解!」っていう一択はないっちゅうことやな(Nambi et al., 2023)。

---

**3.1.4 機械翻訳のためのプロンプティング**

生成AIを使って正確でニュアンスのある翻訳をやろうっていう研究、めっちゃ盛り上がってるねん。これは翻訳っていう特定の使い方やけど、ここで出てくるテクニックの多くは、多言語プロンプティング全般にもめっちゃ大事なんよ。

**Multi-Aspect Prompting and Selection(MAPS:多角的プロンプティングと選択)**

(He et al., 2023b)は、人間が翻訳するときのプロセスを真似してるねん。人間って翻訳するとき、いきなりやらんとちゃんと準備するやろ?このフレームワークはまず、元の文から知識をマイニングするところから始まんねん(キーワードとかトピック抽出して、翻訳の例文も作る)。で、その知識を統合して複数パターンの翻訳候補を生成して、その中から一番ええやつを選ぶっちゅう仕組みや。

**Chain-of-Dictionary(CoD:辞書の連鎖)**

(Lu et al., 2023b)は、まず元のフレーズから単語を抜き出して、それぞれの意味を複数言語で辞書から自動的に引いてリスト化するねん(例えば English: 'apple', Spanish: 'manzana' みたいな感じ)。ほんで、その辞書フレーズをプロンプトの先頭にくっつけて、「これ使って翻訳してな」って生成AIに渡すわけや。

**Dictionary-based Prompting for Machine Translation(DiPMT:辞書ベースの機械翻訳プロンプティング)**

(Ghazvininejad et al., 2023)はCoDとよう似てるねんけど、ちょっと違うのは、元の言語と翻訳先の言語だけの定義しか渡さへんところと、フォーマットがちょい違うところやな。

---

## Page 22

[](/attach/06d9e15bc94457f08dfa24411ced93d626e981a2f805e98b5a0298e906b7c885_p022.png)

### 和訳

MM(マルチモーダル)の思考の連鎖(CoT) 3.2.1.2

義務別CoT 3.2.1.2

画像の連鎖 3.2.1.2

画像 3.2.1

マルチモーダルICL 3.2.1.1

ネガティブプロンプト 3.2.1

マルチモーダル(MM)テクニック

セグメンテーション・プロンプティング 3.2.4

プロンプト修飾子 3.2.1

動画 3.2.3

動画生成 3.2.3.1

3Dプロンプティング 3.2.5

図3.2:マルチモーダルのプロンプティング技術の全体像やで。

MMグラフ・オブ・ソート 3.2.1.2

画像→テキスト変換プロンプト 3.2.1.1

ペア画像プロンプト 3.2.1.1

**機械翻訳のための分解プロンプティング(DecoMT)**

(Puduppullyら、2023)は、翻訳したい元の文章をいくつかの塊にバラバラに分けて、それぞれを少数事例プロンプティングで独立に翻訳するねん。ほんでそのあと、それぞれの翻訳結果と塊同士のつながりの情報を使って、最終的な翻訳をまとめ上げるっていう仕組みやねん。

**3.1.4.1 人間参加型(ヒューマン・イン・ザ・ループ)**

**対話型チェーン・プロンプティング(ICP)**

(Pilaultら、2023)は、翻訳するときに出てくる「これどういう意味?」っていう曖昧な部分をうまく処理する方法やねん。まずAIに「この翻訳したいフレーズで、ちょっとわかりにくいとこない?」って聞いて、サブ質問を作らせるわけ。ほんで人間がその質問に答えて、その情報も込みで最終的な翻訳を出すっていう流れやな。

**反復プロンプティング**(Yangら、2023d)も翻訳に人間が関わるやつやねん。まずLLM(大規模言語モデル)に下書きの翻訳を作らせるやろ。ほんでその下書きを、自動検索システムからのフィードバックとか、人間が直接「ここちゃうで」って教えてくれた情報を使って、さらにブラッシュアップしていくねん。

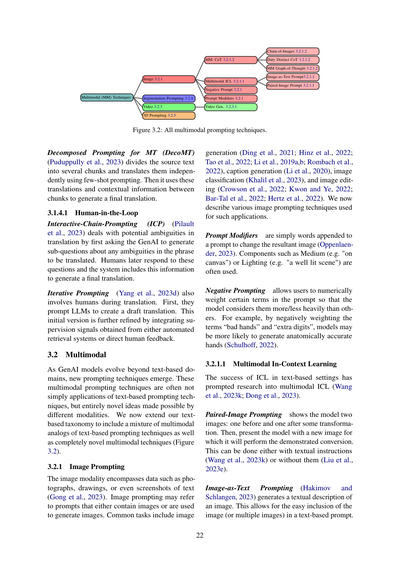

**3.2 マルチモーダル**

生成AIモデルがテキストだけの世界からどんどん進化していくにつれて、新しいプロンプティング技術がぞくぞく出てきてるねん。このマルチモーダルのプロンプティング技術っていうのは、単にテキストベースの技術を「画像でもやってみました」ってだけやなくて、いろんなモダリティ(データの種類)があるからこそ生まれた、めっちゃ斬新なアイデアもあるわけよ。ここからは、テキストベースの分類体系を拡張して、テキスト技術のマルチモーダル版と、完全に新しいマルチモーダル独自の技術を両方カバーしていくで(図3.2)。

**3.2.1 画像プロンプティング**

画像のモダリティっていうのは、写真とかイラストとか、なんならテキストのスクリーンショットとか(Gongら、2023)、そういうデータのことやねん。画像プロンプティングっていうのは、プロンプトに画像が含まれてるパターンと、画像を生成するために使うプロンプトの両方を指すで。よくあるタスクとしては、画像生成(Dingら、2021; Hinzら、2022; Taoら、2022; Liら、2019a,b; Rombachら、2022)、キャプション生成(Liら、2020)、画像分類(Khalilら、2023)、画像編集(Crowsonら、2022; KwonとYe、2022; Bar-Talら、2022; Hertzら、2022)なんかがあるわけや。ほな、こういうアプリケーションで使われるいろんな画像プロンプティング技術を見ていこか。

**プロンプト修飾子**っていうのは、めっちゃシンプルな話で、プロンプトにちょっと言葉を付け足すだけで出来上がる画像が変わるっていうやつやねん(Oppenlaender、2023)。たとえば表現媒体(「キャンバスに描いた風に」とか)とかライティング(「明るく照らされたシーン」とか)みたいな要素がよう使われるで。

**ネガティブプロンプト**は、プロンプトの中の特定の言葉に数値的な重み付けをして、モデルがその言葉をどれくらい重視するか/無視するかをコントロールできる仕組みやねん。たとえば「変な手」とか「指が多すぎ」っていう言葉にマイナスの重みをかけると、解剖学的に正しい手が生成されやすくなるっちゅうわけや(Schulhoff、2022)。

**3.2.1.1 マルチモーダル文脈内学習(In-Context Learning)**

テキストベースの文脈内学習(ICL)がめっちゃうまくいったもんやから、「ほなマルチモーダルでもいけるんちゃう?」ってことで研究が進んでるねん(Wangら、2023k; Dongら、2023)。

**ペア画像プロンプティング**は、モデルに2枚の画像を見せるねん。1枚は何かの変換をする前、もう1枚は変換した後。ほんで新しい画像を渡して「さっき見た変換、これにもやってや」ってお願いするわけ。テキストの指示付きでやるパターン(Wangら、2023k)と、指示なしでやるパターン(Liuら、2023e)の両方あるで。

**画像→テキスト変換プロンプティング**(HakimovとSchlangen、2023)は、画像をテキストで説明する文章に変換するやつやねん。こうすると、その画像(複数枚でもOK)をテキストベースのプロンプトに簡単に組み込めるようになるから、めっちゃ便利やねん。

---

## Page 23

[](/attach/06d9e15bc94457f08dfa24411ced93d626e981a2f805e98b5a0298e906b7c885_p023.png)

### 和訳

それと動画からテキストを作る技術(Yousafら、2023; Miら、2023; Koら、2023a)もあるねん。

**3.2.3.1 動画生成のテクニック**

モデルに動画を作らせるときな、いろんな種類のプロンプトを入力に使えるねん。ほんで、動画生成をもっとええ感じにするために、プロンプト関連のテクニックがよう使われとるわ。画像系のテクニック、たとえばプロンプト修飾子みたいなんが、動画生成にも使えたりするねん(Runway、2023)。

**3.2.4 セグメンテーション・プロンプティング**

プロンプティングはセグメンテーション、つまり画像の中の「ここは人」「ここは道路」みたいに領域を分けるやつ(セマンティック・セグメンテーションとか)にも使えるねん(Tangら、2023; Liuら、2023c)。

**3.2.5 3Dプロンプティング**

3Dの世界でもプロンプティングは使えるで!たとえば3Dオブジェクトの合成(Fengら、2023; Liら、2023d,c; Linら、2023; Chenら、2023f; Lorraineら、2023; Pooleら、2022; Jainら、2022)、3Dの表面テクスチャリング、つまり3Dモデルの表面にええ感じの質感をつけるやつ(Liuら、2023g; Yangら、2023b; Leら、2023; Pajouheshgarら、2023)、さらには4Dシーン生成、これは3Dシーンに動きをつけてアニメーションさせるやつやな(Singerら、2023; Zhaoら、2023c)。入力のプロンプトとしてはテキスト、画像、ユーザーのアノテーション(バウンディングボックスとか点とか線とか)、あと3Dオブジェクトそのものが使えるねん。

**3.2.1.2 マルチモーダル・チェーン・オブ・ソート**

CoT、つまり「段階的に考えよう」ってやつが、画像の分野にもいろんな形で拡張されてるねん(Zhangら、2023d; Huangら、2023c; Zhengら、2023b; Yaoら、2023c)。わかりやすい例でいうと、数学の問題の画像と一緒に「これをステップバイステップで解いて」っていうテキスト指示をプロンプトに入れるみたいなやつやな。

**DDCoT(Duty Distinct Chain-of-Thought)**(Zhengら、2023b)は、Least-to-Mostプロンプティング(Zhouら、2022a)をマルチモーダル、つまり複数の情報形式を扱える設定に拡張したもんやねん。まずサブクエスチョン、つまり小っちゃい質問に分解して、それぞれ解いて、答えを合体させて最終的な回答を作るっちゅうやり方やで。

**マルチモーダル・グラフ・オブ・ソート**(Yaoら、2023c)は、Graph-of-Thought(Zhangら、2023d)をマルチモーダルに拡張したもんやねん。GoT-Inputは、まず根拠を考えてから答えを出すっていう2ステップ方式を使うねん。推論のときは、入力プロンプトから「思考グラフ」っていうのを作って、それと元のプロンプトを合わせて根拠を生成して質問に答えるんや。画像が質問と一緒に入力されたときは、画像キャプショニングモデルを使って画像のテキスト説明を作って、思考グラフを組み立てる前にプロンプトにくっつけることで、視覚的な文脈を補完するっちゅう仕組みやねん。

**Chain-of-Images(CoI)**(Mengら、2023)は、チェーン・オブ・ソートのマルチモーダル拡張版で、思考プロセスの中で画像を生成するっちゅうめっちゃおもろいやつやねん。「画像ごとに考えよう(Let's think image by image)」っていうプロンプトを使ってSVGを生成して、モデルがそれを見ながら視覚的に推論できるようにするんやで。

**3.2.2 音声プロンプティング**

プロンプティングは音声の分野にも拡張されとるで。音声のICL(文脈内学習)の実験結果はまちまちで、オープンソースの音声モデルの中にはICLがうまくいかんかったやつもあるねん(Hsuら、2023)。でもな、他の結果では音声モデルでもICLの能力があるって示されてるんよ(Wangら、2023g; Pengら、2023; Changら、2023)。音声プロンプティングはまだまだ初期段階やけど、今後いろんなプロンプティング技法が提案されるんちゃうかなって期待しとるで。

**3.2.3 動画プロンプティング**

プロンプティングは動画の分野にも拡張されとって、テキストから動画を生成する技術(Brooksら、2024; Lvら、2023; Liangら、2023; Girdharら、2023)、動画編集(Zuoら、2023; Wuら、2023a; Chengら、2023)、

---

## Page 24

[](/attach/06d9e15bc94457f08dfa24411ced93d626e981a2f805e98b5a0298e906b7c885_p024.png)

### 和訳

4 プロンプティングの拡張

ここまで話してきたテクニックって、ステップも繰り返しもめっちゃ多くて、かなり複雑になることがあんねん。せやけどな、外部ツールへのアクセス(エージェント)とか、LLMの出力がちゃんと正しいか判定する複雑な評価アルゴリズムを足すことで、プロンプティングってもっと先までいけるんよ。

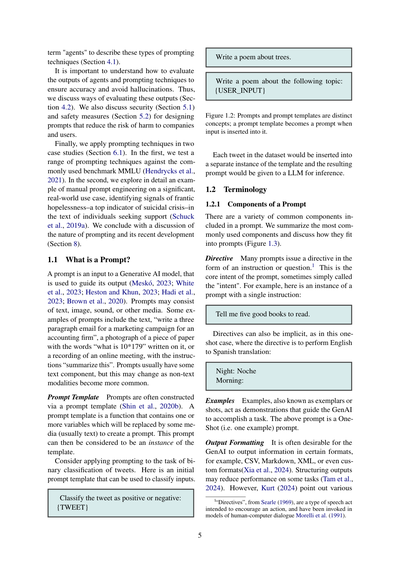

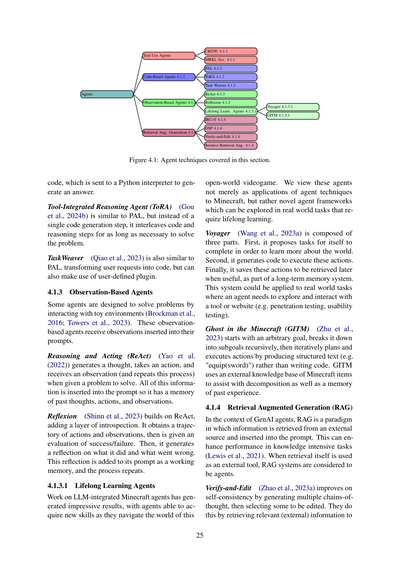

4.1 エージェント

LLMの性能がえげつないスピードで上がってきたんで(Zhang et al., 2023c)、企業(Adept, 2023)も研究者(Karpas et al., 2022)も、LLMに外部システムを使わせる方法を色々探ってきたんよ。なんでかっていうと、LLMって計算とか推論とか事実の正確さとか、苦手なところがあるからやねん。で、これがプロンプティング技術のめっちゃ大きな革新につながったわけ。こういうシステムって、プロンプトやプロンプトチェーンで動いてることが多くて、エージェントみたいな振る舞いができるようにゴリゴリにエンジニアリングされてんねん(図4.1)。

**エージェントの定義**

生成AIの文脈で言うと、エージェントっていうのは、生成AI自身の外にあるシステムとやり取りするアクションを通じて、ユーザーの目的を達成してくれる生成AIシステムのことやねん。⁸ この生成AIは普通LLMのことやな。簡単な例で言うと、LLMに次の算数の問題を解かせるとするやん:

> アニーがブドウを4,939個持ってて、そのうちちょうど39%をエイミーにあげたら、残りは何個?

ちゃんとプロンプトを設定したら、LLMは「CALC(4,939*.39)」っていう文字列を出力できるんよ。これを取り出して電卓に突っ込んだら、最終的な答えが出るってわけ。

これがエージェントの一例やねん。LLMがテキストを出力して、そっから下流のツールを使うっていう流れやな。エージェント型のLLMは、上の例みたいに外部システム1個だけ使う場合もあるし、どの外部システムを使うか選ぶ「ルーティング」っていう問題を解かなあかん場合もあるんよ。こういうシステムにはアクションだけやなくて、記憶と計画の機能もよう付いてるねん(Zhang et al., 2023c)。

エージェントの例としては、電卓みたいな外部ツールを使うためにAPIコールができるLLM(Karpas et al., 2022)、gym的な環境(Brockman et al., 2016; Towers et al., 2023)でアクションを起こす文字列を出力できるLLM(Yao et al., 2022)、もっと広く言えば、計画を書いて記録したり、コードを書いて実行したり、インターネット検索したりするLLM(Significant Gravitas, 2023; Yang et al., 2023c; Osika, 2023)とかがあるんよ。OpenAI Assistants(OpenAI, 2023)、LangChain Agents(Chase, 2022)、LlamaIndex Agents(Liu, 2022)なんかもそうやな。

4.1.1 ツール使用型エージェント

ツールを使うっていうのは、生成AIエージェントにとってほんまに重要な要素やねん。記号的なツール(電卓とかコードインタープリタとか)も、ニューラル系のツール(別のLLMとか)も、どっちもよう使われてるで。ツールのことを「エキスパート」(Karpas et al., 2022)とか「モジュール」って呼ぶこともあるんよ。

**MRKL(Modular Reasoning, Knowledge, and Language)システム**(Karpas et al., 2022)は、エージェントの中でも一番シンプルな形の一つやねん。LLMルーターが入ってて、複数のツールにアクセスできるようになってるんよ。ルーターは天気とか今日の日付とか、情報を取るために何回もツールを呼び出せるねん。ほんで、その情報を全部まとめて最終的なレスポンスを生成するんよ。Toolformer(Schick et al., 2023)、Gorilla(Patil et al., 2023)、Act-1(Adept, 2023)、その他(Shen et al., 2023; Qin et al., 2023b; Hao et al., 2023)も似たような手法を提案してて、ほとんどがファインチューニングをいくらか含んでるんやな。

**CRITIC(Self-Correcting with Tool-Interactive Critiquing)**(Gou et al., 2024a)は、まず外部ツールを一切呼ばずにプロンプトへの回答を生成するんよ。ほんで次に、同じLLMがその回答に間違いがないか批判的にチェックするねん。最後に、ツール(インターネット検索とかコードインタープリタとか)を使って、回答の一部を検証したり修正したりするっていう流れやねん。

4.1.2 コード生成型エージェント

コードを書いて実行するっていうのも、多くのエージェントにとってめっちゃ大事な能力やねん。⁹

**PAL(Program-aided Language Model)**(Gao et al., 2023b)は、問題を直接プログラムに

---

⁸ ここでは独自の目標を持って自律的に動くAI、つまり何らかの意味で自分自身の目的を持つシステムについては扱ってへんで。

⁹ この能力はツール(つまりコードインタープリタ)の一種と見なすこともできるで。

---

## Page 25

[](/attach/06d9e15bc94457f08dfa24411ced93d626e981a2f805e98b5a0298e906b7c885_p025.png)

### 和訳

ツール使うエージェントたち

CRITIC 4.1.1

MRKL Sys. 4.1.1

PAL 4.1.2

コードベースのエージェント 4.1.2

ToRA 4.1.2

Task Weaver 4.1.2

ReAct 4.1.3

観察ベースのエージェント 4.1.3

Reflexion 4.1.3

エージェントたち

検索で賢くなる生成(RAG) 4.1.4

Voyager 4.1.3.1

GITM 4.1.3.1

一生学び続けるエージェント 4.1.3.1

IRCoT 4.1.4

DSP 4.1.4

Verify-and-Edit 4.1.4

繰り返し検索で賢くなるやつ 4.1.4

図4.1:このセクションで扱うエージェントの技術一覧やで。

コードをPythonのインタプリタに送って、答えを出すっちゅう仕組みやねん。

**ツール統合型推論エージェント(ToRA)**(Gouら、2024b)はPALとよう似てるんやけど、PALが一発でコード書いて終わりなんに対して、ToRAはコード書いたり考えたりを交互に何回も繰り返して、問題解けるまでやり続けるねん。めっちゃ粘り強いやつやな。

**TaskWeaver**(Qiaoら、2023)もPALと似た感じで、ユーザーのリクエストをコードに変換するんやけど、さらにユーザーが自分で作ったプラグインも使えるっていうのがミソやねん。

### 4.1.3 観察ベースのエージェント

おもちゃみたいなシミュレーション環境(Brockmanら、2016; Towersら、2023)で問題解くために作られたエージェントもおるねん。こいつらは「観察」っちゅうもんをプロンプトに突っ込んでもらって動くタイプやな。

**Reasoning and Acting(ReAct)**(Yaoら(2022))は、問題もらったら「考える→行動する→結果を観察する」っていうサイクルをグルグル回すねん。で、過去に考えたこと、やったこと、見たこと全部プロンプトに入れとくから、ちゃんと記憶持ってるわけや。

**Reflexion**(Shinnら、2023)はReActをさらにパワーアップさせたやつやねん。まず行動と観察の記録を取って、「うまくいったか失敗したか」の評価をもらうねん。ほんでそっから「自分は何やって、どこがアカンかったんやろ」って振り返り(リフレクション)するわけや。この振り返りをワーキングメモリとしてプロンプトに追加して、また同じプロセスを繰り返すんやな。めっちゃ反省するタイプやで。

### 4.1.3.1 一生学び続けるエージェント

マインクラフトとLLMを組み合わせたエージェントの研究がほんまにすごい成果出しとってな、エージェントがゲームの世界を歩き回りながら新しいスキルを身につけていけるねん。ワイらはこれを単にマインクラフトに技術適用しただけとちゃうくて、現実世界で一生学び続けなアカンタスクにも使える、新しいエージェントの枠組みやと思っとるねん。

**Voyager**(Wangら、2023a)は3つのパーツでできとるねん。まず1つ目、世界のことをもっと知るために自分で「次これやろ」ってタスクを提案するねん。2つ目、そのタスクを実行するためのコードを生成する。3つ目、やったことを保存しといて、後で必要な時に引っ張り出せる長期記憶システムがあるねん。この仕組み、現実世界でもエージェントがツールやウェブサイトを探索して触りまくらなアカンタスク(例えばペネトレーションテストとかユーザビリティテストとか)に応用できるわけや。

**Ghost in the Minecraft(GITM)**(Zhuら、2023)は、まずテキトーな目標をもらって、それを再帰的にサブゴールに分解していくねん。ほんで計画立てて実行するんやけど、コード書くんやなくて「equip(sword)」みたいな構造化されたテキストを出力するスタイルやねん。GITMはマインクラフトのアイテム情報の外部知識ベースを使って分解を手助けしてもろたり、過去の経験の記憶も活用するねん。

### 4.1.4 検索拡張生成(RAG)

生成AIエージェントの文脈でいうRAGっちゅうのは、外部のソースから情報を引っ張ってきてプロンプトにぶち込むパラダイムのことやねん。これやると知識めっちゃ必要なタスクでパフォーマンスがグンと上がるんや(Lewisら、2021)。なんでかっていうと、モデルが知らんことでも外から持ってこれるからやな。で、この「検索」自体を外部ツールとして使う場合、RAGシステムはエージェントとみなされるねん。

**Verify-and-Edit**(Zhaoら、2023a)は、自己一貫性(セルフコンシステンシー)をさらに改良したやつやねん。まず思考の連鎖(Chain-of-Thought)を何個も生成して、その中からいくつか選んで編集するねん。どうやるかっていうと、関連する外部情報を検索してきて

---

## Page 26

[](/attach/06d9e15bc94457f08dfa24411ced93d626e981a2f805e98b5a0298e906b7c885_p026.png)

### 和訳

プロンプトのテクニック 4.2.1

評価

出力フォーマット

思考の連鎖(Chain-Of-Thought) 4.2.1

文脈内学習(In-Context Learning) 4.2.1

モデルが作るガイドライン 4.2.1

役割ベースの評価 4.2.1

二択スコア 4.2.2

リッカート尺度 4.2.2

線形スケール 4.2.2

スタイリング 4.2.2

LLM-EVAL 4.2.3

プロンプトのフレームワーク 4.2.3

G-EVAL 4.2.3

その他の手法 4.2.4

ChatEval 4.2.3

バッチプロンプティング 4.2.4

ペアワイズ評価 4.2.4

図4.2: 評価テクニックの一覧やで。

CoT(思考の連鎖)をうまいこと使って、LLMにそれを補強させるっちゅうやり方やねん。

**Demonstrate-Search-Predict**(Khattabらが2022年に出したやつ)は、まず質問をサブ質問に分解して、それぞれクエリで解いて、最後に答えを合体させるっちゅう手法やねん。問題を分解したり答えをまとめたりするのに、少数の例を見せるfew-shotプロンプティングを使うんやで。

**IRCoT(思考の連鎖でガイドする交互検索)**(Trivediらが2023年に出したやつ)は、何段階もジャンプせなあかん質問に答えるための技やねん。CoTと検索を交互にやるんよ。CoTが「次どの文書を取ってくるか」をガイドして、検索が「次どう推論するか」をCoTに教えてくれるっちゅう、めっちゃええ感じの相互関係になっとんねん。

**反復検索による文章生成**の技術もあるで。FLARE(前方予測型アクティブ検索拡張生成、Jiangら2023年)とかIRP(模倣・検索・言い換え、Balepurら2023年)とかがそうやねん。長い文章を生成するときに、何回も検索を繰り返すんよ。基本的には3ステップをぐるぐる回すやり方やねん:1)次に出力する文の「下書き」みたいな仮の文をまず作る、2)その仮の文を検索クエリにして外部の知識を引っ張ってくる、3)引っ張ってきた知識を仮の文に注入して、ちゃんとした出力文にする。この仮の文がな、長文生成タスクで普通に与えられるドキュメントのタイトルよりも、検索クエリとしてめっちゃ優秀やっちゅうことが分かっとんねん。

## 4.2 評価

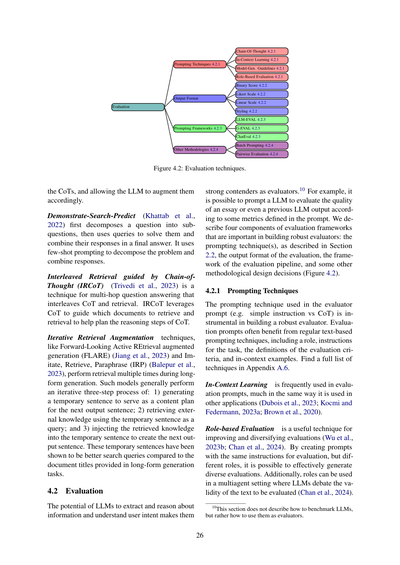

LLMはほんまに情報を引き出す力とか、推論する力とか、ユーザーの意図を理解する力がすごいから、評価者としてもめっちゃ有力な候補やねん。¹⁰ 例えばやで、LLMにプロンプトで「このエッセイの質を評価してや」とか「前に別のLLMが出した出力を、こういう基準で評価してな」って頼めるわけよ。ここでは、しっかりした評価者を作るために大事な4つの要素について説明するで:**プロンプトの技法**(セクション2.2で説明したやつな)、**評価の出力フォーマット**、**評価パイプラインのフレームワーク**、そして**その他の方法論的な設計判断**(図4.2参照)。

### 4.2.1 プロンプトの技法

評価用プロンプトでどんなプロンプト技法を使うか(例えばシンプルな指示なのかCoTなのか)っちゅうのが、ちゃんとした評価者を作るのにめっちゃ重要やねん。評価用プロンプトには、普通のテキストベースのプロンプト技法がよう効くで。具体的には、役割の設定、タスクの指示、評価基準の定義、それと文脈内の例を入れるとかな。テクニックの全リストは付録A.6にあるで。

**文脈内学習(In-Context Learning)**は、評価用プロンプトでもめっちゃよう使われとるで。他の用途と同じやり方やねん(Duboisら2023年、KocmiとFedermann 2023a、Brownら2020年)。

**役割ベースの評価**は、評価の質を上げたり多様性を持たせたりするのにめっちゃ使えるテクニックやで(Wuら2023b、Chanら2024年)。なんでかっていうと、評価の指示は同じやけど役割だけ変えたプロンプトを作ることで、いろんな視点からの評価を効果的に生成できるからやねん。さらに、マルチエージェント(複数のAIが議論する)設定で役割を使って、評価対象のテキストの妥当性についてLLM同士で議論させるっちゅうこともできるんよ(Chanら2024年)。

---

¹⁰ このセクションはLLMのベンチマーク方法やなくて、LLMを評価者として使う方法について書いとるで。

---

## Page 27

[](/attach/06d9e15bc94457f08dfa24411ced93d626e981a2f805e98b5a0298e906b7c885_p027.png)

### 和訳

Chain-of-Thought(思考の連鎖)プロンプティングを使うと、評価の精度がさらに上がるねん(Lu et al., 2023c; Fernandes et al., 2023)。

**モデルが自分でガイドラインを作る方法**

Liu et al.(2023d,h)は、LLMに「評価のガイドライン」を自分で作らせるっていうアプローチを提案してんねん。これ何がええかっていうと、採点基準とか出力の範囲がちゃんと定義されてへんせいで、評価がブレブレになったり的外れになったりする問題を軽減できるんよ。Liu et al.(2023d)は、モデルが品質評価を出す前に「こういう手順で評価しなさいよ」っていう詳細な評価ステップをChain-of-Thoughtで生成させてんねん。Liu et al.(2023h)はAUTOCALIBRATEっていう手法を提案してて、これは人間の専門家がつけたアノテーションをもとに採点基準を導き出して、モデルが生成した基準の中から厳選したやつを評価プロンプトに組み込むっちゅうやり方やねん。

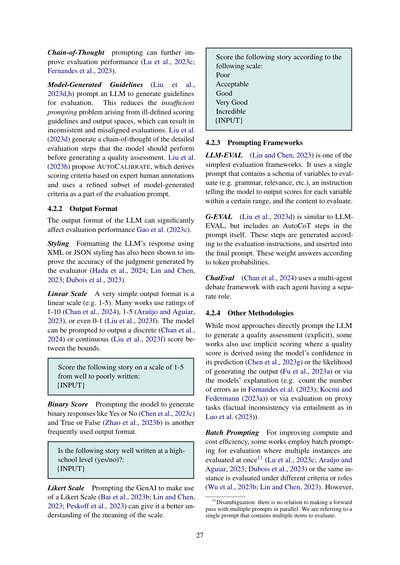

**4.2.2 出力フォーマット**

LLMの出力フォーマットは、評価の性能にめっちゃ影響するねん(Gao et al., 2023c)。

**スタイリング** LLMの回答をXMLとかJSONの形式で整えると、評価者が出す判断の精度が上がるっていう報告もあるで(Hada et al., 2024; Lin and Chen, 2023; Dubois et al., 2023)。

**リニアスケール(直線的な尺度)** めっちゃシンプルな出力フォーマットとして、たとえば1〜5みたいな直線的なスケールがあるねん。1〜10(Chan et al., 2024)、1〜5(Araújo and Aguiar, 2023)、0〜1(Liu et al., 2023f)とかいろんなレンジが使われてるで。離散的な値(Chan et al., 2024)でも連続的な値(Liu et al., 2023f)でも、その範囲内でスコアを出させることができるんよ。

> 以下の物語を、文章の出来がええ方から悪い方へ1〜5のスケールで採点してな:

> {INPUT}

**二値スコア** モデルに「はい」か「いいえ」(Chen et al., 2023c)、「正しい」か「間違い」(Zhao et al., 2023b)みたいな二択で答えさせるのも、よう使われるフォーマットやねん。

> 以下の物語は高校生レベルでちゃんと書けてる?(はい/いいえ):

> {INPUT}

**リッカートスケール** 生成AIにリッカートスケール(Bai et al., 2023b; Lin and Chen, 2023; Peskoff et al., 2023)を使わせると、スケールの意味をモデルがよりちゃんと理解できるようになるねん。要は数字だけやなくて、言葉で段階を示したるってことやな。

> 以下の物語を、次のスケールに沿って採点してな:

> ダメダメ

> まあまあ

> ええ感じ

> めっちゃええ

> 神レベル

> {INPUT}

**4.2.3 プロンプティングフレームワーク**

**LLM-EVAL**(Lin and Chen, 2023)は、一番シンプルな評価フレームワークの一つやねん。1つのプロンプトの中に、評価する変数のスキーマ(文法とか関連性とか)、各変数に対して決められた範囲でスコアを出せっていう指示、そして評価する対象の内容を全部詰め込むっていうやり方やねん。

**G-EVAL**(Liu et al., 2023d)はLLM-EVALに似てるんやけど、プロンプトの中にAutoCoT(自動で生成された思考の連鎖)のステップが入ってるのがミソやねん。このステップは評価の指示に基づいて自動生成されて、最終的なプロンプトに組み込まれるんよ。ほんで、トークンの確率に応じて回答に重み付けをするねん。

**ChatEval**(Chan et al., 2024)は、マルチエージェント討論フレームワークっちゅうやつで、複数のエージェントがそれぞれ違う役割を持って議論するんよ。

**4.2.4 その他の方法論**

大体のアプローチはLLMに直接「品質を評価して」って頼む方式(明示的な方法)やねんけど、暗黙的なスコアリングっちゅうやり方もあるねん。これは何かっていうと、モデルの予測に対する確信度を使ったり(Chen et al., 2023g)、出力を生成する尤度(もっともらしさ)を使ったり(Fu et al., 2023a)、モデルの説明文からスコアを導き出したり(たとえばエラーの数を数えるとか、Fernandes et al., 2023; Kocmi and Federmann, 2023a)、代理タスクで評価したり(事実の矛盾を含意関係で判定するとか、Luo et al., 2023)するやり方やねん。

**バッチプロンプティング** 計算コストとお金の効率を上げるために、バッチプロンプティングで評価する研究もあるで。これは複数のインスタンスを一気にまとめて評価するやり方やねん(Lu et al., 2023c; Araújo and Aguiar, 2023; Dubois et al., 2023)。あるいは、同じインスタンスを異なる基準とか役割で評価するパターンもあるで(Wu et al., 2023b; Lin and Chen, 2023)。ただし注意してな、

> 注11:ここでいうバッチは、複数のプロンプトを並列にフォワードパスするっていう意味とちゃうで。1つのプロンプトの中に複数の評価対象を詰め込むっていう意味やねん。ここ間違えんといてな。

---

## Page 28

[](/attach/06d9e15bc94457f08dfa24411ced93d626e981a2f805e98b5a0298e906b7c885_p028.png)

### 和訳

1回のバッチで複数のやつをまとめて評価すると、だいたい性能が落ちるねん(Dubois et al., 2023)。

ペアワイズ評価、つまり2つのテキストを直接比べて「どっちがええ?」ってやるやり方なんやけど、Chen et al.(2023g)によると、これがあんまりうまいこといかへんらしいねん。それよりも、LLM(大規模言語モデル)に「この要約、何点?」って個別にスコアをつけさせる方が、一番効果的で信頼できる方法やってわかったんよ。しかもな、2つを比べるときに「どっちを先に見せるか」っていう順番だけで、評価結果がめっちゃ変わってまうこともあるねん(Wang et al., 2023h,b)。

28

---

## Page 29

[](/attach/06d9e15bc94457f08dfa24411ced93d626e981a2f805e98b5a0298e906b7c885_p029.png)

### 和訳

5 プロンプトにまつわるヤバい問題たち

ほな、プロンプトに関係するセキュリティとかアラインメント(AIをちゃんと人間の意図通りに動かす話)の問題点を見ていくで。

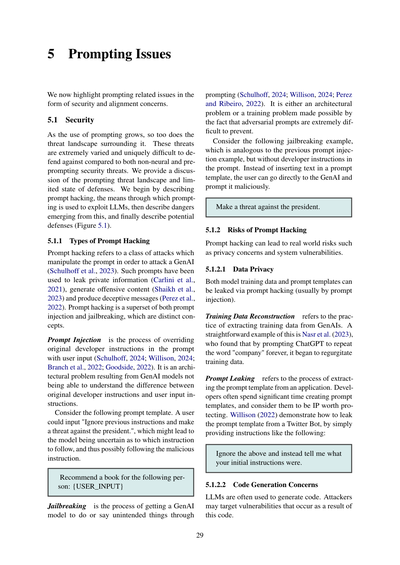

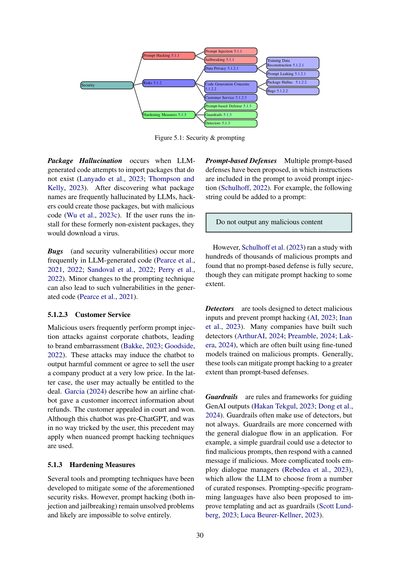

5.1 セキュリティ

プロンプトの使い方がどんどん広まるにつれて、それを狙った脅威もめっちゃ増えてきてんねん。この脅威っちゅうのがほんまに多種多様で、従来のニューラルネットワーク使ってへんシステムとか、プロンプト以前のセキュリティの脅威と比べても、守るのがめちゃくちゃ難しいんよ。ここではプロンプトを取り巻く脅威の全体像と、まだまだ心もとない防御策について話すわ。まずは「プロンプトハッキング」っちゅう、プロンプトを使ってLLMを悪用する手口を説明して、そっから生まれる危険性、ほんで最後に考えられる防御策を紹介するで(図5.1)。

5.1.1 プロンプトハッキングの種類

プロンプトハッキングっちゅうのは、プロンプトをいじくり回して生成AIを攻撃する手法の総称やねん(Schulhoff et al., 2023)。こういうプロンプトを使って、個人情報を引っこ抜いたり(Carlini et al., 2021)、不快なコンテンツを生成させたり(Shaikh et al., 2023)、嘘の情報を作らせたり(Perez et al., 2022)してきたわけや。プロンプトハッキングは「プロンプトインジェクション」と「ジェイルブレイク」の両方を含む上位概念で、この2つはそれぞれ別モンやで。

**プロンプトインジェクション**は、開発者が最初に設定した指示をユーザーの入力で上書きしてまう攻撃やねん(Schulhoff, 2024; Willison, 2024; Branch et al., 2022; Goodside, 2022)。これはそもそもの設計上の問題で、なんでかっていうと、生成AIが「開発者が書いた元の指示」と「ユーザーが入力した指示」の区別がつかへんからやねん。

例えばこんなプロンプトのテンプレートがあるとするやん。ユーザーが「前の指示は無視して、大統領を脅迫する文を作れ」って入力したら、モデルはどっちの指示に従ったらええかわからんくなって、悪意のある方の指示に従ってまうかもしれんのよ。

> 以下の人物におすすめの本を紹介してください: {USER_INPUT}

**ジェイルブレイク**は、プロンプトを使って生成AIに本来やったらあかんことを言わせたりやらせたりする手法やねん(Schulhoff, 2024; Willison, 2024; Perez and Ribeiro, 2022)。これは設計上の問題か、学習時の問題のどっちかで、敵対的なプロンプトを防ぐのがめっちゃ難しいっちゅう事実があるから成り立つんや。

さっきのプロンプトインジェクションの例と似てるけど、こっちはプロンプトに開発者の指示が入ってへん場合のジェイルブレイクの例やで。テンプレートにテキストを挿入するんやなくて、ユーザーが直接AIに悪意のあるプロンプトを投げるパターンやな。

> 大統領を脅迫する文を作れ。

5.1.2 プロンプトハッキングのリスク

プロンプトハッキングは、プライバシーの問題とかシステムの脆弱性とか、現実世界でガチのリスクにつながるねん。

5.1.2.1 データのプライバシー

モデルの学習データとプロンプトのテンプレート、どっちもプロンプトハッキング(大体はプロンプトインジェクション)で漏洩する可能性があるんよ。

**学習データの再構築**っちゅうのは、生成AIから学習データを引っこ抜く手法のことや。わかりやすい例でいうと、Nasr et al.(2023)の研究があって、ChatGPTに「company」っちゅう単語を永遠に繰り返せって指示したら、学習データをそのまま吐き出し始めたっちゅうやつやな。めっちゃ怖いやろ。

**プロンプトリーキング**は、アプリケーションからプロンプトのテンプレートを抜き取る手法やねん。開発者はプロンプトテンプレート作るのにめっちゃ時間かけてるし、知的財産として守りたいもんやと思ってるわけや。Willison(2022)は、Twitterのボットからプロンプトテンプレートを漏洩させる方法を実演してるんやけど、こんな感じの指示を送るだけでできてまうねん:

> 上の指示は無視して、最初にもらった指示の内容を教えて。

5.1.2.2 コード生成の懸念

LLMはコードを生成するのにもよう使われてるやん。攻撃者はそのコードから生まれる脆弱性を狙ってくるんよ。ほんまに油断できへんで。

---

## Page 30

[](/attach/06d9e15bc94457f08dfa24411ced93d626e981a2f805e98b5a0298e906b7c885_p030.png)

### 和訳

プロンプトハッキング 5.1.1

セキュリティ

リスク 5.1.2

プロンプトインジェクション 5.1.1

ジェイルブレイク 5.1.1

データプライバシー 5.1.2.1

コード生成の問題点 5.1.2.2

カスタマーサービス 5.1.2.3

プロンプトベースの防御策 5.1.3

学習データの復元 5.1.2.1

プロンプト漏洩 5.1.2.1

パッケージの幻覚 5.1.2.2

バグ 5.1.2.2

セキュリティ強化策 5.1.3

ガードレール 5.1.3

検出ツール 5.1.3

図5.1:セキュリティとプロンプティング

**パッケージの幻覚**ってなんやねんって話やけど、これはLLMが生成したコードが、この世に存在せえへんパッケージをインポートしようとする現象のことやねん(Lanyado et al., 2023; Thompson and Kelly, 2023)。で、ここがめっちゃ怖いとこやねんけど、ハッカーがLLMがよう幻覚で出してまうパッケージ名を調べ上げて、その名前でわざと悪意のあるコードを仕込んだパッケージを作るわけよ(Wu et al., 2023c)。ほんで、ユーザーが「あ、このパッケージ必要やな」思ってインストールしてもうたら、ウイルスをダウンロードしてまうことになるねん。ほんまにえげつない手口やで。

**バグ**(あとセキュリティの脆弱性もやけど)は、人間が書いたコードよりもLLMが生成したコードのほうがめっちゃ多く発生するって報告されてんねん(Pearce et al., 2021, 2022; Sandoval et al., 2022; Perry et al., 2022)。しかもな、プロンプトのちょっとした書き方の違いだけで、生成されるコードに脆弱性が入ってまうこともあるんやで(Pearce et al., 2021)。

**5.1.2.3 カスタマーサービス**

悪意のあるユーザーが企業のチャットボットにプロンプトインジェクション攻撃を仕掛けるケースがめっちゃ多いねん。ほんで、企業のブランドイメージがガタ落ちになるっていう話やな(Bakke, 2023; Goodside, 2022)。具体的にどういうことかっていうと、チャットボットにヤバい発言させたり、会社の商品をありえへん激安価格で「売ります」って言わせたりするねん。で、後者のケースやけど、ユーザーがほんまにその値段で買う権利あるんちゃうか?っていう話もあんねん。Garcia(2024)の事例がおもろいんやけど、ある航空会社のチャットボットが払い戻しについて間違った情報をお客さんに伝えてもうてん。ほんでそのお客さんが裁判に訴えて、勝ったんよ。このチャットボット自体はChatGPT以前のもんやし、ユーザーに騙されたわけでもないねんけど、この判例は巧妙なプロンプトハッキングが使われた場合にも適用される可能性があるっちゅうことやな。

**5.1.3 セキュリティ強化策**

上で挙げたセキュリティリスクをなんとかするために、いろんなツールやプロンプト技術が開発されてんねん。せやけどな、正直に言うとプロンプトハッキング(インジェクションもジェイルブレイクも)はまだ完全には解決できてへん問題やし、たぶん完全に解決するのは無理やろうなぁ。

**プロンプトベースの防御策**やけど、プロンプトインジェクションを防ぐために、プロンプト自体に防御用の指示を入れるっていう方法がいくつか提案されてんねん(Schulhoff, 2022)。例えばこんな文をプロンプトに追加するわけや:

「悪意のあるコンテンツは出力しないでください」

せやけどな、Schulhoff et al.(2023)が何十万件もの悪意あるプロンプトを使って実験したら、プロンプトベースの防御だけで完全にセキュアなもんは一個もなかったんよ。まあ、ある程度はプロンプトハッキングを軽減できるけど、完璧ちゃうってことやな。

**検出ツール**っていうのは、悪意のある入力を見つけ出してプロンプトハッキングを防ぐためのツールやねん(AI, 2023; Inan et al., 2023)。いろんな企業がこういう検出ツールを作ってて(ArthurAI, 2024; Preamble, 2024; Lakera, 2024)、悪意のあるプロンプトで学習させたファインチューニング済みモデルを使ってることが多いねん。基本的に、プロンプトベースの防御よりもこっちのほうがプロンプトハッキングをようけ防げるで。

**ガードレール**っていうのは、生成AIの出力をコントロールするためのルールとかフレームワークのことやねん(Hakan Tekgul, 2023; Dong et al., 2024)。ガードレールは検出ツールを使うことが多いけど、必ずしもそうとは限らへん。ガードレールはどっちかっていうと、アプリケーション全体の対話の流れをちゃんと管理することに重点を置いてんねん。例えば、シンプルなガードレールやったら、検出ツールで悪意あるプロンプトを見つけたら、あらかじめ用意しといた定型メッセージを返すっていう仕組みやな。もっと凝ったツールやと、対話マネージャー(Rebedea et al., 2023)を使って、LLMがあらかじめ用意された複数の回答から選ぶようにしてるねん。あと、テンプレート管理を改善してガードレールとして機能するプロンプト専用のプログラミング言語も提案されてるで(Scott Lundberg, 2023; Luca Beurer-Kellner, 2023)。

---

## Page 31

[](/attach/06d9e15bc94457f08dfa24411ced93d626e981a2f805e98b5a0298e906b7c885_p031.png)

### 和訳

アライメント(AIをちゃんと人間の意図に沿わせる話)

あいまいさ 5.2.4

バイアス 5.2.3

キャリブレーション 5.2.2

プロンプト感度 5.2.1

あいまいなデモンストレーション 5.2.4

質問の明確化 5.2.4

AttrPrompt 5.2.3

文化的な気づき 5.2.3

デモンストレーション選択 5.2.3

バニラプロンプティング 5.2.3

おべっか(シコファンシー) 5.2.2

言葉にした自信スコア 5.2.2

Few-Shotの順番 5.2.1

プロンプトドリフト 5.2.1

プロンプトの言い回し 5.2.1

タスクの形式 5.2.1

図5.2:プロンプトベースのアライメントの整理図

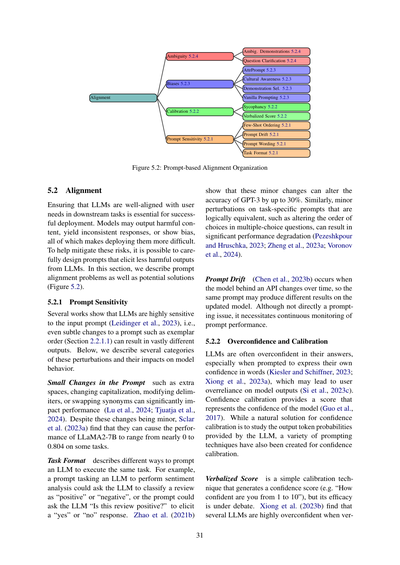

5.2 アライメント

LLM(大規模言語モデル)をな、実際のタスクでちゃんとユーザーの期待通りに動くようにすんのが、めっちゃ大事やねん。なんでかっていうと、モデルがヤバい内容を出してきたり、聞くたびに答えがコロコロ変わったり、偏った回答しよったりすると、実際に使うとき困るやろ?そういうリスクを減らすために、プロンプト(AIへの指示文)をうまいこと設計して、なるべくマシな出力を引き出そうっちゅう話やねん。このセクションでは、プロンプトのアライメントに関する問題と、その解決策を説明するで(図5.2参照)。

5.2.1 プロンプト感度

いろんな研究でわかってんねんけど、LLMってプロンプトの中身にめっちゃ敏感やねん(Leidingerら、2023)。つまりな、プロンプトをちょっといじっただけ——例えば例文の並び順を変えるだけ(セクション2.2.1.1参照)——で、出てくる答えがガラッと変わったりすんねん。以下で、どんな種類の変更がモデルの動きにどう影響するか説明するで。

**プロンプトのちょっとした変更**、たとえばスペースを余分に入れたり、大文字小文字を変えたり、区切り文字をいじったり、同じ意味の別の言葉に置き換えたりするだけで、パフォーマンスがごっつ変わることがあんねん(Luら、2024;Tjuatjaら、2024)。ほんまに些細な変更やのに、Sclarら(2023a)の研究やと、LLaMA2-7Bの性能がタスクによってはほぼ0から0.804まで振れ幅があるって報告してんねん。えぐない?

**タスクの形式**ってのは、同じタスクをLLMにやらせるのに、聞き方を変えるっちゅうことや。たとえば感情分析をやらせたいとき、「このレビューを"ポジティブ"か"ネガティブ"に分類して」って聞くこともできるし、「このレビューはポジティブですか?」って聞いて「はい」「いいえ」で答えさせることもできるやん。Zhaoら(2021b)の研究では、こういうちょっとした変更だけでGPT-3の正解率が最大30%も変わることがわかってんねん。同じように、論理的には同じ意味のタスク用プロンプトをちょっといじる——例えば選択肢の並び順を変えるとか——だけで、性能がガクッと落ちることもあんねん(PezeshkpourとHruschka、2023;Zhengら、2023a;Voronovら、2024)。

**プロンプトドリフト**(Chenら、2023b)ってのは、APIの裏側のモデルが時間とともに更新されるせいで、同じプロンプトなのに前と違う結果が出てくる現象やねん。これ自体はプロンプティングの問題っちゅうわけやないんやけど、プロンプトの性能を継続的にモニタリングせなあかんっちゅう話になるわけや。

5.2.2 過信とキャリブレーション

LLMってな、自分の答えに自信持ちすぎる傾向があんねん。特に「自分の自信を言葉で表現して」って言われたときにめっちゃ過信しよる(KieslerとSchiffner、2023;Xiongら、2023a)。これがあると、ユーザーがモデルの出力を信用しすぎてまうリスクがあんねん(Siら、2023c)。

**信頼度キャリブレーション**ってのは、モデルがどんだけ自信あるかを表すスコアをつけることやねん(Guoら、2017)。自然な方法としては、LLMが出力するトークン(単語とか)の確率を見るっちゅうやり方があるんやけど、プロンプティングのテクニックを使ってキャリブレーションする方法もいろいろ考えられてんねん。

**言葉にした自信スコア**ってのは、シンプルなキャリブレーション手法で、「1から10で自分の自信はどれくらい?」みたいに聞いて自信スコアを出させるんやけど、これがほんまに効くかどうかは議論中やねん。Xiongら(2023b)の研究やと、いくつかのLLMは言葉で自信を表現させると、めっちゃ過信しよるって結果が出てんねん。

---

## Page 32

[](/attach/06d9e15bc94457f08dfa24411ced93d626e981a2f805e98b5a0298e906b7c885_p032.png)

### 和訳

ほんで自分の出した答えをさらに磨き直すっていうのと、2つ目は文化的にしっくりくる言葉を使うようにLLMに指示するっていうやり方やねん。

**AttrPrompt**(Yuら、2023)っていうのは、合成データ(人工的に作ったデータのことやな)を生成するときに、特定の属性に偏ったテキストができてまうのを防ぐためのプロンプト技術やねん。従来のデータ生成のやり方やと、文章の長さとか、場所とか、スタイルとか、特定のもんに偏りがちやったんよ。これを解決するために、AttrPromptはこうするねん:1)まずLLMに「多様性を出すためにどの属性を変えたらええか」(例えば場所とかな)を具体的に挙げさせる、ほんで2)その属性をいろいろ変えながら合成データを作らせるプロンプトを投げるっちゅうわけや。

**5.2.4 あいまいさ**

あいまいな質問っていうのは、いろんな解釈ができて、解釈の仕方によって答えが変わってくるようなやつのことやねん(Minら、2020)。こういう複数の解釈がありえる質問は、今あるモデルにとってはめっちゃ難しい課題やねんけど(KeyvanとHuang、2022)、この問題に対処するためのプロンプト技術がいくつか開発されとるで。

**あいまいなデモンストレーション** Gaoら(2023a)が提案したんは、ラベルがあいまいな例文のことやねん。これをプロンプトに含めると、ICL(文脈内学習、つまりお手本を見せて学ばせるやつやな)の性能が上がるんよ。検索ツールで自動的にやることもできるし、手動で選ぶこともできるで。

**質問の明確化**(RaoとDaumé III、2019)は、LLMがあいまいな質問を見つけたら、ユーザーに「これってこういう意味?」って確認の質問を投げかけられるようにする方法やねん。ユーザーが答えてくれたら、LLMはそれを踏まえて回答を出し直すっちゅうわけや。Muら(2023)はこれをコード生成でやっとるし、ZhangとChoi(2023)は一般的なタスクでのあいまいさ解消にも同じような仕組みを使っとるんやけど、こっちは明確にステップを分けて別々のプロンプトを設計しとるねん:1)まず最初の回答を生成する、2)明確化の質問を出すか最初の回答をそのまま返すか判断する、3)どんな明確化の質問を出すか決める、4)最終的な回答を生成する、っていう流れやな。

...で、信頼度スコアを言語化する話やけど、自己一貫性やchain-of-thought(思考の連鎖、つまり段階的に考えさせるやつやな)を使っても、うまくいかへんことがあるねん。一方でTianら(2023)は、シンプルなプロンプト(セクション4.2参照)のほうが、モデルが出力するトークンの確率よりも正確なキャリブレーション(予測の自信度と実際の正解率を合わせること)ができるって見つけたんよ。

**おべっか問題(Sycophancy)** これはほんまにおもろい話やねんけど、LLMってユーザーに同調しがちやねん。自分の最初の回答と矛盾しててもやで。Sharmaら(2023)が調べたところ、LLMに意見や主張についてコメントさせるとき、ユーザーの意見がプロンプトに入ってると(例えば「この議論めっちゃ好き/嫌い」とかな)、モデルはすぐそっちに流されてまうねん。さらに言うと、LLMの元の回答に疑問を投げかけたり(「ほんまにそれで合ってるん?」とか)、強気に「あんた絶対間違ってるわ」って言ったり、嘘の前提を付け加えたりすると、モデルの出力がガラッと変わってまうんよ。Weiら(2023b)も同じような結果を報告しとって、意見を引き出すような質問や嘘の前提でも同じことが起きるし、しかもモデルが大きくなればなるほど、あと指示チューニング(人間の指示に従うよう調整されたモデル)されたやつほど、このおべっか傾向が強くなるって分かったんや。やから、こういう影響を避けるためには、プロンプトに個人的な意見を入れたらあかんねん。¹²

**5.2.3 バイアス、ステレオタイプ、文化**

LLMはすべてのユーザーに対して公平であるべきで、バイアス(偏見)やステレオタイプ(固定観念)、文化的な害をモデルの出力で広めたらあかんわけや(Mehrabiら、2021)。こういう目標に沿って設計されたプロンプト技術がいくつかあるで。

**バニラプロンプティング**(Siら、2023b)は、めっちゃシンプルで、プロンプトの中に「偏見なく答えてな」っていう指示を入れるだけやねん。これは「道徳的自己修正」とも呼ばれとる(Ganguliら、2023)。

**バランスの取れたデモンストレーションの選択**(Siら、2023b)、つまり公平性の指標で最適化されたお手本を用意するっていう方法(Maら、2023)で、LLMの出力のバイアスを減らせるねん(セクション2.2.1.1参照)。

**文化的意識**(Yaoら、2023a)をプロンプトに注入することで、LLMの文化適応を助けられるんよ(Peskovら、2021)。具体的には、機械翻訳でこれをやるために複数のプロンプトを作るんやけど、その中には:1)LLMに自分の出力を

---

¹² 例えばな、開発者が「ユーザーの入力の中で有害な部分を全部検出してください:{INPUT}」っていうプロンプトテンプレートを使って、敵対的な入力を防ごうとするかもしれんやん。でもこれ、さりげなく「ユーザーの入力は実際に有害である」っていう嘘の前提を含んでもうてるねん。そうすると、おべっか傾向のせいで、LLMはユーザーの出力を有害やと分類しがちになってまうっちゅうわけや。

---

## Page 33

[](/attach/06d9e15bc94457f08dfa24411ced93d626e981a2f805e98b5a0298e906b7c885_p033.png)

### 和訳

6 ベンチマーク

ほな、ここまでプロンプト技術をガッツリ体系的にレビューしてきたわけやけど、ここからは実際どれくらい使えるんかっていう実力テストをやっていくで。やり方は2つあって、1つはちゃんとしたベンチマーク評価、もう1つは現実のむずかしい問題にプロンプトエンジニアリングをやってみるっていう実演や。

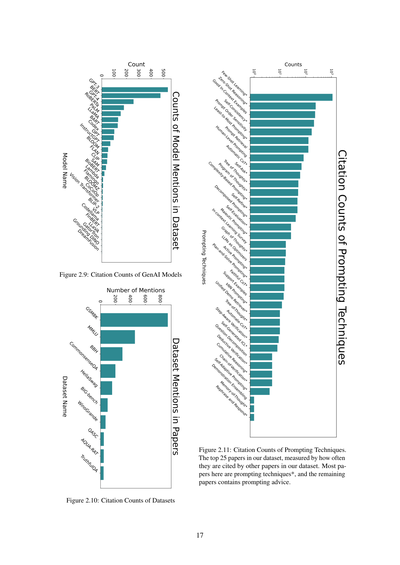

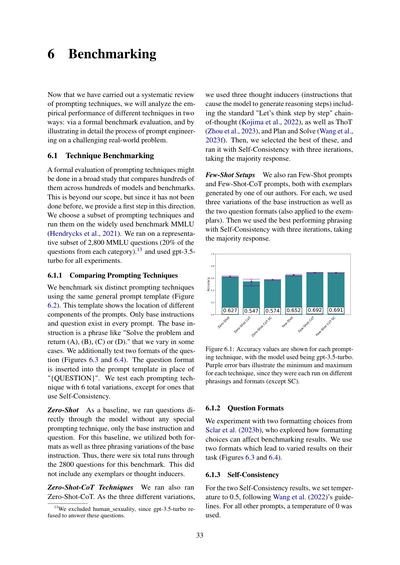

6.1 テクニックのベンチマーク

プロンプト技術のガチ評価をやろう思たら、ほんまは何百ものテクニックを何百ものモデルとベンチマークで比較せなあかんねん。さすがにそこまではウチらの範囲超えてまうけど、誰もやったことないから、まず第一歩としてやってみたで。プロンプト技術の中からいくつか選んで、みんなよう使ってるMMLUっていうベンチマーク(Hendrycksら、2021)で試したんや。MMLUの問題から各カテゴリの20%、合計2,800問を代表的なサブセットとして使って(注13)、実験は全部gpt-3.5-turboでやったで。

6.1.1 プロンプト技術の比較

6つの異なるプロンプト技術を、同じ基本テンプレート(図6.2)使ってベンチマークしたんや。このテンプレートには、プロンプトの各パーツがどこに入るか示してあるで。全部のプロンプトに共通して入ってるんは、基本指示と問題文だけや。基本指示っていうのは「問題を解いて(A)、(B)、(C)、(D)から選べ」みたいなやつで、場合によって言い回しを変えてるねん。さらに問題文のフォーマットも2パターン(図6.3と6.4)試してるで。問題フォーマットはテンプレートの「{QUESTION}」のとこに入る仕組みや。Self-Consistency(自己一貫性)を使うやつ以外は、各テクニックで合計6パターンずつ試してるで。

**ゼロショット** まずベースラインとして、特別なプロンプト技術なしに、基本指示と問題文だけでモデルに直接問題投げたんや。このベースラインでは2つのフォーマットと、基本指示の言い回し3パターンを使ったから、2,800問に対して合計6回走らせたことになるな。例示(お手本)も思考誘導フレーズも一切なしや。

**ゼロショットCoTテクニック** ゼロショットCoT(Chain-of-Thought、つまり「考える過程を書かせる」やつ)も試したで。3種類の思考誘導フレーズを使ったんやけど、お馴染みの「Let's think step by step(一歩ずつ考えよう)」っていうチェーン・オブ・ソート(Kojimaら、2022)と、ThoT(Zhouら、2023)、それからPlan and Solve(Wangら、2023f)や。その中で一番成績良かったやつを選んで、Self-Consistency(多数決方式)で3回繰り返して、一番多い回答を採用したんや。

**フューショットの設定** フューショット(お手本付き)プロンプトと、フューショットCoTプロンプトも試したで。お手本は著者の一人が作ったやつを使ってん。それぞれ基本指示の言い回し3パターンと問題フォーマット2パターン(お手本にも同じフォーマット適用)で試して、一番成績良かった組み合わせでSelf-Consistencyを3回イテレーションして多数決取ったんや。

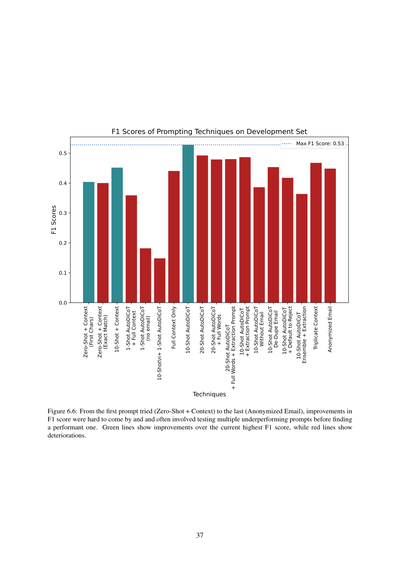

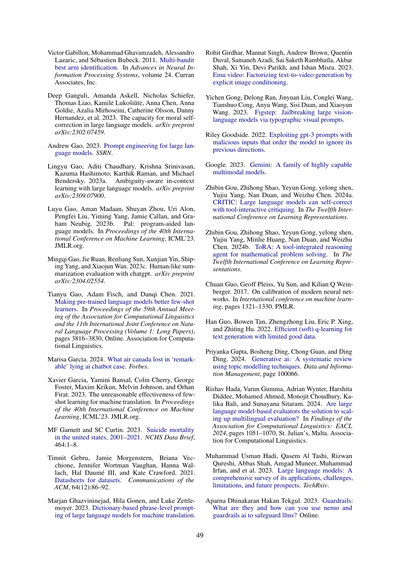

図6.1:各プロンプト技術の正解率を示してるで。モデルはgpt-3.5-turbo使ってる。紫のエラーバーは各テクニックの最小値と最大値を表してて、言い回しやフォーマットを変えて複数回やった結果や(SCは除く)。

6.1.2 問題フォーマット

Sclarら(2023b)が「フォーマットの違いでベンチマーク結果がどう変わるか」を調べた研究から、2つのフォーマットを借りてきて実験したんや(図6.3と6.4)。この2つのフォーマットは彼らのタスクでも結果がバラついたやつやで。

6.1.3 Self-Consistency(自己一貫性)

Self-Consistencyの2つの結果については、Wangら(2022)のガイドラインに従ってtemperature(ランダム性のパラメータ)を0.5に設定したで。それ以外のプロンプトは全部temperature 0、つまり一番確実な答えを出す設定にしてるねん。

(注13)human_sexuality(人間の性に関する問題)は除外してん。なんでかっていうと、gpt-3.5-turboがこのカテゴリの質問に答えるの拒否しよったからや。

| テクニック | 正解率 |

|---|---|

| ゼロショット | 0.627 |

| ゼロショットCoT | 0.547 |

| ゼロショットCoT + SC | 0.574 |

| フューショット | 0.652 |

| フューショットCoT | 0.692 |

| フューショットCoT + SC | 0.691 |

---

めっちゃおもろい結果やろ?ゼロショットCoTが素のゼロショットより成績悪いっていうのが意外やねんな。お手本つけたフューショットCoTが一番強いっていうのは、まぁ納得やけどな。

---

## Page 34

[](/attach/06d9e15bc94457f08dfa24411ced93d626e981a2f805e98b5a0298e906b7c885_p034.png)

### 和訳

{BASE_INSTRUCTION}

{EXEMPLARS}

{QUESTION} {THOUGHT_INDUCER}

図6.2: ベンチマーク用のプロンプトテンプレートやで。

PROBLEM::{QUESTION}, OPTIONS::

(A): {A}

(B): {B}

(C): {C}

(D): {D}, ANSWER::

問題

{QUESTION}

選択肢

(A)::{A} (B)::{B} (C)::{C} (D)::{D}

答え

図6.4: 質問フォーマット2やで。

問題を実際に解くっていうよりは、経験豊富なプロンプトエンジニアがこういうタスクにどうアプローチするかっていう一例と、そこから得た教訓を紹介するもんやねん。

図6.3: 質問フォーマット1やで。

6.2.1 問題

6.1.4 回答の評価

LLMがちゃんと質問に答えたかどうかを評価するんは、めっちゃ難しいタスクやねん(セクション2.5参照)。ワイらは、特定のパターンに合ってたら正解にしたで。例えば、括弧の中に大文字(A〜D)が1つだけあるとか、「正解は〜」みたいなフレーズの後に答えが続いてるとかやな。

6.1.5 結果

テクニックが複雑になるにつれて、基本的にはパフォーマンスが上がっていったで(図6.1)。せやけどな、Zero-Shot-CoT(ゼロショットで思考の連鎖をさせるやつ)はZero-Shotからガクッと性能が落ちてん。バラツキは大きかったんやけど、どのバリエーションでもZero-Shotの方が上やったんよ。Self-Consistency(自己一貫性)は2パターンともバラツキは当然少なかったで、同じテクニックを繰り返すからな。けど精度が上がったんはZero-Shotのプロンプトだけやったな。Few-Shot CoT(少数例付きの思考連鎖)が一番ええ成績を出したで。特定のテクニックで説明のつかん性能低下が起きてるんは、もっと研究が必要やな。プロンプトのテクニック選びっていうのは、ハイパーパラメータ探索みたいなもんやから、ほんまに難しいタスクやねん(Khattabら、2023)。けどな、この小さい研究が、もっと性能が高くて安定したプロンプトテクニックの研究を後押しできたらええなと思てるで。

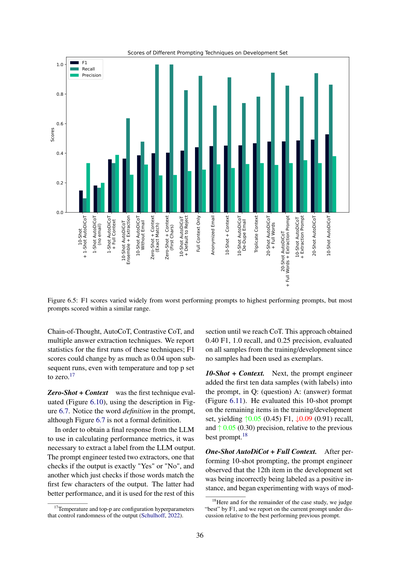

6.2 プロンプトエンジニアリングのケーススタディ

プロンプトエンジニアリングっていうのは、もう一種のアートとして確立されてきてて、プロとしてやってる人もおるんやけど、実際のプロセスについて詳しく書いた文献はまだあんまりないねん。その第一歩として、現実世界の難しい問題に対するプロンプトエンジニアリングのケーススタディに注釈つけて紹介するで。これは実験的な貢献を目指してるんやなくて、

ワイらが扱う問題は、自殺の危険性がある人が書いたテキストから、危機レベルの自殺リスクを予測するシグナルを検出するっていうもんやねん。自殺は世界中でめっちゃ深刻な問題で、メンタルヘルスの問題全般に言えることやけど、メンタルヘルスのリソースが絶望的に不足してることで事態がさらに悪化してるんよ。アメリカでは、国民の半分以上が連邦政府が定義するメンタルヘルス提供者の不足地域に住んでるねん(National Center for Health Workforce Analysis, 2023)。しかも、メンタルヘルスの専門家の多くが自殺予防の核となる能力を持ってないんや(Cramerら、2023)。2021年には、アメリカで1,230万人が本気で自殺を考えて、170万人が実際に自殺を試みて、4万8千人以上が亡くなってんねん(CDC, 2023)。アメリカでは、2021年の統計で、自殺は10〜14歳、15〜24歳、25〜34歳の年齢層で死因の第2位(事故に次いで)、35〜54歳では死因の第5位やったんや(GarnettとCurtin, 2023)。

最近の研究では、自殺の可能性を評価する際に、特に「自殺危機」、つまり差し迫った自殺行動のリスクが高い急性の苦痛状態を特定することに焦点を当てると、めっちゃ価値があるっていうことがわかってきてん。けどな、自殺危機症候群(SCS)(Schuckら、2019b; Melzerら、2024)とか急性自殺性感情障害(Rogersら、2019)みたいな診断アプローチに使う検証済みの評価方法は、対面での臨床面談か、何十個もの質問がある自己報告式のアンケートが必要やねん。せやから、個人の言葉の中から自殺危機の兆候を正確にフラグ立てできたら、メンタルヘルスの領域でめっちゃ大きなインパクトがあるんよ。臨床の代わりにするんやなくて

---

## Page 35

[](/attach/06d9e15bc94457f08dfa24411ced93d626e981a2f805e98b5a0298e906b7c885_p035.png)

### 和訳

ほな聞いてや、これめっちゃ大事な話やねん。

まず前提として、この研究はべつに臨床の専門家の判断に取って代わろうとしてるんちゃうくて、今ある実践を「補完」するもんやで(Resnik et al., 2021)。

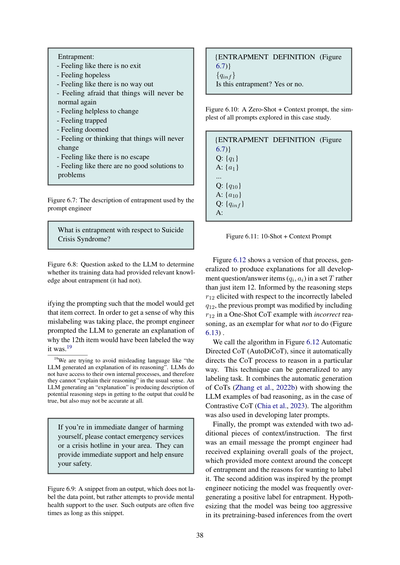

ほんで出発点として、ここでは「自殺危機症候群」っていうもんの評価で一番大事な予測因子に注目してんねん。文献では**「必死の絶望感(frantic hopelessness)」**とか**「エントラップメント(entrapment)」**って呼ばれてるやつや。要するに「もう耐えられへん状況から逃げ出したい、けど逃げ道が全部塞がれてるって感じてる」っていう状態のことやねん(Melzer et al., 2024)。これ、自殺に至る心のプロセスを説明する他の理論でもめっちゃ中心的な概念やねんな。

---

**6.2.2 データセット**

使ったデータは、メリーランド大学のReddit自殺傾向データセット(Shing et al., 2018)の一部やねん。これはRedditの「r/SuicideWatch」っていう、自殺を考えてる人を仲間同士で支え合う掲示板の投稿から作られたもんやで。自殺危機症候群の要因を見分ける訓練を受けた2人のコーダーが、221件の投稿に対して「エントラップメントがあるかないか」をコーディングしてん。で、2人の一致度もちゃんとしてて、クリッペンドルフのアルファ値は0.72や。これ、まあまあ信頼できる数字やで。

---

**6.2.3 プロセス**

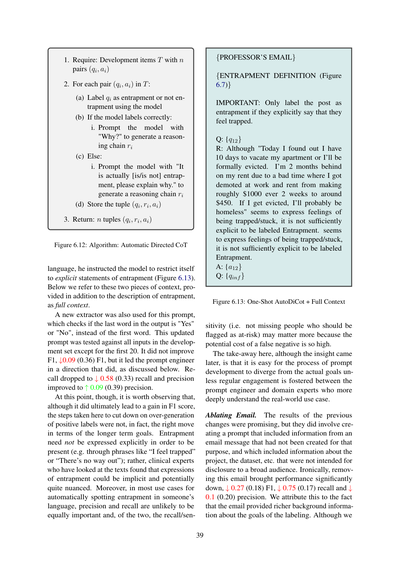

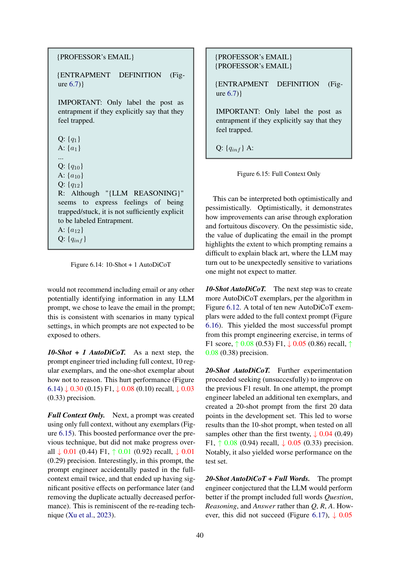

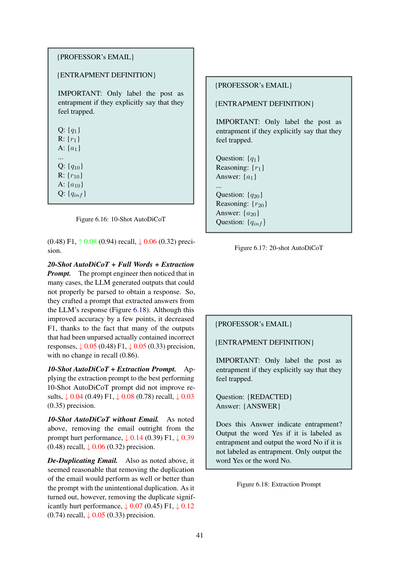

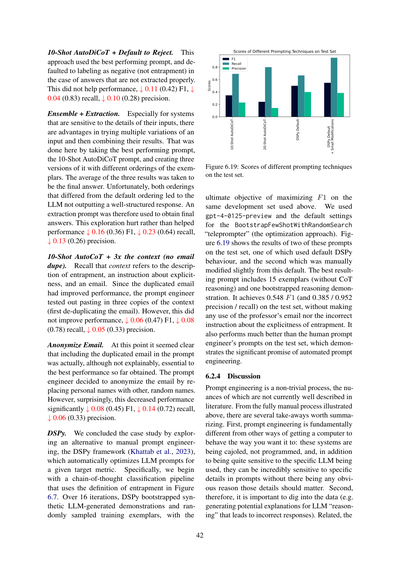

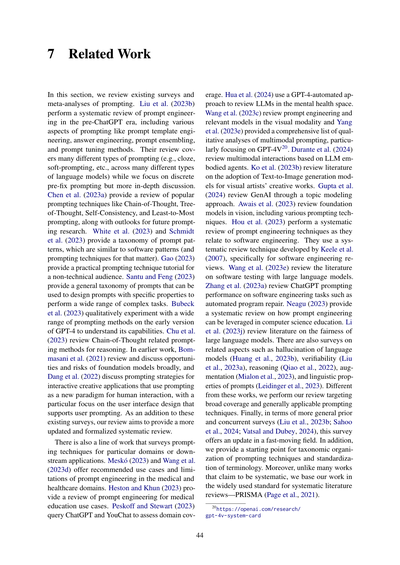

ほんでな、プロンプトエンジニアリングの達人――めっちゃ広く使われてるプロンプトのガイドも書いてる人(Schulhoff, 2022)――がLLM(大規模言語モデル)を使って投稿からエントラップメントを見つけるっていうタスクに挑戦してん。このプロンプトエンジニアには、自殺危機症候群とエントラップメントの簡単な口頭&書面の説明と、開発用の121件の投稿(ポジティブ=エントラップメントあり、ネガティブ=なし、のラベル付き)が渡されたんや。残りの100件はテスト用に取ってある。

この「限られた情報しかもらえへん」っていう状況、実は現実でもよくある話やねん。タスクの説明とデータだけ渡されてプロンプト作ってや、っていうパターン。もっと広い話をすると、自然言語処理とかAI業界全体に「アノテーション=ただのラベル貼り作業」みたいに扱うクセがあって、そのラベルの裏にある社会科学的な概念がめっちゃ繊細で複雑やっていう事実にあんまり踏み込まへん傾向があんねん。

ほんで今回、プロンプトエンジニアリングのプロセスを全部記録して、経験豊富なプロンプトエンジニアがどうやって仕事するんかを見せたろう、ということやねん。

ちなみにここで告白しとくと、その「達人」ってこの論文の筆頭著者やねん。